Содержание

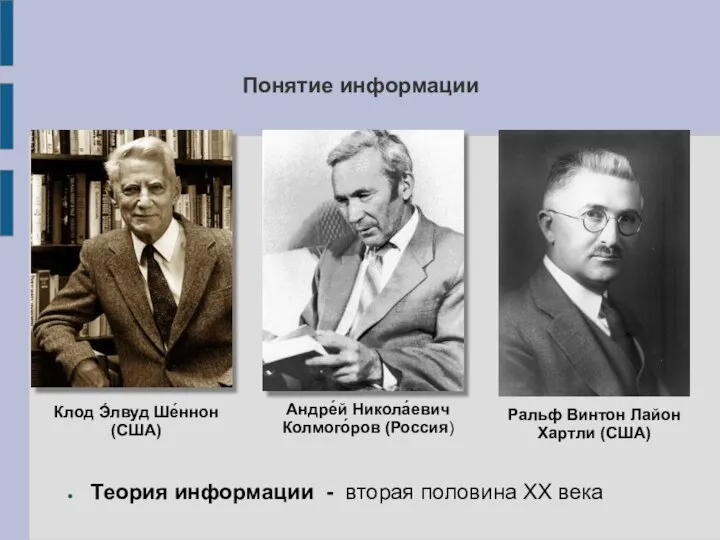

- 2. Понятие информации Теория информации - вторая половина XX века Клод Э́лвуд Ше́ннон (США) Андре́й Никола́евич Колмого́ров

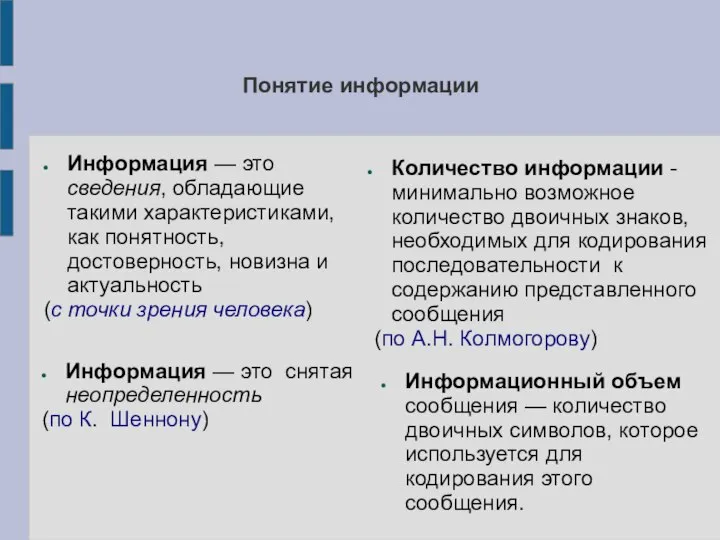

- 3. Понятие информации Информация — это сведения, обладающие такими характеристиками, как понятность, достоверность, новизна и актуальность (с

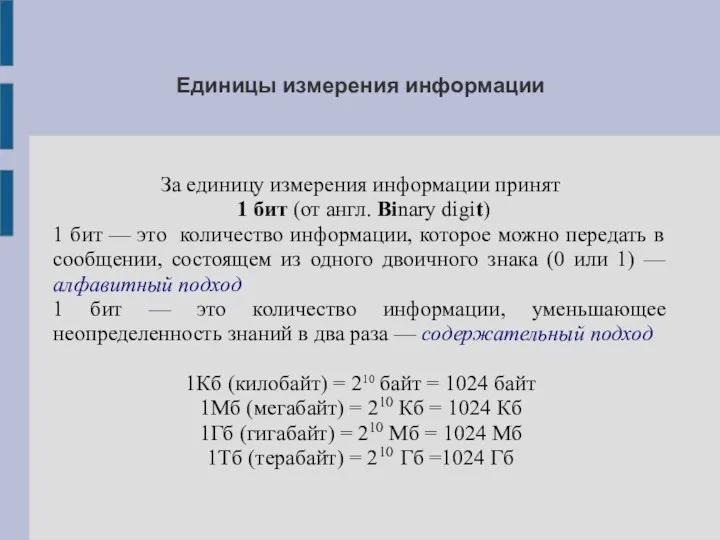

- 4. Единицы измерения информации За единицу измерения информации принят 1 бит (от англ. Binary digit) 1 бит

- 5. ВОПРОСЫ И ЗАДАНИЯ Расскажите, как вы понимаете термин «информация». Что общего и каковы различия между бытовым

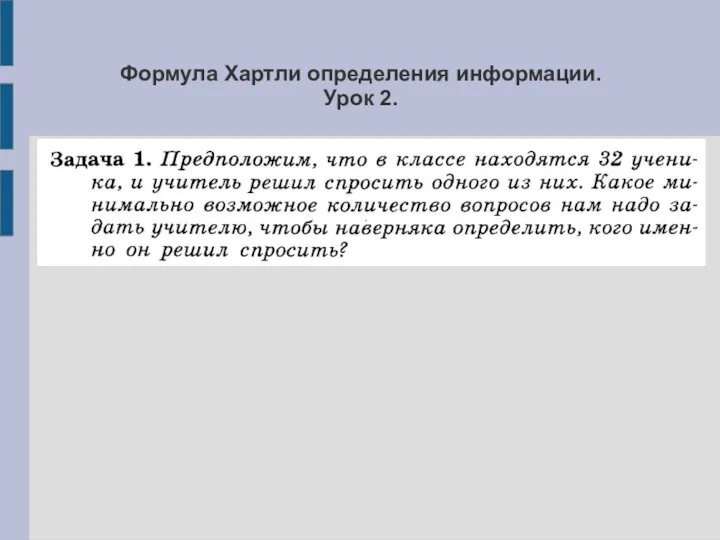

- 6. Формула Хартли определения информации. Урок 2.

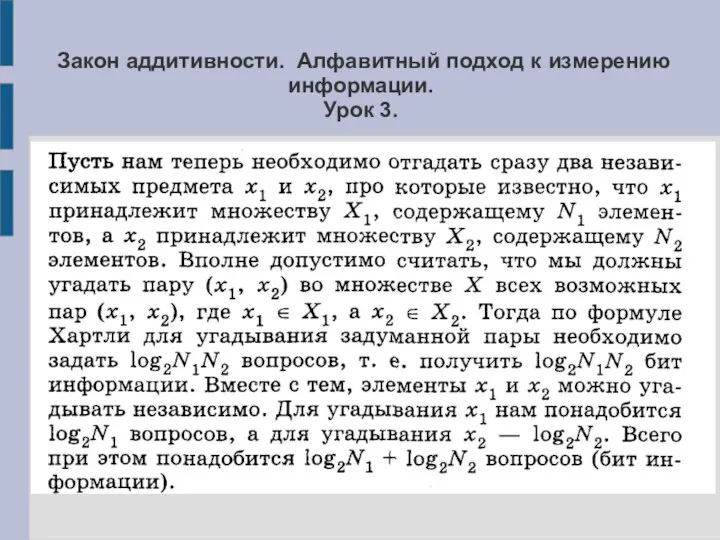

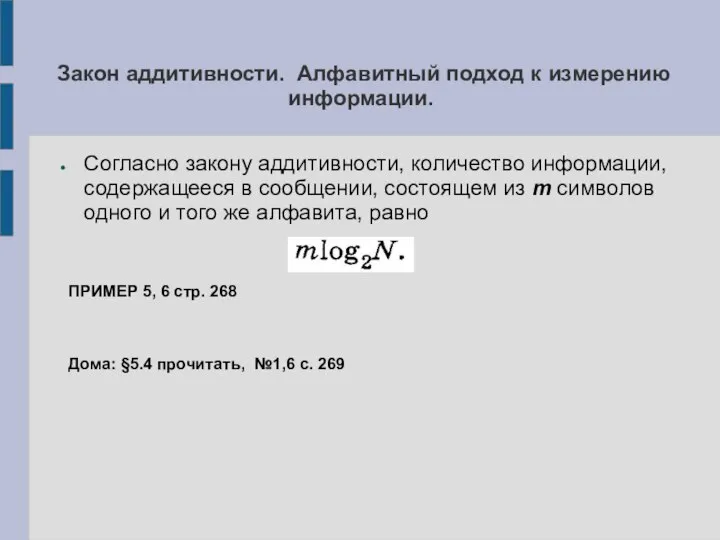

- 7. Закон аддитивности. Алфавитный подход к измерению информации. Урок 3.

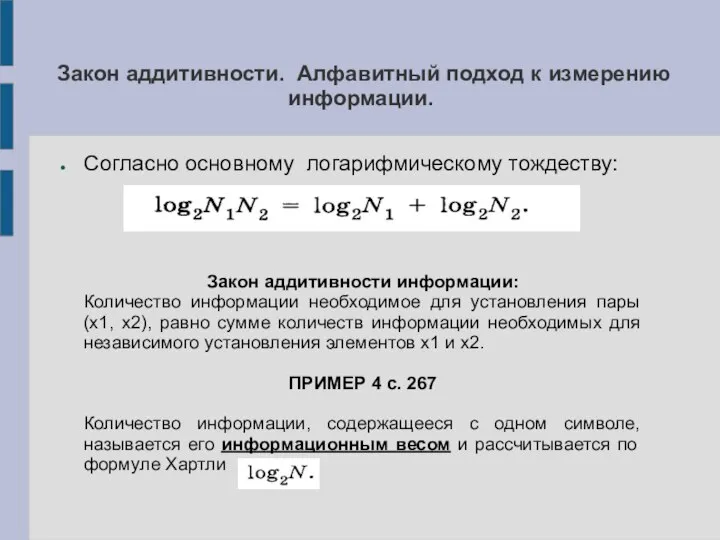

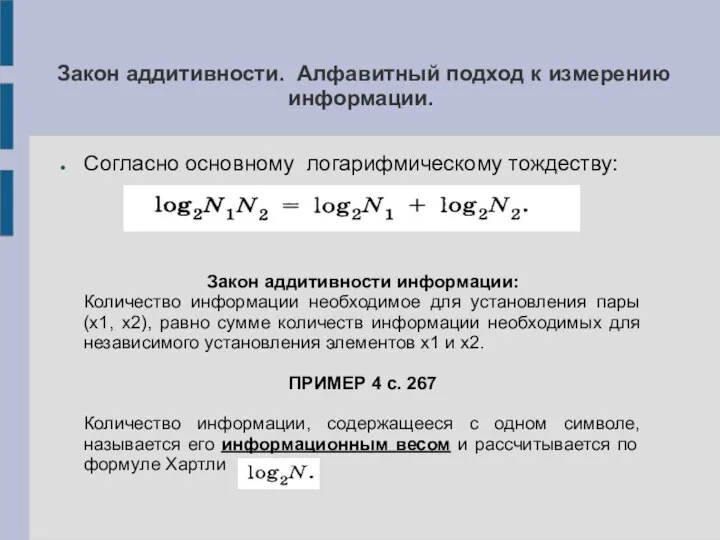

- 8. Закон аддитивности. Алфавитный подход к измерению информации. Согласно основному логарифмическому тождеству: Закон аддитивности информации: Количество информации

- 9. Закон аддитивности. Алфавитный подход к измерению информации. Согласно основному логарифмическому тождеству: Закон аддитивности информации: Количество информации

- 10. Закон аддитивности. Алфавитный подход к измерению информации. Согласно закону аддитивности, количество информации, содержащееся в сообщении, состоящем

- 11. Оптимальное кодирование информации и её сложность. Урок 7. ОСНОВЫ ТЕОРИИ ИНФОРМАЦИИ

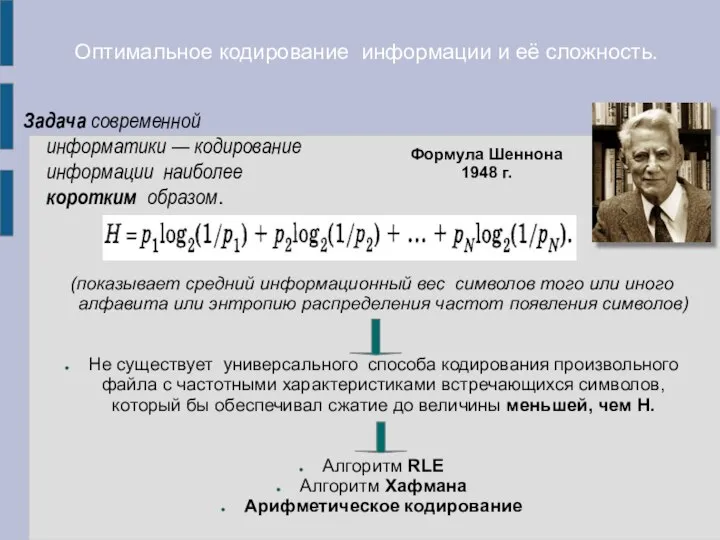

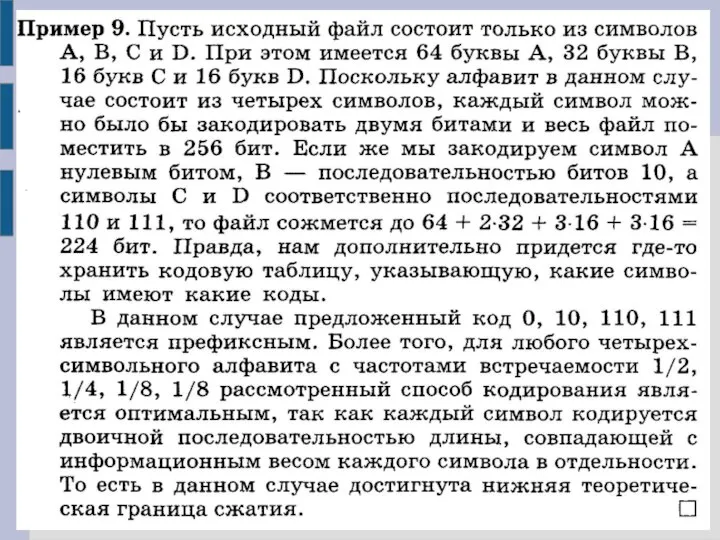

- 12. Оптимальное кодирование информации и её сложность. Задача современной информатики — кодирование информации наиболее коротким образом. (показывает

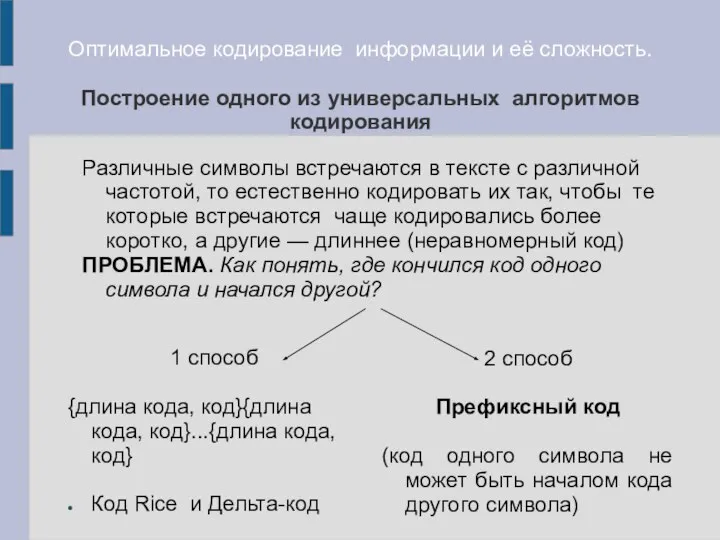

- 13. Оптимальное кодирование информации и её сложность. Построение одного из универсальных алгоритмов кодирования 1 способ {длина кода,

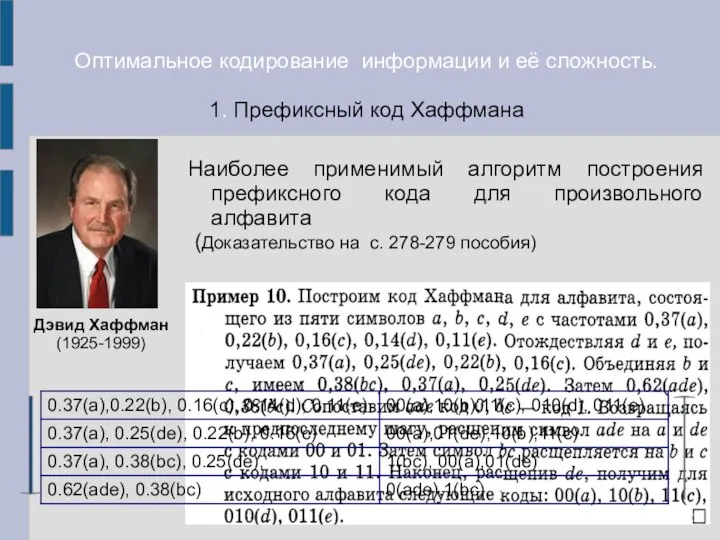

- 15. Оптимальное кодирование информации и её сложность. 1. Префиксный код Хаффмана Наиболее применимый алгоритм построения префиксного кода

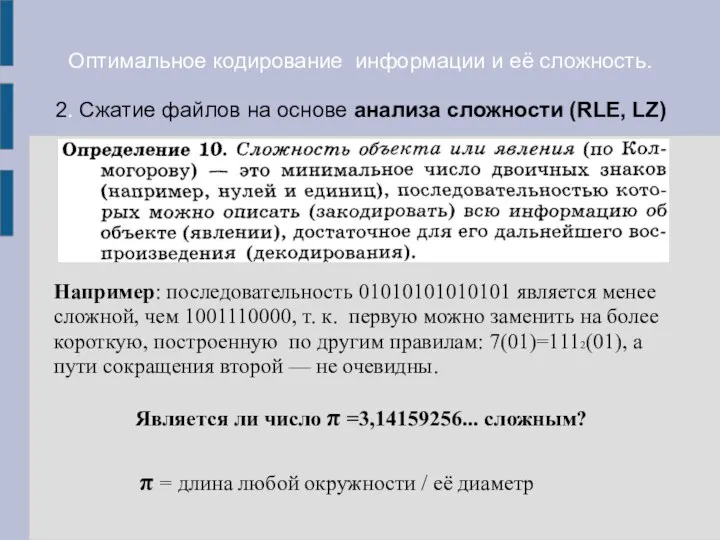

- 16. Оптимальное кодирование информации и её сложность. 2. Сжатие файлов на основе анализа сложности (RLE, LZ) Например:

- 18. Скачать презентацию

История развития вычислительной техники

История развития вычислительной техники Software Engineering Fundamentals (SEF): MS.NET Design Patterns

Software Engineering Fundamentals (SEF): MS.NET Design Patterns Исследование для компании Мегафон. Удовлетворенность качеством связи у МегаФон

Исследование для компании Мегафон. Удовлетворенность качеством связи у МегаФон Получение информации о последних событиях в мире

Получение информации о последних событиях в мире Элементы языка программирования. Паскаль

Элементы языка программирования. Паскаль Измерение информации. Алфавитный (объемный) подход. Лекция №2

Измерение информации. Алфавитный (объемный) подход. Лекция №2 Словесное описание модели

Словесное описание модели Искусственный интеллект и системы искусственного интеллекта

Искусственный интеллект и системы искусственного интеллекта Измерения и дискретизация

Измерения и дискретизация ООО Теком. Проекты CallCenter, Энергетика 2.0, Выносной Контроллер

ООО Теком. Проекты CallCenter, Энергетика 2.0, Выносной Контроллер История социально сети Вконтакте

История социально сети Вконтакте Тайны шифрования

Тайны шифрования Псевдослучайные последовательности и процедуры их машинной генерации

Псевдослучайные последовательности и процедуры их машинной генерации Компьютерная графика (Autodesk 3ds max). Создание и работа с примитивами. Управление объектами. (Лекция 2.2)

Компьютерная графика (Autodesk 3ds max). Создание и работа с примитивами. Управление объектами. (Лекция 2.2) Нахождение сайта в ТОП 10 поисковой выдачи. Предложение по сотрудничеству

Нахождение сайта в ТОП 10 поисковой выдачи. Предложение по сотрудничеству Перспективы продвижения ореха грецкого в Центральном Черноземье

Перспективы продвижения ореха грецкого в Центральном Черноземье Информационная система ателье

Информационная система ателье Живые рисунки на компьютере

Живые рисунки на компьютере Cистемный блок и системная плата

Cистемный блок и системная плата Антифрод-системы

Антифрод-системы Перспективы развития и применения информационно-правовых систем

Перспективы развития и применения информационно-правовых систем Актуальные способы мошенничества и защита от них

Актуальные способы мошенничества и защита от них Kofax. Настраиваемые (обучаемые) локаторы для счет-фактуры

Kofax. Настраиваемые (обучаемые) локаторы для счет-фактуры Библиотека знаний PLM урал

Библиотека знаний PLM урал Организация ввода и вывода данных

Организация ввода и вывода данных В мире информатики

В мире информатики Операторы языка C#. (Лекция 3)

Операторы языка C#. (Лекция 3) Методы быстрого прототипирования

Методы быстрого прототипирования