Слайд 2OpenMP: Что это?

Стандарт, позволяющий распараллеливать вычисления на системах с общей памятью.

Преимущества:

Простота использования.

Переносимость.

Низкие

накладные расходы.

Поддержка параллелизма по данным.

Слайд 3Синтаксис

Compiler directives:

C/C++

#pragma omp directive [clause, …]

Fortran

!$OMP directive [clause, …]

C$OMP directive [clause, …]

*$OMP

![Синтаксис Compiler directives: C/C++ #pragma omp directive [clause, …] Fortran !$OMP directive](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/423764/slide-2.jpg)

directive [clause, …]

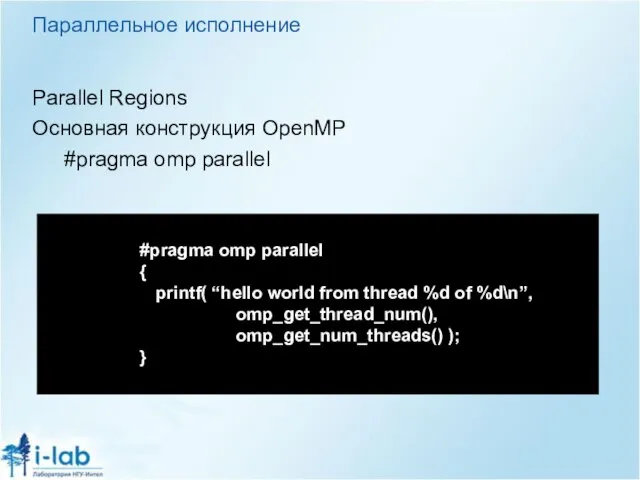

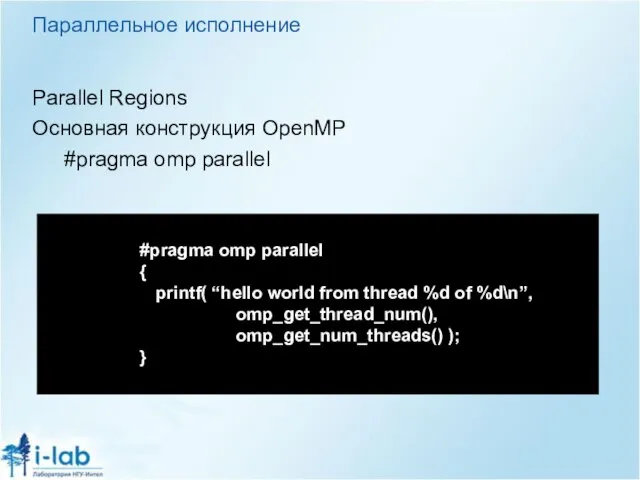

Слайд 4Параллельное исполнение

Parallel Regions

Основная конструкция OpenMP

#pragma omp parallel

#pragma omp parallel

{

printf( “hello world from

thread %d of %d\n”, omp_get_thread_num(),

omp_get_num_threads() );

}

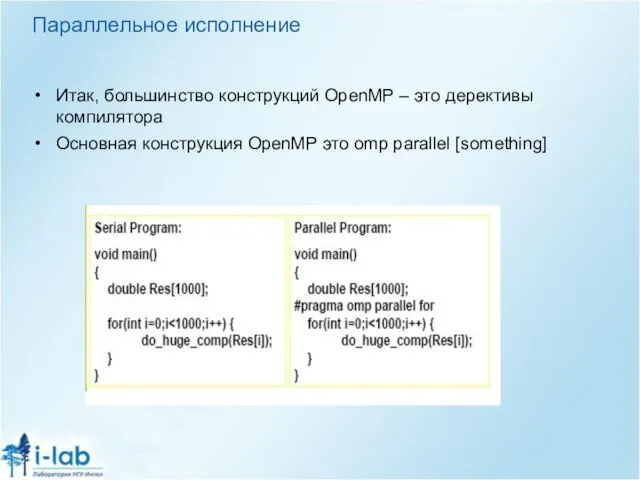

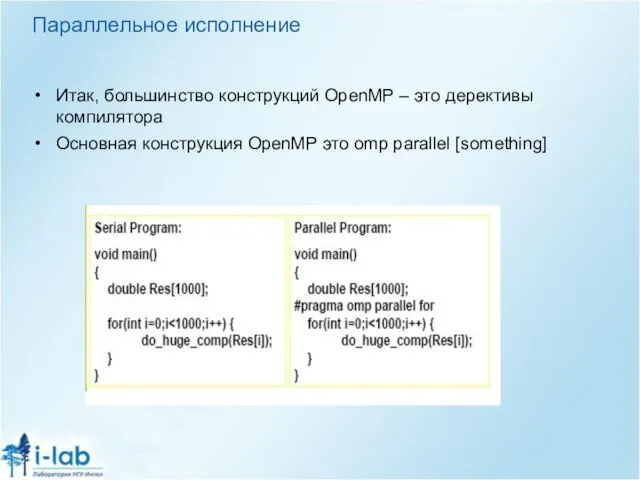

Слайд 5Параллельное исполнение

Итак, большинство конструкций OpenMP – это дерективы компилятора

Основная конструкция OpenMP это

omp parallel [something]

Слайд 6OpenMP подход к параллелизму

OpenMP основано на модели разделяемой памяти.

Вычислительная задача распределяется на

потоки.

– Переменные могут быть

• общими для всех потоков;

• или каждый поток работает со своей независимой копией.

Неосторожное или неправильное использование переменных может привести к неверной работе распараллеленной программы.

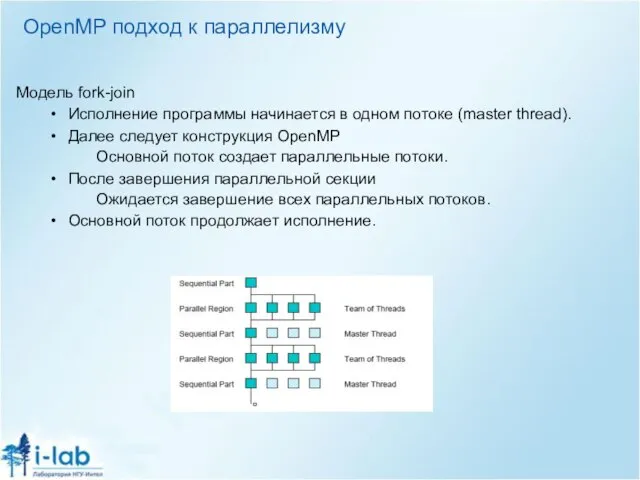

Слайд 7OpenMP подход к параллелизму

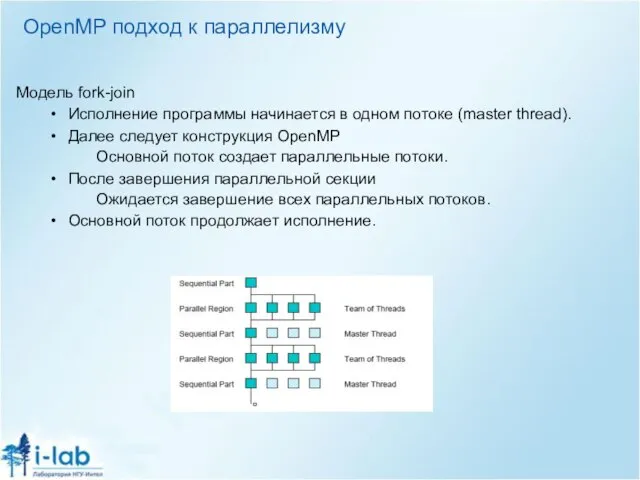

Модель fork-join

Исполнение программы начинается в одном потоке (master thread).

Далее

следует конструкция OpenMP

Основной поток создает параллельные потоки.

После завершения параллельной секции

Ожидается завершение всех параллельных потоков.

Основной поток продолжает исполнение.

Слайд 8Основные конструкции OpenMP

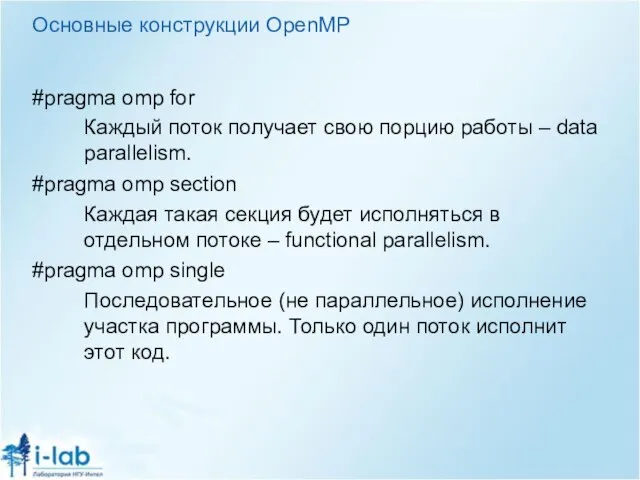

#pragma omp for

Каждый поток получает свою порцию работы – data

parallelism.

#pragma omp section

Каждая такая секция будет исполняться в отдельном потоке – functional parallelism.

#pragma omp single

Последовательное (не параллельное) исполнение участка программы. Только один поток исполнит этот код.

Слайд 9OpenMP sections

#pragma omp sections [ clause [ clause ] ... ] new-line

{

[#pragma

![OpenMP sections #pragma omp sections [ clause [ clause ] ... ]](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/423764/slide-8.jpg)

omp section new-line ]

structured-block1

[#pragma omp section new-line

structured-block2 ]

...

}

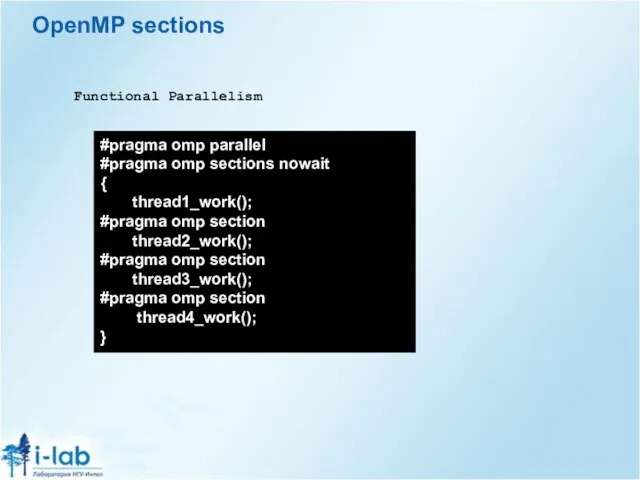

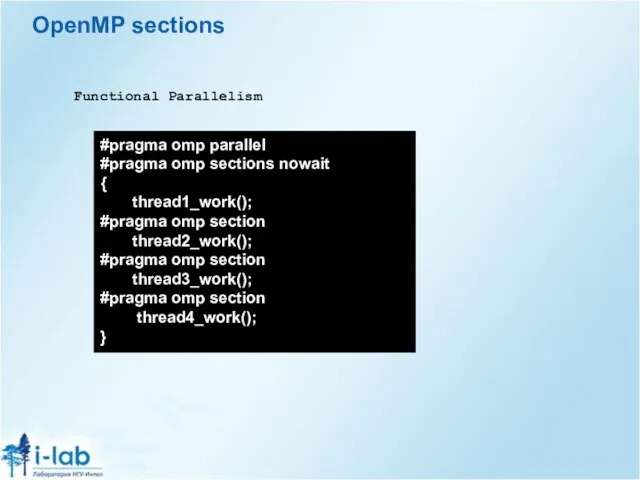

Слайд 10OpenMP sections

#pragma omp parallel

#pragma omp sections nowait

{

thread1_work();

#pragma omp section

thread2_work();

#pragma omp section

thread3_work();

#pragma omp

section

thread4_work();

}

Functional Parallelism

Слайд 11OpenMP for directive

#pragma omp for [ clause [ clause ] ...

Непосредственно

![OpenMP for directive #pragma omp for [ clause [ clause ] ...](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/423764/slide-10.jpg)

следующий за директивой цикл будет исполнен параллельно (будет разделён по данным между исполнителями).

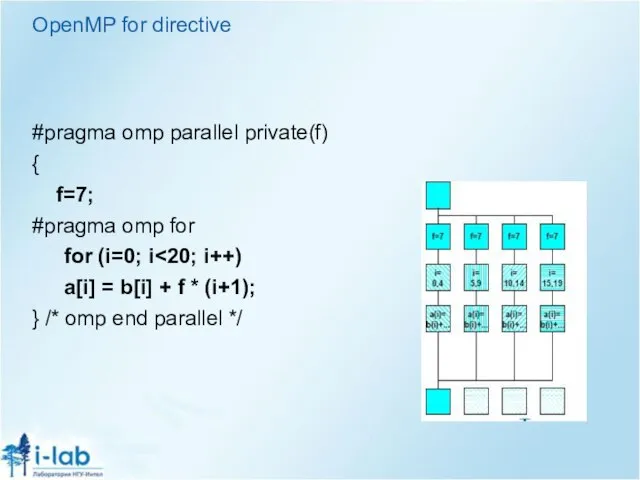

Слайд 12OpenMP for directive

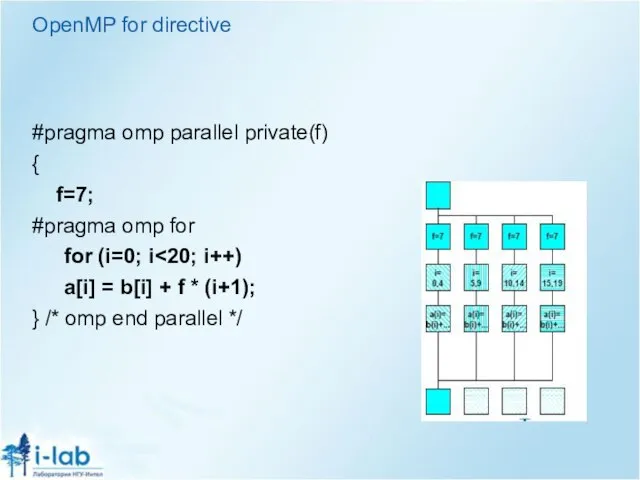

#pragma omp parallel private(f)

{

f=7;

#pragma omp for

for (i=0; i<20; i++)

a[i] =

b[i] + f * (i+1);

} /* omp end parallel */

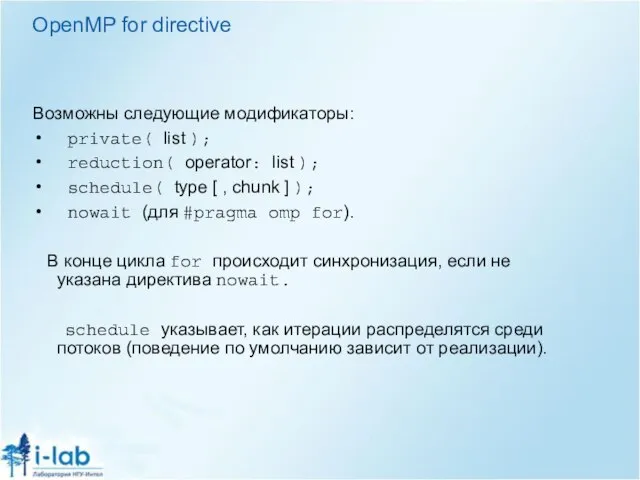

Слайд 13OpenMP for directive

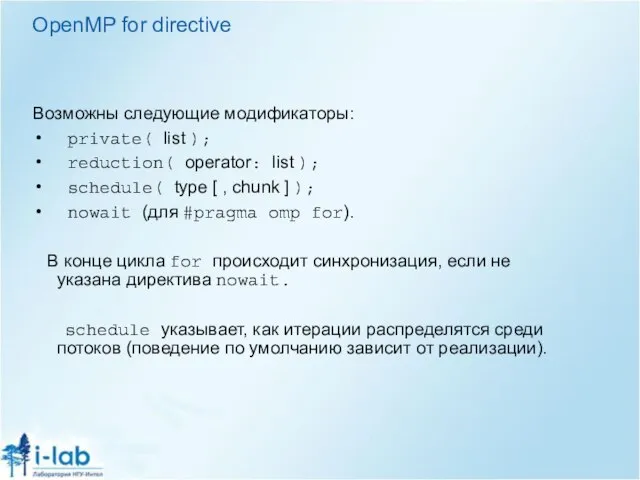

Возможны следующие модификаторы:

private( list );

reduction( operator: list );

schedule( type [ , chunk ] );

nowait (для #pragma omp for).

В конце цикла for происходит синхронизация, если не указана директива nowait.

schedule указывает, как итерации распределятся среди потоков (поведение по умолчанию зависит от реализации).

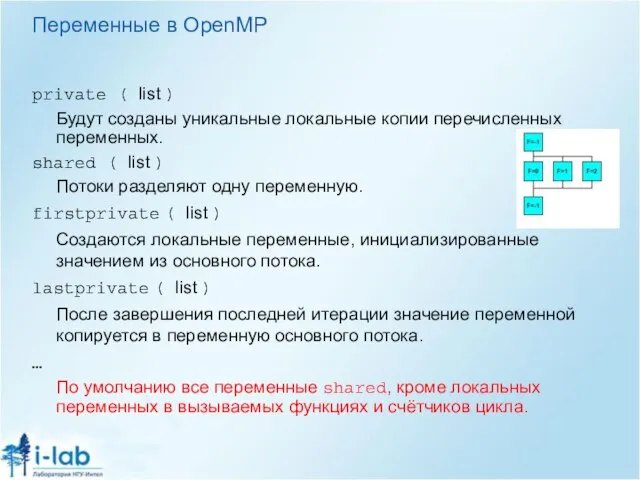

Слайд 14Переменные в OpenMP

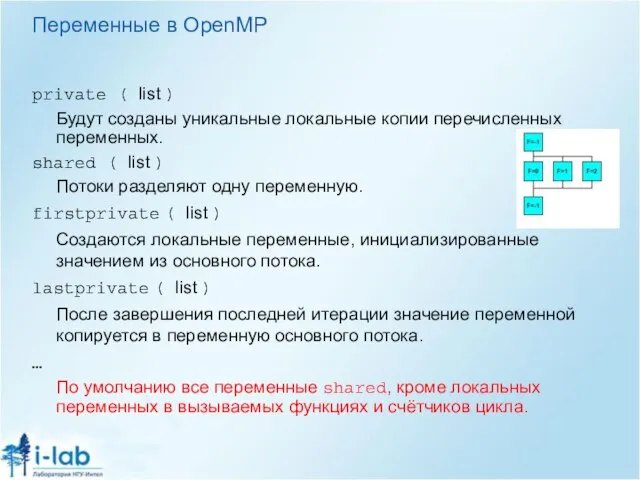

private ( list )

Будут созданы уникальные локальные копии перечисленных переменных.

shared

( list )

Потоки разделяют одну переменную.

firstprivate ( list )

Создаются локальные переменные, инициализированные значением из основного потока.

lastprivate ( list )

После завершения последней итерации значение переменной копируется в переменную основного потока.

…

По умолчанию все переменные shared, кроме локальных переменных в вызываемых функциях и счётчиков цикла.

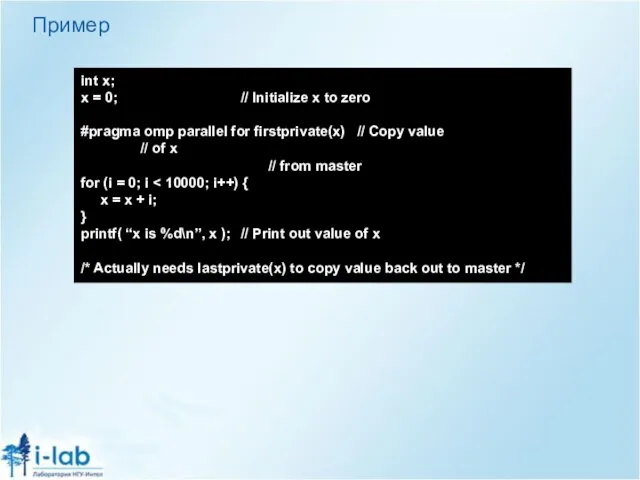

Слайд 15Пример

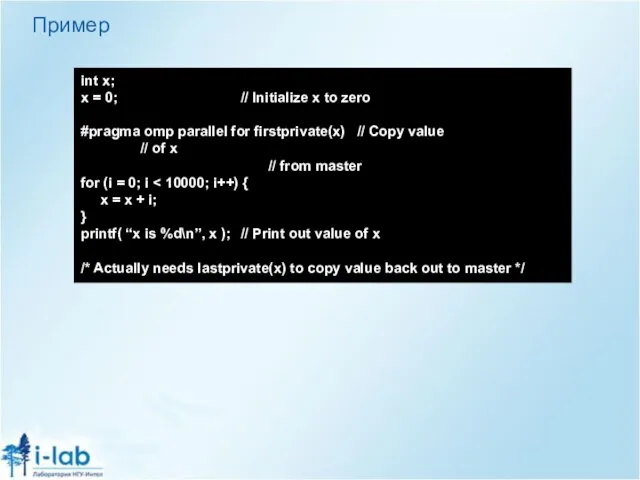

int x;

x = 0; // Initialize x to zero

#pragma omp parallel for firstprivate(x)

// Copy value // of x

// from master

for (i = 0; i < 10000; i++) {

x = x + i;

}

printf( “x is %d\n”, x ); // Print out value of x

/* Actually needs lastprivate(x) to copy value back out to master */

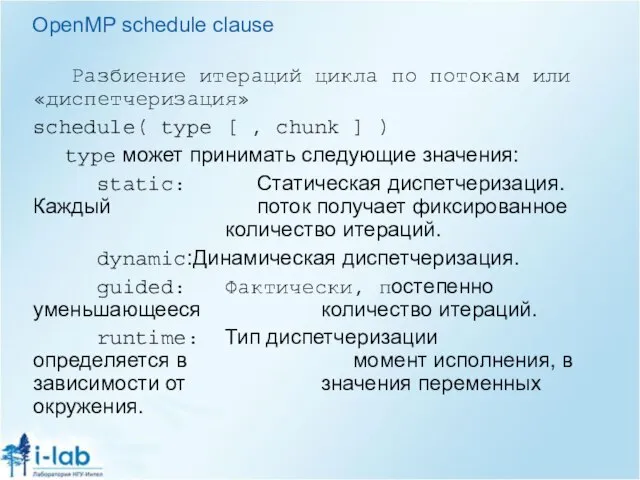

Слайд 16OpenMP schedule clause

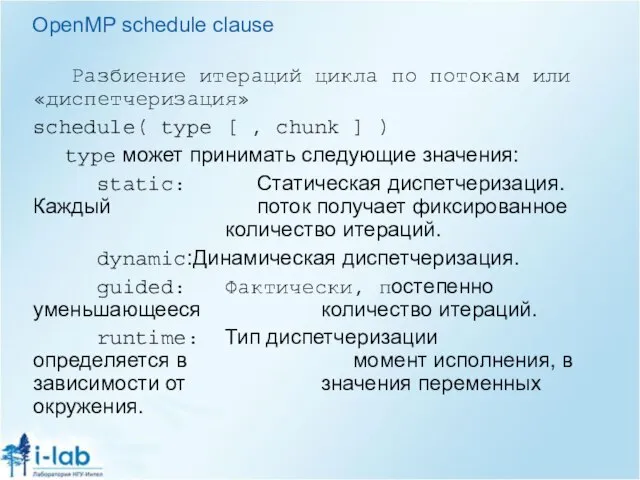

Разбиение итераций цикла по потокам или «диспетчеризация»

schedule( type [

, chunk ] )

type может принимать следующие значения:

static: Статическая диспетчеризация. Каждый поток получает фиксированное количество итераций.

dynamic: Динамическая диспетчеризация.

guided: Фактически, постепенно уменьшающееся количество итераций.

runtime: Тип диспетчеризации определяется в момент исполнения, в зависимости от значения переменных окружения.

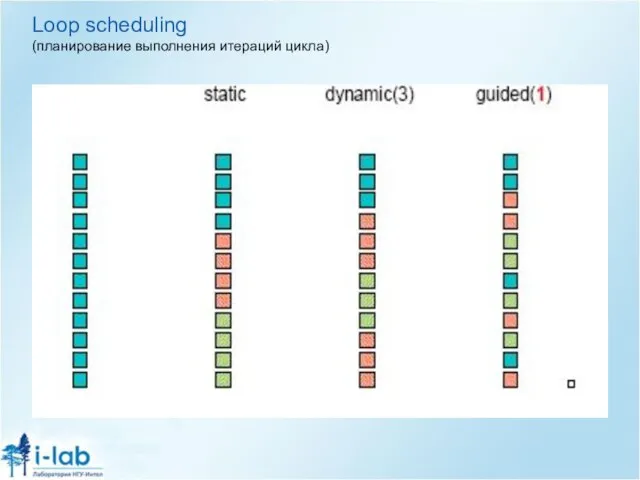

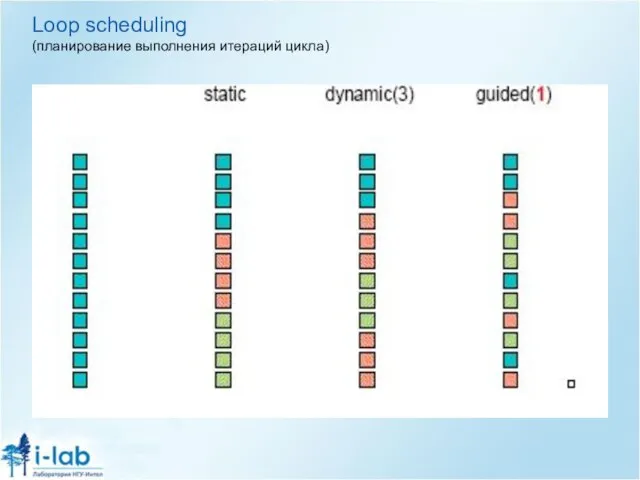

Слайд 17Loop scheduling

(планирование выполнения итераций цикла)

Слайд 18Основные функции OpenMP

int omp_get_num_threads(void);

int omp_get_thread_num(void);

…

http://www.openmp.org/

Слайд 19Синхронизация в OpenMP

Неявная синхронизация происходит в начале и конце любой конструкции

parallel

(до тех пор, пока не указана директива nowait).

Слайд 20Синхронизация в OpenMP

сritical – критическая секция. Не может исполняться одновременно несколькими потоками.

atomic

– специальная версия критической секции для атомарных операций (таких, как запись переменной).

barrier – точка синхронизации всех потоков.

ordered – последовательное исполнение.

master – только основной поток исполняет следующий код.

…

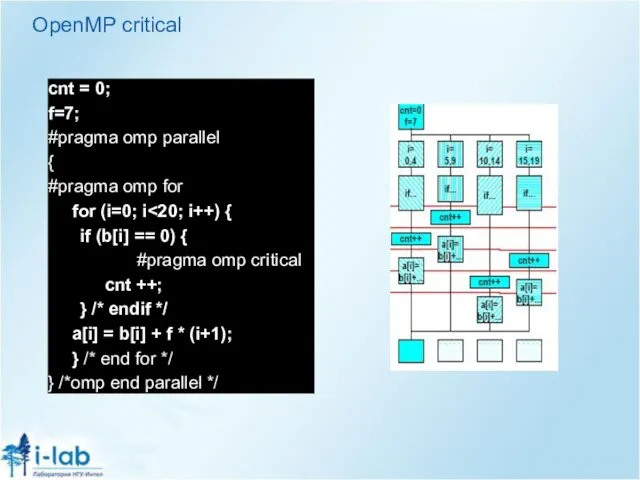

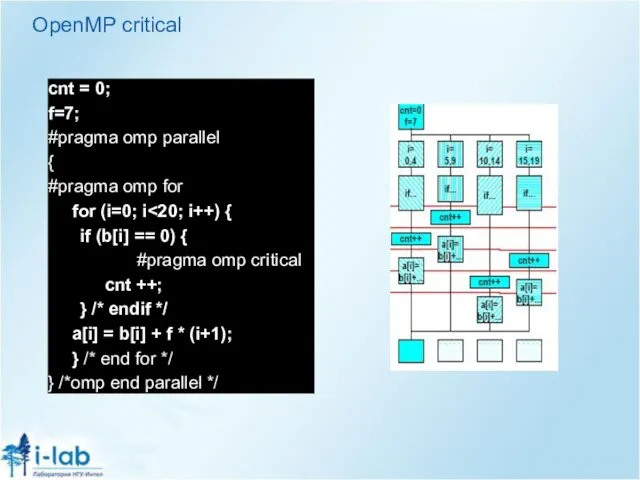

Слайд 21OpenMP critical

cnt = 0;

f=7;

#pragma omp parallel

{

#pragma omp for

for (i=0; i<20; i++) {

if

(b[i] == 0) {

#pragma omp critical

cnt ++;

} /* endif */

a[i] = b[i] + f * (i+1);

} /* end for */

} /*omp end parallel */

Слайд 22Полная информация

OpenMP Homepage: http://www.openmp.org/

Introduction to OpenMP - tutorial from WOMPEI 2000 (link)

Writing and Tuning OpenMP Programs on Distributed Shared Memory Machines (link)

R.Chandra, L. Dagum, D. Kohr, D. Maydan, J. McDonald, R. Menon:

Parallel programming in OpenMP.

Academic Press, San Diego, USA, 2000, ISBN 1-55860-671-8

R. Eigenmann, Michael J. Voss (Eds):

OpenMP Shared Memory Parallel Programming.

Springer LNCS 2104, Berlin, 2001, ISBN 3-540-42346-X

![Синтаксис Compiler directives: C/C++ #pragma omp directive [clause, …] Fortran !$OMP directive](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/423764/slide-2.jpg)

![OpenMP sections #pragma omp sections [ clause [ clause ] ... ]](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/423764/slide-8.jpg)

![OpenMP for directive #pragma omp for [ clause [ clause ] ...](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/423764/slide-10.jpg)

Отдых в загородном оздоровительном лагере – это…

Отдых в загородном оздоровительном лагере – это… Учебно-методические комплексы и цифровые образовательные ресурсы по химии как составляющая часть подготовки к ГИА

Учебно-методические комплексы и цифровые образовательные ресурсы по химии как составляющая часть подготовки к ГИА Интерьер – средство создания пространственно-вещной среды интерьера

Интерьер – средство создания пространственно-вещной среды интерьера Staffing the Lodging

Staffing the Lodging История болезни. Клинический диагноз

История болезни. Клинический диагноз Телеканал РБК+

Телеканал РБК+ Книга образов Style book для Натальи Бакулевой. Курс Найди свой стиль

Книга образов Style book для Натальи Бакулевой. Курс Найди свой стиль Проектная деятельность как метод совершенствования коммуникативной компетентности младшего школьника.

Проектная деятельность как метод совершенствования коммуникативной компетентности младшего школьника. Проведение экспертной оценки качества хлеба реализуемого в магазинах торговых сетей Смак

Проведение экспертной оценки качества хлеба реализуемого в магазинах торговых сетей Смак Жизнь и приключения Дятла Вуди

Жизнь и приключения Дятла Вуди Реки Тамбовской области

Реки Тамбовской области Презентация на тему Законы Менделя

Презентация на тему Законы Менделя  Палеозой. Ордовик

Палеозой. Ордовик Школа правовой и финансовой грамотности Основа

Школа правовой и финансовой грамотности Основа Социальные нормы преступность

Социальные нормы преступность Клиника и диагностика хронического панкреатита Докладчик: Цивковский В.Ю. 6 курс, лечебный факультет.

Клиника и диагностика хронического панкреатита Докладчик: Цивковский В.Ю. 6 курс, лечебный факультет. Механизация уплотнения кормов и обработки корнеклубнеплодов

Механизация уплотнения кормов и обработки корнеклубнеплодов Персидская кошка

Персидская кошка BYK Факты & цифры

BYK Факты & цифры Аварийные службы Петербурга

Аварийные службы Петербурга Fit for partnership with Germany

Fit for partnership with Germany Титульный лист кадетка

Титульный лист кадетка Выпуск печатного издания «Наш мир» и оказание полиграфических услуг населению

Выпуск печатного издания «Наш мир» и оказание полиграфических услуг населению Презентация на тему Вредные привычки

Презентация на тему Вредные привычки  Imperfectum onregelmatig Ik val – ik viel

Imperfectum onregelmatig Ik val – ik viel Принципы лечения острых кровотечений

Принципы лечения острых кровотечений Русская-народная сказка Кот, петух и лиса

Русская-народная сказка Кот, петух и лиса Презентация на тему Робототехника и искусственный интеллект

Презентация на тему Робототехника и искусственный интеллект