- Главная

- Информатика

- PR в поисковых системах

Содержание

- 2. Рекламные возможности и форматы первого экрана поисковых машин Деньги, время, эффективность… Баннер на главной странице (большой

- 3. Поисковые алгоритмы совершенствуются Поисковые машины постоянно улучшают работу своих алгоритмов для того, чтобы поисковая выдача была

- 4. Что можно задействовать в органике помимо собственного сайта? Изучайте поисковую выдачу по своим ключевым запросам. Помимо

- 5. Работа с информационными площадками Если в топе по нужной вам группе поисковых запросов есть информационный ресурс,

- 6. Пишите для людей Для того, чтобы создать успешную контентную рекламную кампанию нужно: четко понимать свою целевую

- 7. Уважайте своего потенциального клиента Если дать читателю действительно полезный контент, то он будет воспринимать данную информацию

- 8. Статьи сравнительного типа (имидж) Многие интернет пользователи ищут в интернете информацию сравнительного характера, особенно когда у

- 9. Работайте с аудиторией в смежных областях После того как вы научились собирать прямую целевую аудиторию, можно

- 10. Проводите отстройку от конкурентов Можно забирать аудиторию через инфо-поводы, определенные тренды или формировать спрос с нуля.

- 11. Работайте над укреплением бренда Зачастую, узнав о вашей компании, перед принятием решения о сотрудничестве, интернет пользователь

- 12. Работает ли формат нативной рекламы? Формат нативной рекламы, где рекламные блоки являются логичным продолжением контента статьи,

- 13. Качество данного трафика Так как на сайт рекламодателя перейдет лишь целевая аудитория, которая до этого прошла

- 15. Скачать презентацию

Слайд 2Рекламные возможности и форматы первого экрана поисковых машин

Деньги, время, эффективность…

Баннер на главной

Рекламные возможности и форматы первого экрана поисковых машин

Деньги, время, эффективность…

Баннер на главной

Блок контекстной рекламы (быстро, но дорого)

Органическая выдача поисковых машин (эффективно, но долго)

По одежке встречают! – это правило работает и на поиске.

Следите за тем как оформлено ваше обращение к интернет пользователю, тут важно все, мелочей не бывает: организуйте информативный Title, интересный сниппет, добавьте быстрые ссылки, покажите сразу адрес и телефон для удобной коммуникации.

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Слайд 3Поисковые алгоритмы совершенствуются

Поисковые машины постоянно улучшают работу своих алгоритмов для того, чтобы

Поисковые алгоритмы совершенствуются

Поисковые машины постоянно улучшают работу своих алгоритмов для того, чтобы

Но так как доля уникальных неповторяющихся поисковых запросов в сутки составляет 30-40% от общей массы, то задача создания релевантного топа оказалась очень сложна.

Для решения проблемы сложных запросов появился алгоритм “Палех” – он работает на основе использования нейронных сетей для ранжирования сайтов. Если раньше ранжирование базировалось на количестве вхождения ключевых слов, ссылочном профиле сайта, его индикативных показателях, поведенческих характеристиках аудитории, уникальности дизайна и контента и более 150 других разноплановых факторов, то сейчас Яндексу удалось обучить алгоритм распознавать страницы с подходящим содержимым, что должно обеспечить более релевантную поисковому запросу выдачу.

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Слайд 4Что можно задействовать в органике помимо собственного сайта?

Изучайте поисковую выдачу по своим

Что можно задействовать в органике помимо собственного сайта?

Изучайте поисковую выдачу по своим

Помимо сайтов конкурентов (корпоративные сайты, интернет магазины), там в обязательном порядке будут те позиции, с которыми можно эффективно взаимодействовать и превращать их из конкурентов за место в поисковой выдаче в реферальные каналы трафика.

Поисковые подсказки

Яндекс Маркет

Картографические сервисы и каталоги (yell, zoon, 2gis …)

Википедия

Информационные ресурсы \ СМИ

Сайты отзовики

Блок с картинками и видео

Базы резюме, вакансий и отзывов, корпоративные соц сети (брендовые запросы)

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Слайд 5Работа с информационными площадками

Если в топе по нужной вам группе поисковых запросов

Работа с информационными площадками

Если в топе по нужной вам группе поисковых запросов

Возможные варианты:

Брендирование материала;

Интеграция в материал баннера, ссылки для перехода;

Интеграция в материал формы для генерации лидов или кнопки “call to action”.

Что делать, если таких материалов нет, правильно – создать с нуля!

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Слайд 6Пишите для людей

Для того, чтобы создать успешную контентную рекламную кампанию нужно:

четко понимать

Пишите для людей

Для того, чтобы создать успешную контентную рекламную кампанию нужно:

четко понимать

знать как эта целевая аудитория формирует свою потребность в интернете;

подготовить полезный независимый редакционный контент, действительно помогающий вашему потенциальному клиенту получить исчерпывающую полезную информацию и определиться с выбором товара или услуги.

Зачастую доверие к информации (качество коммуникации) оказывается даже важнее чем такие факторы как цена, логистика, удобство расположения и тд.

Клиент должен чувствовать, что он работает с профессионалами, обладающими необходимой экспертизой в интересующем его вопросе!

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Слайд 7Уважайте своего потенциального клиента

Если дать читателю действительно полезный контент, то он будет

Уважайте своего потенциального клиента

Если дать читателю действительно полезный контент, то он будет

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Кейс – Барьер.

Объект рекламирования – кувшины, фильтры, системы водоподготовки для частных домов.

Выход на целевую аудиторию через серию информационных полезных статей, направленных на соответствующие группы поисковых запросов.

Слайд 8Статьи сравнительного типа (имидж)

Многие интернет пользователи ищут в интернете информацию сравнительного характера,

Статьи сравнительного типа (имидж)

Многие интернет пользователи ищут в интернете информацию сравнительного характера,

Это запросы вида:

- рейтинг аутстаффинговых компани - лучший кроссовер 2016 - лучшая страховая компания - рейтинг консалтинговых компаний

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Кейс – Subaru.

Объект рекламирования – автомобили Subaru.

Выход на целевую аудиторию через аналитические материалы сравнительного характера о самых популярных на данный момент на рынке кроссоверах.

Слайд 9Работайте с аудиторией в смежных областях

После того как вы научились собирать прямую

Работайте с аудиторией в смежных областях

После того как вы научились собирать прямую

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Кейс – ВТБ страхование.

Объект рекламирования – страховой полис взр.

Выход на целевую аудиторию через серию информационных полезных статей по различным туристическим направлениям.

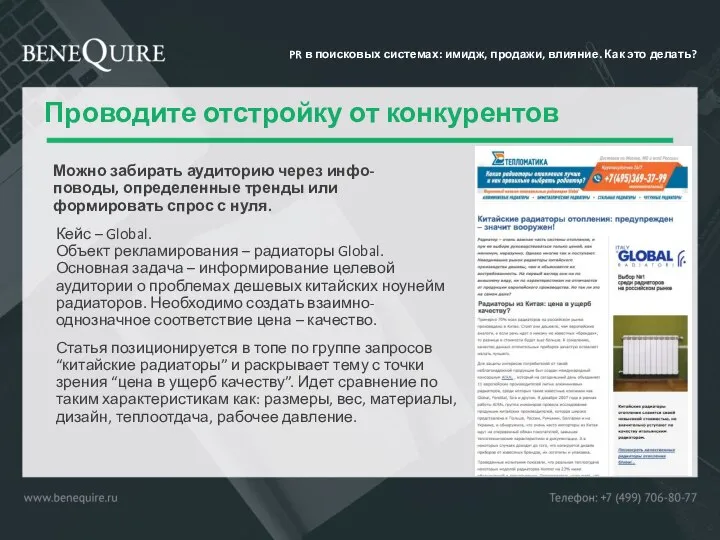

Слайд 10Проводите отстройку от конкурентов

Можно забирать аудиторию через инфо-поводы, определенные тренды или формировать

Проводите отстройку от конкурентов

Можно забирать аудиторию через инфо-поводы, определенные тренды или формировать

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Кейс – Global.

Объект рекламирования – радиаторы Global.

Основная задача – информирование целевой аудитории о проблемах дешевых китайских ноунейм радиаторов. Необходимо создать взаимно-однозначное соответствие цена – качество.

Статья позиционируется в топе по группе запросов “китайские радиаторы” и раскрывает тему с точки зрения “цена в ущерб качеству”. Идет сравнение по таким характеристикам как: размеры, вес, материалы, дизайн, теплоотдача, рабочее давление.

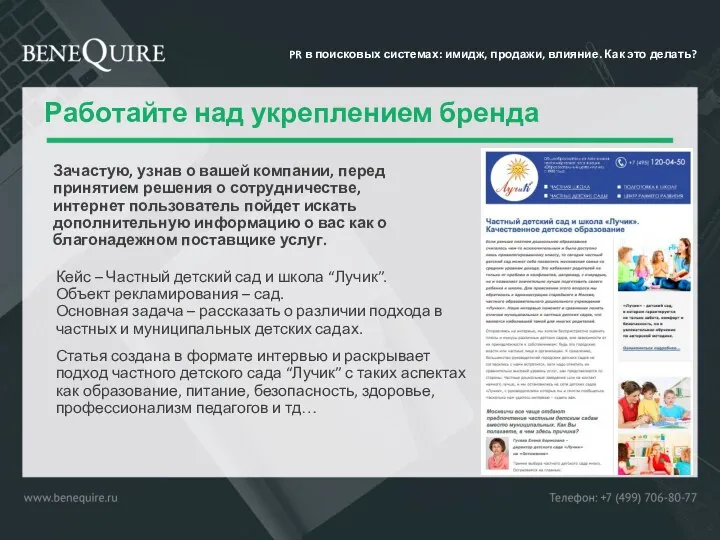

Слайд 11Работайте над укреплением бренда

Зачастую, узнав о вашей компании, перед принятием решения о

Работайте над укреплением бренда

Зачастую, узнав о вашей компании, перед принятием решения о

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Кейс – Частный детский сад и школа “Лучик”.

Объект рекламирования – сад.

Основная задача – рассказать о различии подхода в частных и муниципальных детских садах.

Статья создана в формате интервью и раскрывает подход частного детского сада “Лучик” с таких аспектах как образование, питание, безопасность, здоровье, профессионализм педагогов и тд…

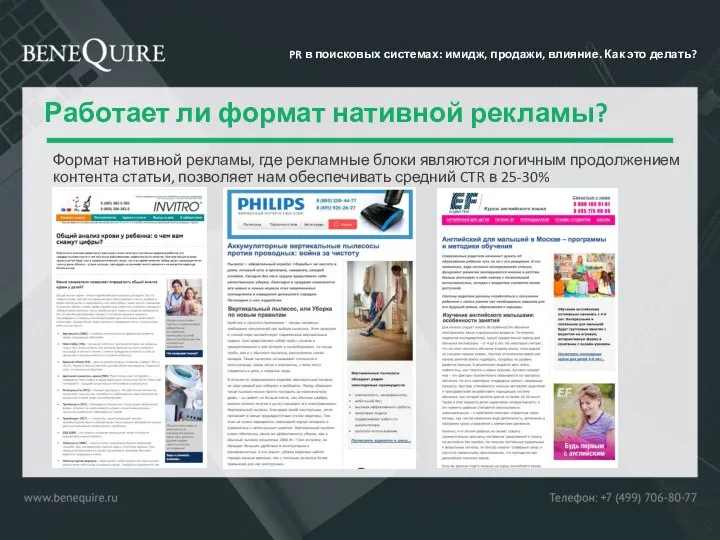

Слайд 12Работает ли формат нативной рекламы?

Формат нативной рекламы, где рекламные блоки являются логичным

Работает ли формат нативной рекламы?

Формат нативной рекламы, где рекламные блоки являются логичным

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Слайд 13Качество данного трафика

Так как на сайт рекламодателя перейдет лишь целевая аудитория, которая

Качество данного трафика

Так как на сайт рекламодателя перейдет лишь целевая аудитория, которая

По нашему опыту взаимодействие на уровне тематических статей на информационных ресурсах является важной точкой коммуникации в цепочке продаж, создавая на определенном этапе очень качественны контакт с брендом рекламодателем. Более того контентный маркетинг такого формата может создать канал с наибольшим процентом первичных контактов, которые зачастую являются самыми ценными на рынке.

Эти данные подтверждаются в ассоциированных конверсиях и многоканальных последовательностях.

PR в поисковых системах: имидж, продажи, влияние. Как это делать?

Основные принципы защиты от НСД. Основные способы НСД. Основные направления обеспечения защиты от НСД

Основные принципы защиты от НСД. Основные способы НСД. Основные направления обеспечения защиты от НСД урок 3

урок 3 Теория конечных автоматов. Задача

Теория конечных автоматов. Задача Триггеры в презентации Применение Создание слайдов с триггерами

Триггеры в презентации Применение Создание слайдов с триггерами Электронные таблицы

Электронные таблицы Условный оператор

Условный оператор Классификация и типовая организация СУБД. Основные функции СУБД. Лекция 2

Классификация и типовая организация СУБД. Основные функции СУБД. Лекция 2 Технологии программирования. Введение. Массивы, матрицы, строки

Технологии программирования. Введение. Массивы, матрицы, строки Комментарии к видео с Галиной

Комментарии к видео с Галиной Кодирование данных и структуры данных

Кодирование данных и структуры данных Инстаграм-программа Sprechen Sie Deutsch? (Разговариваете ли вы на немецком?)

Инстаграм-программа Sprechen Sie Deutsch? (Разговариваете ли вы на немецком?) Toshkent shaxridagi AYOQSHlarni hisobga olish axborot tizimini yaratish

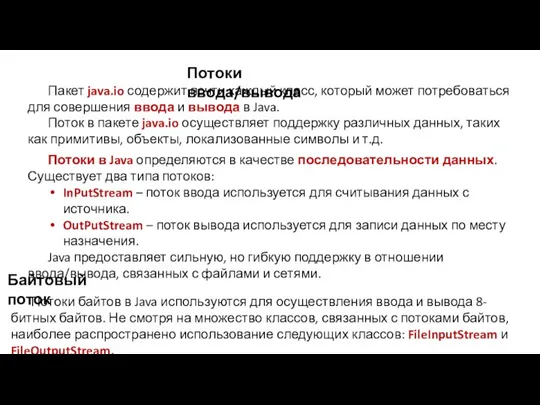

Toshkent shaxridagi AYOQSHlarni hisobga olish axborot tizimini yaratish Потоки ввода/вывода. Пример копирования данных в файл. Класс OutputStream

Потоки ввода/вывода. Пример копирования данных в файл. Класс OutputStream Плюсы интернета. Ермакович Елена,Зибницкая Александра,Безусов Виталий,Каплун Нина,Иванин Евгений,Кириченко Владислав,Казимирова

Плюсы интернета. Ермакович Елена,Зибницкая Александра,Безусов Виталий,Каплун Нина,Иванин Евгений,Кириченко Владислав,Казимирова  Моделирование. Модели

Моделирование. Модели Марафон “5 дней - 5 навыков”. Востребованные навыки в удаленной профессии

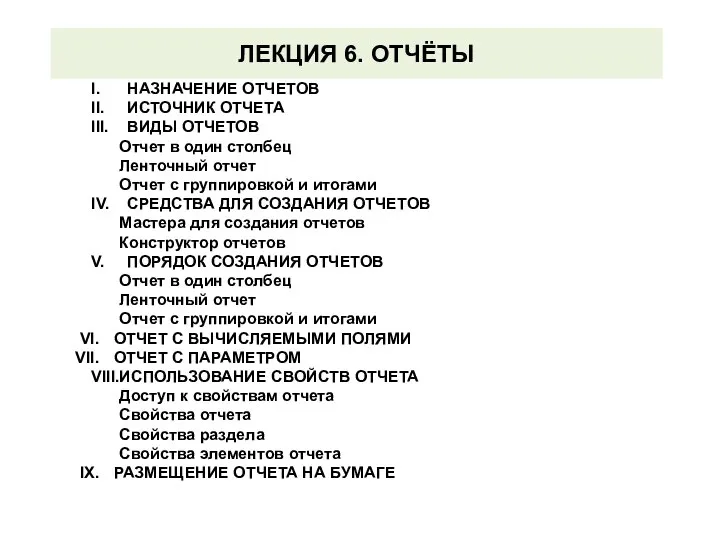

Марафон “5 дней - 5 навыков”. Востребованные навыки в удаленной профессии Отчёты. Лекция 6

Отчёты. Лекция 6 Передача информации в компьютерных сетях

Передача информации в компьютерных сетях Дистанционное обучение. Выполнение практической работы

Дистанционное обучение. Выполнение практической работы WISE² Close-out Meeting

WISE² Close-out Meeting Архикад. Методичка

Архикад. Методичка Понятие алгоритма

Понятие алгоритма urok_4-5_v3

urok_4-5_v3 Google company

Google company Лекция 3

Лекция 3 Инстаграмм Блог Sunrise

Инстаграмм Блог Sunrise Автоматизация инженерных расчетов

Автоматизация инженерных расчетов Разработка внутрикорпоративного сайта для БУ Республиканская детская клиническая больница

Разработка внутрикорпоративного сайта для БУ Республиканская детская клиническая больница