Содержание

- 2. План лекции Задачи Sequence to Sequence Архитектура энкодер-декодер Механизм внимания Tips & Tricks Разбор примера Machine

- 3. RNN Recap

- 4. RNN Recap len(input) != len(output)

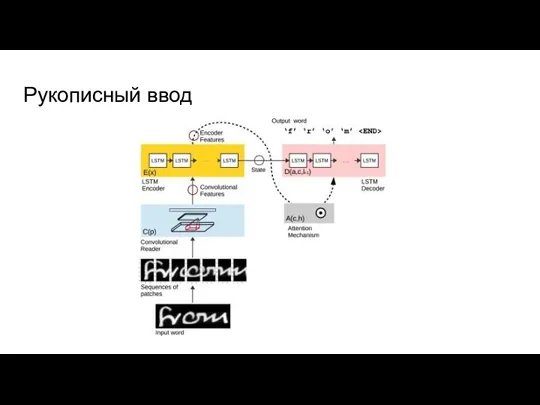

- 5. Задачи Sequence to Sequence Распознавание речи (spectrum -> text) Синтез речи (text -> waveform) Рукописный ввод

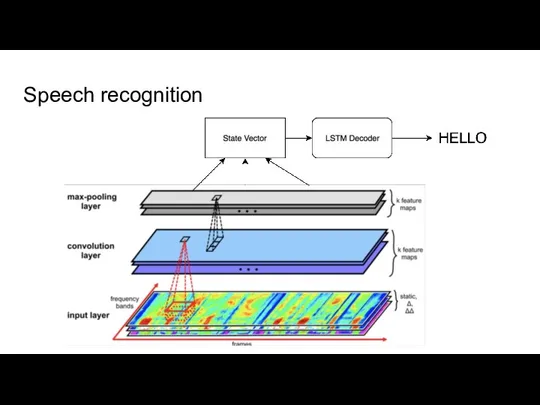

- 6. Speech recognition

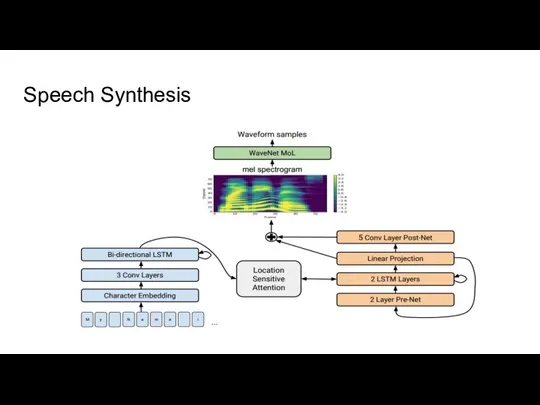

- 7. Speech Synthesis

- 8. Рукописный ввод

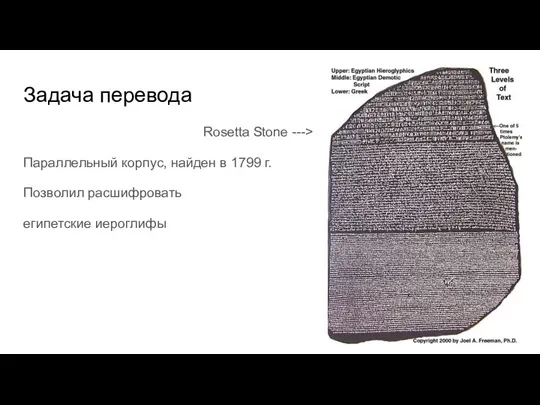

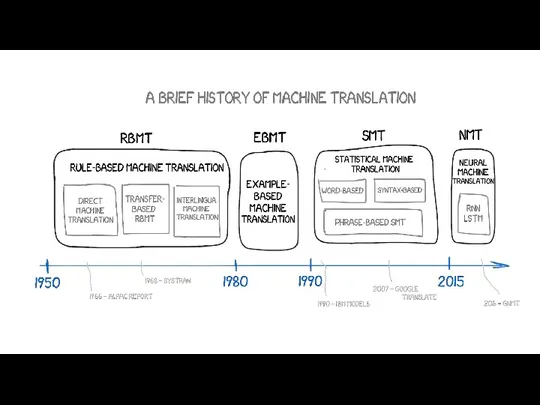

- 9. Задача перевода Rosetta Stone ---> Параллельный корпус, найден в 1799 г. Позволил расшифровать египетские иероглифы

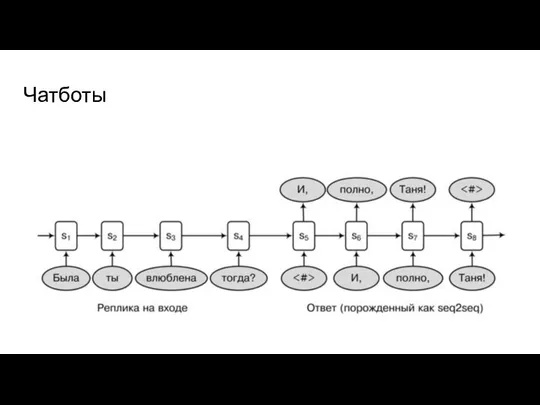

- 11. Чатботы

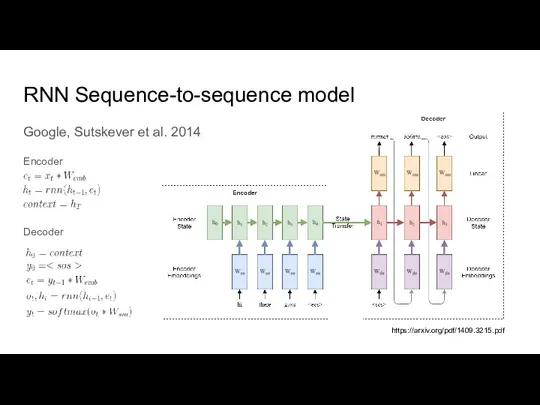

- 12. RNN Sequence-to-sequence model Google, Sutskever et al. 2014 Encoder Decoder https://arxiv.org/pdf/1409.3215.pdf

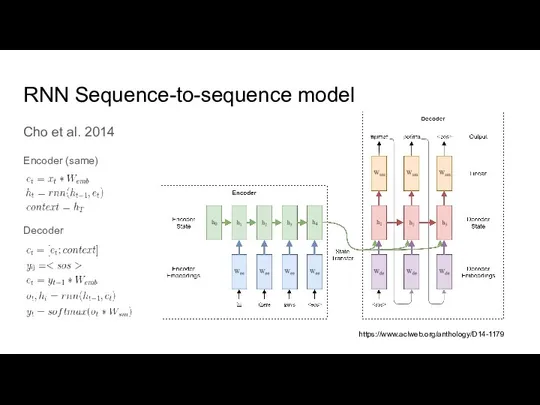

- 13. RNN Sequence-to-sequence model Cho et al. 2014 Encoder (same) Decoder https://www.aclweb.org/anthology/D14-1179

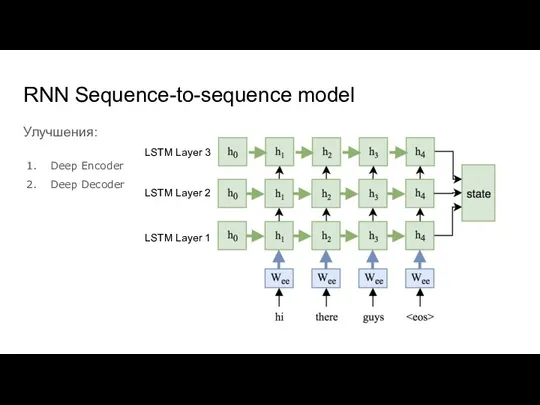

- 14. RNN Sequence-to-sequence model Улучшения: Deep Encoder Deep Decoder LSTM Layer 1 LSTM Layer 2 LSTM Layer

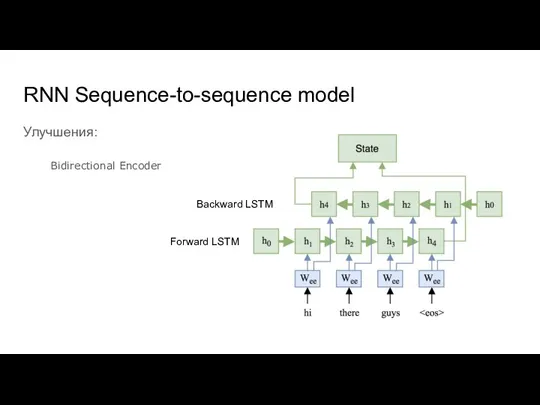

- 15. RNN Sequence-to-sequence model Улучшения: Bidirectional Encoder Forward LSTM Backward LSTM

- 16. RNN Sequence-to-sequence model Проблемы: Размер стейта фиксирован Изменения из начала последовательности затираются Не все входные токены

- 17. RNN Sequence-to-sequence model Решение: Внимание

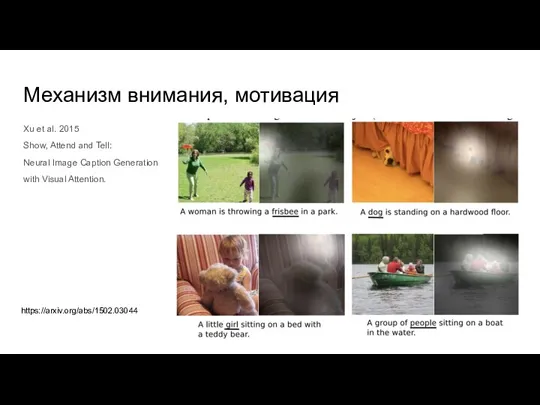

- 18. Механизм внимания, мотивация Xu et al. 2015 Show, Attend and Tell: Neural Image Caption Generation with

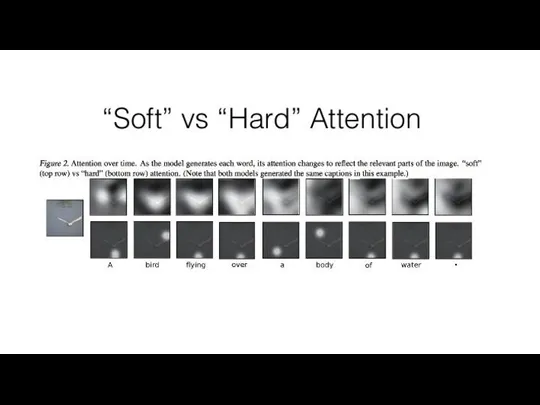

- 20. Soft vs Hard Attention Hard Выбор одной/n областей Получаем сэмплингом из softmax Не дифференцируем Нужно учить

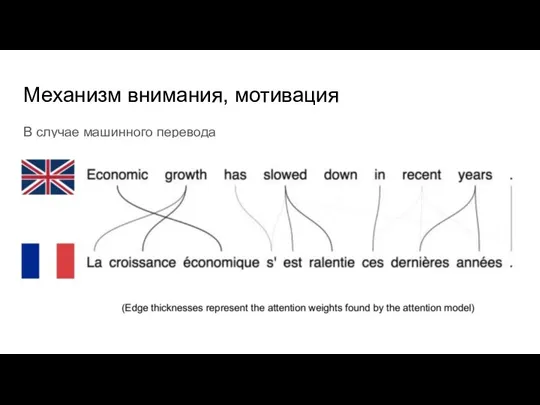

- 21. Механизм внимания, мотивация В случае машинного перевода

- 22. Механизм внимания, alignment

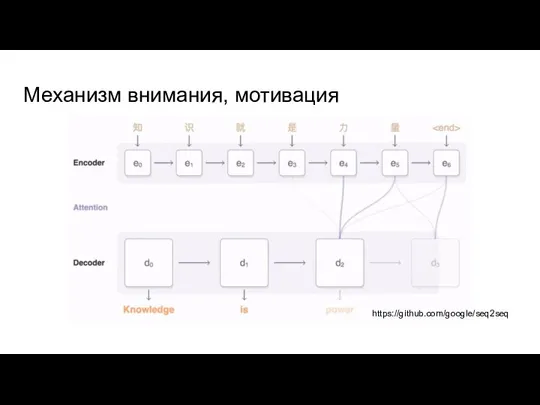

- 23. Механизм внимания, мотивация https://github.com/google/seq2seq

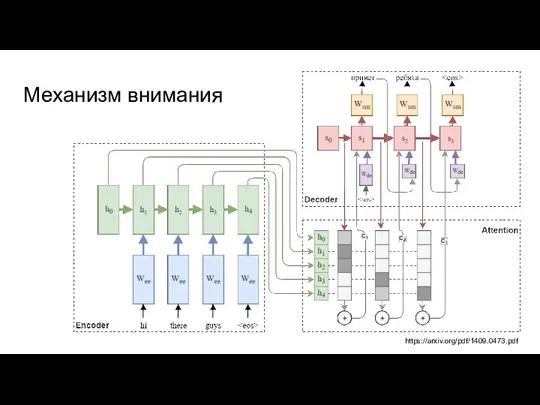

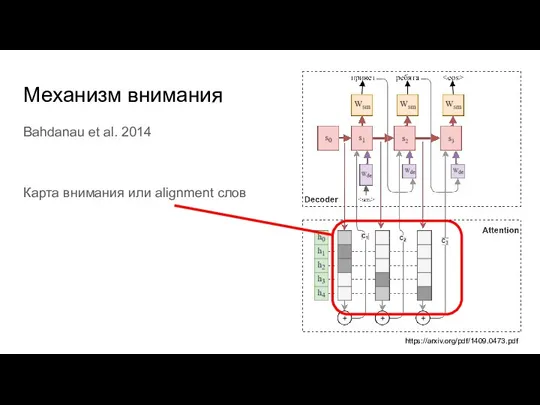

- 24. Механизм внимания https://arxiv.org/pdf/1409.0473.pdf

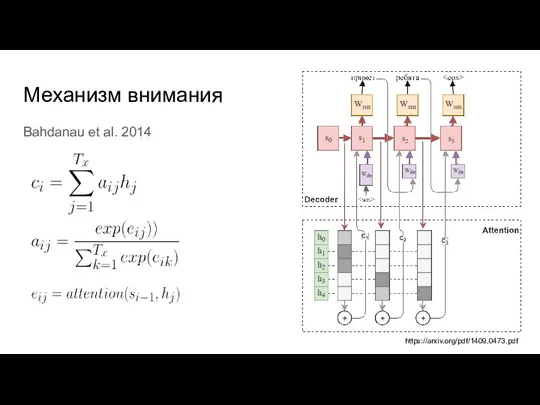

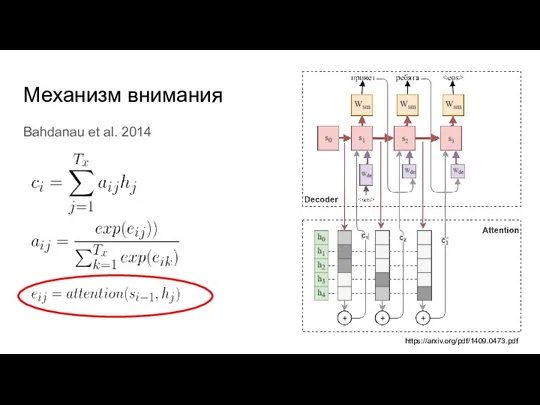

- 25. Механизм внимания Bahdanau et al. 2014 https://arxiv.org/pdf/1409.0473.pdf

- 26. Механизм внимания Bahdanau et al. 2014 Карта внимания или alignment слов https://arxiv.org/pdf/1409.0473.pdf

- 27. Механизм внимания Bahdanau et al. 2014 https://arxiv.org/pdf/1409.0473.pdf

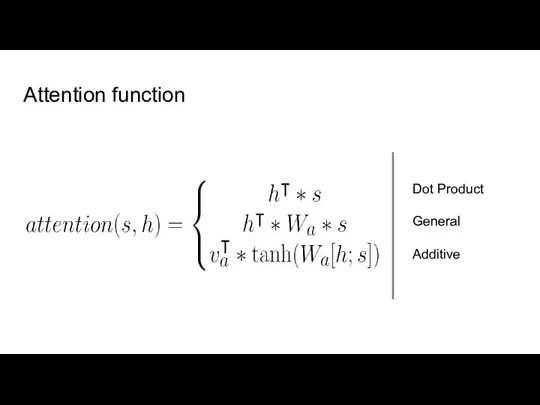

- 28. Attention function Dot Product General Additive

- 29. Практические нюансы Wordpiece models and character-based models Pretrained embeddings Multihead Attention Teacher Forcing Beam Search

- 30. Проблемы словаря большой размер эмбеддингов и софтмакс слоя (сотни тысяч) неизвестные слова при инференсе, приходится заменять

- 31. Pretrained embeddings

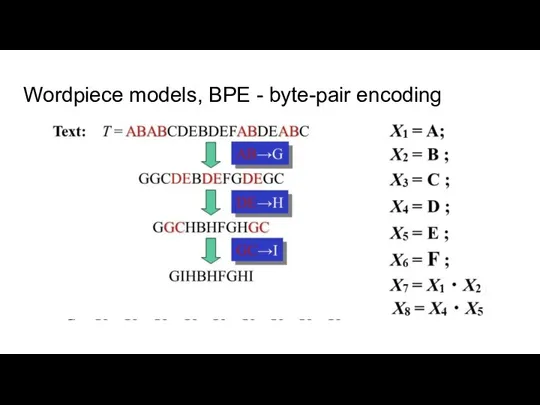

- 32. Wordpiece models, BPE - byte-pair encoding

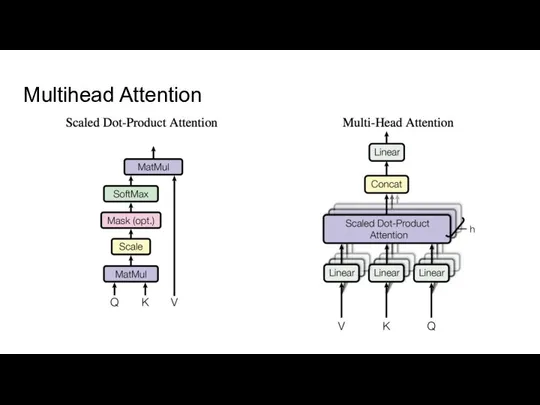

- 33. Multihead Attention

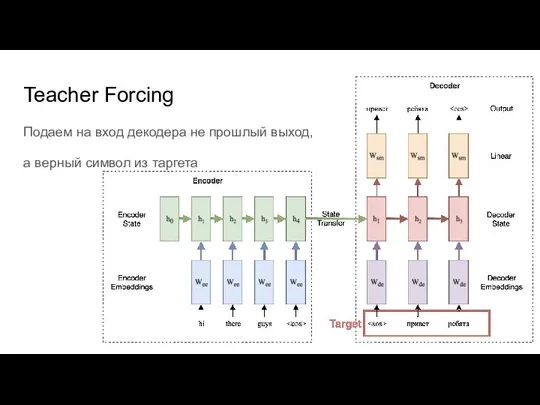

- 34. Teacher Forcing Подаем на вход декодера не прошлый выход, а верный символ из таргета

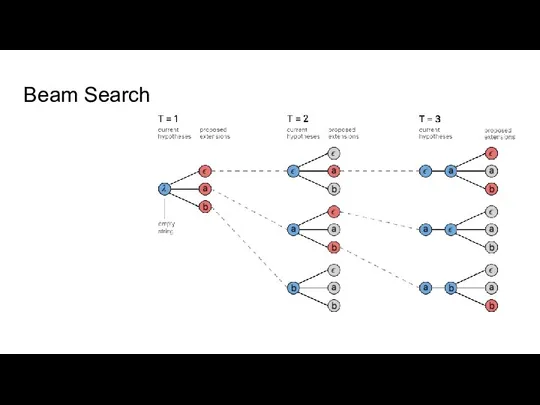

- 35. Beam Search

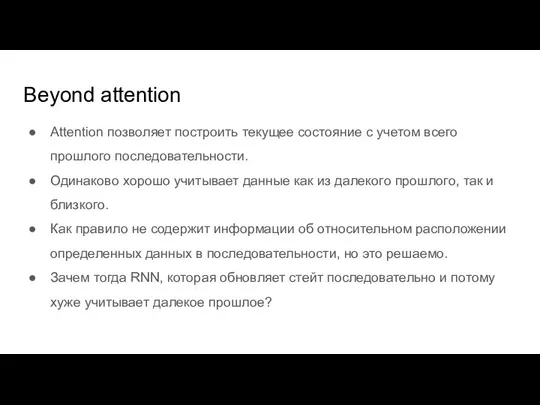

- 36. Beyond attention Attention позволяет построить текущее состояние с учетом всего прошлого последовательности. Одинаково хорошо учитывает данные

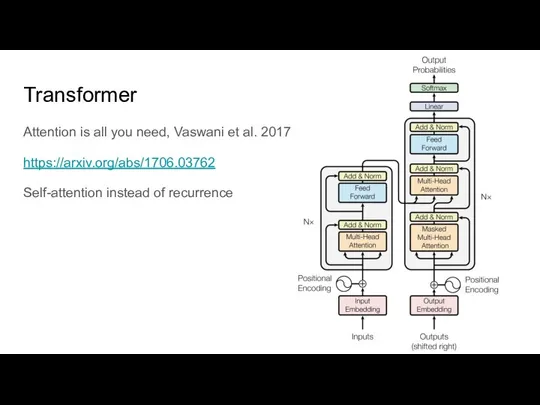

- 37. Transformer Attention is all you need, Vaswani et al. 2017 https://arxiv.org/abs/1706.03762 Self-attention instead of recurrence

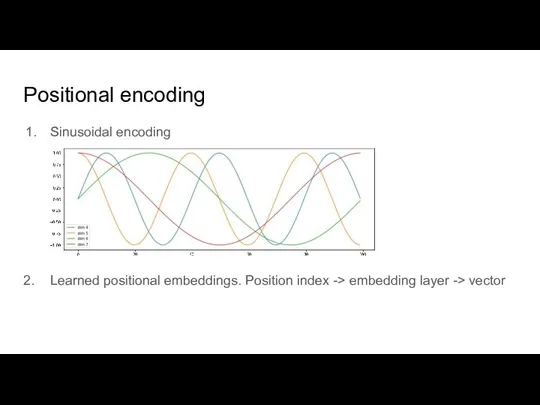

- 38. Positional encoding Sinusoidal encoding 2. Learned positional embeddings. Position index -> embedding layer -> vector

- 40. Скачать презентацию

Алгоритмизация и программирование С#. Перечисления, структуры, массивы, строки. (Лекция 6)

Алгоритмизация и программирование С#. Перечисления, структуры, массивы, строки. (Лекция 6) Презентация на тему Алгоритм и алгоритмизация

Презентация на тему Алгоритм и алгоритмизация  Итилиум. Введение

Итилиум. Введение Прокачай EA в FO

Прокачай EA в FO Задачи ЦОИ и физические принципы получения изображений

Задачи ЦОИ и физические принципы получения изображений Архивация файлов. Программы архиваторы

Архивация файлов. Программы архиваторы Приложение для изучения информатики Рlay Market

Приложение для изучения информатики Рlay Market Текстовый процессор Microsoft Word

Текстовый процессор Microsoft Word Виды пк в будущем

Виды пк в будущем Зефирки((

Зефирки(( Особенности работы МЭ на ОС Linux_Гусев

Особенности работы МЭ на ОС Linux_Гусев Оптимизация процессов публично-правовой организации. Создание базы данных

Оптимизация процессов публично-правовой организации. Создание базы данных Библиотеки Республики Марий Эл в цифровую эпоху

Библиотеки Республики Марий Эл в цифровую эпоху Устройства памяти

Устройства памяти Электронные ресурсы научной библиотеки СПбГУ по географии

Электронные ресурсы научной библиотеки СПбГУ по географии ГИА регистрация

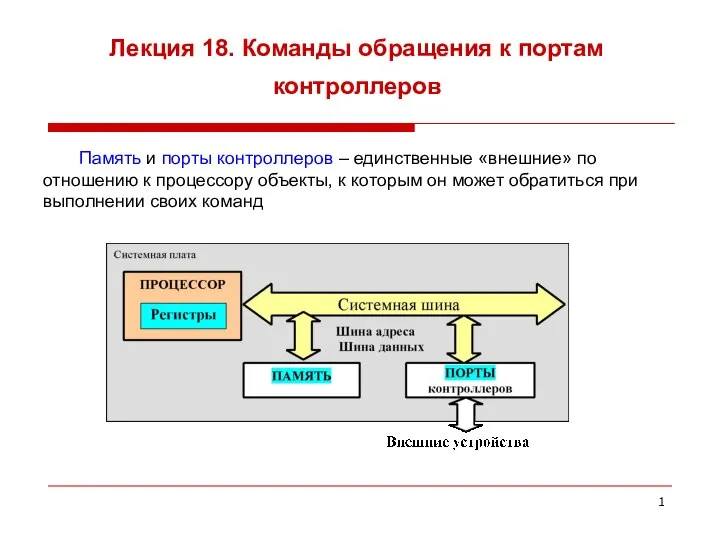

ГИА регистрация Команды обращения к портам контроллеров. (Лекция 18)

Команды обращения к портам контроллеров. (Лекция 18) Основы командной работы

Основы командной работы Работа в Excel 2007

Работа в Excel 2007 Установка сносок

Установка сносок Триггеры в презентации. Применение

Триггеры в презентации. Применение Анимация в Microsoft PowerPoint 2013

Анимация в Microsoft PowerPoint 2013 Предыстория информатики 9 класс

Предыстория информатики 9 класс Основы работы с векторными объектами

Основы работы с векторными объектами ИСМ Бэст-план

ИСМ Бэст-план Векторная графика

Векторная графика Известия VS Медиазона

Известия VS Медиазона Искусственный интеллект в системе управления электроприводом

Искусственный интеллект в системе управления электроприводом