Содержание

- 2. Лекция 4 2008 Аннотация В лекции описываются средства организации неблокирующих двухточечных обменов. Рассматриваются операции неблокирующих отправки

- 3. План лекции 2008 Пример использования блокирующих двухточечных обменов Общая характеристика неблокирующих обменов. Неблокирующие передача и приём.

- 4. Одномерное уравнение Лапласа. Метод Якоби 2008

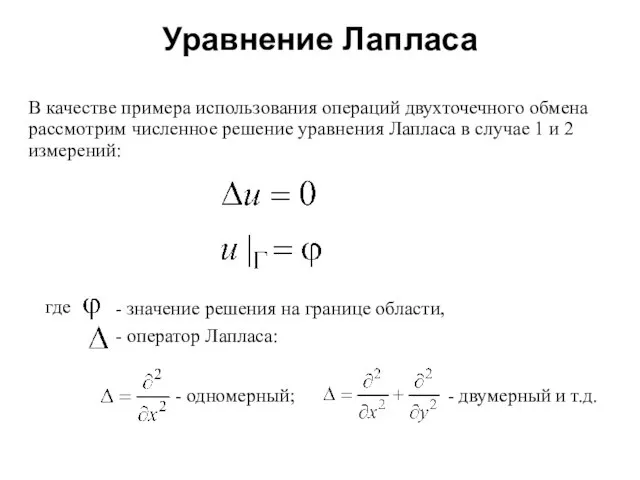

- 5. Уравнение Лапласа 2008 В качестве примера использования операций двухточечного обмена рассмотрим численное решение уравнения Лапласа в

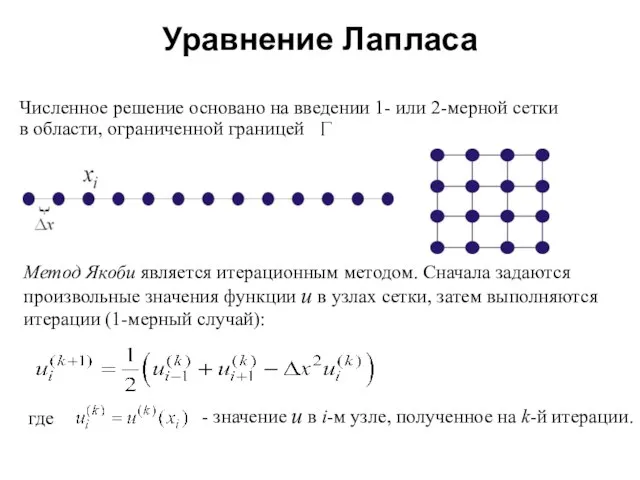

- 6. Уравнение Лапласа 2008 Численное решение основано на введении 1- или 2-мерной сетки в области, ограниченной границей

- 7. Уравнение Лапласа 2008 Последовательная программа на языке Fortran 90

- 8. Уравнение Лапласа 2008 program jacobi_serial implicit none real, dimension(0:10001) :: x, newx real :: dx2 integer

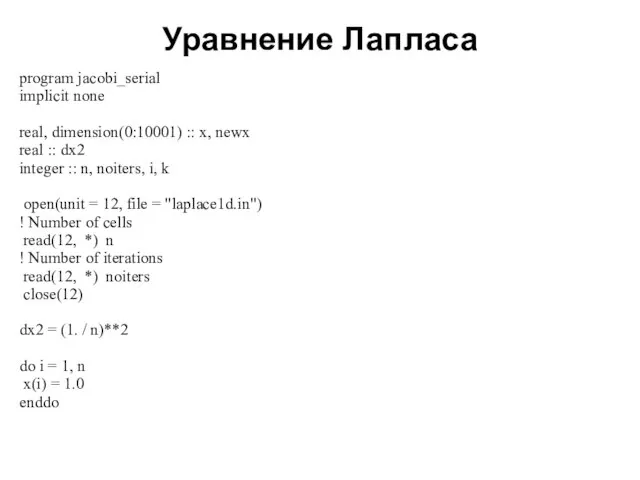

- 9. Уравнение Лапласа 2008 x(0) = 0.0 x(n + 1) = 0.0 do k = 1, noiters

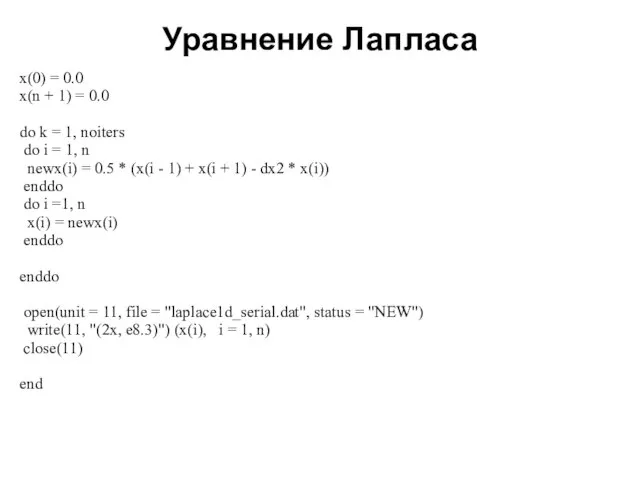

- 10. Уравнение Лапласа 2008 Параллельная программа на языке Fortran 90

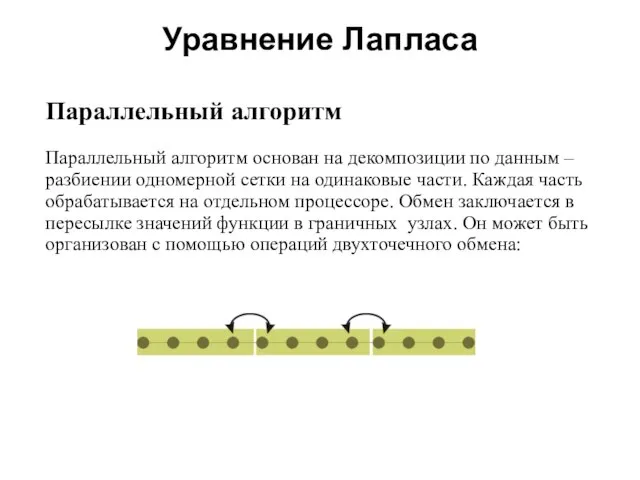

- 11. Уравнение Лапласа 2008 Параллельный алгоритм Параллельный алгоритм основан на декомпозиции по данным – разбиении одномерной сетки

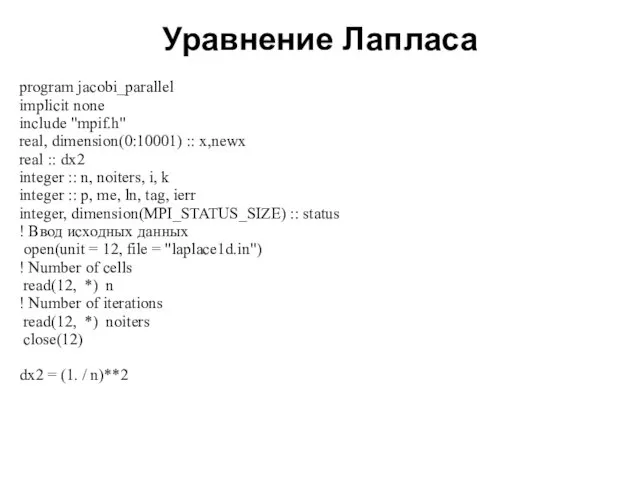

- 12. Уравнение Лапласа 2008 program jacobi_parallel implicit none include "mpif.h" real, dimension(0:10001) :: x,newx real :: dx2

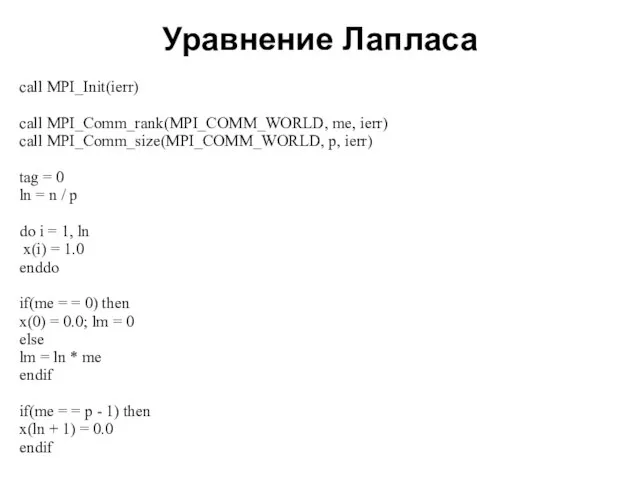

- 13. Уравнение Лапласа 2008 call MPI_Init(ierr) call MPI_Comm_rank(MPI_COMM_WORLD, me, ierr) call MPI_Comm_size(MPI_COMM_WORLD, p, ierr) tag = 0

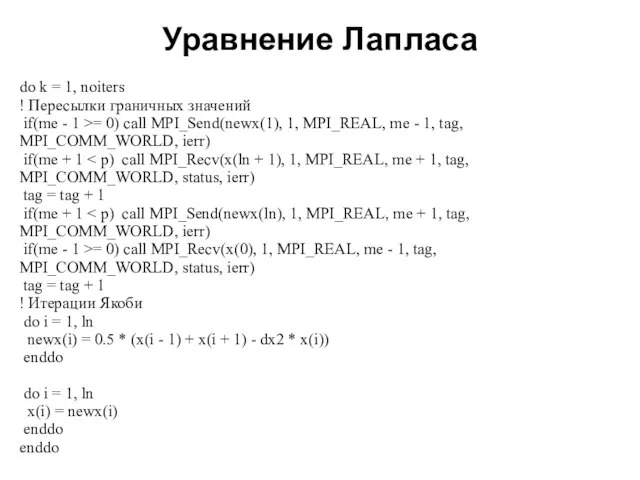

- 14. Уравнение Лапласа 2008 do k = 1, noiters ! Пересылки граничных значений if(me - 1 >=

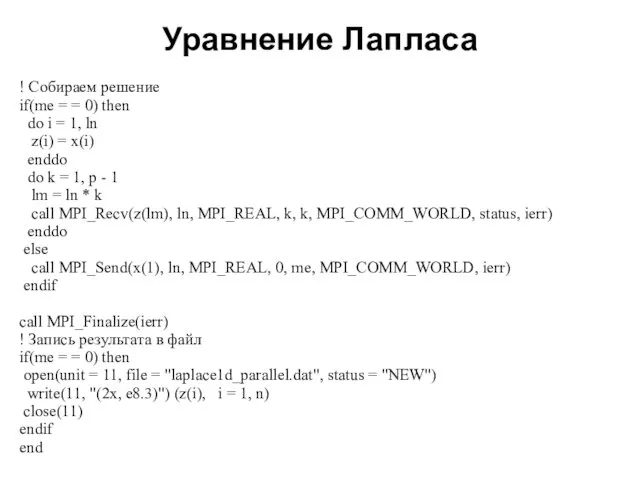

- 15. Уравнение Лапласа 2008 ! Собираем решение if(me = = 0) then do i = 1, ln

- 16. Неблокирующие двухточечные обмены 2008

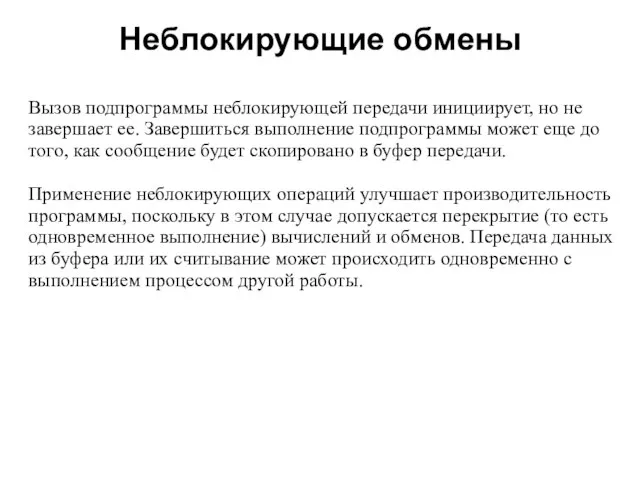

- 17. Неблокирующие обмены 2008 Вызов подпрограммы неблокирующей передачи инициирует, но не завершает ее. Завершиться выполнение подпрограммы может

- 18. Неблокирующие обмены 2008 Для завершения неблокирующего обмена требуется вызов дополнительной процедуры, которая проверяет, скопированы ли данные

- 19. Неблокирующие обмены 2008 Неблокирующий обмен выполняется в два этапа: инициализация обмена; проверка завершения обмена. Разделение этих

- 20. Неблокирующие обмены 2008 Инициализация неблокирующей стандартной передачи выполняется подпрограммами MPI_I[S, B, R]send. Стандартная неблокирующая передача выполняется

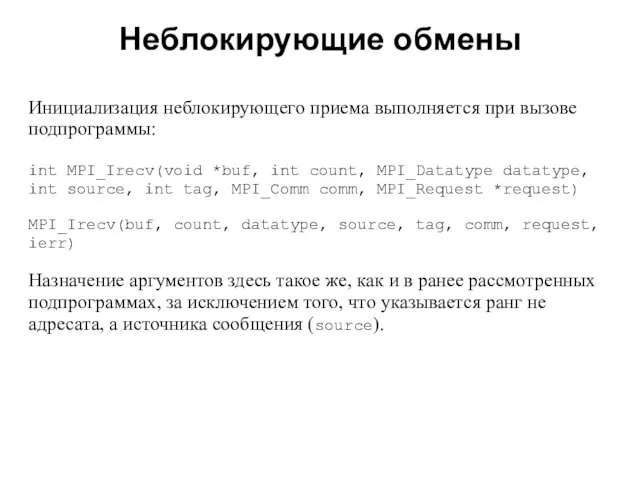

- 21. Неблокирующие обмены 2008 Инициализация неблокирующего приема выполняется при вызове подпрограммы: int MPI_Irecv(void *buf, int count, MPI_Datatype

- 22. Неблокирующие обмены 2008 Вызовы подпрограмм неблокирующего обмена формируют запрос на выполнение операции обмена и связывают его

- 23. Неблокирующие обмены 2008 Проверка выполнения обмена Проверка фактического выполнения передачи или приема в неблокирующем режиме осуществляется

- 24. Неблокирующие обмены 2008 В том случае, когда одновременно несколько процессов обмениваются сообщениями, можно использовать проверки, которые

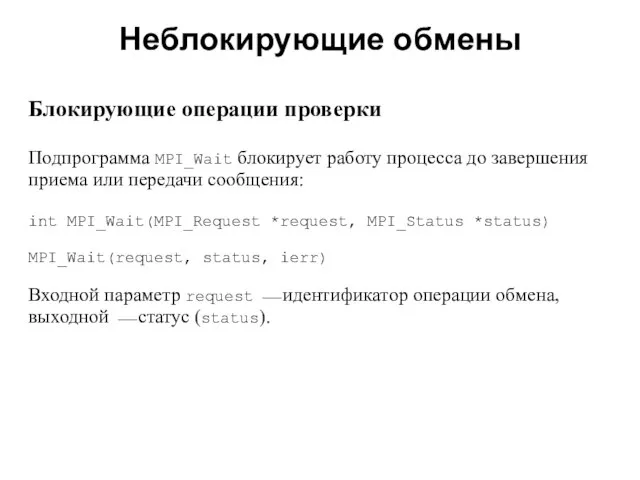

- 25. Неблокирующие обмены 2008 Блокирующие операции проверки Подпрограмма MPI_Wait блокирует работу процесса до завершения приема или передачи

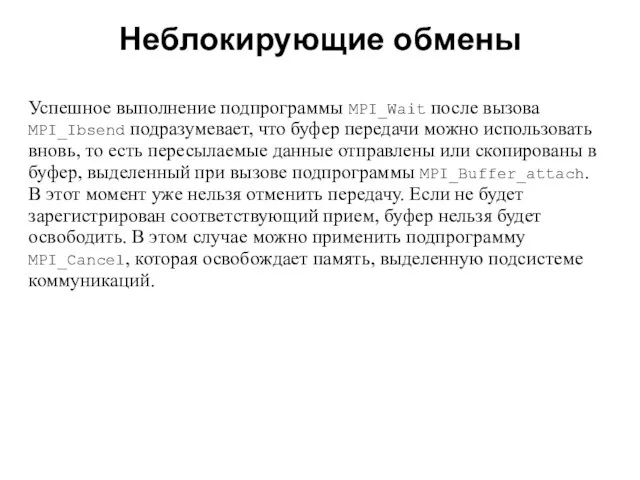

- 26. Неблокирующие обмены 2008 Успешное выполнение подпрограммы MPI_Wait после вызова MPI_Ibsend подразумевает, что буфер передачи можно использовать

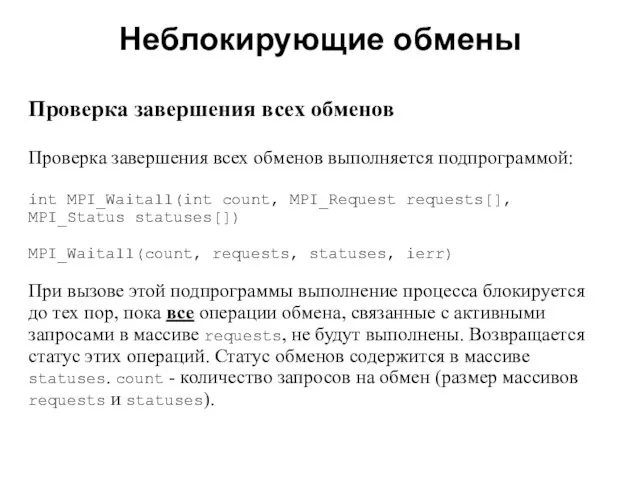

- 27. Неблокирующие обмены 2008 Проверка завершения всех обменов Проверка завершения всех обменов выполняется подпрограммой: int MPI_Waitall(int count,

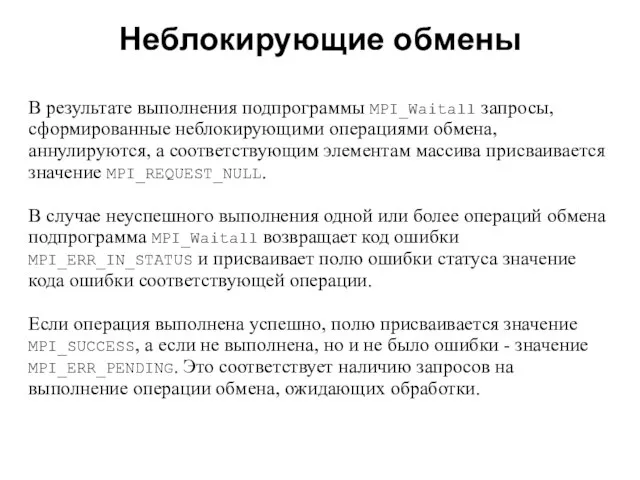

- 28. Неблокирующие обмены 2008 В результате выполнения подпрограммы MPI_Waitall запросы, сформированные неблокирующими операциями обмена, аннулируются, а соответствующим

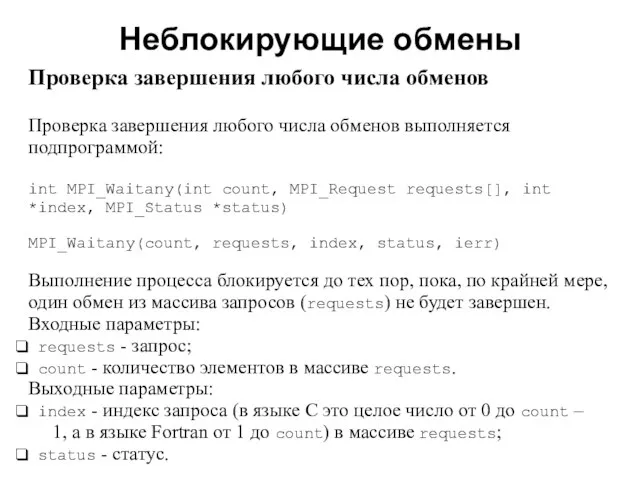

- 29. Неблокирующие обмены 2008 Проверка завершения любого числа обменов Проверка завершения любого числа обменов выполняется подпрограммой: int

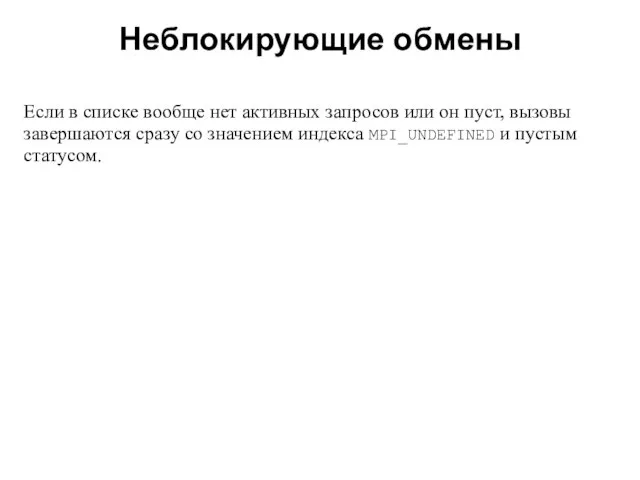

- 30. Неблокирующие обмены 2008 Если в списке вообще нет активных запросов или он пуст, вызовы завершаются сразу

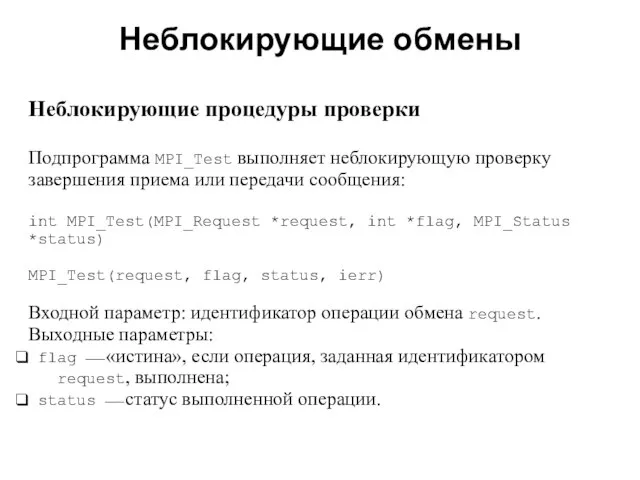

- 31. Неблокирующие обмены 2008 Неблокирующие процедуры проверки Подпрограмма MPI_Test выполняет неблокирующую проверку завершения приема или передачи сообщения:

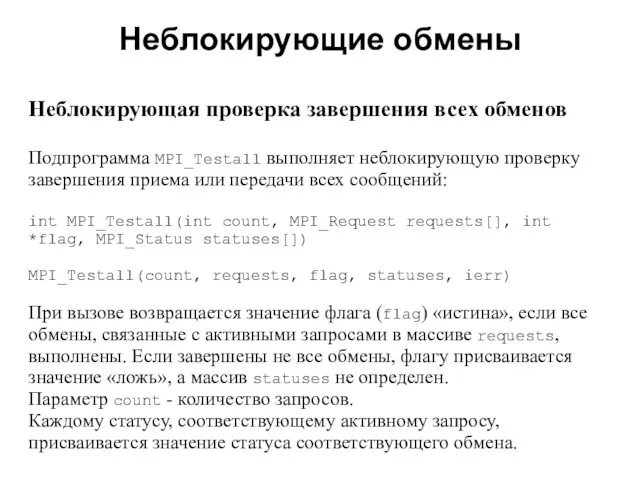

- 32. Неблокирующие обмены 2008 Неблокирующая проверка завершения всех обменов Подпрограмма MPI_Testall выполняет неблокирующую проверку завершения приема или

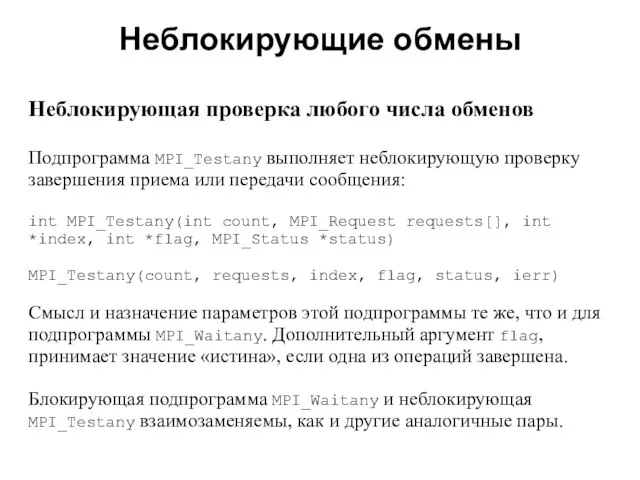

- 33. Неблокирующие обмены 2008 Неблокирующая проверка любого числа обменов Подпрограмма MPI_Testany выполняет неблокирующую проверку завершения приема или

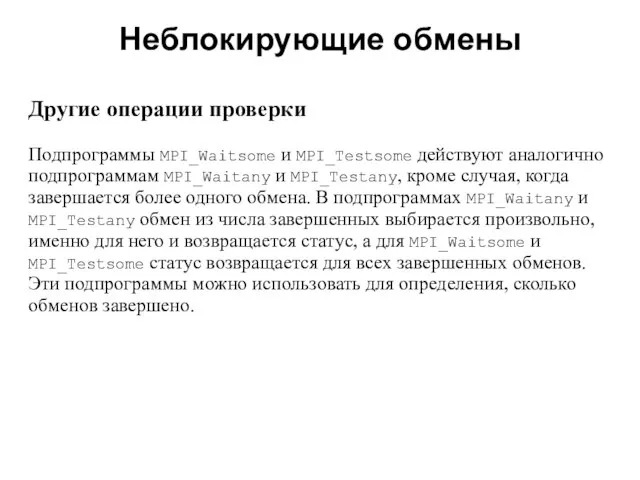

- 34. Неблокирующие обмены 2008 Другие операции проверки Подпрограммы MPI_Waitsome и MPI_Testsome действуют аналогично подпрограммам MPI_Waitany и MPI_Testany,

- 35. Неблокирующие обмены 2008 Интерфейс этих подпрограмм: int MPI_Waitsome(int incount, MPI_Request requests[], int *outcount, int indices[], MPI_Status

- 36. Неблокирующие обмены 2008 Неблокирующая проверка выполнения обменов int MPI_Testsome(int incount, MPI_Request requests[], int *outcount, int indices[],

- 37. Примеры использования неблокирующих двухточечных обменов 2008

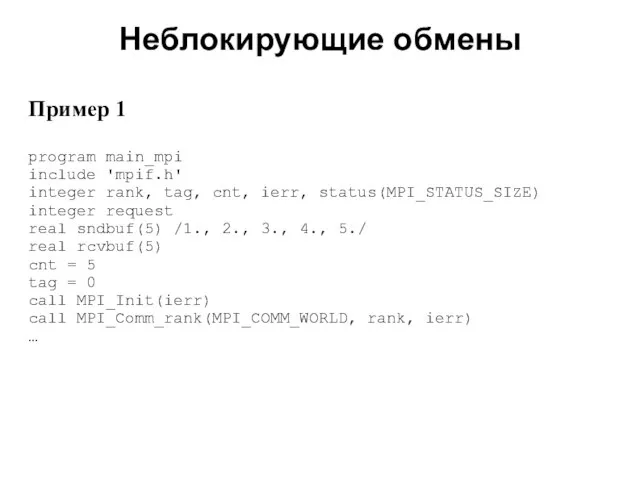

- 38. Неблокирующие обмены 2008 Пример 1 program main_mpi include 'mpif.h' integer rank, tag, cnt, ierr, status(MPI_STATUS_SIZE) integer

- 39. Неблокирующие обмены 2008 if(rank.eq.0) then call MPI_Isend(sndbuf(1), cnt, MPI_REAL, 1, tag, MPI_COMM_WORLD, request, ierr) print *,

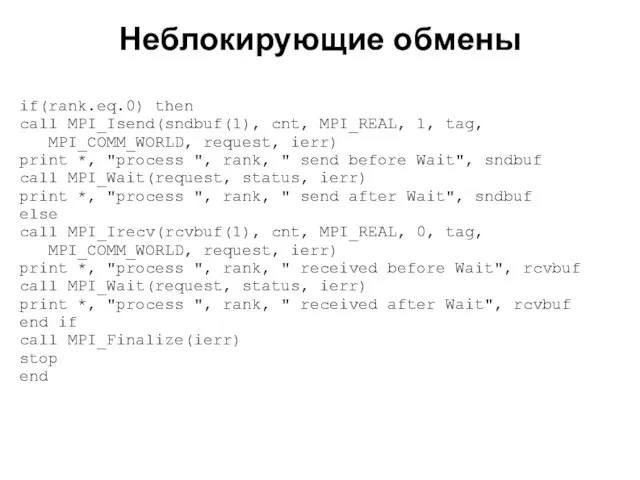

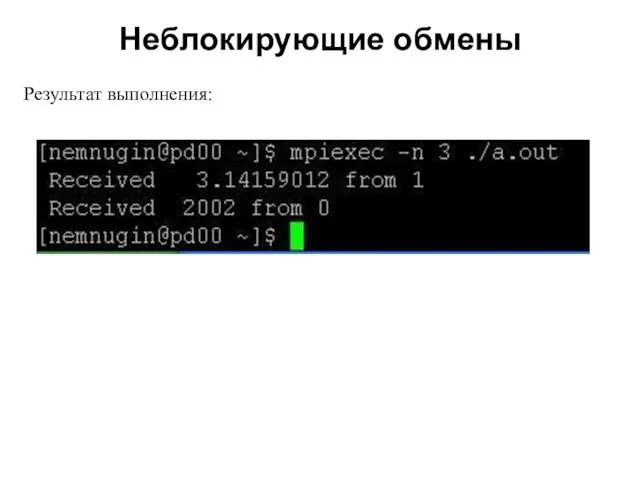

- 40. Неблокирующие обмены 2008 Результат выполнения:

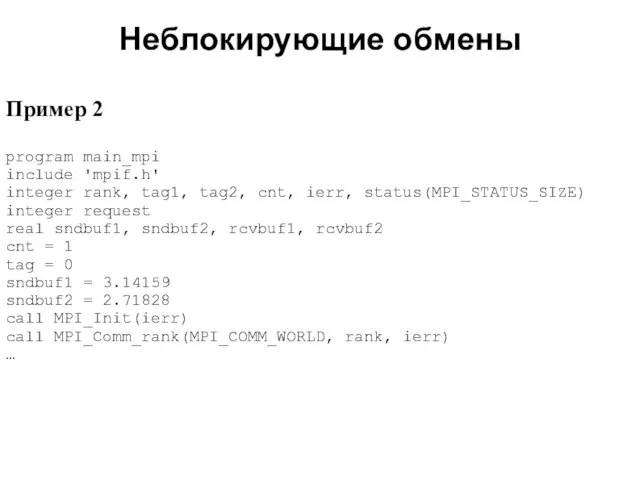

- 41. Неблокирующие обмены 2008 Пример 2 program main_mpi include 'mpif.h' integer rank, tag1, tag2, cnt, ierr, status(MPI_STATUS_SIZE)

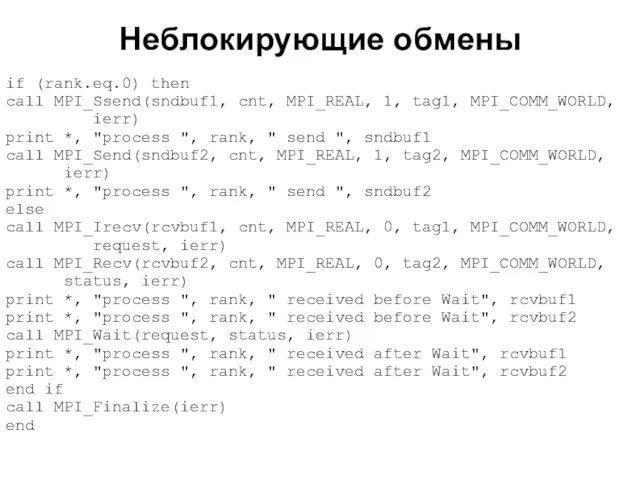

- 42. Неблокирующие обмены 2008 if (rank.eq.0) then call MPI_Ssend(sndbuf1, cnt, MPI_REAL, 1, tag1, MPI_COMM_WORLD, ierr) print *,

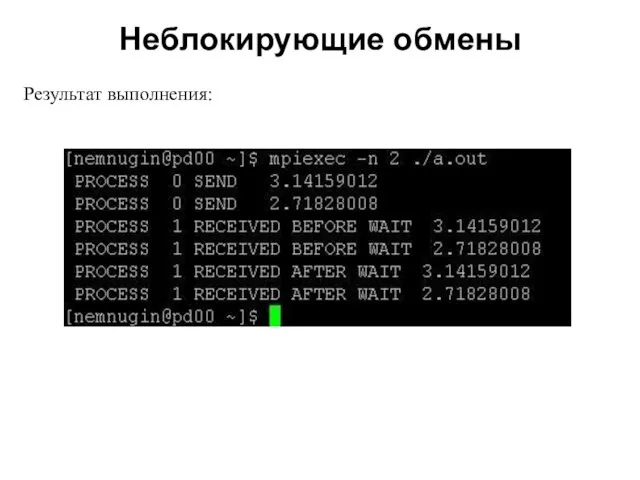

- 43. Неблокирующие обмены 2008 Результат выполнения:

- 44. Подпрограммы-пробники 2008

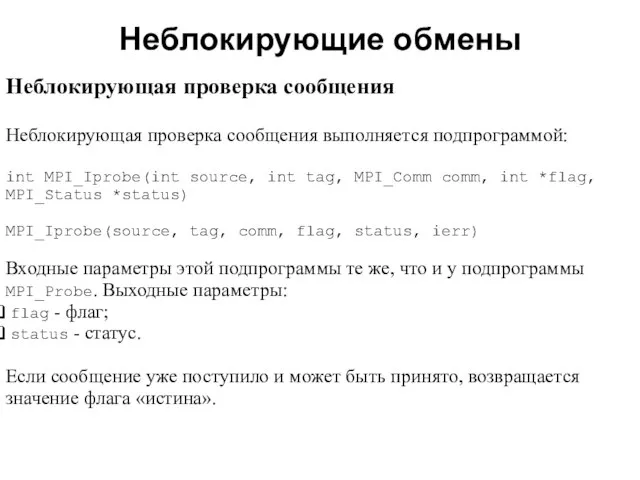

- 45. Неблокирующие обмены 2008 Неблокирующая проверка сообщения Неблокирующая проверка сообщения выполняется подпрограммой: int MPI_Iprobe(int source, int tag,

- 46. Неблокирующие обмены 2008 Размер полученного сообщения (count) можно определить с помощью вызова подпрограммы int MPI_Get_count(MPI_Status *status,

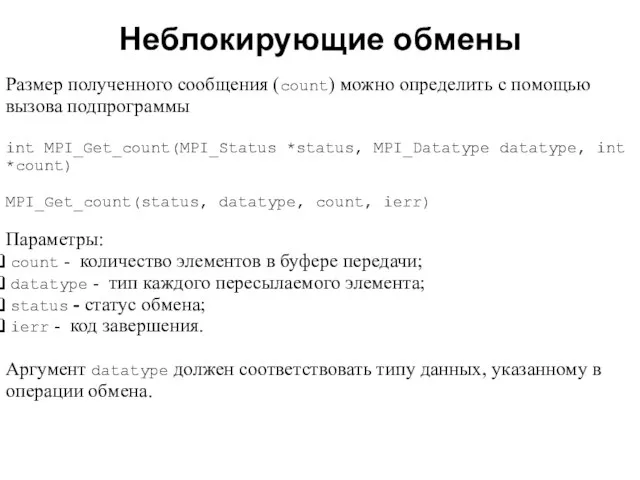

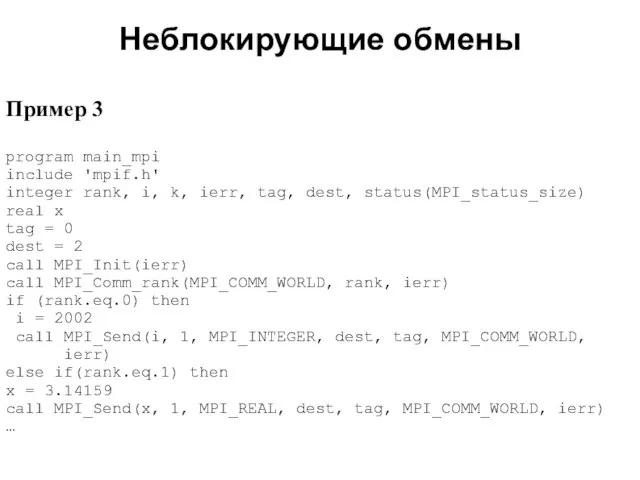

- 47. Неблокирующие обмены 2008 Пример 3 program main_mpi include 'mpif.h' integer rank, i, k, ierr, tag, dest,

- 48. Неблокирующие обмены 2008 do k = 1, 2 call MPI_Probe(MPI_any_source, tag, MPI_COMM_WORLD, status, ierr) if (status(MPI_source).eq.0)

- 49. Неблокирующие обмены 2008 Результат выполнения:

- 50. Отложенные обмены 2008

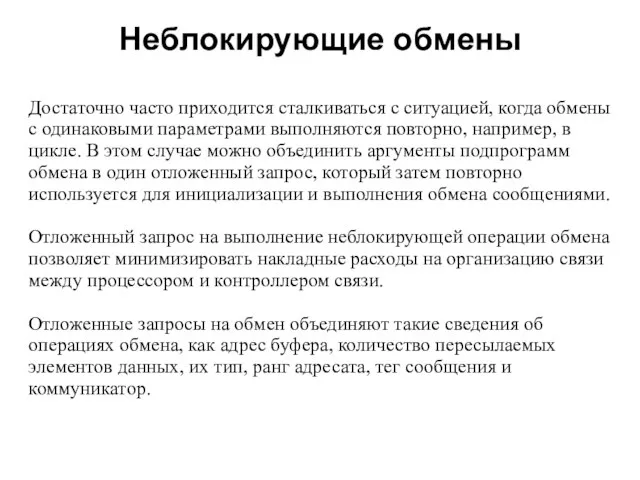

- 51. Неблокирующие обмены 2008 Достаточно часто приходится сталкиваться с ситуацией, когда обмены с одинаковыми параметрами выполняются повторно,

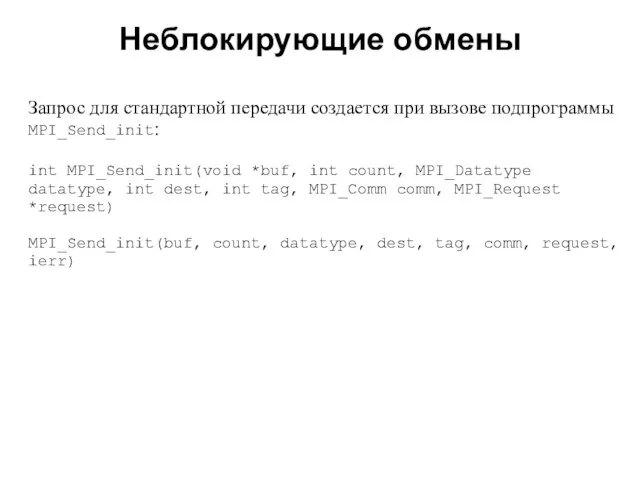

- 52. Неблокирующие обмены 2008 Запрос для стандартной передачи создается при вызове подпрограммы MPI_Send_init: int MPI_Send_init(void *buf, int

- 53. Неблокирующие обмены 2008 Отложенный запрос может быть сформирован для всех режимов обмена. Для этого используются подпрограммы

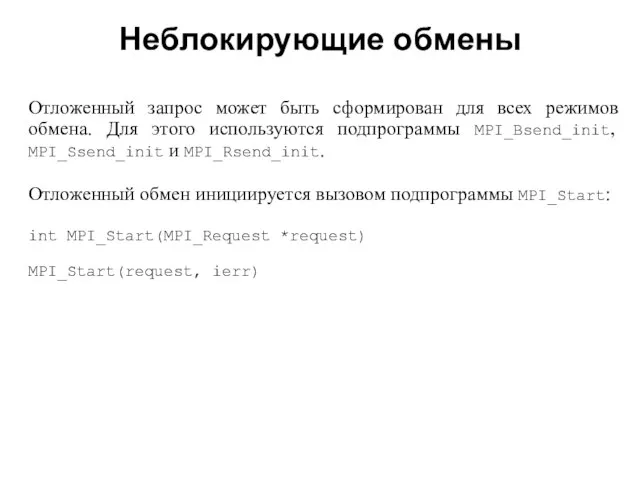

- 54. Неблокирующие обмены 2008 Подпрограмма MPI_Startall: int MPI_Startall(int count, MPI_request *requests) MPI_Startall(count, requests, ierr) инициирует все обмены,

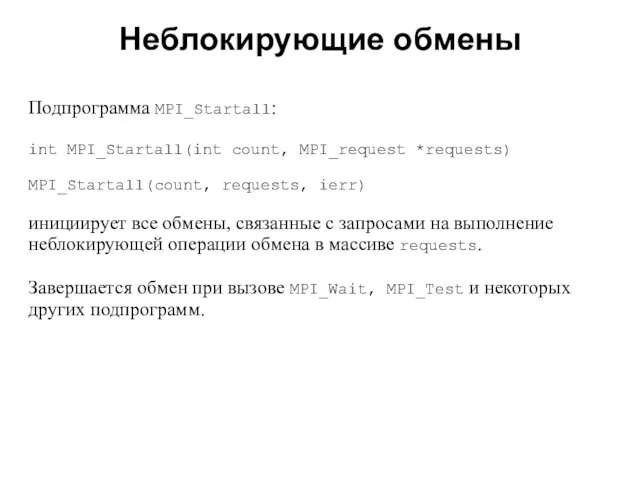

- 55. 2008 В этой лекции мы рассмотрели: примеры использования двухточечных обменов; особенности двухточечных неблокирующих обменов; реализацию неблокирующих

- 56. 2008 Задания для самостоятельной работы Решения следует высылать по электронной почте: [email protected]

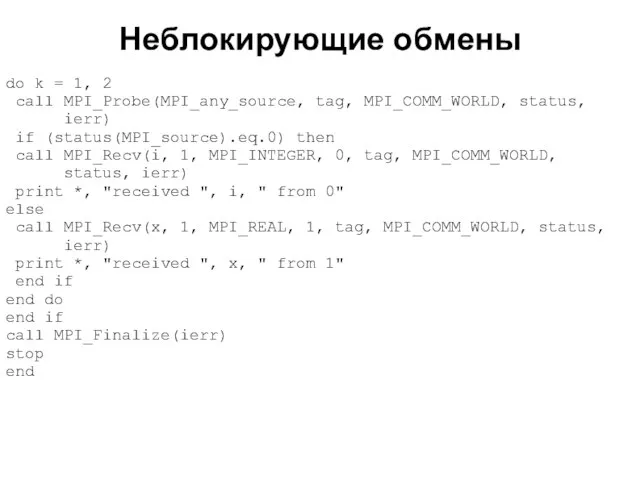

- 57. 2008 Задания для самостоятельной работы Задание 1 Разберите работу следующей программы. Запустите ее на выполнение.

- 58. 2008 #include "mpi.h" #include int main(int argc,char *argv[]) { int myid, numprocs, **buf, source, i; int

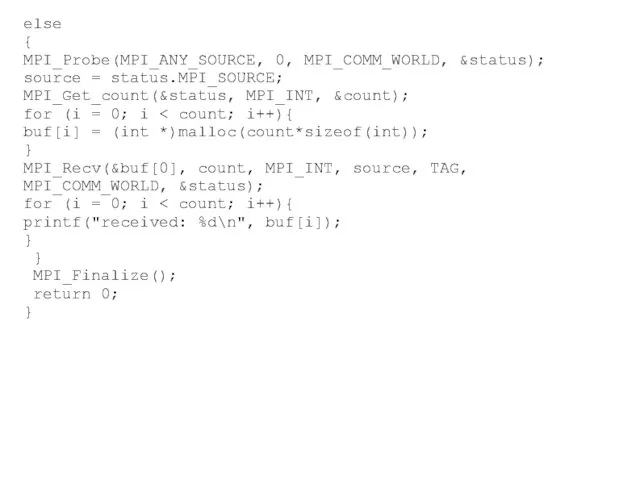

- 59. 2008 else { MPI_Probe(MPI_ANY_SOURCE, 0, MPI_COMM_WORLD, &status); source = status.MPI_SOURCE; MPI_Get_count(&status, MPI_INT, &count); for (i =

- 60. 2008 Задания для самостоятельной работы Задание 2 Два вектора a и b размерности N представлены двумя

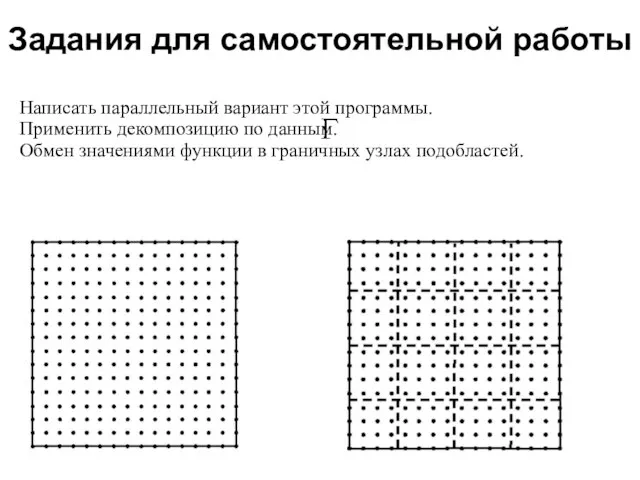

- 61. 2008 Задания для самостоятельной работы Задание 3 Имеется последовательная программа на языке Fortran 90 решения двумерного

- 62. Задания для самостоятельной работы 2008 Двумерное уравнение Лапласа. Последовательная программа на языке Fortran 90

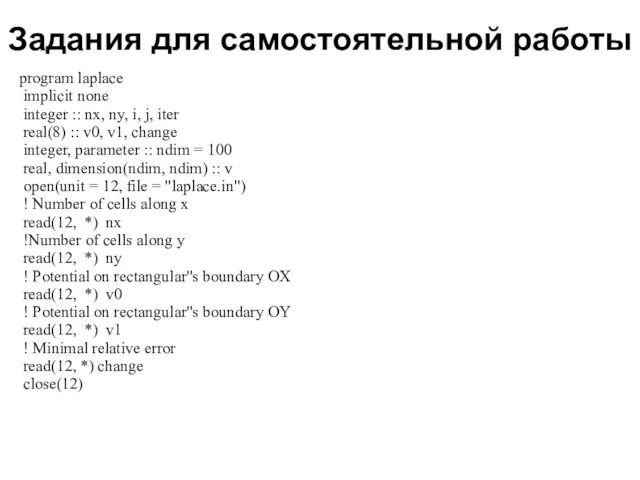

- 63. Задания для самостоятельной работы 2008 program laplace implicit none integer :: nx, ny, i, j, iter

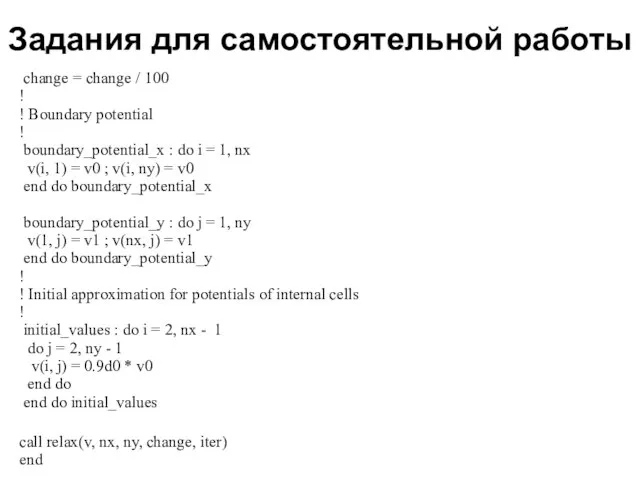

- 64. Задания для самостоятельной работы 2008 change = change / 100 ! ! Boundary potential ! boundary_potential_x

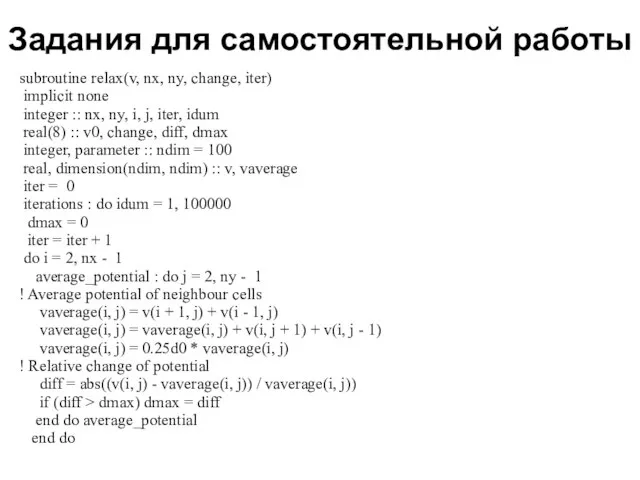

- 65. Задания для самостоятельной работы 2008 subroutine relax(v, nx, ny, change, iter) implicit none integer :: nx,

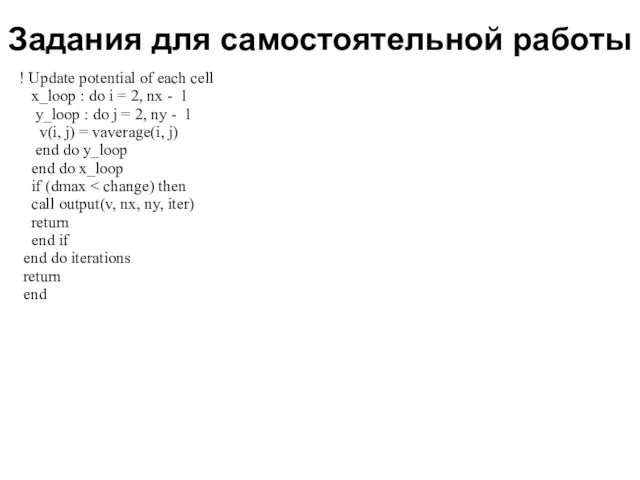

- 66. Задания для самостоятельной работы 2008 ! Update potential of each cell x_loop : do i =

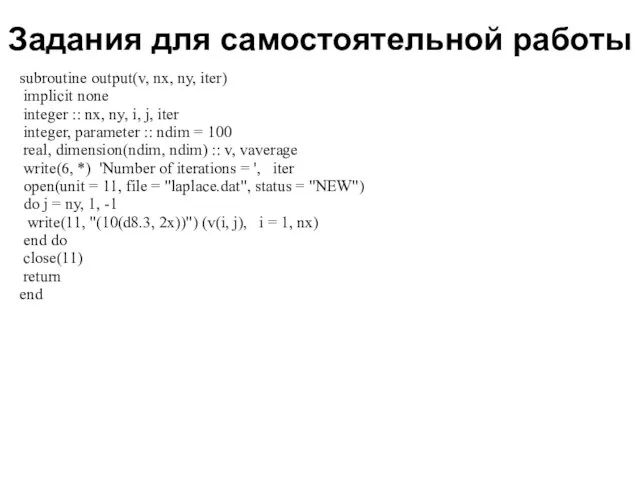

- 67. Задания для самостоятельной работы 2008 subroutine output(v, nx, ny, iter) implicit none integer :: nx, ny,

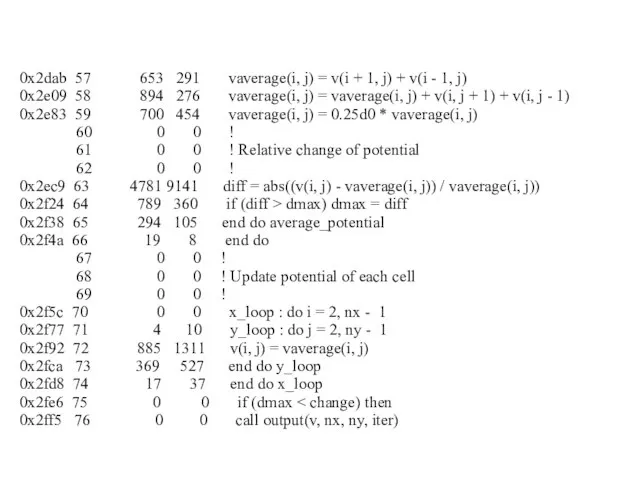

- 68. 2008 0x2dab 57 653 291 vaverage(i, j) = v(i + 1, j) + v(i - 1,

- 69. Задания для самостоятельной работы 2008 Написать параллельный вариант этой программы. Применить декомпозицию по данным. Обмен значениями

- 71. Скачать презентацию

![Неблокирующие обмены 2008 Инициализация неблокирующей стандартной передачи выполняется подпрограммами MPI_I[S, B, R]send.](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/461334/slide-19.jpg)

![Неблокирующие обмены 2008 Интерфейс этих подпрограмм: int MPI_Waitsome(int incount, MPI_Request requests[], int](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/461334/slide-34.jpg)

![Неблокирующие обмены 2008 Неблокирующая проверка выполнения обменов int MPI_Testsome(int incount, MPI_Request requests[],](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/461334/slide-35.jpg)

![2008 #include "mpi.h" #include int main(int argc,char *argv[]) { int myid, numprocs,](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/461334/slide-57.jpg)

Презентация на тему Алгебра и логика высказываний

Презентация на тему Алгебра и логика высказываний Заболевание височно-нижнечелюстного сустава

Заболевание височно-нижнечелюстного сустава  Конфликтный треугольник: семья-ребенок-образовательное учреждение. Детская агрессия

Конфликтный треугольник: семья-ребенок-образовательное учреждение. Детская агрессия кольцово

кольцово Проблемы преемственности начального и основного (общего) образования

Проблемы преемственности начального и основного (общего) образования Проектная деятельность

Проектная деятельность Власть. Структурная и ситуационная власть

Власть. Структурная и ситуационная власть Свечникова В.В. правоведение тема 2 презентация

Свечникова В.В. правоведение тема 2 презентация Майолика. Гутные изделия. Ковка

Майолика. Гутные изделия. Ковка Saint Petersburg state University

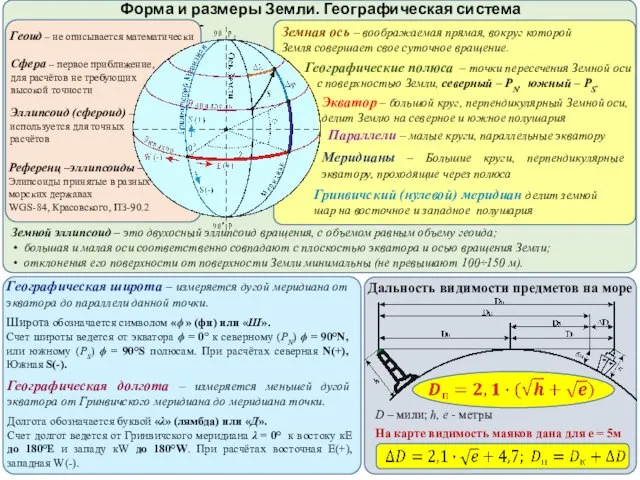

Saint Petersburg state University  Форма и размеры Земли

Форма и размеры Земли Поздравление крестной жениха

Поздравление крестной жениха Гендерные аспекты образования и рынка труда

Гендерные аспекты образования и рынка труда Геометрия на службе у архитектуры

Геометрия на службе у архитектуры Психология двигательно-волевой сферы психической деятельности

Психология двигательно-волевой сферы психической деятельности Команда звёздочки

Команда звёздочки История семейного образования в СанктПетербурге

История семейного образования в СанктПетербурге Русский пейзаж в поэзии и живописи

Русский пейзаж в поэзии и живописи Физическая культура в период самоизоляции студентов педагогического вуза

Физическая культура в период самоизоляции студентов педагогического вуза Заповедники России

Заповедники России Презентация на тему Прощание с 1 классом

Презентация на тему Прощание с 1 классом Клёш и фалды

Клёш и фалды Быть нормальным

Быть нормальным Основные формы рельефа Алтайского края

Основные формы рельефа Алтайского края  Проект: Комплексное сопровождение покупки страховой компании

Проект: Комплексное сопровождение покупки страховой компании Сделка. Предпринимательская деятельность

Сделка. Предпринимательская деятельность русский язык - язык международного общения

русский язык - язык международного общения Условия признания и исполнения иностранных судебных решений

Условия признания и исполнения иностранных судебных решений