Содержание

- 2. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 3. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 4. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 5. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 6. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 7. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 8. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 9. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

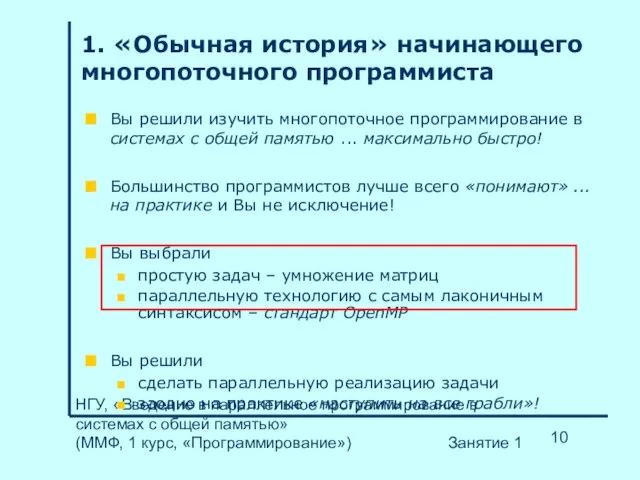

- 10. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

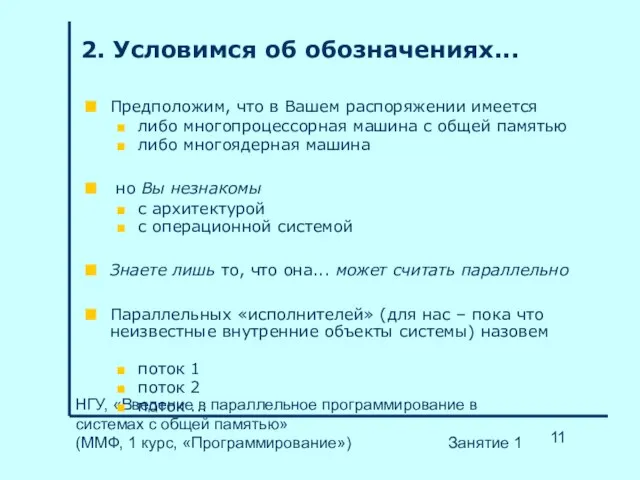

- 11. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

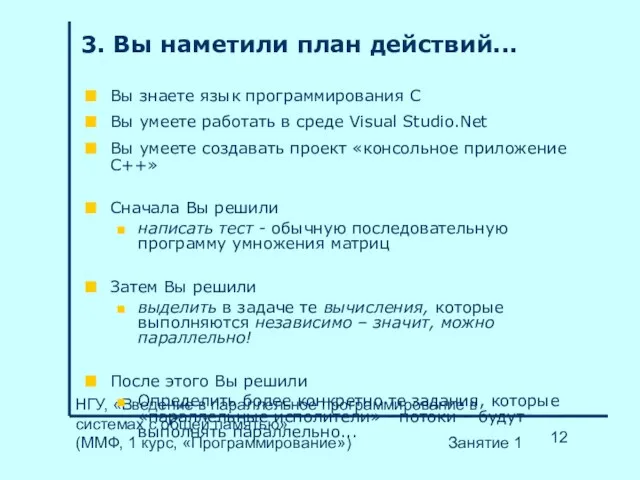

- 12. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

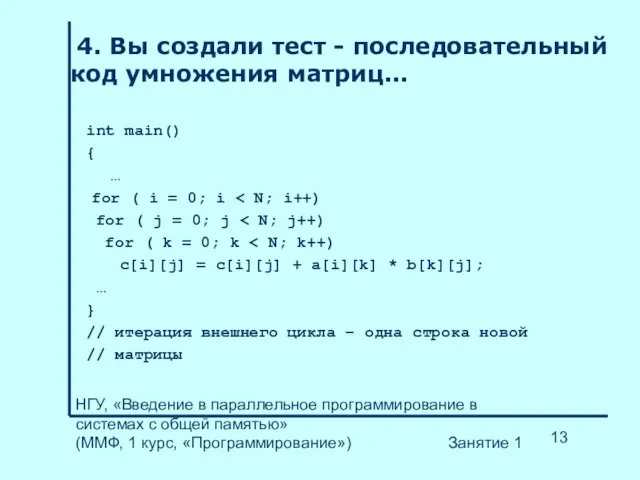

- 13. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

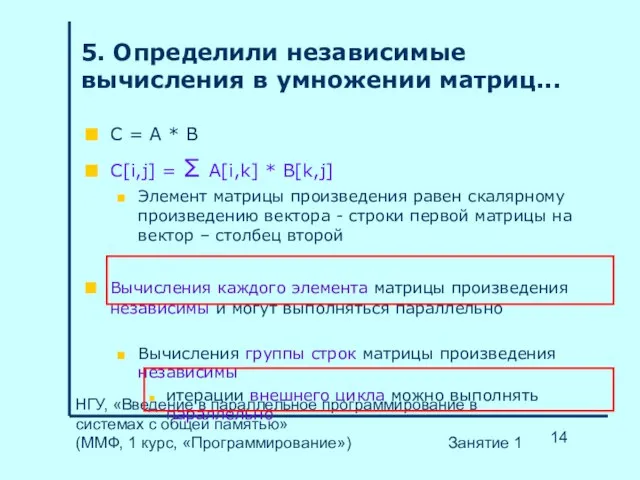

- 14. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

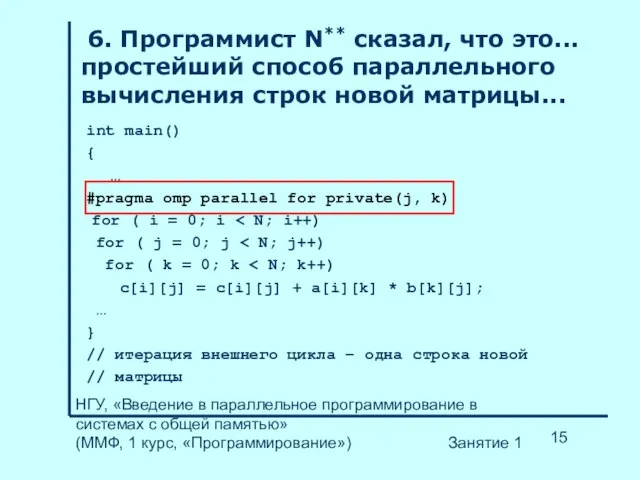

- 15. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

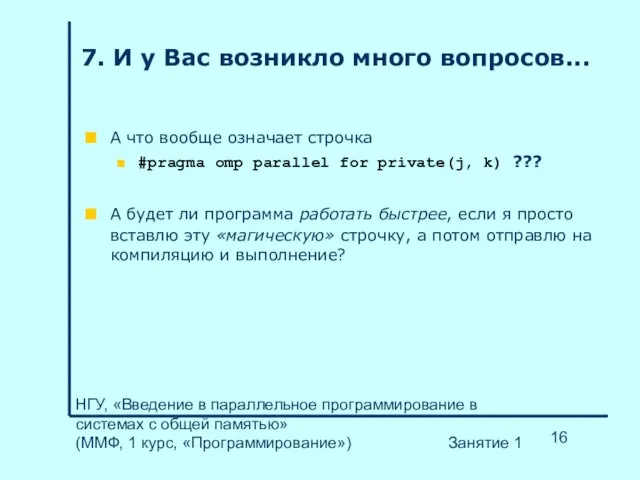

- 16. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

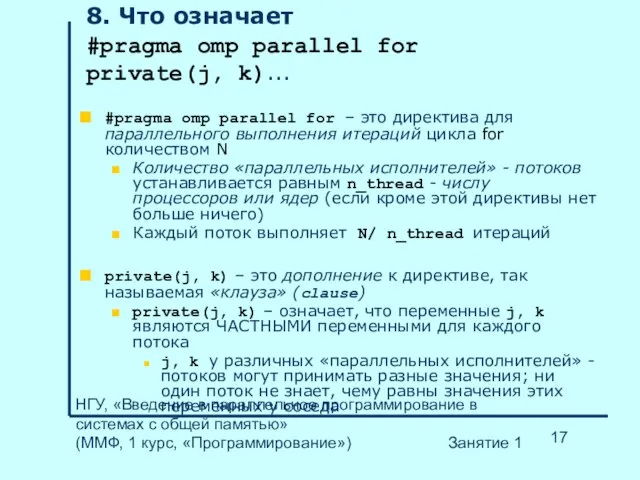

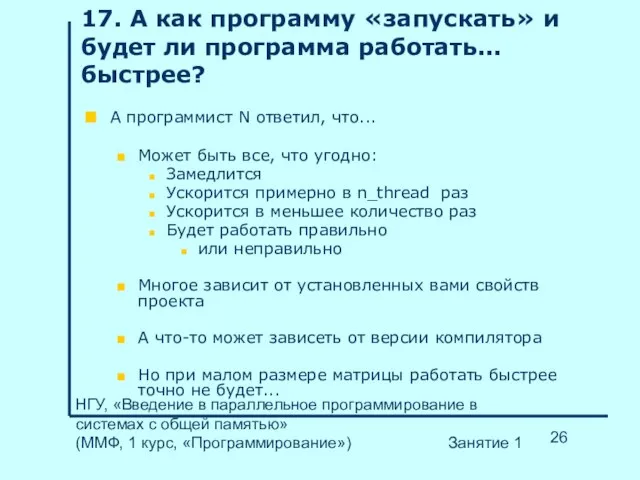

- 17. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

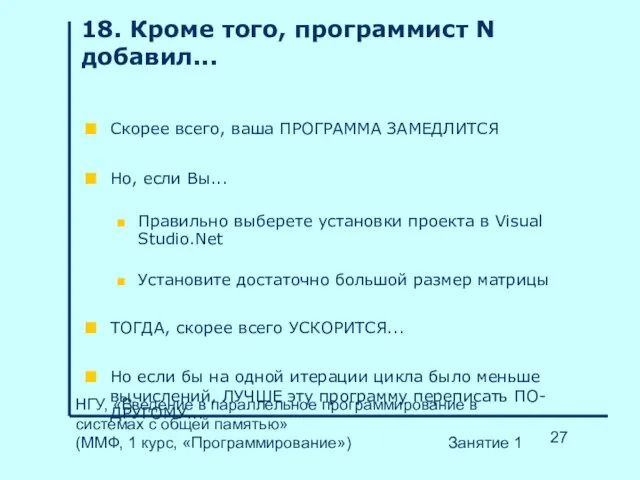

- 18. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

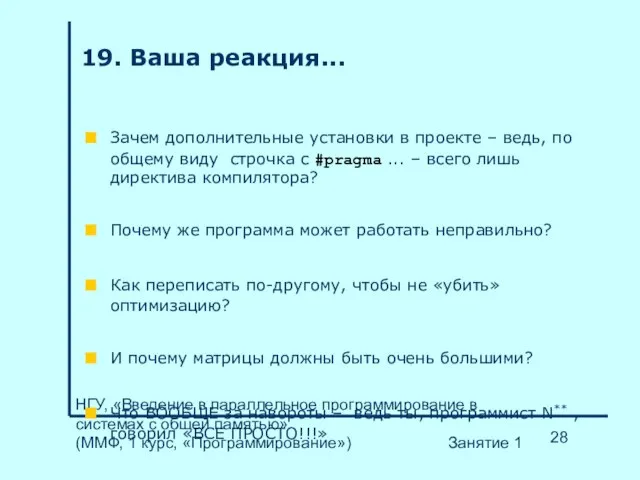

- 19. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

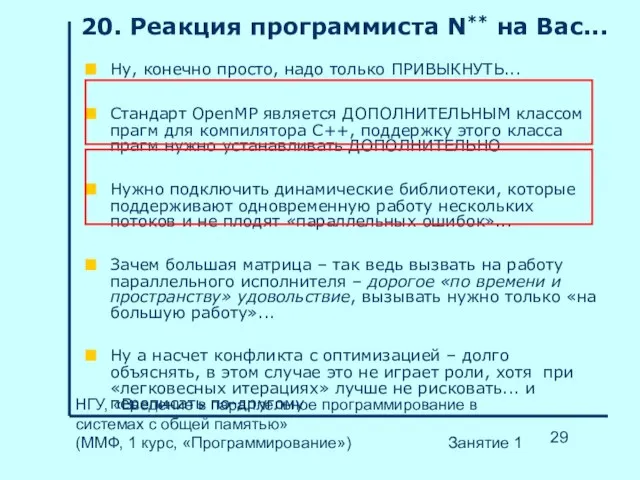

- 20. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 21. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

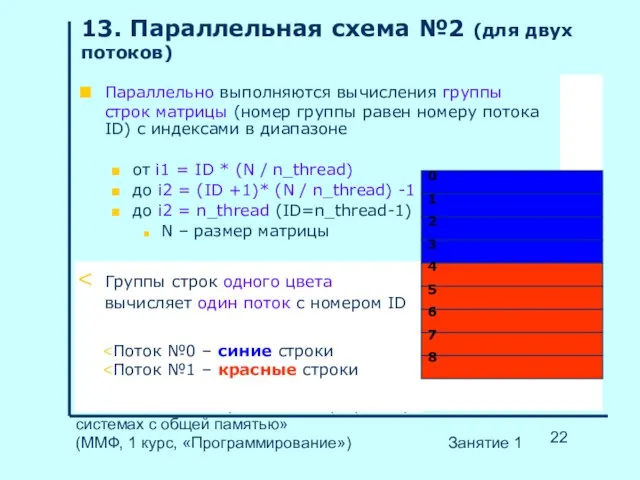

- 22. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 23. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 24. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

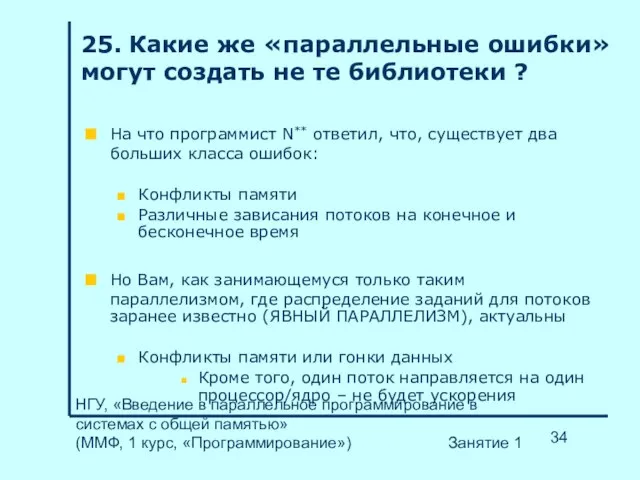

- 25. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

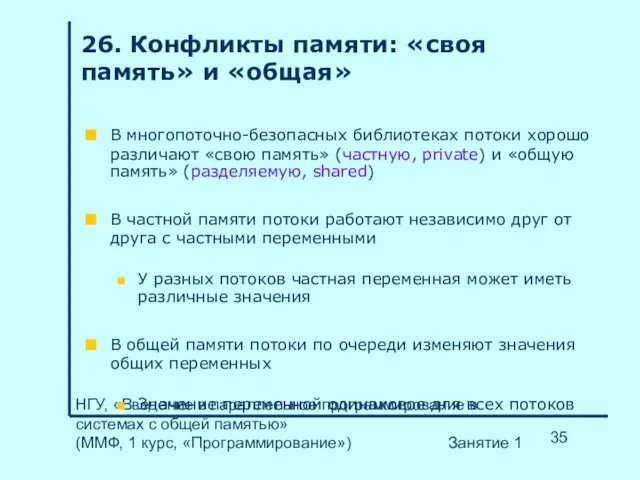

- 26. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

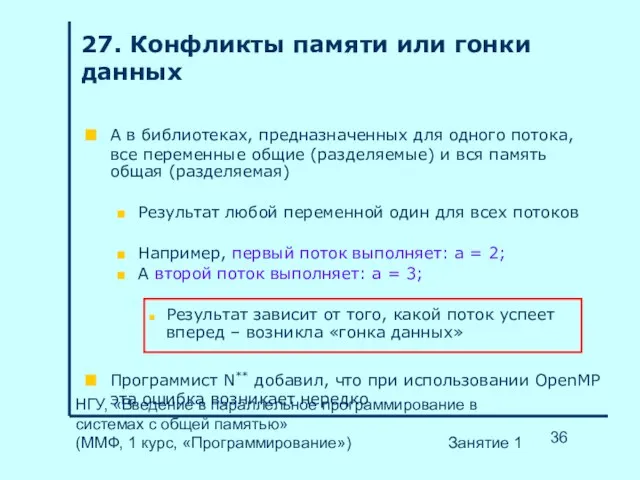

- 27. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

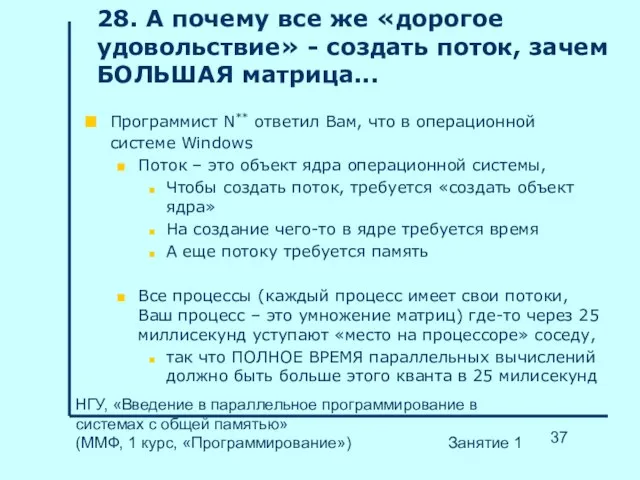

- 28. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

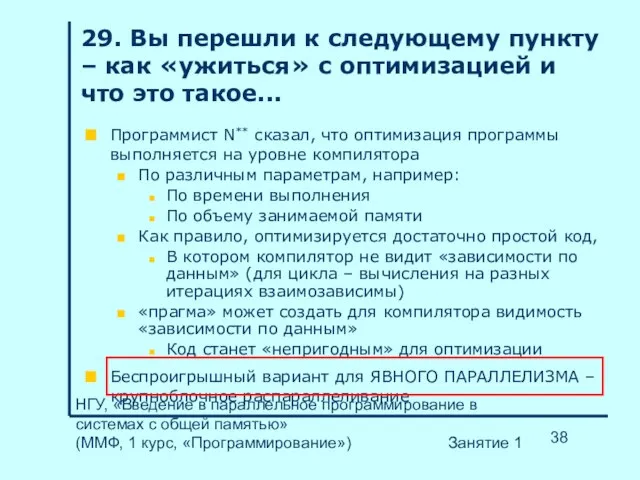

- 29. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 30. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

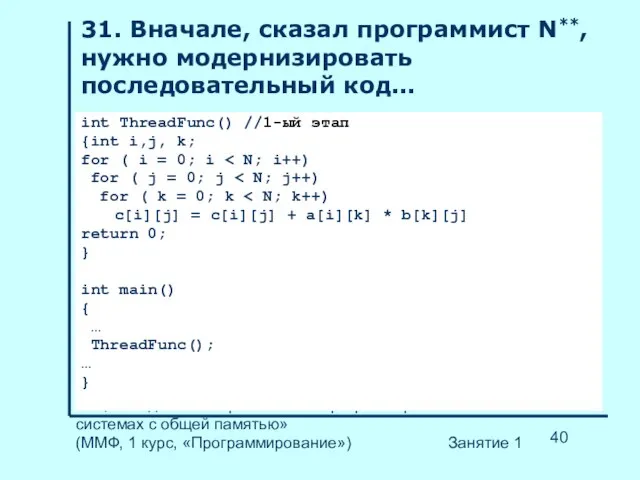

- 31. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

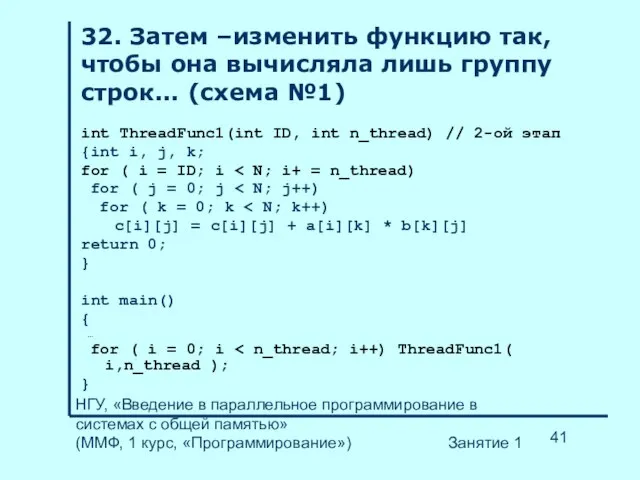

- 32. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 33. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 34. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 35. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 36. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 37. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 38. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 39. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 40. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 41. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

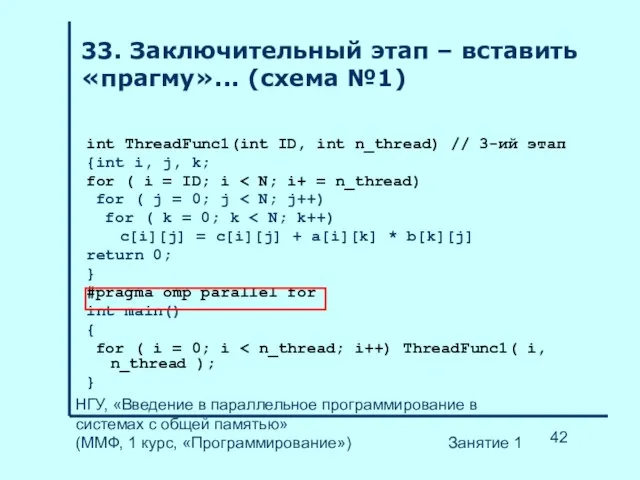

- 42. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

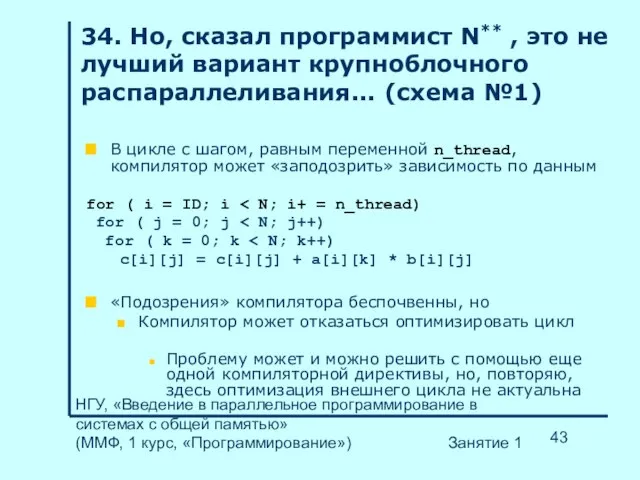

- 43. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

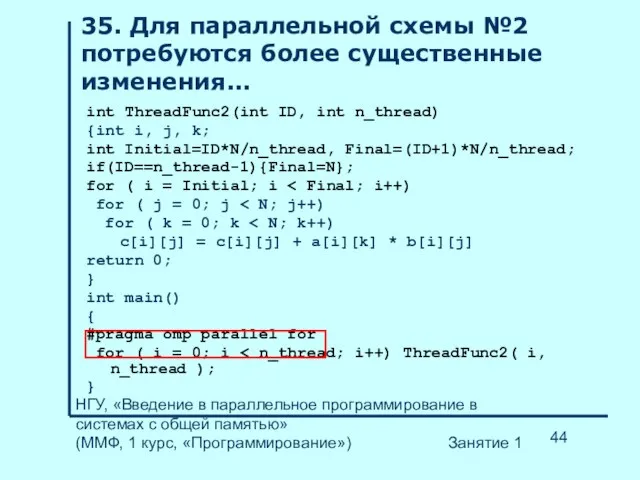

- 44. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

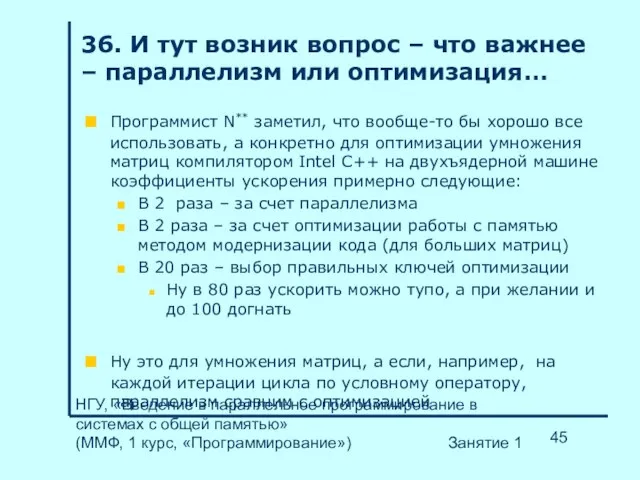

- 45. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

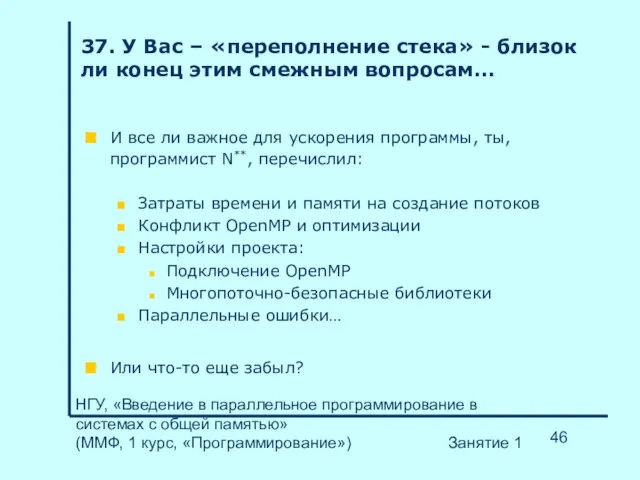

- 46. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

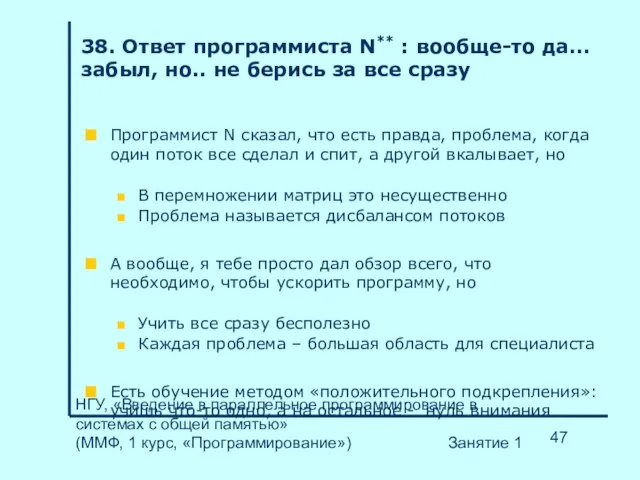

- 47. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

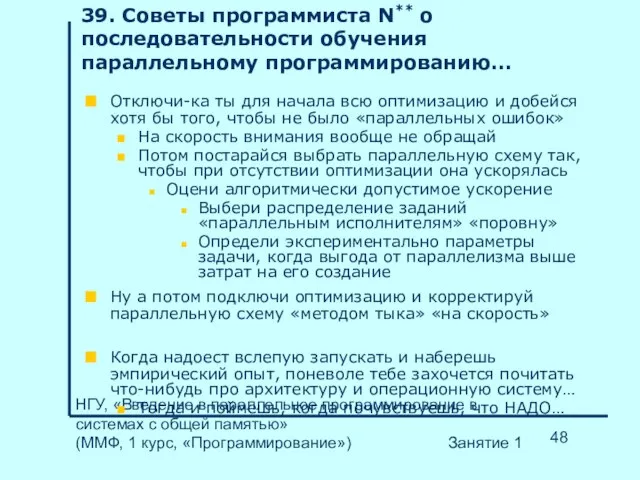

- 48. НГУ, «Введение в параллельное программирование в системах с общей памятью» (ММФ, 1 курс, «Программирование») Занятие 1

- 50. Скачать презентацию

Управление предприятиями общественного питания

Управление предприятиями общественного питания Правовое регулирование системы местного самоуправления

Правовое регулирование системы местного самоуправления Конференция «Бизнес и этика»

Конференция «Бизнес и этика» Джозеф Редьярд Киплинг

Джозеф Редьярд Киплинг Образ дороги в русской живописи

Образ дороги в русской живописи Телефонный разговор

Телефонный разговор Конфликты в нашей жизни и как их предотвратить

Конфликты в нашей жизни и как их предотвратить Озеро Байкал

Озеро Байкал Костюмы Ани и Вани

Костюмы Ани и Вани Сестрица Алёнушка и братец Иванушка

Сестрица Алёнушка и братец Иванушка Старинное , модное кружево

Старинное , модное кружево В.Бианки «Сова»

В.Бианки «Сова» Современные требования к профессионалу

Современные требования к профессионалу Влияние цвета на человека

Влияние цвета на человека Презентация на тему Знаки зодиака

Презентация на тему Знаки зодиака  Открытый экспертный совет по развитию энергетики Свердловской области

Открытый экспертный совет по развитию энергетики Свердловской области Антисоциальные и криминальные молодежные группы

Антисоциальные и криминальные молодежные группы Год росийского кино

Год росийского кино Кардиохирургия . Кардиохирург

Кардиохирургия . Кардиохирург Случайные события и вероятность

Случайные события и вероятность Презентация на тему Стили речи

Презентация на тему Стили речи Эмоциональный интеллект и принятие решения

Эмоциональный интеллект и принятие решения Третий урок

Третий урок СУХАЯ ФОРМА « Н А Р И Н Э » Lactobacilus Acidofilus ИНМИА 9602

СУХАЯ ФОРМА « Н А Р И Н Э » Lactobacilus Acidofilus ИНМИА 9602 Художник XIX века. Рауль Дюфи (1877-1953)

Художник XIX века. Рауль Дюфи (1877-1953) 12.4. ГОСТ 2.109-73. Основные требования к чертежам

12.4. ГОСТ 2.109-73. Основные требования к чертежам Инвестиционная составляющая в плате за технологическое присоединение потребителей к электрическим сетям: проблемы и решения

Инвестиционная составляющая в плате за технологическое присоединение потребителей к электрическим сетям: проблемы и решения Методы и приёмы обучения младших школьников

Методы и приёмы обучения младших школьников