Содержание

- 2. Алгоритм C4.5 Усовершенствование простого алгоритма индуцирования знаний. Основнoе отличие: следующий условный атрибут, по которому проводится разбиение,

- 3. Общее описание алгоритма C4.5 Алгоритм работает для таких таблиц данных, в которых атрибут класса (целевой атрибут)

- 4. Общее описание алгоритма C4.5 (продолжение) Обозначения (продолжение) |T | — мощность множества примеров (количество строк в

- 5. Общее описание алгоритма C4.5 (окончание) Обозначения (окончание) A1 , A2 , …, AN — значения, принима-емые

- 6. Выбор условного атрибута для разбиения Пусть рассматриваем условный атрибут X, принимающий n значений A1, A2 ...

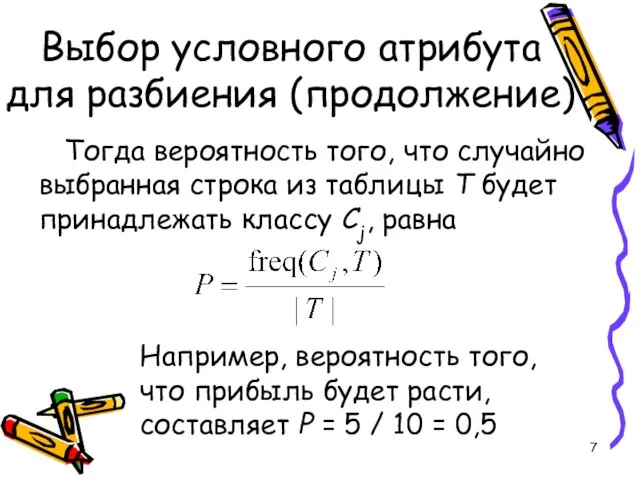

- 7. Выбор условного атрибута для разбиения (продолжение) Тогда вероятность того, что случайно выбранная строка из таблицы T

- 8. Выбор условного атрибута для разбиения (продолжение) Согласно теории информации, количество содержащейся в сообщении информации зависит от

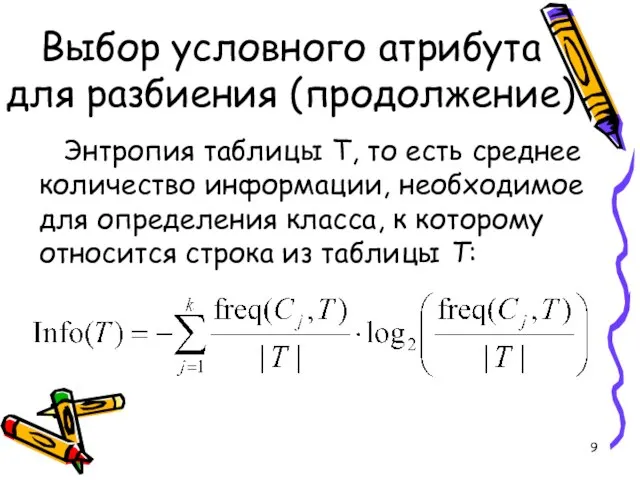

- 9. Выбор условного атрибута для разбиения (продолжение) Энтропия таблицы T, то есть среднее количество информации, необходимое для

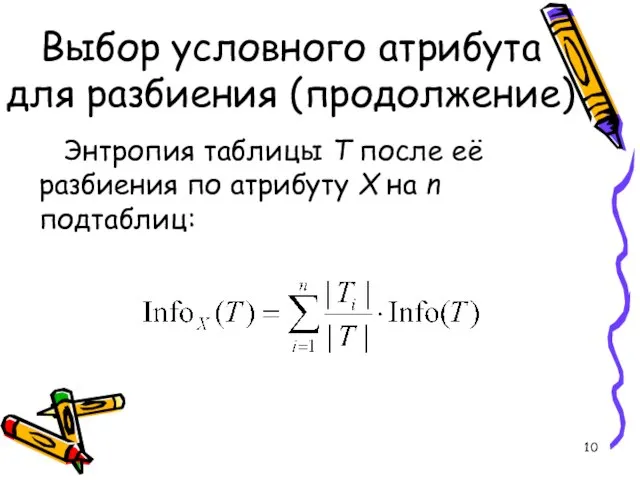

- 10. Выбор условного атрибута для разбиения (продолжение) Энтропия таблицы T после её разбиения по атрибуту X на

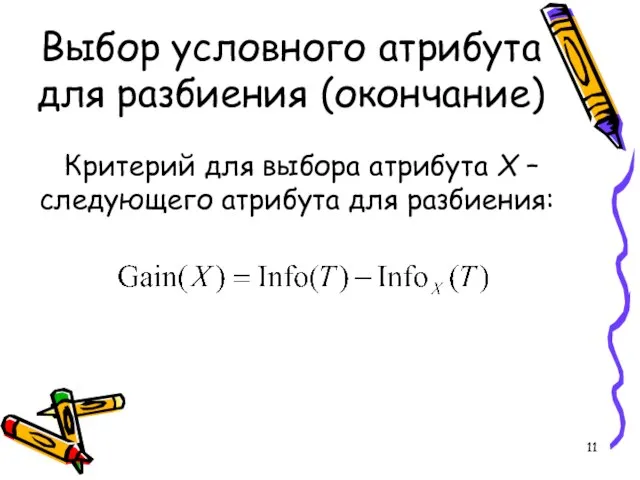

- 11. Выбор условного атрибута для разбиения (окончание) Критерий для выбора атрибута X – следующего атрибута для разбиения:

- 13. Скачать презентацию

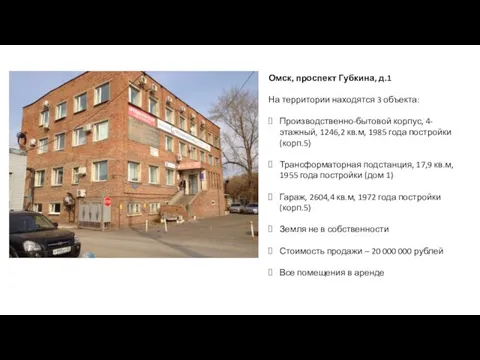

Омск, проспект Губкина, д.1

Омск, проспект Губкина, д.1 Рыжие. Поцелованные солнцем

Рыжие. Поцелованные солнцем Учитель- профессия нужная, важная, самая главная на земле

Учитель- профессия нужная, важная, самая главная на земле Смысловые уровни вещей

Смысловые уровни вещей Презентация на тему "Причины плохого поведения ребенка" - скачать презентации по Педагогике

Презентация на тему "Причины плохого поведения ребенка" - скачать презентации по Педагогике Создание презентаций на ПК

Создание презентаций на ПК Контрольная работа №1 по ЛА и АГ_нов3

Контрольная работа №1 по ЛА и АГ_нов3 aa9c82ab93914bd3847e6c12db9c6ace

aa9c82ab93914bd3847e6c12db9c6ace Задачи в жизненных ситуациях

Задачи в жизненных ситуациях КРУГЛЫЙ СТОЛ «Состояние и перспективы развития профессионального образования в Кабардино-Балкарской Республике с учётом совр

КРУГЛЫЙ СТОЛ «Состояние и перспективы развития профессионального образования в Кабардино-Балкарской Республике с учётом совр Жизнь и творчество

Жизнь и творчество prezentatsia_vkr

prezentatsia_vkr Микросотовая система KIRK 500

Микросотовая система KIRK 500 Реализация личностно-ориентированного обучения в начальной школе

Реализация личностно-ориентированного обучения в начальной школе Использование системно-деятельностнoго подхода на уроках математики

Использование системно-деятельностнoго подхода на уроках математики основная часть урока

основная часть урока Подготовила учитель истории Подготовила учитель истории МОУ Талаканской СОШ №6 Черткова Ольга Александровна

Подготовила учитель истории Подготовила учитель истории МОУ Талаканской СОШ №6 Черткова Ольга Александровна Олимпийский урок

Олимпийский урок Резюме ФИО: Иванова Дарья Абрамовна Дата рождения:10 января, 1927 Место рождения: д. Челкума

Резюме ФИО: Иванова Дарья Абрамовна Дата рождения:10 января, 1927 Место рождения: д. Челкума Управленческая мысль в эпоху Европейского средневековья

Управленческая мысль в эпоху Европейского средневековья Presentation Title

Presentation Title  Аудит бренда. Шаблон

Аудит бренда. Шаблон Обмен веществ и энергии в клетке

Обмен веществ и энергии в клетке  Презентация на тему Типы изомерии

Презентация на тему Типы изомерии Презентация на тему Законы электролиза

Презентация на тему Законы электролиза Презентация на тему Геном человека

Презентация на тему Геном человека Дорогая наша Елена Николаевна!

Дорогая наша Елена Николаевна! МОУ СОШ №4 г.Всеволожска

МОУ СОШ №4 г.Всеволожска