Содержание

- 2. Определение новизны информации Определение новизны информации – важная и нерешённая задача. Проблема в общем виде: поток

- 3. Конкретная задача Новостной кластер – набор документов по поводу некоторого события. Аннотация – краткое описание события,

- 4. Конференция TAC Создана при поддержке и спонсируется Национальным Институтом Стандартов и Технологий (NIST) и Департаментом Защиты

- 5. Постановка задачи «Обновление аннотации» в TAC - 1 Данная задача впервые была поставлена в TAC в

- 6. Постановка задачи «Обновление аннотации» в TAC - 2 То есть по сути задача делилась на две

- 7. Входные данные для задачи «Обновление аннотации» в TAC - 1 AQUAINT-2 collection New York Times Associated

- 8. Входные данные для задачи «Обновление аннотации» в TAC - 2 Специалисты NIST сделали 48 различных топиков.

- 9. Оценка результатов задачи «Обновление аннотации» в TAC Специалисты NIST сделали вручную по 4 «идеальных» аннотации к

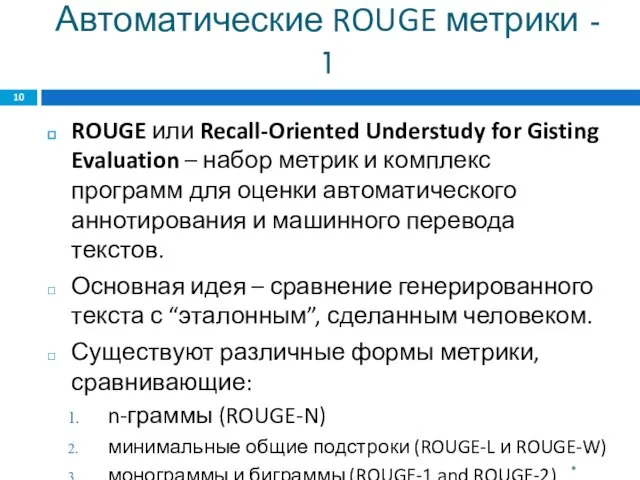

- 10. Автоматические ROUGE метрики - 1 ROUGE или Recall-Oriented Understudy for Gisting Evaluation – набор метрик и

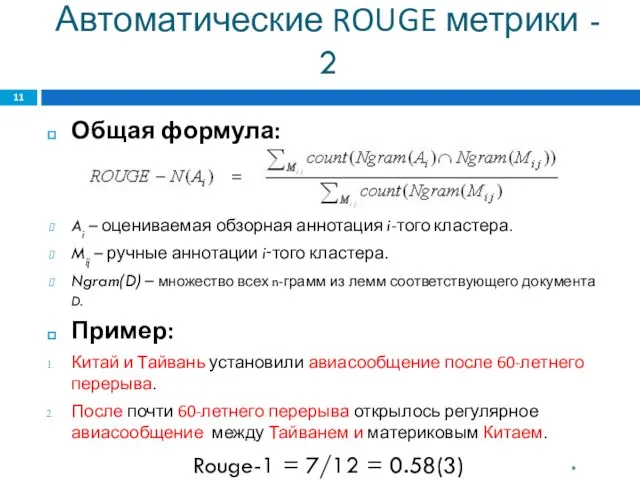

- 11. Автоматические ROUGE метрики - 2 Общая формула: Ai – оцениваемая обзорная аннотация i-того кластера. Mij –

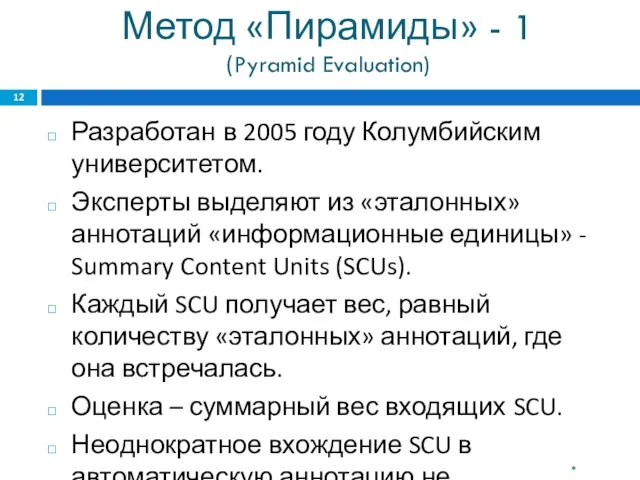

- 12. Метод «Пирамиды» - 1 (Pyramid Evaluation) Разработан в 2005 году Колумбийским университетом. Эксперты выделяют из «эталонных»

- 13. Метод «Пирамиды» - 2 (Pyramid Evaluation) Итоговый результат: [Суммарный вес найденных SCU] [ Суммарный вес всех

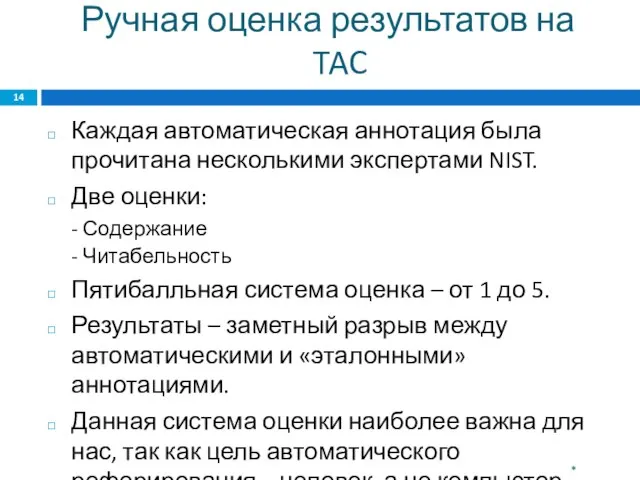

- 14. Ручная оценка результатов на TAC Каждая автоматическая аннотация была прочитана несколькими экспертами NIST. Две оценки: -

- 15. Сравнение методов оценки ROUGE: + Малое участие человека, лёгкость применения - Отсутствие оценки читабельности, результат не

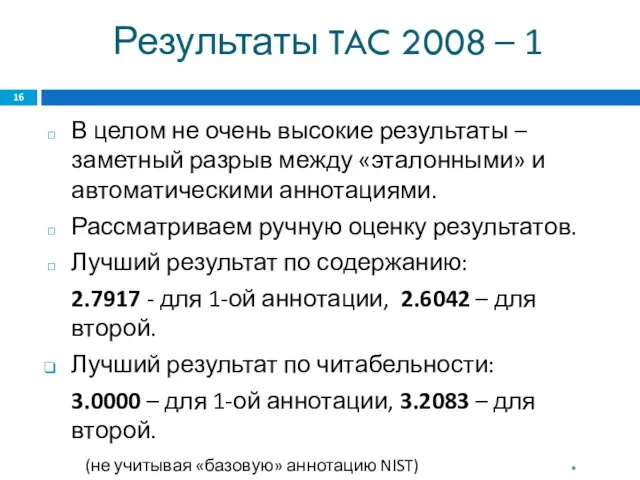

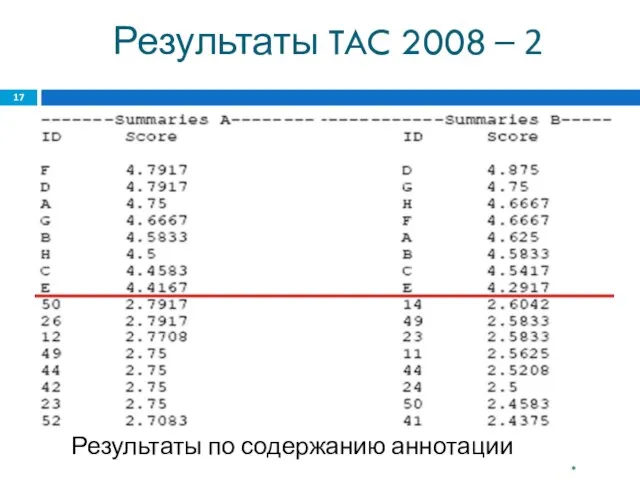

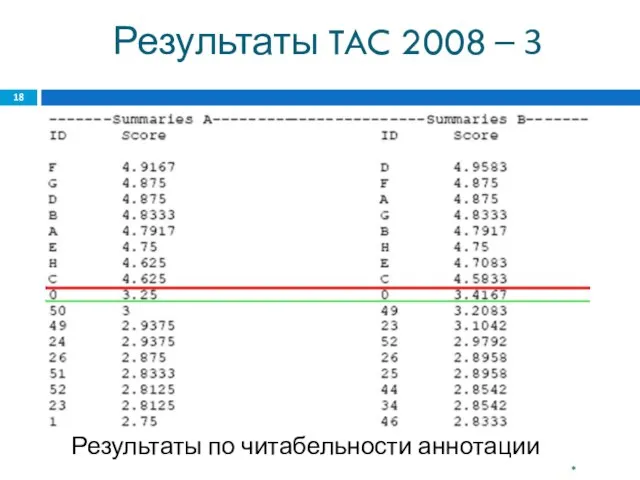

- 16. Результаты TAC 2008 – 1 В целом не очень высокие результаты – заметный разрыв между «эталонными»

- 17. Результаты TAC 2008 – 2 Худшие результаты ~ 1.2000. Результаты по содержанию аннотации *

- 18. Результаты TAC 2008 – 3 Худшие результаты ~ 1.2000. Результаты по читабельности аннотации *

- 19. Анализ результатов TAC 2008 Одна из лучших – система канадского университета Монтреаль для франкоговорящих. (Universit´e de

- 20. Maximal Marginal Relevance (MMR) - 1 Итеративный метод. На каждой итерации производится ранжирование предложений-кандидатов. В итоговую

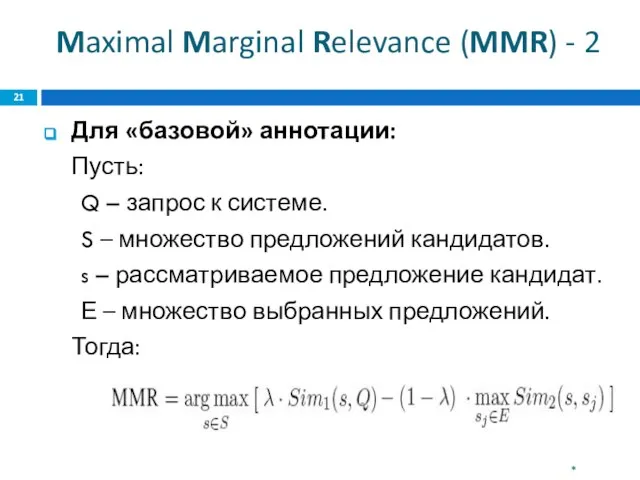

- 21. Maximal Marginal Relevance (MMR) - 2 Для «базовой» аннотации: Пусть: Q – запрос к системе. S

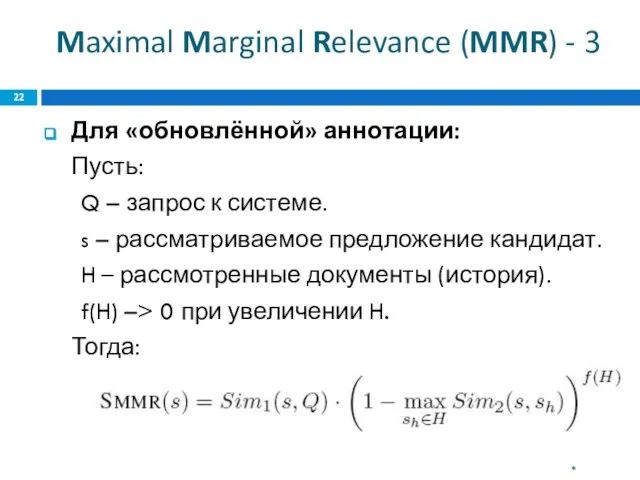

- 22. Maximal Marginal Relevance (MMR) - 3 Для «обновлённой» аннотации: Пусть: Q – запрос к системе. s

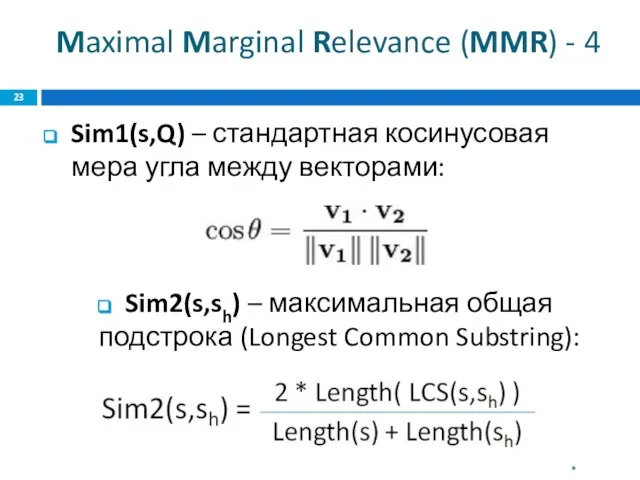

- 23. Maximal Marginal Relevance (MMR) - 4 Sim1(s,Q) – стандартная косинусовая мера угла между векторами: Sim2(s,sh) –

- 24. Постпроцессинг (Post-processing) После отбора предложений производится улучшение связности и читаемости аннотации: Замена аббревиатур Приведение номеров и

- 25. Направление дальнейшей работы Поиск принципиально иных подходов к созданию «обновлённой» аннотации. Реализация существующих подходов с целью

- 27. Скачать презентацию

![Метод «Пирамиды» - 2 (Pyramid Evaluation) Итоговый результат: [Суммарный вес найденных SCU]](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/388072/slide-12.jpg)

Аральское море

Аральское море Социальная психология

Социальная психология Педагогические Lookи

Педагогические Lookи Фізика754

Фізика754 Презентация на тему Равнодействующая сила

Презентация на тему Равнодействующая сила  Духовно – нравственные основы развития личности

Духовно – нравственные основы развития личности Мариинский театр. Владивосток

Мариинский театр. Владивосток Будни и праздники начальной школы

Будни и праздники начальной школы Каша во рту

Каша во рту Добро, ласка, поощрение, требовательность, твердость, ограничение желаний в воспитании детей

Добро, ласка, поощрение, требовательность, твердость, ограничение желаний в воспитании детей Жизнь прожить – не поле перейти, или «Этапы большого пути»

Жизнь прожить – не поле перейти, или «Этапы большого пути» Механизм сборки ящиков

Механизм сборки ящиков « Распространение Реформации в Европе. Контрреформация»

« Распространение Реформации в Европе. Контрреформация» ПОЧЕМУ НУЖНО РАЦИОНАЛЬНО ИСПОЛЬЗОВАТЬ ЭНЕРГЕТИЧЕСКИЕ РЕСУРСЫ?

ПОЧЕМУ НУЖНО РАЦИОНАЛЬНО ИСПОЛЬЗОВАТЬ ЭНЕРГЕТИЧЕСКИЕ РЕСУРСЫ? Климат Тверской области

Климат Тверской области Мониторинг социальных настроений населения стран постсоветского пространства ЕМ-VI. Предварительные результаты 1 Проект «Евразий

Мониторинг социальных настроений населения стран постсоветского пространства ЕМ-VI. Предварительные результаты 1 Проект «Евразий Информационные компьютерные технологии в практике логопеда

Информационные компьютерные технологии в практике логопеда Презентация на тему путешествие Афанасия НИКИТИНА В ИНДИЮ 1466-1472

Презентация на тему путешествие Афанасия НИКИТИНА В ИНДИЮ 1466-1472  Конституция Российской Федерации

Конституция Российской Федерации Комедия А.С. Грибоедова «Горе от ума». Поэтика заглавия пьесы

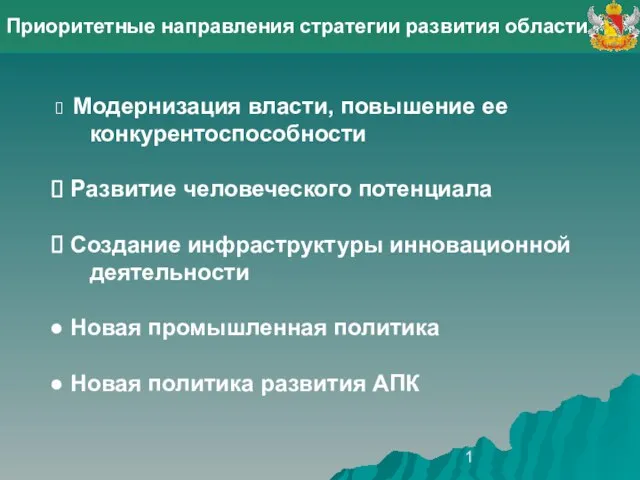

Комедия А.С. Грибоедова «Горе от ума». Поэтика заглавия пьесы 1 Приоритетные направления стратегии развития области Модернизация власти, повышение ее конкурентоспособности Развитие человече

1 Приоритетные направления стратегии развития области Модернизация власти, повышение ее конкурентоспособности Развитие человече К. Паустовский Барсучий нос

К. Паустовский Барсучий нос Генетика человека

Генетика человека Maryinsky Park

Maryinsky Park Техническая эксплуатация и обслуживание электрического и электромеханического оборудования

Техническая эксплуатация и обслуживание электрического и электромеханического оборудования Из серии " 100 великих картин "

Из серии " 100 великих картин " Искусство эпохи. Возрождения Проторенессанс. Ранний Ренессанс

Искусство эпохи. Возрождения Проторенессанс. Ранний Ренессанс Простейший ремонт сантехнического оборудования

Простейший ремонт сантехнического оборудования