Исследование ускорения вычислений параллельных реализаций метода конечных элементов для уравнений мелкой воды

Содержание

- 2. Подготовка входных данных о сетках и триангуляции для расчетов на многопроцессорной ВС. Анализ ускорения и эффективности

- 3. В данной работе: было проведено исследование эффективности распараллеливания метода конечных элементов для решения краевой задачи для

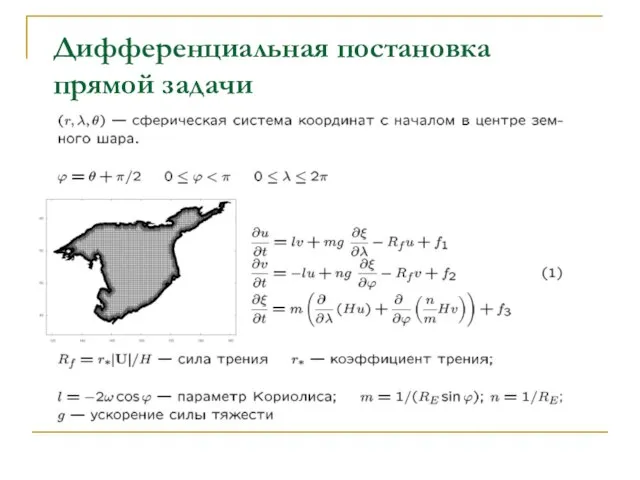

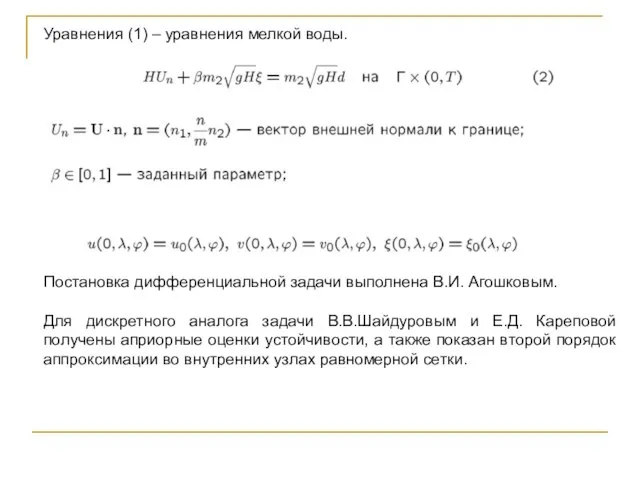

- 4. Дифференциальная постановка прямой задачи

- 5. Уравнения (1) – уравнения мелкой воды. Постановка дифференциальной задачи выполнена В.И. Агошковым. Для дискретного аналога задачи

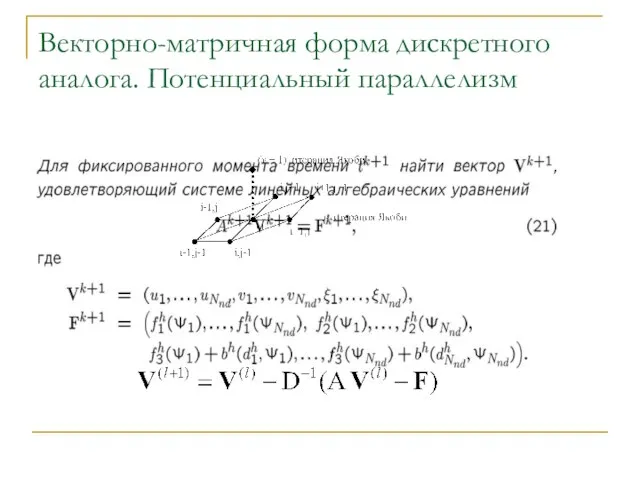

- 6. Векторно-матричная форма дискретного аналога. Потенциальный параллелизм

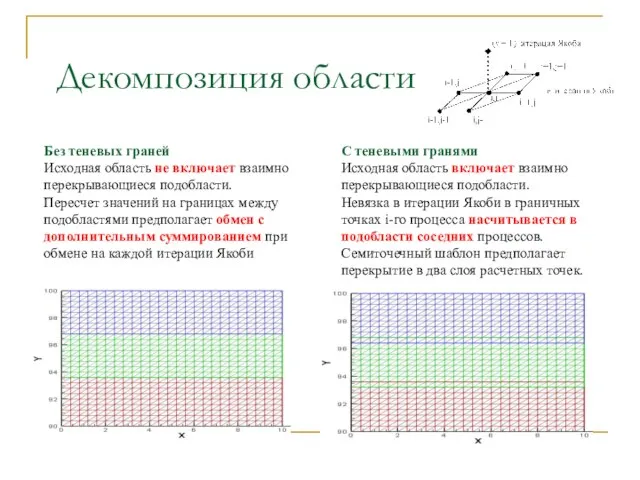

- 7. Декомпозиция области Без теневых граней Исходная область не включает взаимно перекрывающиеся подобласти. Пересчет значений на границах

- 8. Однородное распределение данных по компьютерам Баланса времени затрачиваемого на вычисления затрачиваемого на взаимодействия ветвей параллельной программы

- 9. Программа распределения данных по процессам Написана на языке программирования С На входе файл, описывающий сетку координат

- 10. Отметим, что поскольку декомпозиция с теневыми гранями на P процессов требует дополнительного хранения в каждой граничной

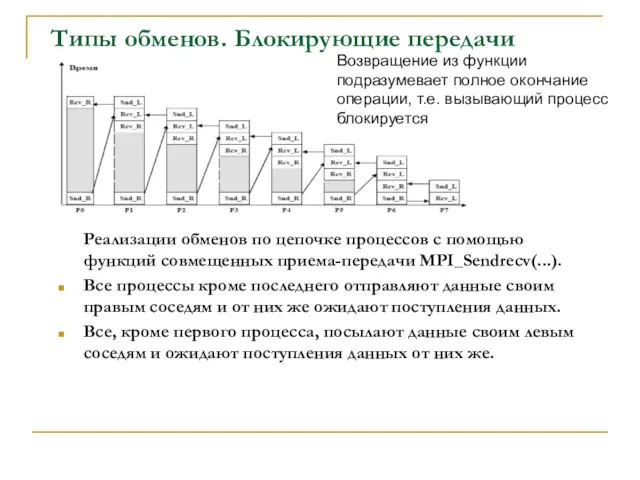

- 11. Типы обменов. Блокирующие передачи Реализации обменов по цепочке процессов с помощью функций совмещенных приема-передачи MPI_Sendrecv(...). Все

- 12. Типы обменов. Неблокирующие передачи Неблокирующие функции подразумевают совмещение операций обмена с другими операциями Время, затрачиваемое на

- 13. Численные эксперименты

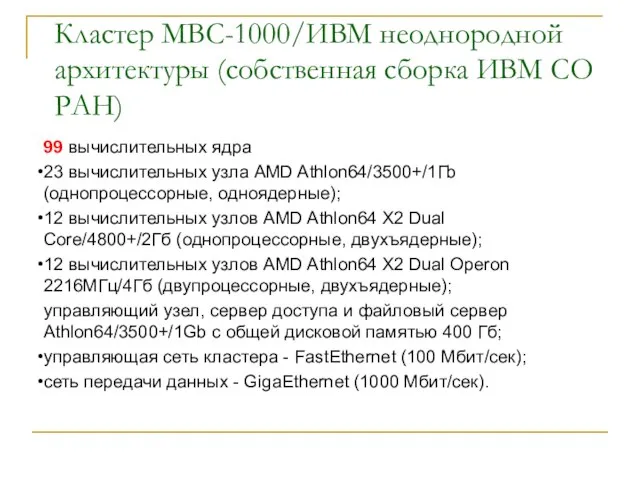

- 14. Кластер МВС-1000/ИВМ неоднородной архитектуры (собственная сборка ИВМ СО РАН) 99 вычислительных ядра 23 вычислительных узла AMD

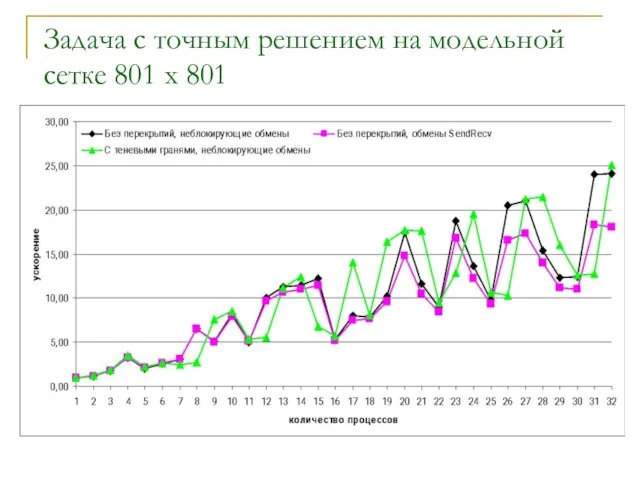

- 15. Задача с точным решением на модельной сетке 801 x 801

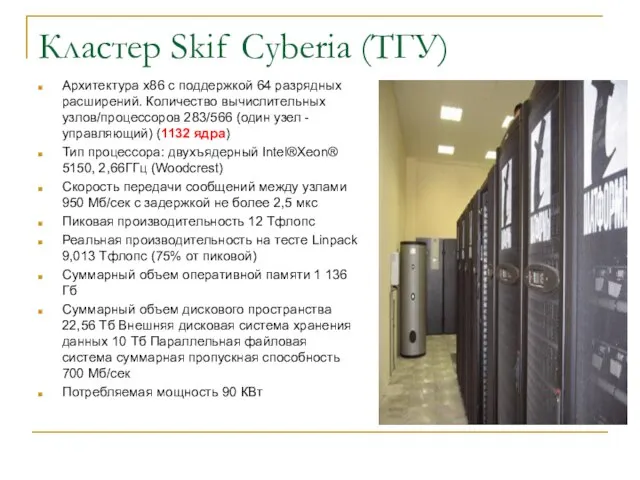

- 16. Кластер Skif Cyberia (ТГУ) Архитектура x86 с поддержкой 64 разрядных расширений. Количество вычислительных узлов/процессоров 283/566 (один

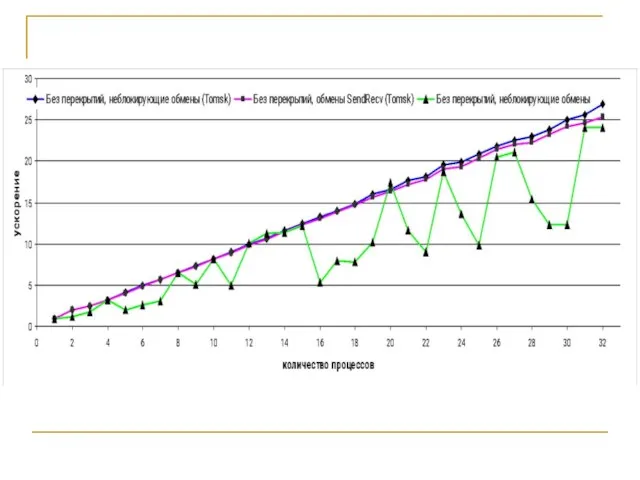

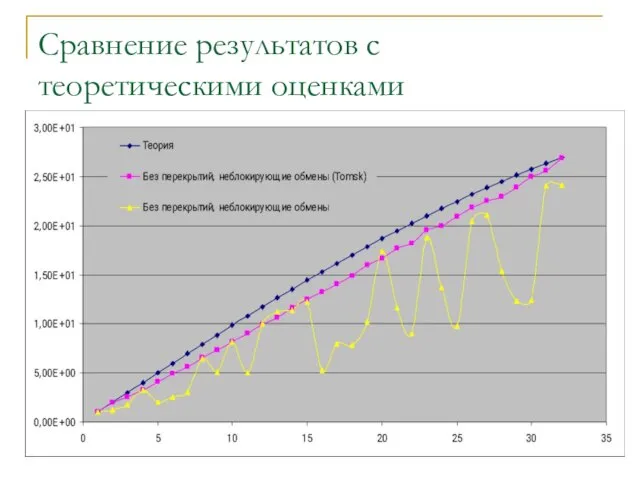

- 18. Сравнение результатов с теоретическими оценками

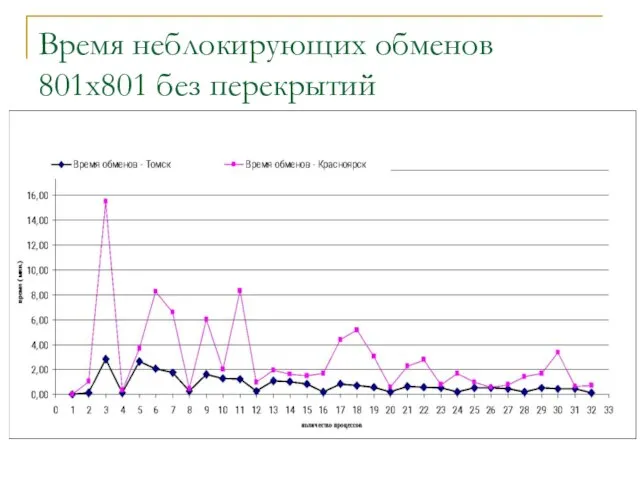

- 19. Время неблокирующих обменов 801x801 без перекрытий

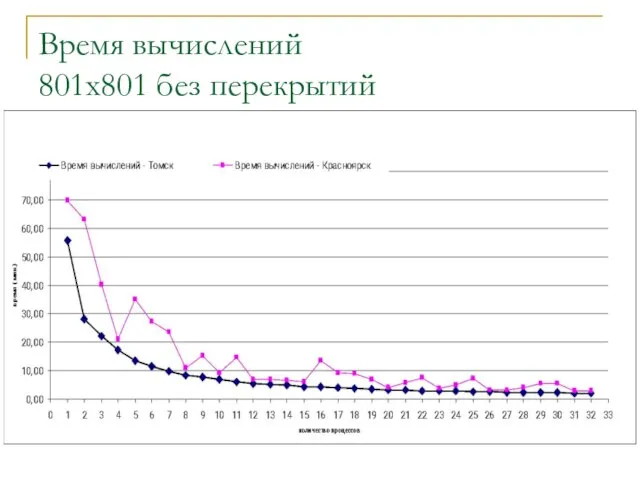

- 20. Время вычислений 801x801 без перекрытий

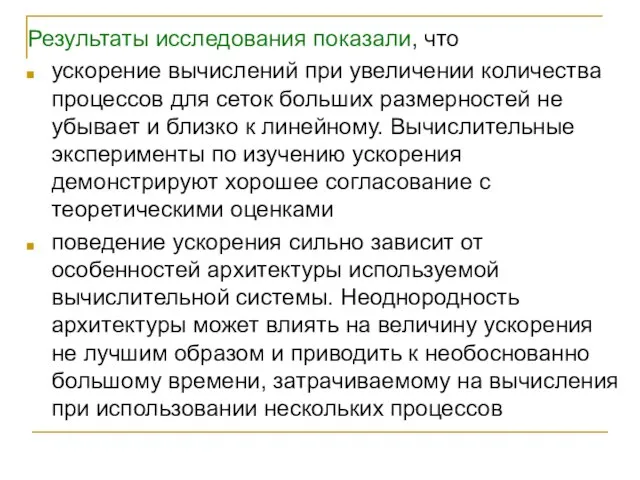

- 21. Результаты исследования показали, что ускорение вычислений при увеличении количества процессов для сеток больших размерностей не убывает

- 23. Скачать презентацию

Органы путевой стабилизации и управления маневренных самолётов и беспилотных летательных аппаратов

Органы путевой стабилизации и управления маневренных самолётов и беспилотных летательных аппаратов Мультипликационные герои

Мультипликационные герои Всемирный день правовой помощи детям

Всемирный день правовой помощи детям Музыкальная живопись и живописная музыка

Музыкальная живопись и живописная музыка игра кузя

игра кузя game-4

game-4 Отчёт о работе отдела продаж за май

Отчёт о работе отдела продаж за май Акеда. Воля и попущение

Акеда. Воля и попущение Суффикс и его роль в слове

Суффикс и его роль в слове УФК по Оренбургской области Внедрение системы ключевых показателей эффективности исполнения бюджетов бюджетной системы Российс

УФК по Оренбургской области Внедрение системы ключевых показателей эффективности исполнения бюджетов бюджетной системы Российс Презентация на тему Изменчивость Мутации

Презентация на тему Изменчивость Мутации Основной закон - основа жизни

Основной закон - основа жизни ...В слове МЫ сто тысяч Я.

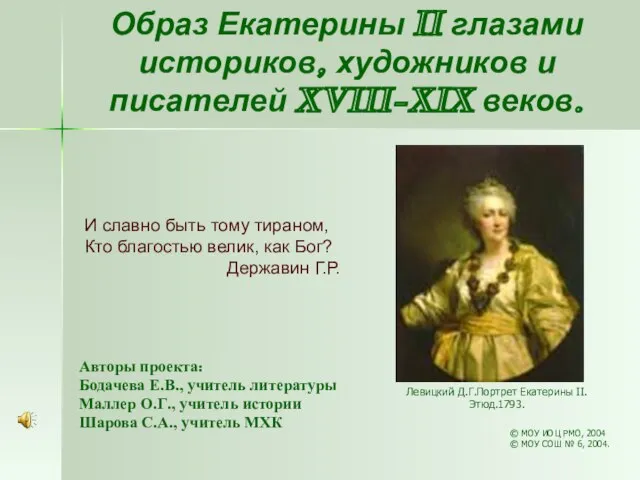

...В слове МЫ сто тысяч Я. Образ Екатерины II глазами историков, художников и писателей XVIII-XIX веков

Образ Екатерины II глазами историков, художников и писателей XVIII-XIX веков ФОРМИРОВАНИЕ ИНСТИТУТОВ РИСК-МЕНЕДЖМЕНТА В КОРПОРАЦИЯХ: ПРОБЛЕМЫ И ПЕРСПЕКТИВЫ Роман Качалов ЦЭМИ РАН 07 апреля 2010 XI Международн

ФОРМИРОВАНИЕ ИНСТИТУТОВ РИСК-МЕНЕДЖМЕНТА В КОРПОРАЦИЯХ: ПРОБЛЕМЫ И ПЕРСПЕКТИВЫ Роман Качалов ЦЭМИ РАН 07 апреля 2010 XI Международн Как начать спокойную жизнь, без мыслей о тревоге, панических атаках и страхах

Как начать спокойную жизнь, без мыслей о тревоге, панических атаках и страхах Из опыта работы по реализации программы математического кружка «Решение олимпиадных задач»

Из опыта работы по реализации программы математического кружка «Решение олимпиадных задач» ОБРЯДЫ И ВЕРОВАНИЯ, СВЯЗАННЫЕС ПОСТРОЙКОЙ И ЗАСЕЛЕНИЕМ ДОМА.ОБЕРЕГИ СЕВЕРНОЙ ИЗБЫ

ОБРЯДЫ И ВЕРОВАНИЯ, СВЯЗАННЫЕС ПОСТРОЙКОЙ И ЗАСЕЛЕНИЕМ ДОМА.ОБЕРЕГИ СЕВЕРНОЙ ИЗБЫ Так ли безобидна кнопка?

Так ли безобидна кнопка? День Героев Отечества

День Героев Отечества Баллада о влюбленном Павуке. Синопсис. Игра для одного человека

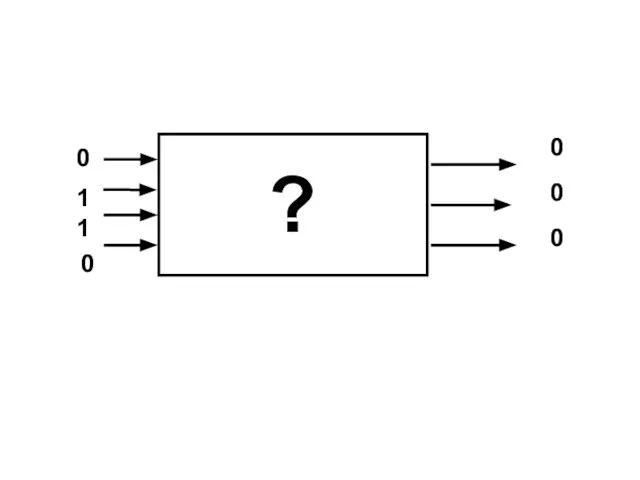

Баллада о влюбленном Павуке. Синопсис. Игра для одного человека 0 0 0 1 1 0 ? 01 1 0 1 1 0 ? 1Простое высказывание – повествовательное предложение, принимающее одно из двух возможных значений – истина или

0 0 0 1 1 0 ? 01 1 0 1 1 0 ? 1Простое высказывание – повествовательное предложение, принимающее одно из двух возможных значений – истина или  Унҗиденче март. Билгеле үткән заман хикәя фигыль

Унҗиденче март. Билгеле үткән заман хикәя фигыль Рельеф территории России

Рельеф территории России Динамика твердого тела

Динамика твердого тела 25 000 000 5 000 000 58% аудитории старше 25 лет TNS Web Index Report, сентябрь 2010.

25 000 000 5 000 000 58% аудитории старше 25 лет TNS Web Index Report, сентябрь 2010. Бизнес-планирование

Бизнес-планирование Институт филологии, иностранных языков и массовых коммуникаций

Институт филологии, иностранных языков и массовых коммуникаций