- Главная

- Разное

- Лекции: 60 часов. Лектор: В.П. Ипатов Email: [email protected] Упражнения и демонстрации: 20часов.

Содержание

- 2. Основные положения лекций

- 3. Лекция 1

- 4. Источник Обобщенные модели систем передачи и хранения информации Передатчик Приемник Получатель Среда распространения Источник Получатель Память

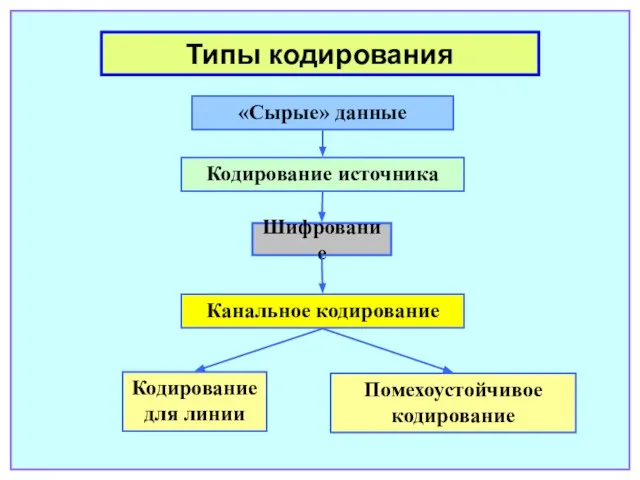

- 5. Типы кодирования «Сырые» данные Кодирование источника Канальное кодирование Шифрование Кодирование для линии Помехоустойчивое кодирование

- 6. Обобщенная модель системы передачи информации Декодер источника Дешифратор Декодер канала Демодулятор К получателю Передатчик Приемник

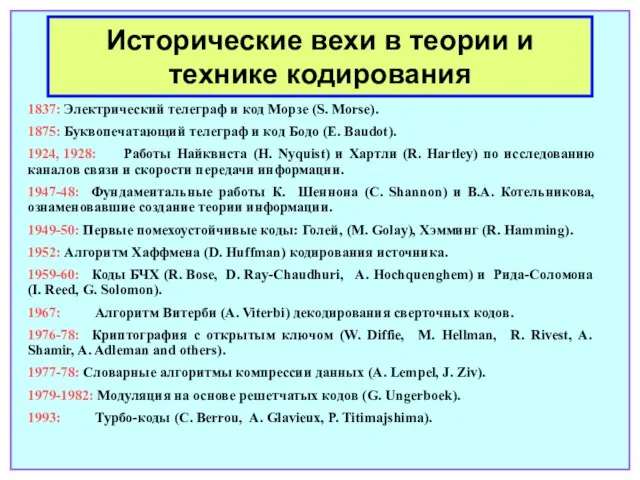

- 7. Исторические вехи в теории и технике кодирования 1837: Электрический телеграф и код Морзе (S. Morse). 1875:

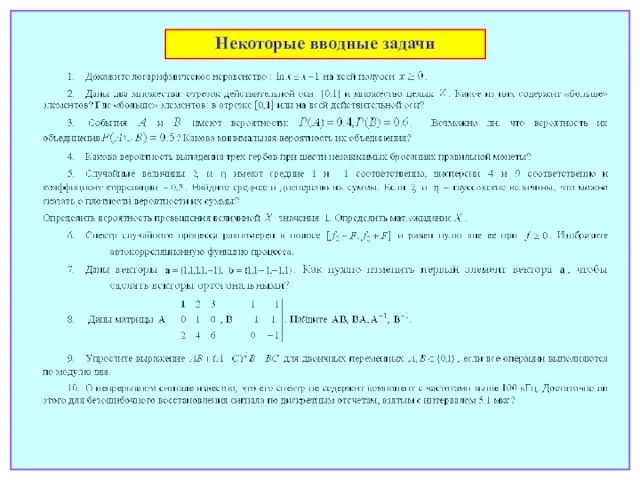

- 8. Некоторые вводные задачи

- 9. Лекция 2

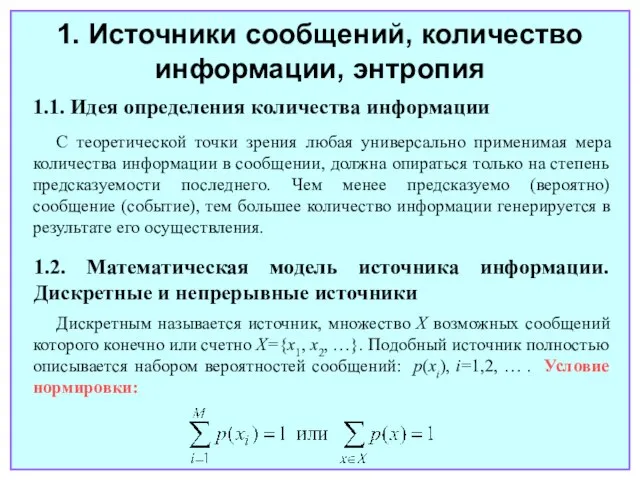

- 10. 1. Источники сообщений, количество информации, энтропия 1.1. Идея определения количества информации С теоретической точки зрения любая

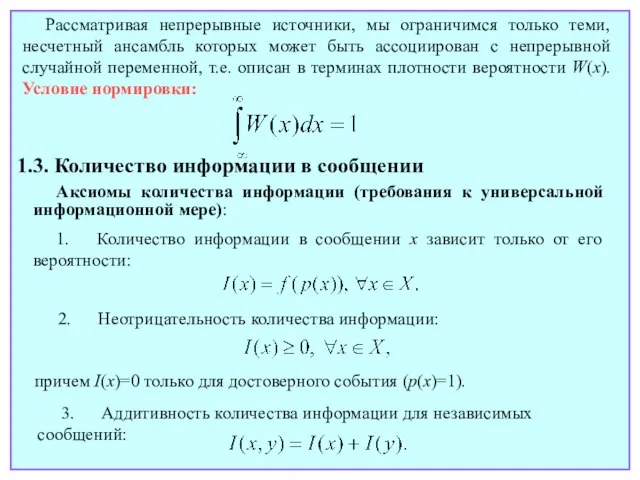

- 11. Рассматривая непрерывные источники, мы ограничимся только теми, несчетный ансамбль которых может быть ассоциирован с непрерывной случайной

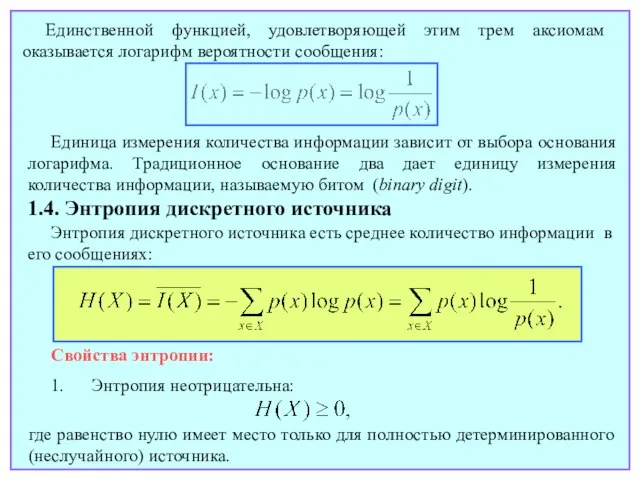

- 12. Единственной функцией, удовлетворяющей этим трем аксиомам оказывается логарифм вероятности сообщения: 1.4. Энтропия дискретного источника Энтропия дискретного

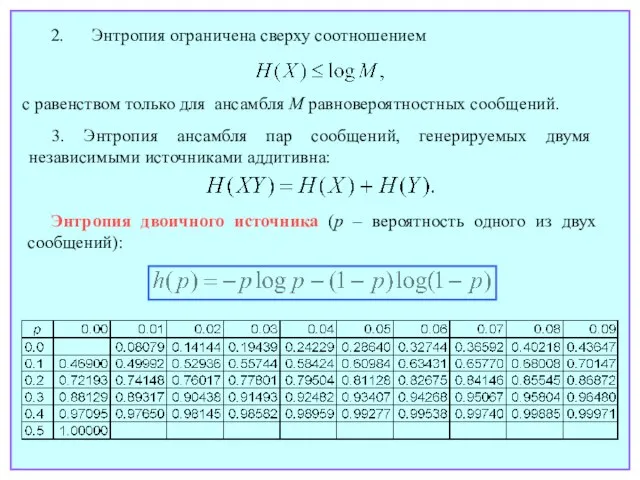

- 13. 2. Энтропия ограничена сверху соотношением 3. Энтропия ансамбля пар сообщений, генерируемых двумя независимыми источниками аддитивна: Энтропия

- 14. Энтропия двоичного источника в зависимости от p

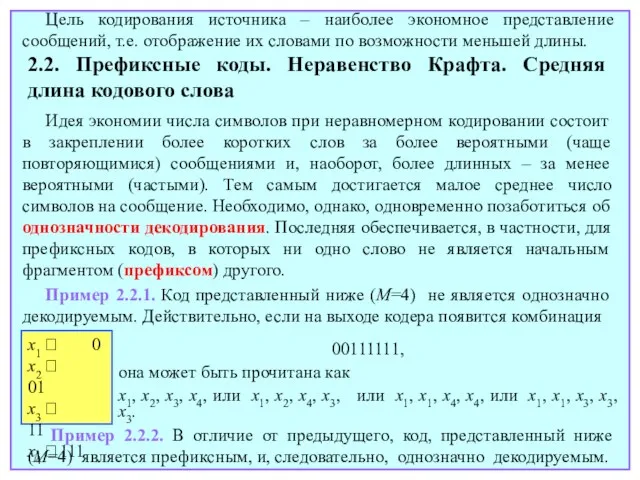

- 15. Лекция 3

- 16. Источник Кодер источника Сообщения (буквы, блоки и т.п.) Кодовые слова 2. Кодирование источника 2.1. Основные определения

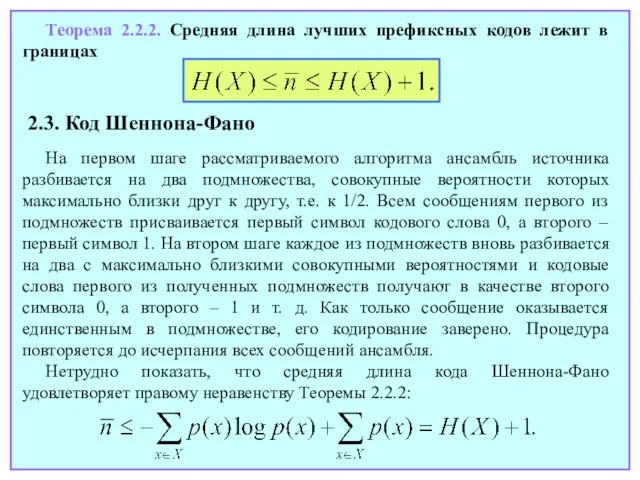

- 17. 2.2. Префиксные коды. Неравенство Крафта. Средняя длина кодового слова Идея экономии числа символов при неравномерном кодировании

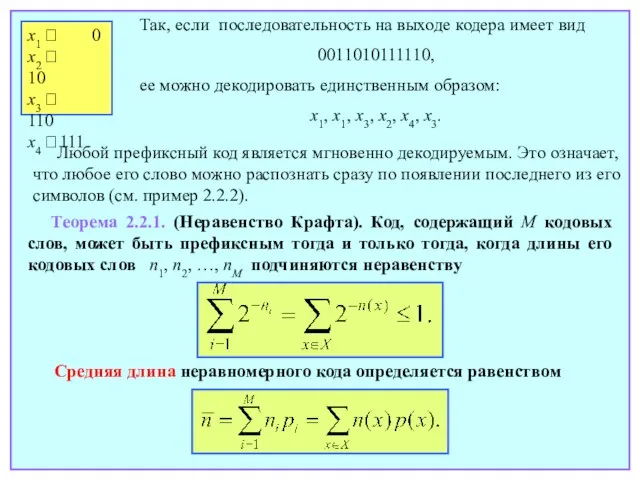

- 18. x1 ⭢ 0 x2 ⭢ 10 x3 ⭢ 110 x4 ⭢ 111 Так, если последовательность на

- 19. Теорема 2.2.2. Средняя длина лучших префиксных кодов лежит в границах 2.3. Код Шеннона-Фано На первом шаге

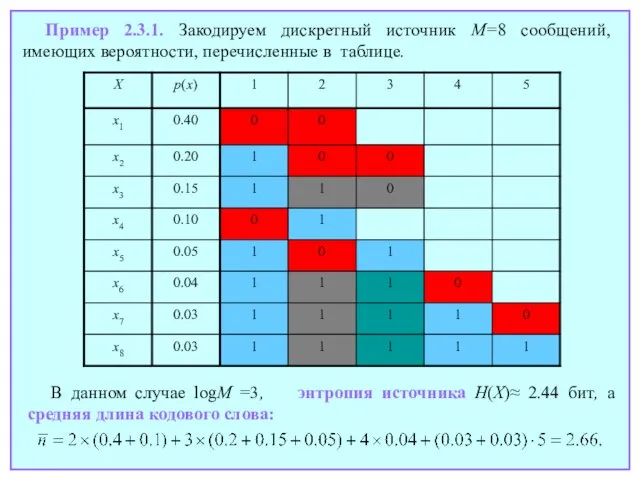

- 20. Пример 2.3.1. Закодируем дискретный источник M=8 сообщений, имеющих вероятности, перечисленные в таблице. В данном случае logM

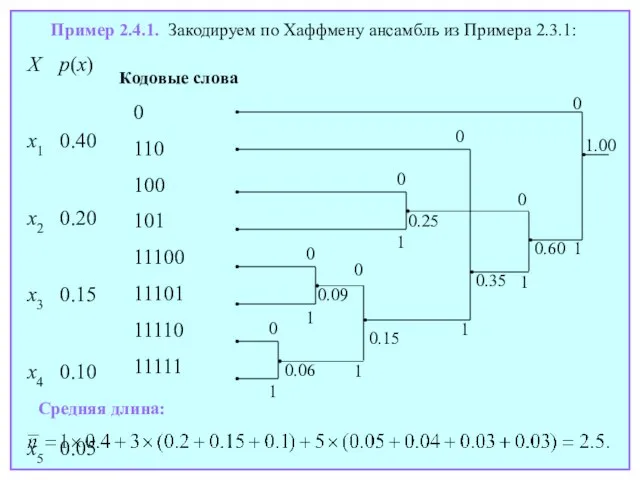

- 21. Лекция 4

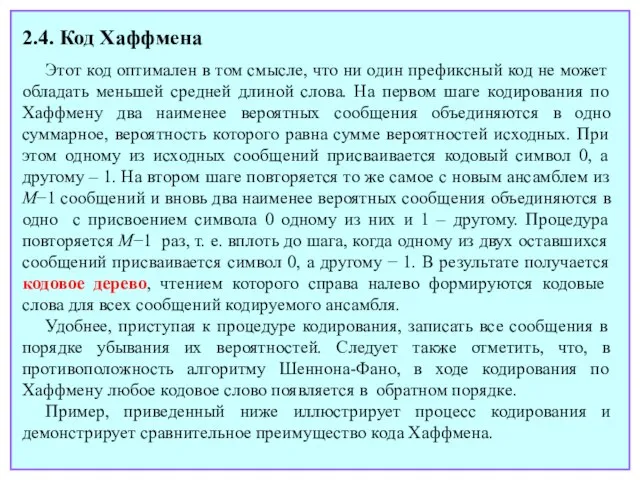

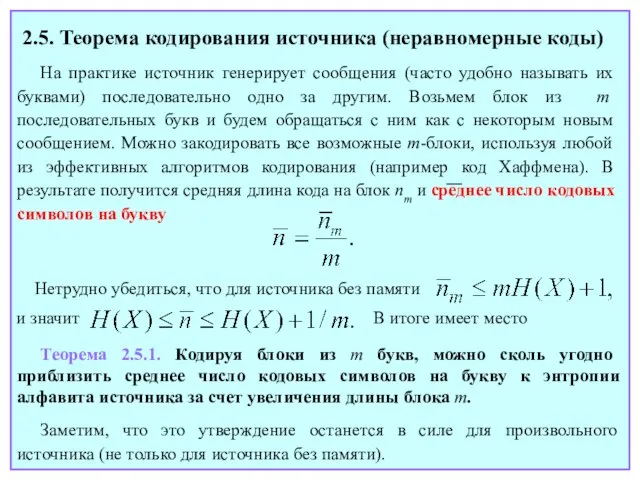

- 22. 2.4. Код Хаффмена Этот код оптимален в том смысле, что ни один префиксный код не может

- 23. Пример 2.4.1. Закодируем по Хаффмену ансамбль из Примера 2.3.1: X p(x) x1 0.40 x2 0.20 x3

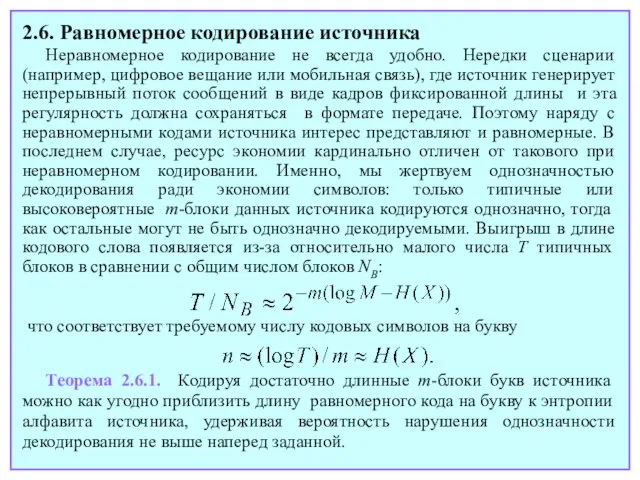

- 24. На практике источник генерирует сообщения (часто удобно называть их буквами) последовательно одно за другим. Возьмем блок

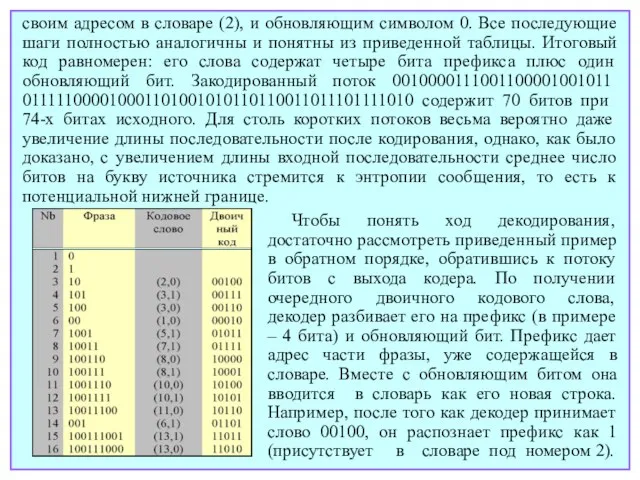

- 25. 2.6. Равномерное кодирование источника Неравномерное кодирование не всегда удобно. Нередки сценарии (например, цифровое вещание или мобильная

- 26. 2.7. Словарные коды. Алгоритм Лемпеля-Зива Рассмотренные ранее методы кодирования источника опираются на априорное знание вероятностей всех

- 27. своим адресом в словаре (2), и обновляющим символом 0. Все последующие шаги полностью аналогичны и понятны

- 28. Наряду с обновляющим символом 0 это дает новый вход словаря для фразы 10, помещаемой в третьей

- 29. Лекция 5

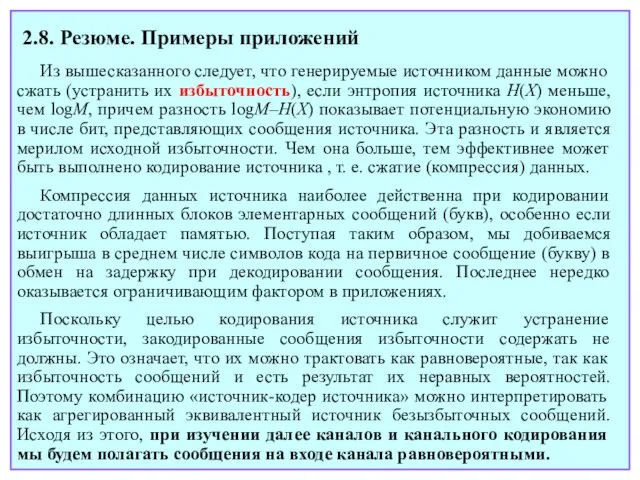

- 30. 2.8. Резюме. Примеры приложений Из вышесказанного следует, что генерируемые источником данные можно сжать (устранить их избыточность),

- 31. В настоящее время широко применяются как равномерное, так и неравномерное кодирование источника. Коды Хаффмена, например, входят

- 32. Многообразны и поучительны примеры применения методов адаптивного сжатия данных в кодировании речи, цифровом вещании, мобильных телефонах

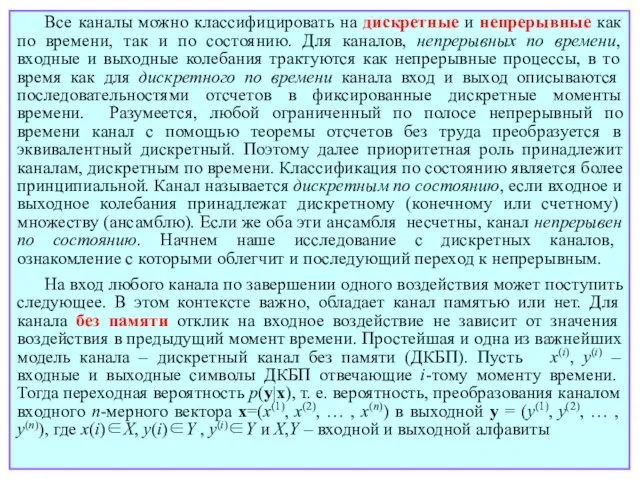

- 33. В стандартах мобильной связи GSM, IS-95 и 3G используются вокодеры типов VSELP (vector-sum excited linear prediction

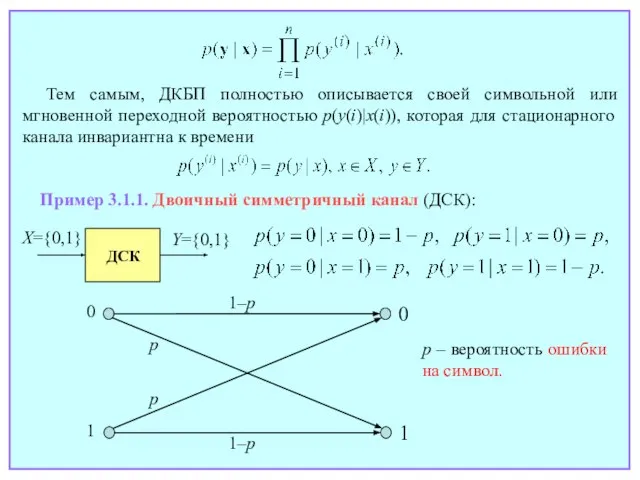

- 34. 3. Взаимная информация. Пропускная способность канала. Теоремы кодирования для канала 3.1. Математическое описание канала связи. Дискретный

- 35. Все каналы можно классифицировать на дискретные и непрерывные как по времени, так и по состоянию. Для

- 36. Пример 3.1.1. Двоичный симметричный канал (ДСК): p – вероятность ошибки на символ. Тем самым, ДКБП полностью

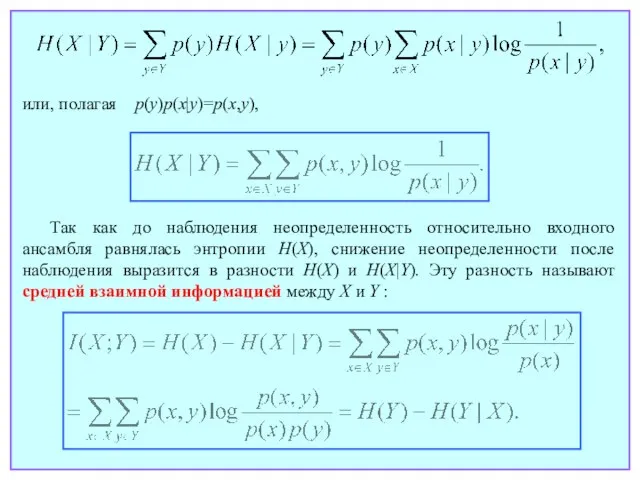

- 37. Лекция 6

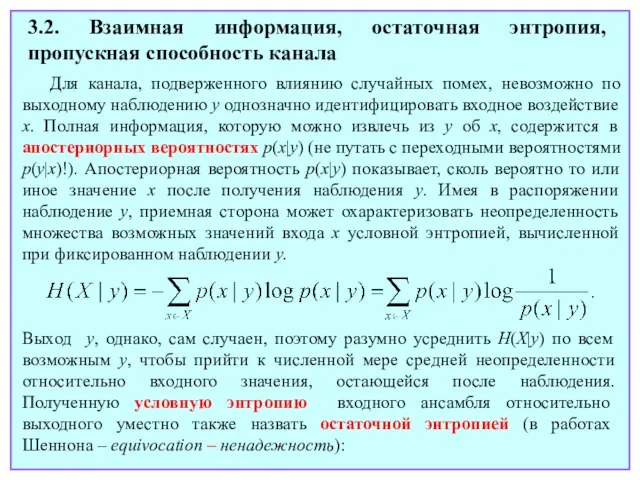

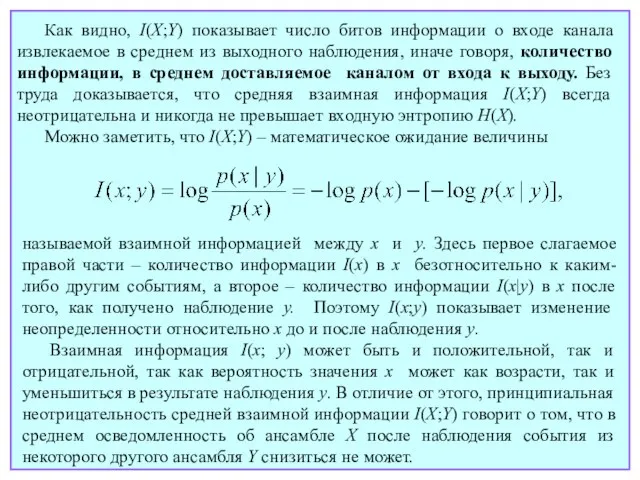

- 38. 3.2. Взаимная информация, остаточная энтропия, пропускная способность канала Для канала, подверженного влиянию случайных помех, невозможно по

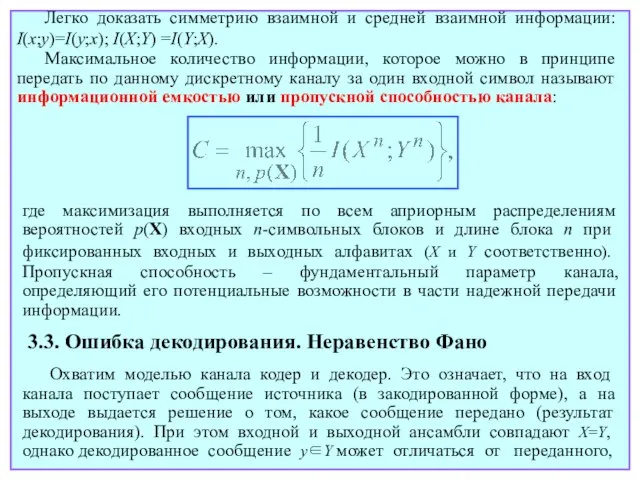

- 39. или, полагая p(y)p(x|y)=p(x,y), Так как до наблюдения неопределенность относительно входного ансамбля равнялась энтропии H(X), снижение неопределенности

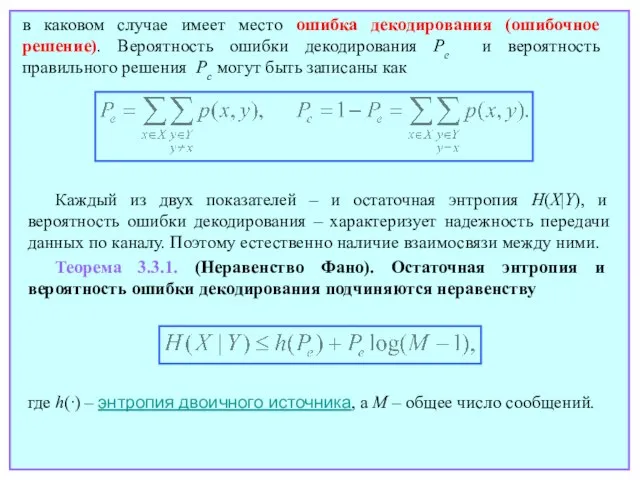

- 40. Как видно, I(X;Y) показывает число битов информации о входе канала извлекаемое в среднем из выходного наблюдения,

- 41. Легко доказать симметрию взаимной и средней взаимной информации: I(x;y)=I(y;x); I(X;Y) =I(Y;X). Максимальное количество информации, которое можно

- 42. в каковом случае имеет место ошибка декодирования (ошибочное решение). Вероятность ошибки декодирования Pe и вероятность правильного

- 43. Лекция 7

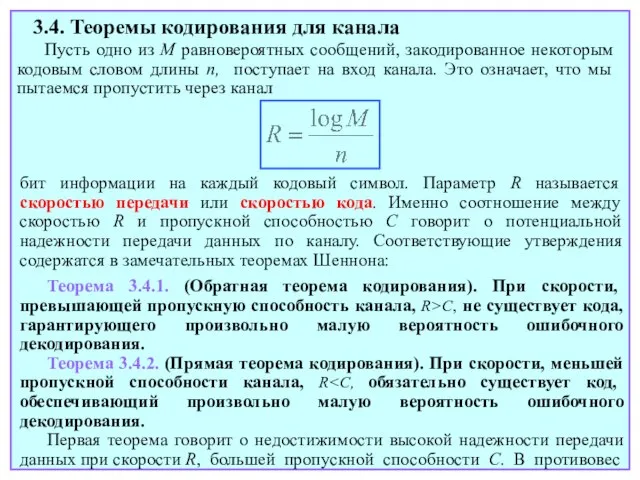

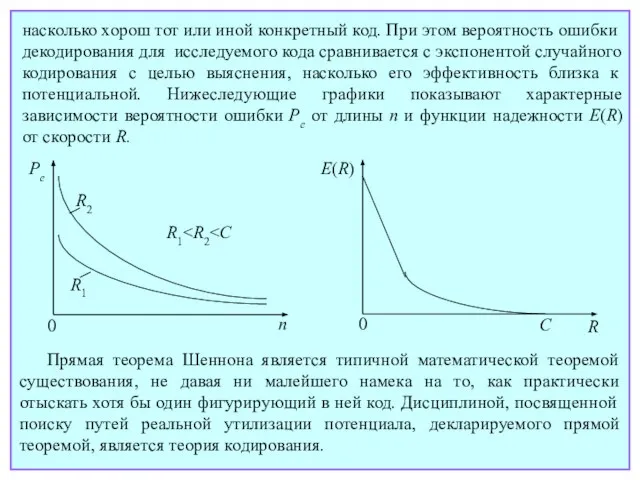

- 44. 3.4. Теоремы кодирования для канала Пусть одно из M равновероятных сообщений, закодированное некоторым кодовым словом длины

- 45. этому, если скорость R меньше емкости канала C, в принципе всегда можно передавать данные с любой

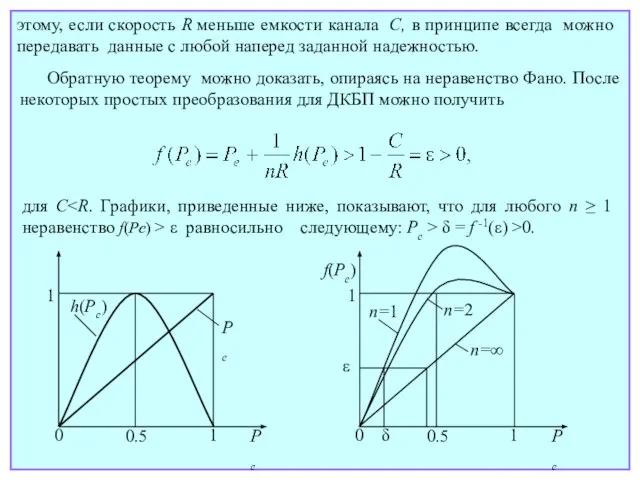

- 46. В отличие от обратной, доказательство прямой теоремы для общей модели канала без памяти достаточно трудоемко. Оно

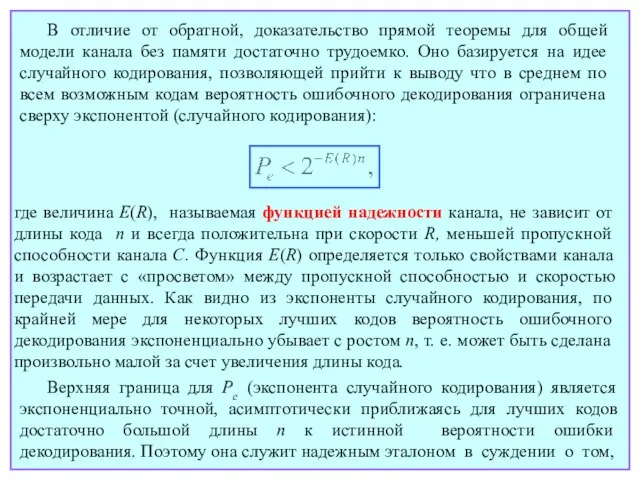

- 47. Прямая теорема Шеннона является типичной математической теоремой существования, не давая ни малейшего намека на то, как

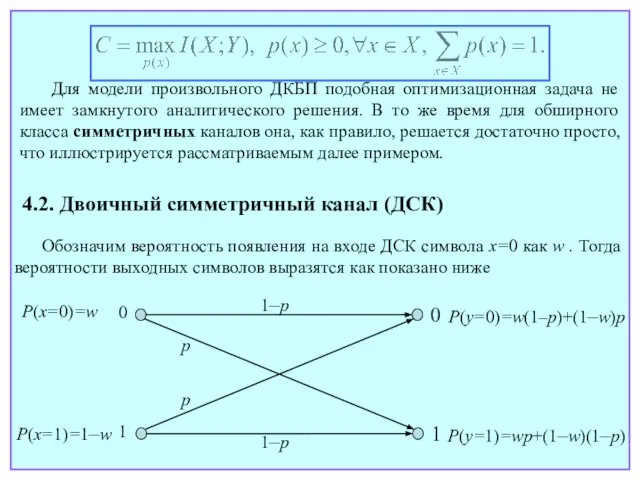

- 48. Лекция 8

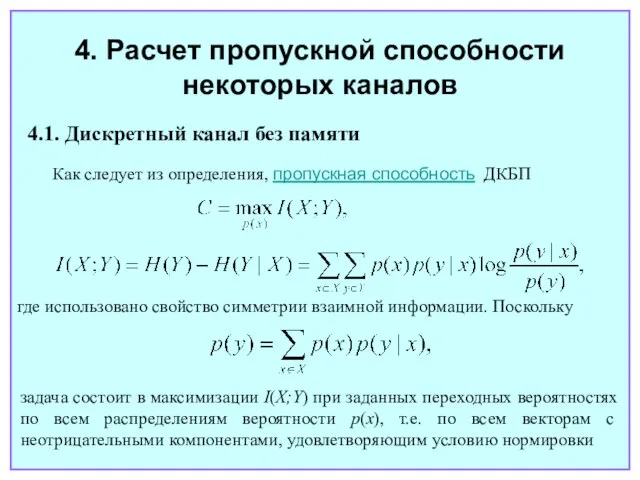

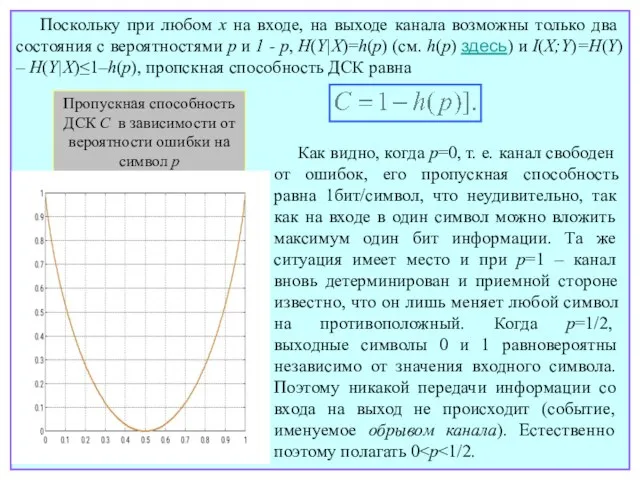

- 49. 4. Расчет пропускной способности некоторых каналов 4.1. Дискретный канал без памяти Как следует из определения, пропускная

- 50. Для модели произвольного ДКБП подобная оптимизационная задача не имеет замкнутого аналитического решения. В то же время

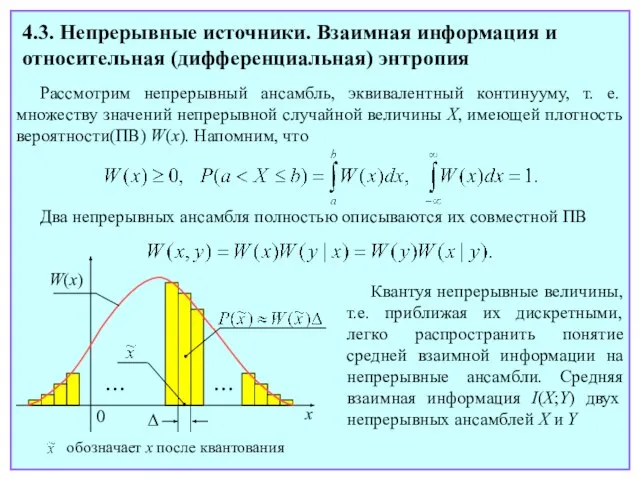

- 51. Поскольку при любом x на входе, на выходе канала возможны только два состояния с вероятностями p

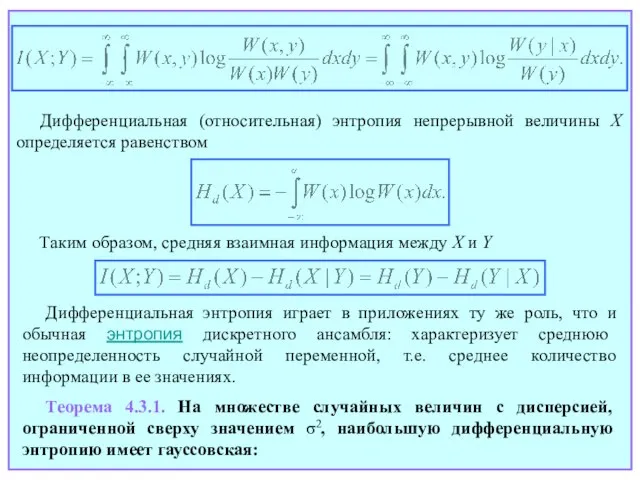

- 52. Лекция 9

- 53. 4.3. Непрерывные источники. Взаимная информация и относительная (дифференциальная) энтропия Рассмотрим непрерывный ансамбль, эквивалентный континууму, т. е.

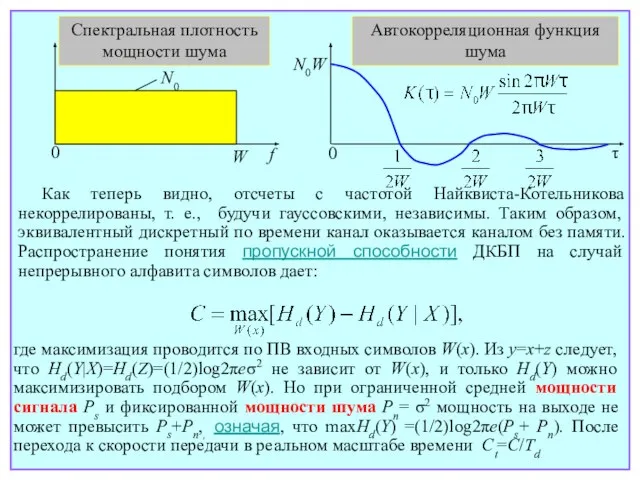

- 54. Дифференциальная (относительная) энтропия непрерывной величины X определяется равенством Таким образом, средняя взаимная информация между X и

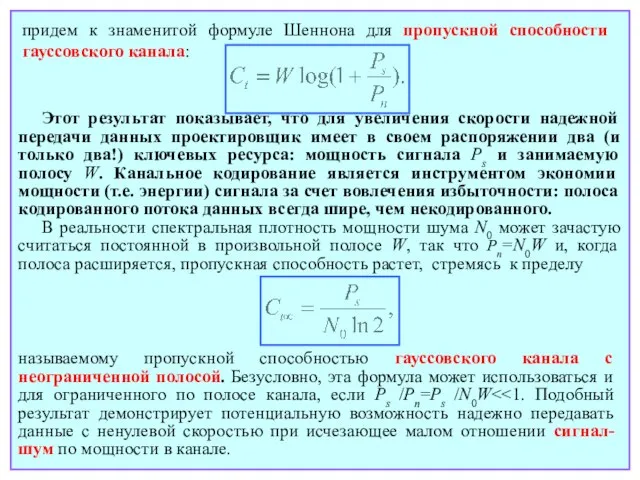

- 55. 4.4. Пропускная способность непрерывного гауссовского канала Рассмотрим полностью непрерывный (по времени и состоянию) канал. На его

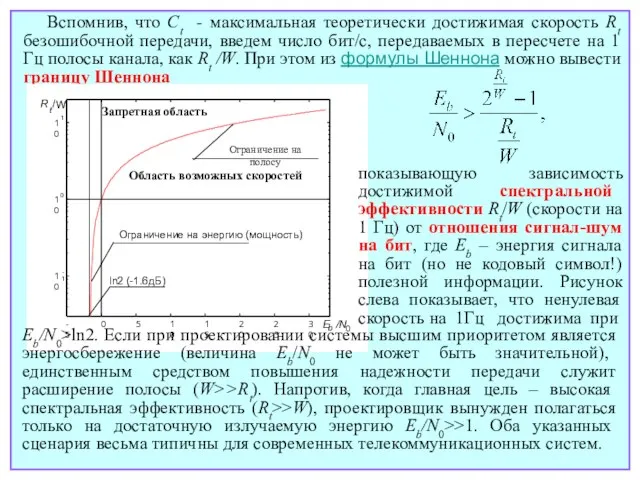

- 56. 0 f W N0 Спектральная плотность мощности шума τ N0W 0 Автокорреляционная функция шума Как теперь

- 57. придем к знаменитой формуле Шеннона для пропускной способности гауссовского канала: Этот результат показывает, что для увеличения

- 58. Вспомнив, что Ct - максимальная теоретически достижимая скорость Rt безошибочной передачи, введем число бит/с, передаваемых в

- 59. Лекция 10

- 60. 5. Введение в блоковые коды 5.1. Общая идея канального кодирования. Классификация кодов Как уже отмечалось, канальное

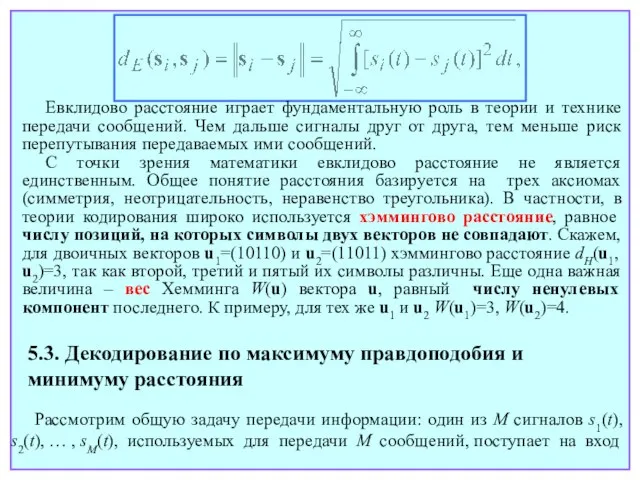

- 61. было передано, если решение выносится в пользу «ближайшего» (отличающегося в минимальном числе позиций от принятого пятисимвольного

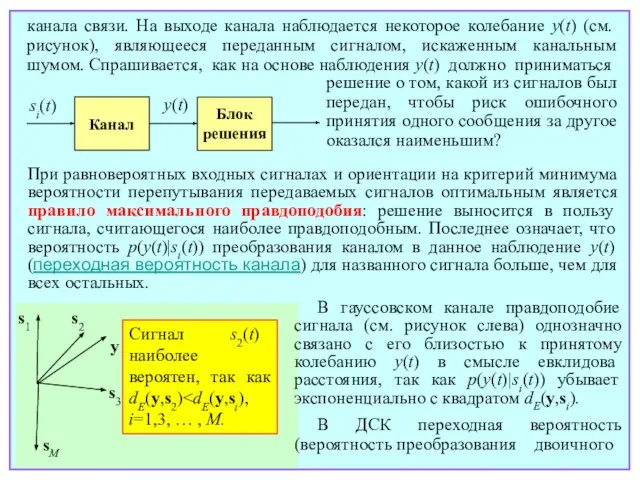

- 62. В последующем тексте используются слегка измененные обозначения: U={u1, u2, … , uM} – канальный код, ui

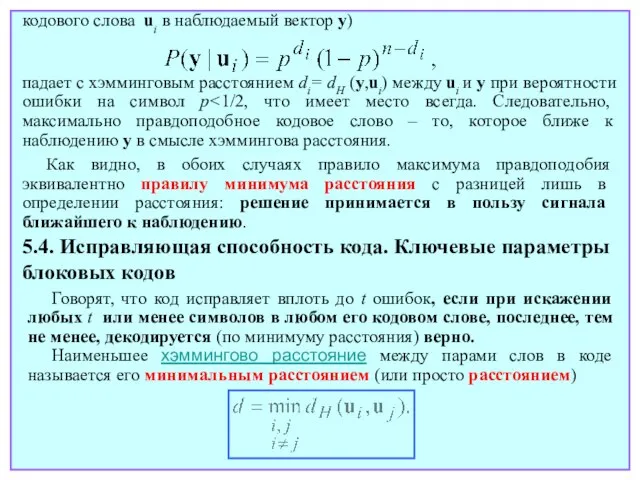

- 63. Евклидово расстояние играет фундаментальную роль в теории и технике передачи сообщений. Чем дальше сигналы друг от

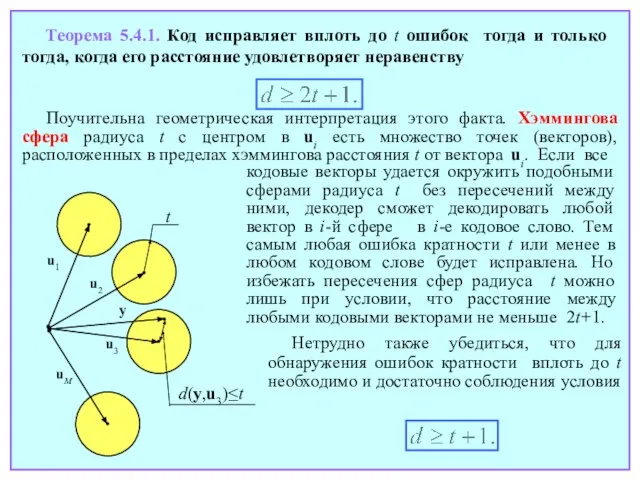

- 64. канала связи. На выходе канала наблюдается некоторое колебание y(t) (см.рисунок), являющееся переданным сигналом, искаженным канальным шумом.

- 65. кодового слова ui в наблюдаемый вектор y) падает с хэмминговым расстоянием di= dH (y,ui) между ui

- 66. Теорема 5.4.1. Код исправляет вплоть до t ошибок тогда и только тогда, когда его расстояние удовлетворяет

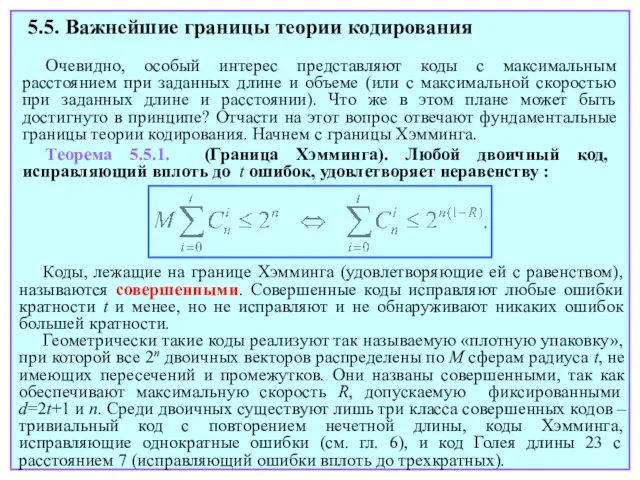

- 67. Длина кода n вместе с объемом M и расстоянием d составляют тройку ключевых параметров блокового. Вместо

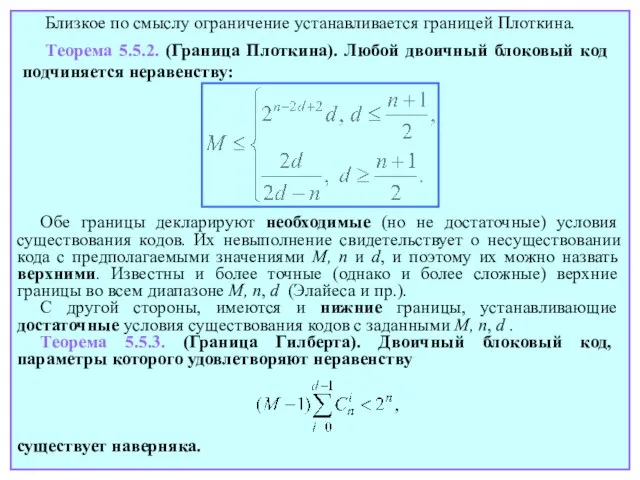

- 68. Лекция 11

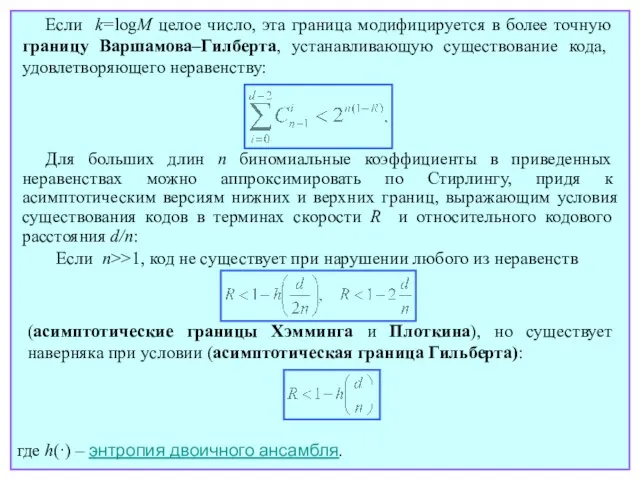

- 69. 5.5. Важнейшие границы теории кодирования Очевидно, особый интерес представляют коды с максимальным расстоянием при заданных длине

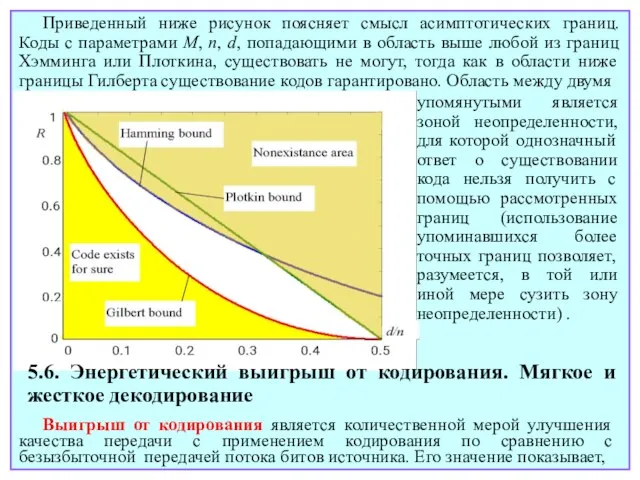

- 70. Близкое по смыслу ограничение устанавливается границей Плоткина. Теорема 5.5.2. (Граница Плоткина). Любой двоичный блоковый код подчиняется

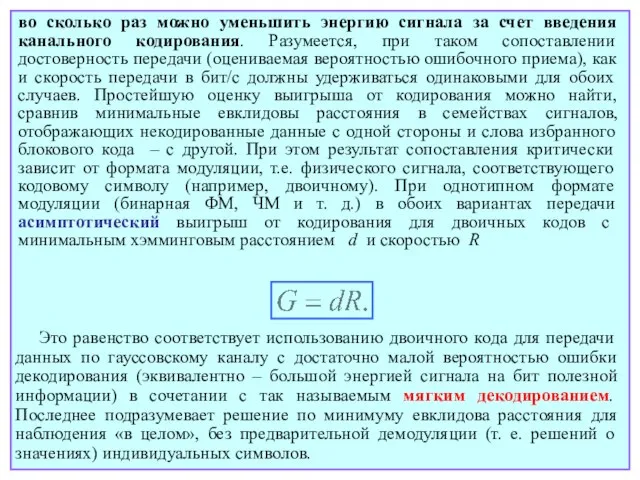

- 71. Для больших длин n биномиальные коэффициенты в приведенных неравенствах можно аппроксимировать по Стирлингу, придя к асимптотическим

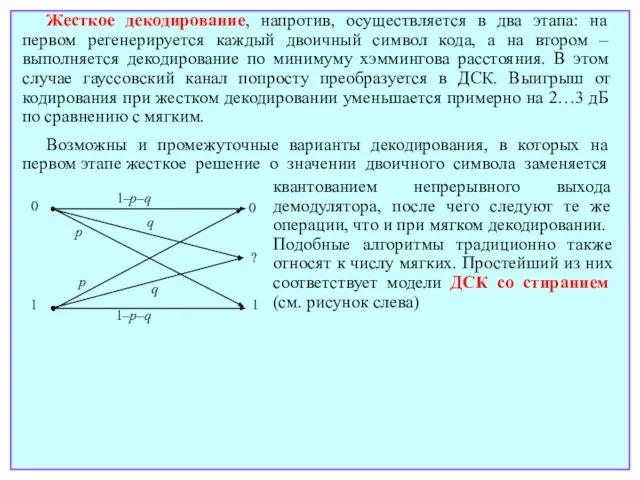

- 72. упомянутыми является зоной неопределенности, для которой однозначный ответ о существовании кода нельзя получить с помощью рассмотренных

- 73. во сколько раз можно уменьшить энергию сигнала за счет введения канального кодирования. Разумеется, при таком сопоставлении

- 74. квантованием непрерывного выхода демодулятора, после чего следуют те же операции, что и при мягком декодировании. Подобные

- 75. Лекция 12

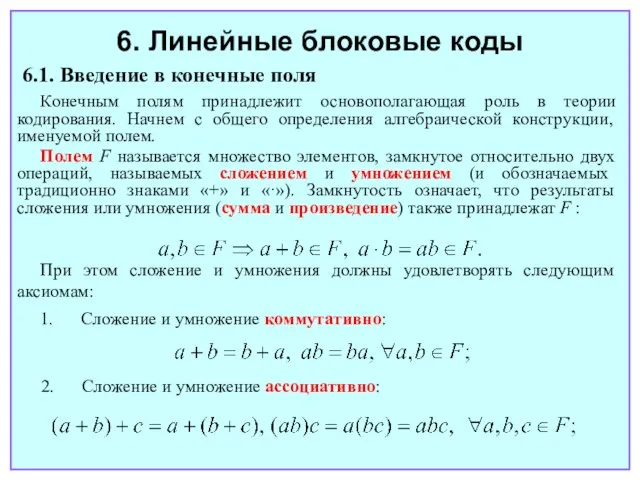

- 76. 6. Линейные блоковые коды 6.1. Введение в конечные поля Конечным полям принадлежит основополагающая роль в теории

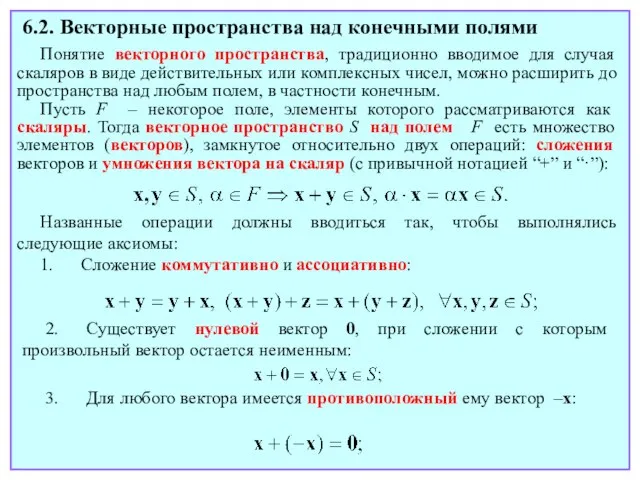

- 77. 3. В F присутствуют два нейтральных элемента – нуль (обозначаемый символом «0») и единица (обозначаемая как

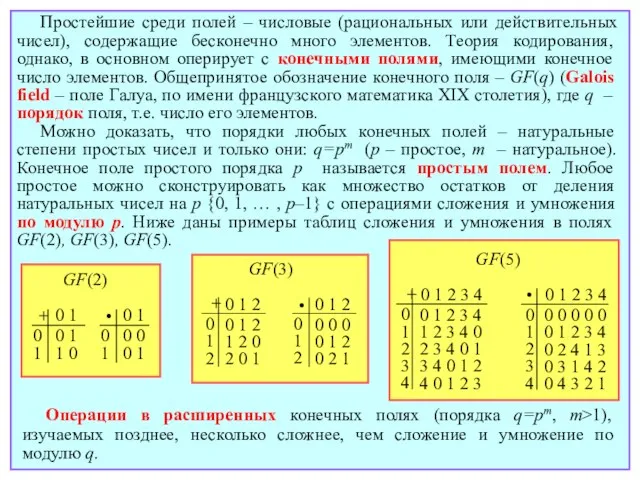

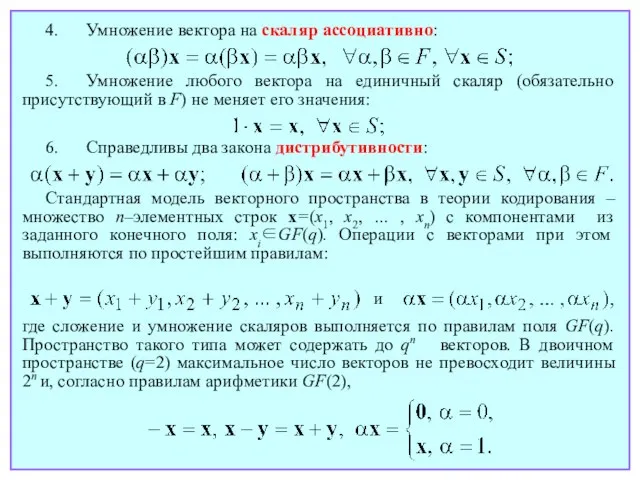

- 78. Простейшие среди полей – числовые (рациональных или действительных чисел), содержащие бесконечно много элементов. Теория кодирования, однако,

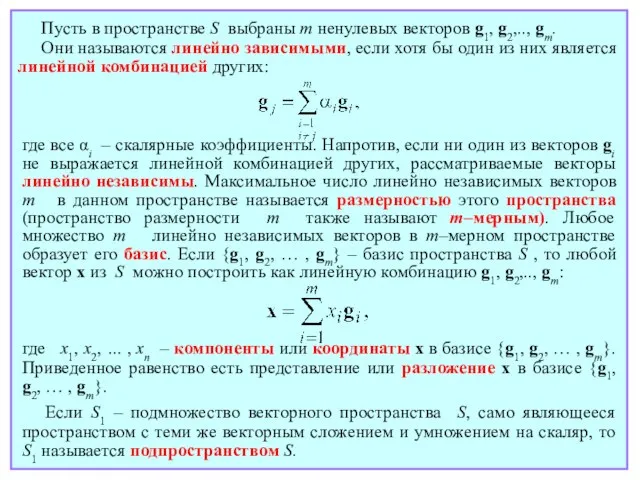

- 79. 6.2. Векторные пространства над конечными полями Понятие векторного пространства, традиционно вводимое для случая скаляров в виде

- 80. 4. Умножение вектора на скаляр ассоциативно: 5. Умножение любого вектора на единичный скаляр (обязательно присутствующий в

- 81. Пусть в пространстве S выбраны m ненулевых векторов g1, g2,.., gm. Они называются линейно зависимыми, если

- 82. Лекция 13

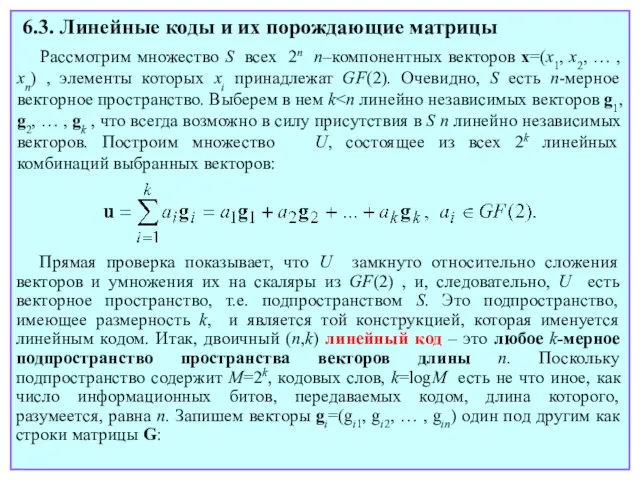

- 83. 6.3. Линейные коды и их порождающие матрицы Рассмотрим множество S всех 2n n–компонентных векторов x=(x1, x2,

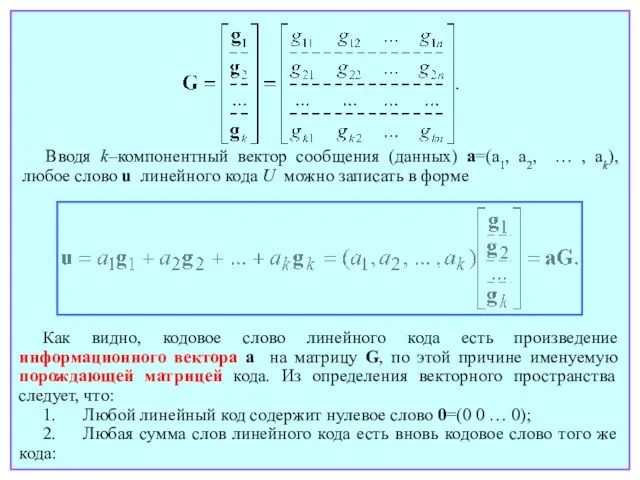

- 84. Вводя k–компонентный вектор сообщения (данных) a=(a1, a2, … , ak), любое слово u линейного кода U

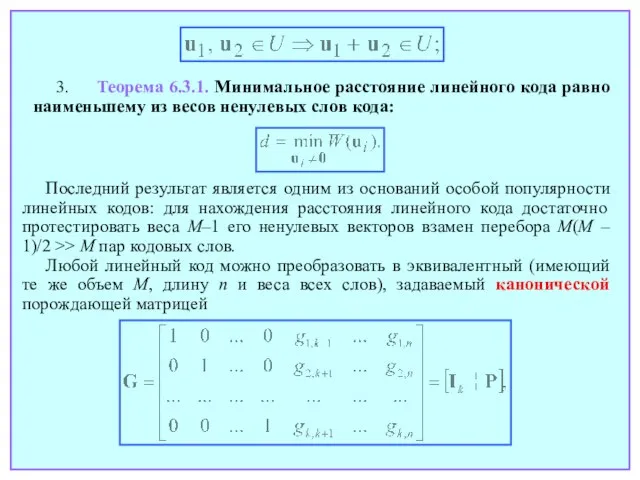

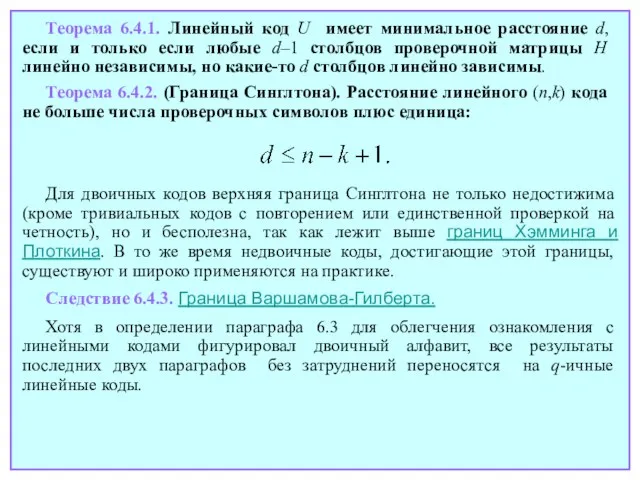

- 85. 3. Теорема 6.3.1. Минимальное расстояние линейного кода равно наименьшему из весов ненулевых слов кода: Последний результат

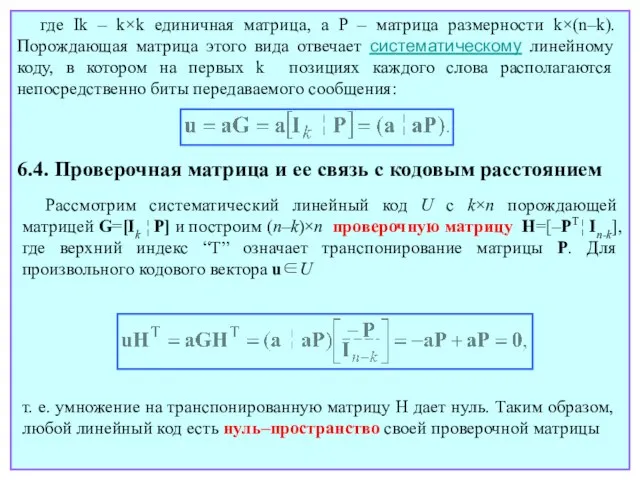

- 86. где Ik – k×k единичная матрица, а P – матрица размерности k×(n–k). Порождающая матрица этого вида

- 87. Теорема 6.4.1. Линейный код U имеет минимальное расстояние d, если и только если любые d–1 столбцов

- 88. Лекция 14

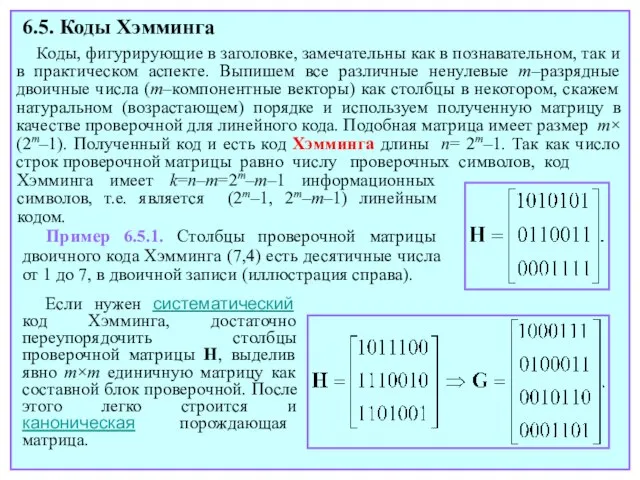

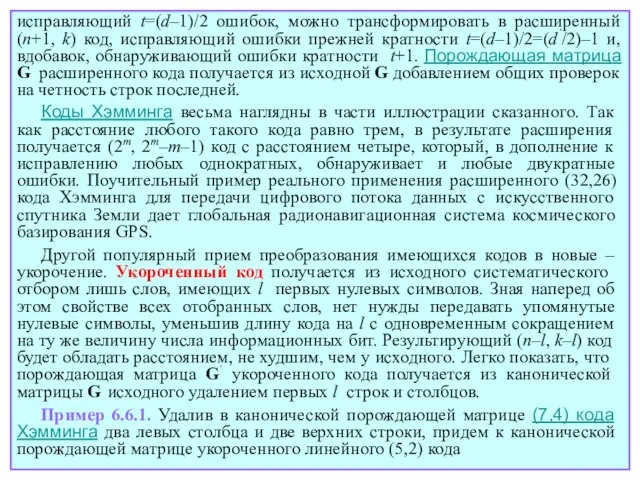

- 89. Коды, фигурирующие в заголовке, замечательны как в познавательном, так и в практическом аспекте. Выпишем все различные

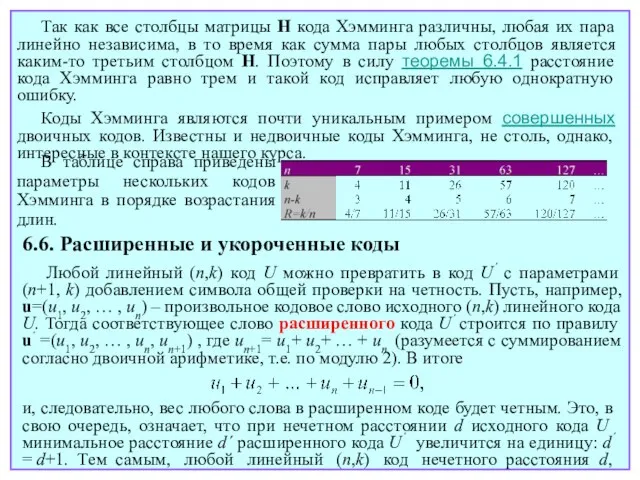

- 90. Так как все столбцы матрицы H кода Хэмминга различны, любая их пара линейно независима, в то

- 91. исправляющий t=(d–1)/2 ошибок, можно трансформировать в расширенный (n+1, k) код, исправляющий ошибки прежней кратности t=(d–1)/2=(d´/2)–1 и,

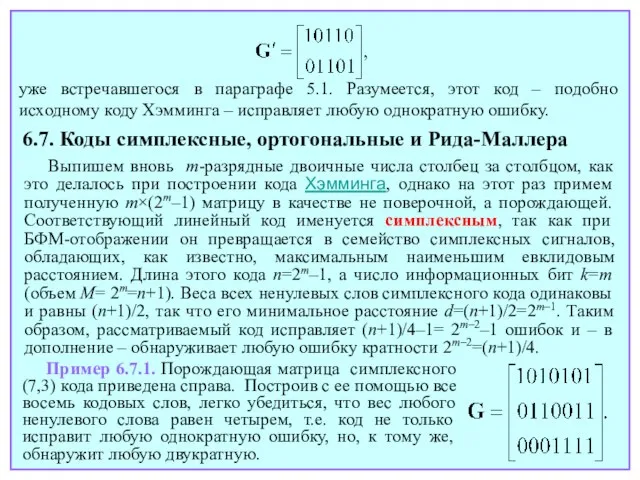

- 92. уже встречавшегося в параграфе 5.1. Разумеется, этот код – подобно исходному коду Хэмминга – исправляет любую

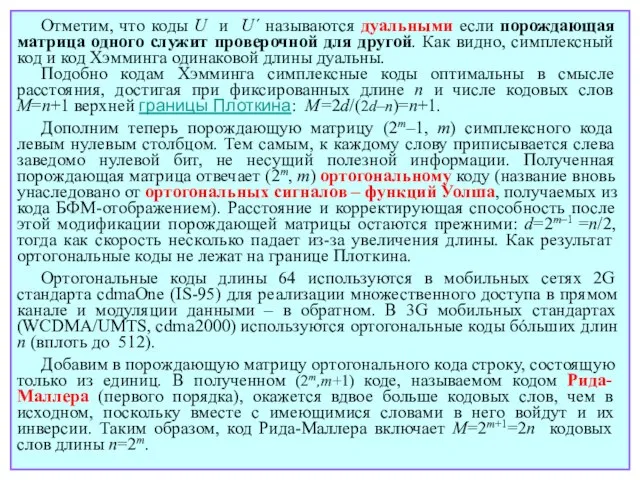

- 93. Отметим, что коды U и U´ называются дуальными если порождающая матрица одного служит проверочной для другой.

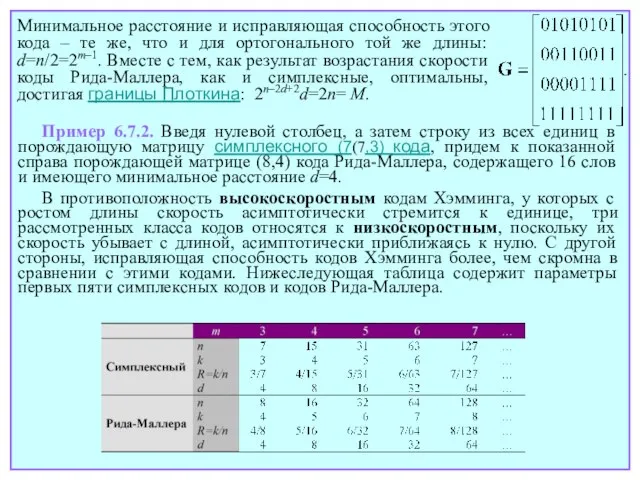

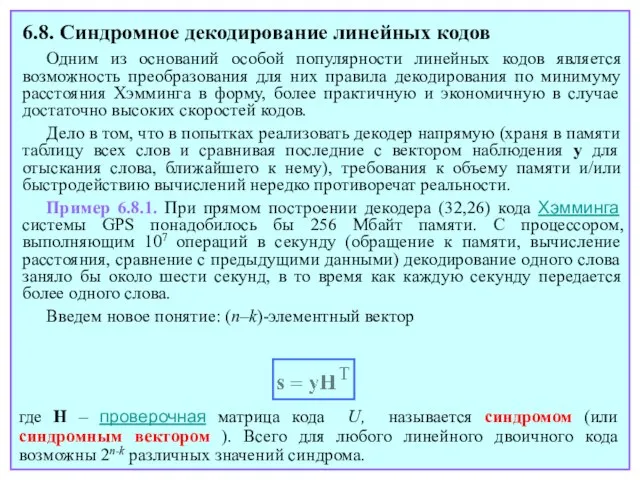

- 94. Минимальное расстояние и исправляющая способность этого кода – те же, что и для ортогонального той же

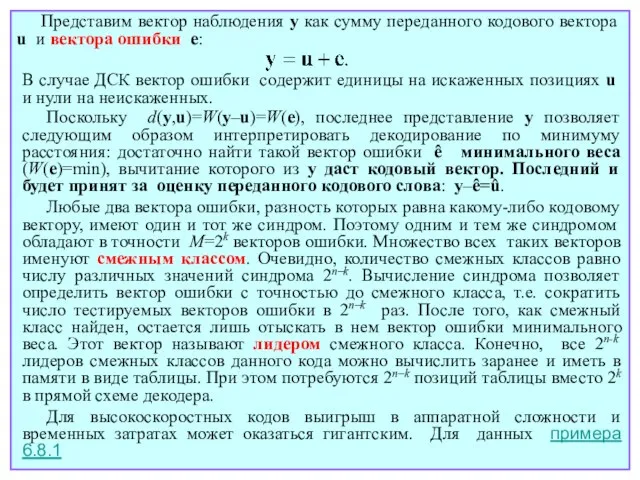

- 95. Лекция 15

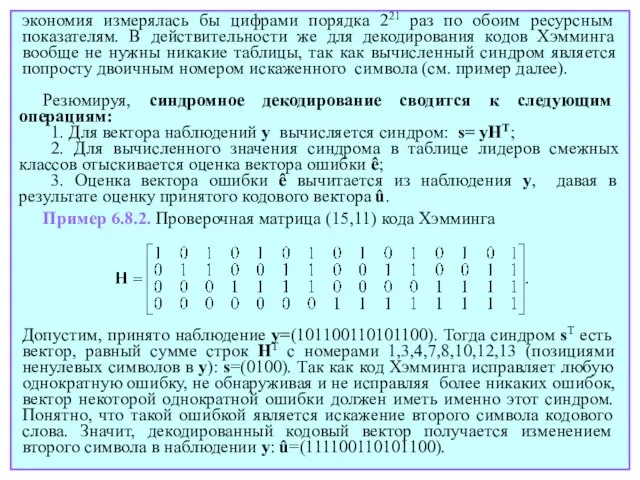

- 96. 6.8. Синдромное декодирование линейных кодов Одним из оснований особой популярности линейных кодов является возможность преобразования для

- 97. Представим вектор наблюдения y как сумму переданного кодового вектора u и вектора ошибки e: В случае

- 98. экономия измерялась бы цифрами порядка 221 раз по обоим ресурсным показателям. В действительности же для декодирования

- 99. Лекция 16

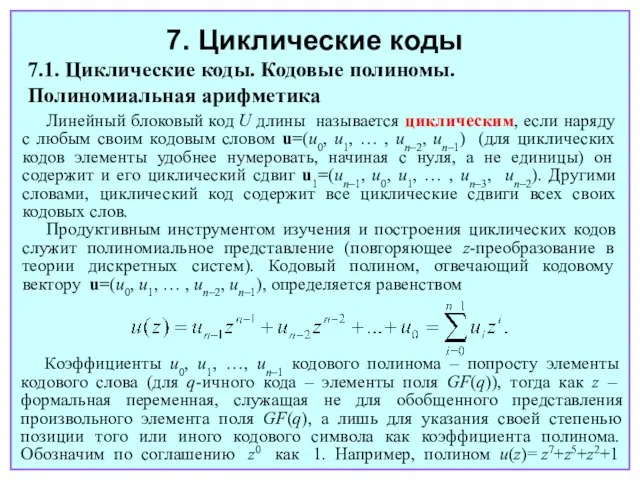

- 100. 7. Циклические коды 7.1. Циклические коды. Кодовые полиномы. Полиномиальная арифметика Линейный блоковый код U длины называется

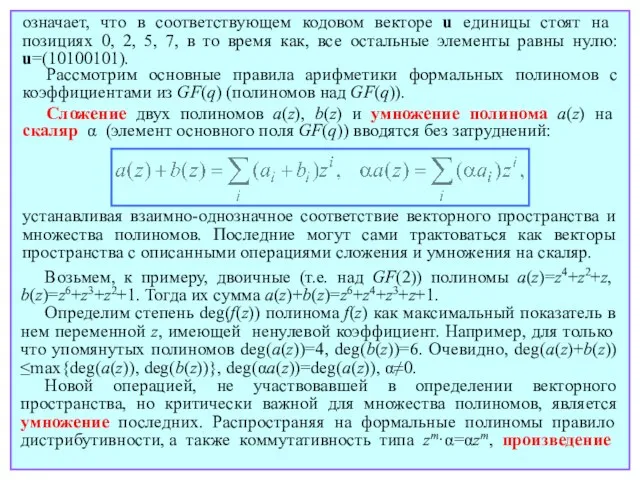

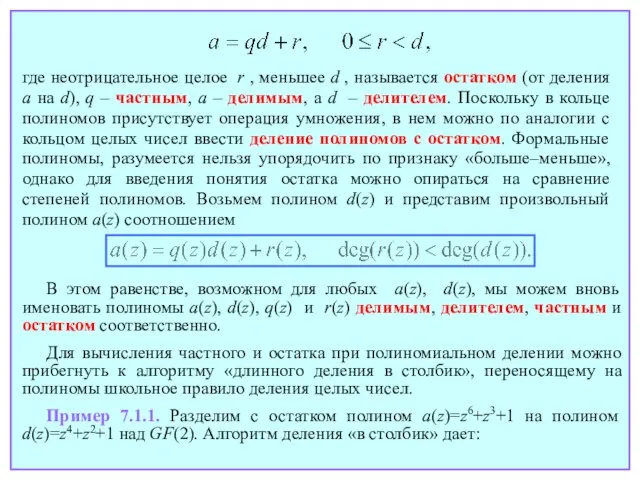

- 101. Рассмотрим основные правила арифметики формальных полиномов с коэффициентами из GF(q) (полиномов над GF(q)). Сложение двух полиномов

- 102. полиномов можно определить равенством, полностью заимствованным из «школьной» алгебры полиномов с действительными коэффициентами: a(z)=amzm+am-1zm–1 +…+a0, b(z)=blzl+bl-1zl–1+…+b0

- 103. где неотрицательное целое r , меньшее d , называется остатком (от деления a на d), q

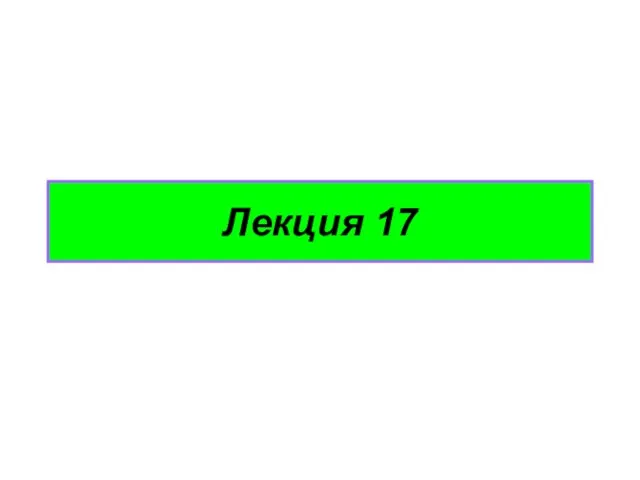

- 104. делитель частное делимое остаток В теории циклических кодов важнейшая роль принадлежит остатку. Часто используемая символика означает,

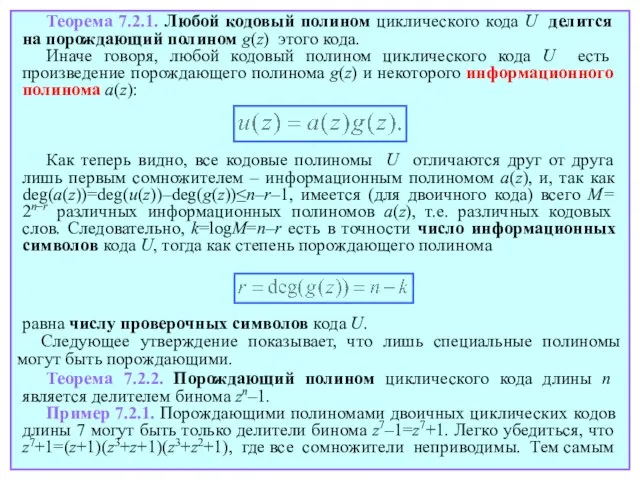

- 105. Лекция 17

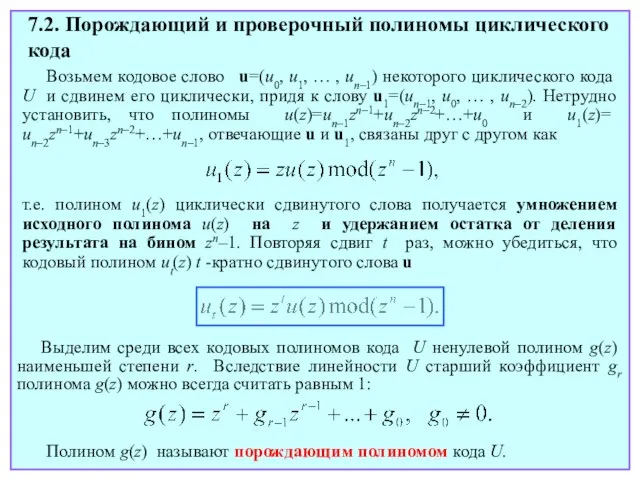

- 106. 7.2. Порождающий и проверочный полиномы циклического кода Возьмем кодовое слово u=(u0, u1, … , un–1) некоторого

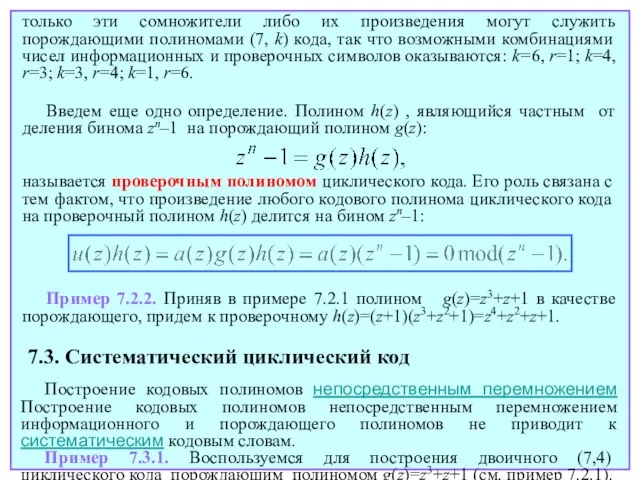

- 107. Теорема 7.2.2. Порождающий полином циклического кода длины n является делителем бинома zn–1. Пример 7.2.1. Порождающими полиномами

- 108. только эти сомножители либо их произведения могут служить порождающими полиномами (7, k) кода, так что возможными

- 109. Сообщению (1110) отвечает информационный полином a(z)=z2+z+1. При этом кодовый полином, получаемый прямым перемножением a(z) и g(z):

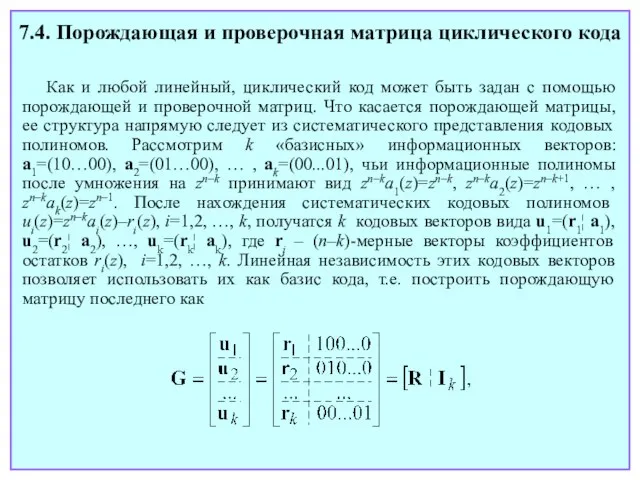

- 110. после деления на g(z) дает остаток r(z)=z. В итоге u(z)= z5+z4+z3+z, и соответствующий кодовый вектор U=(0101110)

- 111. Лекция 18

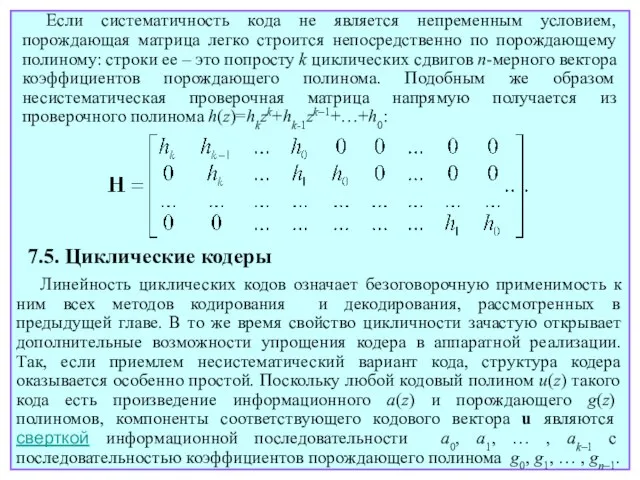

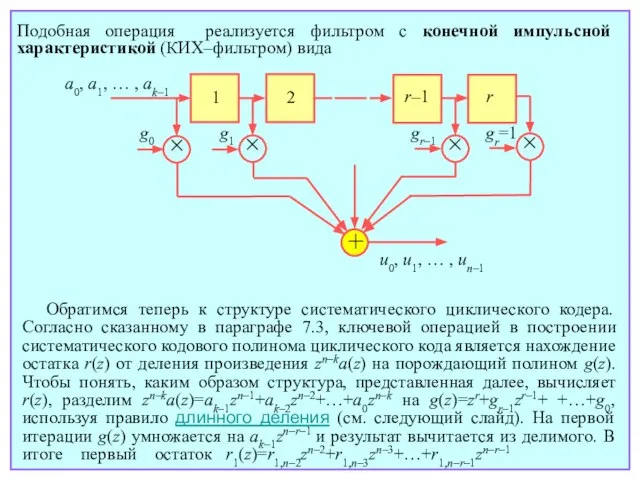

- 112. 7.4. Порождающая и проверочная матрица циклического кода Как и любой линейный, циклический код может быть задан

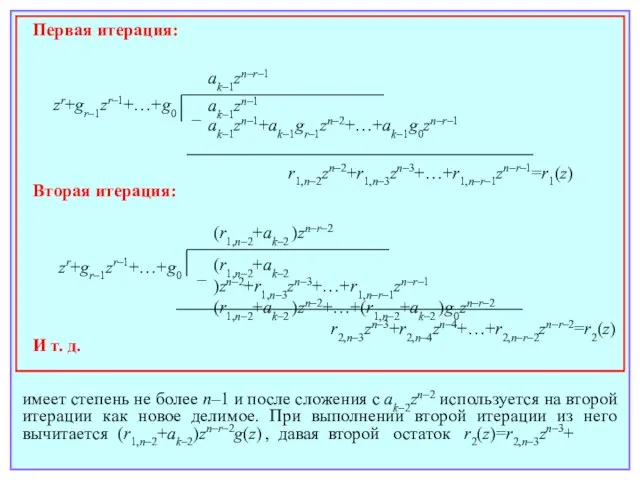

- 113. Если систематичность кода не является непременным условием, порождающая матрица легко строится непосредственно по порождающему полиному: строки

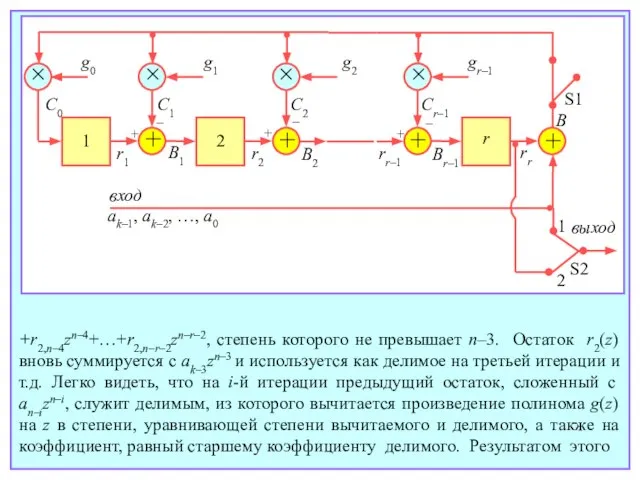

- 114. Обратимся теперь к структуре систематического циклического кодера. Согласно сказанному в параграфе 7.3, ключевой операцией в построении

- 115. имеет степень не более n–1 и после сложения с ak–2zn–2 используется на второй итерации как новое

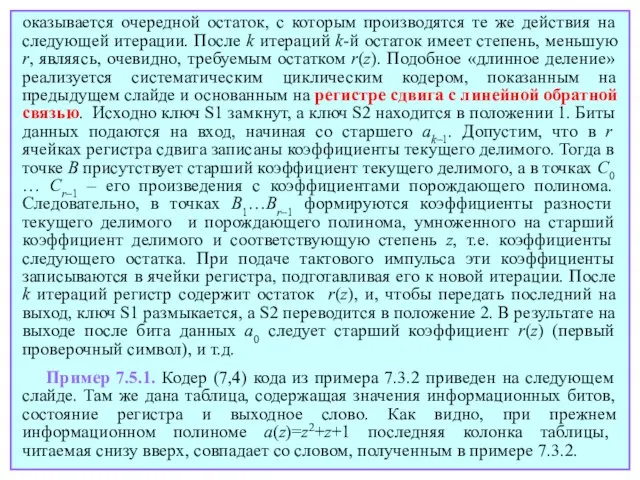

- 116. + + × + + g0 g1 g2 gr–1 1 2 r S1 S2 B 1

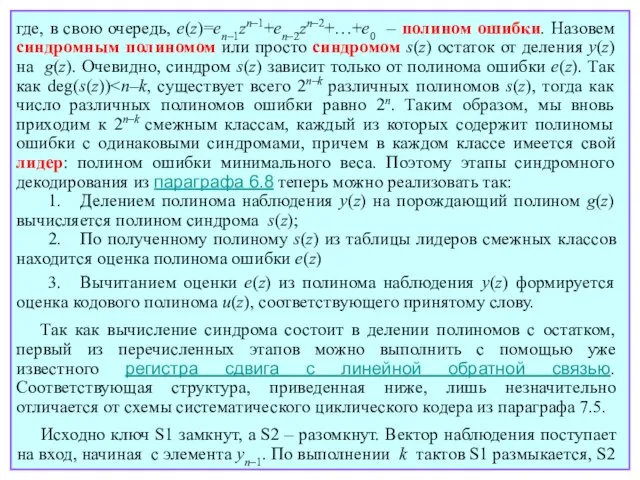

- 117. оказывается очередной остаток, с которым производятся те же действия на следующей итерации. После k итераций k-й

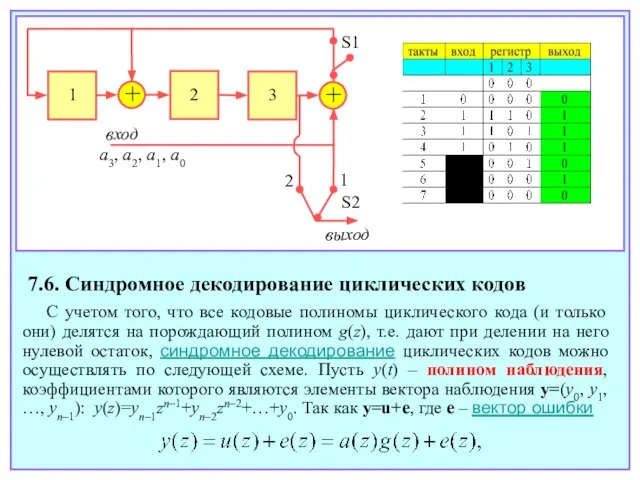

- 118. 7.6. Синдромное декодирование циклических кодов С учетом того, что все кодовые полиномы циклического кода (и только

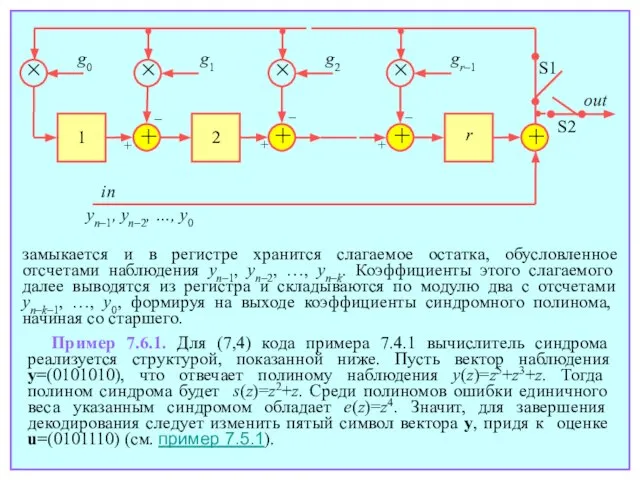

- 119. где, в свою очередь, e(z)=en–1zn–1+en–2zn–2+…+e0 – полином ошибки. Назовем синдромным полиномом или просто синдромом s(z) остаток

- 120. + + g0 g1 1 2 in yn–1, yn–2, …, y0 + + g2 gr–1 r

- 121. + + S1 S2 out in y6, y5, …, y0 1 2 3 В цикличности заложен

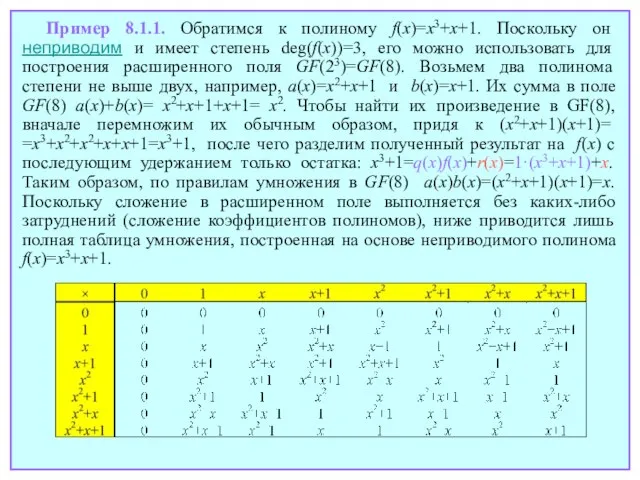

- 122. Лекция 19

- 123. 8. Коды БЧХ и Рида-Соломона 8.1. Расширенные конечные поля Как уже известно, конечные поля существуют только

- 124. Пример 8.1.1. Обратимся к полиному f(x)=x3+x+1. Поскольку он неприводим и имеет степень deg(f(x))=3, его можно использовать

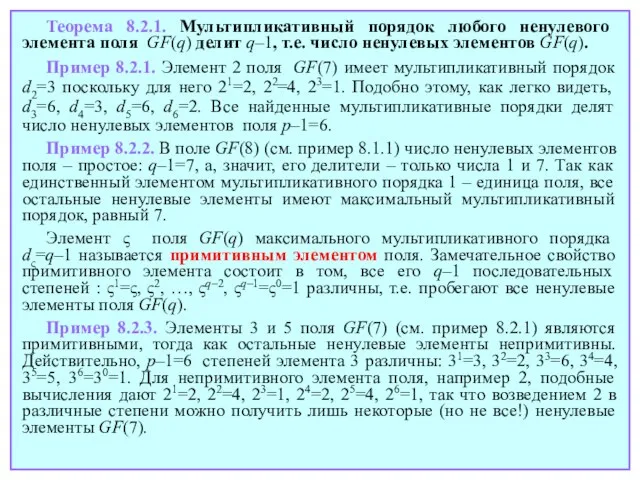

- 125. Отметим, что в числе полиномов степени не выше m–1 присутствуют и полиномы нулевой степени, т.е. элементы

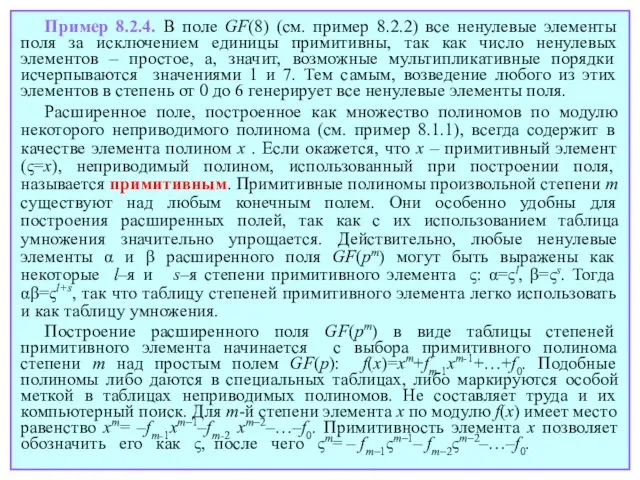

- 126. и для любого ненулевого α Таким образом, в конечных полях действуют те же правила обращения с

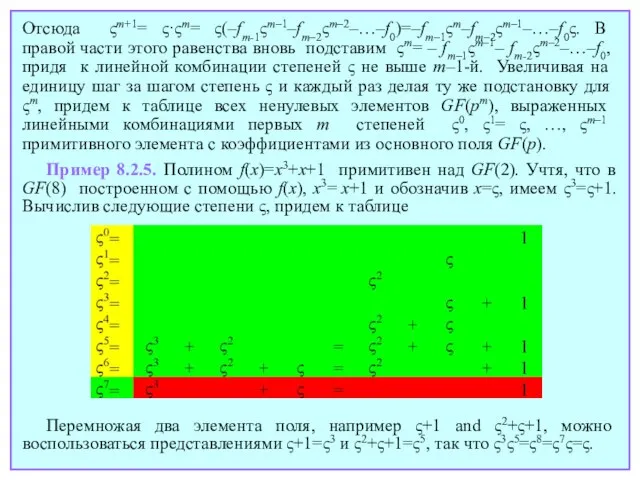

- 127. Теорема 8.2.1. Мультипликативный порядок любого ненулевого элемента поля GF(q) делит q–1, т.е. число ненулевых элементов GF(q).

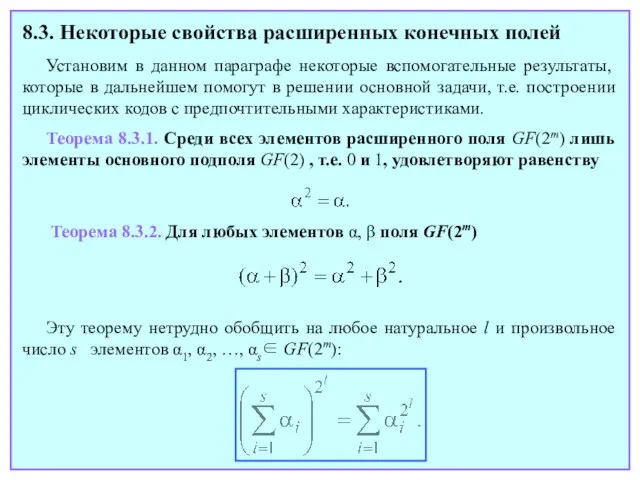

- 128. Пример 8.2.4. В поле GF(8) (см. пример 8.2.2) все ненулевые элементы поля за исключением единицы примитивны,

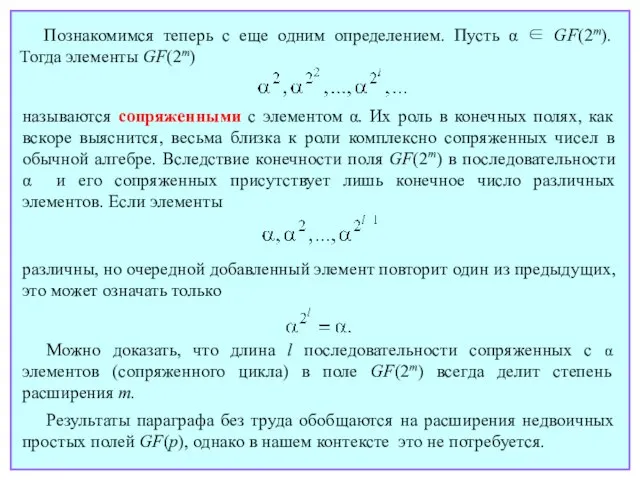

- 129. Отсюда ςm+1= ς·ςm= ς(–fm-1ςm–1–fm–2ςm–2–…–f0)=–fm–1ςm–fm–2ςm–1–…–f0ς. В правой части этого равенства вновь подставим ςm= – fm–1ςm–1– fm-2ςm–2–…–f0, придя

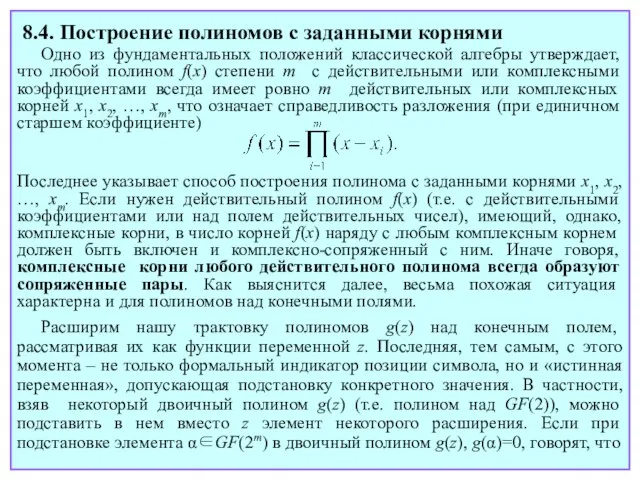

- 130. 8.3. Некоторые свойства расширенных конечных полей Установим в данном параграфе некоторые вспомогательные результаты, которые в дальнейшем

- 131. называются сопряженными с элементом α. Их роль в конечных полях, как вскоре выяснится, весьма близка к

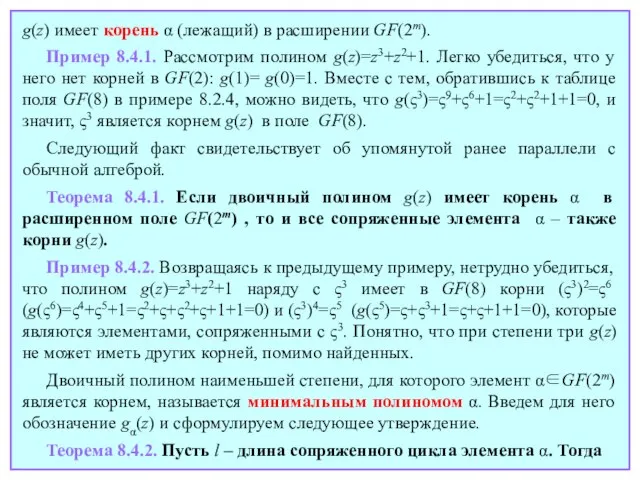

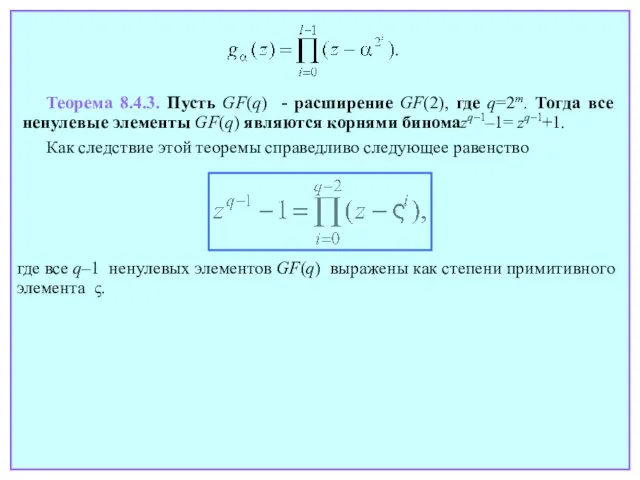

- 132. 8.4. Построение полиномов с заданными корнями Одно из фундаментальных положений классической алгебры утверждает, что любой полином

- 133. g(z) имеет корень α (лежащий) в расширении GF(2m). Пример 8.4.1. Рассмотрим полином g(z)=z3+z2+1. Легко убедиться, что

- 134. где все q–1 ненулевых элементов GF(q) выражены как степени примитивного элемента ς. Теорема 8.4.3. Пусть GF(q)

- 135. Лекция 20

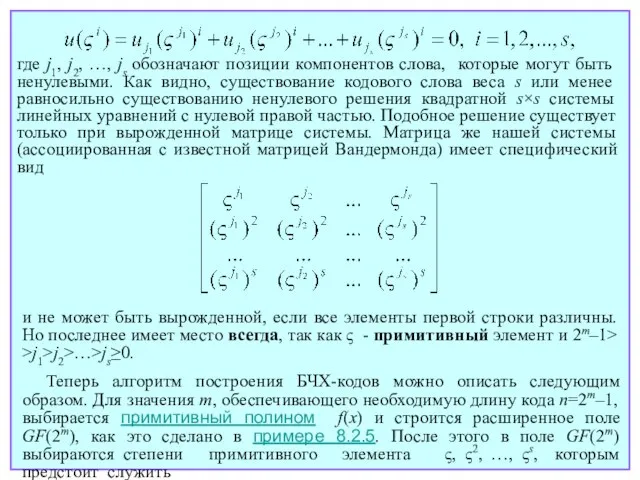

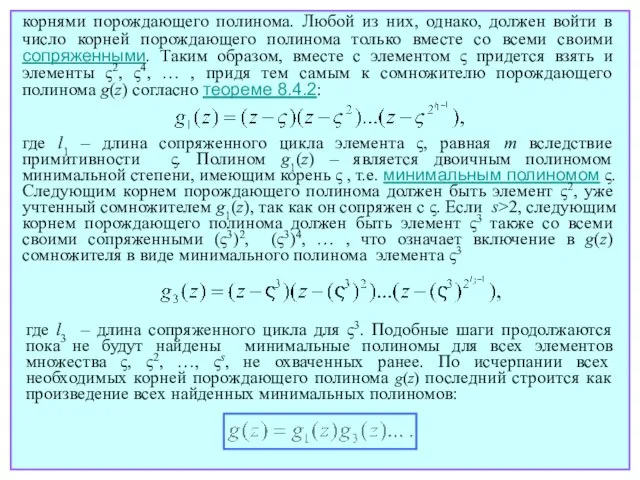

- 136. 8.5. Двоичные БЧХ-коды Накопленные к данному моменту знания открывают путь к ознакомлению с одним из наиболее

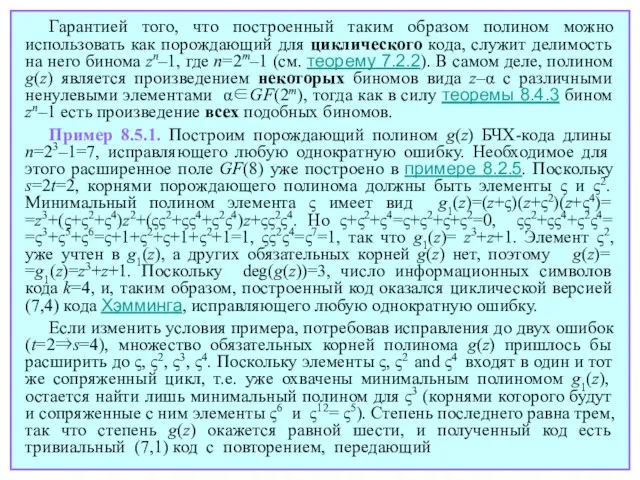

- 137. и не может быть вырожденной, если все элементы первой строки различны. Но последнее имеет место всегда,

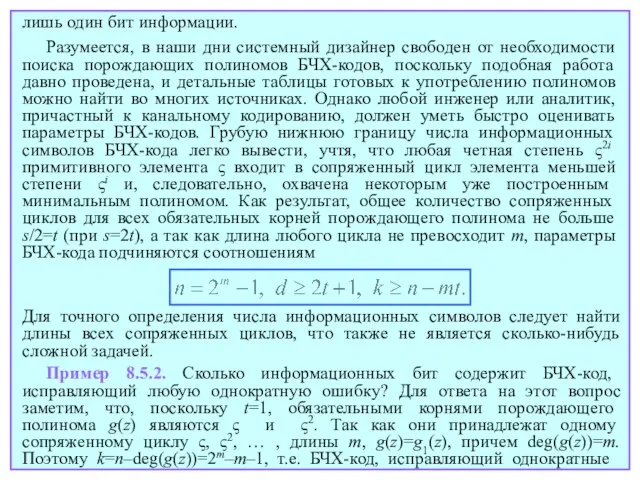

- 138. корнями порождающего полинома. Любой из них, однако, должен войти в число корней порождающего полинома только вместе

- 139. Гарантией того, что построенный таким образом полином можно использовать как порождающий для циклического кода, служит делимость

- 140. Разумеется, в наши дни системный дизайнер свободен от необходимости поиска порождающих полиномов БЧХ-кодов, поскольку подобная работа

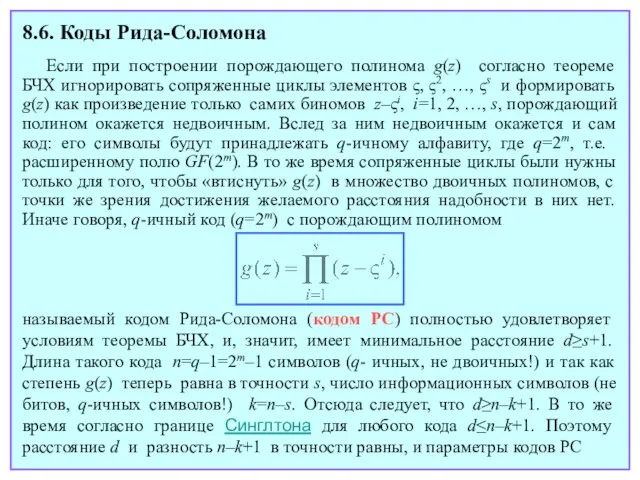

- 141. Пример 8.5.3. Найдем точное число информационных бит БЧХ-кода длины n=31, исправляющего до 5 ошибок. Корнями его

- 142. Лекция 21

- 143. 8.6. Коды Рида-Соломона Если при построении порождающего полинома g(z) согласно теореме БЧХ игнорировать сопряженные циклы элементов

- 144. где свобода выбора числа информационных символов k ограничена лишь одним: с увеличением k на единицу кодовое

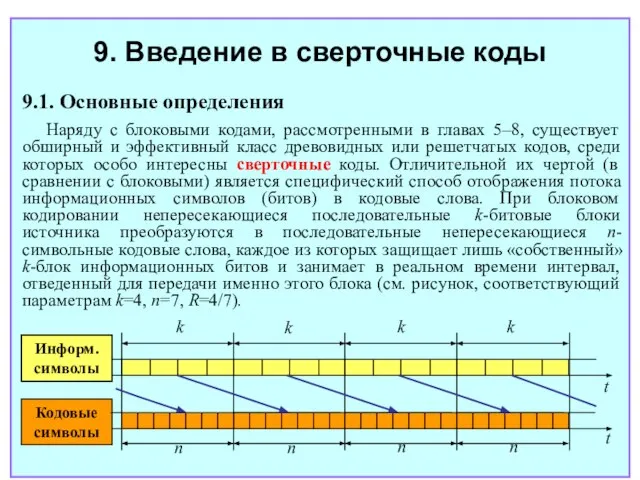

- 145. Коды БЧХ и РС находят широкое применение в современных информационных системах. Приведем лишь несколько поучительных примеров.

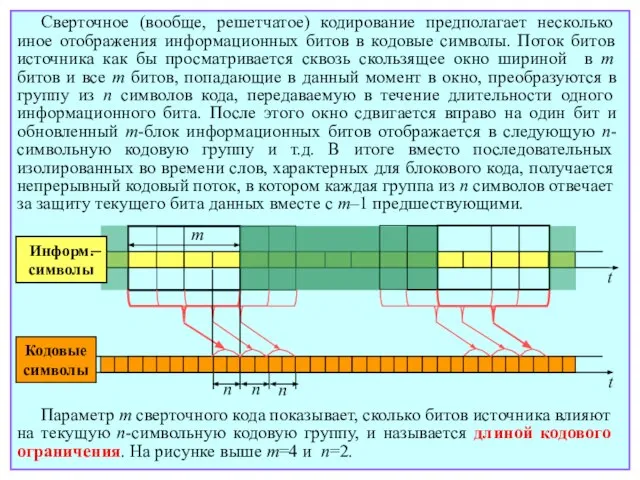

- 146. укороченных (32,28) и (28,24) кодов РС. Стандарт цифрового телевизионного вещания DVB-T (Digital Video Broadcasting-Terrestrial) включает (204,188)

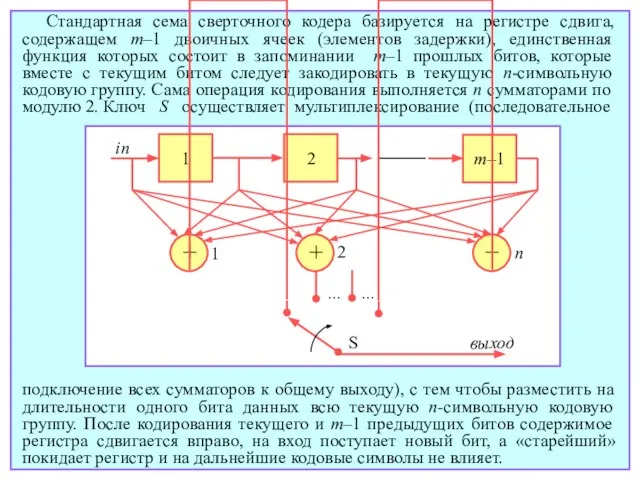

- 147. 9. Введение в сверточные коды 9.1. Основные определения Наряду с блоковыми кодами, рассмотренными в главах 5–8,

- 148. Сверточное (вообще, решетчатое) кодирование предполагает несколько иное отображения информационных битов в кодовые символы. Поток битов источника

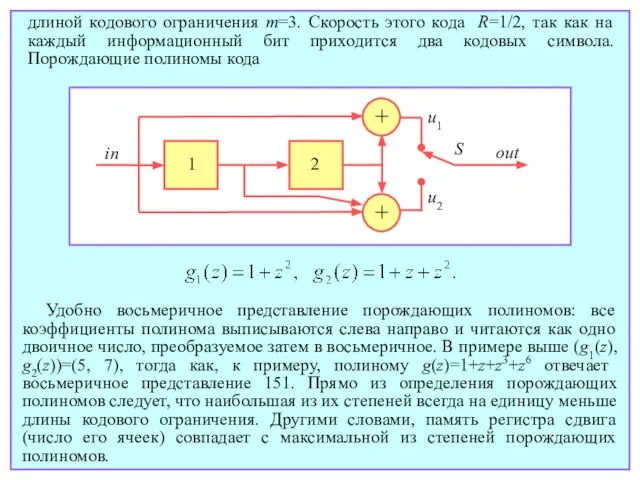

- 149. Стандартная сема сверточного кодера базируется на регистре сдвига, содержащем m–1 двоичных ячеек (элементов задержки), единственная функция

- 150. Если подать на вход этого устройства k информационных битов, на выходе появится последовательность длиной не kn,

- 151. длиной кодового ограничения m=3. Скорость этого кода R=1/2, так как на каждый информационный бит приходится два

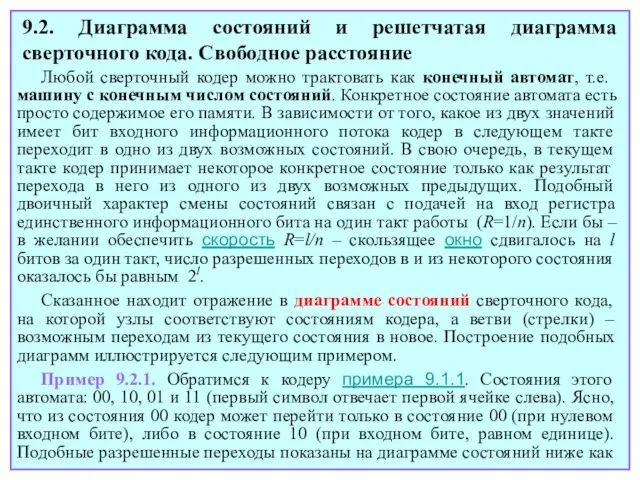

- 152. Нетрудно убедиться в линейности сверточных кодов. Более того, само их название связано с тем, что сверточный

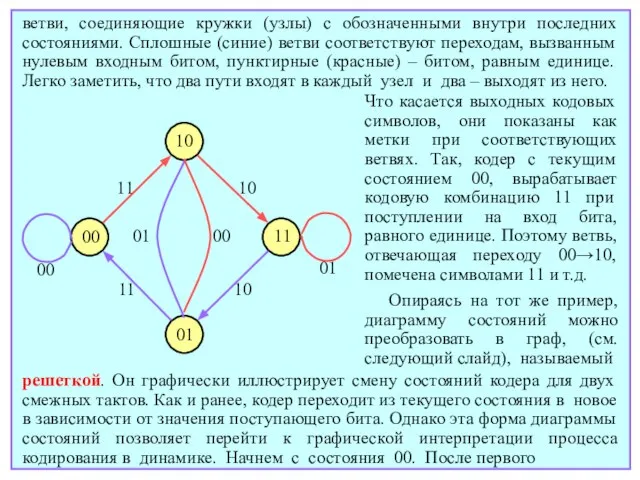

- 153. Лекция 22

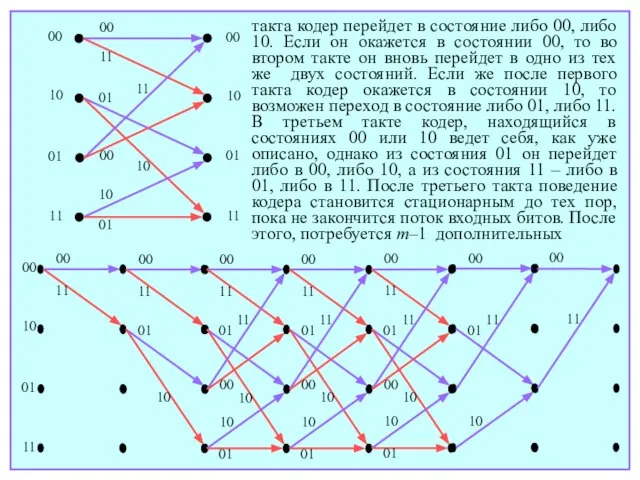

- 154. 9.2. Диаграмма состояний и решетчатая диаграмма сверточного кода. Свободное расстояние Любой сверточный кодер можно трактовать как

- 155. ветви, соединяющие кружки (узлы) с обозначенными внутри последних состояниями. Сплошные (синие) ветви соответствуют переходам, вызванным нулевым

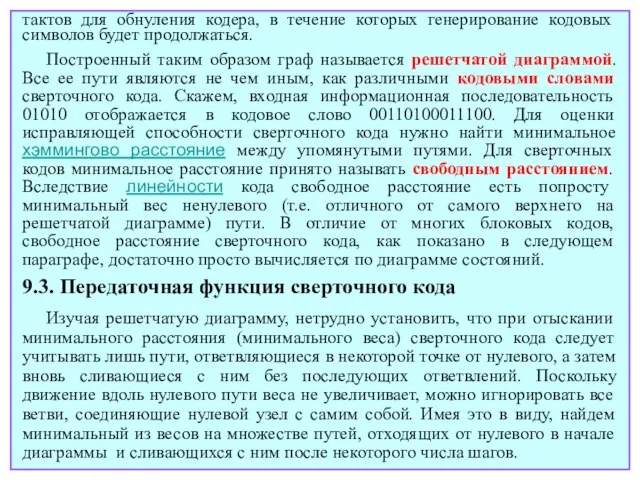

- 156. такта кодер перейдет в состояние либо 00, либо 10. Если он окажется в состоянии 00, то

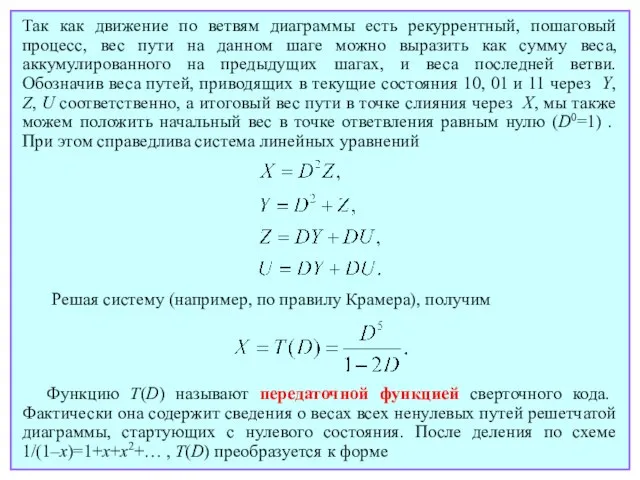

- 157. тактов для обнуления кодера, в течение которых генерирование кодовых символов будет продолжаться. Построенный таким образом граф

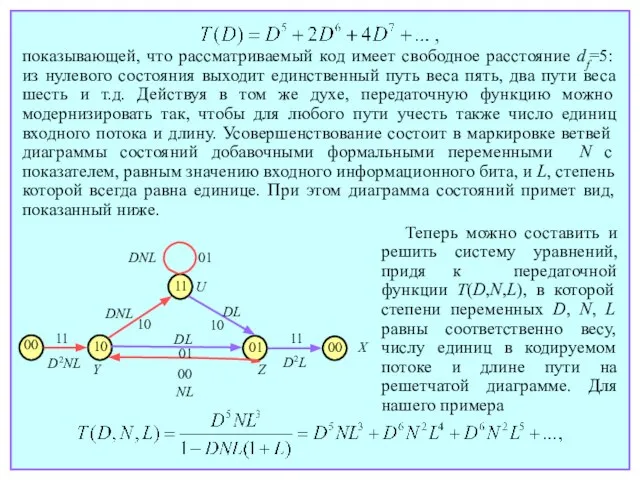

- 158. Пометим каждую ветвь диаграммы состояний формальной переменной D, в степени, равной весу ветви. Так, в примере

- 159. Так как движение по ветвям диаграммы есть рекуррентный, пошаговый процесс, вес пути на данном шаге можно

- 160. показывающей, что рассматриваемый код имеет свободное расстояние df=5: из нулевого состояния выходит единственный путь веса пять,

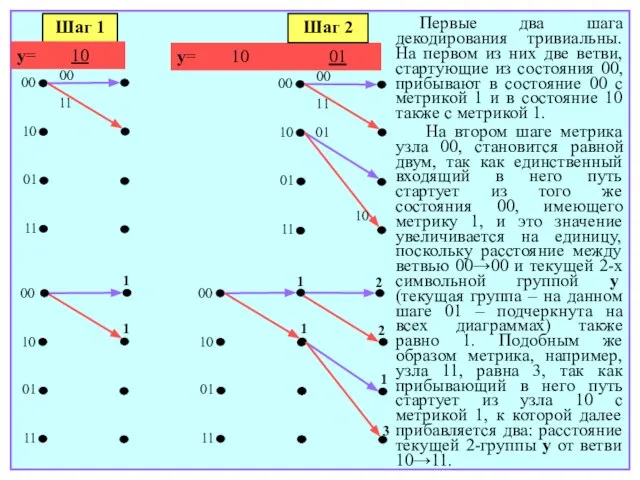

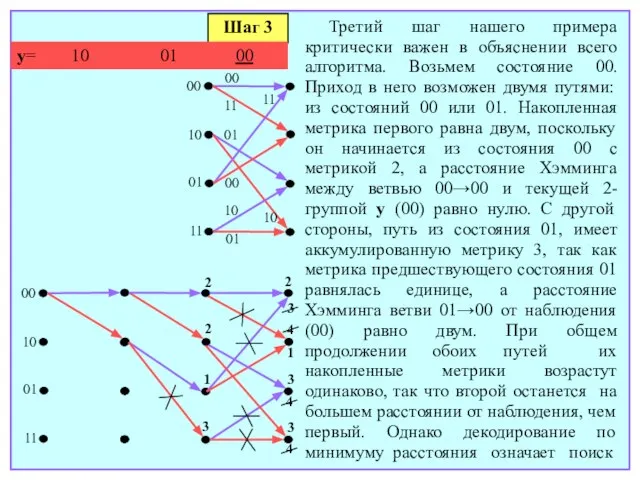

- 161. откуда видно, что в рассматриваемом коде присутствуют один путь длины 3 и веса 5, кодирующий блок

- 162. Лекция 23

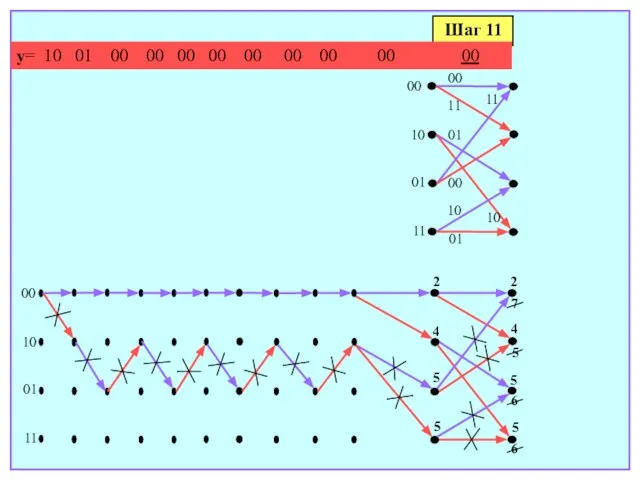

- 163. 9.4. Алгоритм декодирования Витерби Рекурсивная природа сверточного кодирования лежит в основе также рекурсивного и ресурсно-экономного алгоритма

- 164. 1. Вычисляются хэмминговы расстояния от принятой n-символьной группы до каждой из ветвей решетчатой диаграммы. Так как

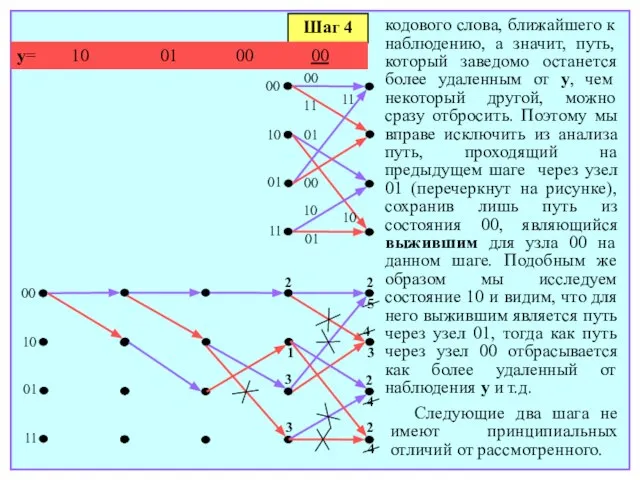

- 165. 00 10 01 11 00 11 Шаг 1 y= 10 00 10 01 11 1 1

- 166. 00 10 01 11 2 2 1 3 00 10 01 11 00 01 00 01

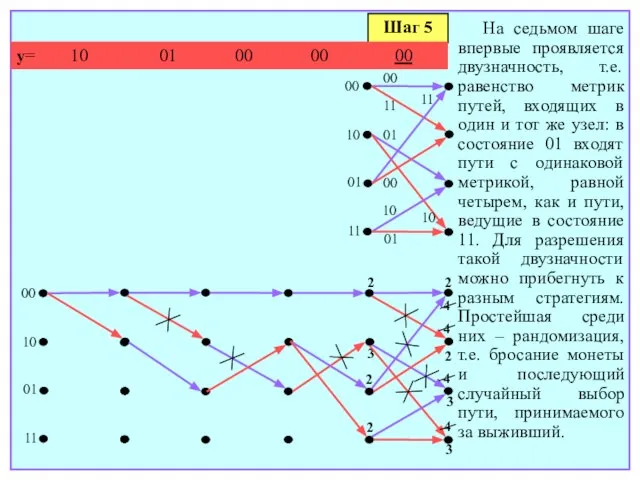

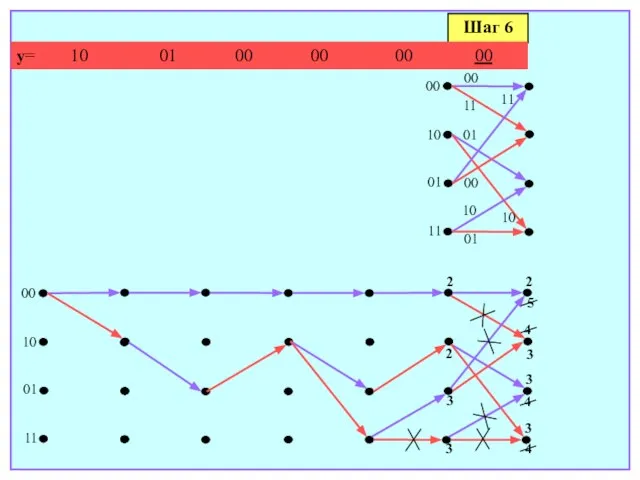

- 167. кодового слова, ближайшего к наблюдению, а значит, путь, который заведомо останется более удаленным от y, чем

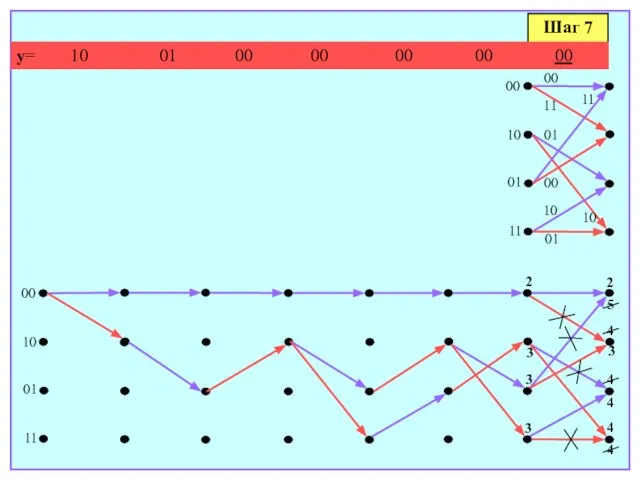

- 168. Шаг 5 y= 10 01 00 00 00 00 10 01 11 00 10 01 11

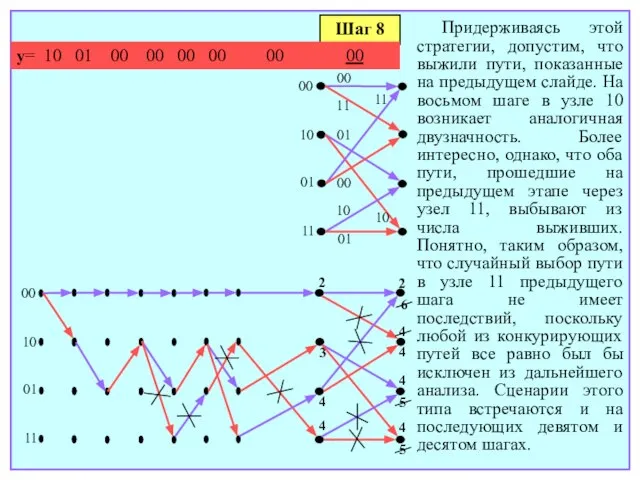

- 169. Шаг 6 y= 10 01 00 00 00 00 00 10 01 11 00 10 01

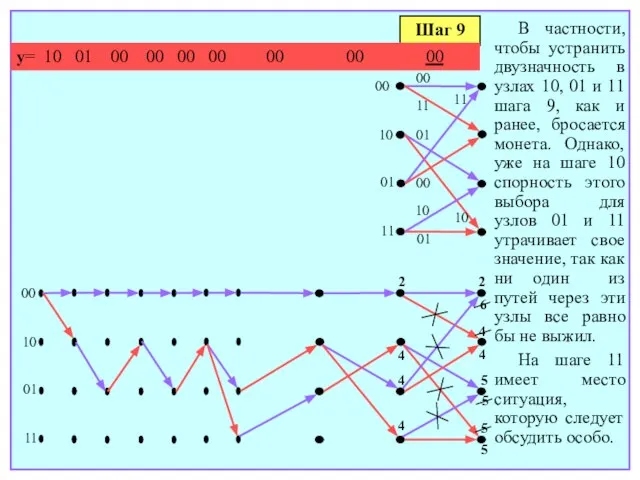

- 170. Шаг 7 y= 10 01 00 00 00 00 00 00 10 01 11 00 10

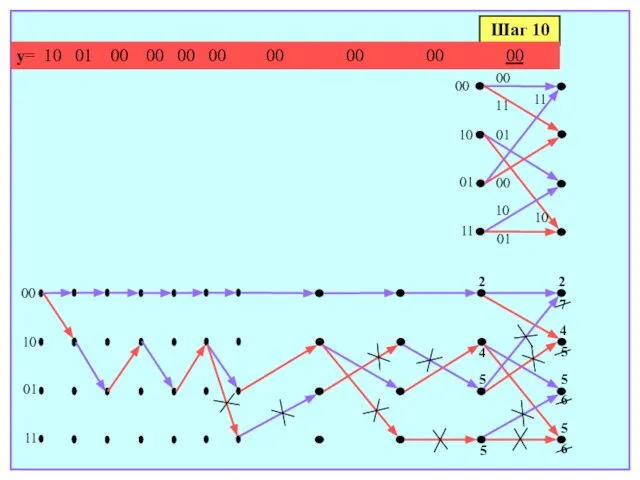

- 171. Шаг 8 y= 10 01 00 00 00 00 00 00 00 10 01 11 00

- 172. Шаг 9 y= 10 01 00 00 00 00 00 00 00 00 10 01 11

- 173. Шаг 10 y= 10 01 00 00 00 00 00 00 00 00 00 10 01

- 174. Шаг 11 y= 10 01 00 00 00 00 00 00 00 00 00 00 10

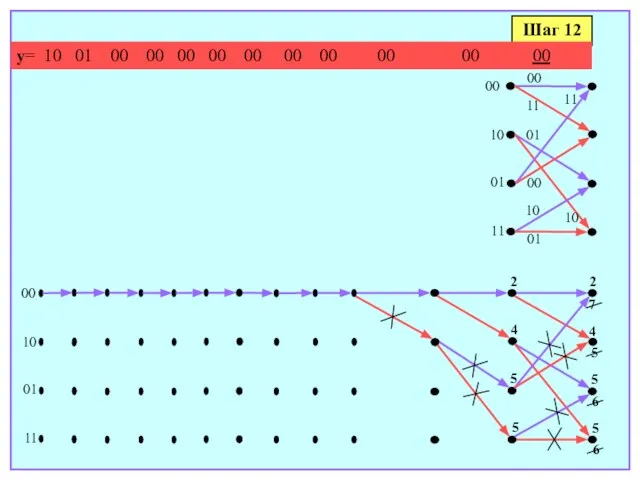

- 175. Шаг 12 y= 10 01 00 00 00 00 00 00 00 00 00 00 00

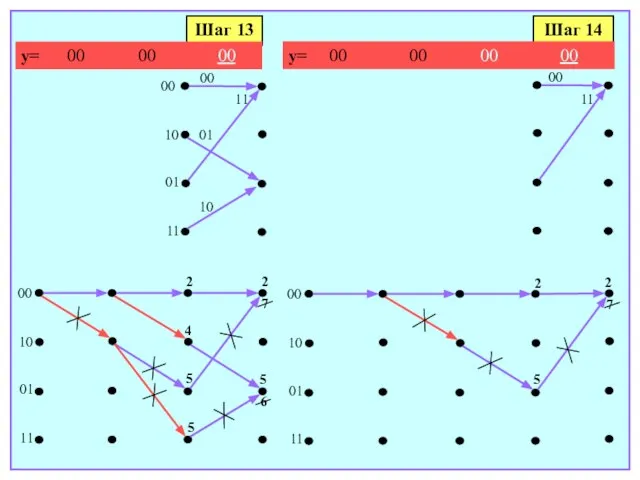

- 176. Шаг 14 00 11 Шаг 13 2 5 4 5 00 10 01 11 y= 00

- 177. Во-первых, ни один из путей, для которых ранее приходилось разрешать неоднозначность, не выжил, а значит, какие-либо

- 178. На финальном, 14-м шаге осуществляется выбор между двумя путями, сходящимися в состоянии 00, что завершает декодирование:

- 179. Лекция 24

- 180. 9.5. Мягкое декодирование сверточных кодов Наилучшая (максимально правдоподобная) стратегия принятия решений на выходе гауссовского канала состоит

- 181. того из двух путей, который приходит в узел, накопив бóльшее евклидово расстояние. Отметим, что среди 2m

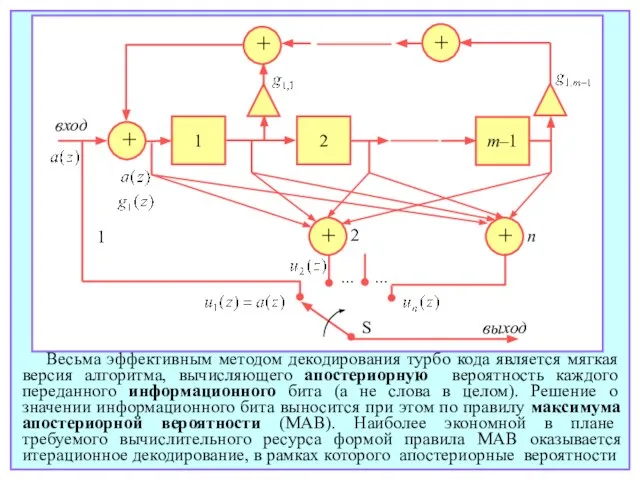

- 182. в каждом блоке, длина которого после выкалывания g символов составит ln–g. В итоге скорость выколотого кода

- 183. Подбором l и g при заданном n можно варьировать скорость в широком диапазоне, добиваясь ее желаемого

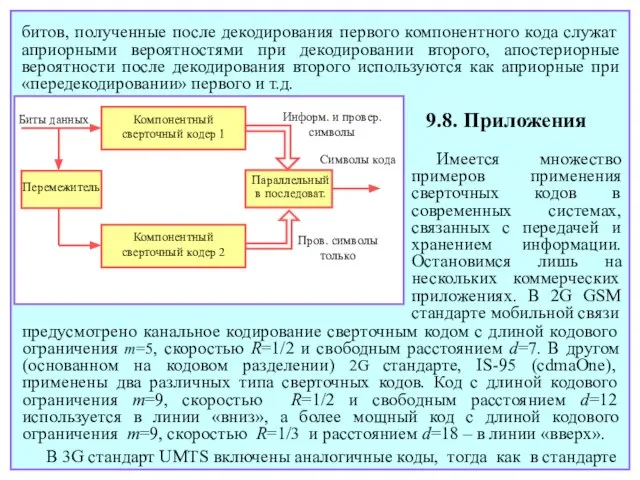

- 184. при построении турбо кода систематичность критически важна, компонентный кодер приходится модифицировать, применяя рекурсивный фильтр с бесконечной

- 185. + + 1 2 m–1 1 2 n S выход вход ... ... + + +

- 186. битов, полученные после декодирования первого компонентного кода служат априорными вероятностями при декодировании второго, апостериорные вероятности после

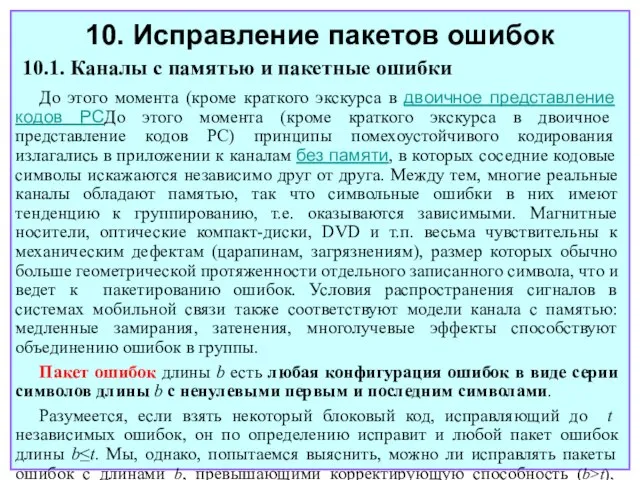

- 187. Использование турбо кодов наряду со сверточными характерно для 3G стандартов UMTS, cdma2000, etc., а также для

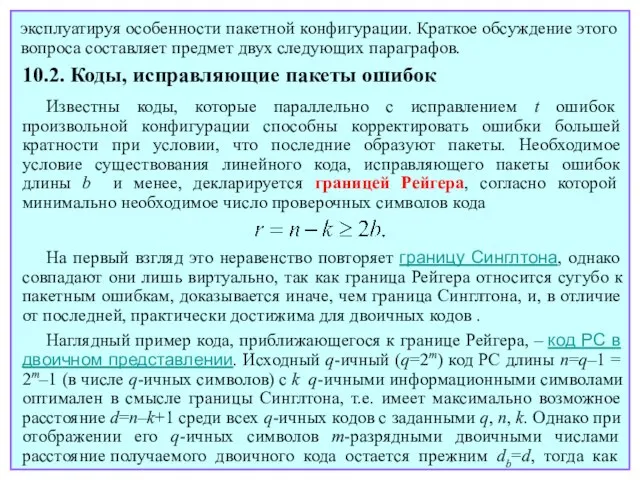

- 188. Лекция 25

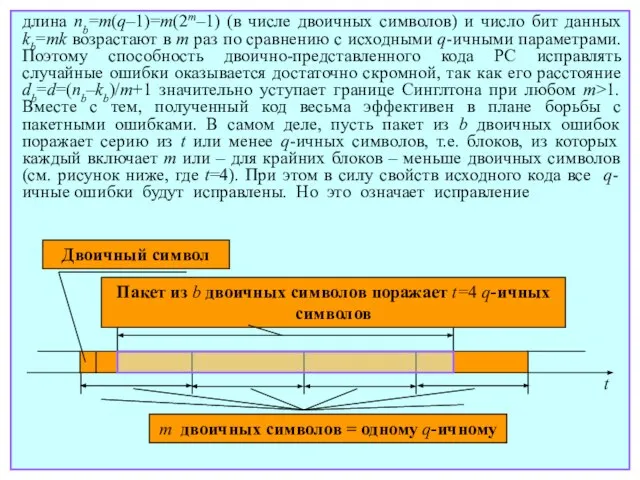

- 189. До этого момента (кроме краткого экскурса в двоичное представление кодов РСДо этого момента (кроме краткого экскурса

- 190. эксплуатируя особенности пакетной конфигурации. Краткое обсуждение этого вопроса составляет предмет двух следующих параграфов. 10.2. Коды, исправляющие

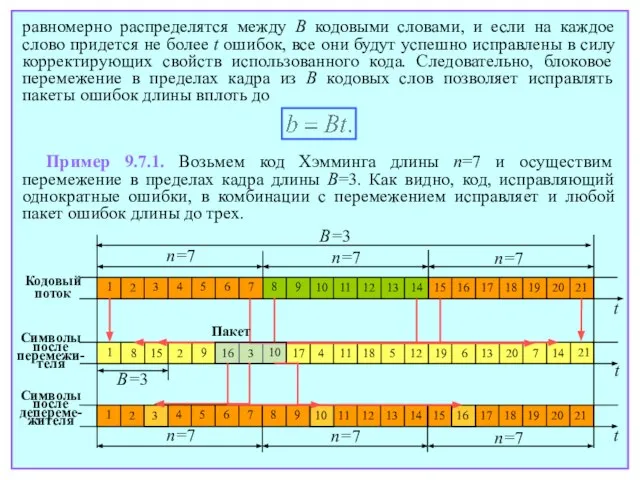

- 191. длина nb=m(q–1)=m(2m–1) (в числе двоичных символов) и число бит данных kb=mk возрастают в m раз по

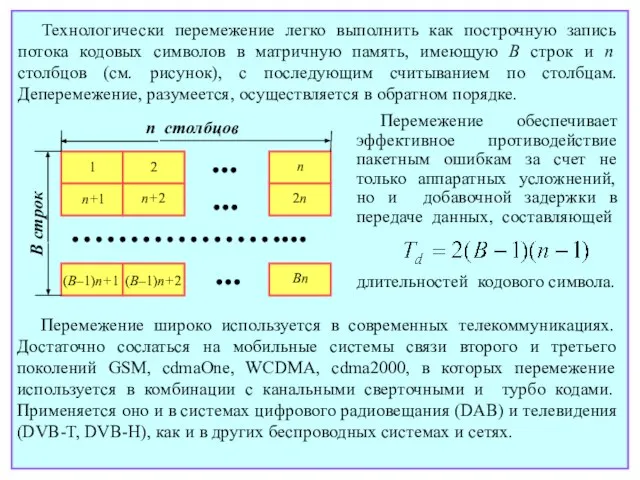

- 192. любого пакета двоичных ошибок длины b=m(t–1)+1=m[(nb–kb)/2m–1]+1 и менее. Когда число проверочных символов РС кода достаточно велико

- 193. равномерно распределятся между B кодовыми словами, и если на каждое слово придется не более t ошибок,

- 194. Технологически перемежение легко выполнить как построчную запись потока кодовых символов в матричную память, имеющую B строк

- 195. Лекция 26

- 196. 11. Элементы криптографии 11.1. Основные определения Термин криптография происходит от греческого kryptos (скрытый) и относится к

- 197. z. Для облегчения понимания задачи полезно представить все множество возможных шифров как некий гигантский справочник, в

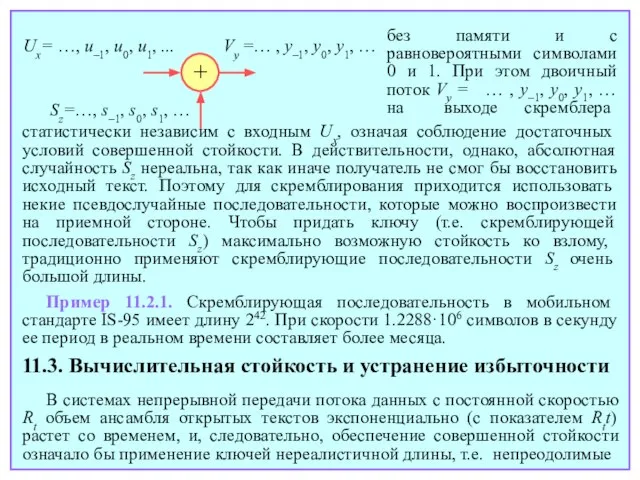

- 198. Как можно видеть, основная идея любой криптосистемы – доступность ключа только отправителю и получателю. Как, однако,

- 199. Другими словами, шифрование должно обеспечивать статистическую независимость открытых текстов и криптограмм. При выполнении этого условия криптосистема

- 200. статистически независим с входным Ux, означая соблюдение достаточных условий совершенной стойкости. В действительности, однако, абсолютная случайность

- 201. проблемы в управлении ключами. По этой причине в практических криптосистемах повсеместно применяется дробление потока данных на

- 202. помощью простейшего шифра подстановки, т.е. заменяет каждую букву (восьмибитовый блок ASCII кода) некоторой другой, например, A→U,

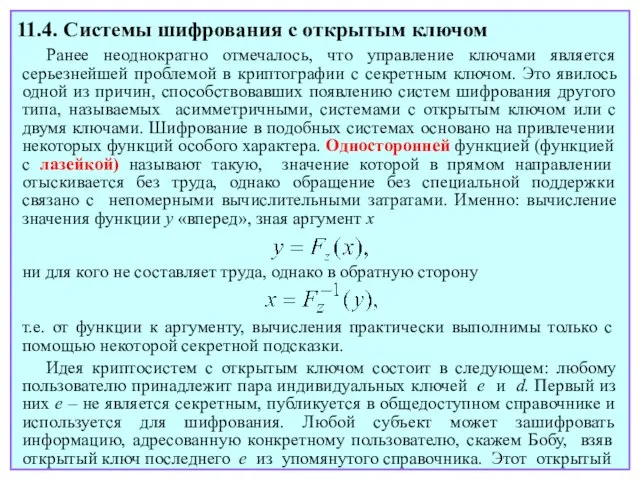

- 203. Предшествующее шифрованию устранение избыточности, как следует из сказанного, потенциально повышает стойкость криптосистемы и потому широко используется

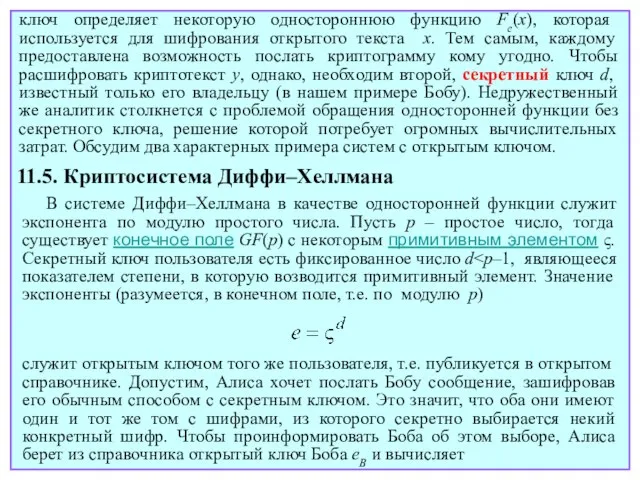

- 204. Лекция 27

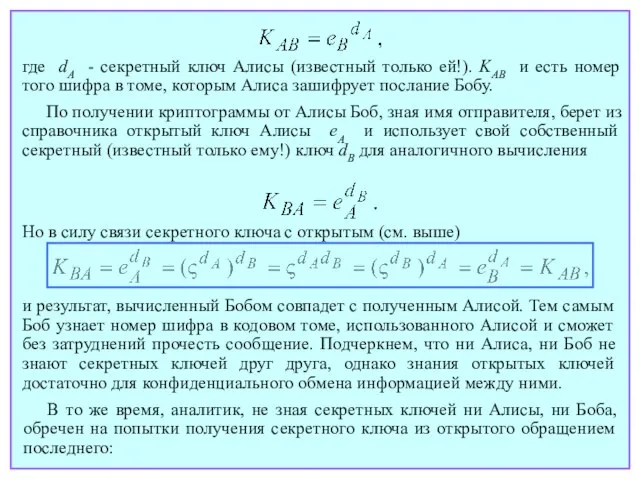

- 205. Ранее неоднократно отмечалось, что управление ключами является серьезнейшей проблемой в криптографии с секретным ключом. Это явилось

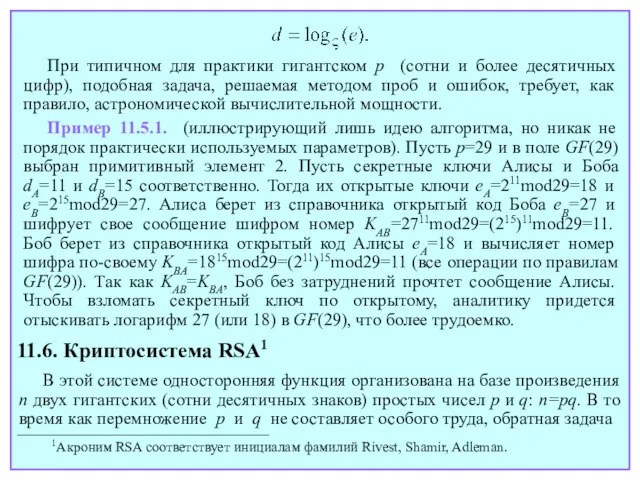

- 206. ключ определяет некоторую одностороннюю функцию Fe(x), которая используется для шифрования открытого текста x. Тем самым, каждому

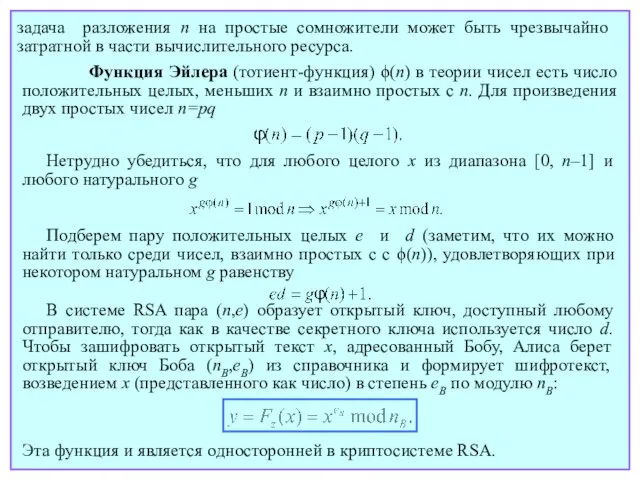

- 207. где dA - секретный ключ Алисы (известный только ей!). KAB и есть номер того шифра в

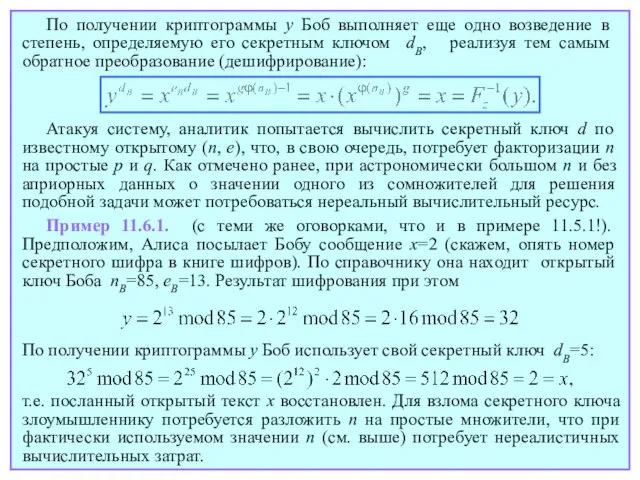

- 208. При типичном для практики гигантском p (сотни и более десятичных цифр), подобная задача, решаемая методом проб

- 209. Функция Эйлера (тотиент-функция) ϕ(n) в теории чисел есть число положительных целых, меньших n и взаимно простых

- 210. По получении криптограммы y Боб выполняет еще одно возведение в степень, определяемую его секретным ключом dB,

- 212. Скачать презентацию

Слайд 3Лекция 1

Лекция 1

Слайд 4Источник

Обобщенные модели систем передачи и хранения информации

Передатчик

Приемник

Получатель

Среда распространения

Источник

Получатель

Память

Устройство записи

Устройство чтения

Источник

Обобщенные модели систем передачи и хранения информации

Передатчик

Приемник

Получатель

Среда распространения

Источник

Получатель

Память

Устройство записи

Устройство чтения

Слайд 5Типы кодирования

«Сырые» данные

Кодирование источника

Канальное кодирование

Шифрование

Кодирование для линии

Помехоустойчивое кодирование

Типы кодирования

«Сырые» данные

Кодирование источника

Канальное кодирование

Шифрование

Кодирование для линии

Помехоустойчивое кодирование

Слайд 6Обобщенная модель системы передачи информации

Декодер источника

Дешифратор

Декодер канала

Демодулятор

К получателю

Передатчик

Приемник

Обобщенная модель системы передачи информации

Декодер источника

Дешифратор

Декодер канала

Демодулятор

К получателю

Передатчик

Приемник

Слайд 7Исторические вехи в теории и технике кодирования

1837: Электрический телеграф и код Морзе

Исторические вехи в теории и технике кодирования

1837: Электрический телеграф и код Морзе

1875: Буквопечатающий телеграф и код Бодо (E. Baudot).

1924, 1928: Работы Найквиста (H. Nyquist) и Хартли (R. Hartley) по исследованию каналов связи и скорости передачи информации.

1947-48: Фундаментальные работы К. Шеннона (C. Shannon) и В.А. Котельникова, ознаменовавшие создание теории информации.

1949-50: Первые помехоустойчивые коды: Голей, (M. Golay), Хэмминг (R. Hamming).

1952: Алгоритм Хаффмена (D. Huffman) кодирования источника.

1959-60: Коды БЧХ (R. Bose, D. Ray-Chaudhuri, A. Hochquenghem) и Рида-Соломона (I. Reed, G. Solomon).

1967: Алгоритм Витерби (A. Viterbi) декодирования сверточных кодов.

1976-78: Криптография с открытым ключом (W. Diffie, M. Hellman, R. Rivest, A. Shamir, A. Adleman and others).

1977-78: Словарные алгоритмы компрессии данных (A. Lempel, J. Ziv).

1979-1982: Модуляция на основе решетчатых кодов (G. Ungerboek).

1993: Турбо-коды (C. Berrou, A. Glavieux, P. Titimajshima).

Слайд 8Некоторые вводные задачи

Некоторые вводные задачи

Слайд 9Лекция 2

Лекция 2

Слайд 101. Источники сообщений, количество информации, энтропия

1.1. Идея определения количества информации

С теоретической точки

1. Источники сообщений, количество информации, энтропия

1.1. Идея определения количества информации

С теоретической точки

1.2. Математическая модель источника информации. Дискретные и непрерывные источники

Дискретным называется источник, множество X возможных сообщений которого конечно или счетно X={x1, x2, …}. Подобный источник полностью описывается набором вероятностей сообщений: p(xi), i=1,2, … . Условие нормировки:

Слайд 11Рассматривая непрерывные источники, мы ограничимся только теми, несчетный ансамбль которых может быть

Рассматривая непрерывные источники, мы ограничимся только теми, несчетный ансамбль которых может быть

1.3. Количество информации в сообщении

Аксиомы количества информации (требования к универсальной информационной мере):

1. Количество информации в сообщении x зависит только от его вероятности:

2. Неотрицательность количества информации:

причем I(x)=0 только для достоверного события (p(x)=1).

3. Аддитивность количества информации для независимых сообщений:

Слайд 12Единственной функцией, удовлетворяющей этим трем аксиомам оказывается логарифм вероятности сообщения:

1.4. Энтропия дискретного

Единственной функцией, удовлетворяющей этим трем аксиомам оказывается логарифм вероятности сообщения:

1.4. Энтропия дискретного

Энтропия дискретного источника есть среднее количество информации в его сообщениях:

Свойства энтропии:

1. Энтропия неотрицательна:

где равенство нулю имеет место только для полностью детерминированного (неслучайного) источника.

Единица измерения количества информации зависит от выбора основания логарифма. Традиционное основание два дает единицу измерения количества информации, называемую битом (binary digit).

Слайд 132. Энтропия ограничена сверху соотношением

3. Энтропия ансамбля пар сообщений, генерируемых двумя независимыми

2. Энтропия ограничена сверху соотношением

3. Энтропия ансамбля пар сообщений, генерируемых двумя независимыми

Энтропия двоичного источника (p – вероятность одного из двух сообщений):

с равенством только для ансамбля M равновероятностных сообщений.

Слайд 14Энтропия двоичного источника в зависимости от p

Энтропия двоичного источника в зависимости от p

Слайд 15Лекция 3

Лекция 3

Слайд 16Источник

Кодер источника

Сообщения

(буквы, блоки и т.п.)

Кодовые слова

2. Кодирование источника

2.1. Основные определения

При

Источник

Кодер источника

Сообщения

(буквы, блоки и т.п.)

Кодовые слова

2. Кодирование источника

2.1. Основные определения

При

Слайд 172.2. Префиксные коды. Неравенство Крафта. Средняя длина кодового слова

Идея экономии числа символов

2.2. Префиксные коды. Неравенство Крафта. Средняя длина кодового слова

Идея экономии числа символов

Пример 2.2.1. Код представленный ниже (M=4) не является однозначно декодируемым. Действительно, если на выходе кодера появится комбинация

Цель кодирования источника – наиболее экономное представление сообщений, т.е. отображение их словами по возможности меньшей длины.

x1 ⭢ 0

x2 ⭢ 01

x3 ⭢ 11

x4 ⭢ 111

00111111,

она может быть прочитана как

x1, x2, x3, x4, или x1, x2, x4, x3, или x1, x1, x4, x4, или x1, x1, x3, x3, x3.

Пример 2.2.2. В отличие от предыдущего, код, представленный ниже (M=4) является префиксным, и, следовательно, однозначно декодируемым.

Слайд 18x1 ⭢ 0

x2 ⭢ 10

x3 ⭢ 110

x4 ⭢ 111

Так, если последовательность на выходе

x1 ⭢ 0

x2 ⭢ 10

x3 ⭢ 110

x4 ⭢ 111

Так, если последовательность на выходе

0011010111110,

ее можно декодировать единственным образом:

x1, x1, x3, x2, x4, x3.

Теорема 2.2.1. (Неравенство Крафта). Код, содержащий M кодовых слов, может быть префиксным тогда и только тогда, когда длины его кодовых слов n1, n2, …, nM подчиняются неравенству

Средняя длина неравномерного кода определяется равенством

Любой префиксный код является мгновенно декодируемым. Это означает, что любое его слово можно распознать сразу по появлении последнего из его символов (см. пример 2.2.2).

Слайд 19Теорема 2.2.2. Средняя длина лучших префиксных кодов лежит в границах

2.3. Код Шеннона-Фано

На

Теорема 2.2.2. Средняя длина лучших префиксных кодов лежит в границах

2.3. Код Шеннона-Фано

На

Нетрудно показать, что средняя длина кода Шеннона-Фано удовлетворяет правому неравенству Теоремы 2.2.2:

Слайд 20Пример 2.3.1. Закодируем дискретный источник M=8 сообщений, имеющих вероятности, перечисленные в таблице.

В

Пример 2.3.1. Закодируем дискретный источник M=8 сообщений, имеющих вероятности, перечисленные в таблице.

В

Слайд 21Лекция 4

Лекция 4

Слайд 222.4. Код Хаффмена

Этот код оптимален в том смысле, что ни один префиксный

2.4. Код Хаффмена

Этот код оптимален в том смысле, что ни один префиксный

Удобнее, приступая к процедуре кодирования, записать все сообщения в порядке убывания их вероятностей. Следует также отметить, что, в противоположность алгоритму Шеннона-Фано, в ходе кодирования по Хаффмену любое кодовое слово появляется в обратном порядке.

Пример, приведенный ниже иллюстрирует процесс кодирования и демонстрирует сравнительное преимущество кода Хаффмена.

Слайд 23Пример 2.4.1. Закодируем по Хаффмену ансамбль из Примера 2.3.1:

X p(x)

x1 0.40

x2 0.20

x3 0.15

x4 0.10

x5 0.05

x6 0.04

x7 0.03

x8 0.03

0

1

0

0

1

0

1

0

1

0

1

1.00

0.06

0.09

0.35

Средняя длина:

0

1

0.15

0.25

1

0.60

Кодовые слова

0

110

100

101

11100

11101

11110

11111

Пример 2.4.1. Закодируем по Хаффмену ансамбль из Примера 2.3.1:

X p(x)

x1 0.40

x2 0.20

x3 0.15

x4 0.10

x5 0.05

x6 0.04

x7 0.03

x8 0.03

0

1

0

0

1

0

1

0

1

0

1

1.00

0.06

0.09

0.35

Средняя длина:

0

1

0.15

0.25

1

0.60

Кодовые слова

0

110

100

101

11100

11101

11110

11111

Слайд 24На практике источник генерирует сообщения (часто удобно называть их буквами) последовательно одно

На практике источник генерирует сообщения (часто удобно называть их буквами) последовательно одно

2.5. Теорема кодирования источника (неравномерные коды)

Теорема 2.5.1. Кодируя блоки из m букв, можно сколь угодно приблизить среднее число кодовых символов на букву к энтропии алфавита источника за счет увеличения длины блока m.

Заметим, что это утверждение останется в силе для произвольного источника (не только для источника без памяти).

Нетрудно убедиться, что для источника без памяти

и значит

В итоге имеет место

Слайд 252.6. Равномерное кодирование источника

Неравномерное кодирование не всегда удобно. Нередки сценарии (например, цифровое

2.6. Равномерное кодирование источника

Неравномерное кодирование не всегда удобно. Нередки сценарии (например, цифровое

что соответствует требуемому числу кодовых символов на букву

Теорема 2.6.1. Кодируя достаточно длинные m-блоки букв источника можно как угодно приблизить длину равномерного кода на букву к энтропии алфавита источника, удерживая вероятность нарушения однозначности декодирования не выше наперед заданной.

Слайд 262.7. Словарные коды. Алгоритм Лемпеля-Зива

Рассмотренные ранее методы кодирования источника опираются на априорное

2.7. Словарные коды. Алгоритм Лемпеля-Зива

Рассмотренные ранее методы кодирования источника опираются на априорное

Пример 2.7.1. Закодируем по Лемпелю-Зиву поток двоичных данных 10101100001001100111001101001111001110100111110011100001100111001100111000, опираясь на словарь из 16 фраз. Предварительно мы имеем в словаре только две фразы, являющиеся самими символами алфавита 0 и 1, записанными как первая и вторая строки. Кодер видит, что первая самая короткая, отсутствующая в словаре есть 10 и добавляет ее как третью строку словаря, представляя через префикс (1), который, в свою очередь, выражен

Слайд 27своим адресом в словаре (2), и обновляющим символом 0. Все последующие шаги

своим адресом в словаре (2), и обновляющим символом 0. Все последующие шаги

Чтобы понять ход декодирования, достаточно рассмотреть приведенный пример в обратном порядке, обратившись к потоку битов с выхода кодера. По получении очередного двоичного кодового слова, декодер разбивает его на префикс (в примере – 4 бита) и обновляющий бит. Префикс дает адрес части фразы, уже содержащейся в словаре. Вместе с обновляющим битом она вводится в словарь как его новая строка. Например, после того как декодер принимает слово 00100, он распознает префикс как 1 (присутствует в словаре под номером 2).

Слайд 28Наряду с обновляющим символом 0 это дает новый вход словаря для фразы

Наряду с обновляющим символом 0 это дает новый вход словаря для фразы

Слайд 29Лекция 5

Лекция 5

Слайд 302.8. Резюме. Примеры приложений

Из вышесказанного следует, что генерируемые источником данные можно сжать

2.8. Резюме. Примеры приложений

Из вышесказанного следует, что генерируемые источником данные можно сжать

Компрессия данных источника наиболее действенна при кодировании достаточно длинных блоков элементарных сообщений (букв), особенно если источник обладает памятью. Поступая таким образом, мы добиваемся выигрыша в среднем числе символов кода на первичное сообщение (букву) в обмен на задержку при декодировании сообщения. Последнее нередко оказывается ограничивающим фактором в приложениях.

Поскольку целью кодирования источника служит устранение избыточности, закодированные сообщения избыточности содержать не должны. Это означает, что их можно трактовать как равновероятные, так как избыточность сообщений и есть результат их неравных вероятностей. Поэтому комбинацию «источник-кодер источника» можно интерпретировать как агрегированный эквивалентный источник безызбыточных сообщений. Исходя из этого, при изучении далее каналов и канального кодирования мы будем полагать сообщения на входе канала равновероятными.

Слайд 31В настоящее время широко применяются как равномерное, так и неравномерное кодирование источника.

В настоящее время широко применяются как равномерное, так и неравномерное кодирование источника.

Однако коды Хаффмена, хотя и являются оптимальными теоретически, не могут служить универсальным инструментом для всех практических приложений. Чтобы их использование имело реальный смысл, необходимо располагать точной статистической моделью источника, то есть знать статистику сообщений. Столь детальная информация, однако, зачастую недоступна. В подобных ситуациях можно прибегнуть к адаптивному кодированию, идея которого состоит в получении недостающей информации прямо из потока исходных сообщений. Кодер, обучаясь по мере поступления данных от источника, параллельно оптимизирует процедуру кодирования.

Этот принцип лежит в основе алгоритмов «словарного кодирования» (см. раздел 2.7), к числу которых принадлежат популярные версии процедур Лемпеля-Зива и Лемпеля-Зива-Велча, широко применяемые, в частности, при архивировании файлов. Основная идея большинства из них сводится к формированию словаря комбинаций битов источника, в который каждая вновь встреченная комбинация вводится как экономная модификация уже

Слайд 32Многообразны и поучительны примеры применения методов адаптивного сжатия данных в кодировании речи,

Многообразны и поучительны примеры применения методов адаптивного сжатия данных в кодировании речи,

Вокодеры открывают путь к более эффективному сжатию речи. Они основаны на моделировании человеческого голоса фильтром, возбуждаемым некоторым псевдослучайным сигналом. При этом кодируются не отсчеты

упомянутой в словаре. Изящество словарных кодов состоит в отсутствии необходимости передачи словаря декодеру: последний в состоянии восстановить его самостоятельно в ходе декодирования.

Слайд 33В стандартах мобильной связи GSM, IS-95 и 3G используются вокодеры типов VSELP

В стандартах мобильной связи GSM, IS-95 и 3G используются вокодеры типов VSELP

речевого колебания, а параметры фильтра и возбуждающего сигнала.

Слайд 343. Взаимная информация. Пропускная способность канала. Теоремы кодирования для канала

3.1. Математическое описание

3. Взаимная информация. Пропускная способность канала. Теоремы кодирования для канала

3.1. Математическое описание

Теоретически канал можно трактовать как «черный ящик», характеризуемый выходным откликом (наблюдением) y(t) на входной сигнал x(t). Детерминированный канал можно было бы полностью описать его оператором, т. е. зависимостью y(t)=F(x(t)). В нашем же контексте более интересны статистические (стохастические) каналы, свойства которых можно описать только в вероятностных категориях. Все, что можно знать о таком канале, выражено его переходной вероятностью p(y(t)|x(t)), показывающей, с какой вероятностью фиксированный входной сигнал x(t) преобразуется каналом в то или иное выходное наблюдение y(t). Статистическое описание канала является исчерпывающим, когда известны переходные вероятности для всех возможных сочетаний входа x(t) и выхода y(t).

Подчеркнем, что в математическую модель канала можно включать любые компоненты реальных систем передачи информации с единственной оговоркой: в нее обязательно должна войти физическая среда распространения.

Слайд 35Все каналы можно классифицировать на дискретные и непрерывные как по времени, так

Все каналы можно классифицировать на дискретные и непрерывные как по времени, так

На вход любого канала по завершении одного воздействия может поступить следующее. В этом контексте важно, обладает канал памятью или нет. Для канала без памяти отклик на входное воздействие не зависит от значения воздействия в предыдущий момент времени. Простейшая и одна из важнейших модель канала – дискретный канал без памяти (ДКБП). Пусть x(i), y(i) – входные и выходные символы ДКБП отвечающие i-тому моменту времени. Тогда переходная вероятность p(y|x), т. е. вероятность, преобразования каналом входного n-мерного вектора x=(x(1), x(2), … , x(n)) в выходной y = (y(1), y(2), … , y(n)), где x(i)∈X, y(i)∈Y , y(i)∈Y и X,Y – входной и выходной алфавиты

Слайд 36Пример 3.1.1. Двоичный симметричный канал (ДСК):

p – вероятность ошибки на символ.

Тем самым,

Пример 3.1.1. Двоичный симметричный канал (ДСК):

p – вероятность ошибки на символ.

Тем самым,

Слайд 37Лекция 6

Лекция 6

Слайд 383.2. Взаимная информация, остаточная энтропия, пропускная способность канала

Для канала, подверженного влиянию случайных

3.2. Взаимная информация, остаточная энтропия, пропускная способность канала

Для канала, подверженного влиянию случайных

Выход y, однако, сам случаен, поэтому разумно усреднить H(X|y) по всем возможным y, чтобы прийти к численной мере средней неопределенности относительно входного значения, остающейся после наблюдения. Полученную условную энтропию входного ансамбля относительно выходного уместно также назвать остаточной энтропией (в работах Шеннона – equivocation – ненадежность):

Слайд 39или, полагая p(y)p(x|y)=p(x,y),

Так как до наблюдения неопределенность относительно входного ансамбля равнялась энтропии

или, полагая p(y)p(x|y)=p(x,y),

Так как до наблюдения неопределенность относительно входного ансамбля равнялась энтропии

Слайд 40Как видно, I(X;Y) показывает число битов информации о входе канала извлекаемое в

Как видно, I(X;Y) показывает число битов информации о входе канала извлекаемое в

Можно заметить, что I(X;Y) – математическое ожидание величины

называемой взаимной информацией между x и y. Здесь первое слагаемое правой части – количество информации I(x) в x безотносительно к каким-либо другим событиям, а второе – количество информации I(x|y) в x после того, как получено наблюдение y. Поэтому I(x;y) показывает изменение неопределенности относительно x до и после наблюдения y.

Взаимная информация I(x; y) может быть и положительной, так и отрицательной, так как вероятность значения x может как возрасти, так и уменьшиться в результате наблюдения y. В отличие от этого, принципиальная неотрицательность средней взаимной информации I(X;Y) говорит о том, что в среднем осведомленность об ансамбле X после наблюдения события из некоторого другого ансамбля Y снизиться не может.

Слайд 41Легко доказать симметрию взаимной и средней взаимной информации: I(x;y)=I(y;x); I(X;Y) =I(Y;X).

Максимальное количество

Легко доказать симметрию взаимной и средней взаимной информации: I(x;y)=I(y;x); I(X;Y) =I(Y;X).

Максимальное количество

где максимизация выполняется по всем априорным распределениям вероятностей p(X) входных n-символьных блоков и длине блока n при фиксированных входных и выходных алфавитах (X и Y соответственно). Пропускная способность – фундаментальный параметр канала, определяющий его потенциальные возможности в части надежной передачи информации.

3.3. Ошибка декодирования. Неравенство Фано

Охватим моделью канала кодер и декодер. Это означает, что на вход канала поступает сообщение источника (в закодированной форме), а на выходе выдается решение о том, какое сообщение передано (результат декодирования). При этом входной и выходной ансамбли совпадают X=Y, однако декодированное сообщение y∈Y может отличаться от переданного,

Слайд 42в каковом случае имеет место ошибка декодирования (ошибочное решение). Вероятность ошибки декодирования

в каковом случае имеет место ошибка декодирования (ошибочное решение). Вероятность ошибки декодирования

Каждый из двух показателей – и остаточная энтропия H(X|Y), и вероятность ошибки декодирования – характеризует надежность передачи данных по каналу. Поэтому естественно наличие взаимосвязи между ними.

Теорема 3.3.1. (Неравенство Фано). Остаточная энтропия и вероятность ошибки декодирования подчиняются неравенству

где h(·) – энтропия двоичного источника, а M – общее число сообщений.

Слайд 43Лекция 7

Лекция 7

Слайд 443.4. Теоремы кодирования для канала

Пусть одно из M равновероятных сообщений, закодированное

3.4. Теоремы кодирования для канала

Пусть одно из M равновероятных сообщений, закодированное

бит информации на каждый кодовый символ. Параметр R называется скоростью передачи или скоростью кода. Именно соотношение между скоростью R и пропускной способностью C говорит о потенциальной надежности передачи данных по каналу. Соответствующие утверждения содержатся в замечательных теоремах Шеннона:

Теорема 3.4.1. (Обратная теорема кодирования). При скорости, превышающей пропускную способность канала, R>C, не существует кода, гарантирующего произвольно малую вероятность ошибочного декодирования.

Теорема 3.4.2. (Прямая теорема кодирования). При скорости, меньшей пропускной способности канала, R

Слайд 45этому, если скорость R меньше емкости канала C, в принципе всегда можно

этому, если скорость R меньше емкости канала C, в принципе всегда можно

Обратную теорему можно доказать, опираясь на неравенство Фано. После некоторых простых преобразования для ДКБП можно получить

для C 0 1 1 Pe 0.5 0 1 1 Pe 0.5 Pe h(Pe) f(Pe) n=1 n=2 n=∞ ε δ

Слайд 46В отличие от обратной, доказательство прямой теоремы для общей модели канала без

В отличие от обратной, доказательство прямой теоремы для общей модели канала без

где величина E(R), называемая функцией надежности канала, не зависит от длины кода n и всегда положительна при скорости R, меньшей пропускной способности канала C. Функция E(R) определяется только свойствами канала и возрастает с «просветом» между пропускной способностью и скоростью передачи данных. Как видно из экспоненты случайного кодирования, по крайней мере для некоторых лучших кодов вероятность ошибочного декодирования экспоненциально убывает с ростом n, т. е. может быть сделана произвольно малой за счет увеличения длины кода.

Верхняя граница для Pe (экспонента случайного кодирования) является экспоненциально точной, асимптотически приближаясь для лучших кодов достаточно большой длины n к истинной вероятности ошибки декодирования. Поэтому она служит надежным эталоном в суждении о том,

Слайд 47Прямая теорема Шеннона является типичной математической теоремой существования, не давая ни малейшего

Прямая теорема Шеннона является типичной математической теоремой существования, не давая ни малейшего

насколько хорош тот или иной конкретный код. При этом вероятность ошибки декодирования для исследуемого кода сравнивается с экспонентой случайного кодирования с целью выяснения, насколько его эффективность близка к потенциальной. Нижеследующие графики показывают характерные зависимости вероятности ошибки Pe от длины n и функции надежности E(R) от скорости R.

E(R)

Pe

n

0

R1

R2

R1 0 R C

Слайд 48Лекция 8

Лекция 8

Слайд 494. Расчет пропускной способности некоторых каналов

4.1. Дискретный канал без памяти

Как следует из

4. Расчет пропускной способности некоторых каналов

4.1. Дискретный канал без памяти

Как следует из

где использовано свойство симметрии взаимной информации. Поскольку

задача состоит в максимизации I(X;Y) при заданных переходных вероятностях по всем распределениям вероятности p(x), т.е. по всем векторам с неотрицательными компонентами, удовлетворяющим условию нормировки

Слайд 50 Для модели произвольного ДКБП подобная оптимизационная задача не имеет замкнутого аналитического решения.

Для модели произвольного ДКБП подобная оптимизационная задача не имеет замкнутого аналитического решения.

4.2. Двоичный симметричный канал (ДСК)

Обозначим вероятность появления на входе ДСК символа x=0 как w . Тогда вероятности выходных символов выразятся как показано ниже

1–p

1–p

p

p

P(x=0)=w

P(x=1)=1–w

P(y=0)=w(1–p)+(1–w)p

P(y=1)=wp+(1–w)(1–p)

Слайд 51Поскольку при любом x на входе, на выходе канала возможны только два

Поскольку при любом x на входе, на выходе канала возможны только два

Как видно, когда p=0, т. е. канал свободен от ошибок, его пропускная способность равна 1бит/символ, что неудивительно, так как на входе в один символ можно вложить максимум один бит информации. Та же ситуация имеет место и при p=1 – канал вновь детерминирован и приемной стороне известно, что он лишь меняет любой символ на противоположный. Когда p=1/2, выходные символы 0 и 1 равновероятны независимо от значения входного символа. Поэтому никакой передачи информации со входа на выход не происходит (событие, именуемое обрывом канала). Естественно поэтому полагать 0 Пропускная способность ДСК С в зависимости от вероятности ошибки на символ p

Слайд 52Лекция 9

Лекция 9

Слайд 534.3. Непрерывные источники. Взаимная информация и относительная (дифференциальная) энтропия

Рассмотрим непрерывный ансамбль, эквивалентный

4.3. Непрерывные источники. Взаимная информация и относительная (дифференциальная) энтропия

Рассмотрим непрерывный ансамбль, эквивалентный

Два непрерывных ансамбля полностью описываются их совместной ПВ

Квантуя непрерывные величины, т.е. приближая их дискретными, легко распространить понятие средней взаимной информации на непрерывные ансамбли. Средняя взаимная информация I(X;Y) двух непрерывных ансамблей X и Y

W(x)

x

0

...

...

Δ

Слайд 54Дифференциальная (относительная) энтропия непрерывной величины X определяется равенством

Таким образом, средняя взаимная информация

Дифференциальная (относительная) энтропия непрерывной величины X определяется равенством

Таким образом, средняя взаимная информация

Дифференциальная энтропия играет в приложениях ту же роль, что и обычная энтропия дискретного ансамбля: характеризует среднюю неопределенность случайной переменной, т.е. среднее количество информации в ее значениях.

Теорема 4.3.1. На множестве случайных величин с дисперсией, ограниченной сверху значением σ2, наибольшую дифференциальную энтропию имеет гауссовская:

Слайд 554.4. Пропускная способность непрерывного гауссовского канала

Рассмотрим полностью непрерывный (по времени и состоянию)

4.4. Пропускная способность непрерывного гауссовского канала

Рассмотрим полностью непрерывный (по времени и состоянию)

1. шум в канале z(t) аддитивен, т.e. y(t)=x(t)+z(t);

2. шум гауссовский (ПВ его отсчетов есть WG(x));

3. полоса пропускания канала равна W.

Подобный канал называют гауссовским с полосой W.

Благодаря конечности полосы, дискретизация входного и выходного процессов с частотой Найквиста-Котельникова Td=1/2W преобразует непрерывный по времени канал в дискретный с непрерывными (принадлежащими континуальному алфавиту) символами на входе и выходе. Пусть также спектральная плотность шума равномерна в пределах полосы с односторонней спектральной плотностью мощности N0. Тогда автокорреляционная функция шума описывается законом «sinc» (см.рисунок).

Слайд 560

f

W

N0

Спектральная плотность мощности шума

τ

N0W

0

Автокорреляционная функция шума

Как теперь видно, отсчеты с частотой Найквиста-Котельникова

0

f

W

N0

Спектральная плотность мощности шума

τ

N0W

0

Автокорреляционная функция шума

Как теперь видно, отсчеты с частотой Найквиста-Котельникова

где максимизация проводится по ПВ входных символов W(x). Из y=x+z следует, что Hd(Y|X)=Hd(Z)=(1/2)log2πeσ2 не зависит от W(x), и только Hd(Y) можно максимизировать подбором W(x). Но при ограниченной средней мощности сигнала Ps и фиксированной мощности шума Pn= σ2 мощность на выходе не может превысить Ps+Pn,, означая, что maxHd(Y) =(1/2)log2πe(Ps+ Pn). После перехода к скорости передачи в реальном масштабе времени Ct=C/Td

Слайд 57придем к знаменитой формуле Шеннона для пропускной способности гауссовского канала:

Этот результат показывает,

придем к знаменитой формуле Шеннона для пропускной способности гауссовского канала:

Этот результат показывает,

В реальности спектральная плотность мощности шума N0 может зачастую считаться постоянной в произвольной полосе W, так что Pn=N0W и, когда полоса расширяется, пропускная способность растет, стремясь к пределу

называемому пропускной способностью гауссовского канала с неограниченной полосой. Безусловно, эта формула может использоваться и для ограниченного по полосе канала, если Ps /Pn=Ps /N0W<<1. Подобный результат демонстрирует потенциальную возможность надежно передавать данные с ненулевой скоростью при исчезающее малом отношении сигнал-шум по мощности в канале.

Слайд 58Вспомнив, что Ct - максимальная теоретически достижимая скорость Rt безошибочной передачи, введем

Вспомнив, что Ct - максимальная теоретически достижимая скорость Rt безошибочной передачи, введем

показывающую зависимость достижимой спектральной эффективности Rt/W (скорости на 1 Гц) от отношения сигнал-шум на бит, где Eb – энергия сигнала на бит (но не кодовый символ!) полезной информации. Рисунок слева показывает, что ненулевая скорость на 1Гц достижима при

Запретная область

Область возможных скоростей

Eb/N0>ln2. Если при проектировании системы высшим приоритетом является энергосбережение (величина Eb/N0 не может быть значительной), единственным средством повышения надежности передачи служит расширение полосы (W>>Rt). Напротив, когда главная цель – высокая спектральная эффективность (Rt>>W), проектировщик вынужден полагаться только на достаточную излучаемую энергию Eb/N0>>1. Оба указанных сценария весьма типичны для современных телекоммуникационных систем.

Слайд 59Лекция 10

Лекция 10

Слайд 605. Введение в блоковые коды

5.1. Общая идея канального кодирования. Классификация кодов

Как уже

5. Введение в блоковые коды

5.1. Общая идея канального кодирования. Классификация кодов

Как уже

Слайд 61было передано, если решение выносится в пользу «ближайшего» (отличающегося в минимальном числе

было передано, если решение выносится в пользу «ближайшего» (отличающегося в минимальном числе

Канальные коды можно классифицировать на основе ряда признаков. Первый из них – объем алфавита, согласно которому коды разделяются на двоичные, троичные и т. п. Начав с двоичных кодов, мы в дальнейшем коснемся и недвоичных.

Другой классификационный признак отражает способ преобразования потока данных (сообщений) источника в поток кодовых символов. В этом плане коды можно разделить на блоковые и решетчатые (древовидные). В блоковых кодах k битов данных преобразуются в кодовое слово длины n, проверочные символы которого защищают только «свои» k битов данных. В решетчатых (в частности сверточных) кодах текущая группа проверочных символов защищает несколько смежных блоков данных.

В зависимости от явного присутствия битов данных в кодовых словах различают систематические и несистематические коды. Блоковый код из рассмотренного выше примера – систематический, так как первые два символа в любом его слове – «чистые» биты сообщения.

Наконец, название кода часто содержит определение алгоритма построения или имя первооткрывателя: (линейный, циклический, Хэмминга, и пр.).

Слайд 62В последующем тексте используются слегка измененные обозначения:

U={u1, u2, … , uM} –

В последующем тексте используются слегка измененные обозначения:

U={u1, u2, … , uM} –

ui =(ui1, ui2, … , uin) – i-й кодовый вектор (кодовое слово),

uij - j-й элемент i-го кодового слова,

k=logM - число информационных битов в кодовом слове,

в то время как символы n, M и R=k/n служат, как и ранее, для обозначения длины кода, числа кодовых слов (сообщений) и скорости соответственно. В отличие от предшествующих глав, где нижние индексы служили для нумерации состояний, теперь в целях компактности они резервируются за дискретным временем.

5.2. Евклидово и хэммингово расстояние

Из основ теории связи хорошо известно, что сигнал si(t) конечной энергии Ei может интерпретироваться как вектор si длины, устанавливаемой теоремой Пифагора

Подобным же образом вводится евклидово расстояние между si(t) и sj(t):

Слайд 63Евклидово расстояние играет фундаментальную роль в теории и технике передачи сообщений. Чем

Евклидово расстояние играет фундаментальную роль в теории и технике передачи сообщений. Чем

С точки зрения математики евклидово расстояние не является единственным. Общее понятие расстояния базируется на трех аксиомах (симметрия, неотрицательность, неравенство треугольника). В частности, в теории кодирования широко используется хэммингово расстояние, равное числу позиций, на которых символы двух векторов не совпадают. Скажем, для двоичных векторов u1=(10110) и u2=(11011) хэммингово расстояние dH(u1, u2)=3, так как второй, третий и пятый их символы различны. Еще одна важная величина – вес Хемминга W(u) вектора u, равный числу ненулевых компонент последнего. К примеру, для тех же u1 и u2 W(u1)=3, W(u2)=4.

5.3. Декодирование по максимуму правдоподобия и минимуму расстояния

Рассмотрим общую задачу передачи информации: один из M сигналов s1(t), s2(t), … , sM(t), используемых для передачи M сообщений, поступает на вход

Слайд 64канала связи. На выходе канала наблюдается некоторое колебание y(t) (см.рисунок), являющееся переданным

канала связи. На выходе канала наблюдается некоторое колебание y(t) (см.рисунок), являющееся переданным

si(t)

y(t)

Канал

Блок решения

решение о том, какой из сигналов был передан, чтобы риск ошибочного принятия одного сообщения за другое оказался наименьшим?

При равновероятных входных сигналах и ориентации на критерий минимума вероятности перепутывания передаваемых сигналов оптимальным является правило максимального правдоподобия: решение выносится в пользу сигнала, считающегося наиболее правдоподобным. Последнее означает, что вероятность p(y(t)|si(t)) преобразования каналом в данное наблюдение y(t) (переходная вероятность канала) для названного сигнала больше, чем для всех остальных.

В гауссовском канале правдоподобие сигнала (см. рисунок слева) однозначно связано с его близостью к принятому колебанию y(t) в смысле евклидова расстояния, так как p(y(t)|si(t)) убывает экспоненциально с квадратом dE(y,si).

Сигнал s2(t) наиболее вероятен, так как dE(y,s2) В ДСК переходная вероятность (вероятность преобразования двоичного

Слайд 65кодового слова ui в наблюдаемый вектор y)

падает с хэмминговым расстоянием di= dH

кодового слова ui в наблюдаемый вектор y)

падает с хэмминговым расстоянием di= dH

Как видно, в обоих случаях правило максимума правдоподобия эквивалентно правилу минимума расстояния с разницей лишь в определении расстояния: решение принимается в пользу сигнала ближайшего к наблюдению.

5.4. Исправляющая способность кода. Ключевые параметры блоковых кодов

Говорят, что код исправляет вплоть до t ошибок, если при искажении любых t или менее символов в любом его кодовом слове, последнее, тем не менее, декодируется (по минимуму расстояния) верно.

Наименьшее хэммингово расстояние между парами слов в коде называется его минимальным расстоянием (или просто расстоянием)

Слайд 66Теорема 5.4.1. Код исправляет вплоть до t ошибок тогда и только тогда,

Теорема 5.4.1. Код исправляет вплоть до t ошибок тогда и только тогда,

Поучительна геометрическая интерпретация этого факта. Хэммингова сфера радиуса t с центром в ui есть множество точек (векторов), расположенных в пределах хэммингова расстояния t от вектора ui. Если все

кодовые векторы удается окружить подобными сферами радиуса t без пересечений между ними, декодер сможет декодировать любой вектор в i-й сфере в i-е кодовое слово. Тем самым любая ошибка кратности t или менее в любом кодовом слове будет исправлена. Но избежать пересечения сфер радиуса t можно лишь при условии, что расстояние между любыми кодовыми векторами не меньше 2t+1.

u2

u1

u3

uM

y

t

d(y,u3)≤t

Нетрудно также убедиться, что для обнаружения ошибок кратности вплоть до t необходимо и достаточно соблюдения условия

Слайд 67Длина кода n вместе с объемом M и расстоянием d составляют тройку

Длина кода n вместе с объемом M и расстоянием d составляют тройку

Слайд 68Лекция 11

Лекция 11

Слайд 695.5. Важнейшие границы теории кодирования

Очевидно, особый интерес представляют коды с максимальным расстоянием

5.5. Важнейшие границы теории кодирования

Очевидно, особый интерес представляют коды с максимальным расстоянием

Теорема 5.5.1. (Граница Хэмминга). Любой двоичный код, исправляющий вплоть до t ошибок, удовлетворяет неравенству :

Коды, лежащие на границе Хэмминга (удовлетворяющие ей с равенством), называются совершенными. Совершенные коды исправляют любые ошибки кратности t и менее, но не исправляют и не обнаруживают никаких ошибок большей кратности.

Геометрически такие коды реализуют так называемую «плотную упаковку», при которой все 2n двоичных векторов распределены по M сферам радиуса t, не имеющих пересечений и промежутков. Они названы совершенными, так как обеспечивают максимальную скорость R, допускаемую фиксированными d=2t+1 и n. Среди двоичных существуют лишь три класса совершенных кодов – тривиальный код с повторением нечетной длины, коды Хэмминга, исправляющие однократные ошибки (см. гл. 6), и код Голея длины 23 с расстоянием 7 (исправляющий ошибки вплоть до трехкратных).

Слайд 70Близкое по смыслу ограничение устанавливается границей Плоткина.

Теорема 5.5.2. (Граница Плоткина). Любой двоичный

Близкое по смыслу ограничение устанавливается границей Плоткина.

Теорема 5.5.2. (Граница Плоткина). Любой двоичный

Обе границы декларируют необходимые (но не достаточные) условия существования кодов. Их невыполнение свидетельствует о несуществовании кода с предполагаемыми значениями M, n и d, и поэтому их можно назвать верхними. Известны и более точные (однако и более сложные) верхние границы во всем диапазоне M, n, d (Элайеса и пр.).

С другой стороны, имеются и нижние границы, устанавливающие достаточные условия существования кодов с заданными M, n, d .

Теорема 5.5.3. (Граница Гилберта). Двоичный блоковый код, параметры которого удовлетворяют неравенству

существует наверняка.

Слайд 71Для больших длин n биномиальные коэффициенты в приведенных неравенствах можно аппроксимировать по

Для больших длин n биномиальные коэффициенты в приведенных неравенствах можно аппроксимировать по

где h(·) – энтропия двоичного ансамбля.

Если k=logM целое число, эта граница модифицируется в более точную границу Варшамова–Гилберта, устанавливающую существование кода, удовлетворяющего неравенству:

Если n>>1, код не существует при нарушении любого из неравенств

(асимптотические границы Хэмминга и Плоткина), но существует наверняка при условии (асимптотическая граница Гильберта):

Слайд 72упомянутыми является зоной неопределенности, для которой однозначный ответ о существовании кода нельзя

упомянутыми является зоной неопределенности, для которой однозначный ответ о существовании кода нельзя

Выигрыш от кодирования является количественной мерой улучшения качества передачи с применением кодирования по сравнению с безызбыточной передачей потока битов источника. Его значение показывает,

Приведенный ниже рисунок поясняет смысл асимптотических границ. Коды с параметрами M, n, d, попадающими в область выше любой из границ Хэмминга или Плоткина, существовать не могут, тогда как в области ниже границы Гилберта существование кодов гарантировано. Область между двумя

5.6. Энергетический выигрыш от кодирования. Мягкое и жесткое декодирование

Слайд 73во сколько раз можно уменьшить энергию сигнала за счет введения канального кодирования.

во сколько раз можно уменьшить энергию сигнала за счет введения канального кодирования.

Это равенство соответствует использованию двоичного кода для передачи данных по гауссовскому каналу с достаточно малой вероятностью ошибки декодирования (эквивалентно – большой энергией сигнала на бит полезной информации) в сочетании с так называемым мягким декодированием. Последнее подразумевает решение по минимуму евклидова расстояния для наблюдения «в целом», без предварительной демодуляции (т. е. решений о значениях) индивидуальных символов.

Слайд 74квантованием непрерывного выхода демодулятора, после чего следуют те же операции, что и

квантованием непрерывного выхода демодулятора, после чего следуют те же операции, что и

Подобные алгоритмы традиционно также относят к числу мягких. Простейший из них соответствует модели ДСК со стиранием (см. рисунок слева)

1–p–q

0

1

0

1

p

p

?

q

q

Жесткое декодирование, напротив, осуществляется в два этапа: на первом регенерируется каждый двоичный символ кода, а на втором –выполняется декодирование по минимуму хэммингова расстояния. В этом случае гауссовский канал попросту преобразуется в ДСК. Выигрыш от кодирования при жестком декодировании уменьшается примерно на 2…3 дБ по сравнению с мягким.

Возможны и промежуточные варианты декодирования, в которых на первом этапе жесткое решение о значении двоичного символа заменяется

1–p–q

Слайд 75Лекция 12

Лекция 12

Слайд 766. Линейные блоковые коды

6.1. Введение в конечные поля

Конечным полям принадлежит основополагающая роль

6. Линейные блоковые коды

6.1. Введение в конечные поля

Конечным полям принадлежит основополагающая роль

Полем F называется множество элементов, замкнутое относительно двух операций, называемых сложением и умножением (и обозначаемых традиционно знаками «+» и «·»). Замкнутость означает, что результаты сложения или умножения (сумма и произведение) также принадлежат F :

При этом сложение и умножения должны удовлетворять следующим аксиомам:

1. Сложение и умножение коммутативно:

2. Сложение и умножение ассоциативно:

Слайд 773. В F присутствуют два нейтральных элемента – нуль (обозначаемый символом «0») и

3. В F присутствуют два нейтральных элемента – нуль (обозначаемый символом «0») и

4. Для любого элемента a∈F имеется противоположный ему элемент (обозначаемый «–a»), т. е. такой, сумма a с которым равна нулю :

5. Для любого ненулевого элемента a∈F имеется обратный (обозначаемый «a–1»), т.е. такой произведение a на который равно единице:

6. Сложение и умножение подчиняются закону дистрибутивности:

Из перечисленных аксиом следует, что в любом поле наряду со сложением и умножением определены вычитание и деление :

и для

Слайд 78Простейшие среди полей – числовые (рациональных или действительных чисел), содержащие бесконечно много

Простейшие среди полей – числовые (рациональных или действительных чисел), содержащие бесконечно много

Можно доказать, что порядки любых конечных полей – натуральные степени простых чисел и только они: q=pm (p – простое, m – натуральное). Конечное поле простого порядка p называется простым полем. Любое простое можно сконструировать как множество остатков от деления натуральных чисел на p {0, 1, … , p–1} с операциями сложения и умножения по модулю p. Ниже даны примеры таблиц сложения и умножения в полях GF(2), GF(3), GF(5).

+

0 1

0

1

0 1

1 0

•

0 1

0

1

0 0

0 1

GF(2)

GF(5)

•

0 1 2 3 4

0

1

2

3

4

0 0 0 0 0 0 1 2 3 4

0 2 4 1 3

0 3 1 4 2 0 4 3 2 1

Операции в расширенных конечных полях (порядка q=pm, m>1), изучаемых позднее, несколько сложнее, чем сложение и умножение по модулю q.

Слайд 796.2. Векторные пространства над конечными полями

Понятие векторного пространства, традиционно вводимое для случая

6.2. Векторные пространства над конечными полями

Понятие векторного пространства, традиционно вводимое для случая

Пусть F – некоторое поле, элементы которого рассматриваются как скаляры. Тогда векторное пространство S над полем F есть множество элементов (векторов), замкнутое относительно двух операций: сложения векторов и умножения вектора на скаляр (с привычной нотацией “+” и “·”):

Названные операции должны вводиться так, чтобы выполнялись следующие аксиомы:

1. Сложение коммутативно и ассоциативно:

2. Существует нулевой вектор 0, при сложении с которым произвольный вектор остается неименным:

3. Для любого вектора имеется противоположный ему вектор –x:

Слайд 804. Умножение вектора на скаляр ассоциативно:

5. Умножение любого вектора на единичный скаляр (обязательно

4. Умножение вектора на скаляр ассоциативно:

5. Умножение любого вектора на единичный скаляр (обязательно

6. Справедливы два закона дистрибутивности:

Стандартная модель векторного пространства в теории кодирования – множество n–элементных строк x=(x1, x2, … , xn) с компонентами из заданного конечного поля: xi∈GF(q). Операции с векторами при этом выполняются по простейшим правилам:

где сложение и умножение скаляров выполняется по правилам поля GF(q). Пространство такого типа может содержать до qn векторов. В двоичном пространстве (q=2) максимальное число векторов не превосходит величины 2n и, согласно правилам арифметики GF(2),

Слайд 81Пусть в пространстве S выбраны m ненулевых векторов g1, g2,.., gm.

Они называются

Пусть в пространстве S выбраны m ненулевых векторов g1, g2,.., gm.

Они называются

где все αi – скалярные коэффициенты. Напротив, если ни один из векторов gi не выражается линейной комбинацией других, рассматриваемые векторы линейно независимы. Максимальное число линейно независимых векторов m в данном пространстве называется размерностью этого пространства (пространство размерности m также называют m–мерным). Любое множество m линейно независимых векторов в m–мерном пространстве образует его базис. Если {g1, g2, … , gm} – базис пространства S , то любой вектор x из S можно построить как линейную комбинацию g1, g2,.., gm:

где x1, x2, … , xn – компоненты или координаты x в базисе {g1, g2, … , gm}. Приведенное равенство есть представление или разложение x в базисе {g1, g2, … , gm}.

Если S1 – подмножество векторного пространства S, само являющееся пространством с теми же векторным сложением и умножением на скаляр, то S1 называется подпространством S.

Слайд 82Лекция 13

Лекция 13

Слайд 836.3. Линейные коды и их порождающие матрицы

Рассмотрим множество S всех 2n n–компонентных

6.3. Линейные коды и их порождающие матрицы

Рассмотрим множество S всех 2n n–компонентных

Прямая проверка показывает, что U замкнуто относительно сложения векторов и умножения их на скаляры из GF(2) , и, следовательно, U есть векторное пространство, т.е. подпространством S. Это подпространство, имеющее размерность k, и является той конструкцией, которая именуется линейным кодом. Итак, двоичный (n,k) линейный код – это любое k-мерное подпространство пространства векторов длины n. Поскольку подпространство содержит M=2k, кодовых слов, k=logM есть не что иное, как число информационных битов, передаваемых кодом, длина которого, разумеется, равна n. Запишем векторы gi=(gi1, gi2, … , gin) один под другим как строки матрицы G:

Слайд 84Вводя k–компонентный вектор сообщения (данных) a=(a1, a2, … , ak), любое слово

Вводя k–компонентный вектор сообщения (данных) a=(a1, a2, … , ak), любое слово

Как видно, кодовое слово линейного кода есть произведение информационного вектора a на матрицу G, по этой причине именуемую порождающей матрицей кода. Из определения векторного пространства следует, что:

1. Любой линейный код содержит нулевое слово 0=(0 0 … 0);

2. Любая сумма слов линейного кода есть вновь кодовое слово того же кода:

Слайд 853. Теорема 6.3.1. Минимальное расстояние линейного кода равно наименьшему из весов ненулевых слов

3. Теорема 6.3.1. Минимальное расстояние линейного кода равно наименьшему из весов ненулевых слов

Последний результат является одним из оснований особой популярности линейных кодов: для нахождения расстояния линейного кода достаточно протестировать веса M–1 его ненулевых векторов взамен перебора M(M – 1)/2 >> M пар кодовых слов.

Любой линейный код можно преобразовать в эквивалентный (имеющий те же объем M, длину n и веса всех слов), задаваемый канонической порождающей матрицей

Слайд 86где Ik – k×k единичная матрица, а P – матрица размерности k×(n–k).

где Ik – k×k единичная матрица, а P – матрица размерности k×(n–k).

6.4. Проверочная матрица и ее связь с кодовым расстоянием

Рассмотрим систематический линейный код U с k×n порождающей матрицей G=[Ik ¦ P] и построим (n–k)×n проверочную матрицу H=[–PT ¦ In-k], где верхний индекс “T” означает транспонирование матрицы P. Для произвольного кодового вектора u∈U

т. е. умножение на транспонированную матрицу H дает нуль. Таким образом, любой линейный код есть нуль–пространство своей проверочной матрицы

Слайд 87Теорема 6.4.1. Линейный код U имеет минимальное расстояние d, если и только

Теорема 6.4.1. Линейный код U имеет минимальное расстояние d, если и только

Теорема 6.4.2. (Граница Синглтона). Расстояние линейного (n,k) кода не больше числа проверочных символов плюс единица:

Для двоичных кодов верхняя граница Синглтона не только недостижима (кроме тривиальных кодов с повторением или единственной проверкой на четность), но и бесполезна, так как лежит выше границ Хэмминга и Плоткина. В то же время недвоичные коды, достигающие этой границы, существуют и широко применяются на практике.

Следствие 6.4.3. Граница Варшамова-Гилберта.

Хотя в определении параграфа 6.3 для облегчения ознакомления с линейными кодами фигурировал двоичный алфавит, все результаты последних двух параграфов без затруднений переносятся на q-ичные линейные коды.

Слайд 88Лекция 14

Лекция 14

Слайд 89Коды, фигурирующие в заголовке, замечательны как в познавательном, так и в практическом

Коды, фигурирующие в заголовке, замечательны как в познавательном, так и в практическом

Если нужен систематический код Хэмминга, достаточно переупорядочить столбцы проверочной матрицы H, выделив явно m×m единичную матрицу как составной блок проверочной. После этого легко строится и каноническая порождающая матрица.

6.5. Коды Хэмминга

Хэмминга имеет k=n–m=2m–m–1 информационных символов, т.е. является (2m–1, 2m–m–1) линейным кодом.

Пример 6.5.1. Столбцы проверочной матрицы двоичного кода Хэмминга (7,4) есть десятичные числа от 1 до 7, в двоичной записи (иллюстрация справа).

Слайд 90Так как все столбцы матрицы H кода Хэмминга различны, любая их пара

Так как все столбцы матрицы H кода Хэмминга различны, любая их пара

Коды Хэмминга являются почти уникальным примером совершенных двоичных кодов. Известны и недвоичные коды Хэмминга, не столь, однако, интересные в контексте нашего курса.

В таблице справа приведены параметры нескольких кодов Хэмминга в порядке возрастания длин.

6.6. Расширенные и укороченные коды

Любой линейный (n,k) код U можно превратить в код U´ с параметрами (n+1, k) добавлением символа общей проверки на четность. Пусть, например, u=(u1, u2, … , un) – произвольное кодовое слово исходного (n,k) линейного кода U. Тогда соответствующее слово расширенного кода U´ строится по правилу u´ =(u1, u2, … , un, un+1) , где un+1= u1+ u2+ … + un (разумеется с суммированием согласно двоичной арифметике, т.е. по модулю 2). В итоге

и, следовательно, вес любого слова в расширенном коде будет четным. Это, в свою очередь, означает, что при нечетном расстоянии d исходного кода U минимальное расстояние d´ расширенного кода U´ увеличится на единицу: d´ = d+1. Тем самым, любой линейный (n,k) код нечетного расстояния d,

Слайд 91исправляющий t=(d–1)/2 ошибок, можно трансформировать в расширенный (n+1, k) код, исправляющий ошибки

исправляющий t=(d–1)/2 ошибок, можно трансформировать в расширенный (n+1, k) код, исправляющий ошибки

Коды Хэмминга весьма наглядны в части иллюстрации сказанного. Так как расстояние любого такого кода равно трем, в результате расширения получается (2m, 2m–m–1) код с расстоянием четыре, который, в дополнение к исправлению любых однократных, обнаруживает и любые двукратные ошибки. Поучительный пример реального применения расширенного (32,26) кода Хэмминга для передачи цифрового потока данных с искусственного спутника Земли дает глобальная радионавигационная система космического базирования GPS.

Другой популярный прием преобразования имеющихся кодов в новые – укорочение. Укороченный код получается из исходного систематического отбором лишь слов, имеющих l первых нулевых символов. Зная наперед об этом свойстве всех отобранных слов, нет нужды передавать упомянутые нулевые символы, уменьшив длину кода на l с одновременным сокращением на ту же величину числа информационных бит. Результирующий (n–l, k–l) код будет обладать расстоянием, не худшим, чем у исходного. Легко показать, что порождающая матрица G´ укороченного кода получается из канонической матрицы G исходного удалением первых l строк и столбцов.

Пример 6.6.1. Удалив в канонической порождающей матрице (7,4) кода Хэмминга два левых столбца и две верхних строки, придем к канонической порождающей матрице укороченного линейного (5,2) кода

Слайд 92уже встречавшегося в параграфе 5.1. Разумеется, этот код – подобно исходному коду

уже встречавшегося в параграфе 5.1. Разумеется, этот код – подобно исходному коду

6.7. Коды симплексные, ортогональные и Рида-Маллера

Выпишем вновь m-разрядные двоичные числа столбец за столбцом, как это делалось при построении кода Хэмминга, однако на этот раз примем полученную m×(2m–1) матрицу в качестве не поверочной, а порождающей. Соответствующий линейный код именуется симплексным, так как при БФМ-отображении он превращается в семейство симплексных сигналов, обладающих, как известно, максимальным наименьшим евклидовым расстоянием. Длина этого кода n=2m–1, а число информационных бит k=m (объем M= 2m=n+1). Веса всех ненулевых слов симплексного кода одинаковы и равны (n+1)/2, так что его минимальное расстояние d=(n+1)/2=2m–1. Таким образом, рассматриваемый код исправляет (n+1)/4–1= 2m–2–1 ошибок и – в дополнение – обнаруживает любую ошибку кратности 2m–2=(n+1)/4.