Содержание

- 2. Немного «фраз» «Гораздо легче что-то измерить, чем понять, что именно вы измеряете.» — Джон Уильям Салливан

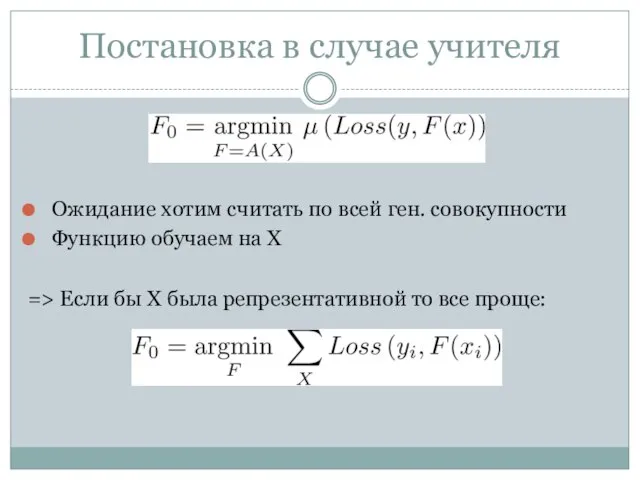

- 3. Постановка в случае учителя Ожидание хотим считать по всей ген. совокупности Функцию обучаем на X =>

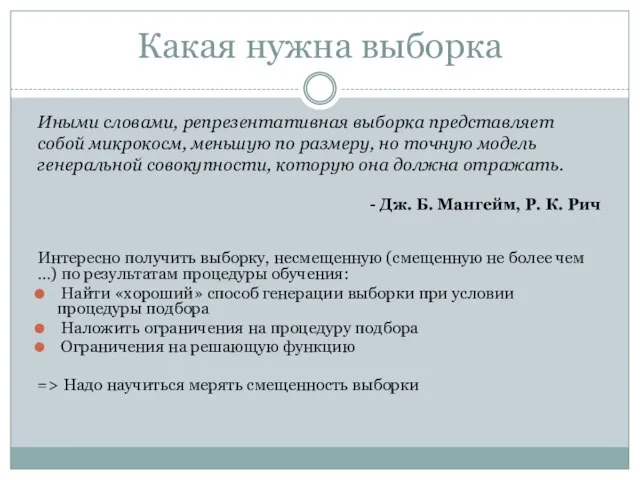

- 4. Какая нужна выборка Интересно получить выборку, несмещенную (смещенную не более чем …) по результатам процедуры обучения:

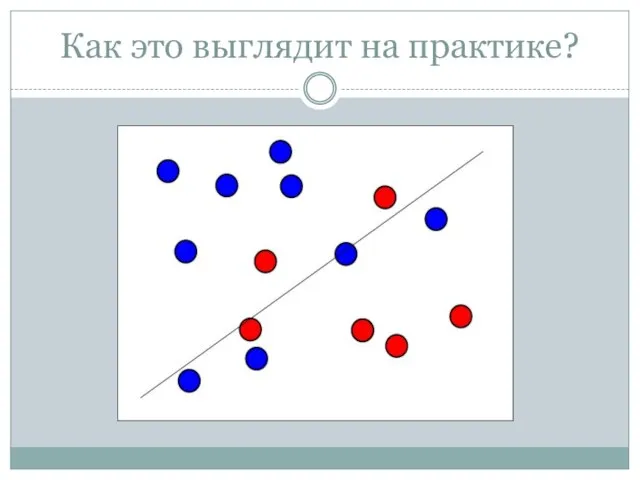

- 5. Как это выглядит на практике?

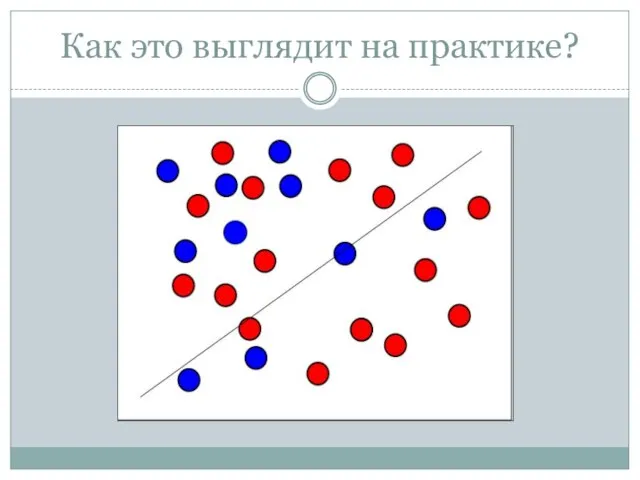

- 6. Как это выглядит на практике?

- 7. Как это выглядит на практике?

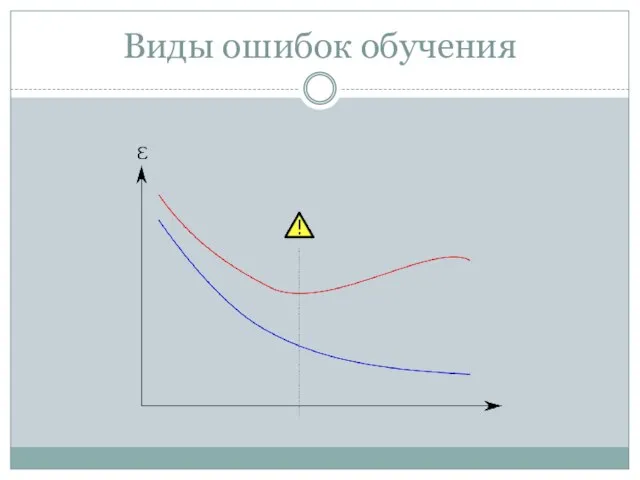

- 8. Виды ошибок обучения

- 9. Виды ошибок обучения Переобучение, переподгонка (overtraining, overfitting) — нежелательное явление, возникающее при решении задач обучения по

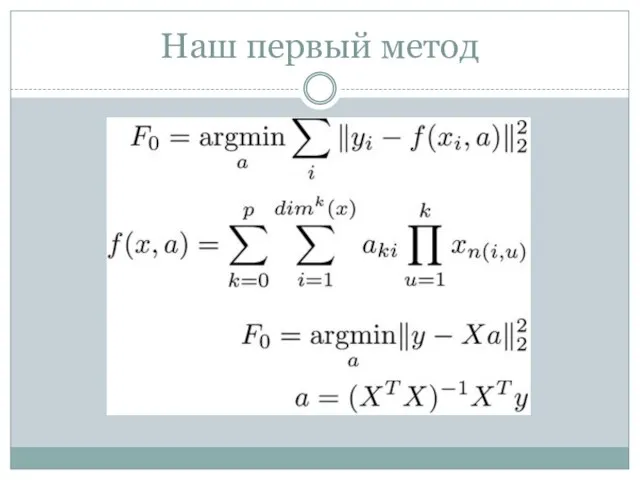

- 10. Наш первый метод

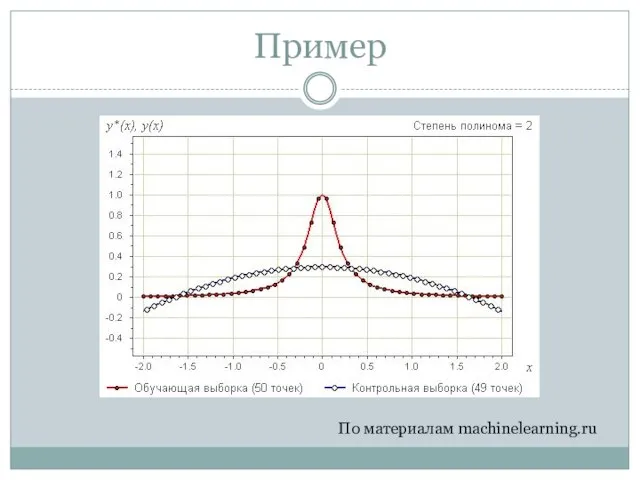

- 11. Пример По материалам machinelearning.ru

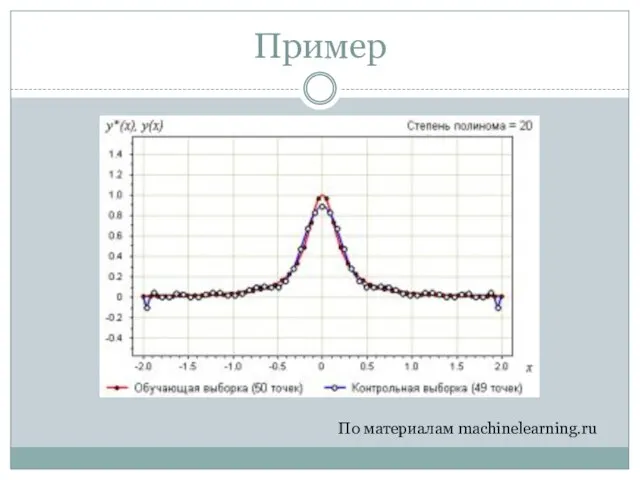

- 12. Пример По материалам machinelearning.ru

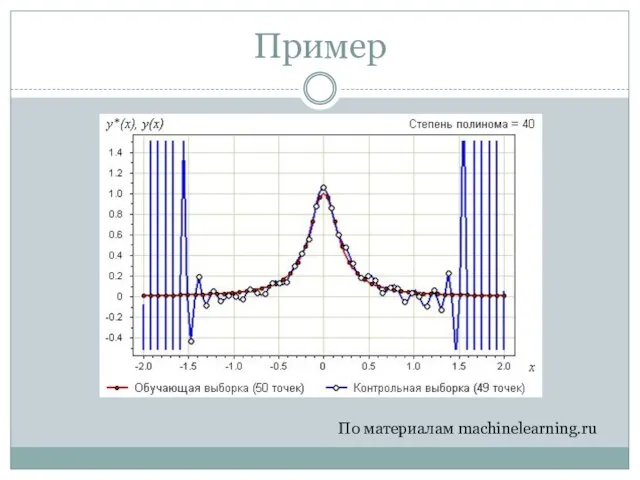

- 13. Пример По материалам machinelearning.ru

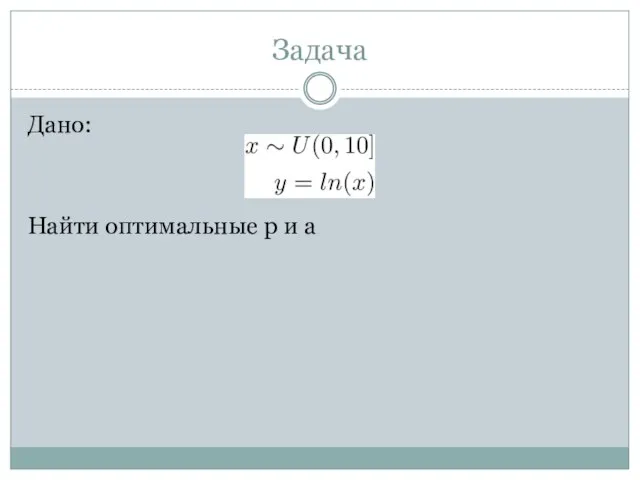

- 14. Задача Дано: Найти оптимальные p и a

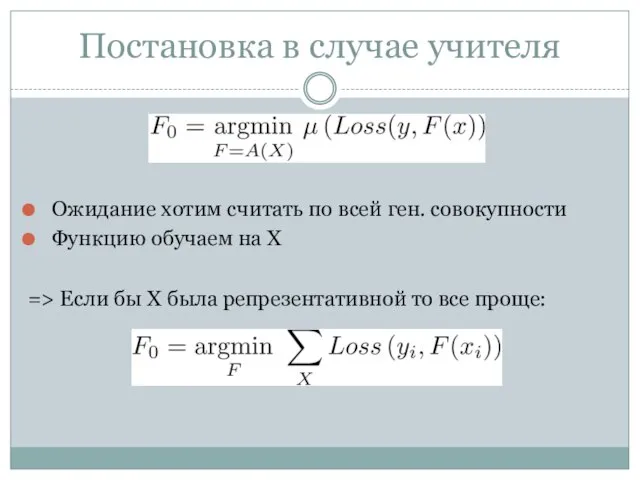

- 15. Постановка в случае учителя Ожидание хотим считать по всей ген. совокупности Функцию обучаем на X =>

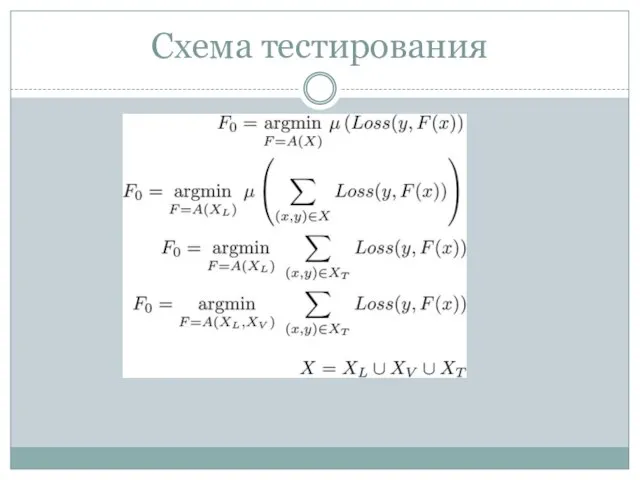

- 16. Схема тестирования

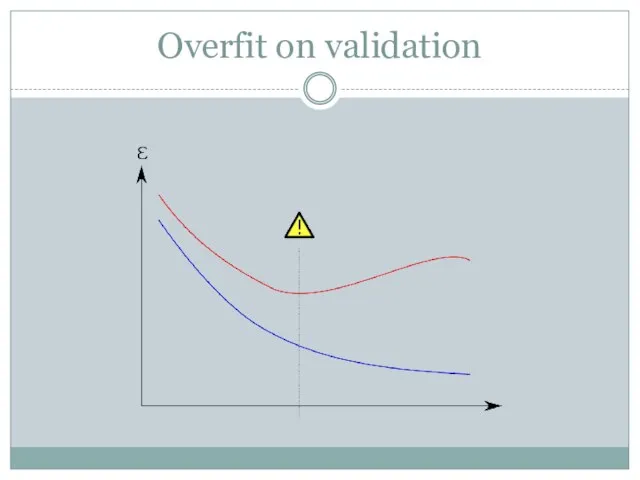

- 17. Overfit on validation

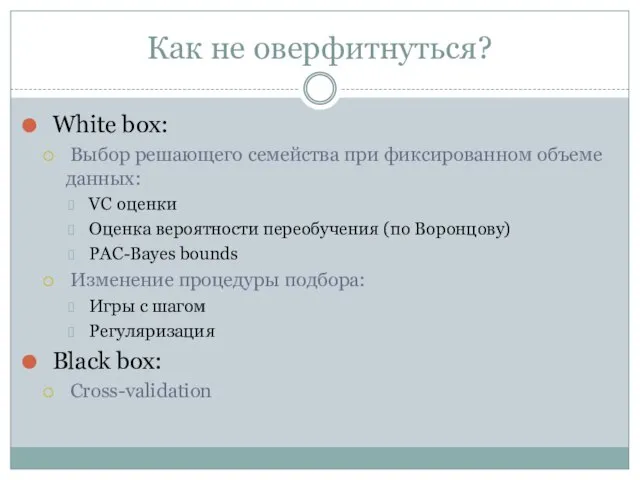

- 18. Как не оверфитнуться? White box: Выбор решающего семейства при фиксированном объеме данных: VC оценки Оценка вероятности

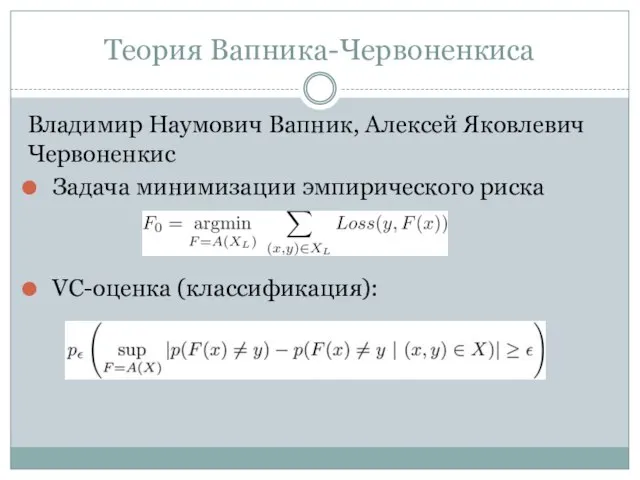

- 19. Теория Вапника-Червоненкиса Владимир Наумович Вапник, Алексей Яковлевич Червоненкис Задача минимизации эмпирического риска VC-оценка (классификация):

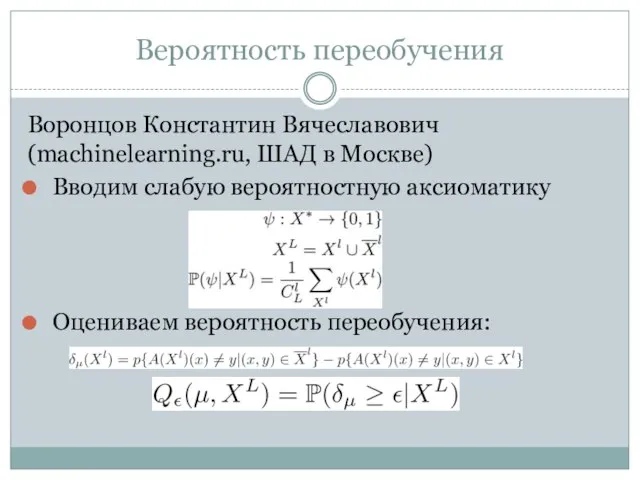

- 20. Вероятность переобучения Воронцов Константин Вячеславович (machinelearning.ru, ШАД в Москве) Вводим слабую вероятностную аксиоматику Оцениваем вероятность переобучения:

- 21. PAC-Bayes bounds Результат алгоритма – распределение над семейством Решающая функция –среднее выборки этого распределения

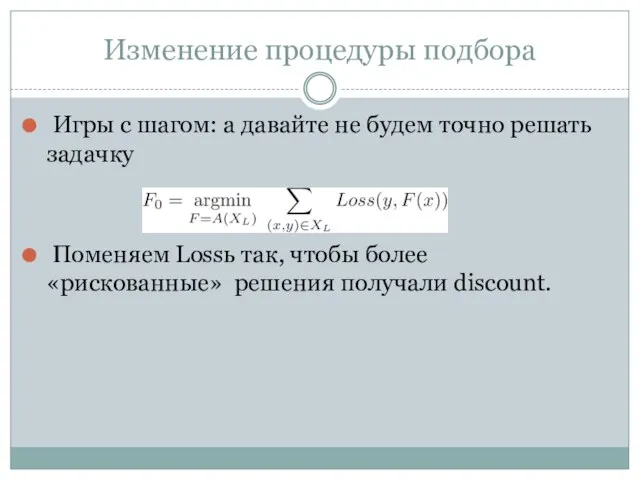

- 22. Изменение процедуры подбора Игры с шагом: а давайте не будем точно решать задачку Поменяем Lossь так,

- 23. Cross-validation Рандомно поделим множество X на несколько кусочков Обучимся на одной части Проверим на оставшихся Повторим

- 24. Виды cross-validation 2-fold k-fold Random sub-sampling (e.g. bootstrapping) Leave-one-out (LOOCV)

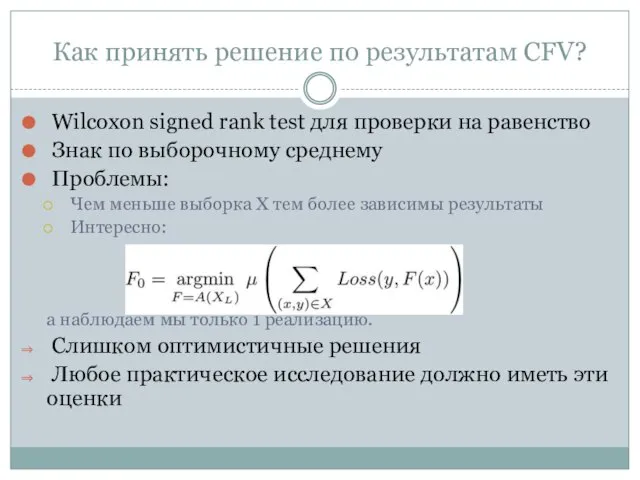

- 25. Как принять решение по результатам CFV? Wilcoxon signed rank test для проверки на равенство Знак по

- 26. На чем тестировать? Реальные данные Поиск: РОМИП, TREC, Яндекс.ИМАТ, Yahoo LTRCh Pascal Challenge InnoCentive Искусственные данные

- 27. ОТСЕБЯТЕНА Машинное Обучение: качество

- 29. Скачать презентацию

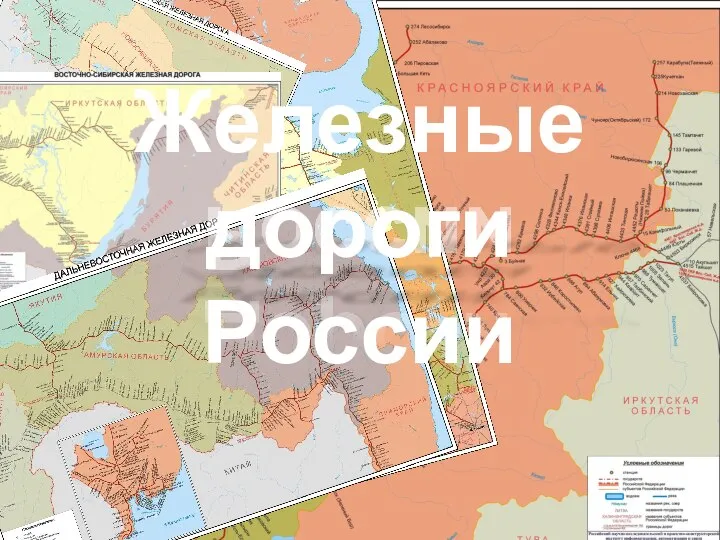

Железные дороги России

Железные дороги России Us posters

Us posters Поляков Е.А. Презентация. Психокоррекция

Поляков Е.А. Презентация. Психокоррекция Общие положения. Сигналы на железнодорожном транспорте. Общие положения

Общие положения. Сигналы на железнодорожном транспорте. Общие положения ист мед

ист мед О результатах работы бокса ЦУР Бизнес

О результатах работы бокса ЦУР Бизнес Понятие признаки и виды правоохранительных органов

Понятие признаки и виды правоохранительных органов Презентация на тему Красивые,но смертельно опасные цветы

Презентация на тему Красивые,но смертельно опасные цветы  Ядерный реактор. Принцип работы ядерного реактора

Ядерный реактор. Принцип работы ядерного реактора Старскаясредняяобщеобразовательнаяшкола

Старскаясредняяобщеобразовательнаяшкола Образ сказочной птицы в изобразительном и устном фольклоре

Образ сказочной птицы в изобразительном и устном фольклоре Музеи Санкт-Петербурга

Музеи Санкт-Петербурга Как не болеть в детском саду?Подготовительная группаМБОУ СОШ №35 «Непоседы»

Как не болеть в детском саду?Подготовительная группаМБОУ СОШ №35 «Непоседы» Вещь на уроке изобразительного искусства

Вещь на уроке изобразительного искусства Помоги Маше добраться до клада

Помоги Маше добраться до клада Как выполняли арифметические действия в Древнем Риме?

Как выполняли арифметические действия в Древнем Риме? Презентация на тему Портфолио студента

Презентация на тему Портфолио студента Обществознание

Обществознание изучаем алгоритмы

изучаем алгоритмы Книга рекордов Гиннесса

Книга рекордов Гиннесса Менеджеры в организации

Менеджеры в организации  Средства и методики бизнес-анализа

Средства и методики бизнес-анализа  Алкоголь и его влияние на здоровье человека

Алкоголь и его влияние на здоровье человека Туризм в России: каталог святынь Красногвардейского района Белгородской области

Туризм в России: каталог святынь Красногвардейского района Белгородской области Психоаналитические теории. Питер Блос

Психоаналитические теории. Питер Блос Презентация на тему Контроль за распространением инфекции

Презентация на тему Контроль за распространением инфекции  Игры с дополненной реальностью и вебкам игры

Игры с дополненной реальностью и вебкам игры Вопросы тарифного регулирования в теплоэнергетике и коммунальном комплексе в 2012 – 2013 годах.

Вопросы тарифного регулирования в теплоэнергетике и коммунальном комплексе в 2012 – 2013 годах.