Слайд 2Программа

Обзор текущего положения дел с энергопотреблением.

Case study параметров запускаемого в настоящего

время в МГУ им. М.В.Ломоносова суперкомпьютера Т-500: расчетная производительность 500 ТФлоп/с, около 3МВт потребляемой мощности, отвод тепла от стоек с блейд-серверами с пиковым тепловыделением до 75 кВт на стойку.

Сравнение эффективности построения схем охлаждения с контейнеризацией холодного и горячего коридоров.

Сравнение применимости чиллерных систем охлаждения и фреоновых (DX) для современных приложений.

Обзор классических систем охлаждения

Заключение: выводы и рекомендации

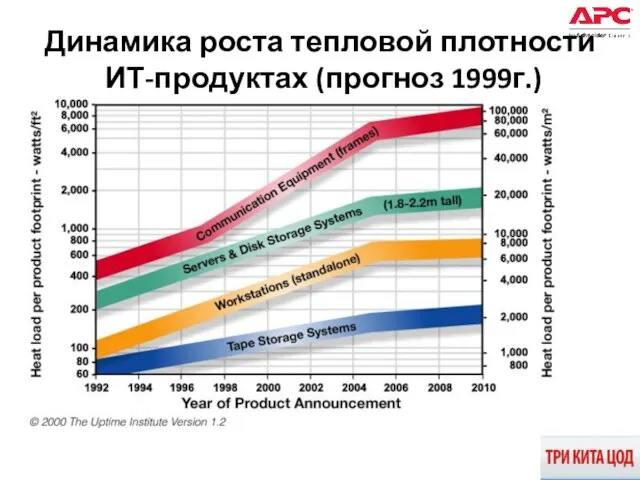

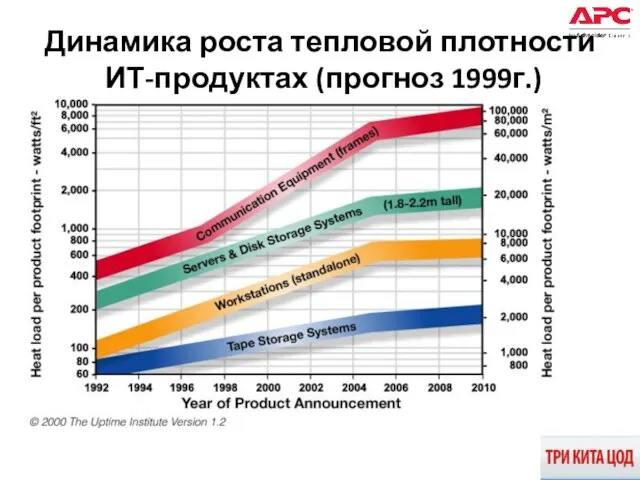

Слайд 3Динамика роста тепловой плотности ИТ-продуктах (прогноз 1999г.)

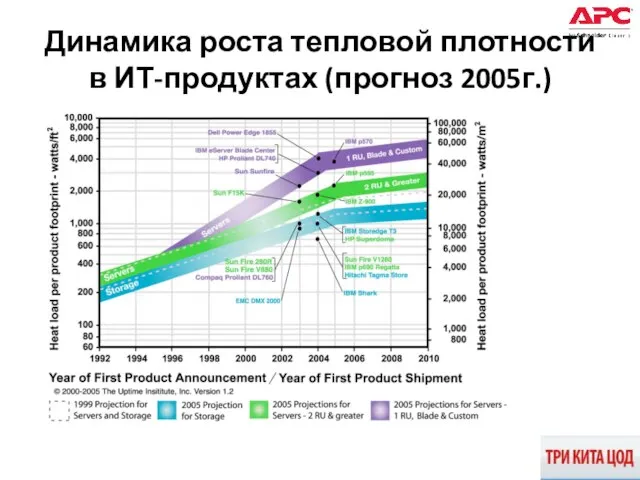

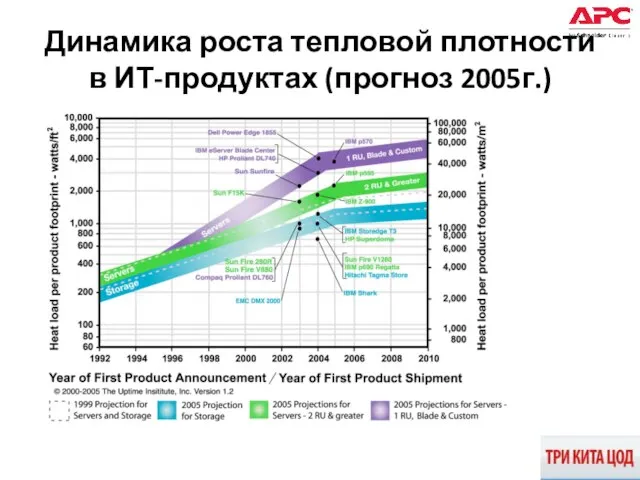

Слайд 4Динамика роста тепловой плотности в ИТ-продуктах (прогноз 2005г.)

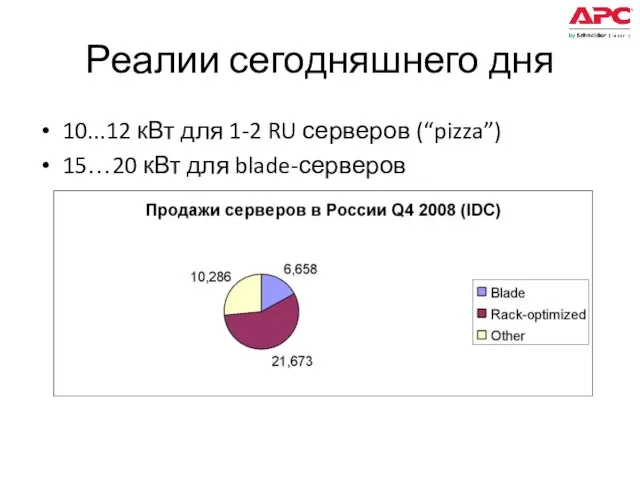

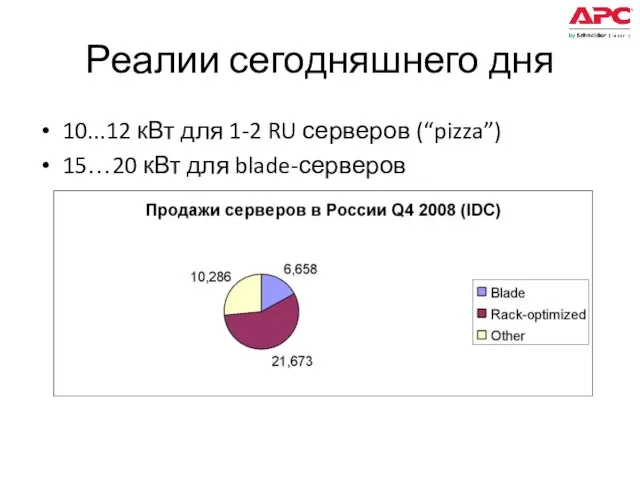

Слайд 5Реалии сегодняшнего дня

10...12 кВт для 1-2 RU серверов (“pizza”)

15…20 кВт для blade-серверов

Слайд 6HPC (High Performance Computing)

Полигон «Formula 1» для многих технологий

Наиболее «горячие» серверы

Слайд 7Энергопотребление 1 PFlop/s компьютера

www.top500.org

Энергопотребление компьютера с производительностью 1 Pflop/s = 2.5 …

15 MВт

Энергопотребление 19” стойки с серверами

CRAY XT5 (#2): 32…43 кВт

SGI Pleiades (#4): 21 кВт

T60 (#82): 33 кВт

Слайд 8Программа

Обзор текущего положения дел с энергопотреблением.

Case study параметров запускаемого в настоящего

время в МГУ им. М.В.Ломоносова суперкомпьютера Т-500: расчетная производительность 500 ТФлоп/с, около 3МВт потребляемой мощности, отвод тепла от стоек с блейд-серверами с пиковым тепловыделением до 70 кВт на стойку.

Сравнение эффективности построения схем охлаждения с контейнеризацией холодного и горячего коридоров.

Сравнение применимости чиллерных систем охлаждения и фреоновых (DX) для современных приложений.

Обзор классических систем охлаждения

Выводы и рекомендации

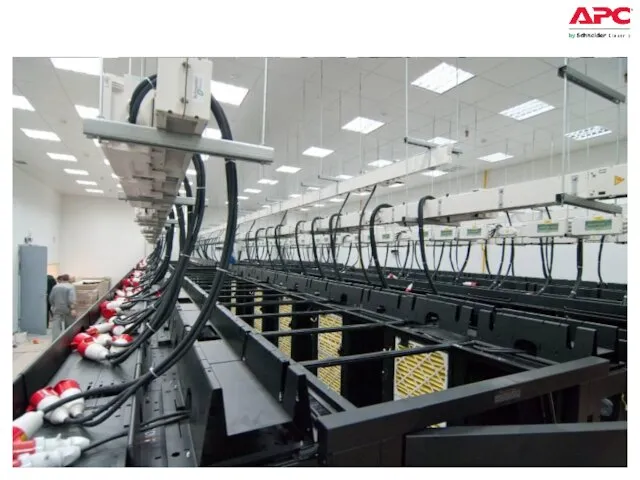

Слайд 9Проект Т-500

Заказчик: МГУ им. М.В.Ломоносова

Генеральный контрактор: Т-Платформы

Расчетная производительность 500 ТФлоп/с

Энергопотребление вычислителя: до

2.4 МВт, общее потребление площадки около 4 МВт

Горячие серверные стойки 65...70 кВт (!!), конфигурация рассчитана на теплосъем до 75 кВт со стойки

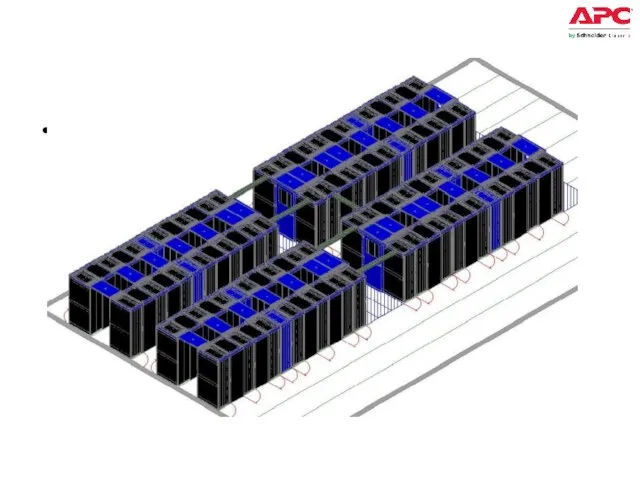

Слайд 13T-500: энергетика

60 стоек с нагрузкой, 40 внутрирядных кондиционеров

Средняя нагрузка ~40 кВт/стойку с

активным оборудованием

В каждом «островке» 8 горячих стоек, по 62...65 кВт тепловыделения

Слайд 14T-500

APC InRow RC, 600mm, Chilled Water, 380-415V, 50Hz

Штатная производительность по холоду

37 кВт

37кВт х 10 = 370кВт

Тепловыделение одного «островка» = 540...620 кВт

В чем же фокус?...

Слайд 15Программа

Обзор текущего положения дел с энергопотреблением.

Сравнение применимости чиллерных систем охлаждения и

фреоновых (DX) для суперкомпьютерных приложений.

Сравнение эффективности построения схем охлаждения с контейнеризацией холодного и горячего коридоров.

Case study параметров запускаемого в настоящего время в МГУ им. М.В.Ломоносова суперкомпьютера Т-500: расчетная производительность 500 ТФлоп/с, около 3МВт потребляемой мощности, отвод тепла от стоек с блейд-серверами с пиковым тепловыделением до 75 кВт на стойку.

Сравнение применимости чиллерных систем охлаждения и фреоновых (DX) для современных приложений.

Обзор классических систем охлаждения

Выводы и рекомендации

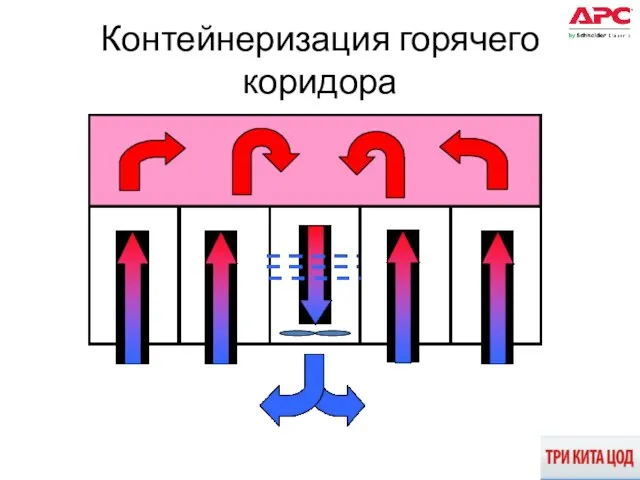

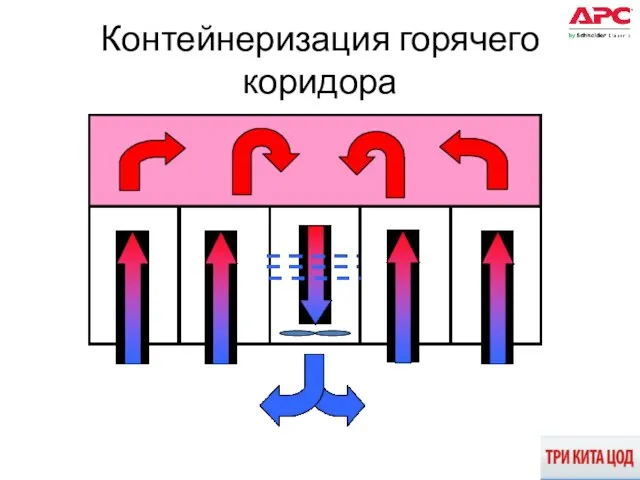

Слайд 16Контейнеризация горячего коридора

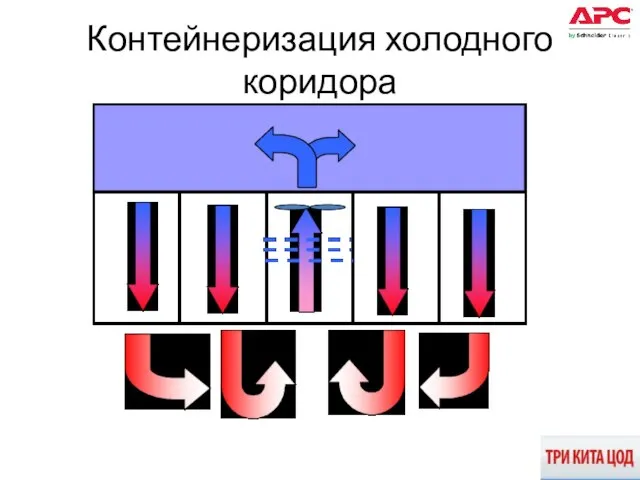

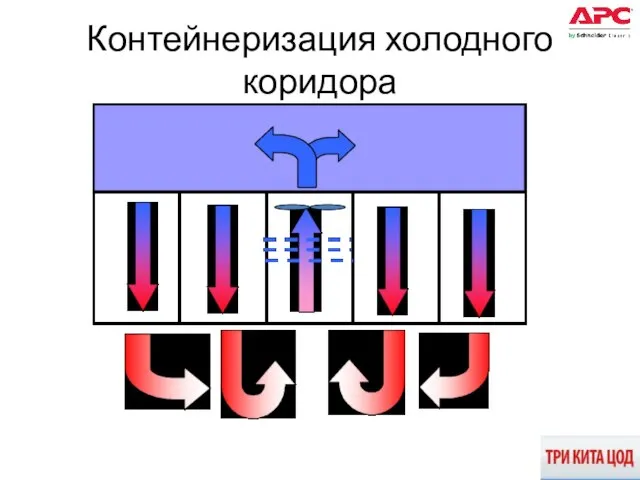

Слайд 17Контейнеризация холодного коридора

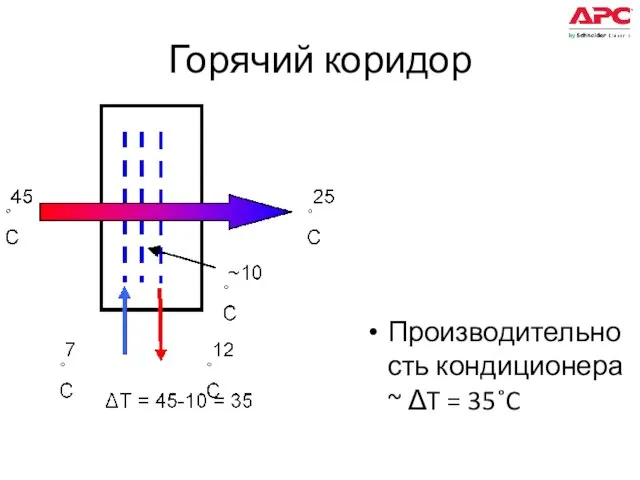

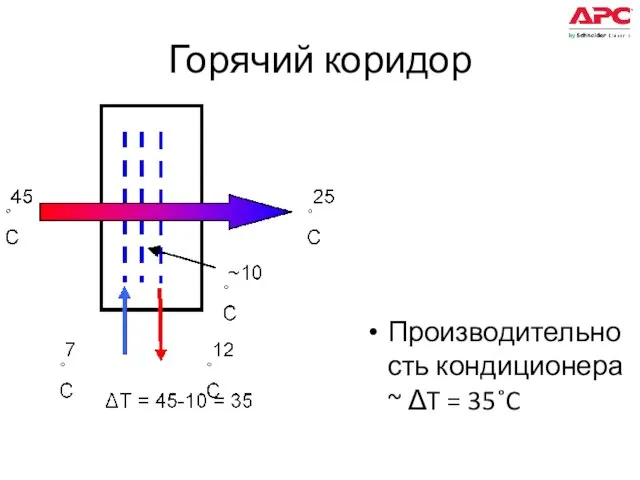

Слайд 18Горячий коридор

Производительность кондиционера ~ ΔT = 35˚C

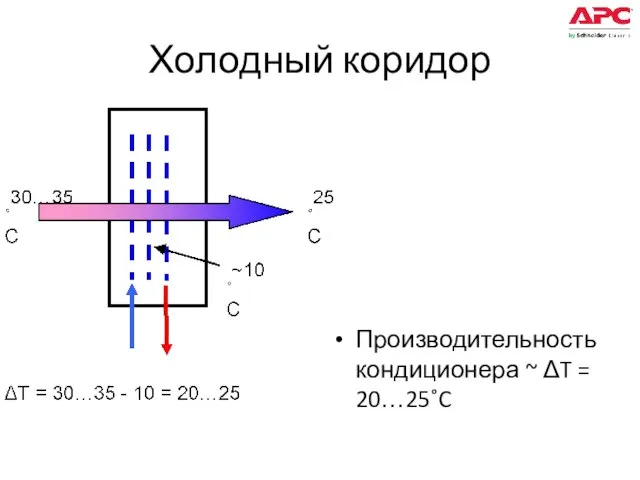

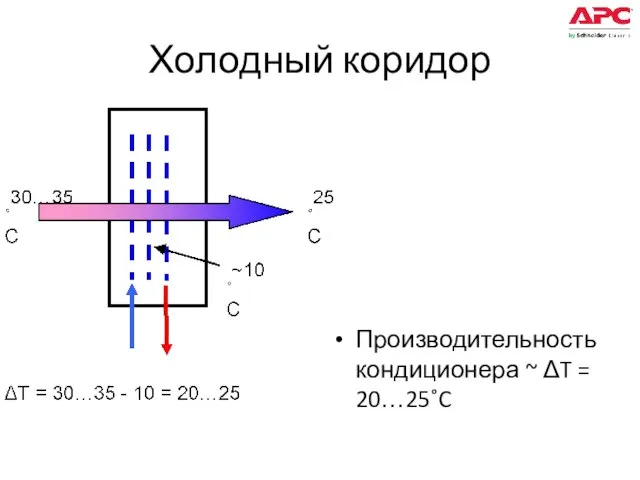

Слайд 19Холодный коридор

Производительность кондиционера ~ ΔT = 20…25˚C

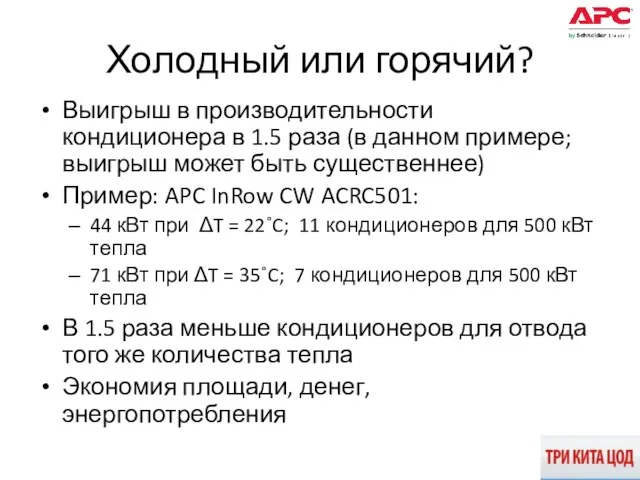

Слайд 20Холодный или горячий?

Выигрыш в производительности кондиционера в 1.5 раза (в данном примере;

выигрыш может быть существеннее)

Пример: APC InRow CW ACRC501:

44 кВт при ΔT = 22˚C; 11 кондиционеров для 500 кВт тепла

71 кВт при ΔT = 35˚C; 7 кондиционеров для 500 кВт тепла

В 1.5 раза меньше кондиционеров для отвода того же количества тепла

Экономия площади, денег, энергопотребления

Слайд 21Программа

Обзор текущего положения дел с энергопотреблением.

Case study параметров запускаемого в настоящего

время в МГУ им. М.В.Ломоносова суперкомпьютера Т-500: расчетная производительность 500 ТФлоп/с, около 3МВт потребляемой мощности, отвод тепла от стоек с блейд-серверами с пиковым тепловыделением до 75 кВт на стойку.

Сравнение эффективности построения схем охлаждения с контейнеризацией холодного и горячего коридоров.

Сравнение применимости чиллерных систем охлаждения и фреоновых (DX) для современных приложений.

Обзор классических систем охлаждения

Выводы и рекомендации

Слайд 22Ограничения фреоновых систем охлаждения

Ограничение по температуре входного воздуха: не выше 30˚С, со

склонностью к «эффекту домино». Требование к избытку воздуха, с ростом потребления вентиляторов

Реализация бесперебойного охлаждения

В данном проекте дополнительная мощность на выходе ИБП для реализации непрерывного охлаждения составила 120 кВт (кондиционеры, циркуляционные насосы), или 5% от мощности нагрузки

Реализация непрерывного охлаждения с фреоновыми кондиционерами потребовала бы ~1.6 МВт дополнительной мощности ИБП для поддержки ВСЕЙ системы кондиционирования

Слайд 23Программа

Обзор текущего положения дел с энергопотреблением.

Case study параметров запускаемого в настоящего

время в МГУ им. М.В.Ломоносова суперкомпьютера Т-500: расчетная производительность 500 ТФлоп/с, около 3МВт потребляемой мощности, отвод тепла от стоек с блейд-серверами с пиковым тепловыделением до 75 кВт на стойку.

Сравнение эффективности построения схем охлаждения с контейнеризацией холодного и горячего коридоров.

Сравнение применимости чиллерных систем охлаждения и фреоновых (DX) для современных приложений.

Обзор классических систем охлаждения

Выводы и рекомендации

Слайд 24Фальшпол

Большое перемешивание

Следовательно вынужденное занижение выходной температуры и завышение объема воздуха

Следовательно низкая эффективность

кондиционера и высокое потребление вентиляторов

Неравномерность подачи

Слайд 25Фальшпол + контейнеризация

Высокое сопротивление систем трубопроводов

Следовательно вынужденное завышение давления подачи воздуха

Следовательно высокое

потребление вентиляторов

Неравномерность подачи

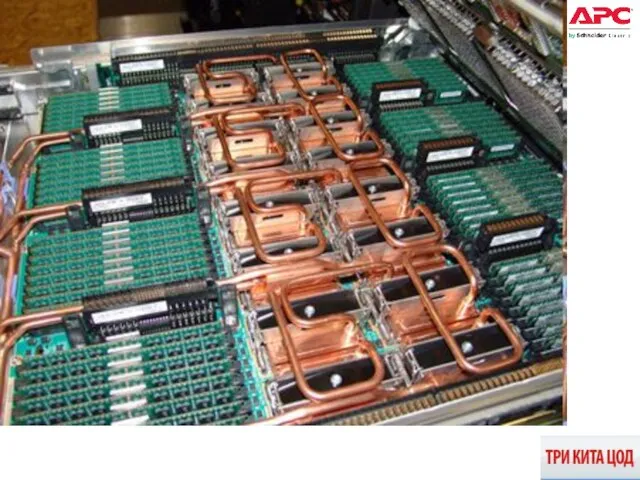

Слайд 26Серверы с прямым водяным охлаждением

75 кВт на стойку => при ΔТ сервера

= 20˚С => скорость воздуха 2.4 м/с на входе стойки

IBM, Supermicro, Sun Microsystems, ... выводят на рынок серверы с прямым водяным охлаждением

Слайд 27IBM Aquasar (BladeCenter with water cooling)

2009

Слайд 31Скиф-Аврора (Скиф ряд 4)

ИПС РАН, 2009

Слайд 34Прямое водяное охлаждение серверов

На ближайшие ~10 лет – ТОЛЬКО для HPC (высокопроизводительные

вычисления)

Почему?

Представьте себе установку 1 (одного) нового сервера с водяным охлаждением в существующей серверной...

Представьте себе сервер(ы) с водяным охлаждением в hosting/co-lo ЦОДе...

Доказано: 40 и даже 60 кВт/стойку снимаются воздухом

Слайд 35Выводы и рекомендации

Глобальное потепление продолжается

10...15...20 кВт/стойку, далее?..

In-row (внутрирядное) кондиционирование доказало свою применимость

для решения широкого круга задач

Герметизация горячего коридора, кондиционеры на чиллерной воде – составляющие рецепта

Самое важное: использованы ИСКЛЮЧИТЕЛЬНО серийные компоненты без какой-либо доработки

Слайд 36Сервера с прямым водяным охлаждением

Применимость в обозримом будущем – лишь HPC-приложения

Правила поведения в компьютерном классе

Правила поведения в компьютерном классе План реализации проекта:«Разработка стратегии развития компании»

План реализации проекта:«Разработка стратегии развития компании» ОБМАНИ МЕНЯ ЕСЛИ СМОЖЕШЬ

ОБМАНИ МЕНЯ ЕСЛИ СМОЖЕШЬ Социальный проект «Детская газета»

Социальный проект «Детская газета» Рельеф и его виды. 3 класс

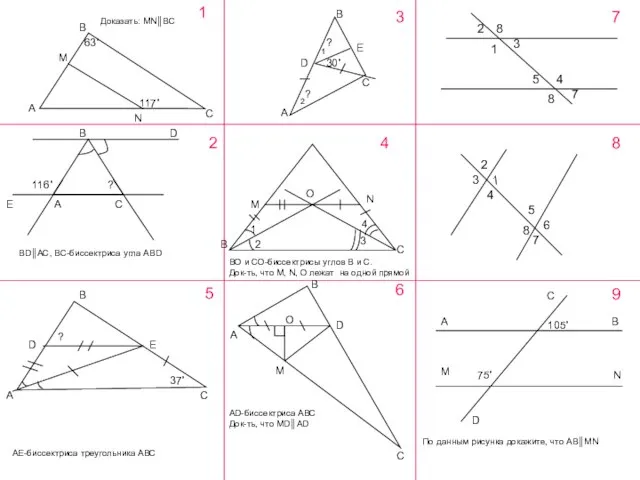

Рельеф и его виды. 3 класс А М В С N 1 2 3 4 BD EАC A B E C D O M N B C B CA DE 5 A B D M O C 6 2 8 1 3 4 5 7 8 1 3 4 2 5 8 6 7 117˚ 63˚ 30˚ ? ? Доказать: MNBC BDAC, BC-биссектриса.

А М В С N 1 2 3 4 BD EАC A B E C D O M N B C B CA DE 5 A B D M O C 6 2 8 1 3 4 5 7 8 1 3 4 2 5 8 6 7 117˚ 63˚ 30˚ ? ? Доказать: MNBC BDAC, BC-биссектриса. Информация о школьной службе медиации

Информация о школьной службе медиации Regulirovanie_studencheskikh_obschezhitiy (1)

Regulirovanie_studencheskikh_obschezhitiy (1) Slide title minimum 48 pt Slide subtitle minimum 30 pt.

Slide title minimum 48 pt Slide subtitle minimum 30 pt. Озеро Байкал Выполнили: ученицы 9 «Б» класса

Озеро Байкал Выполнили: ученицы 9 «Б» класса  Синдром диабетической стопы

Синдром диабетической стопы Отчёт по проделанной работе за 5 семестр

Отчёт по проделанной работе за 5 семестр Презентация на тему Архимедова сила и плавание тел (7 класс)

Презентация на тему Архимедова сила и плавание тел (7 класс) Роль и функции Центрального банка РФ

Роль и функции Центрального банка РФ Радиационное загрязнение в результате аварий на АЭС

Радиационное загрязнение в результате аварий на АЭС Презентация на тему Николай Коперник

Презентация на тему Николай Коперник Обобщающий урок по алгебре 9 класса

Обобщающий урок по алгебре 9 класса Большакова В.П.Галустьян С.А.

Большакова В.П.Галустьян С.А. Памятники белорусской культуры в рамках мирового наследия

Памятники белорусской культуры в рамках мирового наследия Дом-музей С.Т.Аксакова

Дом-музей С.Т.Аксакова Украшения среди нас. Паутинка

Украшения среди нас. Паутинка Приемы предупреждения и преодоления коммуникативных промахов и неудач

Приемы предупреждения и преодоления коммуникативных промахов и неудач Физическая культура. Организация работы студентов в системе Educon

Физическая культура. Организация работы студентов в системе Educon My favorite book

My favorite book Основные условия и сроки выпуска товаров Подготовили: Студенты юридического факультета Учебной группы Ю-113б Кочеткова Екатерин

Основные условия и сроки выпуска товаров Подготовили: Студенты юридического факультета Учебной группы Ю-113б Кочеткова Екатерин ПРАВИТЕЛЬСТВО РОССИЙСКОЙ ФЕДЕРАЦИИ РАСПОРЯЖЕНИЕ О проведении Международной научной конференции по проблемам адаптации к измене

ПРАВИТЕЛЬСТВО РОССИЙСКОЙ ФЕДЕРАЦИИ РАСПОРЯЖЕНИЕ О проведении Международной научной конференции по проблемам адаптации к измене Девятиклассное ассорти

Девятиклассное ассорти В мире боевых искусств

В мире боевых искусств