Содержание

- 2. Что мы знаем: Спецификация эконометрической модели Сбор исходной информации Вычислительный этап: Оценка параметров модели (теорема Гаусса-Маркова)

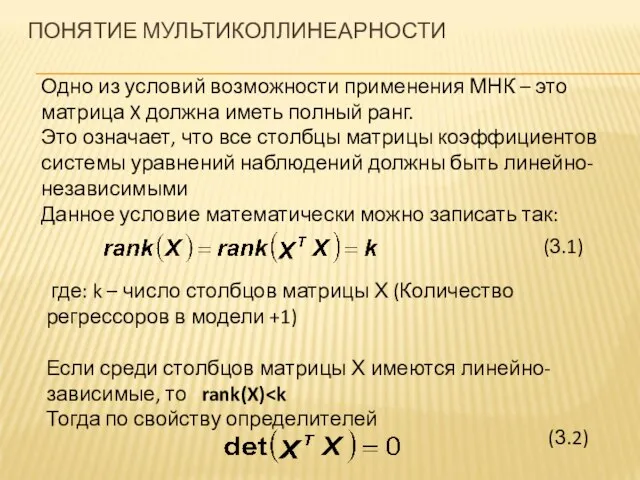

- 3. Одно из условий возможности применения МНК – это матрица X должна иметь полный ранг. Это означает,

- 4. Условие (3.2) приводит к тому, что матрица (XTX)-1 не существует, то есть является вырожденной. Следовательно, нет

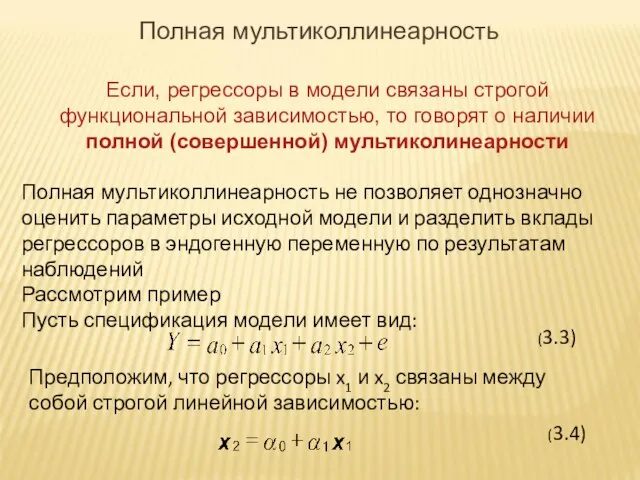

- 5. Если, регрессоры в модели связаны строгой функциональной зависимостью, то говорят о наличии полной (совершенной) мультиколинеарности Полная

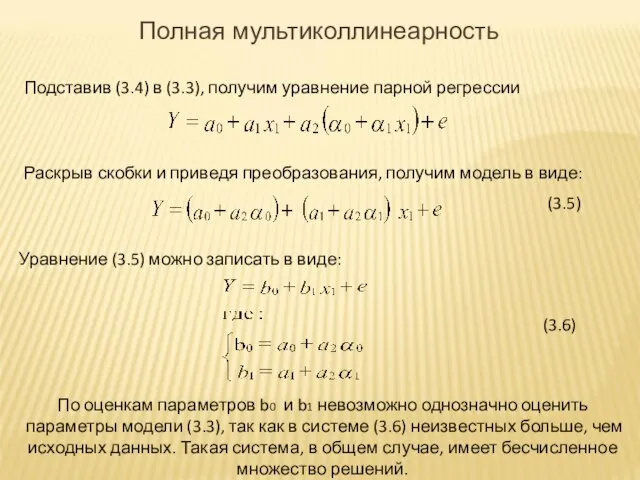

- 6. Подставив (3.4) в (3.3), получим уравнение парной регрессии Раскрыв скобки и приведя преобразования, получим модель в

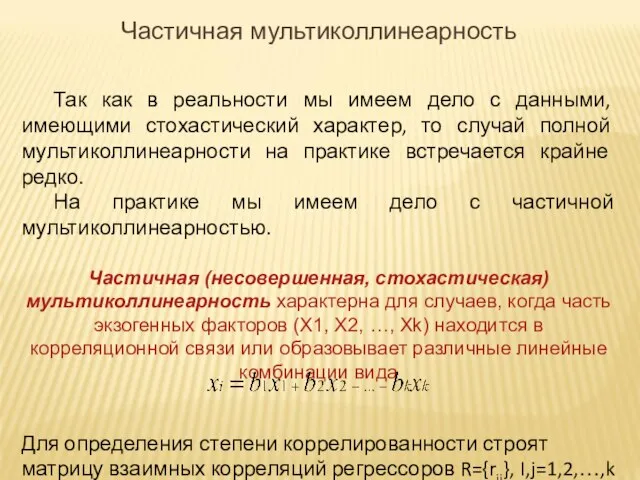

- 7. Так как в реальности мы имеем дело с данными, имеющими стохастический характер, то случай полной мультиколлинеарности

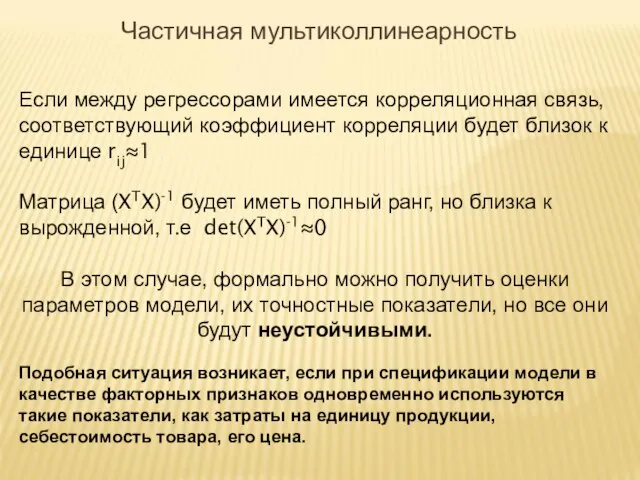

- 8. Если между регрессорами имеется корреляционная связь, соответствующий коэффициент корреляции будет близок к единице rij≈1 Матрица (XTX)-1

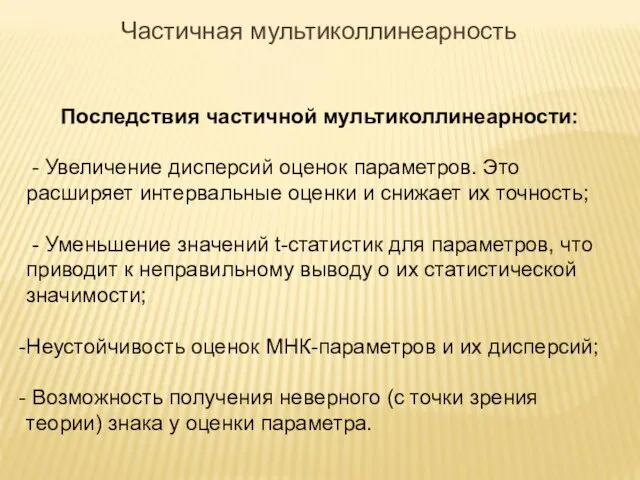

- 9. Последствия частичной мультиколлинеарности: - Увеличение дисперсий оценок параметров. Это расширяет интервальные оценки и снижает их точность;

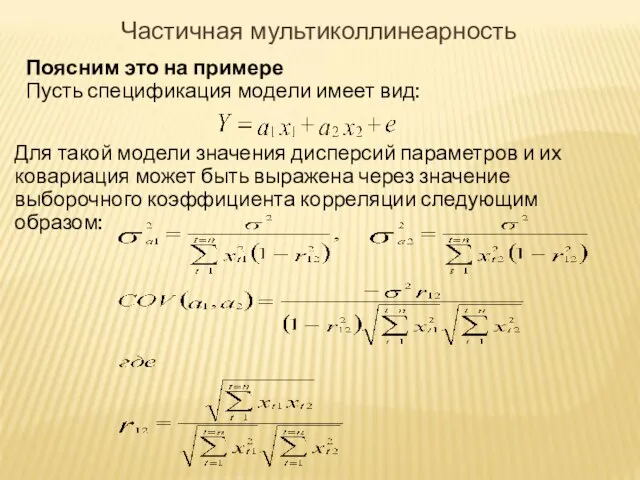

- 10. Поясним это на примере Пусть спецификация модели имеет вид: Для такой модели значения дисперсий параметров и

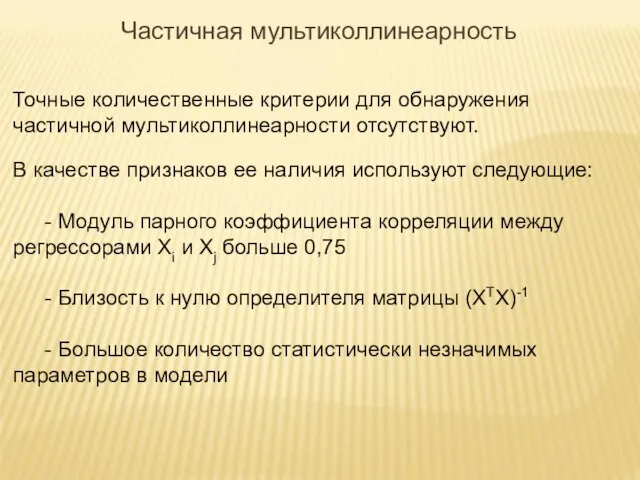

- 11. Точные количественные критерии для обнаружения частичной мультиколлинеарности отсутствуют. В качестве признаков ее наличия используют следующие: -

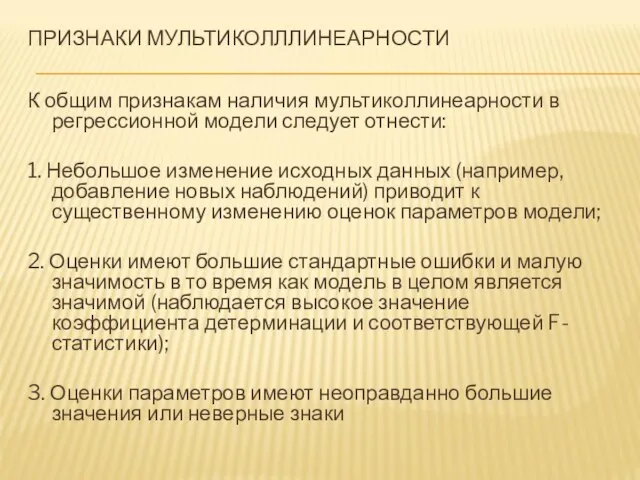

- 12. ПРИЗНАКИ МУЛЬТИКОЛЛЛИНЕАРНОСТИ К общим признакам наличия мультиколлинеарности в регрессионной модели следует отнести: 1. Небольшое изменение исходных

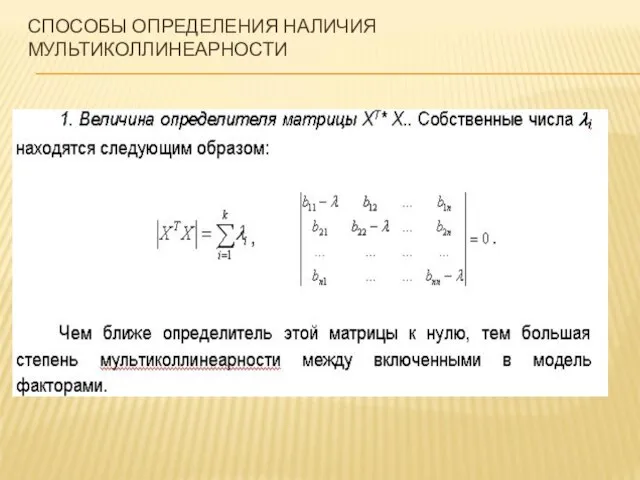

- 13. СПОСОБЫ ОПРЕДЕЛЕНИЯ НАЛИЧИЯ МУЛЬТИКОЛЛИНЕАРНОСТИ

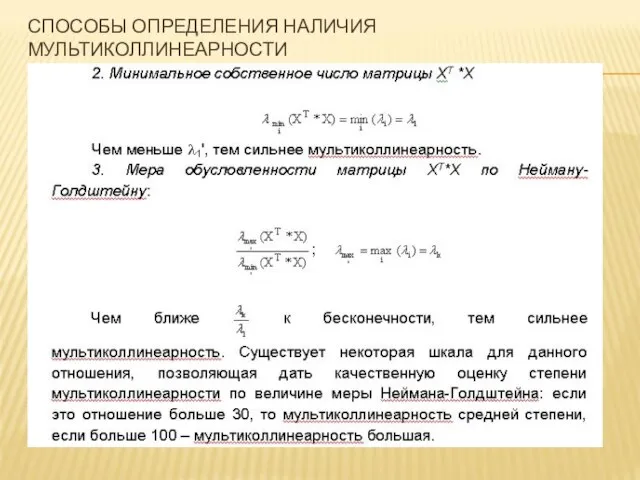

- 14. СПОСОБЫ ОПРЕДЕЛЕНИЯ НАЛИЧИЯ МУЛЬТИКОЛЛИНЕАРНОСТИ

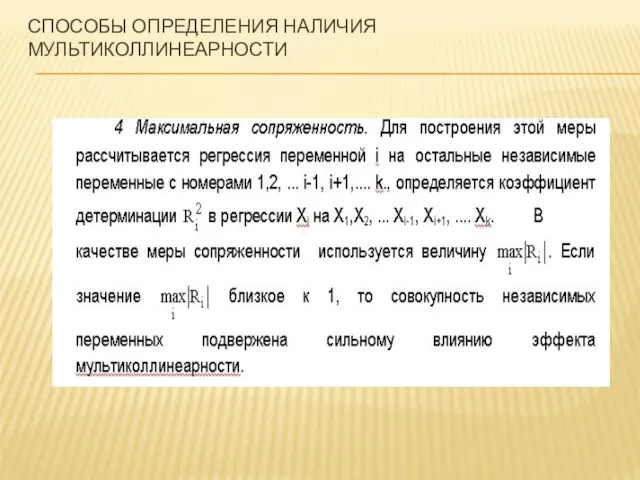

- 15. СПОСОБЫ ОПРЕДЕЛЕНИЯ НАЛИЧИЯ МУЛЬТИКОЛЛИНЕАРНОСТИ

- 16. СПОСОБЫ ОПРЕДЕЛЕНИЯ НАЛИЧИЯ МУЛЬТИКОЛЛИНЕАРНОСТИ 5. Метод Феррара-Глобера, который основан на применении трех видов статистических критериев: 1)

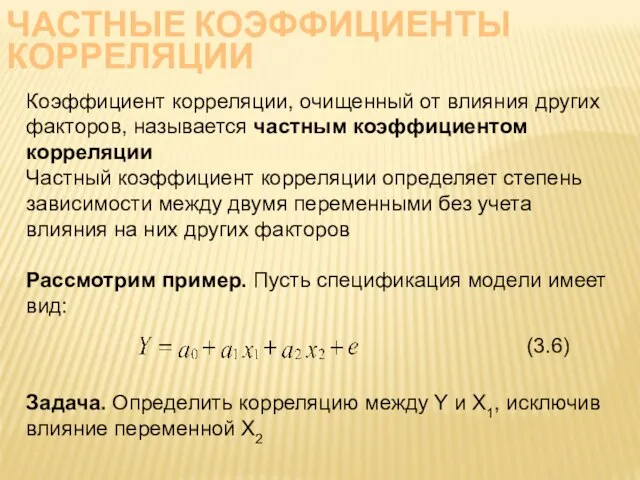

- 17. ЧАСТНЫЕ КОЭФФИЦИЕНТЫ КОРРЕЛЯЦИИ Коэффициент корреляции, очищенный от влияния других факторов, называется частным коэффициентом корреляции Частный коэффициент

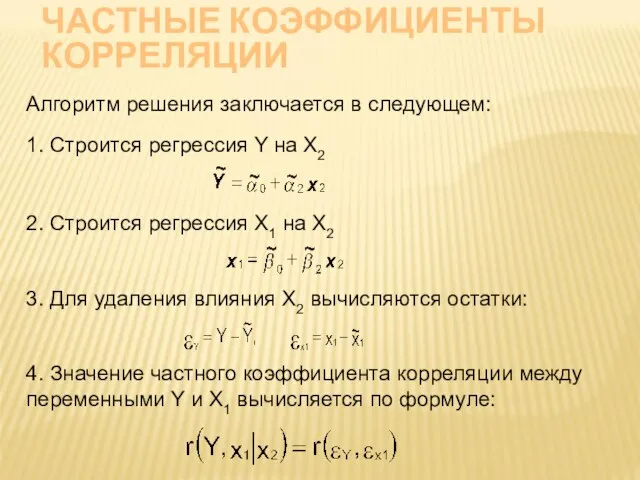

- 18. ЧАСТНЫЕ КОЭФФИЦИЕНТЫ КОРРЕЛЯЦИИ Алгоритм решения заключается в следующем: 1. Строится регрессия Y на X2 2. Строится

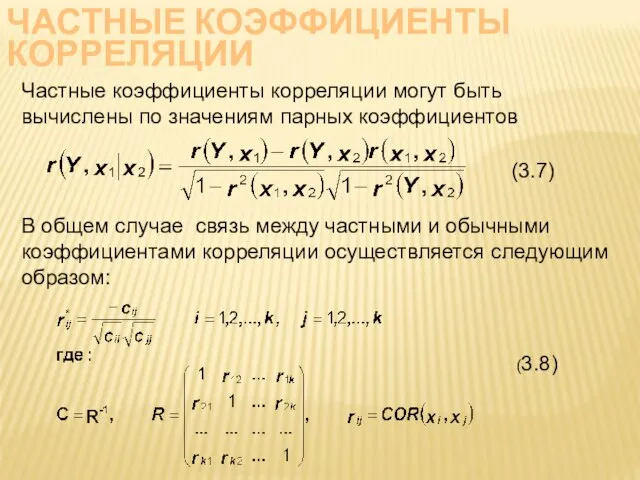

- 19. ЧАСТНЫЕ КОЭФФИЦИЕНТЫ КОРРЕЛЯЦИИ Частные коэффициенты корреляции могут быть вычислены по значениям парных коэффициентов В общем случае

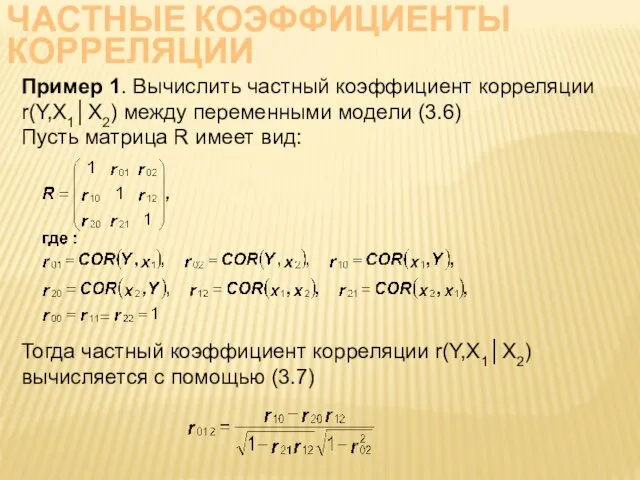

- 20. ЧАСТНЫЕ КОЭФФИЦИЕНТЫ КОРРЕЛЯЦИИ Пример 1. Вычислить частный коэффициент корреляции r(Y,X1│X2) между переменными модели (3.6) Пусть матрица

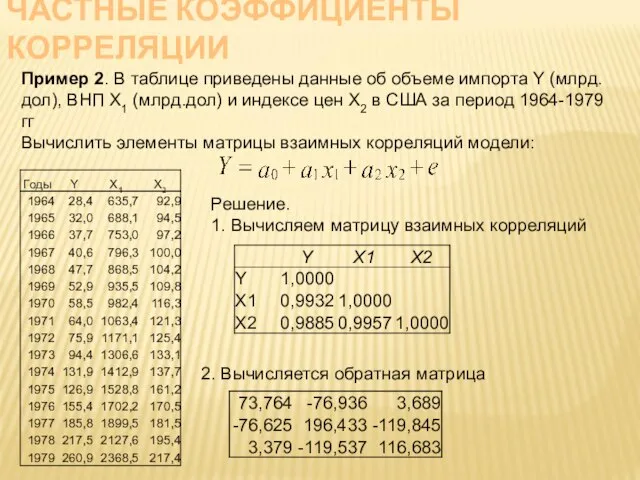

- 21. ЧАСТНЫЕ КОЭФФИЦИЕНТЫ КОРРЕЛЯЦИИ Пример 2. В таблице приведены данные об объеме импорта Y (млрд.дол), ВНП X1

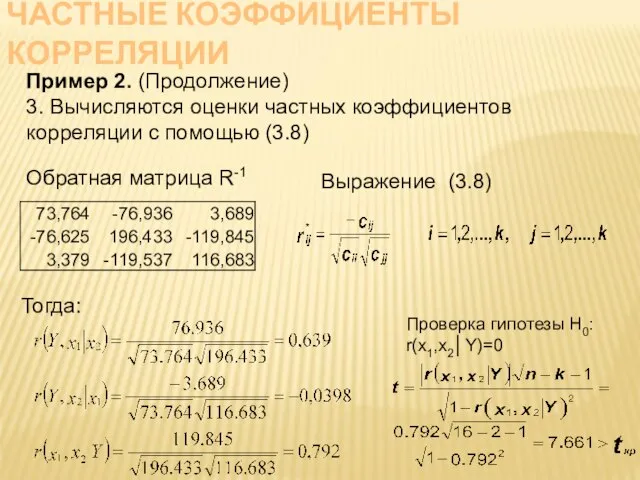

- 22. ЧАСТНЫЕ КОЭФФИЦИЕНТЫ КОРРЕЛЯЦИИ Пример 2. (Продолжение) 3. Вычисляются оценки частных коэффициентов корреляции с помощью (3.8) Обратная

- 23. МЕТОДЫ УСТРАНЕНИЯ МУЛЬТИКОЛЛИНЕАРНОСТИ Существуют следующие группы методов устранения мультиколлинеарности в уравнениях регрессии: Методы исключения переменных модели;

- 24. Метод дополнительных регрессий Алгоритм метода заключается в следующем: Строятся уравнения регрессии, которые связывают каждый из регрессоров

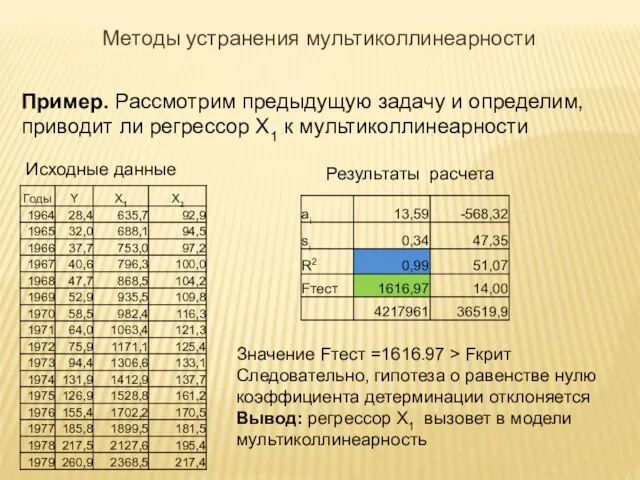

- 25. Пример. Рассмотрим предыдущую задачу и определим, приводит ли регрессор X1 к мультиколлинеарности Исходные данные Результаты расчета

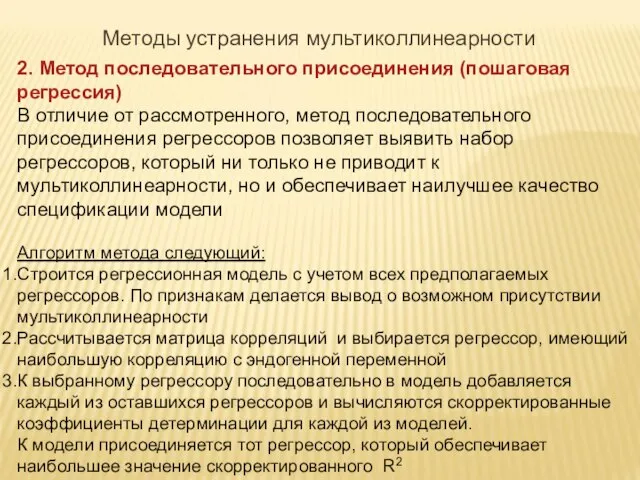

- 26. 2. Метод последовательного присоединения (пошаговая регрессия) В отличие от рассмотренного, метод последовательного присоединения регрессоров позволяет выявить

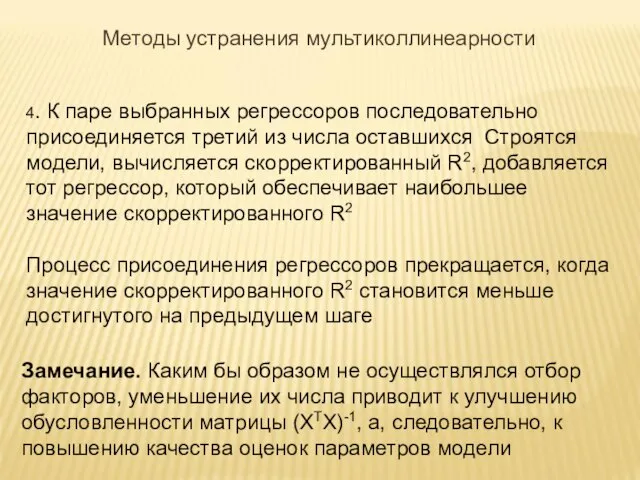

- 27. 4. К паре выбранных регрессоров последовательно присоединяется третий из числа оставшихся Строятся модели, вычисляется скорректированный R2,

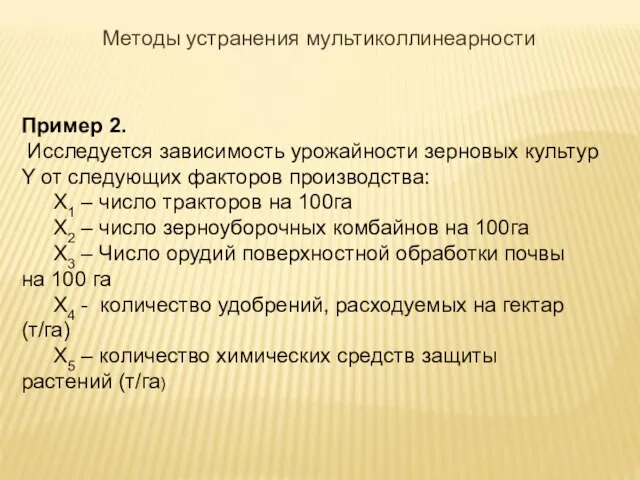

- 28. Пример 2. Исследуется зависимость урожайности зерновых культур Y от следующих факторов производства: X1 – число тракторов

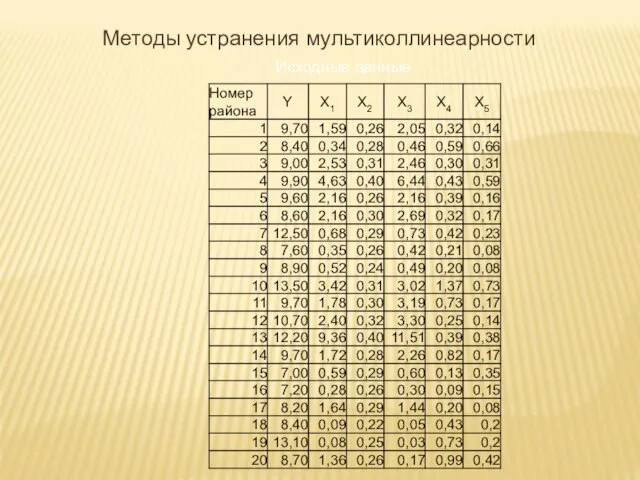

- 29. Исходные данные Методы устранения мультиколлинеарности

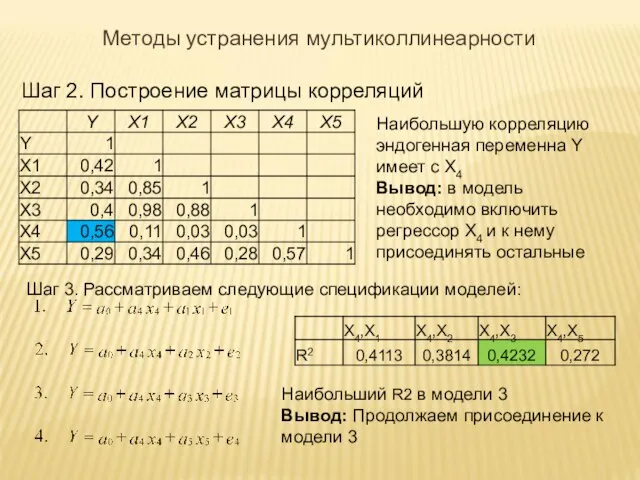

- 30. Шаг 2. Построение матрицы корреляций Наибольшую корреляцию эндогенная переменна Y имеет с X4 Вывод: в модель

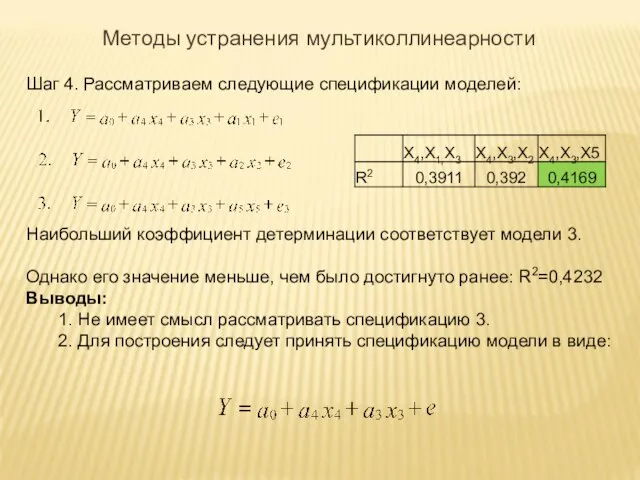

- 31. Шаг 4. Рассматриваем следующие спецификации моделей: Наибольший коэффициент детерминации соответствует модели 3. Однако его значение меньше,

- 33. Скачать презентацию

Презентация на тему Экосистемы арктических пустынь и тундры

Презентация на тему Экосистемы арктических пустынь и тундры  ООО ЭНЕРГОТЕХ. Разработка и производство электротехнического оборудования

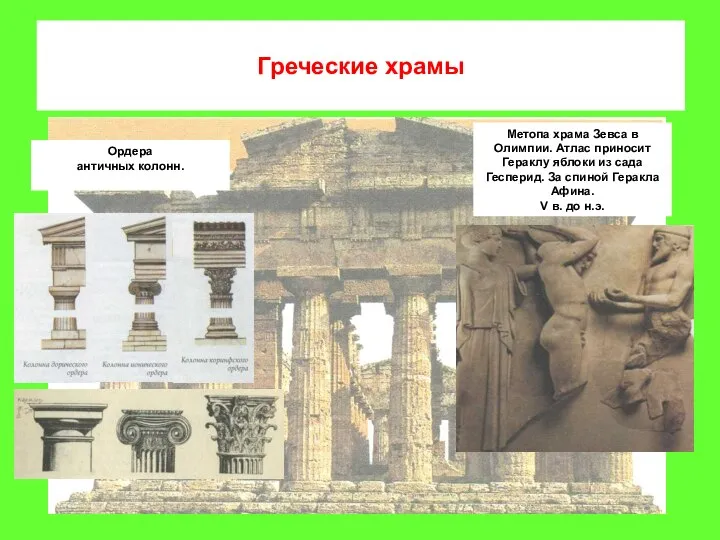

ООО ЭНЕРГОТЕХ. Разработка и производство электротехнического оборудования Греческие храмы. История искусства. Часть 2

Греческие храмы. История искусства. Часть 2 Санкт-Петербургский государственный университетинформационных технологий, механики и оптики

Санкт-Петербургский государственный университетинформационных технологий, механики и оптики Профессия фрезеровщик

Профессия фрезеровщик Государственное казенное образовательное учреждение среднего профессионального образования «Курганский областной колледж куль

Государственное казенное образовательное учреждение среднего профессионального образования «Курганский областной колледж куль Общие подходы в менеджменте и их особенности

Общие подходы в менеджменте и их особенности Оранжевое солнце

Оранжевое солнце Социальные сети, как инструмент взаимодействия с клиентом

Социальные сети, как инструмент взаимодействия с клиентом Автопортрет. Мимический портрет. Работы учащихся

Автопортрет. Мимический портрет. Работы учащихся Детско-юношеский, спортивно-технический кружок Дивизион юниор (фотографии)

Детско-юношеский, спортивно-технический кружок Дивизион юниор (фотографии) Презентация на тему Достижения России в космосе

Презентация на тему Достижения России в космосе Учение Н. И. Пироговао врачебных ошибках

Учение Н. И. Пироговао врачебных ошибках Мир Информации

Мир Информации Борисова Наталья Владимировна Научно-методический центр Юго-восточного окружного управления образования города Москвы, ГОУ СОШ «

Борисова Наталья Владимировна Научно-методический центр Юго-восточного окружного управления образования города Москвы, ГОУ СОШ « Кутузов и Наполеон в романе Л.Н.Толстого «Война и мир» 10 класс

Кутузов и Наполеон в романе Л.Н.Толстого «Война и мир» 10 класс ПОЛІТИЧНА ВЛАДА

ПОЛІТИЧНА ВЛАДА Государственная поддержка региональных промышленных предприятий на федеральном уровне

Государственная поддержка региональных промышленных предприятий на федеральном уровне Организация маркетинговых исследований (презентация курса)

Организация маркетинговых исследований (презентация курса) Урок-путешествие в космос

Урок-путешествие в космос Гостья из будущего

Гостья из будущего Как чай влияет на организм человека

Как чай влияет на организм человека Морфологический разбор глагола

Морфологический разбор глагола Финикия

Финикия Проблемы молодежи в городе

Проблемы молодежи в городе г.Брянсклицей №27

г.Брянсклицей №27 Кислород

Кислород Осторожно, огонь !

Осторожно, огонь !