Слайд 2Что такое аномалии?

Перед началом, важно определиться с типами аномалий:

1. Точечные аномалии. Единичный

случай аномального поведения, когда паттерн сильно отличается от всех предыдущих. Реальный пример: кража денег с карты, распознание на основе потраченных денег.

2. Контекстные аномалии. Аномалии завязанные на контекст, наиболее распространено в данных с временными рядами. Реальный пример: Траты $100 в день по праздникам нормально, но вызывает подозрения в других случаях.

3. Коллективные аномалии: множество данных, совокупно помогающих определить аномалии. Реальный пример: Попытка скопировать данные с удалённой машины.

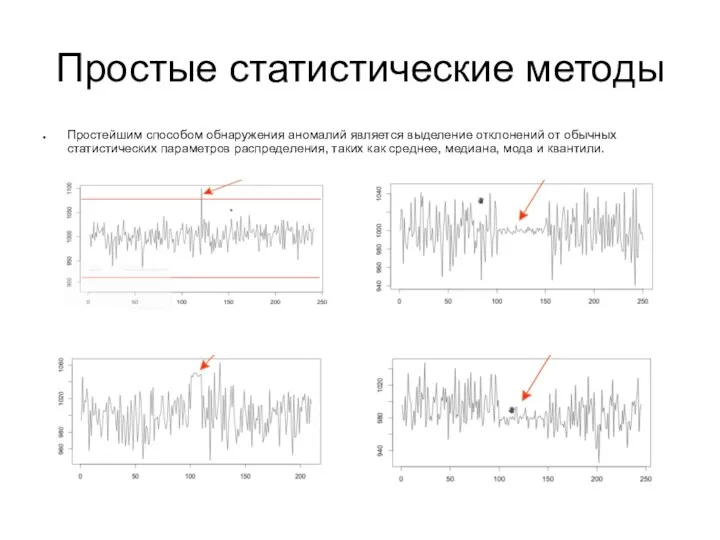

Слайд 3Простые статистические методы

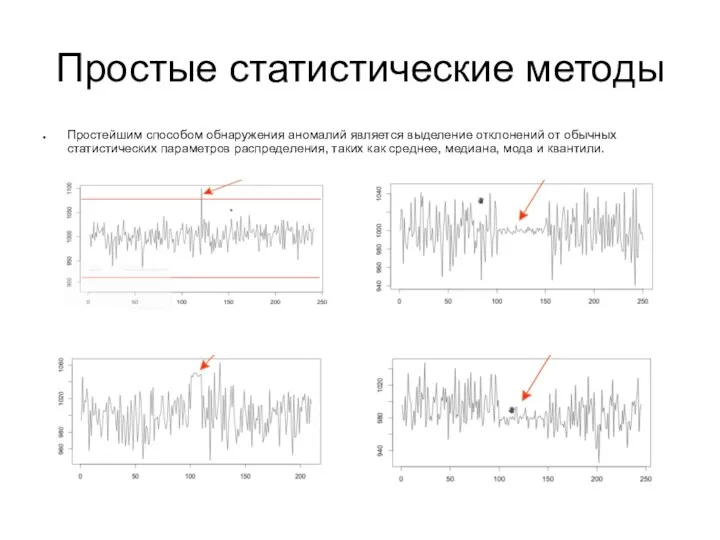

Простейшим способом обнаружения аномалий является выделение отклонений от обычных статистических

параметров распределения, таких как среднее, медиана, мода и квантили.

Слайд 4Минусы статистических подходов

Статистические методы плохо работают в следующих случаях:

Данные содержат шум близкий

к аномальному, бывает тяжело разделить нормальный и аномальный шум

Плавное изменение данных может изменить данные распределения, поэтому такой способ не всегда применим

Данные имеют сезонное распределение, это может потребовать разделение данных на несколько групп

Слайд 5Поиск аномалий, основанный на плотности

Аномалии обнаруживаются из предположения, что схожие данные должны

находится рядом. Метрики могут отличаться, в общему случае используется евклидова метрика, но в случае категориальных данных используются другие.

Наиболее распространённый алгоритм KNN

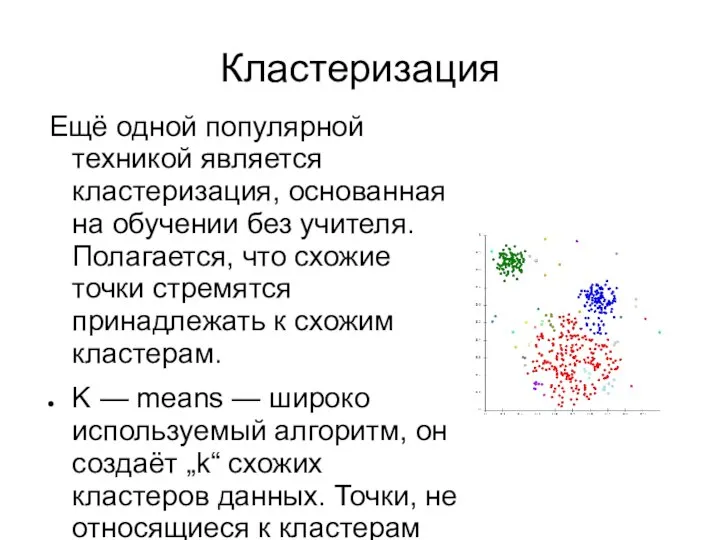

Слайд 6Кластеризация

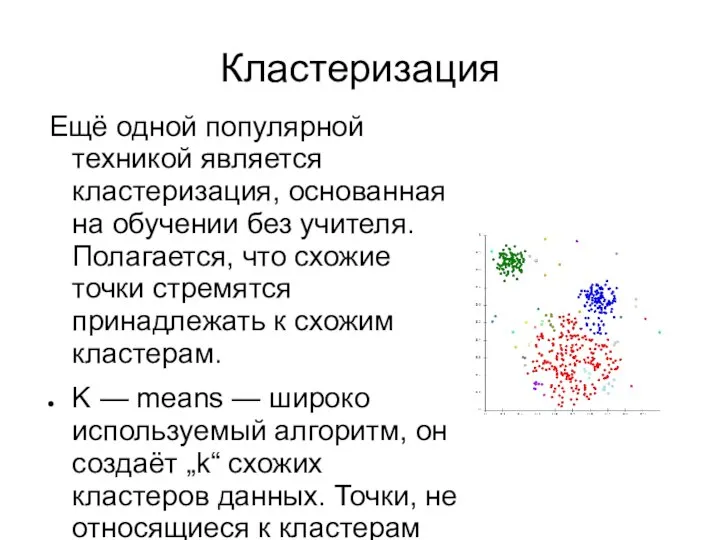

Ещё одной популярной техникой является кластеризация, основанная на обучении без учителя. Полагается,

что схожие точки стремятся принадлежать к схожим кластерам.

K — means — широко используемый алгоритм, он создаёт „k“ схожих кластеров данных. Точки, не относящиеся к кластерам считаются аномалиями.

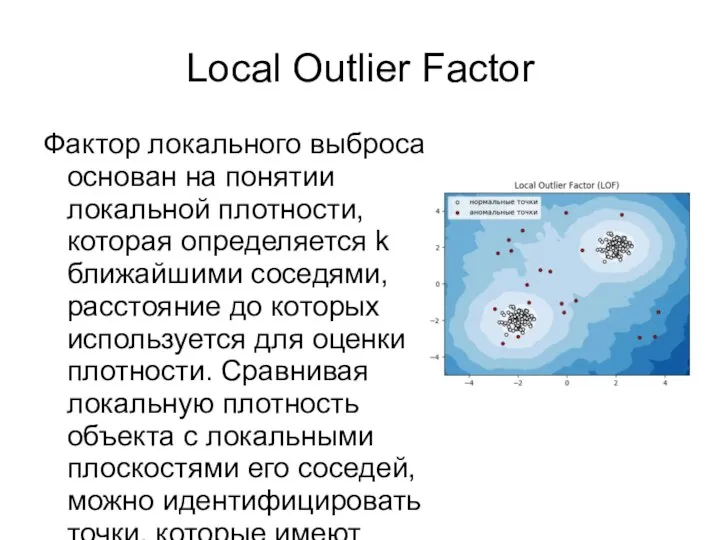

Слайд 7Local Outlier Factor

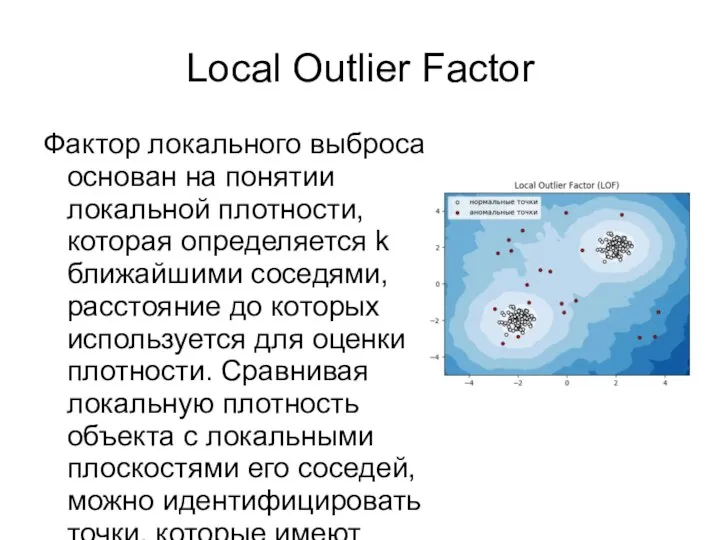

Фактор локального выброса основан на понятии локальной плотности, которая определяется

k ближайшими соседями, расстояние до которых используется для оценки плотности. Сравнивая локальную плотность объекта с локальными плоскостями его соседей, можно идентифицировать точки, которые имеют существенно более низкую плотность чем их соседи. Они считаются выбросами.

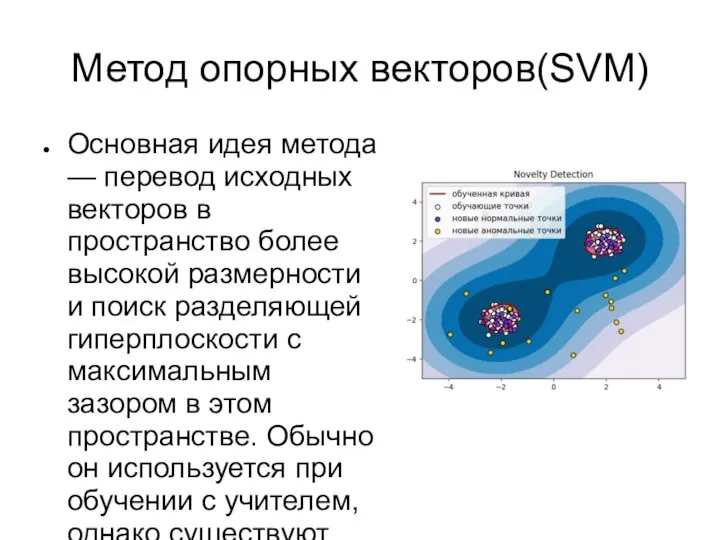

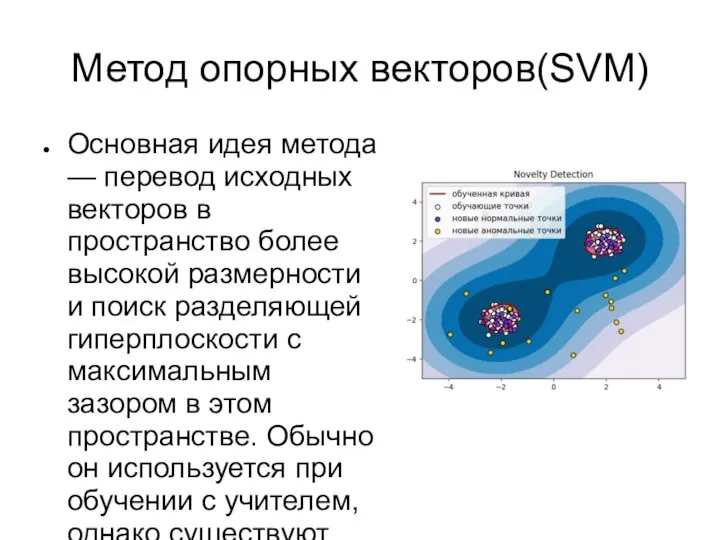

Слайд 8Метод опорных векторов(SVM)

Основная идея метода — перевод исходных векторов в пространство более

высокой размерности и поиск разделяющей гиперплоскости с максимальным зазором в этом пространстве. Обычно он используется при обучении с учителем, однако существуют модификации(OneClassSVM), которые позволяют обнаружить аномалии без учителя, такие алгоритмы строят границы на обучающей выборке, а затем на тестовой выборке подстраивается таким образом, чтобы идентифицировать аномалии

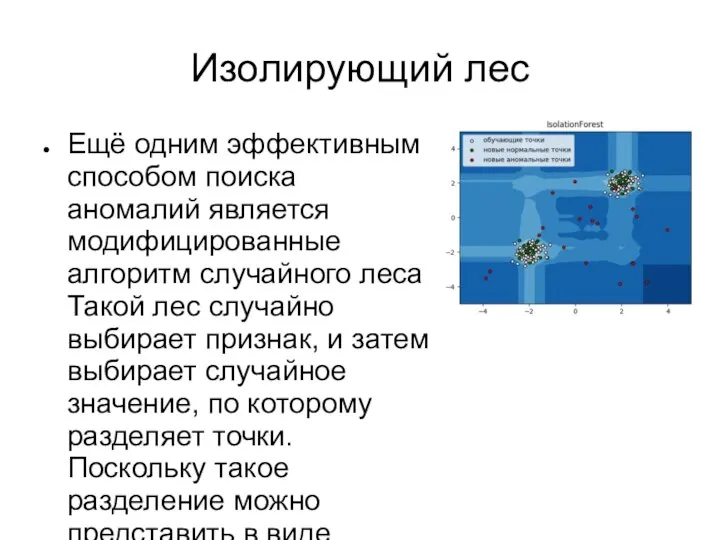

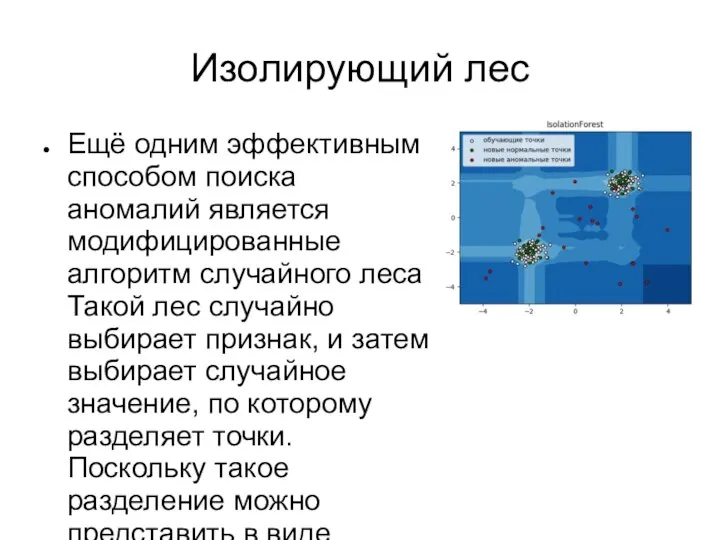

Слайд 9Изолирующий лес

Ещё одним эффективным способом поиска аномалий является модифицированные алгоритм случайного леса.

Такой лес случайно выбирает признак, и затем выбирает случайное значение, по которому разделяет точки. Поскольку такое разделение можно представить в виде дерева, количество разделений, необходимое для изоляции точки, равно длине пути из корня дерева к отделяемому объекту. Средняя длина пути в лесу является мерой нормальности точки, если множество деревьев коллективно строит короткие пути для точки, такая точка является аномалией.

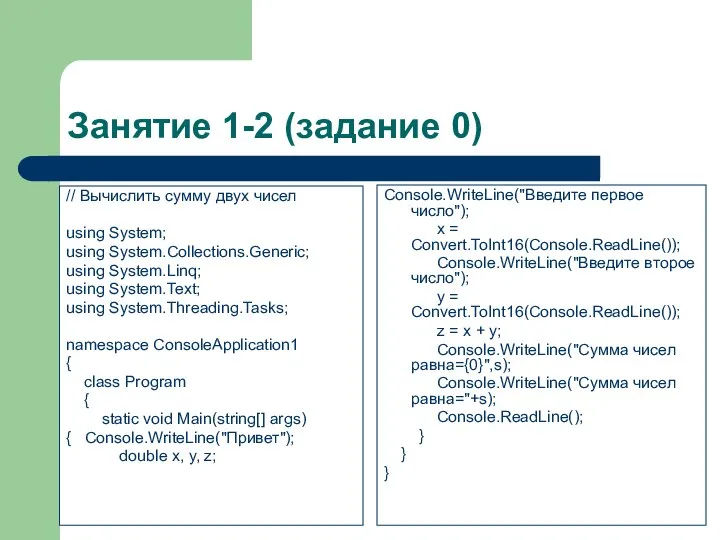

Занятие 1-2 (задание 0)

Занятие 1-2 (задание 0) Векторный радикал

Векторный радикал Логические основы вычислительной техники

Логические основы вычислительной техники Компьютерный вирус

Компьютерный вирус Ссылки в Excel

Ссылки в Excel Метод пузырька. Сортировка массива

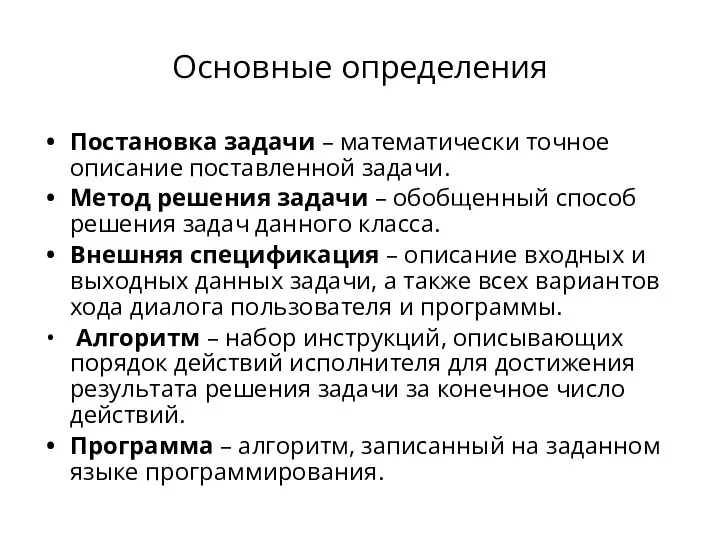

Метод пузырька. Сортировка массива Основные определения

Основные определения Методы защиты информации

Методы защиты информации Выбор способов построения 3d моделей. (1 занятие)

Выбор способов построения 3d моделей. (1 занятие) Основные вектора атак на приложения. Способы их достижения и возможные последствия

Основные вектора атак на приложения. Способы их достижения и возможные последствия Электронная подпись

Электронная подпись 7-1-3 Всемирная паутина

7-1-3 Всемирная паутина Группа ВК Плечом к плечу. Конкурс

Группа ВК Плечом к плечу. Конкурс Поисковые каналы изменили журналистику. Видео и трансляции, визуальная журналистика

Поисковые каналы изменили журналистику. Видео и трансляции, визуальная журналистика Модули, введение. Экспорт и импорт

Модули, введение. Экспорт и импорт Архивация. Стиснення даних

Архивация. Стиснення даних Сжатие данных

Сжатие данных Моя безопасность в информационном веке

Моя безопасность в информационном веке Основы программирования C++

Основы программирования C++ Информационные технологии: понятие, виды информационных технологий

Информационные технологии: понятие, виды информационных технологий Внешние и внутренние устройства компьютера

Внешние и внутренние устройства компьютера Разработка информационной системы для решения задачи анализа финансовых потоков многоуровневой организации

Разработка информационной системы для решения задачи анализа финансовых потоков многоуровневой организации Регистрация ККТ в Личном кабинете ИП

Регистрация ККТ в Личном кабинете ИП Таблицы HTML

Таблицы HTML Указатели. Оператор адреса &

Указатели. Оператор адреса & Алгоритмизация и требования к алгоритму

Алгоритмизация и требования к алгоритму Web-программирование. Лекция 5. Шаблоны проектирования

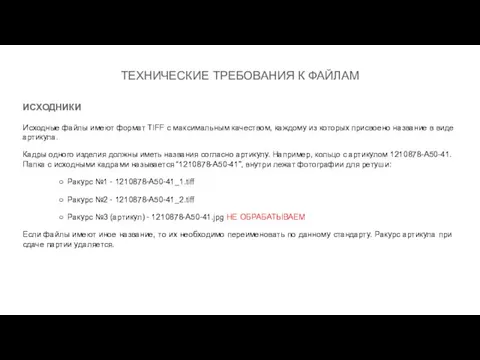

Web-программирование. Лекция 5. Шаблоны проектирования Технические требования к файлам. Исходники

Технические требования к файлам. Исходники