Содержание

- 2. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 3. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

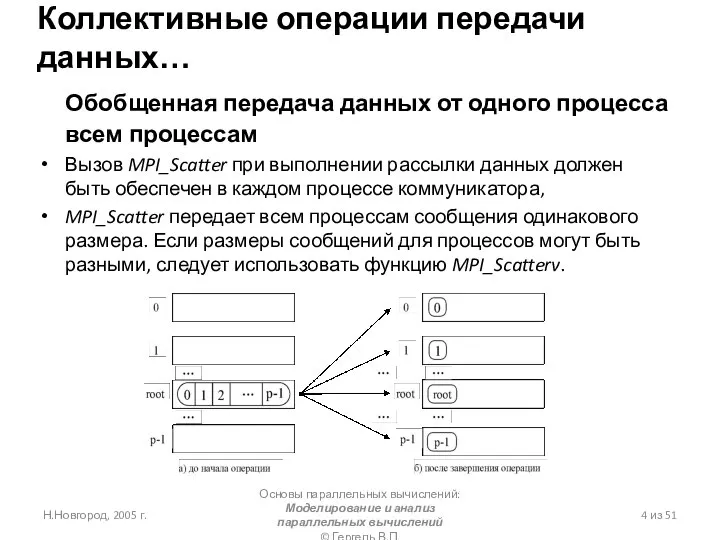

- 4. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

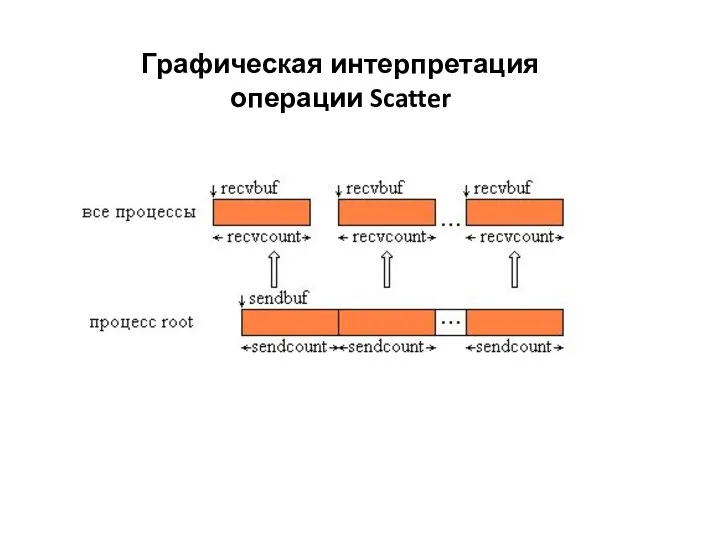

- 5. Графическая интерпретация операции Scatter

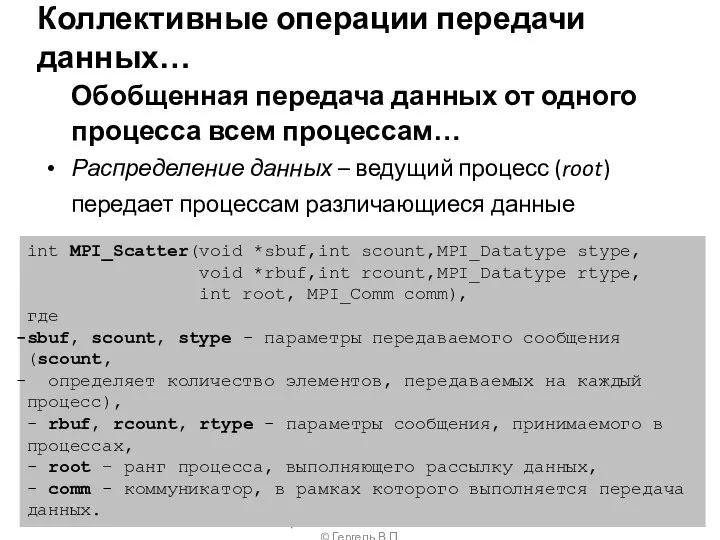

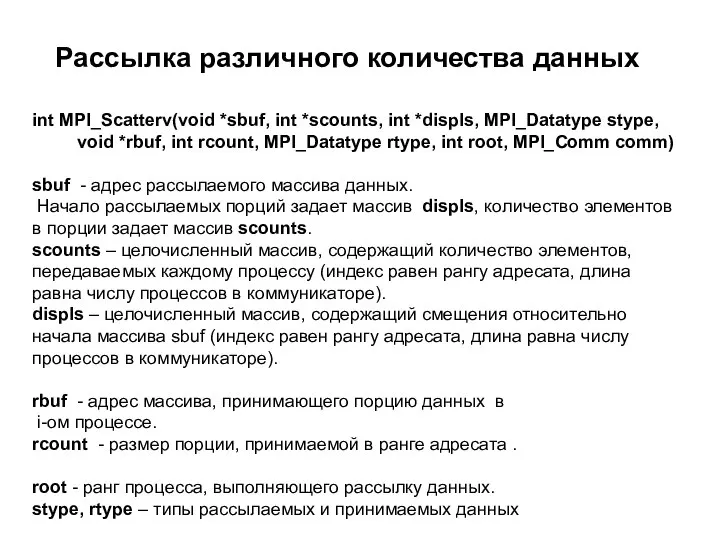

- 6. int MPI_Scatterv(void *sbuf, int *scounts, int *displs, MPI_Datatype stype, void *rbuf, int rcount, MPI_Datatype rtype, int

- 7. Графическая интерпретация операции Scatterv

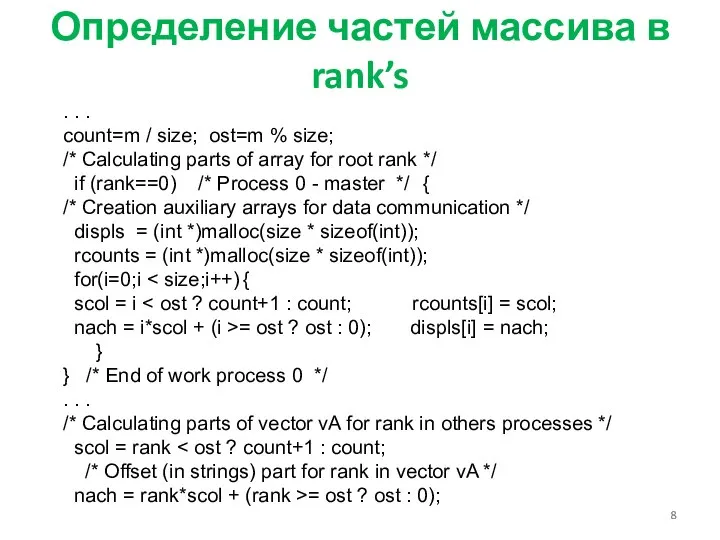

- 8. Определение частей массива в rank’s . . . count=m / size; ost=m % size; /* Calculating

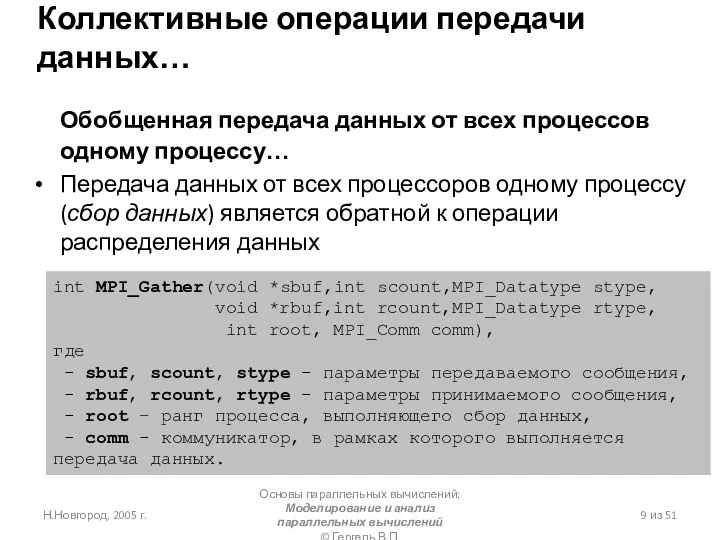

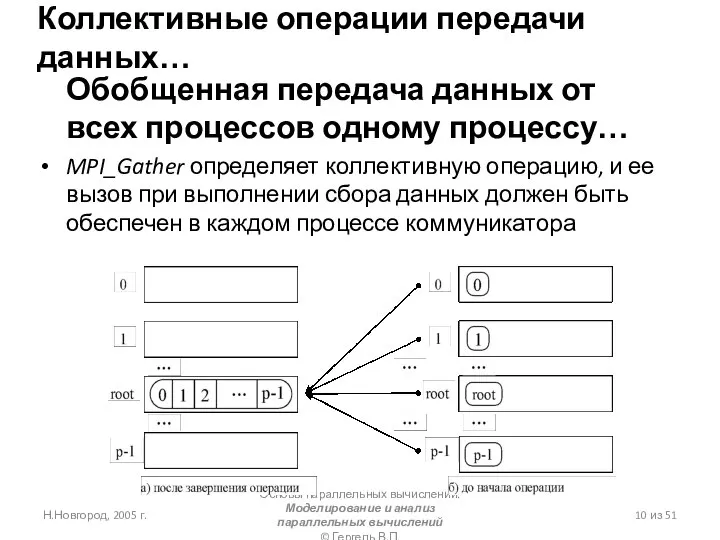

- 9. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 10. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

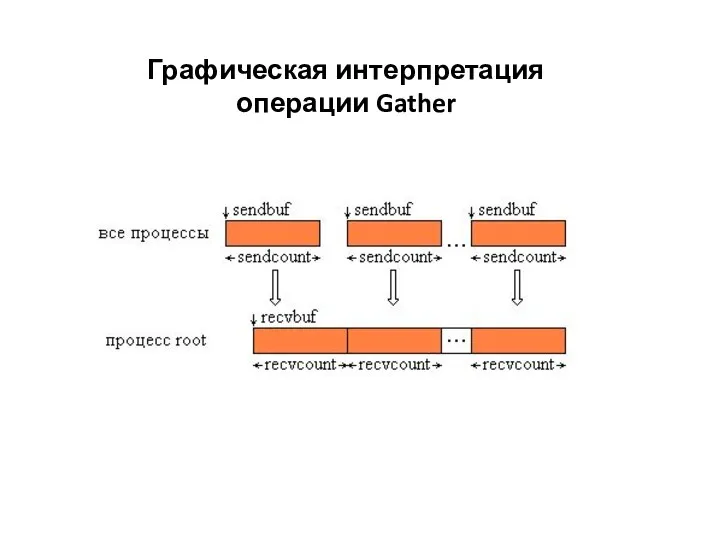

- 11. Графическая интерпретация операции Gather

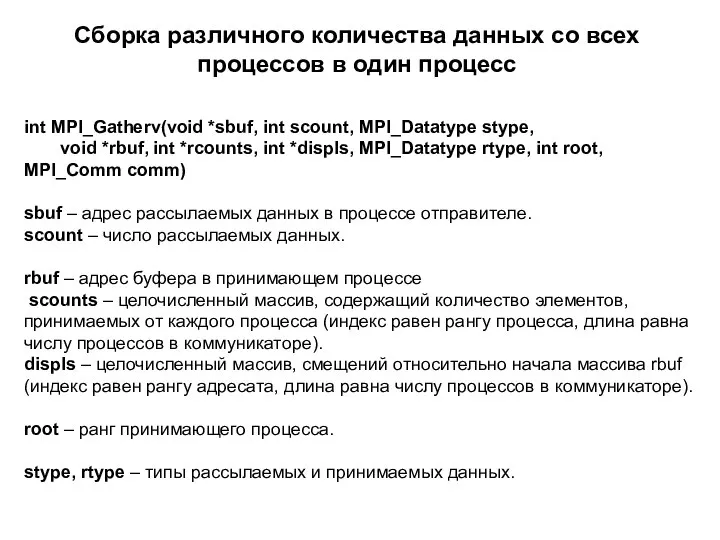

- 12. int MPI_Gatherv(void *sbuf, int scount, MPI_Datatype stype, void *rbuf, int *rcounts, int *displs, MPI_Datatype rtype, int

- 13. Графическая интерпретация операции Gatherv

- 15. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 16. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

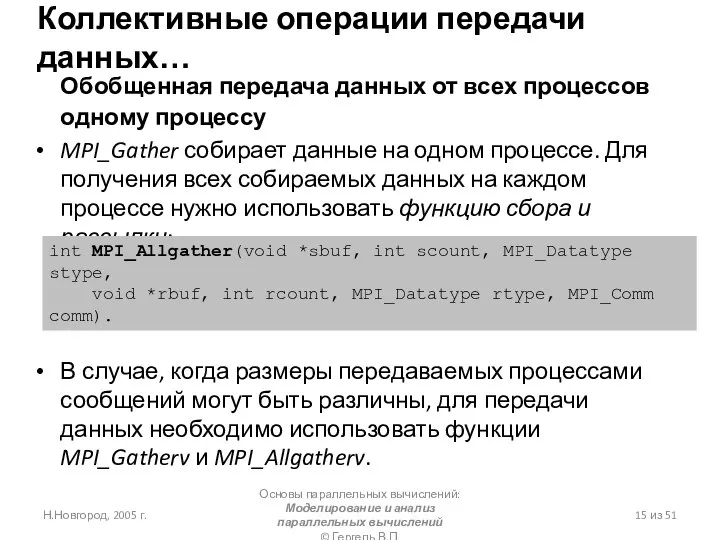

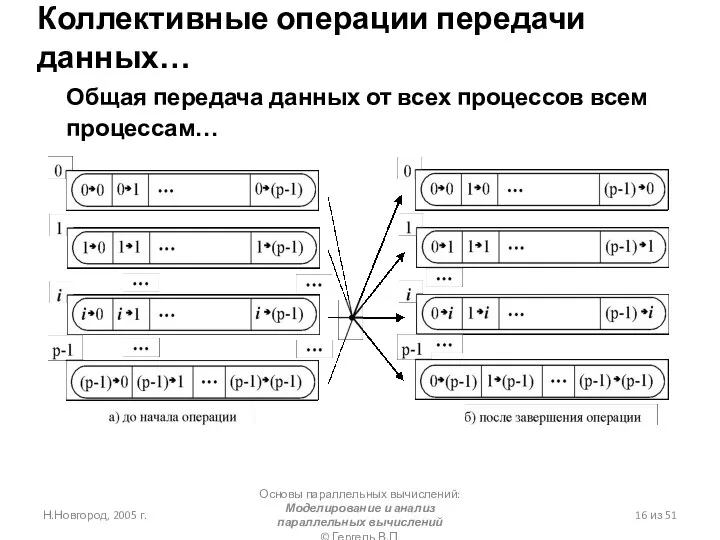

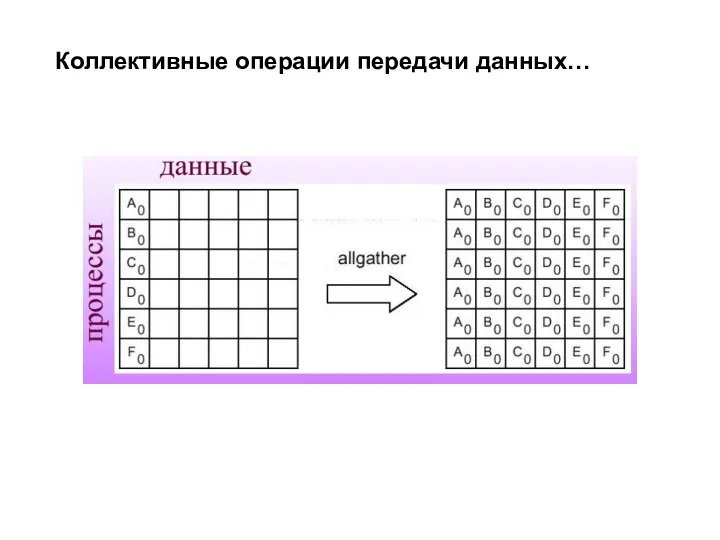

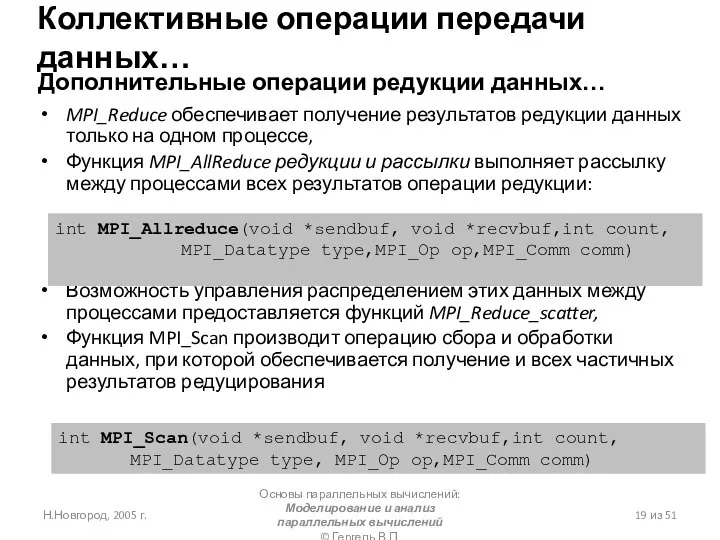

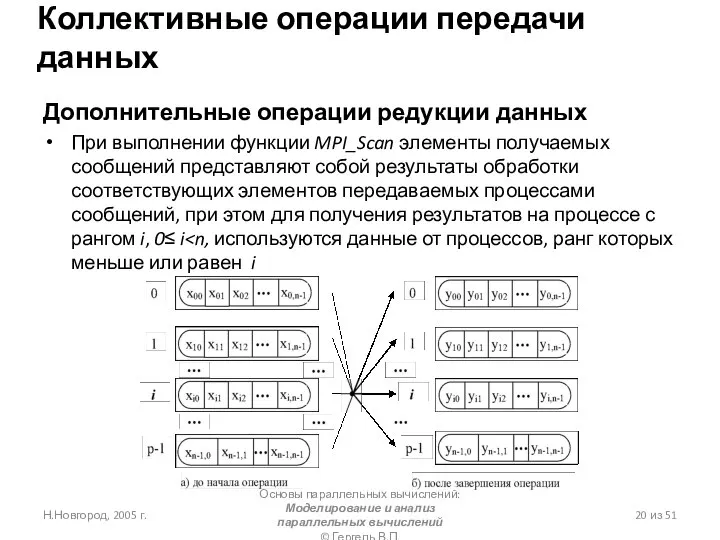

- 17. Коллективные операции передачи данных…

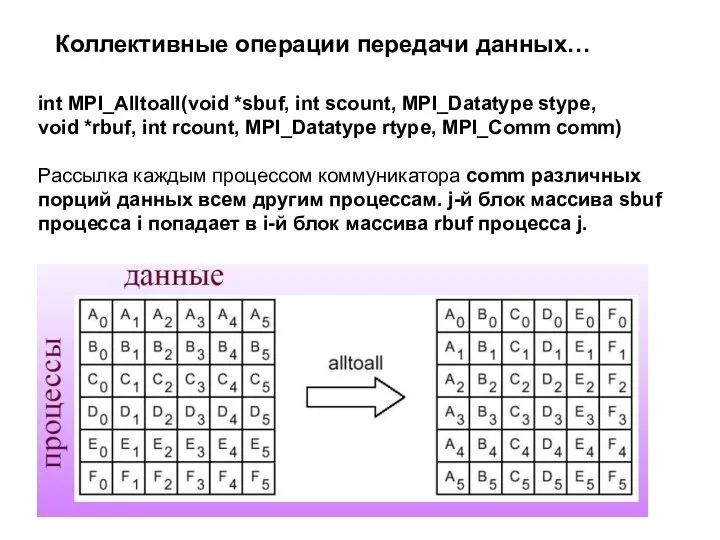

- 18. int MPI_Alltoall(void *sbuf, int scount, MPI_Datatype stype, void *rbuf, int rcount, MPI_Datatype rtype, MPI_Comm comm) Рассылка

- 19. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 20. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 22. Скачать презентацию

Основы видеомонтажа

Основы видеомонтажа Преобразование графических изображений

Преобразование графических изображений Моушен дизайн

Моушен дизайн Поисковые системы

Поисковые системы От тамагочи до криптокотиков

От тамагочи до криптокотиков ТЗ на приложение для сбора анкет

ТЗ на приложение для сбора анкет Виды интерфейсов. Понятие программного интерфейса, его назначение. Интерфейс пользователя. (Лекция 3)

Виды интерфейсов. Понятие программного интерфейса, его назначение. Интерфейс пользователя. (Лекция 3) The basics of working in R

The basics of working in R Что такое компьютер

Что такое компьютер Разработка коллекции видеоматериалов для проведения рекламной кампании

Разработка коллекции видеоматериалов для проведения рекламной кампании Презентация на тему Текст и текстовый редактор

Презентация на тему Текст и текстовый редактор  Аналитическая бизнес-справка на ЮЛ

Аналитическая бизнес-справка на ЮЛ Applications on phones

Applications on phones Классификация ИС

Классификация ИС Искусственный интеллект и системы искусственного интеллекта

Искусственный интеллект и системы искусственного интеллекта Изучение возможностей и синтаксиса Python: Контейнеры. Часть 2. 9 занятие

Изучение возможностей и синтаксиса Python: Контейнеры. Часть 2. 9 занятие Mars 12. Services

Mars 12. Services IT-Practicum для тестировщиков

IT-Practicum для тестировщиков Цифровые технологии в дизайне

Цифровые технологии в дизайне Smart - расчёт. Социальная платформа для экономического образования страны

Smart - расчёт. Социальная платформа для экономического образования страны Основы формальной теории защиты информации. Распознавание и контроль поведения пользователя

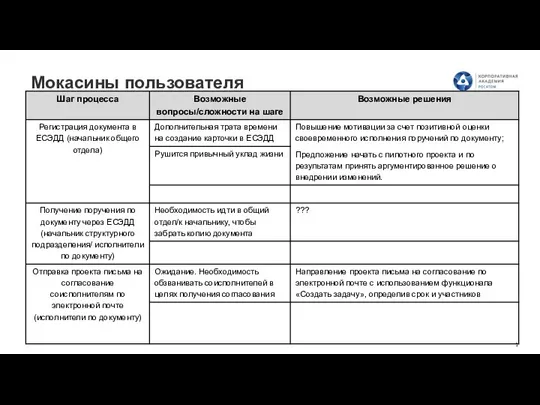

Основы формальной теории защиты информации. Распознавание и контроль поведения пользователя Мокасины пользователя

Мокасины пользователя Belhard Trainings Step-2 Java Enterprise Edition. Общая информация

Belhard Trainings Step-2 Java Enterprise Edition. Общая информация Математические основы информатики. (Тема 2)

Математические основы информатики. (Тема 2) WTS Smart. Специализированное программно-аппаратное решение

WTS Smart. Специализированное программно-аппаратное решение Жизнь замечательных персонажей: Ленинград и СанктПетербург в играх

Жизнь замечательных персонажей: Ленинград и СанктПетербург в играх Логические операции в Excel

Логические операции в Excel Правила стиля. Комбинаторика. Выполнение домашнего задания

Правила стиля. Комбинаторика. Выполнение домашнего задания