Содержание

- 2. Типы машинного обучения Индуктивное (по прецедентам) и дедуктивное. Некоторые методы индуктивного обучения были разработаны в качестве

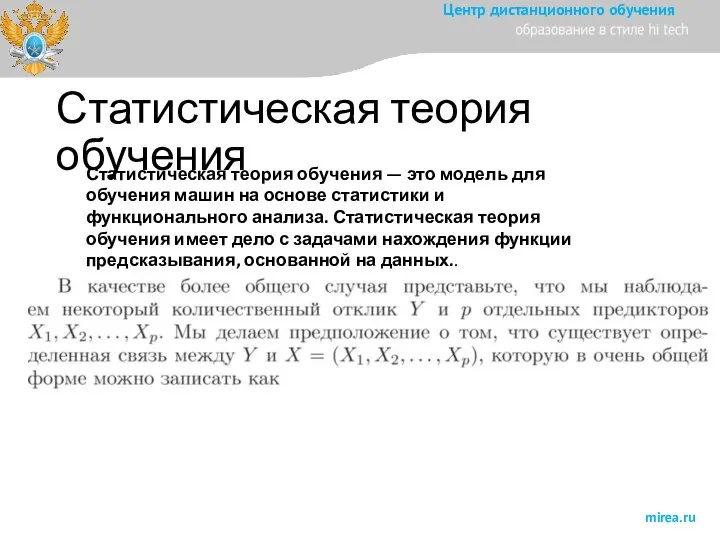

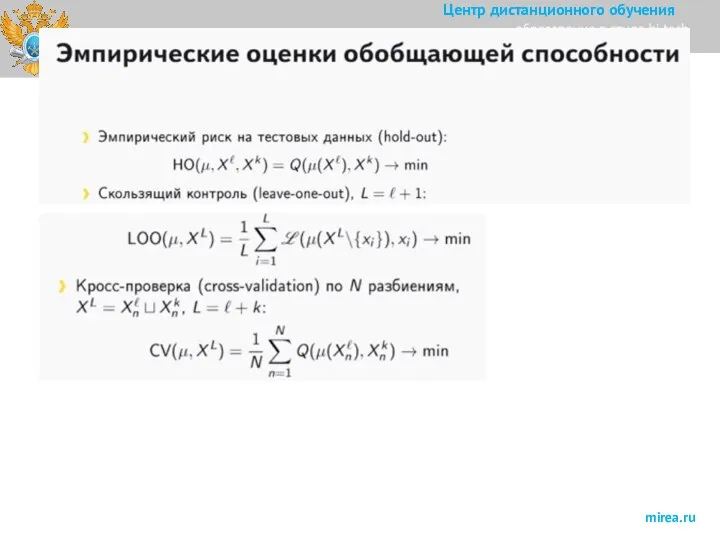

- 3. Статистическая теория обучения Статистическая теория обучения — это модель для обучения машин на основе статистики и

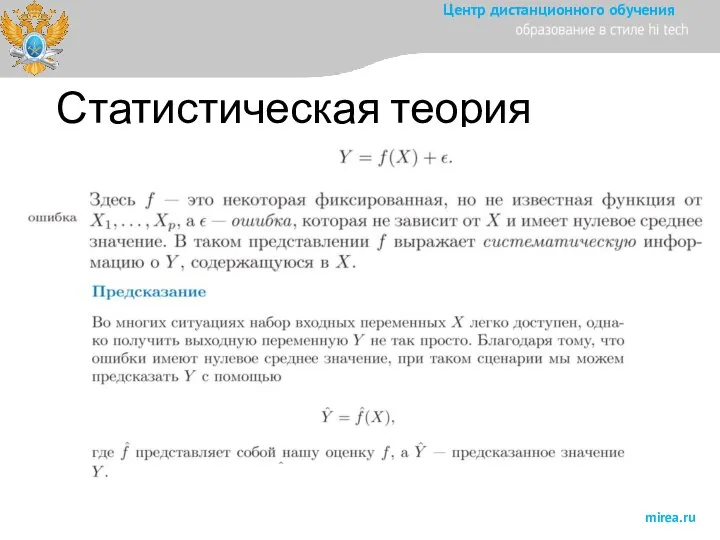

- 4. Статистическая теория обучения

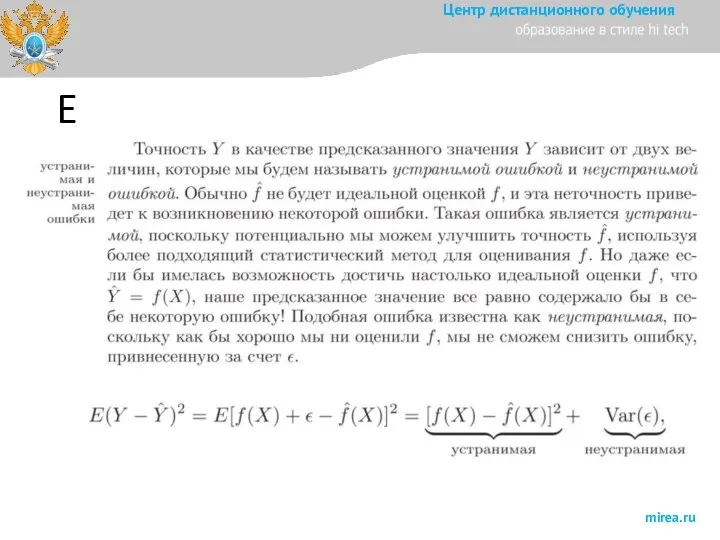

- 5. E

- 6. E Разброс - характеризует разнообразие алгоритмов (из-за случайности обучающей выборки, в том числе шума, и стохастической

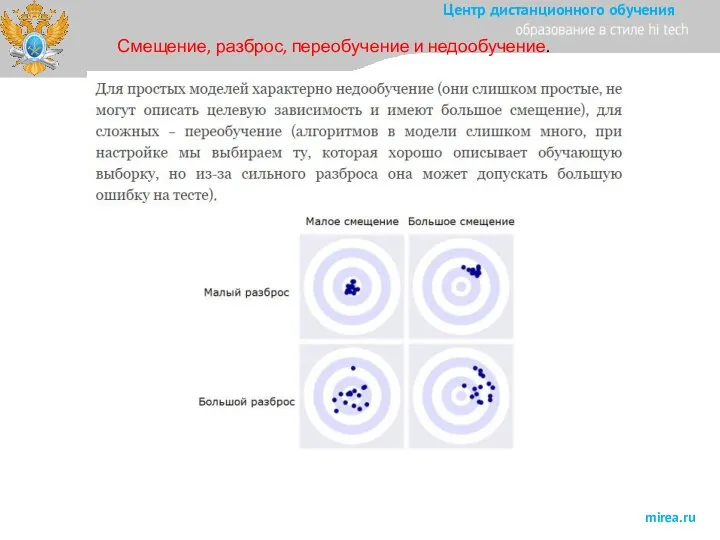

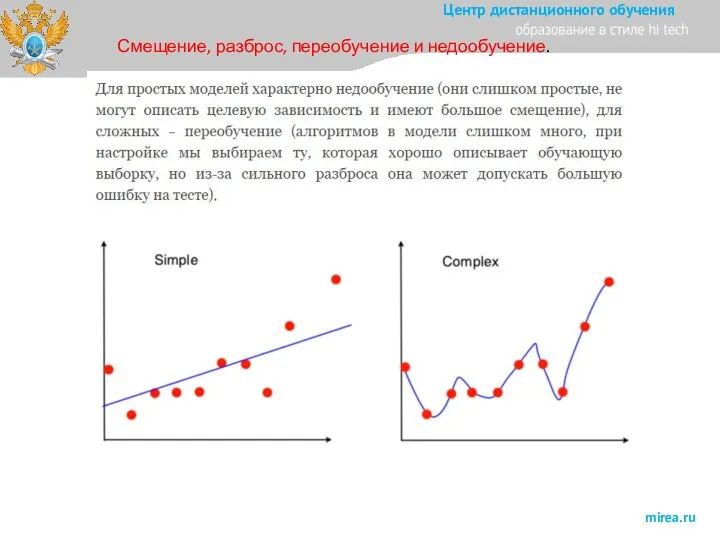

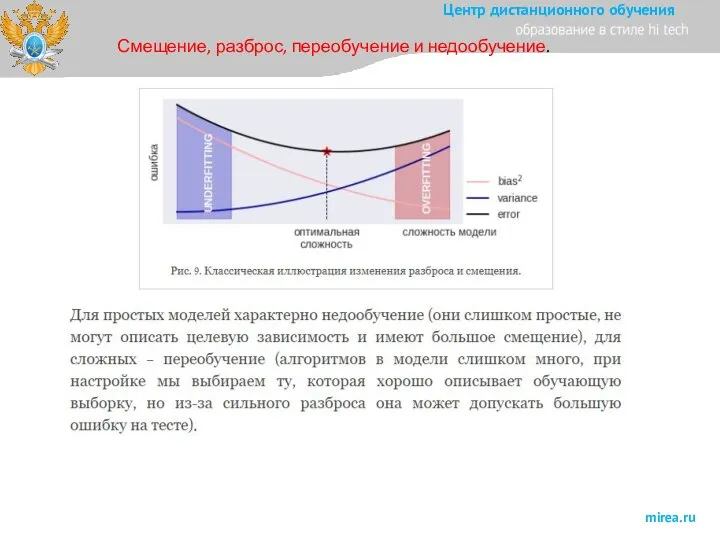

- 7. Смещение, разброс, переобучение и недообучение.

- 8. Смещение, разброс, переобучение и недообучение.

- 9. Смещение, разброс, переобучение и недообучение.

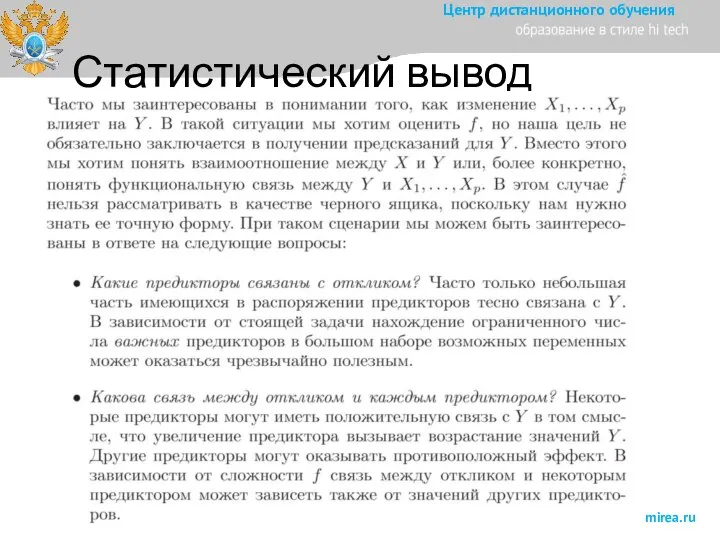

- 10. Статистический вывод

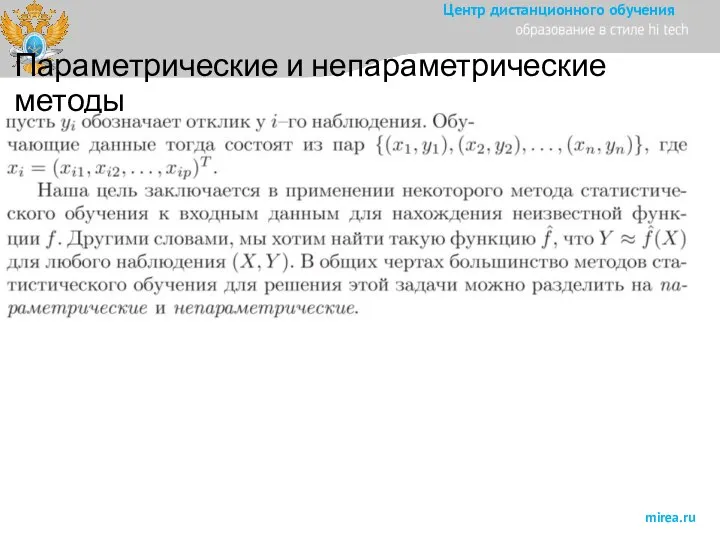

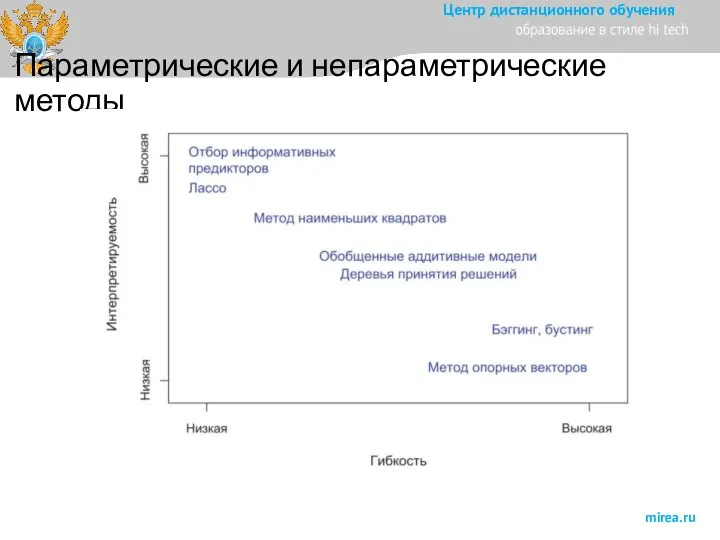

- 11. Параметрические и непараметрические методы

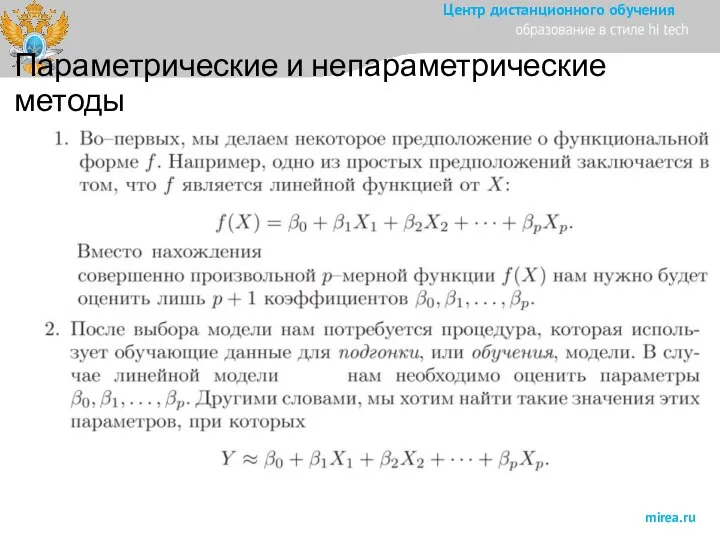

- 12. Параметрические и непараметрические методы

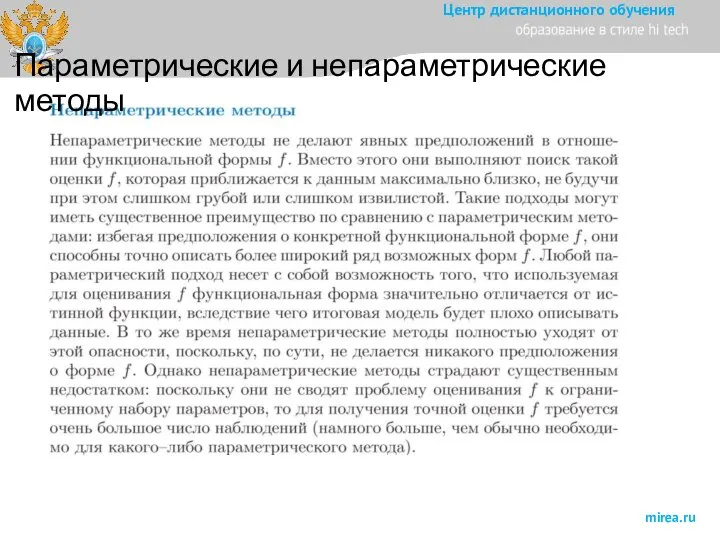

- 13. Параметрические и непараметрические методы

- 14. Параметрические и непараметрические методы

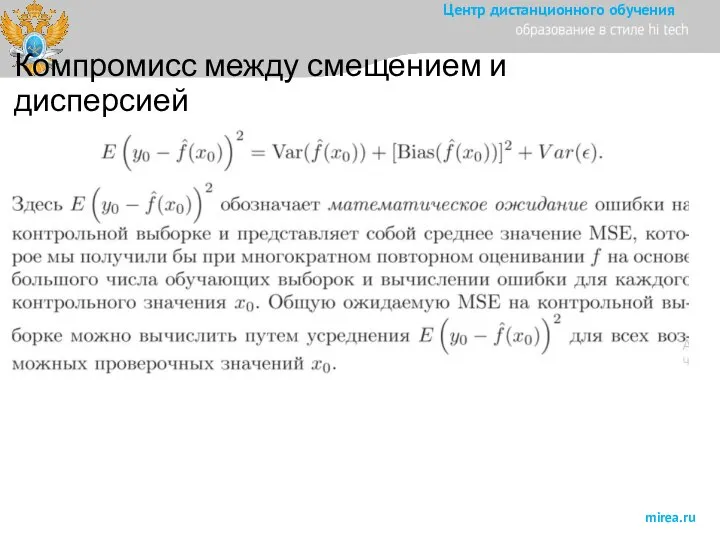

- 15. Компромисс между смещением и дисперсией

- 16. Компромисс между смещением и дисперсией

- 17. Компромисс между смещением и дисперсией

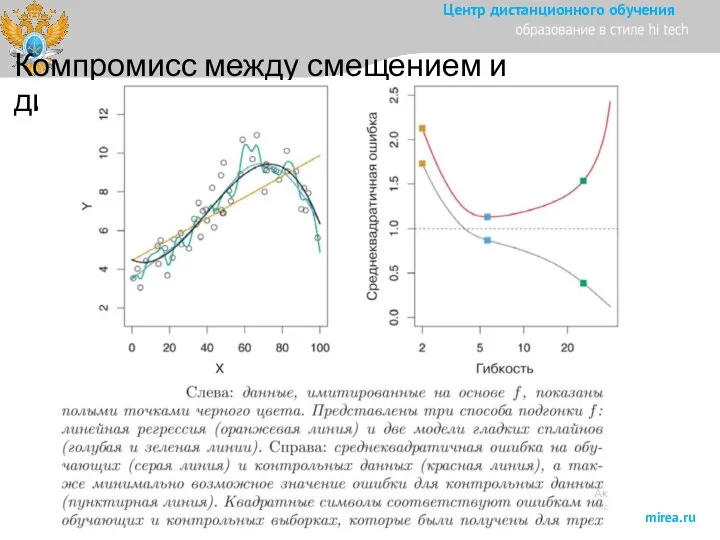

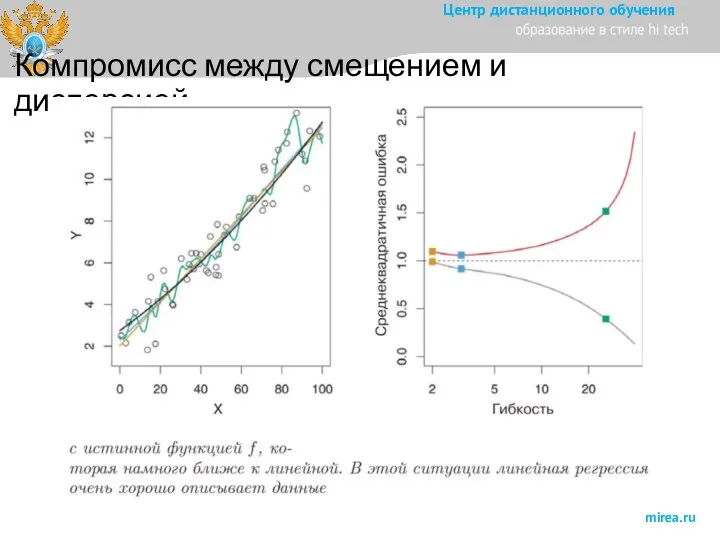

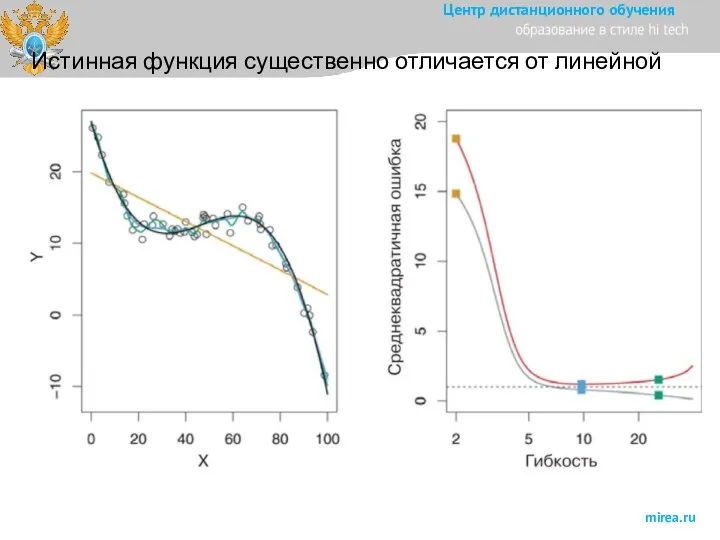

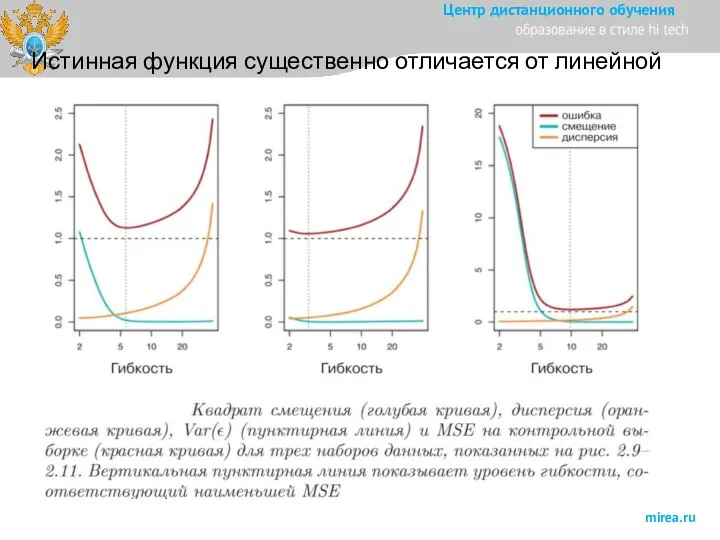

- 18. Истинная функция существенно отличается от линейной

- 19. Истинная функция существенно отличается от линейной

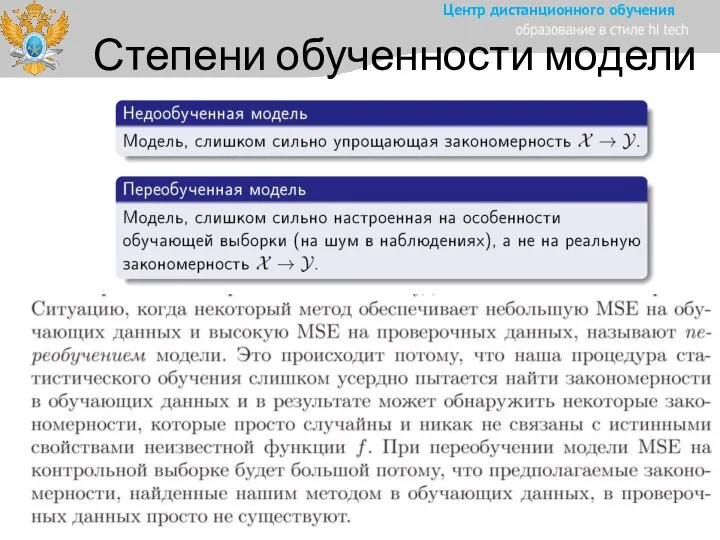

- 20. Степени обученности модели

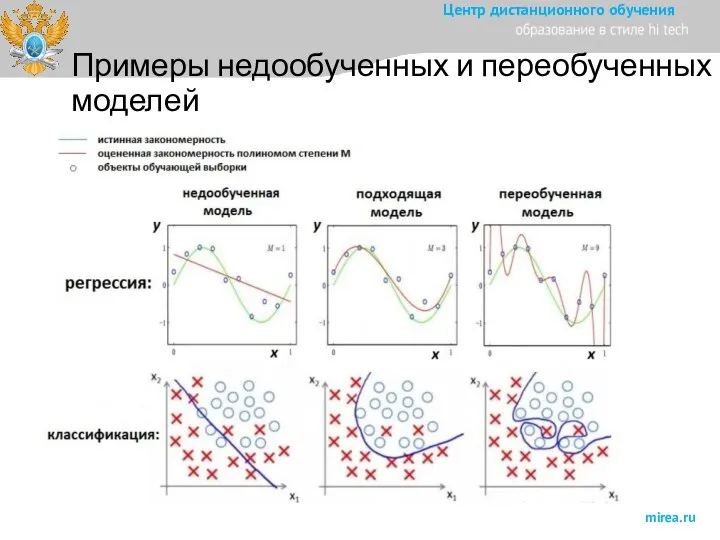

- 21. Примеры недообученных и переобученных моделей

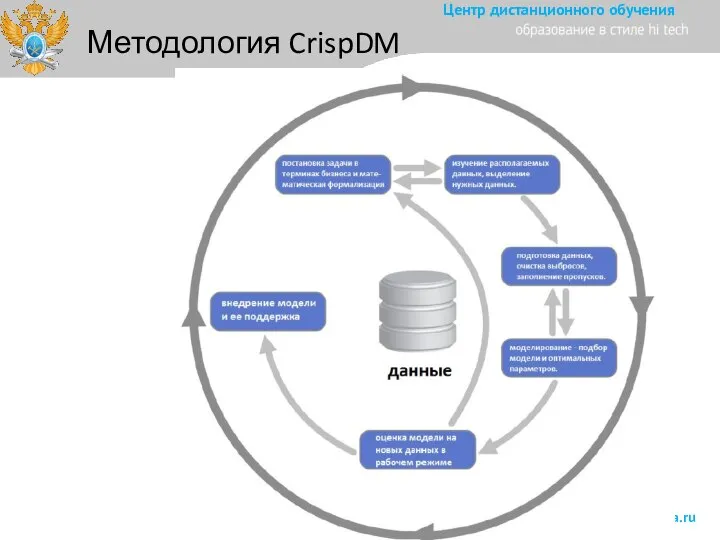

- 28. Методология CrispDM

- 31. Смещение, разброс, переобучение и недообучение. Переобучение (overfitting) – явление, когда ошибка на тестовой выборке заметно больше

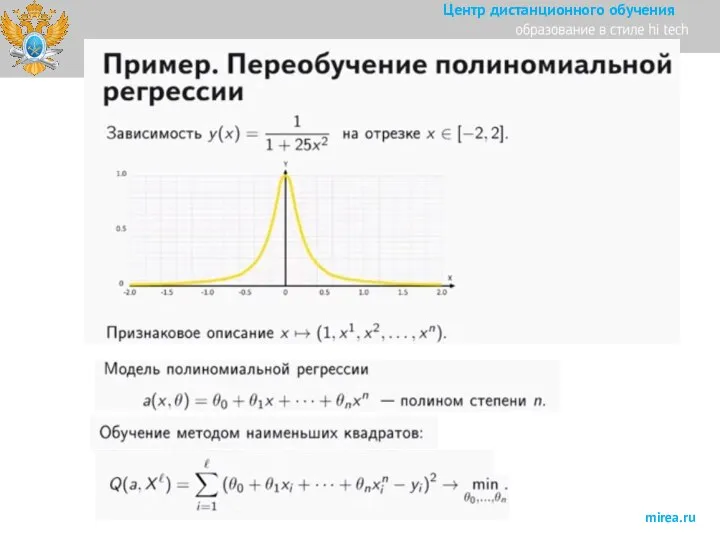

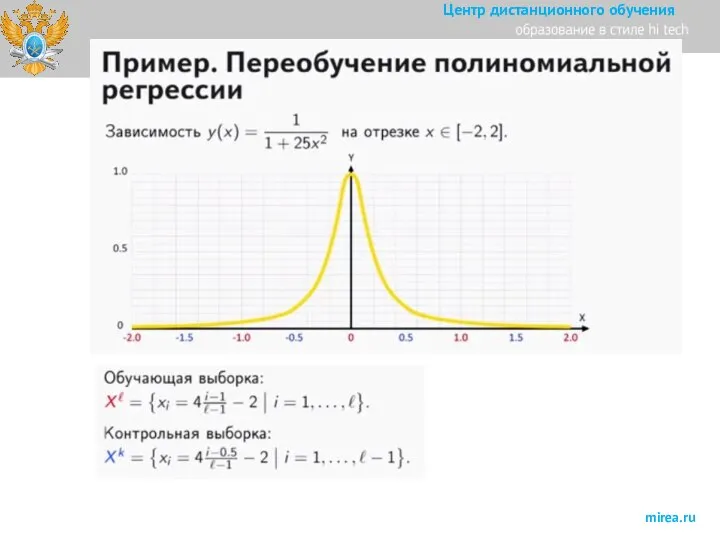

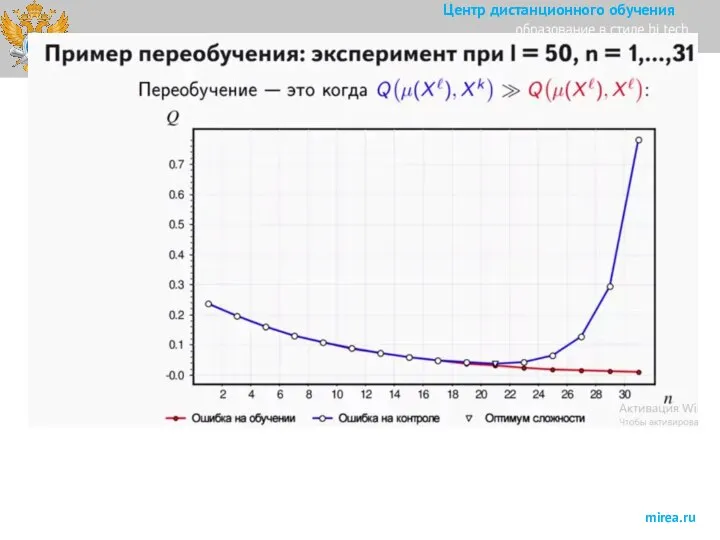

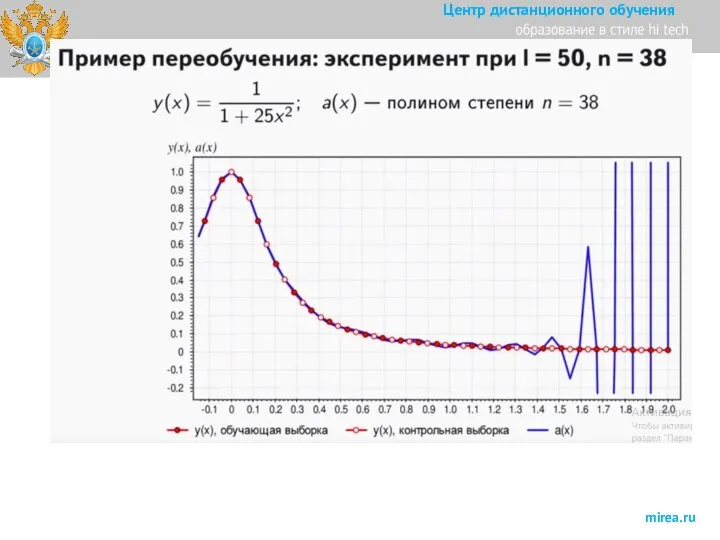

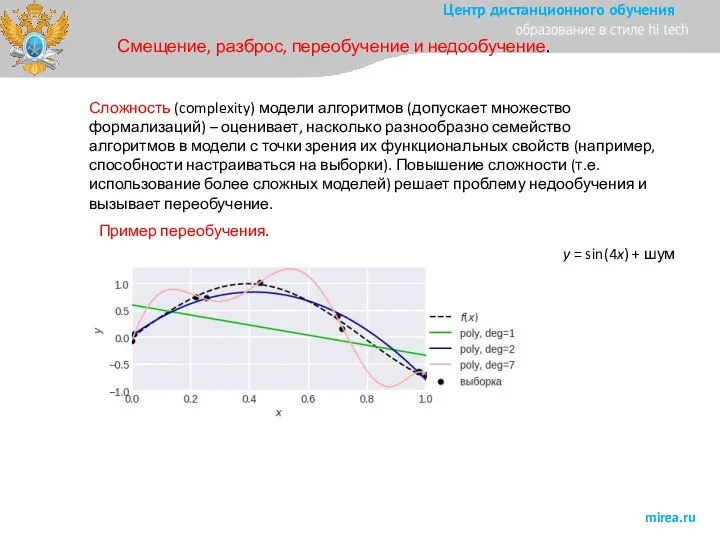

- 32. Смещение, разброс, переобучение и недообучение. Сложность (complexity) модели алгоритмов (допускает множество формализаций) – оценивает, насколько разнообразно

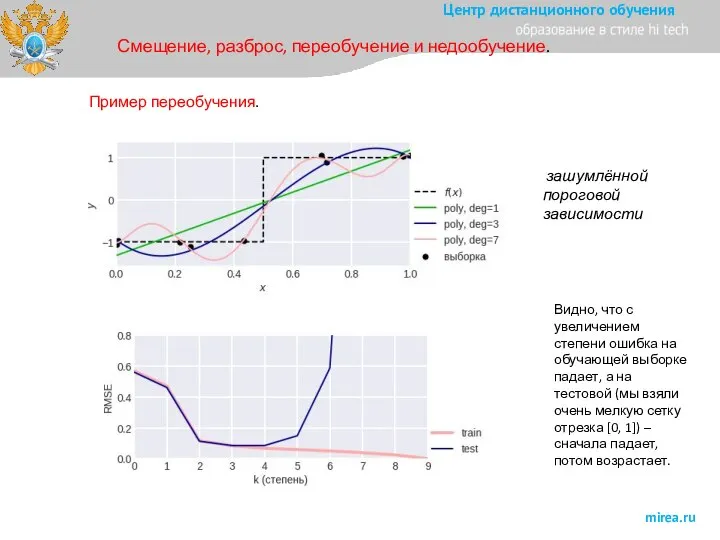

- 33. Смещение, разброс, переобучение и недообучение. Пример переобучения. зашумлённой пороговой зависимости Видно, что с увеличением степени ошибка

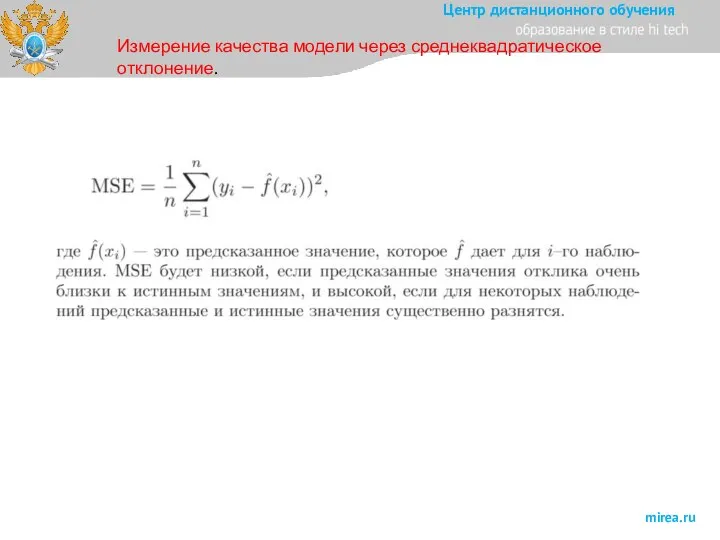

- 34. Измерение качества модели через среднеквадратическое отклонение.

- 35. Список литературы 1. Джеймс Г., Уиттон Д., Хасти Т., Тибширани Р . Введение в статистическое обучение

- 37. Скачать презентацию

Семь кошельков. Финансовая пирамида

Семь кошельков. Финансовая пирамида Программа мотивации 2019 год

Программа мотивации 2019 год Путинский рай - это туда... Севастополь вчера

Путинский рай - это туда... Севастополь вчера Службы интернета

Службы интернета тестирование смэв 2022

тестирование смэв 2022 Электронные таблицы

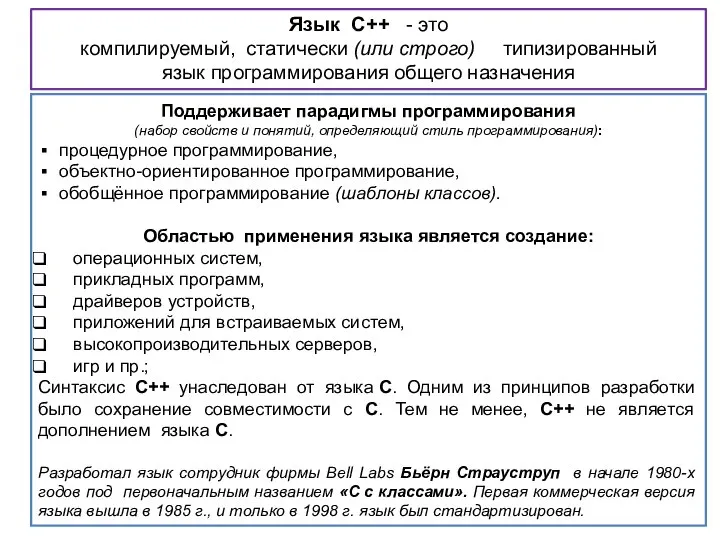

Электронные таблицы Язык С++

Язык С++ Проект Открытка в Scratch

Проект Открытка в Scratch Программные средства эконометрического анализа и прогнозирования

Программные средства эконометрического анализа и прогнозирования Элементарные логические операции

Элементарные логические операции ИТ автоматизации офиса

ИТ автоматизации офиса Моделирование в программе 123D Design Куржка

Моделирование в программе 123D Design Куржка Цифровой куратор

Цифровой куратор Информационная деятельность человека

Информационная деятельность человека Сортировка и поиск. Сортировка массивов. Внутренняя сортировка. Внешняя сортировка

Сортировка и поиск. Сортировка массивов. Внутренняя сортировка. Внешняя сортировка Инструкция по выполнению проекта (1)

Инструкция по выполнению проекта (1) Информация. Информационные процессы

Информация. Информационные процессы Обзор Gimp

Обзор Gimp Виртуальный 3D тур по школе, г. Бор

Виртуальный 3D тур по школе, г. Бор Инновационные англоязычные СМИ в Евросоюзе: роль и функции

Инновационные англоязычные СМИ в Евросоюзе: роль и функции Условный оператор if. 8 класс

Условный оператор if. 8 класс Определение количества информации

Определение количества информации LINQ. WinForms vs WPF. Лекция 10

LINQ. WinForms vs WPF. Лекция 10 XII международная конференция CEE-SECR / РАЗРАБОТКА ПО

XII международная конференция CEE-SECR / РАЗРАБОТКА ПО Формирование коммуникативно-языковой компетентности через внеурочные занятия по программе Hello English

Формирование коммуникативно-языковой компетентности через внеурочные занятия по программе Hello English Формы представления чисел в цифровых устройствах (лекция 3)

Формы представления чисел в цифровых устройствах (лекция 3) Психологическая помощь школьникам через социальную сеть

Психологическая помощь школьникам через социальную сеть Нейромережні архітектурні рішення побудови системи виявлення атак на комп’ютерну систему

Нейромережні архітектурні рішення побудови системи виявлення атак на комп’ютерну систему