Содержание

- 2. Под информацией в быту понимают любые сведения об окружающем мире и протекающих в нем процессах, воспринимаемые

- 3. Под информацией в технике понимают любые сообщения, которые зафиксированы в виде знаков и могут передаваться в

- 4. Под информацией в теории управления (менеджменте) понимают сообщения, уменьшающие существующую до этого неопределенность в той предметной

- 5. ключевые атрибуты информации. 1. Достоверность. информация свободна от ошибок, чьей-либо пристрастности и отражает истинное положение дел.

- 6. в узком смысле информацией можно назвать сведения о предметах, фактах, понятиях некоторой предметной области. С середины

- 7. информацию можно подразделить на: 1) структурную (или связанную) присущую объектам неживой и живой природы естественного или

- 8. Данные, знания Сведения, полученные путем измерения, наблюдения, логических или арифметических операций, и представленные в форме, пригодной

- 9. Свойства знаний 1. Внутренняя интерпретируемость знаний (понятность знания его носителю). 2. Структурированность знаний. Информационные единицы должны

- 10. Введение информации в научно-технический и хозяйственный оборот привело к необходимости ее количественной оценки, т.е. к введению

- 11. Пример 1. Как определить, какая из двух монет фальшивая, если на вид они одинаковы, но известно,

- 12. Понятие бита бит – это и двоичный знак, и единица измерения количества информации, определяемая как количество

- 13. Пример 2. А если монет 8? Тогда делим их на две равные части и взвешиваем их.

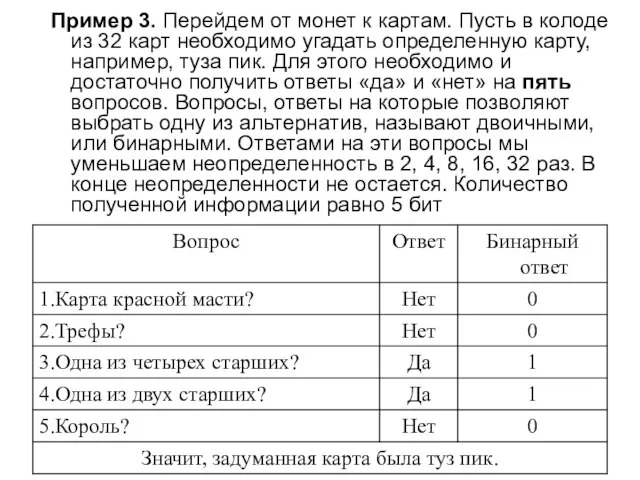

- 14. Пример 3. Перейдем от монет к картам. Пусть в колоде из 32 карт необходимо угадать определенную

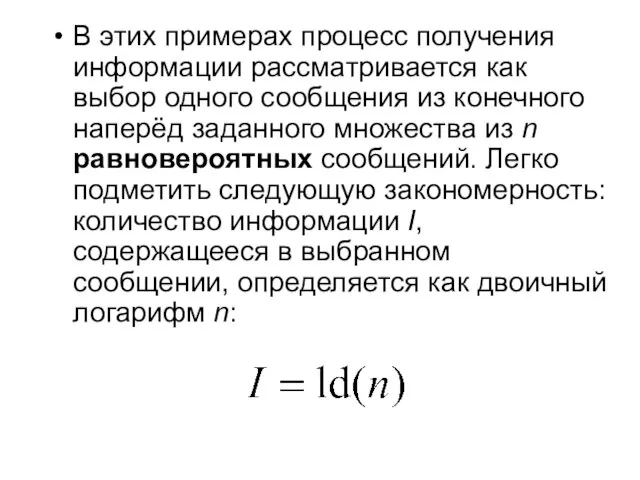

- 15. В этих примерах процесс получения информации рассматривается как выбор одного сообщения из конечного наперёд заданного множества

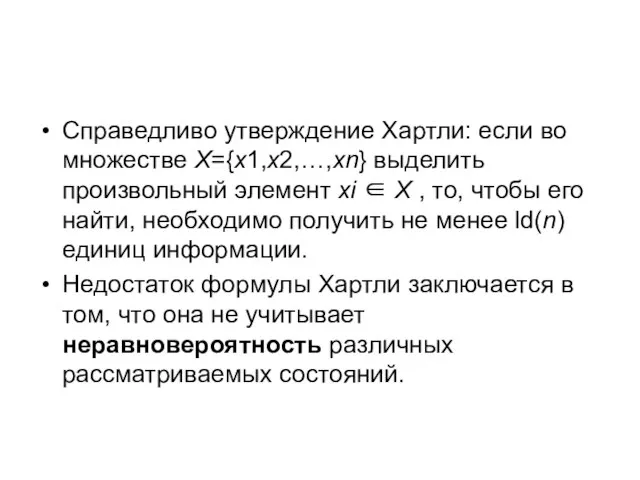

- 16. Справедливо утверждение Хартли: если во множестве X={x1,x2,…,xn} выделить произвольный элемент xi ∈ X , то, чтобы

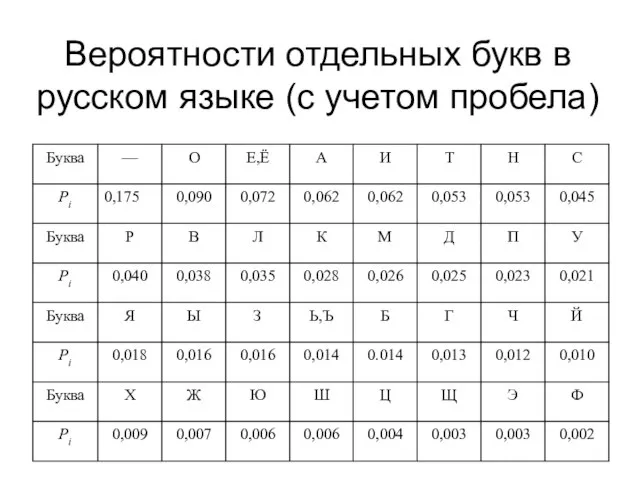

- 17. Вероятности отдельных букв в русском языке (с учетом пробела)

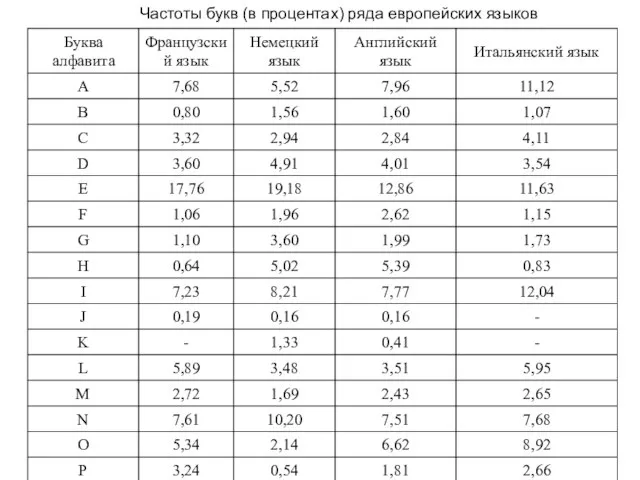

- 18. Частоты букв (в процентах) ряда европейских языков

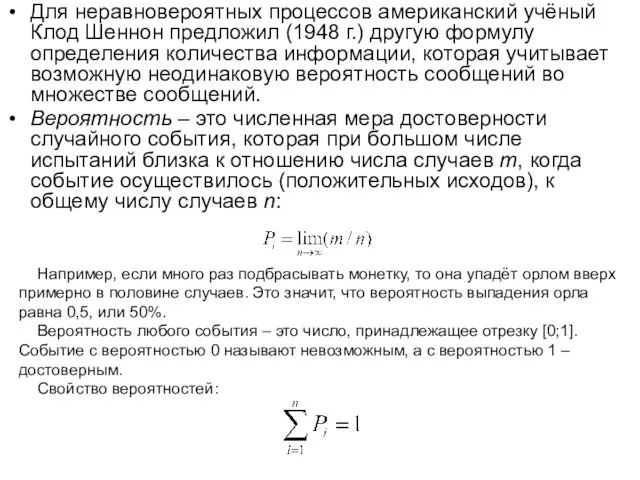

- 19. Для неравновероятных процессов американский учёный Клод Шеннон предложил (1948 г.) другую формулу определения количества информации, которая

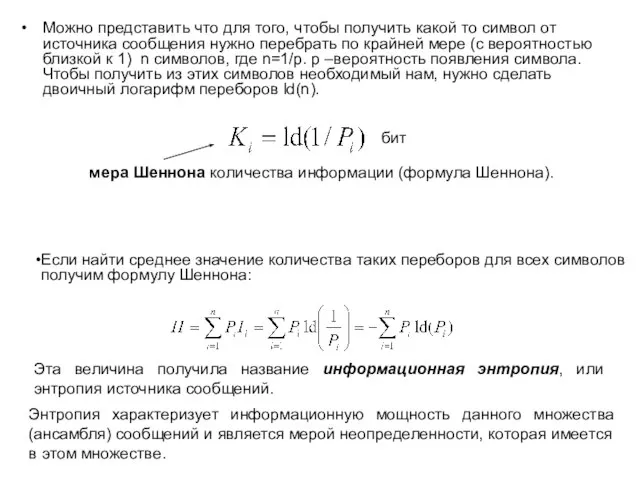

- 20. Можно представить что для того, чтобы получить какой то символ от источника сообщения нужно перебрать по

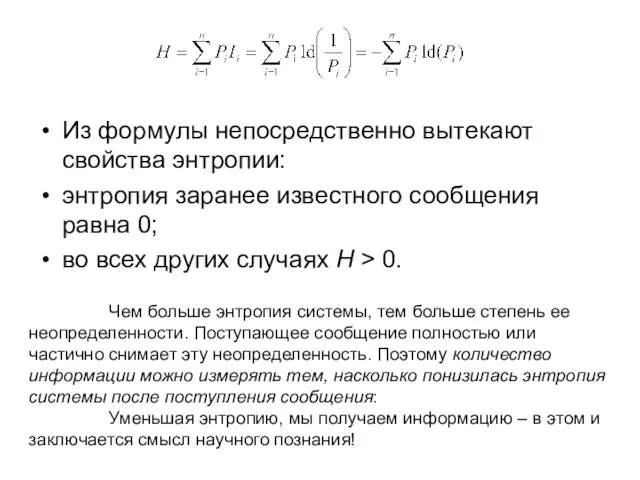

- 21. Из формулы непосредственно вытекают свойства энтропии: энтропия заранее известного сообщения равна 0; во всех других случаях

- 22. Кодирование источника сообщений Как уже отмечалось, результат одного отдельного альтернативного выбора может быть представлен как 0

- 23. Если количество символов представляет собой степень двойки (n = 2N) и все знаки равновероятны Pi =

- 24. Кодирование словами постоянной длины ld(7)≈2,807 и L=3. . Проведем кодирование, разбивая исходное множество знаков на равновероятные

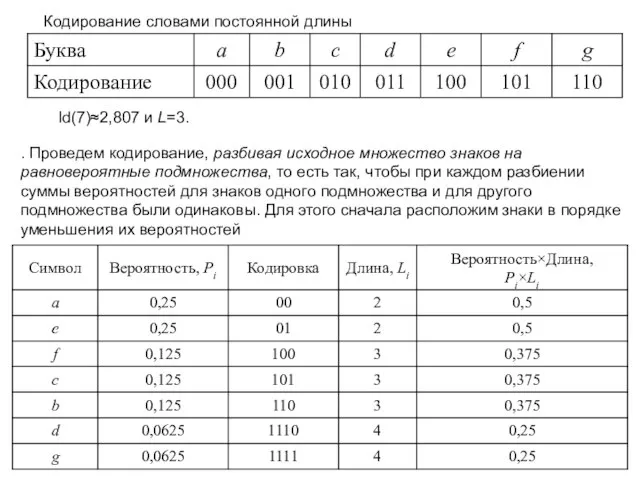

- 25. В общем случае алгоритм построения оптимального кода Шеннона-Фано выглядит следующим образом: 1. сообщения, входящие в ансамбль,

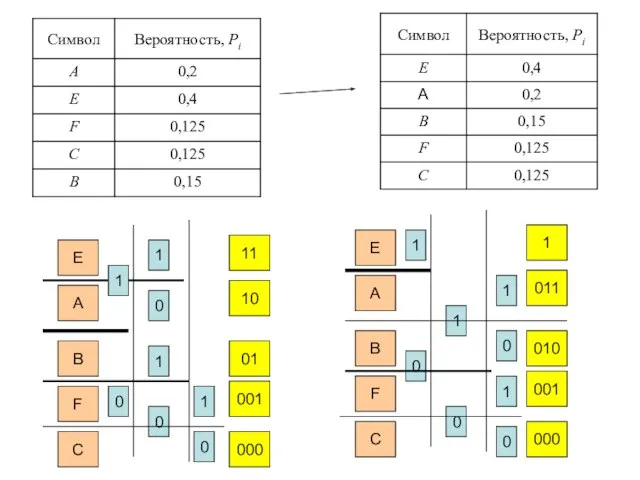

- 26. E A B F C 1 0 1 0 1 0 1 0 11 10 01

- 27. При неравномерном кодировании вводят среднюю длину кодировки, которая определяется по формуле В общем же случае связь

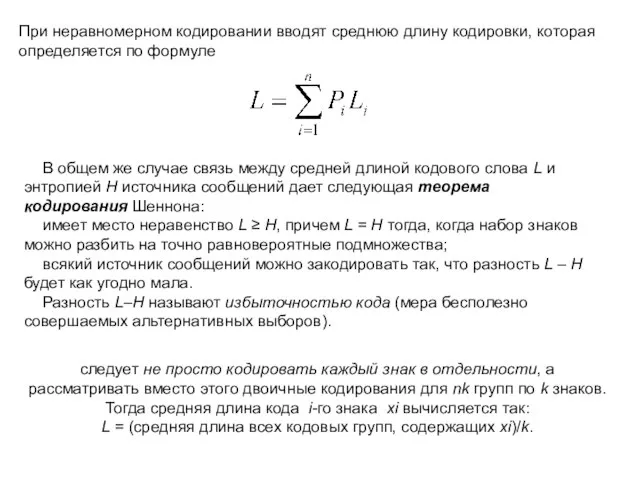

- 28. Средняя длина слова: L = 0,7+0,4+0,2=1,3. Среднее количество информации, содержащееся в знаке (энтропия): H = 0,7×ld(1/0,7)+0,2×ld(1/0,2)+0,1×ld(1/0,1)

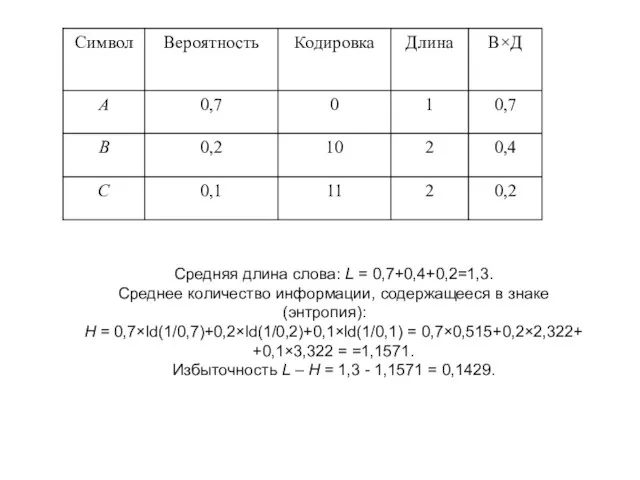

- 29. Кодирование пар Средняя длина кода одного знака равна 2,33/2=1,165 – уже ближе к энтропии. Избыточность равна

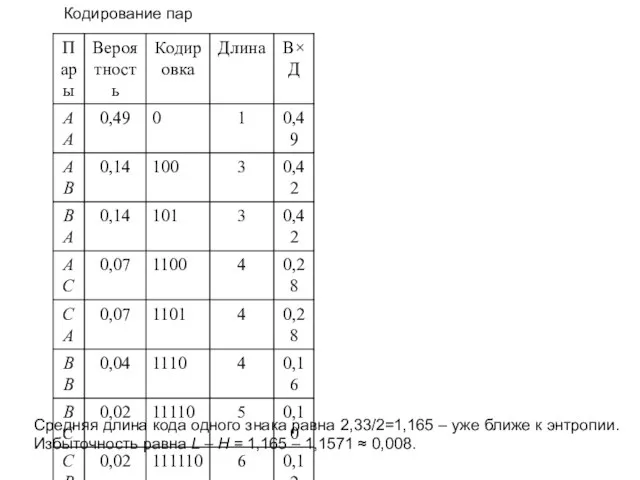

- 31. Скачать презентацию

Информационные технологии. (Лекция 7)

Информационные технологии. (Лекция 7) Автоматизированные системы обработки информации и управления

Автоматизированные системы обработки информации и управления Техническая грамотность (лекция 10)

Техническая грамотность (лекция 10) Алгоритмы и исполнители. Основы алгоритмизации. 8 класс

Алгоритмы и исполнители. Основы алгоритмизации. 8 класс Бизнес в стиле .RU. Управление и аналитика интернет-проекта

Бизнес в стиле .RU. Управление и аналитика интернет-проекта Цифровой волонтер ЛНР

Цифровой волонтер ЛНР Варианты получения информации

Варианты получения информации Что такое связи между таблицами

Что такое связи между таблицами Виды компьютерной графики

Виды компьютерной графики Операционная система

Операционная система Литературный обзор. Цитирование

Литературный обзор. Цитирование Сайт библиотеки, как инструмент в деятельности ШИБЦ для продвижения книги и чтения

Сайт библиотеки, как инструмент в деятельности ШИБЦ для продвижения книги и чтения 10-05-Кодирование текстовой информации (1)

10-05-Кодирование текстовой информации (1) Основы построения и функционирования

Основы построения и функционирования Безопасный Интернет

Безопасный Интернет Мы продаем качественный контакт с аудиторией

Мы продаем качественный контакт с аудиторией Линейный список в динамической памяти. Структура памяти языка Си

Линейный список в динамической памяти. Структура памяти языка Си Развитие систем подвижной связи к 5G

Развитие систем подвижной связи к 5G Многофункциональная электронная карта ОАО РЖД

Многофункциональная электронная карта ОАО РЖД Транспортный уровень (Transport)

Транспортный уровень (Transport) IComparable

IComparable Модели жизненного цикла разработки программного обеспечения

Модели жизненного цикла разработки программного обеспечения Определение PDO

Определение PDO What is computer?

What is computer? Масиви. Введення даних у масив

Масиви. Введення даних у масив Носители информации. Перфокарты

Носители информации. Перфокарты Определение идеи алгоритма, выбор методов решения и структур данных. Деревья

Определение идеи алгоритма, выбор методов решения и структур данных. Деревья 7-1-2

7-1-2