Содержание

- 2. Классификация мер информации Синтаксическая мера информации Семантическая мера информации Прагматическая мера информации

- 3. Единицы измерения информации 1 бит = кол-во двоичных цифр (0 и 1) Пример: код 11001011 имеет

- 4. Вероятностный подход События, о которых нельзя сказать произойдут они или нет, пока не будет осуществлен эксперимент,

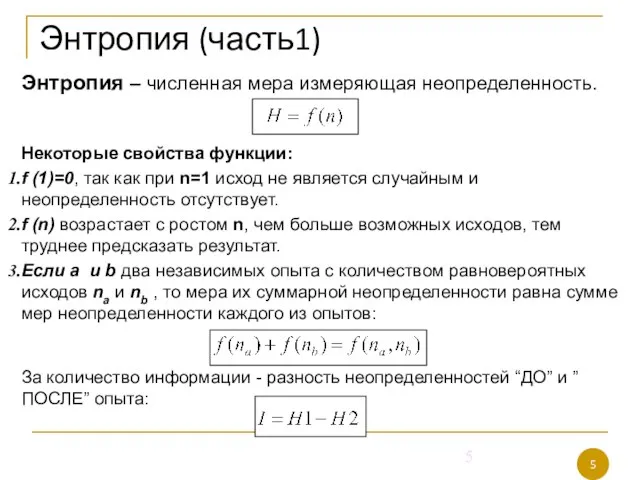

- 5. Энтропия (часть1) Энтропия – численная мера измеряющая неопределенность. Некоторые свойства функции: f (1)=0, так как при

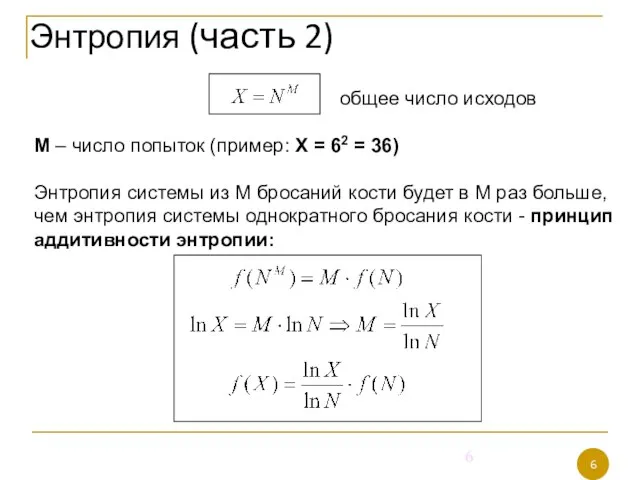

- 6. общее число исходов М – число попыток (пример: Х = 62 = 36) Энтропия системы из

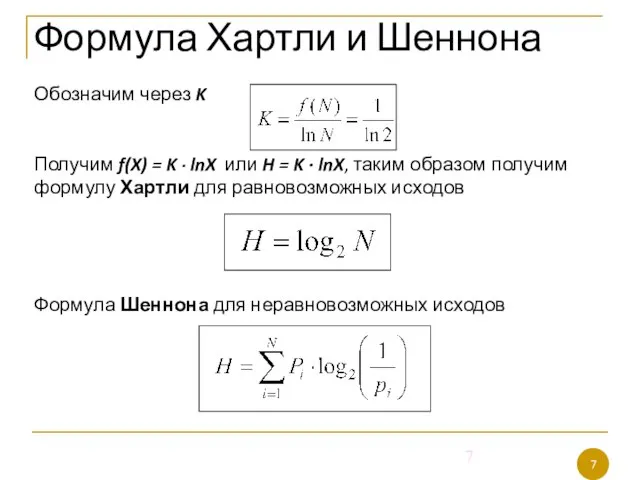

- 7. Обозначим через K Получим f(X) = K ∙ lnX или H = K ∙ lnX, таким

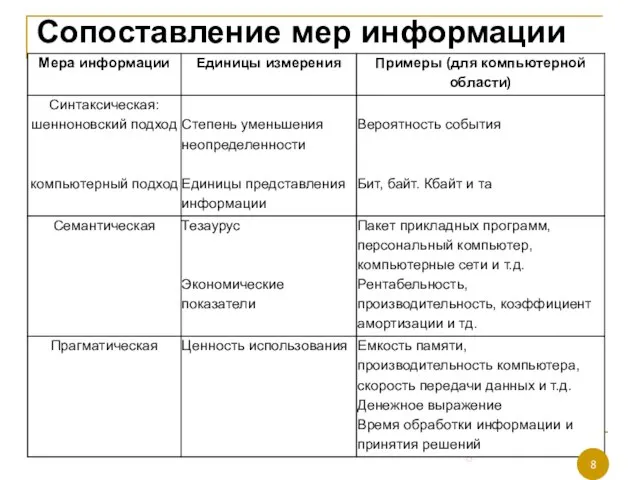

- 8. Сопоставление мер информации

- 9. Кодирование информации. Информатика

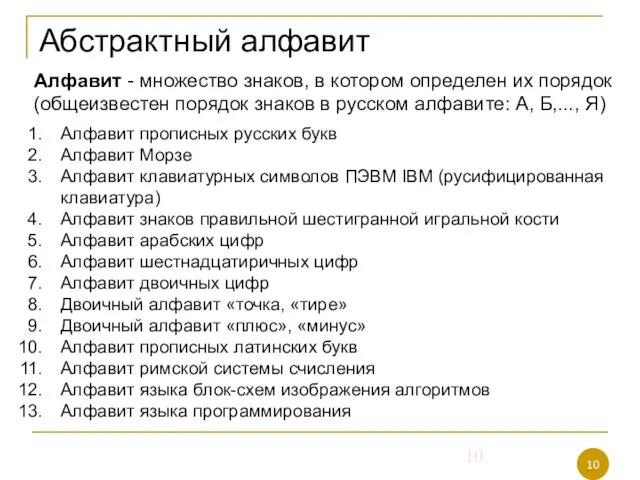

- 10. Абстрактный алфавит Алфавит - множество знаков, в котором определен их порядок (общеизвестен порядок знаков в русском

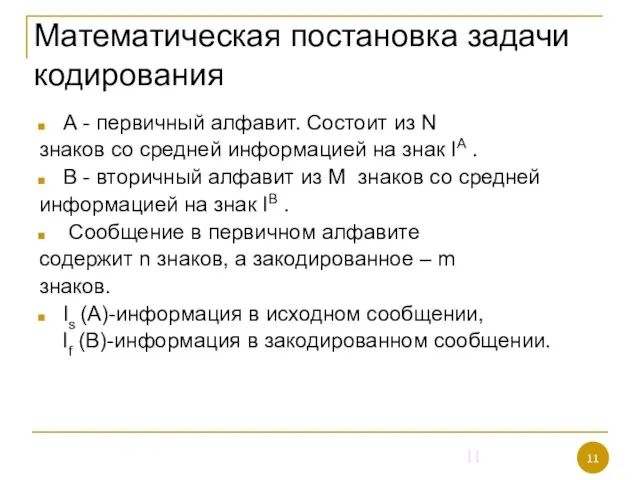

- 11. Математическая постановка задачи кодирования А - первичный алфавит. Состоит из N знаков со средней информацией на

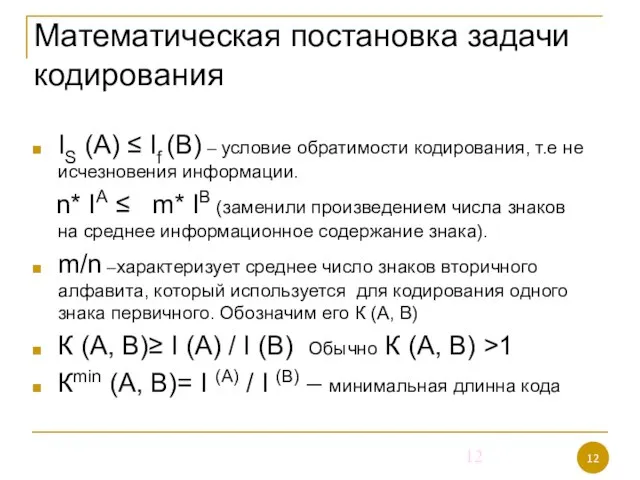

- 12. IS (A) ≤ If (B) – условие обратимости кодирования, т.е не исчезновения информации. n* IА ≤

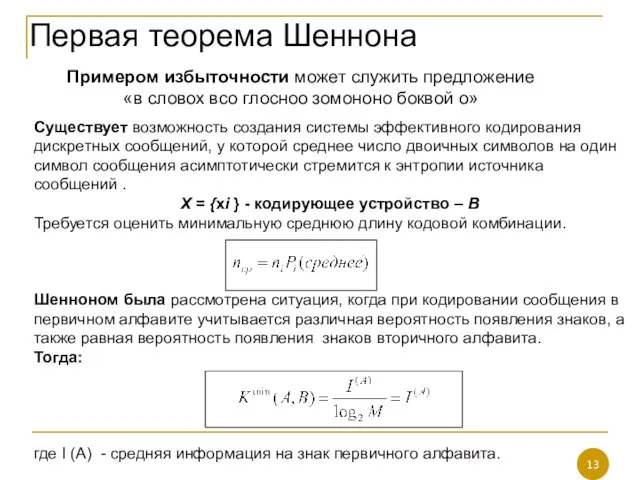

- 13. Первая теорема Шеннона Примером избыточности может служить предложение «в словох всо глосноо зомононо боквой о» Существует

- 14. Вторая теорема Шеннона При наличии помех в канале всегда можно найти такую систему кодирования, при которой

- 15. Вторая теорема Шеннона Это позволяет определять на приемной стороне канала, какому подмножеству принадлежит искаженная помехами принятая

- 17. Скачать презентацию

Презентация на тему Пищеварение в ротовой полости

Презентация на тему Пищеварение в ротовой полости  Межкультурная компетенция

Межкультурная компетенция Миссия бренда

Миссия бренда Виртуальные книжные выставки: особенность технологии создания

Виртуальные книжные выставки: особенность технологии создания Способы образования глаголов

Способы образования глаголов Этапы развития коммерческого права в России

Этапы развития коммерческого права в России Профессиональное определение и его факторы

Профессиональное определение и его факторы Электронный учебникКак понимать и как применять

Электронный учебникКак понимать и как применять Графическое решение физических задач

Графическое решение физических задач ДЗ Урок 1

ДЗ Урок 1 Big Apple International Group

Big Apple International Group Как приготовить манты

Как приготовить манты Диалекты в китайском языке

Диалекты в китайском языке СТРАТЕГИЧЕСКОЕ ПЛАНИРОВАНИЕ И УПРАВЛЕНИЕ РАЗВИТИЕМ ТЕРРИТОРИАЛЬНОЙ ЕДИНИЦЫБАЙДАКОВ СЕРГЕЙ ЛЬВОВИЧЗАМЕСТИТЕЛЬ МЭРА МОСКВЫ

СТРАТЕГИЧЕСКОЕ ПЛАНИРОВАНИЕ И УПРАВЛЕНИЕ РАЗВИТИЕМ ТЕРРИТОРИАЛЬНОЙ ЕДИНИЦЫБАЙДАКОВ СЕРГЕЙ ЛЬВОВИЧЗАМЕСТИТЕЛЬ МЭРА МОСКВЫ  Тесты по русскому языку №1

Тесты по русскому языку №1 Зонирование образовательного процесса: - зона двигательной активности - естественно научная зона - географическая зона

Зонирование образовательного процесса: - зона двигательной активности - естественно научная зона - географическая зона Презентация на тему Современные педагогические технологии

Презентация на тему Современные педагогические технологии Познавательные процессы (память)

Познавательные процессы (память) Ремкомплекты суппортов Moniva (страна-производитель Турция)

Ремкомплекты суппортов Moniva (страна-производитель Турция) Конституция - основной закон жизни

Конституция - основной закон жизни Птицы - наши друзья!

Птицы - наши друзья! Культура второй половины XX в

Культура второй половины XX в Требования к фасилитатору

Требования к фасилитатору Закон Российской Федерации о техническом регулировании и европейский подход

Закон Российской Федерации о техническом регулировании и европейский подход Ассорти по-русски

Ассорти по-русски Услышь меня. Мастер-класс

Услышь меня. Мастер-класс Серебряный век Русской литературы

Серебряный век Русской литературы Техническое обслуживанием ремонт трехфазных силовых трансформаторов

Техническое обслуживанием ремонт трехфазных силовых трансформаторов