Содержание

- 2. Наука исследования свойств знаков и систем Семиотика (греч. semeion – знак, признак) - наука, занимающаяся исследованием

- 3. Синтаксический уровень Идея: Это технические проблемы совершенствования методов передачи сообщений и их материальных носителей - сигналов.

- 4. Семантический уровень Идея: Проблемы связаны с формализацией и учетом смысла передаваемой информации. Проблемы этого уровня чрезвычайно

- 5. Прагматический уровень Идея: Проблемы этого уровня связаны с определением ценности и полезности информации для потребителя. Интересуют

- 6. Классификация мер информации Синтаксическая мера информации Семантическая мера информации Прагматическая мера информации

- 7. На синтаксическом уровне для измерения информации вводятся два параметра Синтаксическая мера информации Объем информации (объемный подход)

- 8. Объемный подход ( VД ) Идея: Если количество информации, содержащейся в сообщении из одного символа, принять

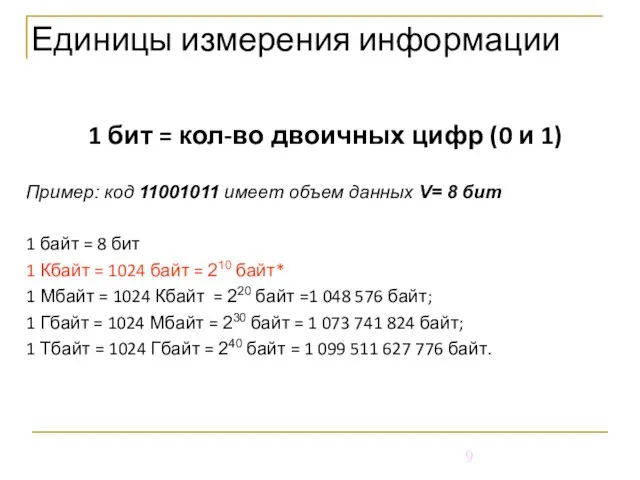

- 9. Единицы измерения информации 1 бит = кол-во двоичных цифр (0 и 1) Пример: код 11001011 имеет

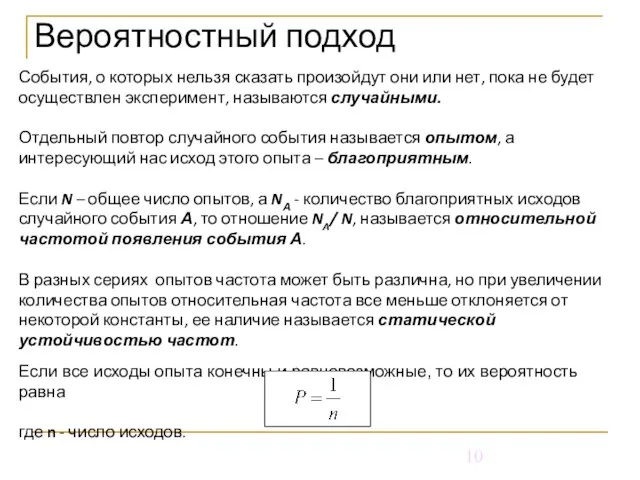

- 10. Вероятностный подход События, о которых нельзя сказать произойдут они или нет, пока не будет осуществлен эксперимент,

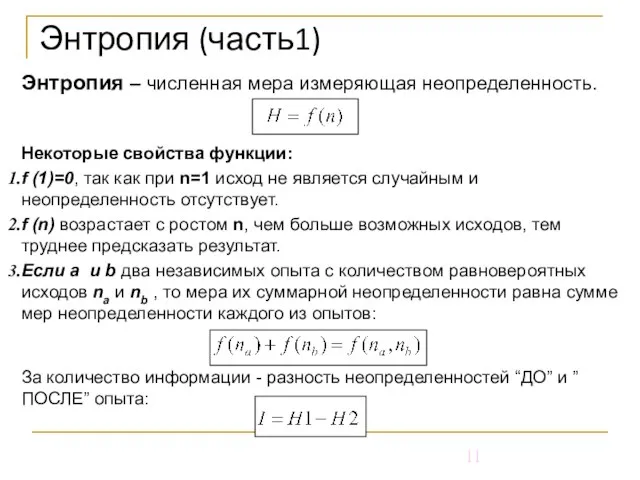

- 11. Энтропия (часть1) Энтропия – численная мера измеряющая неопределенность. Некоторые свойства функции: f (1)=0, так как при

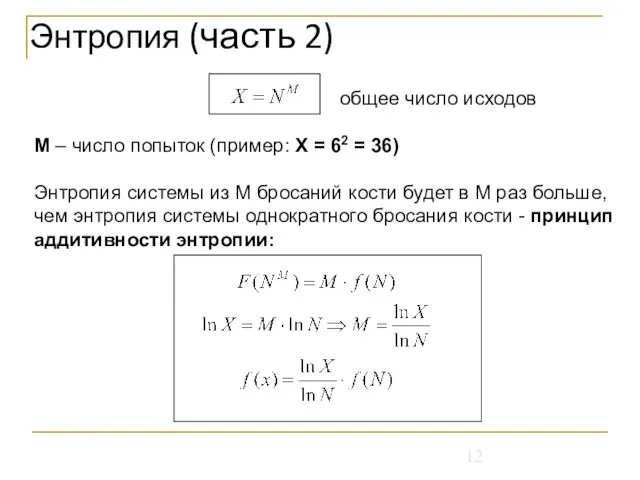

- 12. общее число исходов М – число попыток (пример: Х = 62 = 36) Энтропия системы из

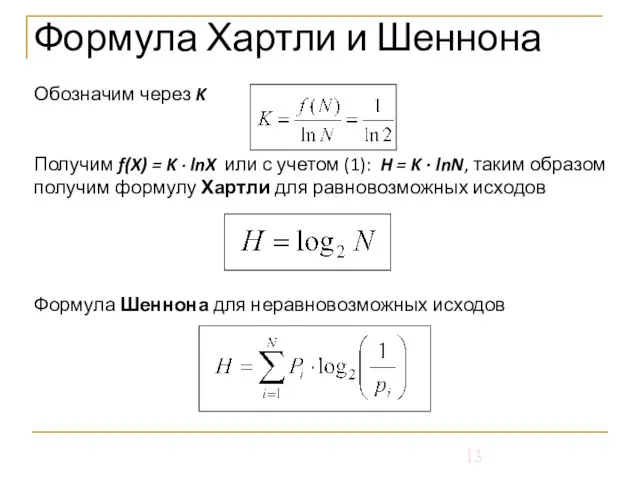

- 13. Обозначим через K Получим f(X) = K ∙ lnX или с учетом (1): H = K

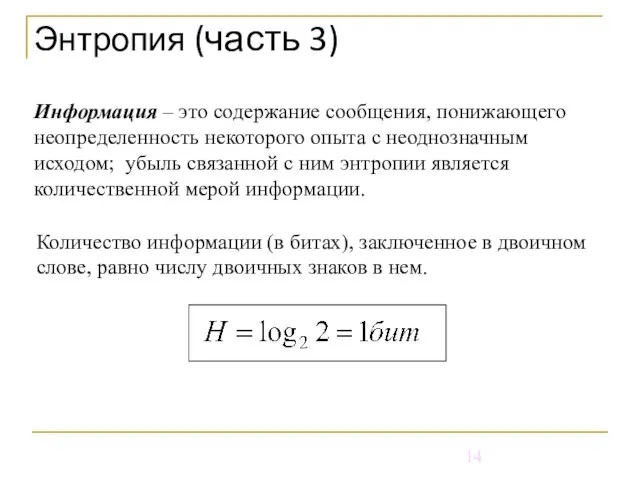

- 14. Количество информации (в битах), заключенное в двоичном слове, равно числу двоичных знаков в нем. Энтропия (часть

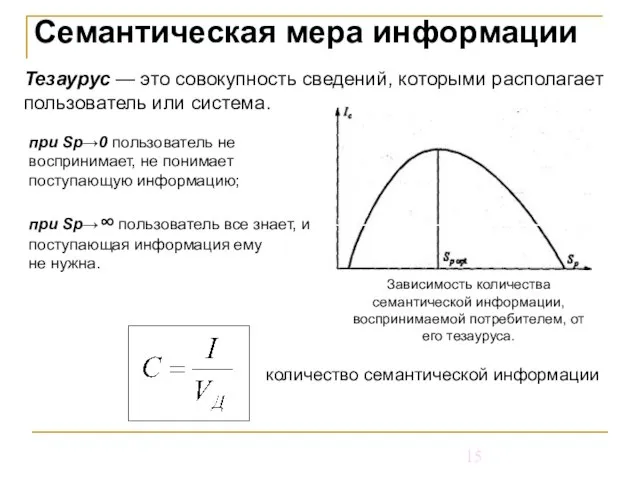

- 15. Семантическая мера информации Тезаурус — это совокупность сведений, которыми располагает пользователь или система. Зависимость количества семантической

- 16. Прагматическая мера информации Эта мера определяет полезность информации (ценность) для достижения пользователем поставленной цели. Эта мера

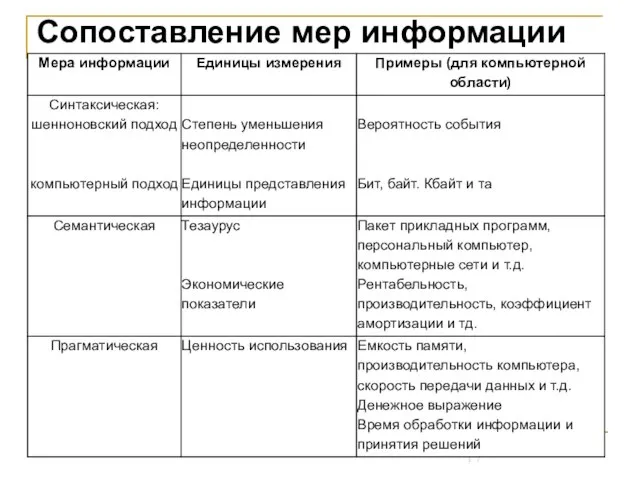

- 17. Сопоставление мер информации

- 18. Кодирование информации. Информатика

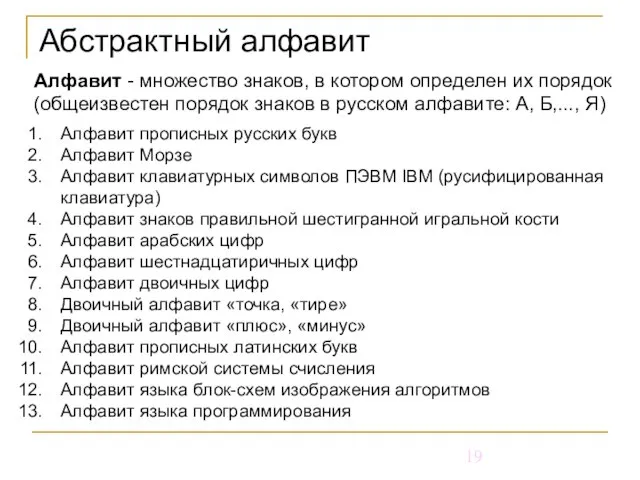

- 19. Абстрактный алфавит Алфавит - множество знаков, в котором определен их порядок (общеизвестен порядок знаков в русском

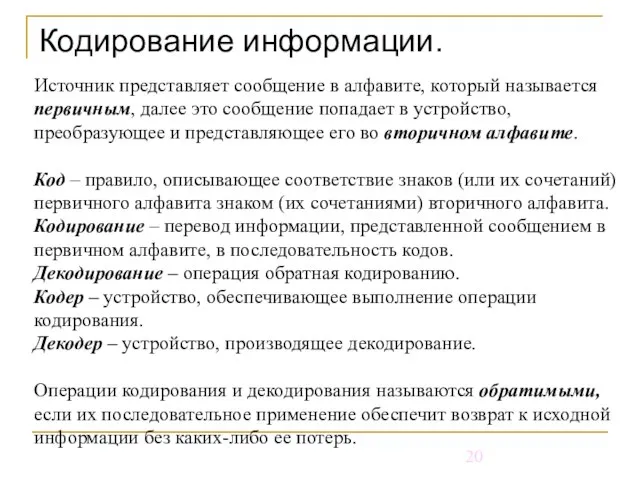

- 20. Кодирование информации. Источник представляет сообщение в алфавите, который называется первичным, далее это сообщение попадает в устройство,

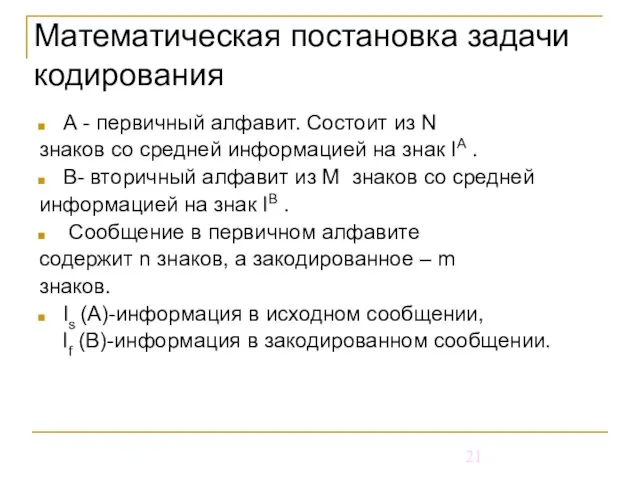

- 21. Математическая постановка задачи кодирования А - первичный алфавит. Состоит из N знаков со средней информацией на

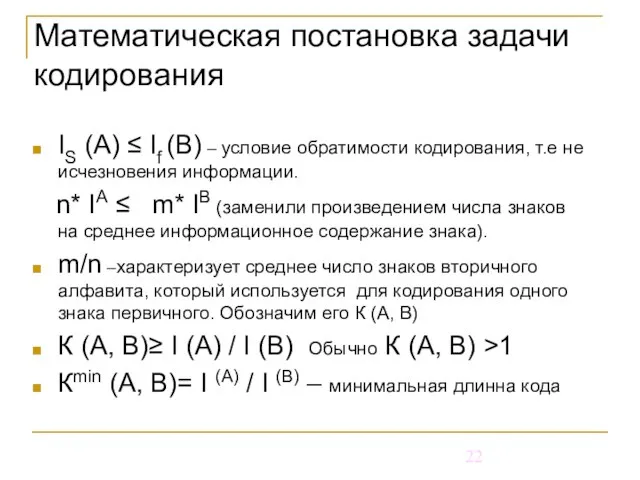

- 22. IS (A) ≤ If (B) – условие обратимости кодирования, т.е не исчезновения информации. n* IА ≤

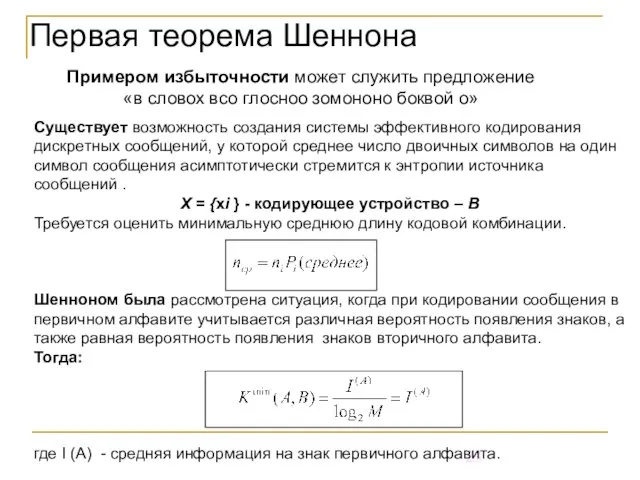

- 23. Первая теорема Шеннона Примером избыточности может служить предложение «в словох всо глосноо зомононо боквой о» Существует

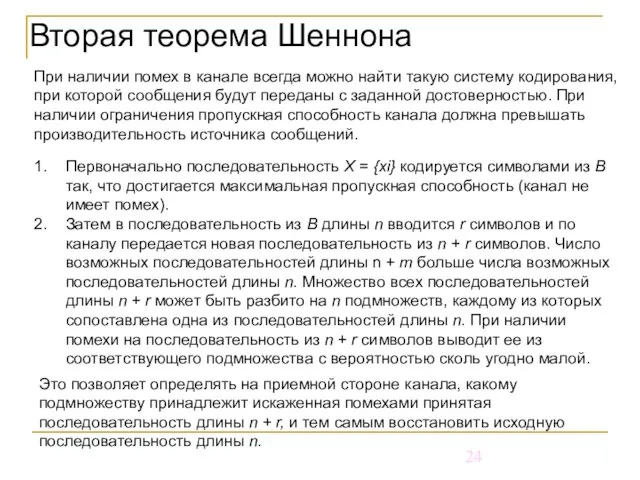

- 24. Вторая теорема Шеннона При наличии помех в канале всегда можно найти такую систему кодирования, при которой

- 25. Вторая теорема Шеннона Это позволяет определять на приемной стороне канала, какому подмножеству принадлежит искаженная помехами принятая

- 26. Вторая теорема Шеннона способ кодирования только устанавливает факт искажения сообщения, что позволяет потребовать повторную передачу; используемый

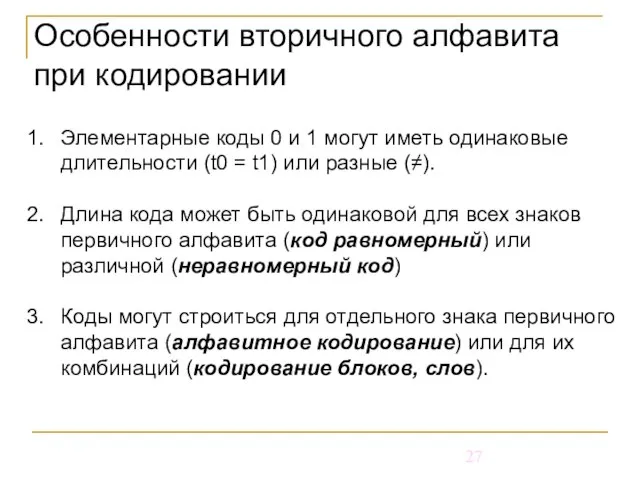

- 27. Особенности вторичного алфавита при кодировании Элементарные коды 0 и 1 могут иметь одинаковые длительности (t0 =

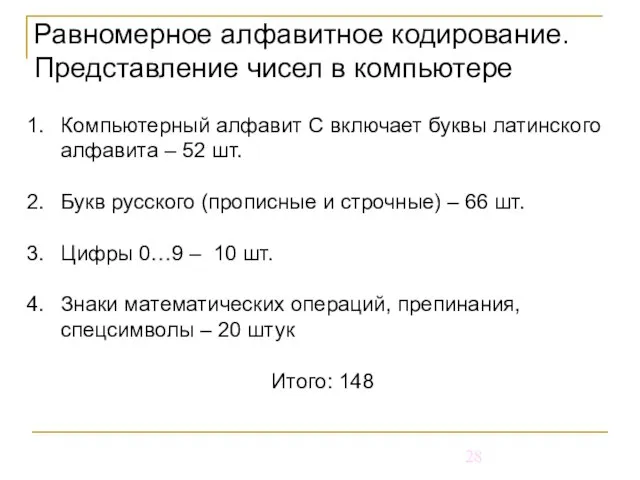

- 28. Равномерное алфавитное кодирование. Представление чисел в компьютере Компьютерный алфавит С включает буквы латинского алфавита – 52

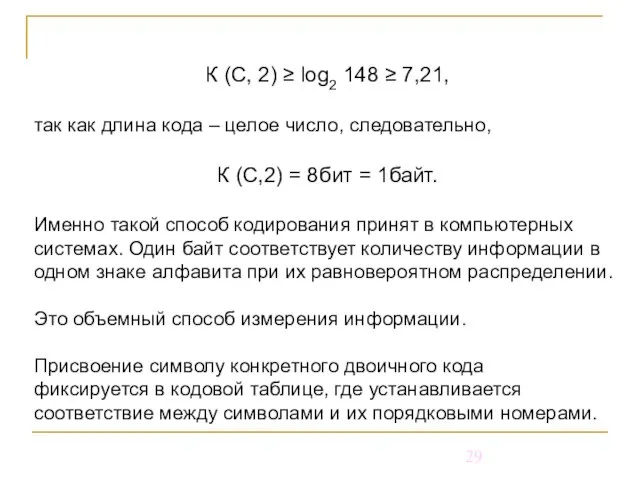

- 29. К (С, 2) ≥ log2 148 ≥ 7,21, так как длина кода – целое число, следовательно,

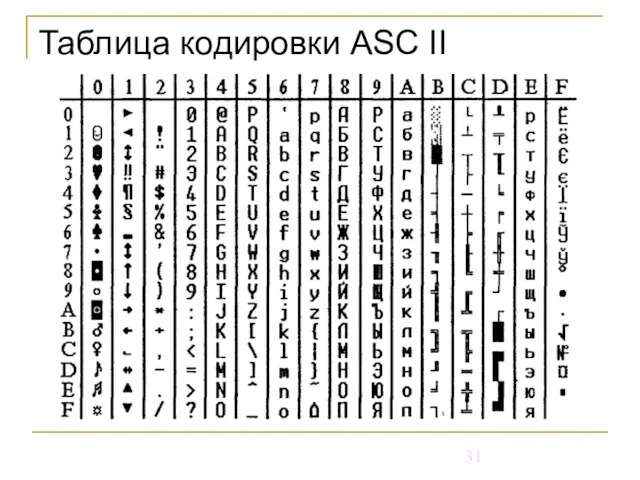

- 30. Таблицы кодировки Таблица, в которой устанавливается однозначное соответствие между символами и их порядковыми номерами, называется таблицей

- 31. Таблица кодировки ASC ІІ

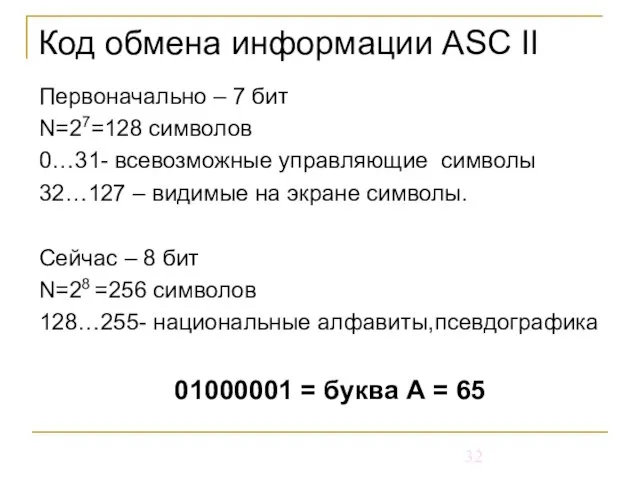

- 32. Код обмена информации ASC ІІ Первоначально – 7 бит N=27=128 символов 0…31- всевозможные управляющие символы 32…127

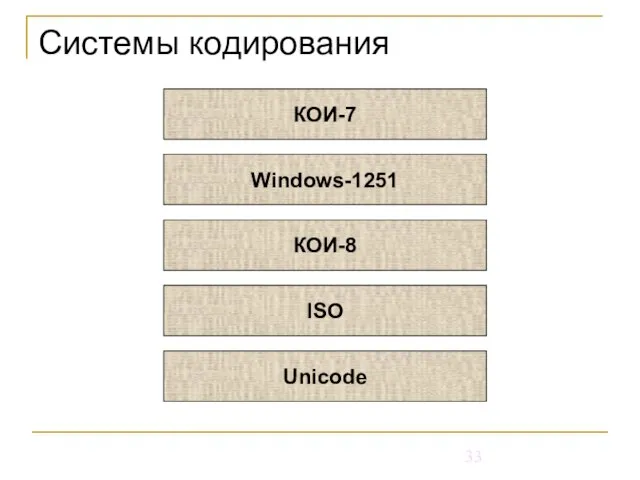

- 33. Системы кодирования КОИ-7 Windows-1251 КОИ-8 ISO Unicode

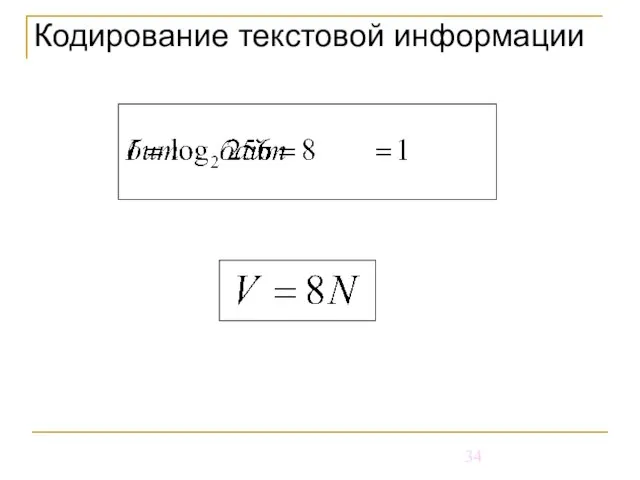

- 34. Кодирование текстовой информации

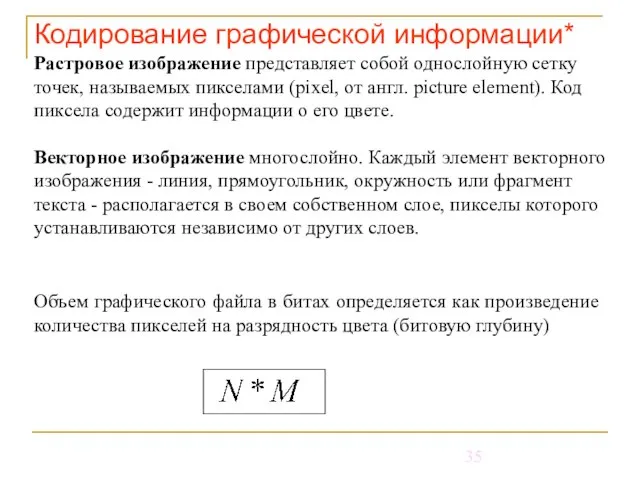

- 35. Кодирование графической информации* Растровое изображение представляет собой однослойную сетку точек, называемых пикселами (pixel, от англ. picture

- 36. Кодирование графической информации

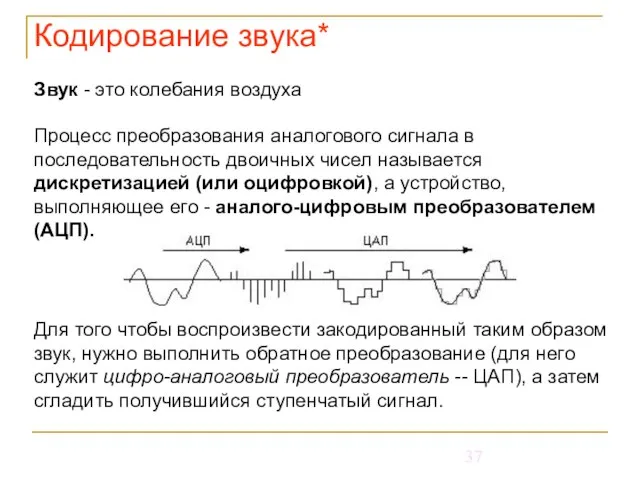

- 37. Кодирование звука* Звук - это колебания воздуха Процесс преобразования аналогового сигнала в последовательность двоичных чисел называется

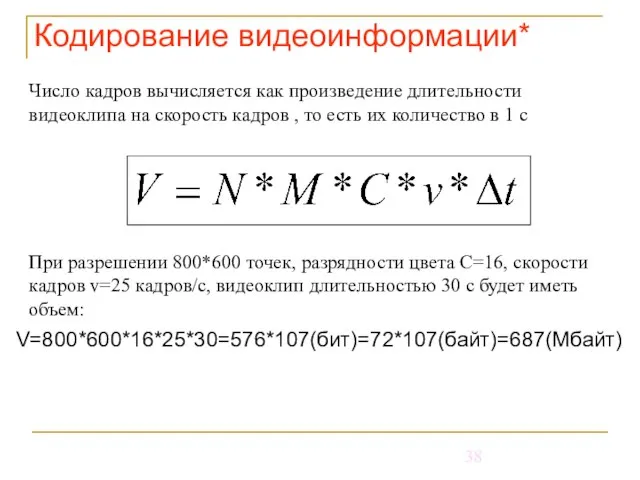

- 38. Кодирование видеоинформации* Число кадров вычисляется как произведение длительности видеоклипа на скорость кадров , то есть их

- 40. Скачать презентацию

Пейзаж – моё настроение

Пейзаж – моё настроение ОСНОВЫ УПРАВЛЕНИЯ

ОСНОВЫ УПРАВЛЕНИЯ ГЕОГРАФИЧЕСКО ПОЛОЖЕНИЕ, ОТКРЫТИЕ И ИССЛЕДОВАНИЕ АНТАРКТИДЫ Работу подготовила учитель географии МОУ СОШ №9 города Карабано

ГЕОГРАФИЧЕСКО ПОЛОЖЕНИЕ, ОТКРЫТИЕ И ИССЛЕДОВАНИЕ АНТАРКТИДЫ Работу подготовила учитель географии МОУ СОШ №9 города Карабано ЗАО «Метростандарт»

ЗАО «Метростандарт» Роль цианобактерий в развитии жизни на Земле

Роль цианобактерий в развитии жизни на Земле Развитие социальных инноваций в образовательной сфере

Развитие социальных инноваций в образовательной сфере Презентация показателей магазина по ул. Карла Маркса, 39

Презентация показателей магазина по ул. Карла Маркса, 39 НОВЫЕ ТРЕБОВАНИЯ НА РЫНКЕ ЛОГИСТИКИ ООО «Финтранс ГЛ»

НОВЫЕ ТРЕБОВАНИЯ НА РЫНКЕ ЛОГИСТИКИ ООО «Финтранс ГЛ» Исследователи южных материков

Исследователи южных материков Презентация на тему Православные иконы

Презентация на тему Православные иконы  АРХИТЕКТУРНЫЕ СТИЛИ

АРХИТЕКТУРНЫЕ СТИЛИ Презентация на тему Экономический рост

Презентация на тему Экономический рост Виды перевода:

Виды перевода: Опыт внедрения рейтинго – накопительной системы оценивания знаний учащихсяв преподавании истории.

Опыт внедрения рейтинго – накопительной системы оценивания знаний учащихсяв преподавании истории. Жидкие вещества

Жидкие вещества Кодекс ЧестиРоссийских пивоваров

Кодекс ЧестиРоссийских пивоваров Роль государства в создании условий для предпринимательской деятельности

Роль государства в создании условий для предпринимательской деятельности Возрастные периоды жизни человека

Возрастные периоды жизни человека Jeux Olympiques

Jeux Olympiques Докучаев Владислав

Докучаев Владислав Пираты 21 века

Пираты 21 века Музейный комплекс старинных народных ремесел и технологий

Музейный комплекс старинных народных ремесел и технологий В. А. Жукуовский

В. А. Жукуовский Корпоративная культура

Корпоративная культура Последний русский царь

Последний русский царь Методы управления проектами

Методы управления проектами  Учиться не только полезно, но и выгодно. ООО Адепт

Учиться не только полезно, но и выгодно. ООО Адепт Оценка достижения планируемых результатов в начальной школе

Оценка достижения планируемых результатов в начальной школе