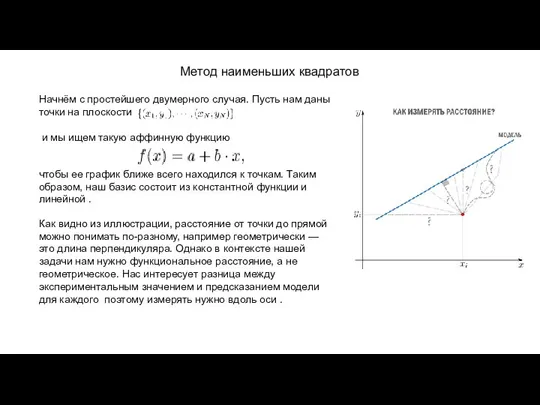

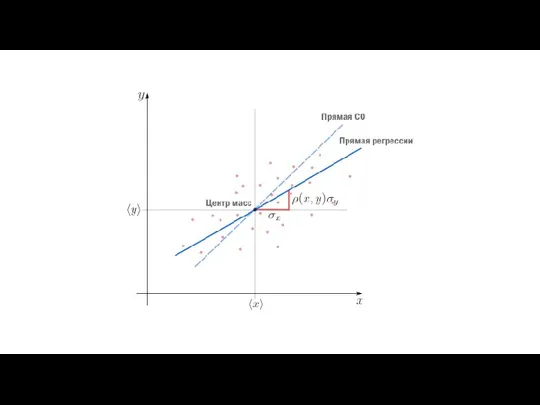

и мы ищем такую аффинную функцию

чтобы ее график ближе всего находился к точкам. Таким образом, наш базис состоит из константной функции и линейной .

Как видно из иллюстрации, расстояние от точки до прямой можно понимать по-разному, например геометрически — это длина перпендикуляра. Однако в контексте нашей задачи нам нужно функциональное расстояние, а не геометрическое. Нас интересует разница между экспериментальным значением и предсказанием модели для каждого поэтому измерять нужно вдоль оси .

Метод наименьших квадратов

Фесиваль-конкурс Вкус и польза постных блюд

Фесиваль-конкурс Вкус и польза постных блюд Город Тула

Город Тула Психологические последствия массовых коммуникаций

Психологические последствия массовых коммуникаций Час истории

Час истории Презентация на тему Сочинение описание животного (5 класс)

Презентация на тему Сочинение описание животного (5 класс) Битва за Москву

Битва за Москву Digital BTL: эффективность интерактивных каналов в BTL-акциях. - презентация

Digital BTL: эффективность интерактивных каналов в BTL-акциях. - презентация Сенсорная интеграция

Сенсорная интеграция Динамическая геометрия, Тихомирова С.В

Динамическая геометрия, Тихомирова С.В События, о которых помнит город и страна

События, о которых помнит город и страна Удивительный мир музыкальных образов

Удивительный мир музыкальных образов Субтропическая зона

Субтропическая зона Управление непрофильными активами

Управление непрофильными активами Практические аспекты обеспечения безопасности облачных вычислений

Практические аспекты обеспечения безопасности облачных вычислений Природоохранное законодательство штата Аляска:Требования для предприятий отрасли по разливам

Природоохранное законодательство штата Аляска:Требования для предприятий отрасли по разливам Цепи PEWAG для лесной техники Economy Plus Helt Perfekt STN Helt Perfekt Soft.

Цепи PEWAG для лесной техники Economy Plus Helt Perfekt STN Helt Perfekt Soft. Игра в имена

Игра в имена Презентация на тему История часов

Презентация на тему История часов Практика

Практика Ваши права и права других людей

Ваши права и права других людей ООО Центр развития ребенка Спектр. Подбор персонала

ООО Центр развития ребенка Спектр. Подбор персонала Социолингвистические особенности английского языка в арабских странах

Социолингвистические особенности английского языка в арабских странах ЭДЕКТРОДУГОВОЙ НАГРЕВ

ЭДЕКТРОДУГОВОЙ НАГРЕВ Моделирование влияния либерализации внешней торговли на благосостояние страны

Моделирование влияния либерализации внешней торговли на благосостояние страны Внутренние причины наиболее стойких мотиваций поведения

Внутренние причины наиболее стойких мотиваций поведения Иркутский государственный университет. Кафедра романо-германской филологии

Иркутский государственный университет. Кафедра романо-германской филологии Тема: Таблица единиц времени.

Тема: Таблица единиц времени. Информация о приеме в Вятский государственный университет в 2021 г

Информация о приеме в Вятский государственный университет в 2021 г