Слайд 2Виды обучения

Обучение с учителем (supervised learning) – есть размеченные данные (для каждого

примера есть «решение или метка класса»)

С частичным привлечением учителя (semi-supervised learning) – для части прецедентов задается пара «ситуация, решение», а для части - только «ситуация»

Обучение без учителя (unsupervised learning) – есть неразмеченные данные («ситуация»), требуется сгруппировать объекты

Слайд 3Виды обучения

Обучение с подкреплением (reinforcement learning) – есть размечаемые данные («ситуация, предполагаемое

решение»). Алгоритм обучения работает через вознаграждение за правильное решение или наказание за неправильное.

Слайд 5Признаки

Исходные

Производные

Агрегированные – показатели, определенные по группе (сумма, среднее, минимум, максимум)

Индикаторы – наличие

или отсутствие характеристики

Отношения – взаимосвязь между двумя или более значениями данных

Отображения – преобразование непрерывных в категориальные

Слайд 6Извлечение признаков

Тексты – это токенизация

Изображения – извлечение краев и цветовые пятна

Дата и

время – полезно вычленить выходные и праздники, дни недели

Местоположение (адрес или координаты) - извлечь плотность, средний доход по району

Номер телефона – регион и оператор связи

Лаги по времени. Окно 3-7 последовательностей

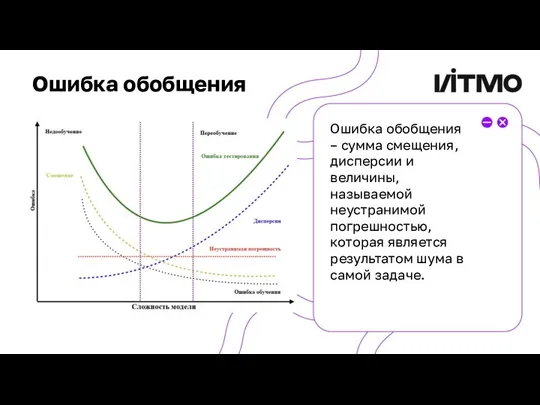

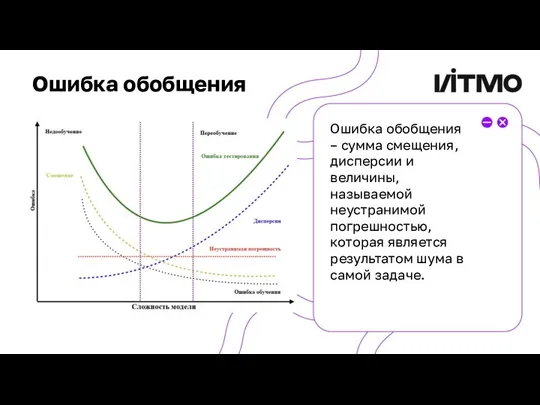

Слайд 7Ошибка обобщения

Ошибка обобщения – сумма смещения, дисперсии и величины, называемой неустранимой погрешностью,

которая является результатом шума в самой задаче.

Слайд 8Сложность

количество настраиваемых параметров архитектуры модели, другими словами, сложность модели определяет ее информационную

емкость. При увеличении сложности модели происходит уменьшение смещения и увеличение разброса.

Слайд 9Недообучение

Недообучение (underfitting) – когда модель, построенная с помощью алгоритма, является слишком упрощенной,

чтобы представлять базовую взаимосвязь между признаками и классом в обучающей выборке.

Это явление можно заметить по большой ошибке на обучающей выборке (еще говорят, что «не удаётся настроиться на выборку»). Помимо простоты модели, недообучение может возникать еще и из-за малого количества эпох обучения.

Слайд 10Переобучение

Переобучение (overfitting) – когда модель, построенная с помощью алгоритма, настолько сложна, что

модель слишком точно приближает обучающую выборку и становится чувствительной к шуму.

Это явление можно заметить по увеличивающейся разнице между ошибкой на обучающей выборке и тестовой выборке с каждой эпохой обучения. Поэтому при обучении строится график изменения ошибки на обучающей и тестовой выборках. Переобученная модель обладает низкой обобщающей способностью, в эксплуатации она будет часто ошибаться.

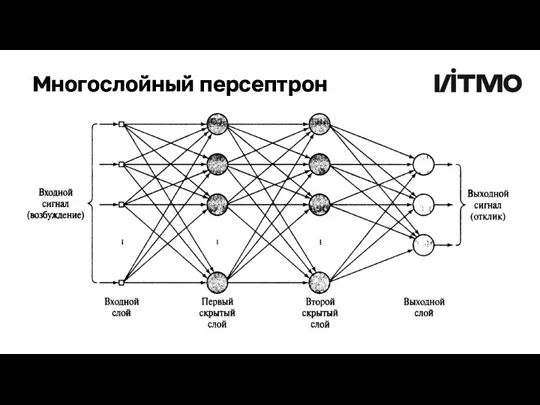

Слайд 11Нейросети по характеру связей

Прямого распространения

Обратного распространения, или рекуррентные

Радиально-базисные функции

Самоорганизующиеся

Слайд 12Кросс-валидация (скользящий контроль)

Метод отложенных данных (holdout method) – разделение 70-30 или 60-40

или 80-20.

Оценка ошибки близка к ошибке модели на новых данных, но сильно зашумлена.

Для борьбы с шумом многократно случайно разделяют обучающую и тестовую выборку, параметр ошибки при этом усредняют.

Но в процессе итераций каждая точка данных будет попадать в тестовое подмножество различное число раз, что может привести к смещению оценки.

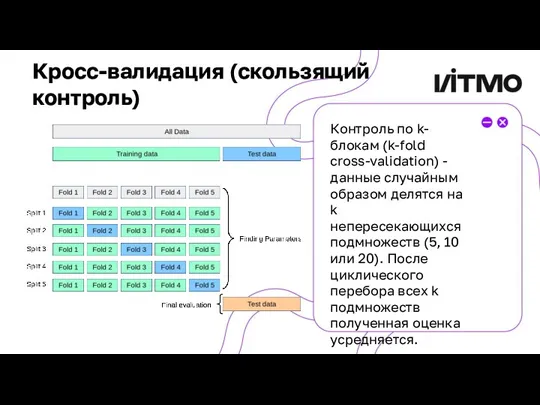

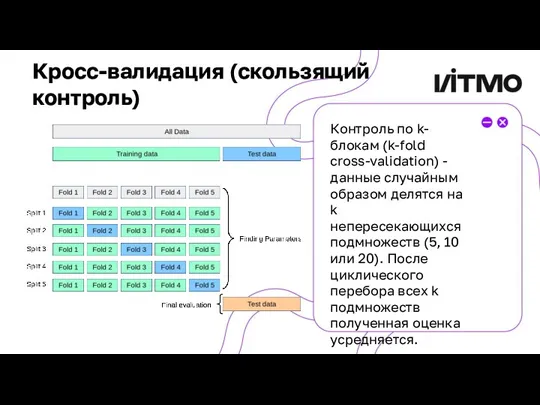

Слайд 13Кросс-валидация (скользящий контроль)

Контроль по k-блокам (k-fold cross-validation) - данные случайным образом делятся

на k непересекающихся подмножеств (5, 10 или 20). После циклического перебора всех k подмножеств полученная оценка усредняется.

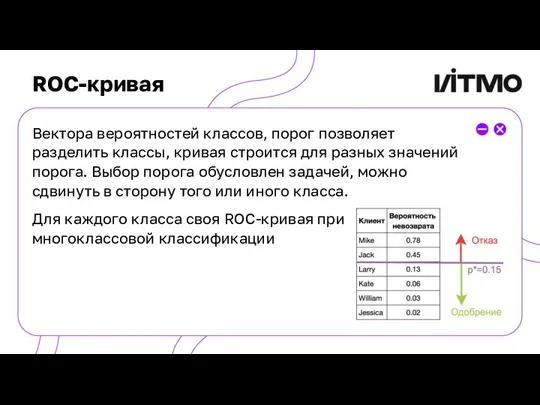

Слайд 17ROC-кривая

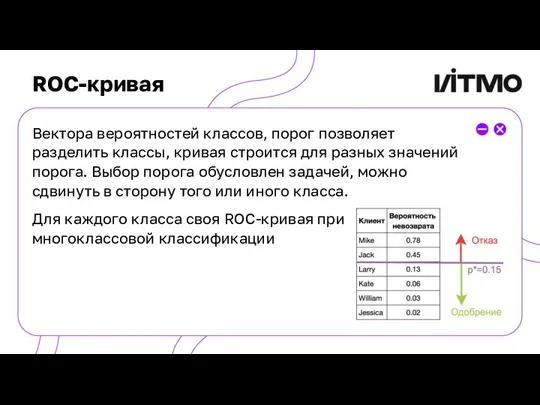

Вектора вероятностей классов, порог позволяет разделить классы, кривая строится для разных значений

порога. Выбор порога обусловлен задачей, можно сдвинуть в сторону того или иного класса.

Для каждого класса своя ROC-кривая при многоклассовой классификации

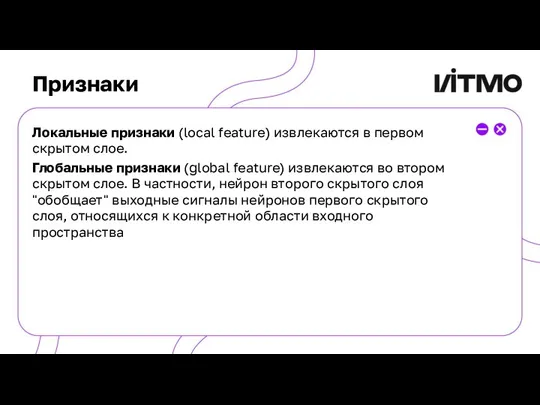

Слайд 27Признаки

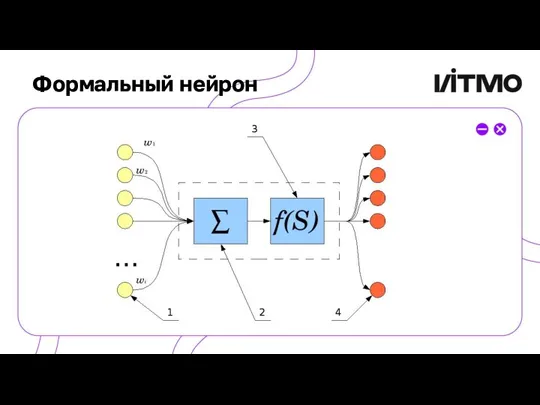

Локальные признаки (local feature) извлекаются в первом скрытом слое.

Глобальные признаки (global

feature) извлекаются во втором скрытом слое. В частности, нейрон второго скрытого слоя "обобщает" выходные сигналы нейронов первого скрытого слоя, относящихся к конкретной области входного пространства

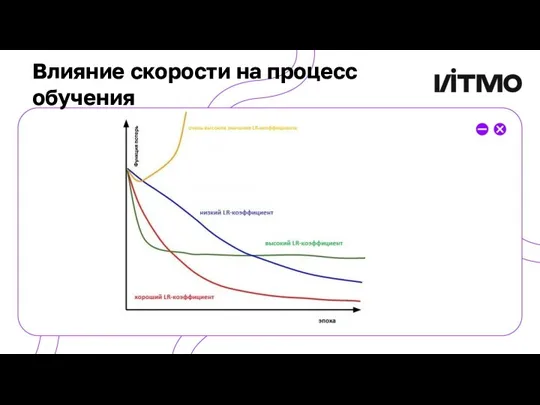

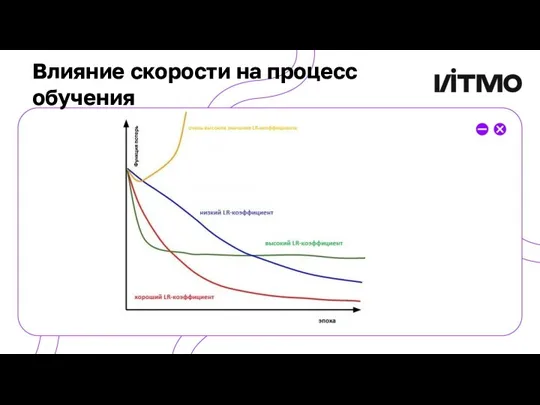

Слайд 32Влияние скорости на процесс обучения

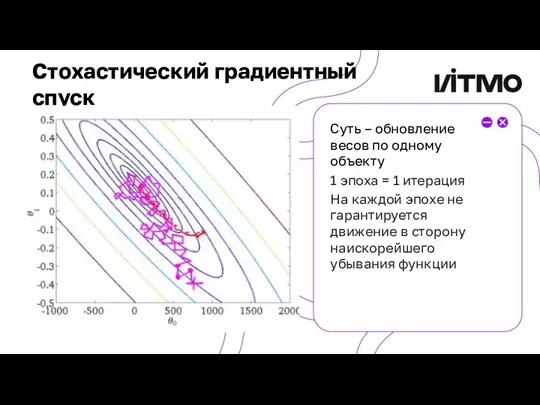

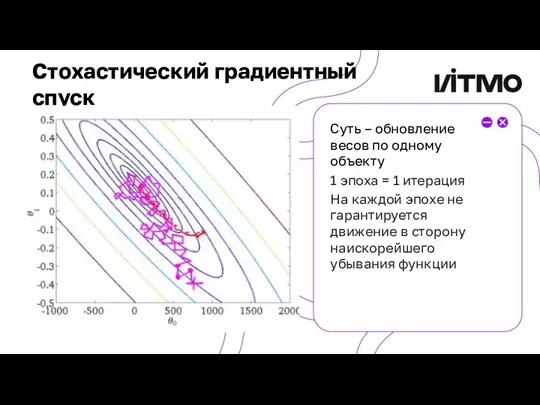

Слайд 43Стохастический градиентный спуск

Суть – обновление весов по одному объекту

1 эпоха = 1

итерация

На каждой эпохе не гарантируется движение в сторону наискорейшего убывания функции

Приорлайф - корпоративные программы для ЮЛ

Приорлайф - корпоративные программы для ЮЛ Василий Макарович ШукшинПисатель. Актёр. Режиссер.

Василий Макарович ШукшинПисатель. Актёр. Режиссер. Презентация на тему ФУНКЦИОНАЛЬНЫЕ СТИЛИ РУССКОГО ЛИТЕРАТУРНОГО ЯЗЫКА

Презентация на тему ФУНКЦИОНАЛЬНЫЕ СТИЛИ РУССКОГО ЛИТЕРАТУРНОГО ЯЗЫКА  IR программа POST IPO

IR программа POST IPO Мир систем координат

Мир систем координат О жизни и творчестве С.Я. Маршака

О жизни и творчестве С.Я. Маршака Тамбовский филиал РАНХиГС, для абитуриентов

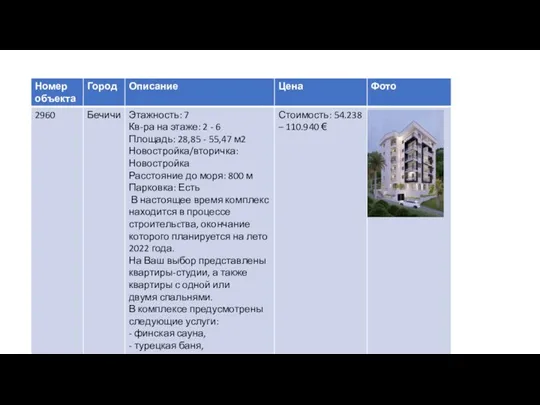

Тамбовский филиал РАНХиГС, для абитуриентов Комплекс в процессе строительcтва

Комплекс в процессе строительcтва Открытый аукцион по продаже права на заключение договора аренды земельного участка для строительства объекта коммунально-складс

Открытый аукцион по продаже права на заключение договора аренды земельного участка для строительства объекта коммунально-складс Витамин В1

Витамин В1 ОнлайнОбразование

ОнлайнОбразование 20170608_musor_-_globalnaya_ekologicheskaya_problema_sovremennogo_obshchestva

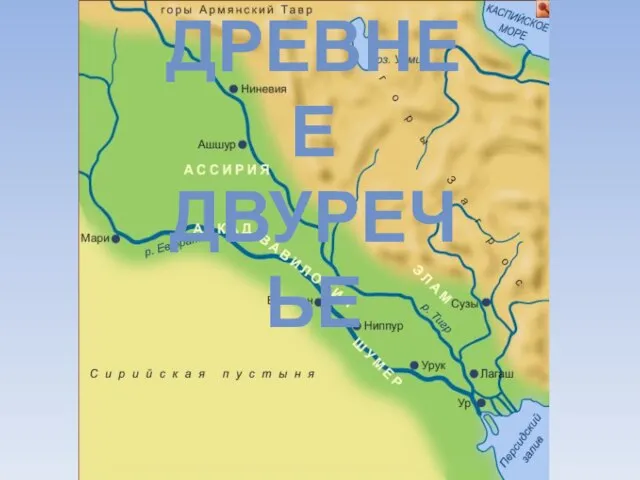

20170608_musor_-_globalnaya_ekologicheskaya_problema_sovremennogo_obshchestva Презентация на тему древнее двуречье презентация 5 класс

Презентация на тему древнее двуречье презентация 5 класс Презентация компании

Презентация компании Мой первые АНГЛИЙСКИЕ слова

Мой первые АНГЛИЙСКИЕ слова Европейски социален фонд Министерство на образованието, младежта и науката Оперативна програма Развитие на човешките ресурси 2007

Европейски социален фонд Министерство на образованието, младежта и науката Оперативна програма Развитие на човешките ресурси 2007  Свинцовый солдатик

Свинцовый солдатик Банки фильтров,шумоподавление

Банки фильтров,шумоподавление Средневековые города Востока

Средневековые города Востока Память. Лекция 5.1

Память. Лекция 5.1 Malsharuashylyq

Malsharuashylyq Конкурс чтецов. Карпова Ксения

Конкурс чтецов. Карпова Ксения American mass media

American mass media Направления исследований предпринимательства

Направления исследований предпринимательства Решение задач на движение

Решение задач на движение Совесть и раскаяние (4 класс)

Совесть и раскаяние (4 класс) Общая методология и механизмработы со СМИ (PR-продвижение Первой российской недели бизнес-ангелов в регионах)

Общая методология и механизмработы со СМИ (PR-продвижение Первой российской недели бизнес-ангелов в регионах) ТИПЫ АЛГОРИТМОВ

ТИПЫ АЛГОРИТМОВ