Проблемы распараллеливания метода частиц в ячейках для задачи взаимодействия электронного пучка с плазмой

Содержание

- 2. Содержание Проблемы эффективного распараллеливания для большого числа процессоров Моделирование динамики плазмы методом частиц в ячейках Проведение

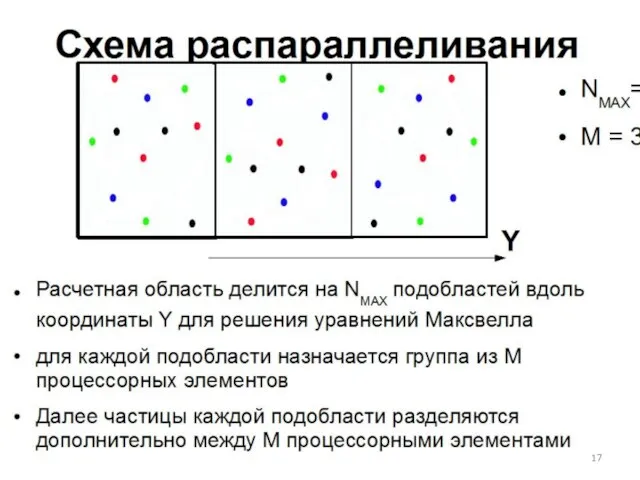

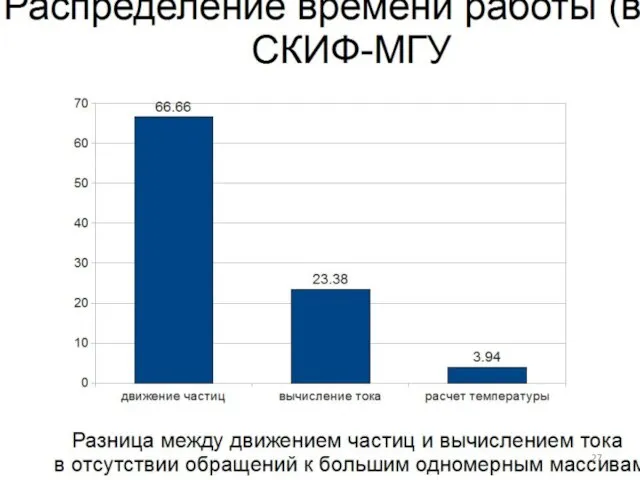

- 3. Проблемы эффективного распараллеливания для большого числа процессоров Решение уравнения Пуассона Параллельная прогонка Метод частиц в ячейках

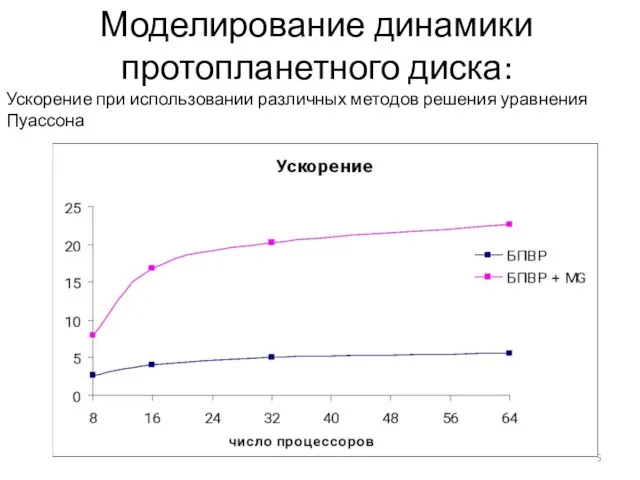

- 5. Многосеточный метод: Ускорение параллельной программы 0-я гармоника вычисляется с помощью многосеточного метода на отдельном процессоре Остальные

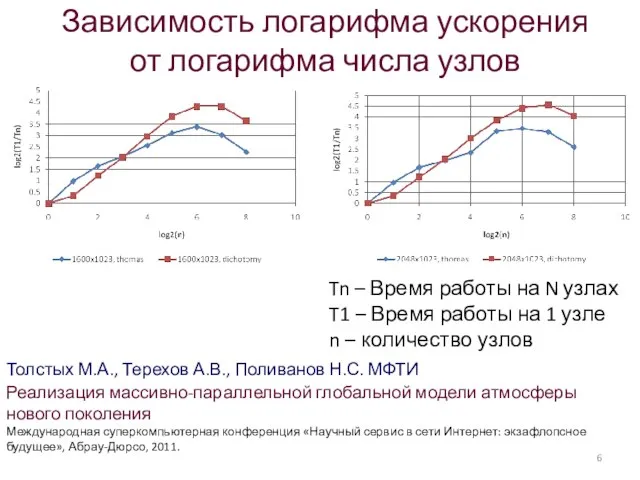

- 6. Зависимость логарифма ускорения от логарифма числа узлов Tn – Время работы на N узлах T1 –

- 7. Всероссийская конференция «Актуальные проблемы вычислительной математики и математического моделирования» 13 - 15 июня 2012 года Новосибирск,

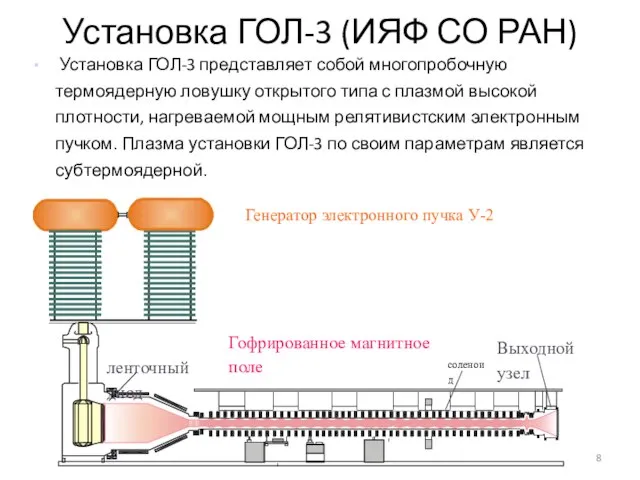

- 8. Установка ГОЛ-3 (ИЯФ СО РАН) Установка ГОЛ-3 представляет собой многопробочную термоядерную ловушку открытого типа с плазмой

- 9. Эффект аномальной теплопроводности В экспериментах на установке ГОЛ-3 (ИЯФ СО РАН) вследствие релаксации мощного электронного пучка

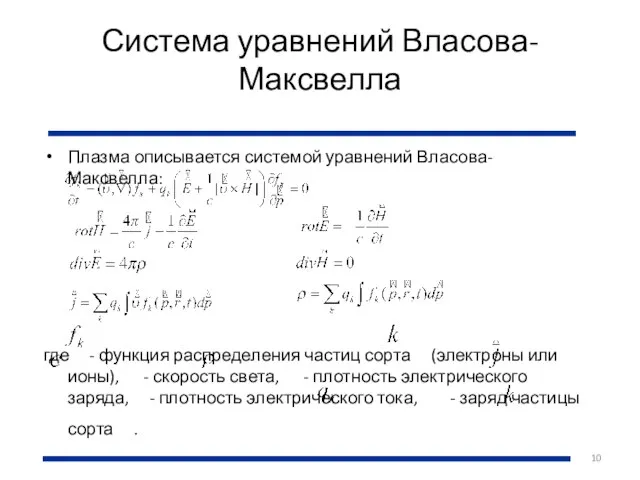

- 10. Система уравнений Власова-Максвелла Плазма описывается системой уравнений Власова-Максвелла: где - функция распределения частиц сорта (электроны или

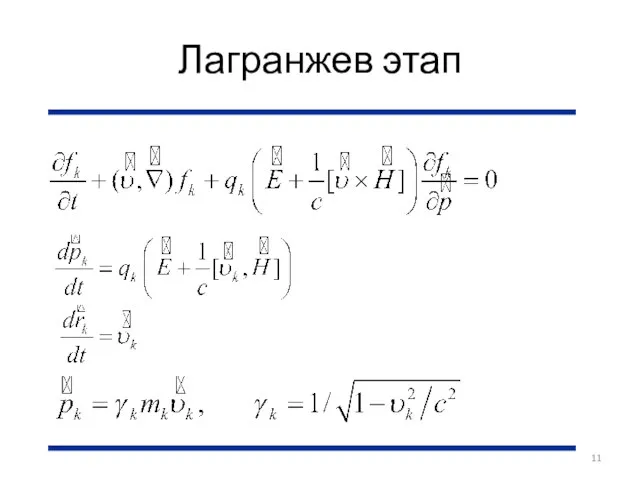

- 11. Лагранжев этап

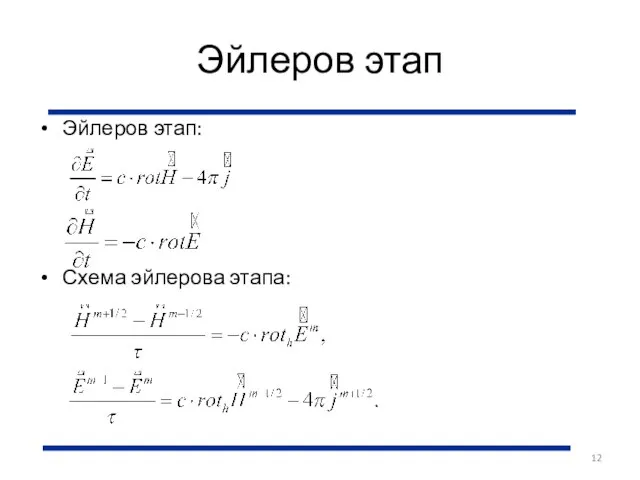

- 12. Эйлеров этап Эйлеров этап: Схема эйлерова этапа:

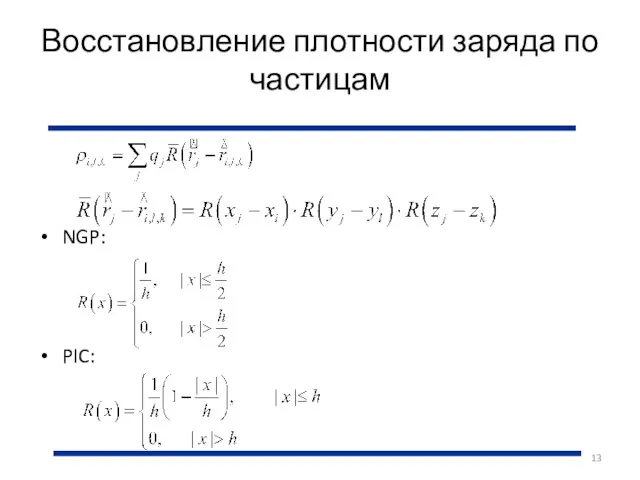

- 13. Восстановление плотности заряда по частицам NGP: PIC:

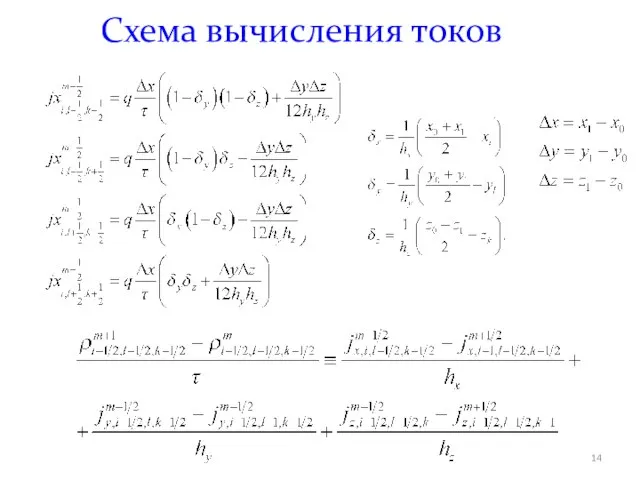

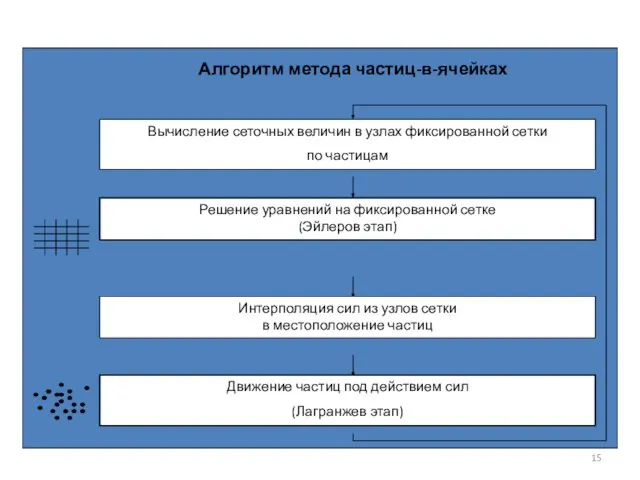

- 14. Схема вычисления токов

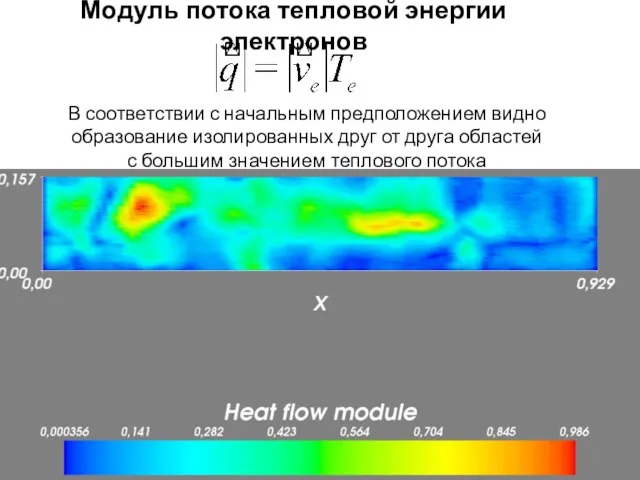

- 16. Модуль потока тепловой энергии электронов В соответствии с начальным предположением видно образование изолированных друг от друга

- 18. Проведение больших численных расчетов на суперЭВМ Оценка производительности суперЭВМ Повышение размерности задачи Компьютер — это не

- 19. Оценка производительности суперЭВМ Принятая единица — FlOpS (теоретические, или реально достигнутые, напр. LINPACK ) Однако для

- 20. Значение объема жесткого диска Пример конкретной задачи Релаксация мощного релятивистского пучка в высокотемпературной плазме, метод частиц-в-ячейках,

- 21. Повышение размерности задачи Существуют планы по поводу вычислений Exascale-масштабе. Тем не менее, лишь небольшое количество программ

- 22. Компьютер — это не только процессоры Результат расчета в задачах физики плазмы (не только в рассмотренной

- 23. Требования к системам хранения и передачи данных Объем диска - 200 Петабайт. Скорость диска - 270

- 24. О реализации метода частиц на GPU Необходимость Методика Результаты

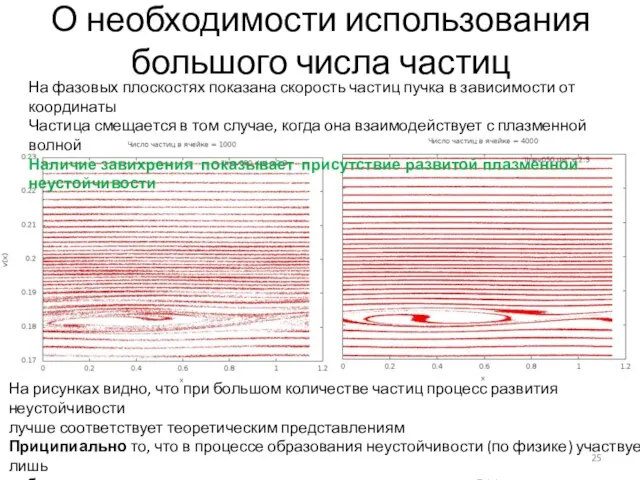

- 25. О необходимости использования большого числа частиц На фазовых плоскостях показана скорость частиц пучка в зависимости от

- 26. Оценка размера задачи В настоящее время проведены расчеты взаимодействия релятивистского электронного пучка с плазмой, позволившие в

- 27. Моделирование плазменных неустойчивостей требует кинетического подхода и больших вычислительных ресурсов: Требуется от 1000 частиц в ячейке

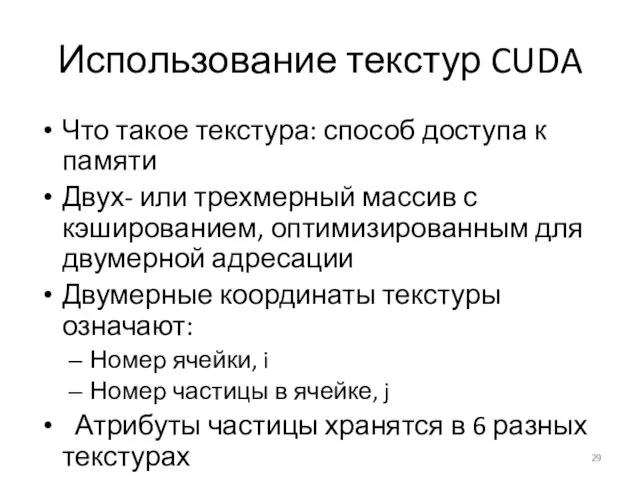

- 29. Использование текстур CUDA Что такое текстура: способ доступа к памяти Двух- или трехмерный массив с кэшированием,

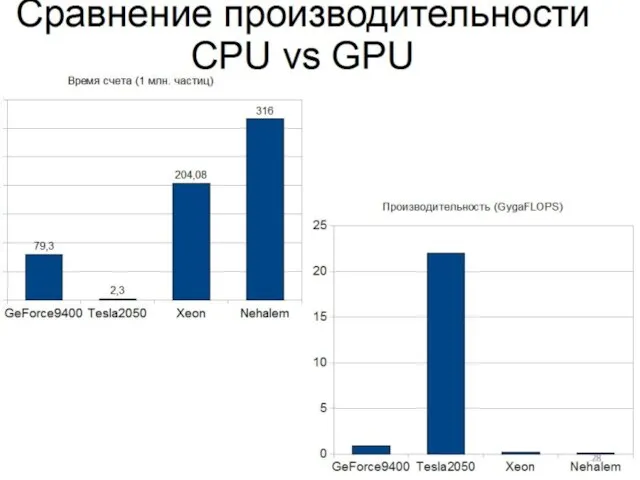

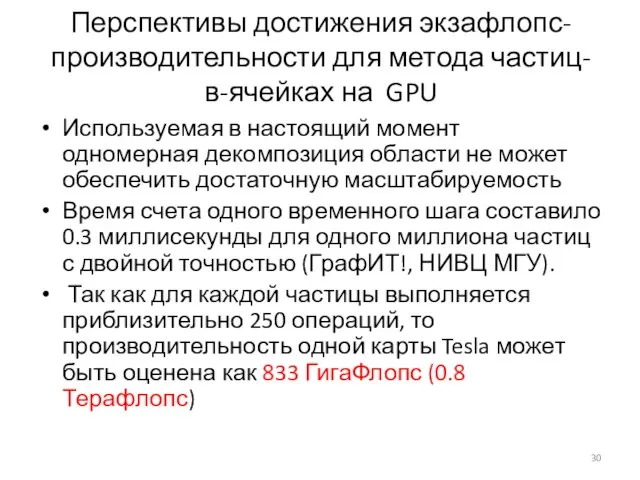

- 30. Перспективы достижения экзафлопс-производительности для метода частиц-в-ячейках на GPU Используемая в настоящий момент одномерная декомпозиция области не

- 31. О перспективах достижения экзафлопс-производительности.Если... Взять за основу для рассуждений Tianhe-1A, Выделить для каждой подобласти один ускоритель

- 32. Заключение 1) В настоящее время параллельные методы и алгоритмы недостаточно разработаны, в связи с чем невозможно

- 33. ЦЕНТР КОЛЛЕКТИВНОГО ПОЛЬЗОВАНИЯ ССКЦ ПРИ ИВМиМГ СО РАН Научный руководитель: академик Б.Г. Михайленко Исполнительный директор: д.т.н.

- 34. ОСНОВНЫЕ ЗАДАЧИ ЦКП ССКЦ Обеспечение работ институтов СО РАН и университетов Сибири по математическому моделированию в

- 35. Сервер с общей памятью (hp DL580 G5) GigabitEthernet InfiniBand GE GE Кластер HKC-160 (hp rx1620) В

- 36. Спасибо за внимание!

- 37. Переход к безразмерным переменным скорость света c = 3x1010 см/с плотность плазмы n0 = 1014 см-3

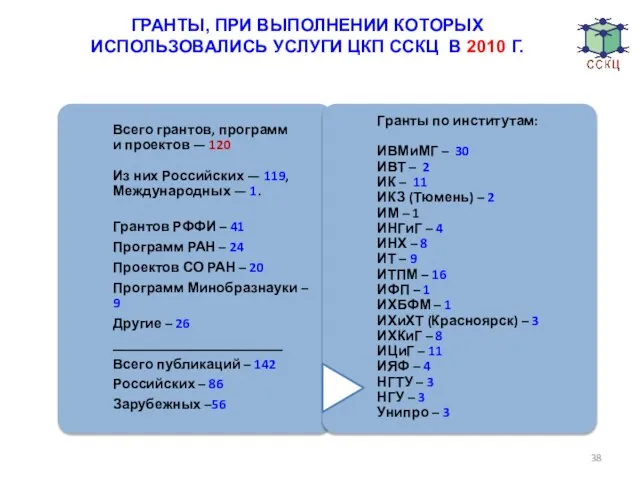

- 38. ГРАНТЫ, ПРИ ВЫПОЛНЕНИИ КОТОРЫХ ИСПОЛЬЗОВАЛИСЬ УСЛУГИ ЦКП ССКЦ В 2010 Г.

- 40. Скачать презентацию

Висит за окошком Кулёк ледяной, Он полон капели И пахнет весной

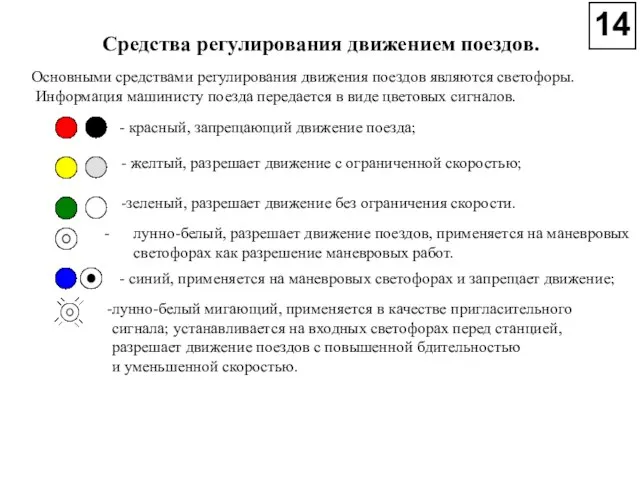

Висит за окошком Кулёк ледяной, Он полон капели И пахнет весной Средства регулирования движением поездов

Средства регулирования движением поездов Афины при Перикле

Афины при Перикле Электронная таблица EXCEL

Электронная таблица EXCEL Архетипы

Архетипы УНИДРУА: международный институт по унификации частного права

УНИДРУА: международный институт по унификации частного права Органы чувств

Органы чувств  «Этимологический анализ прозвищ жителей деревень Завражье, Мешково и поселка Судоверфь Судоверфского сельского поселения»

«Этимологический анализ прозвищ жителей деревень Завражье, Мешково и поселка Судоверфь Судоверфского сельского поселения» Новогодние открытки

Новогодние открытки Робототехника. Проект

Робототехника. Проект Балансирующий рынок

Балансирующий рынок Теорема Пифагора

Теорема Пифагора Культура XX века

Культура XX века Деревня Юрьевец

Деревня Юрьевец Wine. The benefits of wine with moderate consumption

Wine. The benefits of wine with moderate consumption Биопсихосоциодуховный подход к профилактике профессионального выгорания психологов

Биопсихосоциодуховный подход к профилактике профессионального выгорания психологов Воздействие высокоскоростных магистралей на окружающую среду

Воздействие высокоскоростных магистралей на окружающую среду Презентация экскурсии в животноводческий комплекс «ИП Каюмов»

Презентация экскурсии в животноводческий комплекс «ИП Каюмов» 07_0___163

07_0___163 каждую неделю около 600 000 слушателей включаются на частоту 100,5 FM каждый день Радио BEST FM слушают около 300 000 человек каждые 15 минут на в

каждую неделю около 600 000 слушателей включаются на частоту 100,5 FM каждый день Радио BEST FM слушают около 300 000 человек каждые 15 минут на в «Белые» в Гражданской войне

«Белые» в Гражданской войне Внедрение здоровьесберегающих технологий

Внедрение здоровьесберегающих технологий Русское искусство 2 пол.19 века

Русское искусство 2 пол.19 века Всегда ли правы мы- родители?

Всегда ли правы мы- родители? Итоги работы отрасли в 2010 году и задачи на 2011 год Глава департамента Елена Борисовна Чеснокова

Итоги работы отрасли в 2010 году и задачи на 2011 год Глава департамента Елена Борисовна Чеснокова Семейные традиции семьи Митрофановых

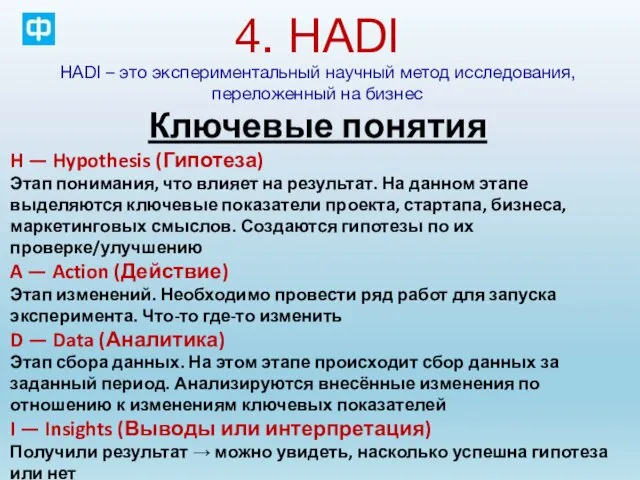

Семейные традиции семьи Митрофановых HADI – это экспериментальный научный метод исследования, переложенный на бизнес

HADI – это экспериментальный научный метод исследования, переложенный на бизнес ПРОЕКТ КНИЖКА-САМОДЕЛКА «Волшебница Зима» 4 класс

ПРОЕКТ КНИЖКА-САМОДЕЛКА «Волшебница Зима» 4 класс