Содержание

- 2. Что такое robots.txt Файл robots.txt – основной инструмент, с помощью которого вебмастер может управлять индексацией сайта

- 3. Зачем запрещать индексацию? Как правило, запрещают индексацию неинформативных и служебных страниц Версии для печати Формы регистрации,

- 4. История протокола исключений В начале 90-х годов участились случаи, когда роботы вызывали сбои в работе веб-серверов

- 5. Выбор имени файла Имя файла должно соответствовать основным критериям к именованиям файлов в большинстве операционных систем.

- 6. Формат файла robots.txt Файл robots.txt должен находиться в корневой директории домена или поддомена Имя файла регистрозависимое

- 7. Пример файла robots.txt # Start User-agent: Googlebot User-agent: StackRambler Disallow: /dir Disallow: /file.htm User-agent: * Disallow:

- 8. Нестандартные директивы Директива Crawl-delay (Yahoo и MSN) – время в секундах между запросами робота. Директива Allow

- 9. Пример файла robots.txt User-agent: msnbot-media User-agent: Googlebot-Image User-agent: Yahoo-MMCrawler Disallow: / User-agent: Yandex Disallow: /Messages.asp?sort= Host:

- 10. Резюме Создавать robots.txt для каждого домен и поддомена сайта Создавать запись для всех остальных роботов (User-agent:

- 12. Скачать презентацию

Презентация на тему Античная лирика

Презентация на тему Античная лирика Система счисления

Система счисления Вид графического изображения силуэт

Вид графического изображения силуэт Талант помогает исправиться

Талант помогает исправиться Динамические процессы в малой группе

Динамические процессы в малой группе Предложение

Предложение Карачаево-Черкесская республика – наш край родной

Карачаево-Черкесская республика – наш край родной КОНЦЕПЦИЯ УНИВЕРСАЛЬНОЙ ПЛАТФОРМЫ ДЛЯ ГРУЗОВОГО, ПАССАЖИРСКОГО И СПЕЦИАЛЬНОГО АВТОТРАНСПОРТА НА ОСНОВЕ ЭЛЕКТРИЧЕСКОЙ ТРАНСМИСС

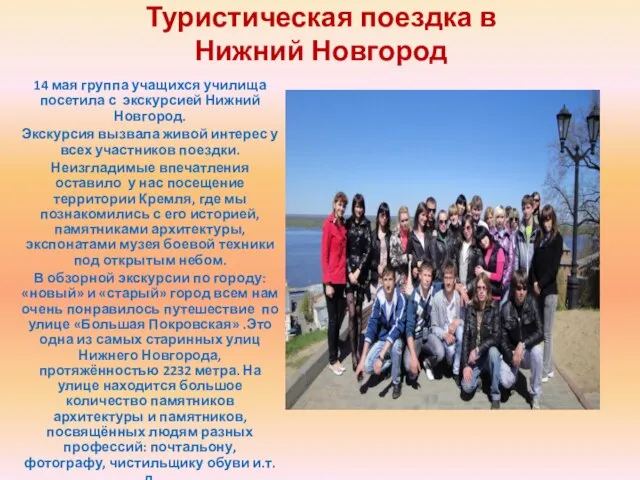

КОНЦЕПЦИЯ УНИВЕРСАЛЬНОЙ ПЛАТФОРМЫ ДЛЯ ГРУЗОВОГО, ПАССАЖИРСКОГО И СПЕЦИАЛЬНОГО АВТОТРАНСПОРТА НА ОСНОВЕ ЭЛЕКТРИЧЕСКОЙ ТРАНСМИСС Туристическая поездка в Нижний Новгород

Туристическая поездка в Нижний Новгород Новое направление Armelle. Функциональное питание

Новое направление Armelle. Функциональное питание Музеи мира

Музеи мира Компьютерные доспехи

Компьютерные доспехи Летний юбилей курсов

Летний юбилей курсов Миротворческие силы России

Миротворческие силы России Критерии оценки персонала

Критерии оценки персонала Blackstar наушники. Внешний вид и упаковка

Blackstar наушники. Внешний вид и упаковка Картины Мане

Картины Мане Презентация на тему Достопримечательности Москвы

Презентация на тему Достопримечательности Москвы  С Новым Годом

С Новым Годом Презентация на тему "Информационная культура личности" - скачать презентации по Педагогике

Презентация на тему "Информационная культура личности" - скачать презентации по Педагогике Социальные сети для HR

Социальные сети для HR Lektsiya dlya vechernikov_ Upravlenie kontentom v organizatsii

Lektsiya dlya vechernikov_ Upravlenie kontentom v organizatsii Презентация на тему Нарушение осанки

Презентация на тему Нарушение осанки Самарский государственный экономический университет

Самарский государственный экономический университет Сюжетные картины

Сюжетные картины Сводный каталог и МОБИС Аветисов М.А. Главный технолог ЦНСХБ

Сводный каталог и МОБИС Аветисов М.А. Главный технолог ЦНСХБ Языковая экология

Языковая экология Понятие самораскрытия в трудах С. Джурарда. Самораскрытие в психотерапии

Понятие самораскрытия в трудах С. Джурарда. Самораскрытие в психотерапии