Содержание

- 2. Темы доклада Сферы деятельности ОВС Локальная сеть отделения Работа с электронной почтой на mail.pnpi.spb.ru Вычислительный кластер

- 3. Основные сферы деятельности отдела и его состав Разработка эффективных вычислительных архитектур для использования в физике высоких

- 4. Локальная сеть ОФВЭ на 7 и 2 корпусах В конце октября 2004 года был получен и

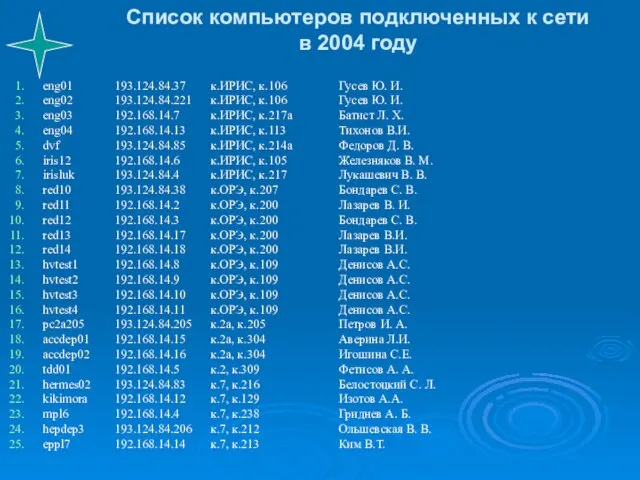

- 5. Список компьютеров подключенных к сети в 2004 году eng01 193.124.84.37 к.ИРИС, к.106 Гусев Ю. И. eng02

- 6. Локальная сеть института в аппаратной 7 корпуса Локальная сеть института на 7 корпусе строится на базе

- 7. Работа с электронной почтой на mail.pnpi.spb.ru Современный вариант мейл сервера создан ОВС на средства центра института

- 8. Антивирусная защита почтовых сообщений Антивирусная защита на сервере организована с использованием Dr.Web для sendmail. Продление лицензии

- 9. Антивирусная политика Уменьшен период опроса новых вирусных записей в базе данных Dr.Web до 15 минут. Если

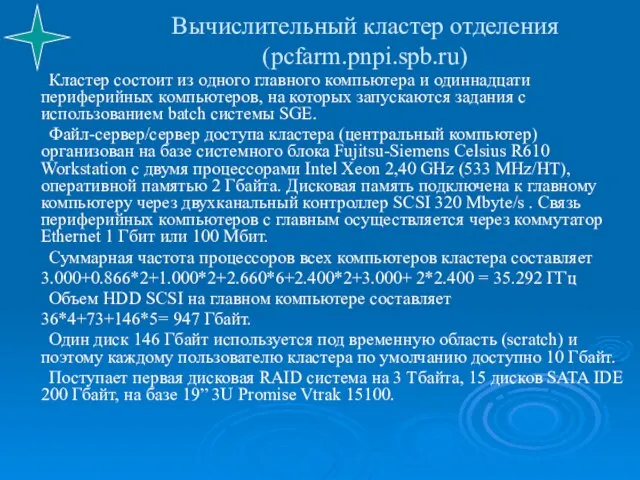

- 10. Вычислительный кластер отделения (pcfarm.pnpi.spb.ru) Кластер состоит из одного главного компьютера и одиннадцати периферийных компьютеров, на которых

- 11. Вычислительный кластер отделения (продолжение) В настоящее время на кластере зарегистрировано 136 пользователей. Все компьютеры кластера работают

- 12. Вычислительный кластер ОФВЭ

- 13. Использование вычислительного кластера пакетными заданиями в 2004 году Статистика с 1 января 2004 года по 27

- 14. PNPI role in Grid Anybody who plans to participate in accelerator physics simulation/analysis has to learn

- 16. Скачать презентацию

Слайд 2Темы доклада

Сферы деятельности ОВС

Локальная сеть отделения

Работа с электронной почтой на mail.pnpi.spb.ru

Вычислительный кластер

Темы доклада

Сферы деятельности ОВС

Локальная сеть отделения

Работа с электронной почтой на mail.pnpi.spb.ru

Вычислительный кластер

Слайд 3Основные сферы деятельности отдела и его состав

Разработка эффективных вычислительных архитектур для использования

Основные сферы деятельности отдела и его состав

Разработка эффективных вычислительных архитектур для использования

Поддержка разработанных и реализованных вычислительных систем ОФВЭ и института.

Локальная сеть ОФВЭ на 7 и 2 корпусах (три узла на 7 корпусе и 6 узлов на 2 корпусе).

Вычислительный кластер отделения, состоящий из двенадцати системных блоков, один из которых главный (pcfarm.pnpi.spb.ru).

Mail сервер института и главный DNS сервер института (mail.pnpi.spb.ru).

WWW, FTP сервер отделения, дополнительный DNS сервер института и mail-list отделения и института (dbserv.pnpi.spb.ru).

Коммутатор локальной сети института на 7 корпусе, обеспечивающий интеграцию сетей института на скорости 100 Мбит/сек

Прокси сервер отделения и центральных подразделений института для работы с Интернет по наземному каналу 512 Кбит/сек (proxyter.pnpi.spb.ru).

Сервер доступа в локальную сеть по модемным линиям.

Сетевые принтеры.

В отделе 5 человек.

Слайд 4Локальная сеть ОФВЭ на 7 и 2 корпусах

В конце октября 2004 года

Локальная сеть ОФВЭ на 7 и 2 корпусах

В конце октября 2004 года

Общее число портов Ethernet в Отделении увеличилось с 300 до 324.

Следует планировать приобретение ещё одного коммутатора на 24 порта 10/100 Мбит и 2 портами 1 Гбит, что обеспечит:

Дополнительные порты на узле в комнате 124 корпуса 7 (аппаратная 7 корпуса), общее число портов 48;

Дополнительные порты на узле корпуса 2А, где всего 12 портов 10 Мбит;

Модернизацию узла в измерительном зале ИРИС путем замены концентратора с 12 портами 100 Мбит на коммутатор с 24 портами 10/100 Мбит.

В будущем рост сетевых потоков Отделения потребует установку гигабитного коммутатора в аппаратной корпуса 7.

Слайд 5Список компьютеров подключенных к сети

в 2004 году

eng01 193.124.84.37 к.ИРИС, к.106 Гусев Ю. И.

eng02 193.124.84.221 к.ИРИС, к.106 Гусев

Список компьютеров подключенных к сети

в 2004 году

eng01 193.124.84.37 к.ИРИС, к.106 Гусев Ю. И.

eng02 193.124.84.221 к.ИРИС, к.106 Гусев

eng03 192.168.14.7 к.ИРИС, к.217а Батист Л. Х.

eng04 192.168.14.13 к.ИРИС, к.113 Тихонов В.И.

dvf 193.124.84.85 к.ИРИС, к.214а Федоров Д. В.

iris12 192.168.14.6 к.ИРИС, к.105 Железняков В. М.

irisluk 193.124.84.4 к.ИРИС, к.217 Лукашевич В. В.

red10 193.124.84.38 к.ОРЭ, к.207 Бондарев С. В.

red11 192.168.14.2 к.ОРЭ, к.200 Лазарев В. И.

red12 192.168.14.3 к.ОРЭ, к.200 Бондарев С. В.

red13 192.168.14.17 к.ОРЭ, к.200 Лазарев В.И.

red14 192.168.14.18 к.ОРЭ, к.200 Лазарев В.И.

hvtest1 192.168.14.8 к.ОРЭ, к.109 Денисов А.С.

hvtest2 192.168.14.9 к.ОРЭ, к.109 Денисов А.С.

hvtest3 192.168.14.10 к.ОРЭ, к.109 Денисов А.С.

hvtest4 192.168.14.11 к.ОРЭ, к.109 Денисов А.С.

pc2a205 193.124.84.205 к.2a, к.205 Петров И. А.

accdep01 192.168.14.15 к.2а, к.304 Аверина Л.И.

accdep02 192.168.14.16 к.2а, к.304 Игошина С.Е.

tdd01 192.168.14.5 к.2, к.309 Фетисов А. А.

hermes02 193.124.84.83 к.7, к.216 Белостоцкий С. Л.

kikimora 192.168.14.12 к.7, к.129 Изотов А.А.

mpl6 192.168.14.4 к.7, к.238 Гриднев А. Б.

hepdep3 193.124.84.206 к.7, к.212 Ольшевская В. В.

eppl7 192.168.14.14 к.7, к.213 Ким В.Т.

Слайд 6Локальная сеть института

в аппаратной 7 корпуса

Локальная сеть института на 7 корпусе

Локальная сеть института

в аппаратной 7 корпуса

Локальная сеть института на 7 корпусе

В 2004 году подключены:

Локальная сеть из пяти компьютеров на 8 корпусе (информационно-общественный центр и профком) по оптоволоконной линии на скорости 100 Мбит/с.

Локальная сеть института на корпусе ИК по оптоволоконной линии на скорости 100 Мбит/с. Ранее связь с локальной сетью на ИК осуществлялась на скорости 10 Мбит/с через маршрутизатор для работы с Интернет по наземному каналу 512 Кбит/с.

Слайд 7Работа с электронной почтой на mail.pnpi.spb.ru

Современный вариант мейл сервера создан ОВС на

Работа с электронной почтой на mail.pnpi.spb.ru

Современный вариант мейл сервера создан ОВС на

На сервере зарегистрировано примерно 600 пользователей (сотрудники ОФВЭ, ОНИ и центральных подразделений).

Осенью 2003 года работа сервера была переведена на системный блок персонального компьютера Fujitsu-Siemens, полученный по немецкому кредиту, который имеет процессор Intel Pentium 4, 1.8 GHz и память 1 Гбайт. Работа сервера выполняется под операционной системой Linux Red Hat.

С краткой информацией по работе с почтой на этом сервере можно ознакомиться на странице http://hepd.pnpi.spb.ru/help/mail.html

Адреса электронной почты зарегистрированных сотрудников института упорядоченных по алфавиту фамилий можно найти на WWW сервере института http://www.pnpi.spb.ru/win/eml/mlist.htm

Слайд 8Антивирусная защита почтовых сообщений

Антивирусная защита на сервере организована с использованием Dr.Web для

Антивирусная защита почтовых сообщений

Антивирусная защита на сервере организована с использованием Dr.Web для

Работать без антивирусной защиты почты невозможно, т.к. в сутки на сервер приходит более 100 мейлов с вирусами. Сильная вирусная эпидемия имела место 27 января 2004 года, когда после получения новых вирусных записей в базу данных было обнаружено, что основное число мейлов с вирусами идет с компьютеров внутри института. В течение 4 часов было обнаружено более 1000 мейлов с вирусами и нам пришлось определять с каких компьютеров идут мейлы с вирусами. Число заражённых компьютеров в сети ПИЯФ насчиталось более десятка. IP-адреса, обнаруженных инфицированных компьютеров были сообщены ответственным лицам за локальные сети, чтобы отключили данные компьютеры от сети до удаления вирусов с компьютера.

Слайд 9Антивирусная политика

Уменьшен период опроса новых вирусных записей в базе данных Dr.Web до

Антивирусная политика

Уменьшен период опроса новых вирусных записей в базе данных Dr.Web до

Информация о заражённом мейле поступает только администратору.

При каждом скачивании новых вирусных записей осуществляется сканирование всех входных ящиков пользователей. Если обнаружены мэйлы с вирусом, то вручную запускается скрипт на удаление заражённых мейлов из списка мейлов данного данного пользователя.

Слайд 10Вычислительный кластер отделения (pcfarm.pnpi.spb.ru)

Кластер состоит из одного главного компьютера и одиннадцати периферийных

Вычислительный кластер отделения (pcfarm.pnpi.spb.ru)

Кластер состоит из одного главного компьютера и одиннадцати периферийных

Файл-сервер/сервер доступа кластера (центральный компьютер) организован на базе системного блока Fujitsu-Siemens Celsius R610 Workstation с двумя процессорами Intel Xeon 2,40 GHz (533 MHz/HT), оперативной памятью 2 Гбайта. Дисковая память подключена к главному компьютеру через двухканальный контроллер SCSI 320 Mbyte/s . Связь периферийных компьютеров с главным осуществляется через коммутатор Ethernet 1 Гбит или 100 Мбит.

Суммарная частота процессоров всех компьютеров кластера составляет

3.000+0.866*2+1.000*2+2.660*6+2.400*2+3.000+ 2*2.400 = 35.292 ГГц

Объем HDD SCSI на главном компьютере составляет

36*4+73+146*5= 947 Гбайт.

Один диск 146 Гбайт используется под временную область (scratch) и поэтому каждому пользователю кластера по умолчанию доступно 10 Гбайт.

Поступает первая дисковая RAID система на 3 Тбайта, 15 дисков SATA IDE 200 Гбайт, на базе 19” 3U Promise Vtrak 15100.

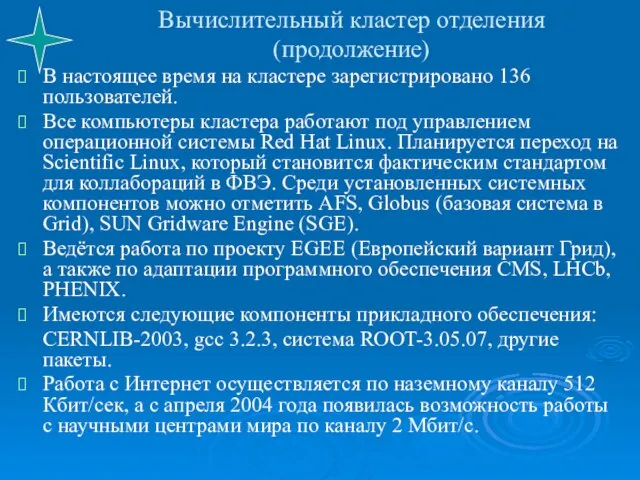

Слайд 11Вычислительный кластер отделения

(продолжение)

В настоящее время на кластере зарегистрировано 136 пользователей.

Все компьютеры

Вычислительный кластер отделения

(продолжение)

В настоящее время на кластере зарегистрировано 136 пользователей.

Все компьютеры

Ведётся работа по проекту EGEE (Европейский вариант Грид), а также по адаптации программного обеспечения CMS, LHCb, PHENIX.

Имеются следующие компоненты прикладного обеспечения:

CERNLIB-2003, gcc 3.2.3, система ROOT-3.05.07, другие пакеты.

Работа с Интернет осуществляется по наземному каналу 512 Кбит/сек, а с апреля 2004 года появилась возможность работы с научными центрами мира по каналу 2 Мбит/с.

Слайд 12Вычислительный кластер ОФВЭ

Вычислительный кластер ОФВЭ

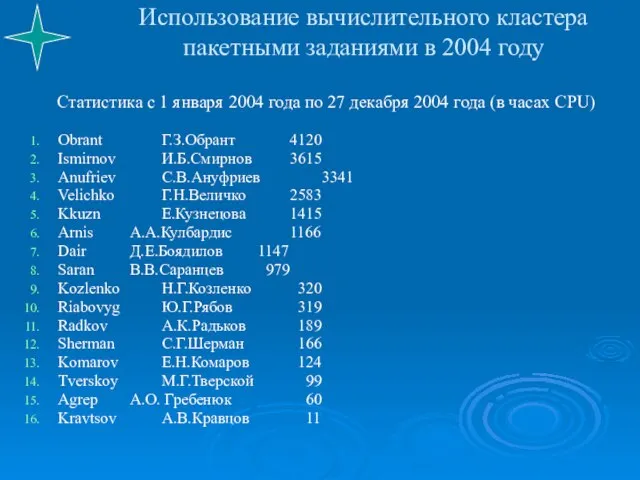

Слайд 13Использование вычислительного кластера

пакетными заданиями в 2004 году

Статистика с 1 января 2004 года

Использование вычислительного кластера

пакетными заданиями в 2004 году

Статистика с 1 января 2004 года

Obrant Г.З.Обрант 4120

Ismirnov И.Б.Смирнов 3615

Anufriev С.В.Ануфриев 3341

Velichko Г.Н.Величко 2583

Kkuzn Е.Кузнецова 1415

Arnis А.А.Кулбардис 1166

Dair Д.Е.Боядилов 1147

Saran В.В.Саранцев 979

Kozlenko Н.Г.Козленко 320

Riabovyg Ю.Г.Рябов 319

Radkov А.К.Радьков 189

Sherman С.Г.Шерман 166

Komarov Е.Н.Комаров 124

Tverskoy М.Г.Тверской 99

Agrep А.О. Гребенюк 60

Kravtsov А.В.Кравцов 11

Слайд 14PNPI role in Grid

Anybody who plans to participate in accelerator physics simulation/analysis

PNPI role in Grid

Anybody who plans to participate in accelerator physics simulation/analysis

HEPD has to keep up to date own computing cluster facility (about 10 TB of disk space and appropriate computing power) and external data transfer throughput 1-5 MBytes/sec.

Цитата из презентации А.Е. Шевеля 14 декабря 2004 года

на семинаре ОФВЭ ( http://dbserv.pnpi.spb.ru/CSD/CSD_Docs/pnpi-dec2004.pdf )

Инфраструктурные инвестиции

Инфраструктурные инвестиции Културен туризъм: международен маркетинг Бележки към кръглата маса организирана от ПП ГЕРБ Асеновград, 23.06.09

Културен туризъм: международен маркетинг Бележки към кръглата маса организирана от ПП ГЕРБ Асеновград, 23.06.09 Pos материалы гербион

Pos материалы гербион Презентация на тему Неофициальные символы России

Презентация на тему Неофициальные символы России CPA launches FOD

CPA launches FOD Методы и приборы разрушающего контроля, применяемые при обследовании

Методы и приборы разрушающего контроля, применяемые при обследовании ЖИЗНЬ И БЫТ В СРЕДНЕВЕКОВОМ ЗАМКЕ

ЖИЗНЬ И БЫТ В СРЕДНЕВЕКОВОМ ЗАМКЕ Презентация компании MOST Marketing«Франчайзинговый пакет: как разработать,чтобы привлечь франчайзи»

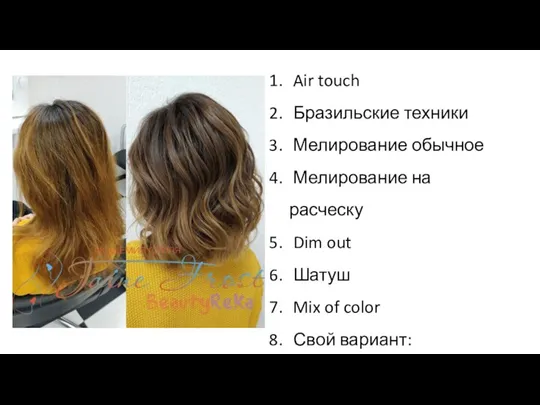

Презентация компании MOST Marketing«Франчайзинговый пакет: как разработать,чтобы привлечь франчайзи» Колористика при окрашивании волос. Тест

Колористика при окрашивании волос. Тест Предложение по летнему корпоративному отдыху на стадионе «Труд» (пос. «Старая Купавна»)

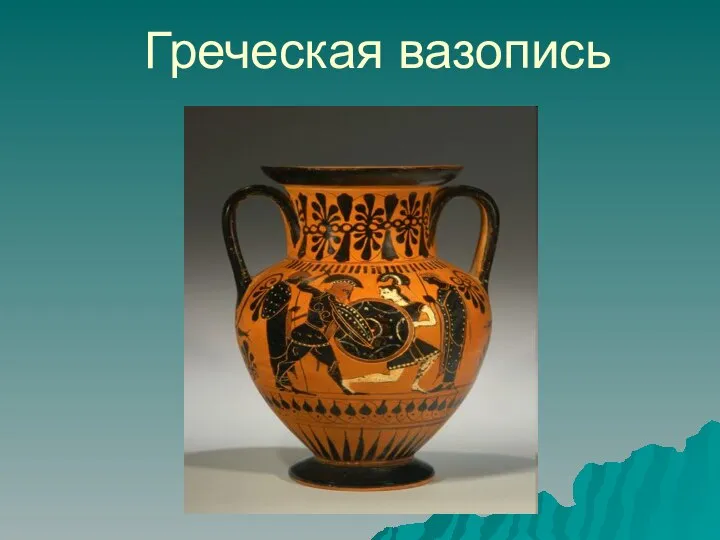

Предложение по летнему корпоративному отдыху на стадионе «Труд» (пос. «Старая Купавна») Греческая вазопись

Греческая вазопись Холод в нефтянной промышленности

Холод в нефтянной промышленности Урок-путешествие по разделу «Были-небылицы». Оценка достижений

Урок-путешествие по разделу «Были-небылицы». Оценка достижений LobbyWorks

LobbyWorks Самоиндукция

Самоиндукция Correct сommunication. Правильное общение

Correct сommunication. Правильное общение Тема: «Положение человека в системе животного мира. Эволюция гоминид».

Тема: «Положение человека в системе животного мира. Эволюция гоминид». Презентация на тему Выживание в природных условиях после аварии

Презентация на тему Выживание в природных условиях после аварии  ангелы

ангелы Интеллектуально-познавательная игра

Интеллектуально-познавательная игра Анализ применимости ПИК «СтОФ» для массовой оценки стоимости движимого имущества Тевелева Оксана Валерьевна тел: (499) 724-15-14, 8(903)208-

Анализ применимости ПИК «СтОФ» для массовой оценки стоимости движимого имущества Тевелева Оксана Валерьевна тел: (499) 724-15-14, 8(903)208- Fruit and vegetables

Fruit and vegetables Ты подвиг совершил во имя жизни на земле

Ты подвиг совершил во имя жизни на земле Обязательства из односторонних сделок и из действий в чужом интересе. Обязательства из договоров, не подлежащие судебной защите

Обязательства из односторонних сделок и из действий в чужом интересе. Обязательства из договоров, не подлежащие судебной защите ТВ - тюнеры

ТВ - тюнеры Применение программного комплекса CorPos (FORCE Technology Norway AS) для диагностики и прогнозирования коррозии на внутренних стенках газопров

Применение программного комплекса CorPos (FORCE Technology Norway AS) для диагностики и прогнозирования коррозии на внутренних стенках газопров Евгений Замятин

Евгений Замятин Characteristic of grain mass

Characteristic of grain mass