Содержание

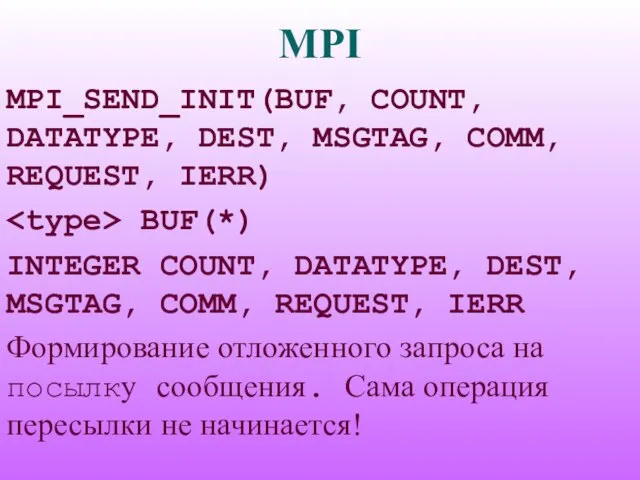

- 2. MPI MPI_SEND_INIT(BUF, COUNT, DATATYPE, DEST, MSGTAG, COMM, REQUEST, IERR) BUF(*) INTEGER COUNT, DATATYPE, DEST, MSGTAG, COMM,

- 3. MPI Модификации функции MPI_SEND_INIT: MPI_BSEND_INIT — формирование запроса на передачу сообщения с буферизацией. MPI_SSEND_INIT — формирование

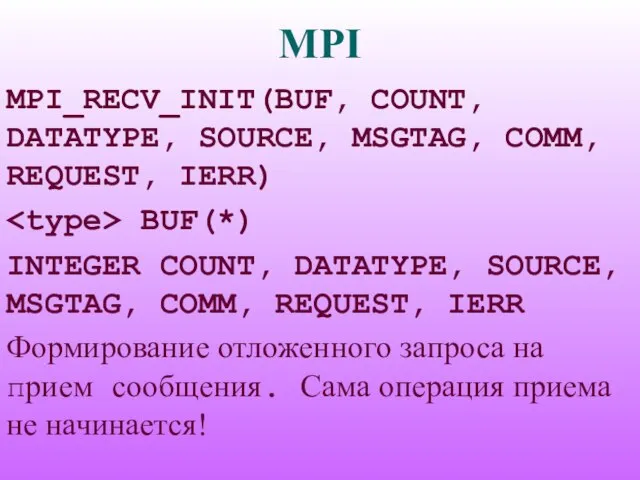

- 4. MPI MPI_RECV_INIT(BUF, COUNT, DATATYPE, SOURCE, MSGTAG, COMM, REQUEST, IERR) BUF(*) INTEGER COUNT, DATATYPE, SOURCE, MSGTAG, COMM,

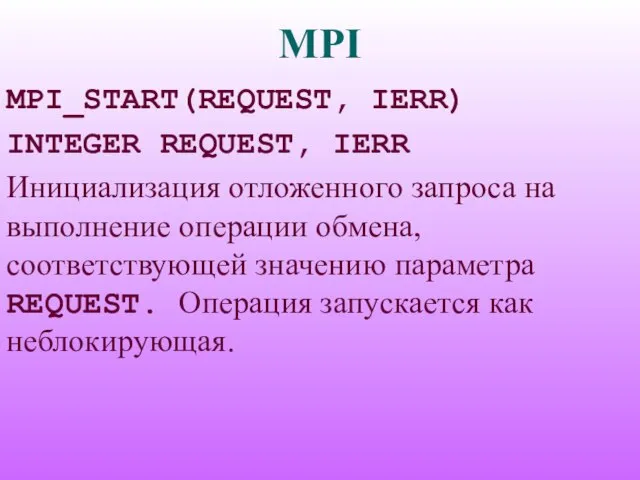

- 5. MPI MPI_START(REQUEST, IERR) INTEGER REQUEST, IERR Инициализация отложенного запроса на выполнение операции обмена, соответствующей значению параметра

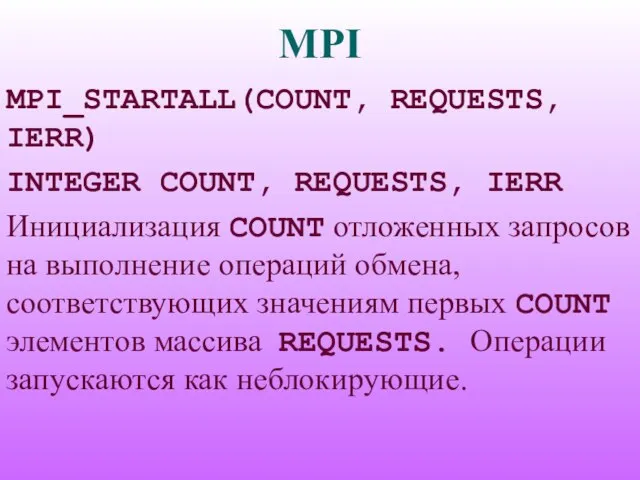

- 6. MPI MPI_STARTALL(COUNT, REQUESTS, IERR) INTEGER COUNT, REQUESTS, IERR Инициализация COUNT отложенных запросов на выполнение операций обмена,

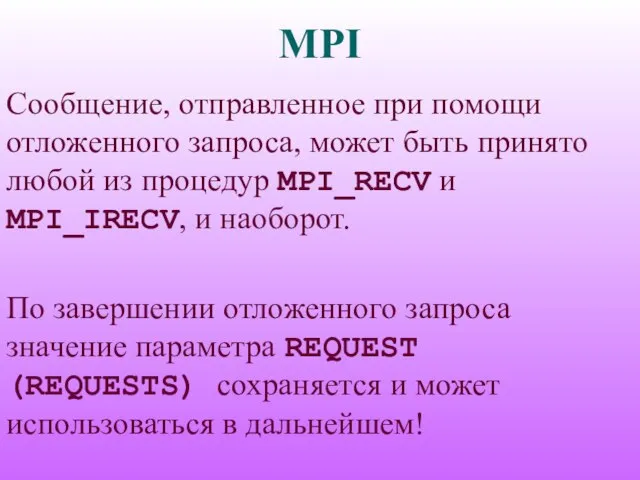

- 7. MPI Сообщение, отправленное при помощи отложенного запроса, может быть принято любой из процедур MPI_RECV и MPI_IRECV,

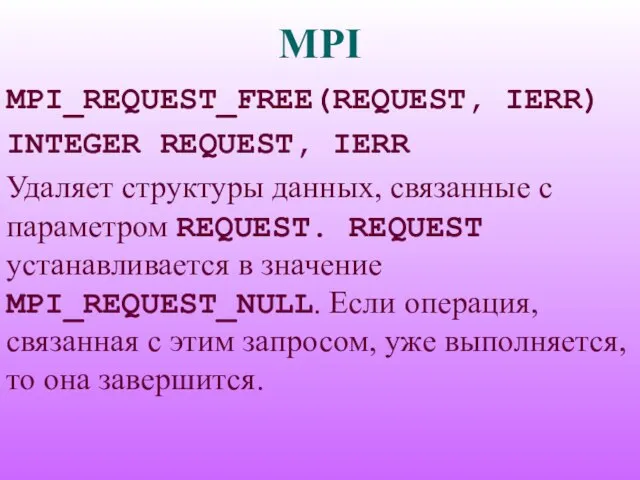

- 8. MPI MPI_REQUEST_FREE(REQUEST, IERR) INTEGER REQUEST, IERR Удаляет структуры данных, связанные с параметром REQUEST. REQUEST устанавливается в

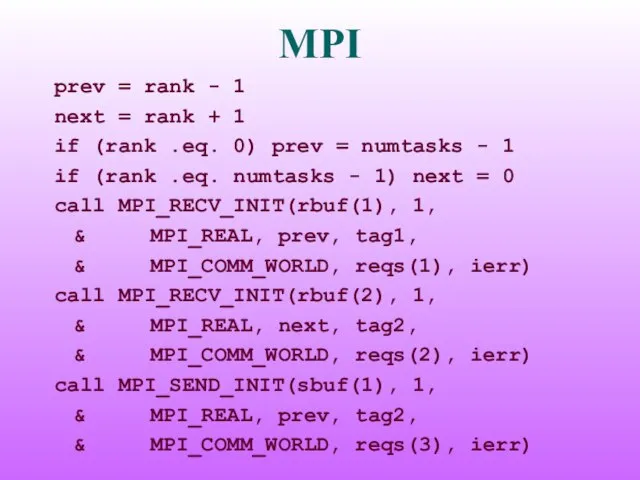

- 9. MPI prev = rank - 1 next = rank + 1 if (rank .eq. 0) prev

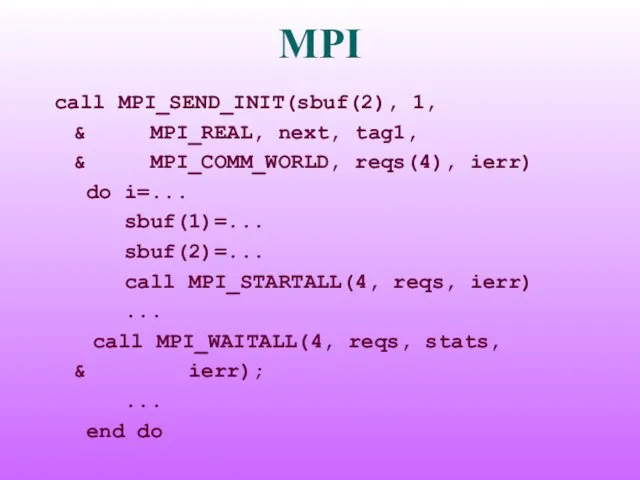

- 10. MPI call MPI_SEND_INIT(sbuf(2), 1, & MPI_REAL, next, tag1, & MPI_COMM_WORLD, reqs(4), ierr) do i=... sbuf(1)=... sbuf(2)=...

- 11. MPI Тупиковые ситуации (deadlock): процесс 0: RECV(1) SEND(1) процесс 1: RECV(0) SEND(0) процесс 0: SEND(1) RECV(1)

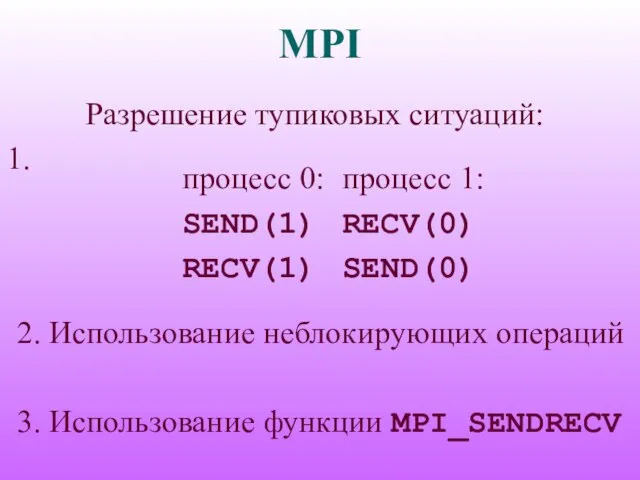

- 12. MPI Разрешение тупиковых ситуаций: 1. процесс 0: SEND(1) RECV(1) процесс 1: RECV(0) SEND(0) 2. Использование неблокирующих

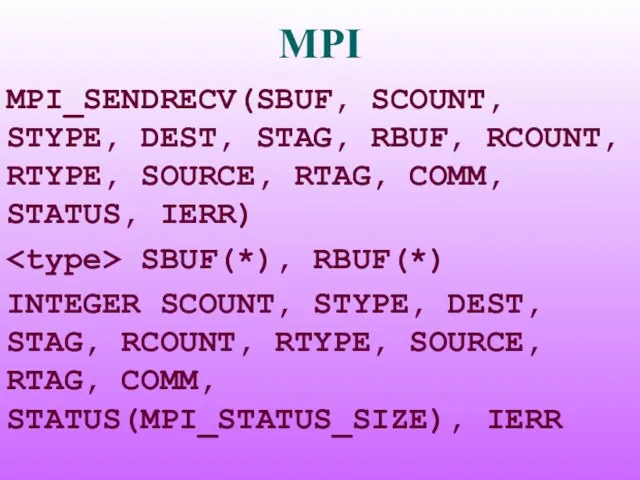

- 13. MPI MPI_SENDRECV(SBUF, SCOUNT, STYPE, DEST, STAG, RBUF, RCOUNT, RTYPE, SOURCE, RTAG, COMM, STATUS, IERR) SBUF(*), RBUF(*)

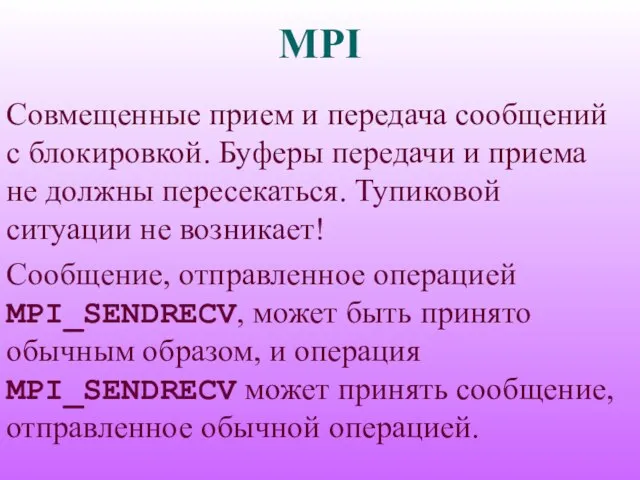

- 14. MPI Совмещенные прием и передача сообщений с блокировкой. Буферы передачи и приема не должны пересекаться. Тупиковой

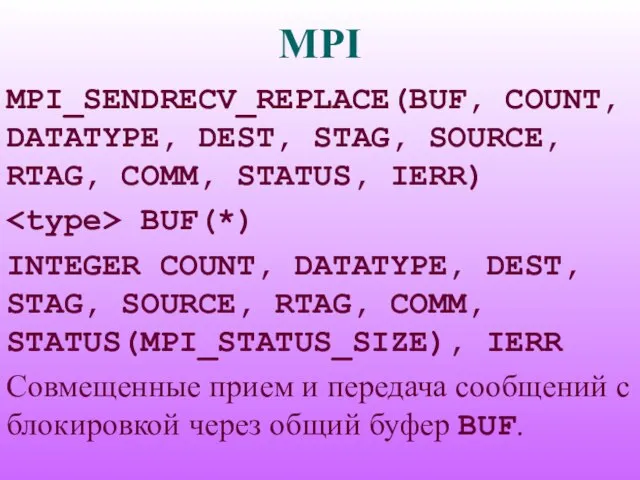

- 15. MPI MPI_SENDRECV_REPLACE(BUF, COUNT, DATATYPE, DEST, STAG, SOURCE, RTAG, COMM, STATUS, IERR) BUF(*) INTEGER COUNT, DATATYPE, DEST,

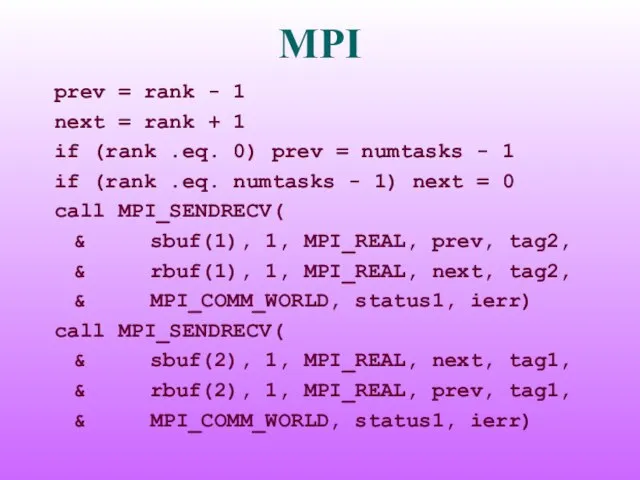

- 16. MPI prev = rank - 1 next = rank + 1 if (rank .eq. 0) prev

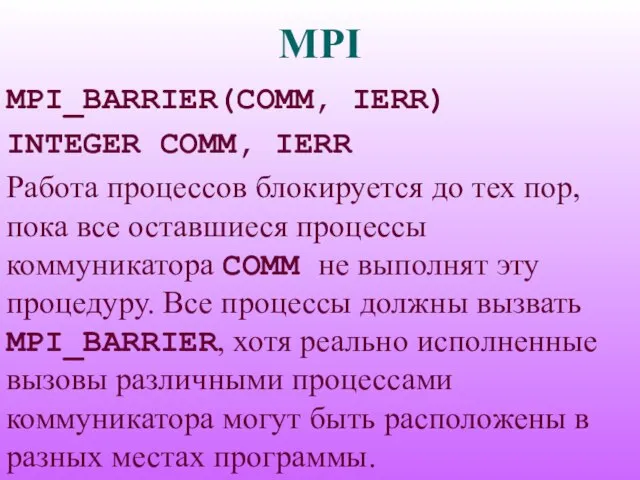

- 17. MPI MPI_BARRIER(COMM, IERR) INTEGER COMM, IERR Работа процессов блокируется до тех пор, пока все оставшиеся процессы

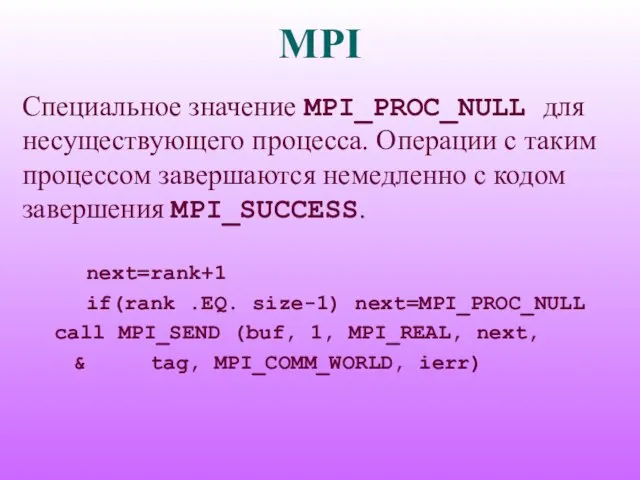

- 18. MPI Специальное значение MPI_PROC_NULL для несуществующего процесса. Операции с таким процессом завершаются немедленно с кодом завершения

- 20. Скачать презентацию

Предложения с прямой речью (5 класс)

Предложения с прямой речью (5 класс) Глаз и зрение 8 класс

Глаз и зрение 8 класс Балллада как жанр. Баллада О Королева Элеонор

Балллада как жанр. Баллада О Королева Элеонор Бальцева Т.В., заведующий МДОУ центром развития ребенка- детским салом № 71

Бальцева Т.В., заведующий МДОУ центром развития ребенка- детским салом № 71 Организация работы по воспитанию навыков безопасного поведения у детей дошкольного возраста

Организация работы по воспитанию навыков безопасного поведения у детей дошкольного возраста Занятие по лепке из пластилина в программе Картонный домик

Занятие по лепке из пластилина в программе Картонный домик Основные этапы законотворческого процесса разработки Федерального Закона о закупках отдельными видами юридических лиц N223-ФЗ

Основные этапы законотворческого процесса разработки Федерального Закона о закупках отдельными видами юридических лиц N223-ФЗ Лирическая зарисовка как жанр художественной литературы

Лирическая зарисовка как жанр художественной литературы Эпоха Возрождения 7 класс

Эпоха Возрождения 7 класс Прямые линии и организация пространства

Прямые линии и организация пространства Урок математики

Урок математики Проектирование полуботинок с настрочными берцами

Проектирование полуботинок с настрочными берцами BlackRock

BlackRock Взаимодействие совокупного спроса и совокупного предложения

Взаимодействие совокупного спроса и совокупного предложения Работа и достижения Муниципального казенного учреждения культуры «Дом культуры»село ГофицкоеПетровского района Ставропольс

Работа и достижения Муниципального казенного учреждения культуры «Дом культуры»село ГофицкоеПетровского района Ставропольс Мифы

Мифы Проектирование и расчет координатной защиты башенных кранов

Проектирование и расчет координатной защиты башенных кранов Классицизм в архитектуре

Классицизм в архитектуре Presentation Title

Presentation Title  Виды и формы СЭМПЛИНГА.

Виды и формы СЭМПЛИНГА. Структура фешн рынка

Структура фешн рынка Домашние животные

Домашние животные НЕОТЛОЖНЫЕ СОСТОЯНИЯ У ДЕТЕЙ.СЕРДЕЧНО-ЛЁГОЧЬНАЯ РЕАНИМАЦИЯ

НЕОТЛОЖНЫЕ СОСТОЯНИЯ У ДЕТЕЙ.СЕРДЕЧНО-ЛЁГОЧЬНАЯ РЕАНИМАЦИЯ День птиц

День птиц Влияние запахов на психоэмоциональное состояние школьников

Влияние запахов на психоэмоциональное состояние школьников Презентация на тему Местные органы власти и управления Украины в послевоенные годы (1945 - первая пол. 1960 гг.)

Презентация на тему Местные органы власти и управления Украины в послевоенные годы (1945 - первая пол. 1960 гг.) Современный международный опыт

Современный международный опыт