Слайд 2В текстовом редакторе создайте файл с именем robots.txt и заполните его в соответствии с

представленными ниже правилами.

Слайд 3В роботе Яндекса используется сессионный принцип работы, на каждую сессию формируется определенный

пул страниц, которые планирует загрузить робот.

Сессия начинается с загрузки файла robots.txt. Если файл отсутствует, не является текстовым или на запрос робота возвращается HTTP-статус отличный от 200 OK, робот считает, что доступ к документам не ограничен.

В файле robots.txt робот проверяет наличие записей, начинающихся с User-agent:, в них учитываются подстроки Yandex (регистр значения не имеет) или * . Если обнаружена строка User-agent: Yandex, директивы для User-agent: * не учитываются. Если строки User-agent: Yandex и User-agent: *отсутствуют, считается, что доступ роботу не ограничен.

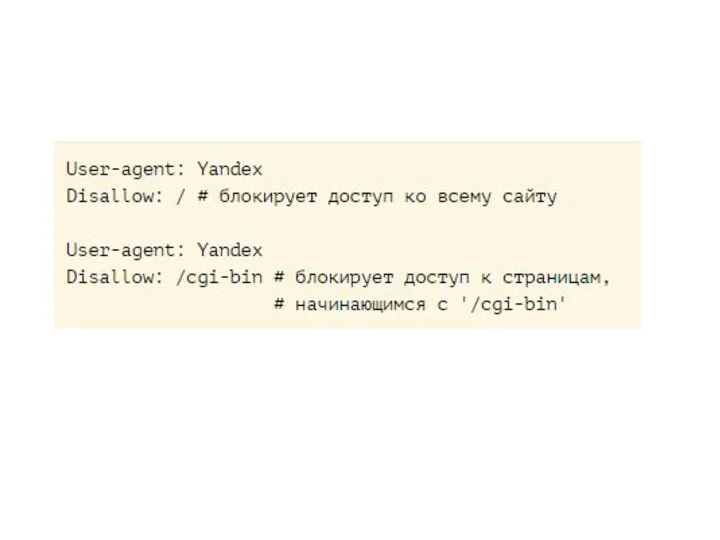

Слайд 4Директивы Disallow и Allow

Чтобы запретить доступ робота к сайту или некоторым его

разделам, используйте директиву Disallow.

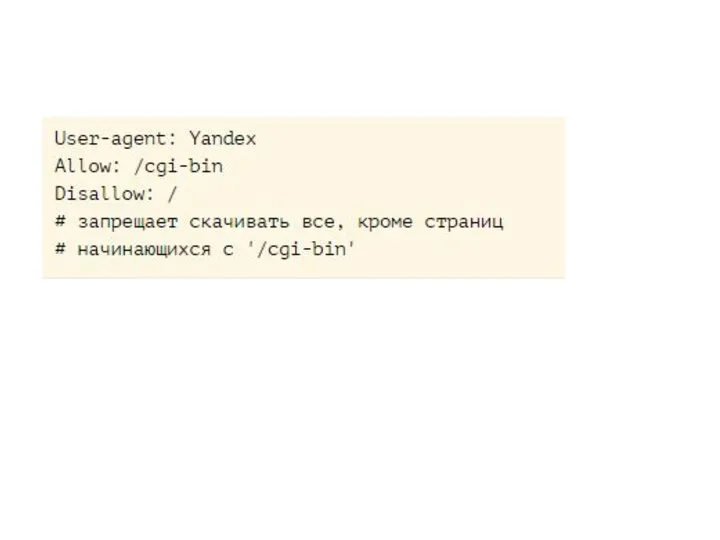

Слайд 6Чтобы разрешить доступ робота к сайту или некоторым его разделам, используйте директиву Allow

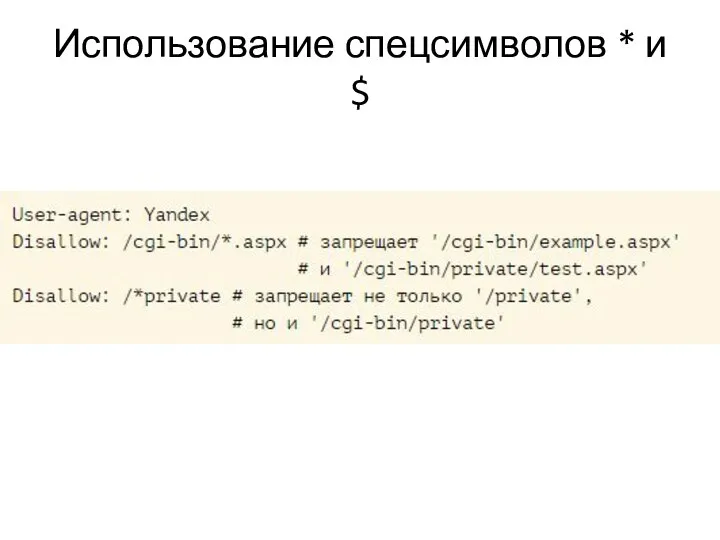

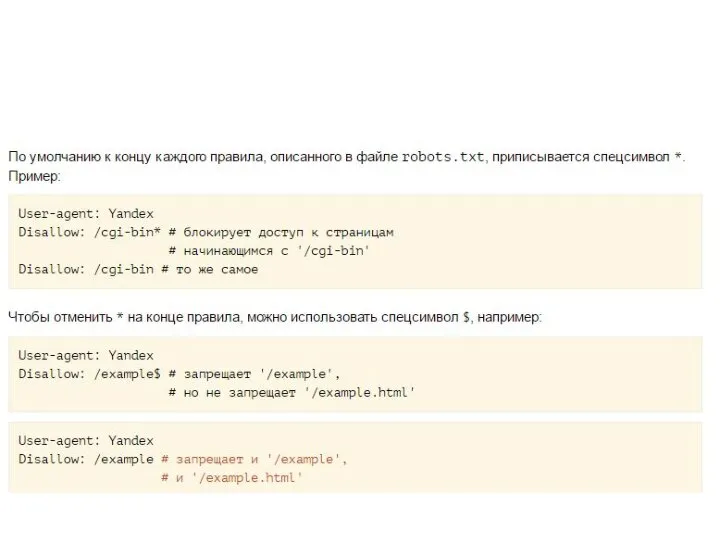

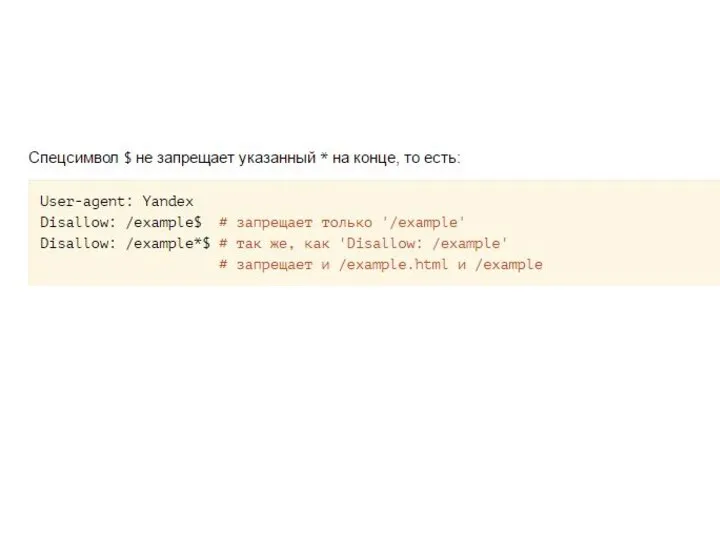

Слайд 8Использование спецсимволов * и $

При указании путей директив Allow и Disallow можно использовать спецсимволы * и $, задавая, таким

образом, определенные регулярные выражения. Спецсимвол * означает любую (в том числе пустую) последовательность символов.

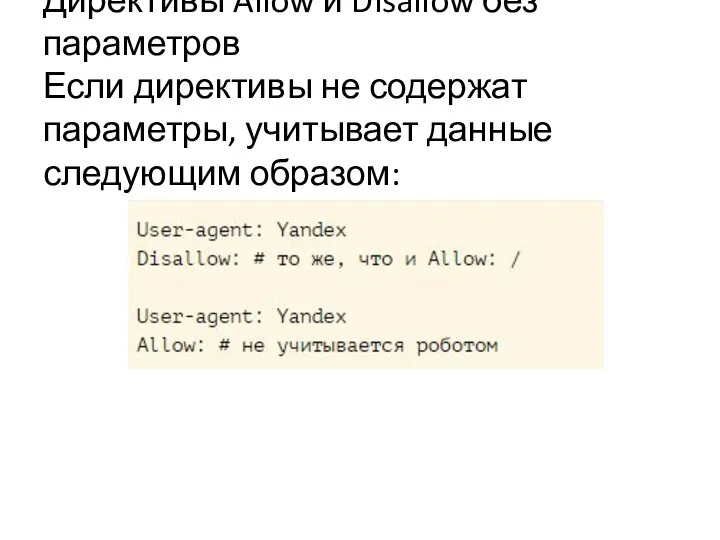

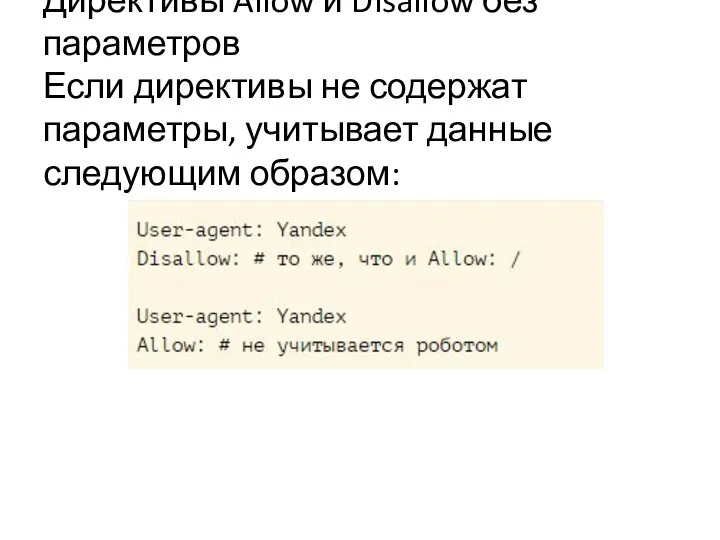

Слайд 9Директивы Allow и Disallow без параметров

Если директивы не содержат параметры, учитывает данные

следующим образом:

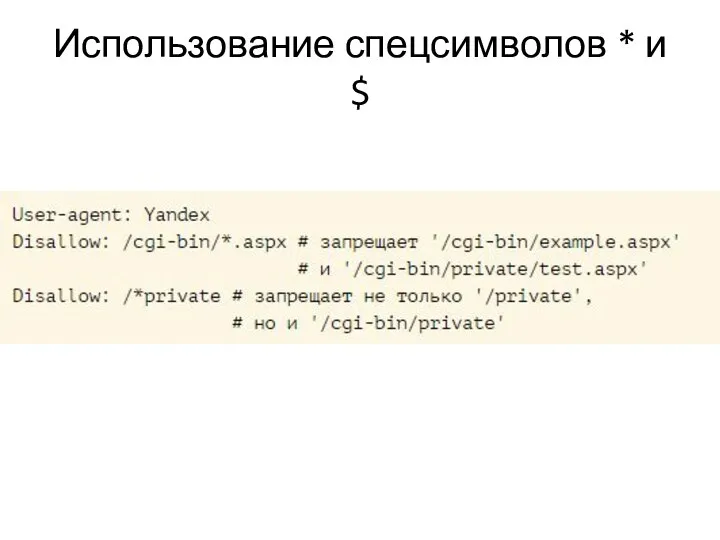

Слайд 10Использование спецсимволов * и $

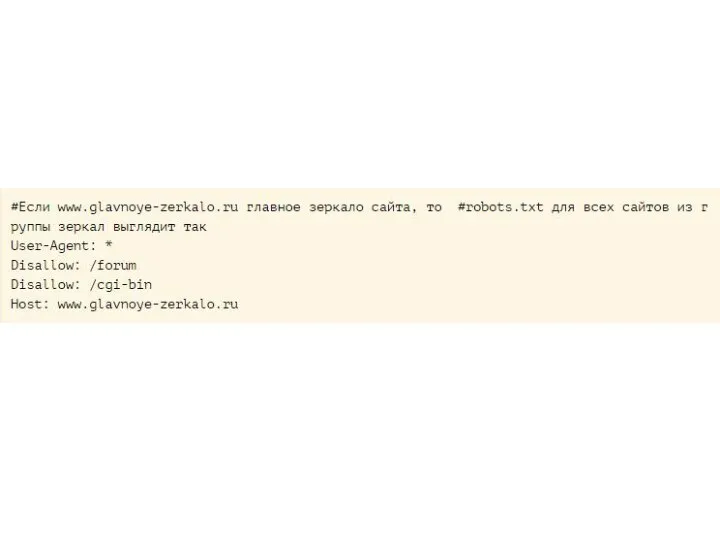

Слайд 14Директива Host

Если у вашего сайта есть зеркала, специальный робот зеркальщик определит их

и сформирует группу зеркал вашего сайта. В поиске будет участвовать только главное зеркало. Вы можете указать его для всех зеркал в файле robots.txt: имя главного зеркала должно быть значением директивы Host.

Директива 'Host' не гарантирует выбор указанного главного зеркала, тем не менее, алгоритм при принятии решения учитывает ее с высоким приоритетом

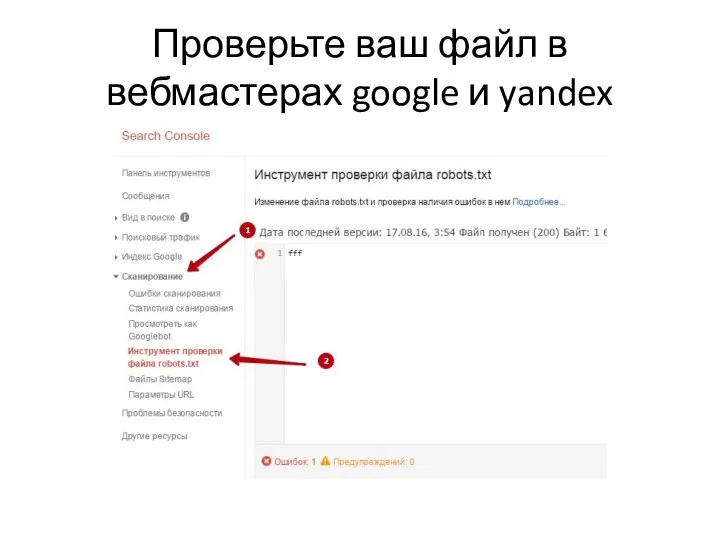

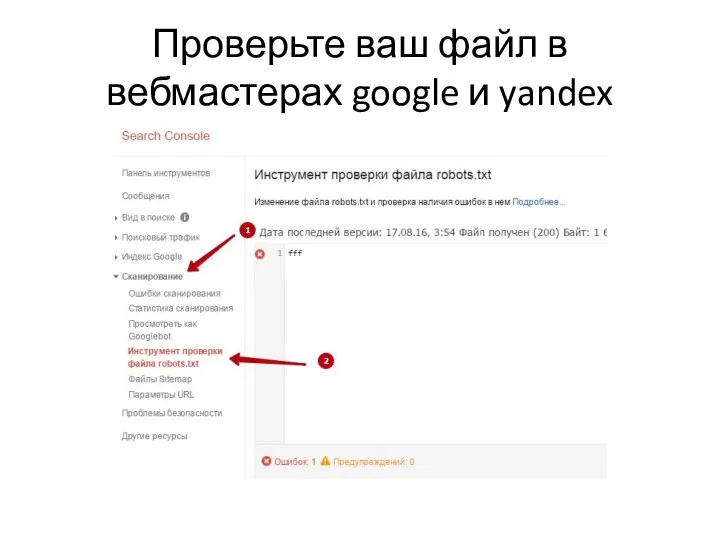

Слайд 16Проверьте ваш файл в вебмастерах google и yandex

Представление и кодирование информации

Представление и кодирование информации Domini Games. Стратегия 2021-2025

Domini Games. Стратегия 2021-2025 Overview of the .NET

Overview of the .NET Синтез электрохромной пленки, основанной на соединении фуллерена лития и оксида переходного металла

Синтез электрохромной пленки, основанной на соединении фуллерена лития и оксида переходного металла Логические операции

Логические операции Табличные расчеты и электронные таблицы

Табличные расчеты и электронные таблицы Обновление содержания экологического образования в эпоху цифровизации

Обновление содержания экологического образования в эпоху цифровизации Электронные библиотечные системы. Поиск в Электронной библиотеке Красноярского ГАУ

Электронные библиотечные системы. Поиск в Электронной библиотеке Красноярского ГАУ Персональный компьютер урок информатики в 7 классе. Персональный компьютер Windows XP

Персональный компьютер урок информатики в 7 классе. Персональный компьютер Windows XP Движение манипулятора. Программа автоматического управления манипулятором

Движение манипулятора. Программа автоматического управления манипулятором Знакомство с Векторным редактором, встроеннЫм в WORD 2007

Знакомство с Векторным редактором, встроеннЫм в WORD 2007 Взлом пароля пользователя программного продукта 1С: Предприятие 8

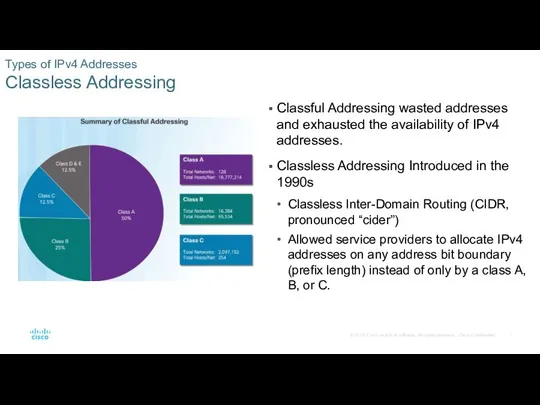

Взлом пароля пользователя программного продукта 1С: Предприятие 8 Classless addressing. Types of IPv4 Addresses

Classless addressing. Types of IPv4 Addresses Питон. Алгоритмизация и программирование. Решение задач на компьютере

Питон. Алгоритмизация и программирование. Решение задач на компьютере Организация циклов. Оператор цикла

Организация циклов. Оператор цикла Перечисления (enum)

Перечисления (enum) Платформы и прикладные решения. Лекция 7

Платформы и прикладные решения. Лекция 7 Проект строительства участка внутризоновой сети с организацией трактов по ВОЛС

Проект строительства участка внутризоновой сети с организацией трактов по ВОЛС Старт партнерки

Старт партнерки Правила безопасности в интернете

Правила безопасности в интернете МДК 02.02. Web-программирование. Язык РНР Работа с файловой системой

МДК 02.02. Web-программирование. Язык РНР Работа с файловой системой Кодирование и обработка звуковой информации

Кодирование и обработка звуковой информации СС_8

СС_8 Dependency Injection. Неявное управление зависимостями

Dependency Injection. Неявное управление зависимостями Информационные технологии. Информатизация

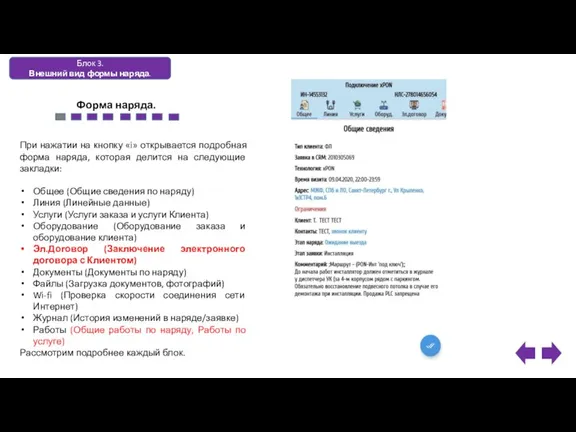

Информационные технологии. Информатизация Электронный договор. Внешний вид формы наряда. Макет

Электронный договор. Внешний вид формы наряда. Макет Функциональная схема взаимодействия участников симметричного криптографического обмена. Недостатки симметричных криптосистем

Функциональная схема взаимодействия участников симметричного криптографического обмена. Недостатки симметричных криптосистем Как безопасно общаться в социальных сетях

Как безопасно общаться в социальных сетях