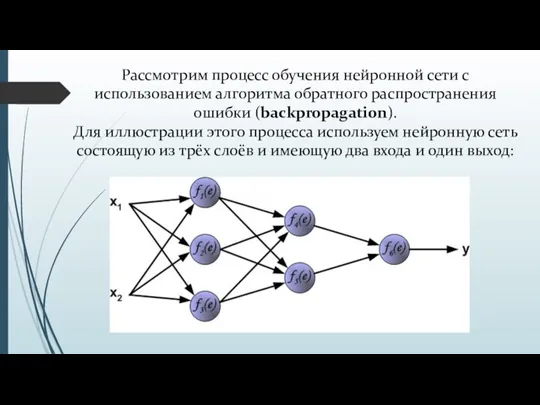

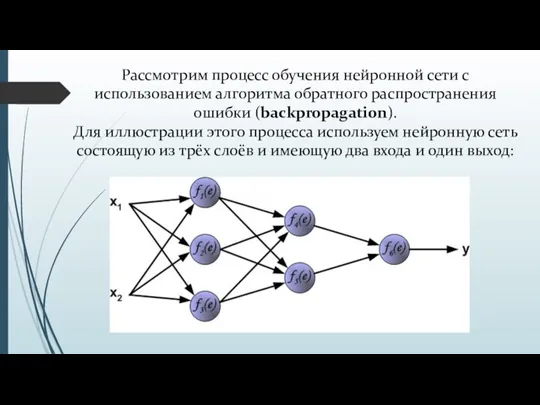

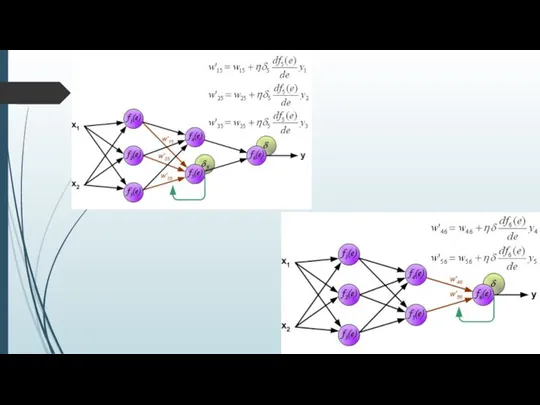

Слайд 2Рассмотрим процесс обучения нейронной сети с использованием алгоритма обратного распространения ошибки (backpropagation).

Для

иллюстрации этого процесса используем нейронную сеть состоящую из трёх слоёв и имеющую два входа и один выход:

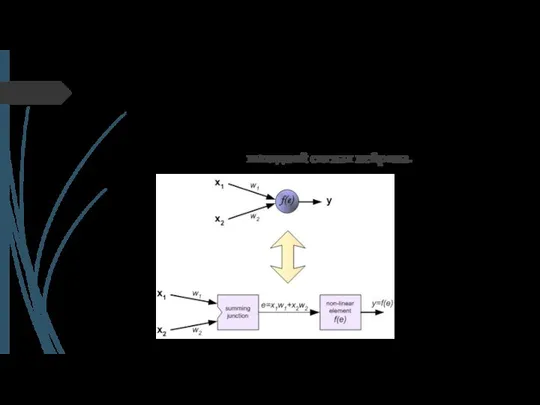

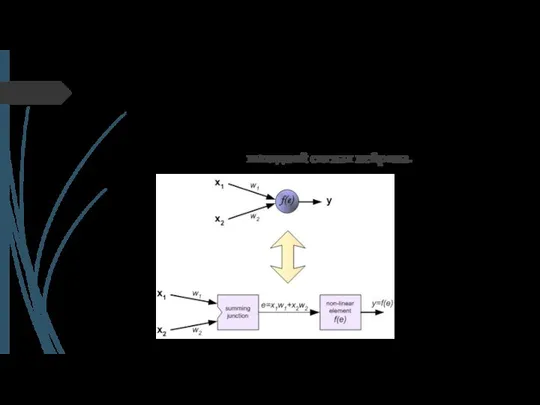

Слайд 3Каждый нейрон состоит из двух элементов.

Первый элемент – дендриты — добавляют весовые

коэффициенты ко входным сигналам.

Второй элемент – тело — реализует нелинейную функцию, т.н. функцию активации нейрона.

Сигнал е – это взвешенная сумма входных сигналов

у = f (е) - выходной сигнал нейрона.

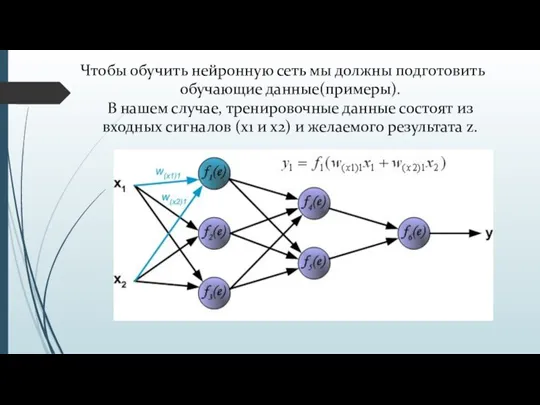

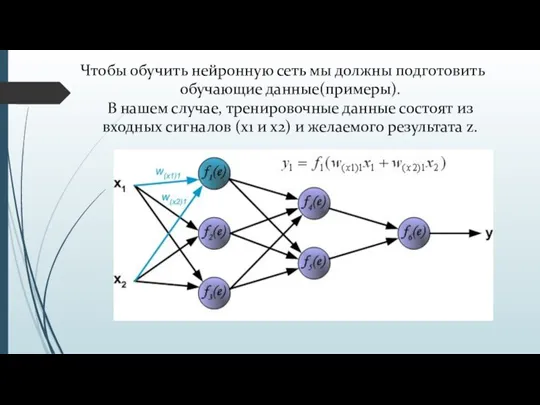

Слайд 4Чтобы обучить нейронную сеть мы должны подготовить обучающие данные(примеры).

В нашем случае, тренировочные

данные состоят из входных сигналов (х1 и х2) и желаемого результата z.

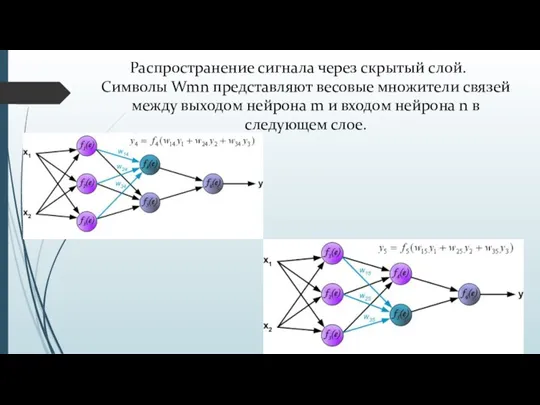

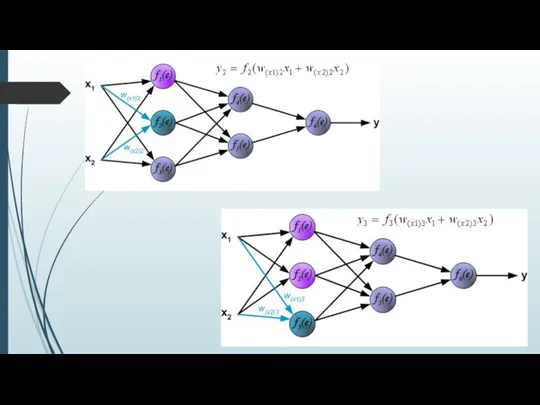

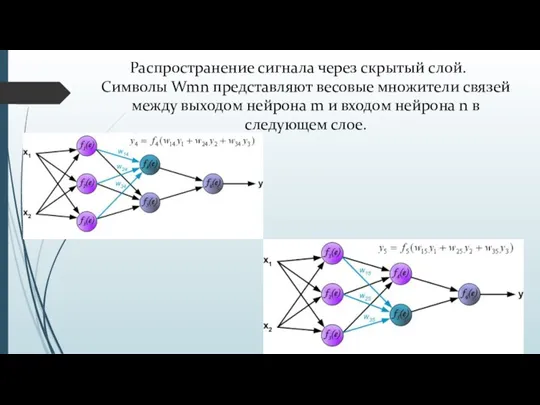

Слайд 6Распространение сигнала через скрытый слой.

Символы Wmn представляют весовые множители связей между выходом нейрона m и входом

нейрона n в следующем слое.

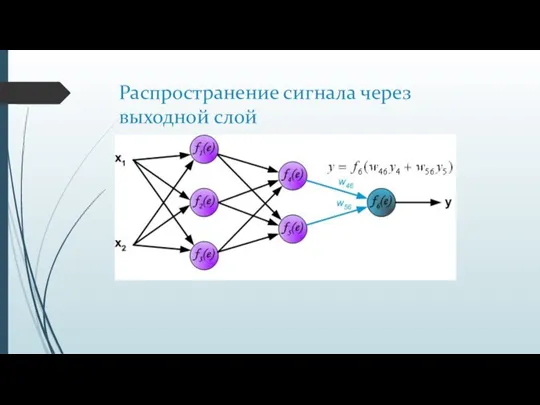

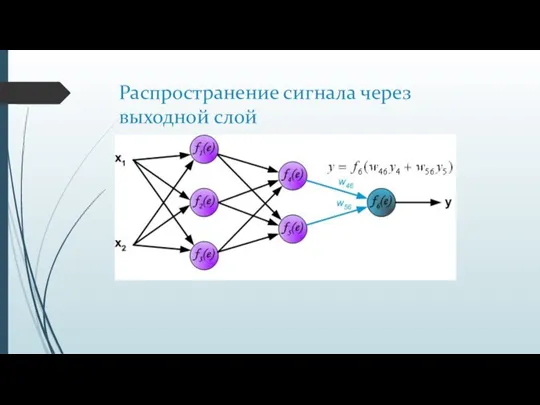

Слайд 7Распространение сигнала через выходной слой

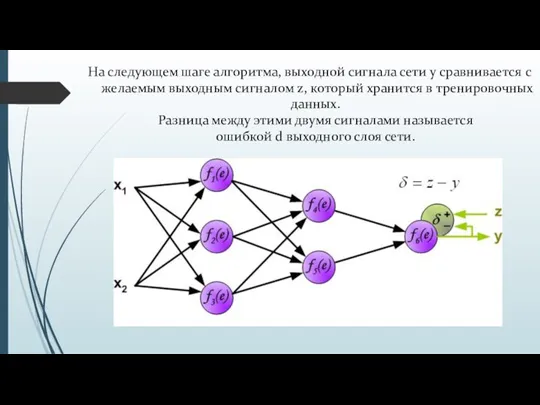

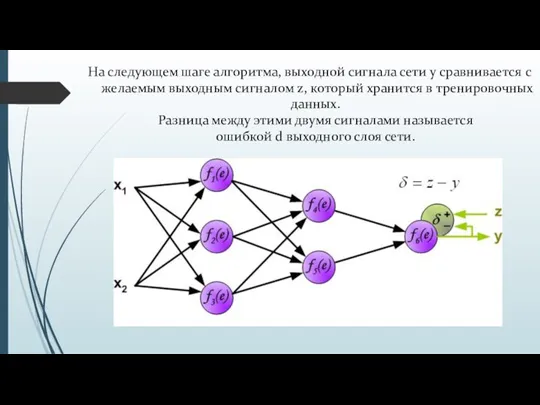

Слайд 8На следующем шаге алгоритма, выходной сигнала сети y сравнивается с желаемым выходным сигналом z, который

хранится в тренировочных данных.

Разница между этими двумя сигналами называется ошибкой d выходного слоя сети.

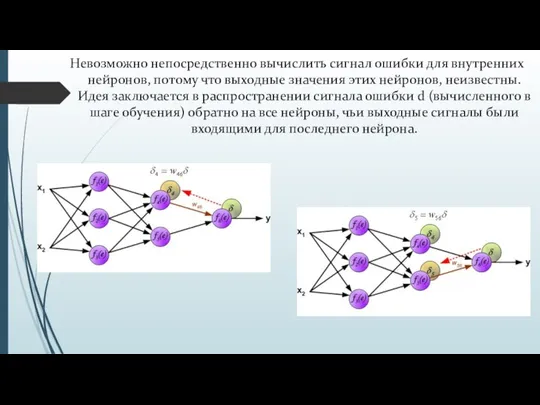

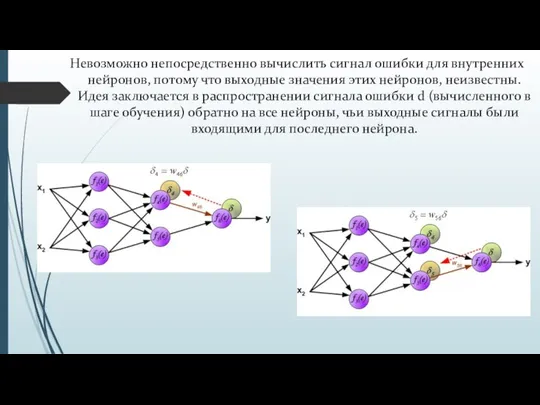

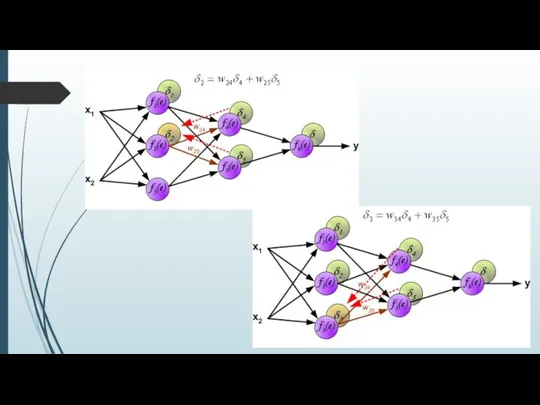

Слайд 9Невозможно непосредственно вычислить сигнал ошибки для внутренних нейронов, потому что выходные значения

этих нейронов, неизвестны.

Идея заключается в распространении сигнала ошибки d (вычисленного в шаге обучения) обратно на все нейроны, чьи выходные сигналы были входящими для последнего нейрона.

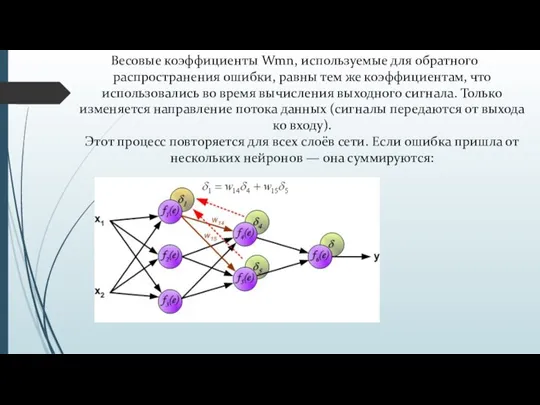

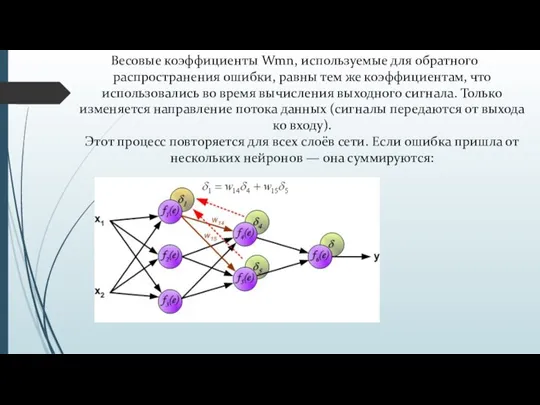

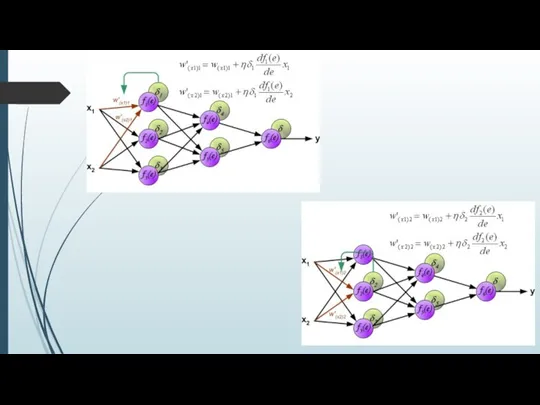

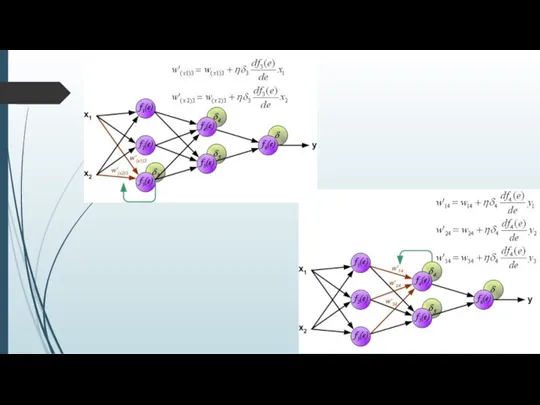

Слайд 10Весовые коэффициенты Wmn, используемые для обратного распространения ошибки, равны тем же коэффициентам, что

использовались во время вычисления выходного сигнала. Только изменяется направление потока данных (сигналы передаются от выхода ко входу).

Этот процесс повторяется для всех слоёв сети. Если ошибка пришла от нескольких нейронов — она суммируются:

Основы Network Access Protection

Основы Network Access Protection Распределение функциональных требований безопасности

Распределение функциональных требований безопасности Обеспечение технологической устойчивости объектов ДЭЗ за счёт внедрения цифровизации и передовых технологий

Обеспечение технологической устойчивости объектов ДЭЗ за счёт внедрения цифровизации и передовых технологий WORD. Работа с таблицей (меню и панель инструментов)

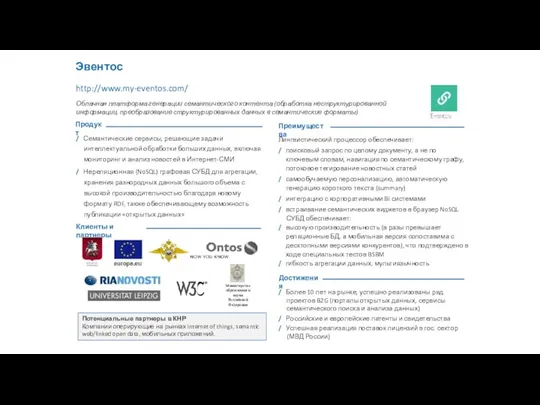

WORD. Работа с таблицей (меню и панель инструментов) Эвентос. Облачная платформа генерации семантического контента

Эвентос. Облачная платформа генерации семантического контента World Wide Web

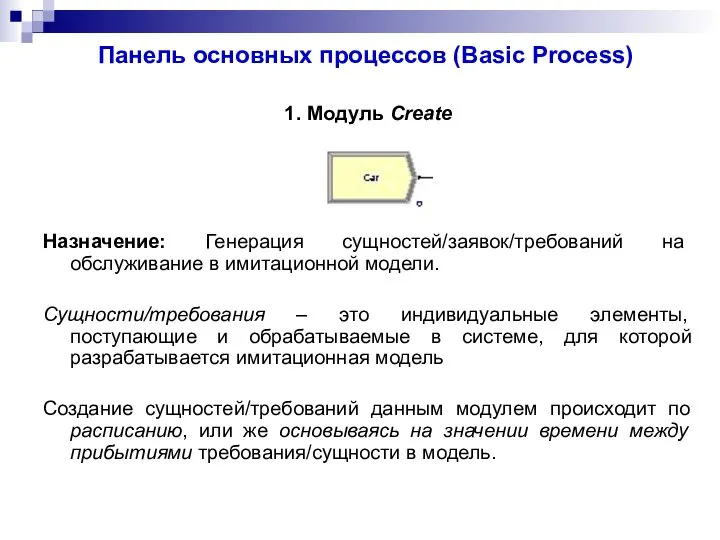

World Wide Web Панель основных процессов (Basic Process)

Панель основных процессов (Basic Process) Заместитель (Proxy) или Сурогат (Surrogate)

Заместитель (Proxy) или Сурогат (Surrogate) Использование Linux при программировании 3

Использование Linux при программировании 3 Конкурс по поиску информации в интернете. Деловая игра

Конкурс по поиску информации в интернете. Деловая игра Android приложение Навигатор первокурсника

Android приложение Навигатор первокурсника Система счисления

Система счисления Введение в HTML. Основы WEB-технологий

Введение в HTML. Основы WEB-технологий Что пишут на C#

Что пишут на C# Операционная система Windows

Операционная система Windows Презентация на тему Внешняя память, её виды

Презентация на тему Внешняя память, её виды  Логические основы ЭВМ

Логические основы ЭВМ Теоретические основы компьютерной безопасности

Теоретические основы компьютерной безопасности Distributed computing and data processing frameworks

Distributed computing and data processing frameworks HDMI конвертеры (AV RCA)

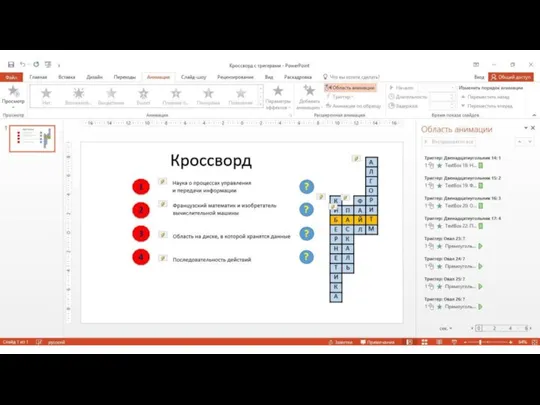

HDMI конвертеры (AV RCA) Кроссворд с триггерами

Кроссворд с триггерами Автоматизированная система удаленного рабочего процесса сотрудников предприятия

Автоматизированная система удаленного рабочего процесса сотрудников предприятия Теория автоматов и формальных языков. Лекция 1

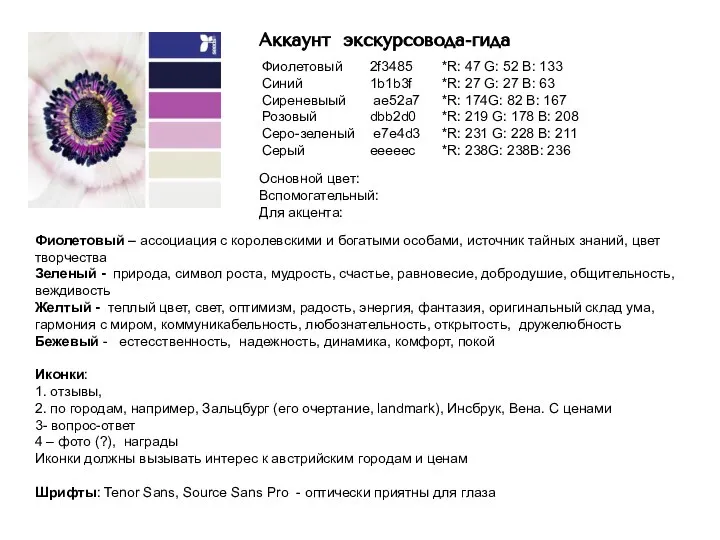

Теория автоматов и формальных языков. Лекция 1 Аккаунт экскурсовода-гида

Аккаунт экскурсовода-гида Digital parenting (цифровое воспитание)

Digital parenting (цифровое воспитание) Презентация на тему Развитие логического мышления на уроках информатики

Презентация на тему Развитие логического мышления на уроках информатики  Программное обеспечение ПК

Программное обеспечение ПК Галамарт | Челябинск-Курган

Галамарт | Челябинск-Курган