Содержание

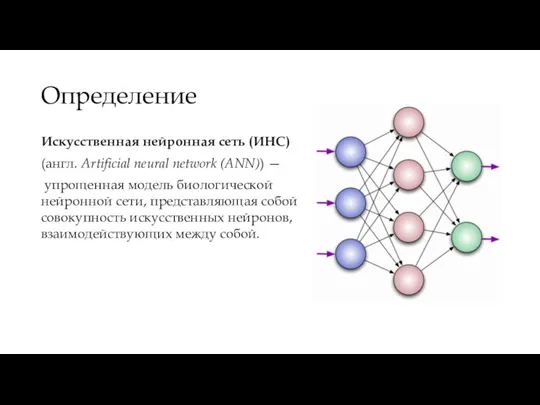

- 2. Определение Искусственная нейронная сеть (ИНС) (англ. Artificial neural network (ANN)) — упрощенная модель биологической нейронной сети,

- 3. Задачи, решаемые нейронными сетями Классификация/распознавание образов. Кластеризация/категоризация Аппроксимация функций. Предсказание/прогноз Оптимизация Ассоциативная память. Управление.

- 4. В общем случае все вышеуказанные задачи, решаемые нейронными сетями, можно свести к двум основным: Задача классификации

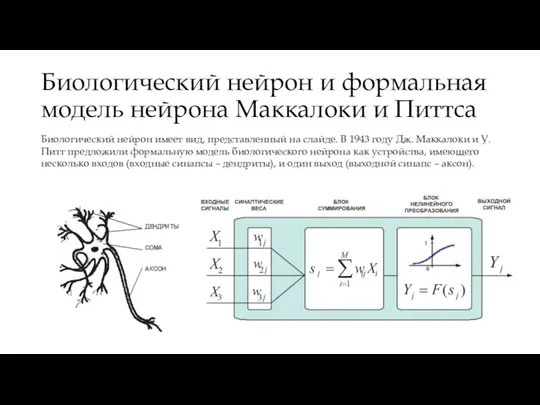

- 5. Биологический нейрон и формальная модель нейрона Маккалоки и Питтса Биологический нейрон имеет вид, представленный на слайде.

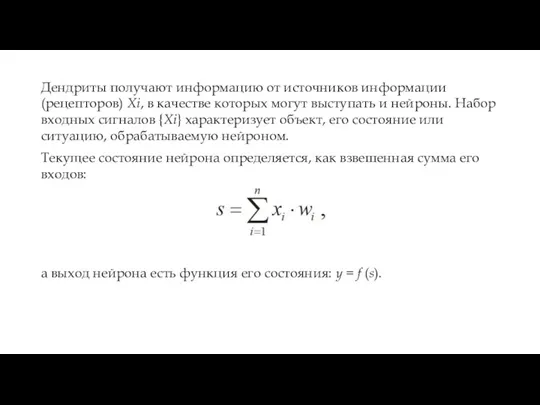

- 6. Дендриты получают информацию от источников информации (рецепторов) Xi, в качестве которых могут выступать и нейроны. Набор

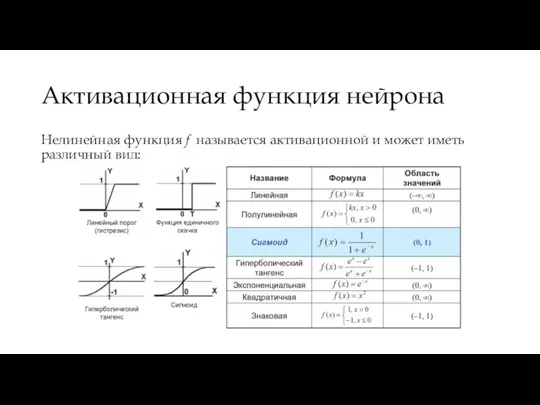

- 7. Активационная функция нейрона Нелинейная функция f называется активационной и может иметь различный вид:

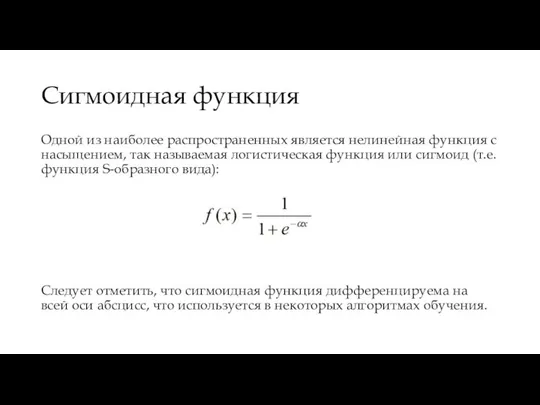

- 8. Сигмоидная функция Одной из наиболее распространенных является нелинейная функция с насыщением, так называемая логистическая функция или

- 9. Простейшая нейронная сеть

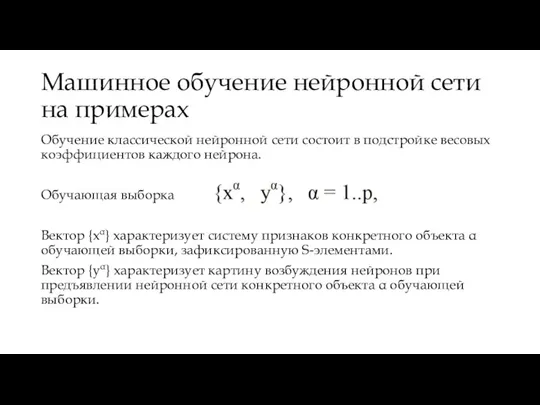

- 10. Машинное обучение нейронной сети на примерах Обучение классической нейронной сети состоит в подстройке весовых коэффициентов каждого

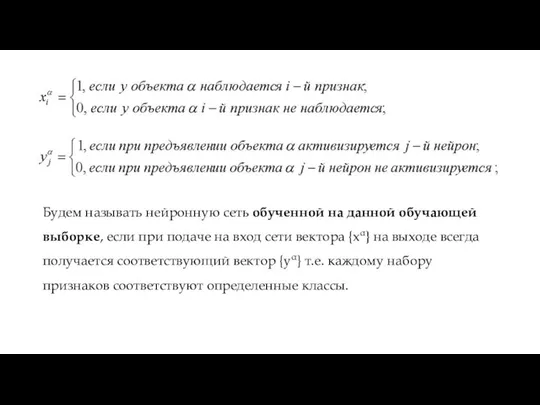

- 11. Будем называть нейронную сеть обученной на данной обучающей выборке, если при подаче на вход сети вектора

- 12. Итерационный алгоритм обучения НС Шаг 0: Начальные значения весов всех нейронов полагаются случайными. Шаг 1: Сети

- 13. Итерационный алгоритм обучения НС Шаг 3: Вектора весовых коэффициентов корректируются таким образом, что величина корректировки пропорциональна

- 14. Итерационный алгоритм обучения НС Шаг 4: Шаги 1-3 повторяются для всех обучающих векторов. Один цикл последовательного

- 16. Скачать презентацию

Приложение для сортировки аудиофайлов

Приложение для сортировки аудиофайлов Инструкция по пользованию moodle

Инструкция по пользованию moodle Приложения, использующие децентрализованную систему

Приложения, использующие децентрализованную систему Как зарегистрироваться на конкурс

Как зарегистрироваться на конкурс Frontend. Основные теги

Frontend. Основные теги Современные веб-технологии. Лекция 2.1

Современные веб-технологии. Лекция 2.1 Построение биоритма человека в среде электронного процессора

Построение биоритма человека в среде электронного процессора Аддитивные технологии

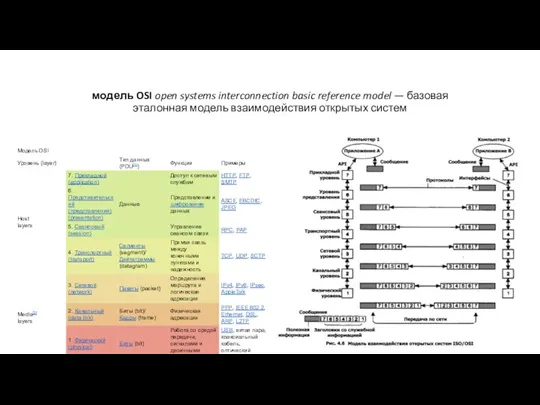

Аддитивные технологии Модель OSI

Модель OSI Табличные информационные модели

Табличные информационные модели Информатика и компьютерная графика

Информатика и компьютерная графика Интерактивная система помощи иностранным студентам

Интерактивная система помощи иностранным студентам Книжный блог в INSTAGRAM как средство воспитания современного читателя

Книжный блог в INSTAGRAM как средство воспитания современного читателя Программирование (C++)

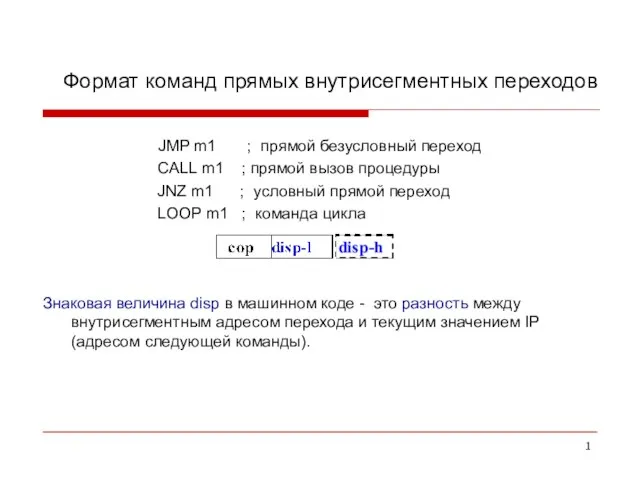

Программирование (C++) Форматы команд процессора. (Лекция 19.2)

Форматы команд процессора. (Лекция 19.2) Уменьшение файлов в размере

Уменьшение файлов в размере Добавлення інформації

Добавлення інформації Эскизное проектирование автоматизированной подсистемы отдела учета запчастей

Эскизное проектирование автоматизированной подсистемы отдела учета запчастей Создание веб-страниц в Word

Создание веб-страниц в Word Программирование на языке Си#. Форма

Программирование на языке Си#. Форма Дизайн пони

Дизайн пони Социальный проект Мотивация к обучению информатике группы 71-16 в последнюю неделю перед практикой

Социальный проект Мотивация к обучению информатике группы 71-16 в последнюю неделю перед практикой Будни Интернета: война ботов

Будни Интернета: война ботов Концепт непрерывного мира в игровой разработке

Концепт непрерывного мира в игровой разработке Криптография и шифрование

Криптография и шифрование Учебно-ознакомительная практика в пресс-службе ПГНИУ

Учебно-ознакомительная практика в пресс-службе ПГНИУ Чем и как полезен интернет?

Чем и как полезен интернет? Знакомство с Векторным редактором, встроеннЫм в WORD 2007

Знакомство с Векторным редактором, встроеннЫм в WORD 2007