Статистические методы в искусственном интеллекте. Предсказание. Наивный Байесовский алгоритм и реализация Байесовского выражения

Содержание

- 2. Представьте себе следующую ситуацию: вы работаете над задачей классификации, уже создали набор гипотез и сформировали признаки.

- 3. Содержание Что такое наивный байесовский алгоритм? Как он работает? Положительные и отрицательные. 4 приложения наивного байесовского

- 4. Что такое наивный байесовский алгоритм? Наивный байесовский алгоритм – это алгоритм классификации, основанный на теореме Байеса

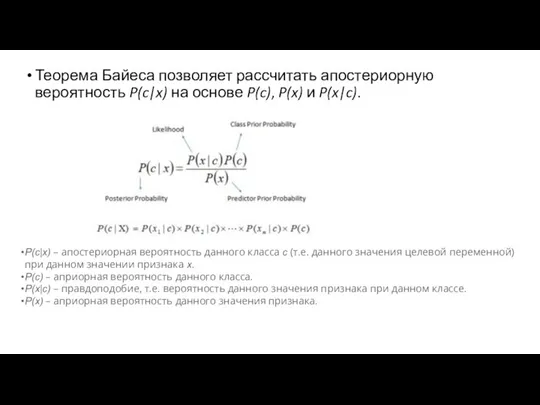

- 5. Теорема Байеса позволяет рассчитать апостериорную вероятность P(c|x) на основе P(c), P(x) и P(x|c). P(c|x) – апостериорная

- 6. Как работает наивный байесовский алгоритм? Давайте рассмотрим пример. Ниже представлен обучающий набор данных, содержащий один признак

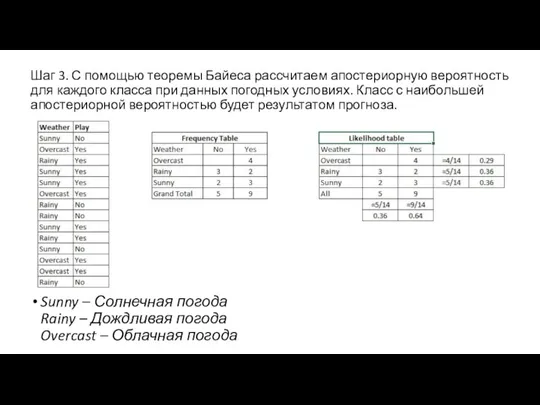

- 7. Шаг 3. С помощью теоремы Байеса рассчитаем апостериорную вероятность для каждого класса при данных погодных условиях.

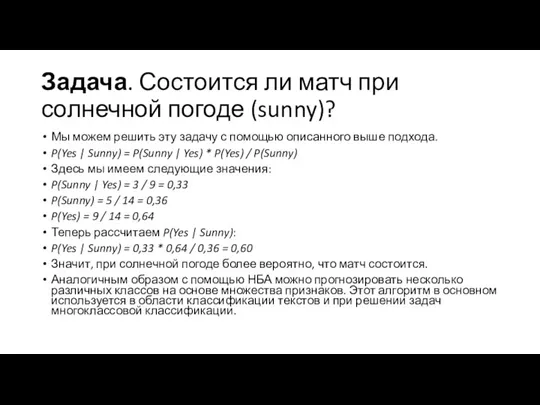

- 8. Задача. Состоится ли матч при солнечной погоде (sunny)? Мы можем решить эту задачу с помощью описанного

- 9. Положительные и отрицательные стороны наивного байесовского алгоритма Положительные стороны: Классификация, в том числе многоклассовая, выполняется легко

- 10. Отрицательные стороны: Если в тестовом наборе данных присутствует некоторое значение категорийного признака, которое не встречалось в

- 11. 4 приложения наивного байесовского алгоритма Классификация в режиме реального времени. НБА очень быстро обучается, поэтому его

- 12. Как создать базовую модель на основе наивного байесовского алгоритма с помощью Python? В этом нам поможет

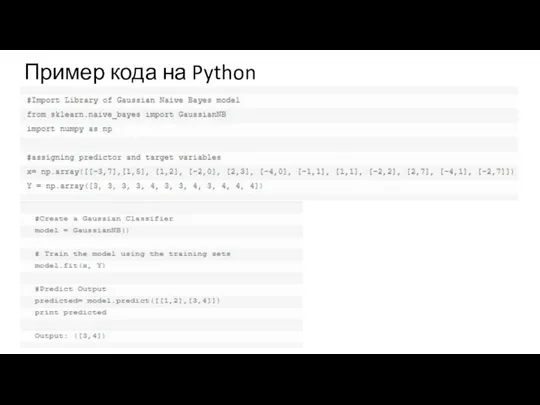

- 13. Пример кода на Python

- 14. Пример: Байесовский классификатор относится к разряду машинного обучения. Суть такова: система, перед которой стоит задача определить,

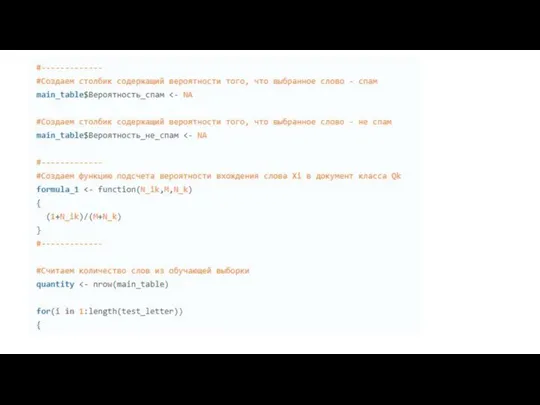

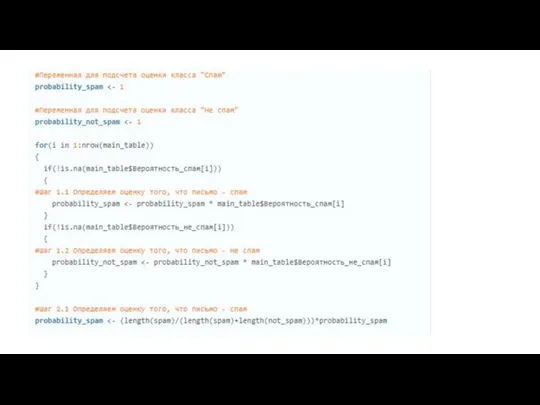

- 15. Необходимо рассчитать оценку для каждого класса (спам/не спам) и выбрать ту, которая получилась максимальной. Для этого

- 16. Когда объем текста очень большой, приходится работать с очень маленькими числами. Для того чтобы этого избежать,

- 17. *Во время выполнения подсчетов вам может встретиться слово, которого не было на этапе обучения системы. Это

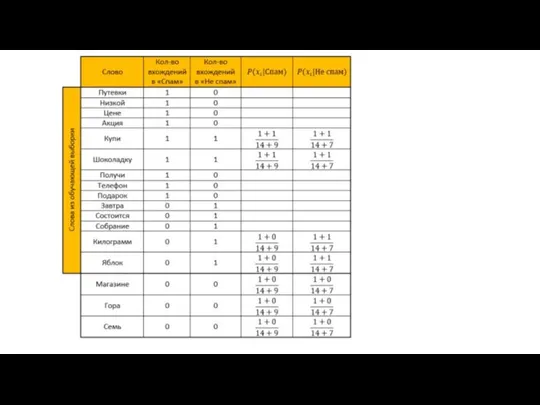

- 18. От теории к практике Пусть наша система обучалась на следующих письмам, заранее известных где «спам», а

- 19. Задание: определить, к какой категории отнести следующее письмо: «В магазине гора яблок. Купи семь килограмм и

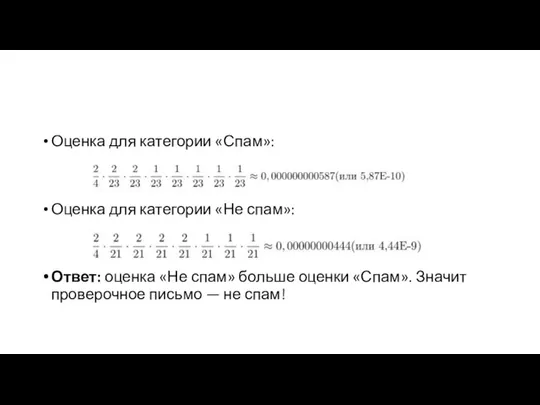

- 21. Оценка для категории «Спам»: Оценка для категории «Не спам»: Ответ: оценка «Не спам» больше оценки «Спам».

- 22. То же самое рассчитаем и с помощью функции, преобразованной по свойству логарифма: Оценка для категории «Спам»:

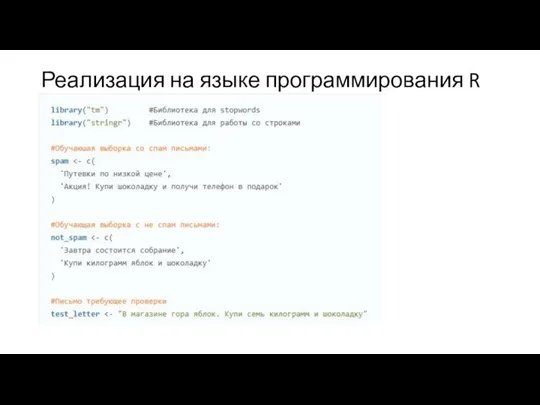

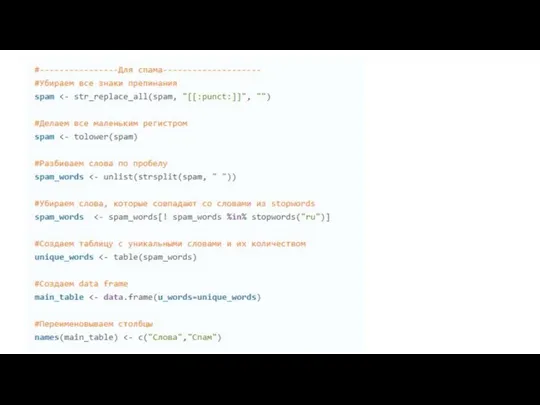

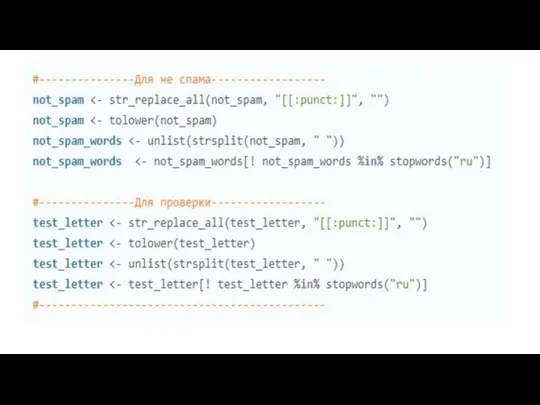

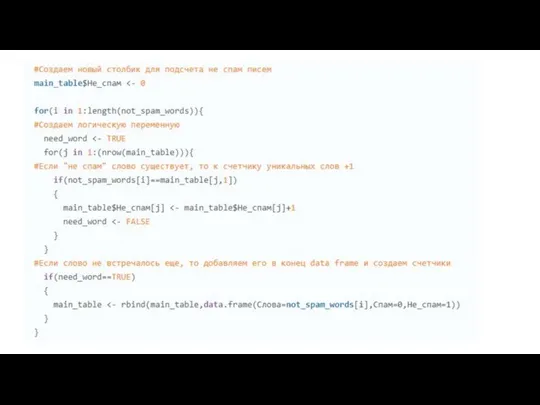

- 23. Реализация на языке программирования R

- 28. #Используем ту же логическую переменную, чтобы не создавать новую need_word for(j in 1:nrow(main_table)) { #Если слово

- 31. Скачать презентацию

Планшет. История планшета

Планшет. История планшета Сайты Лекция 6.10

Сайты Лекция 6.10 Эвристические комбинаторные алгоритмы

Эвристические комбинаторные алгоритмы

Примеры решения задач

Примеры решения задач klientskaya_prezentacziya_tarif_bez_zatrat_sentyabr_2022

klientskaya_prezentacziya_tarif_bez_zatrat_sentyabr_2022 Морской бой. Игра

Морской бой. Игра Неочевидные способы потерять свои деньги в криптовалюте

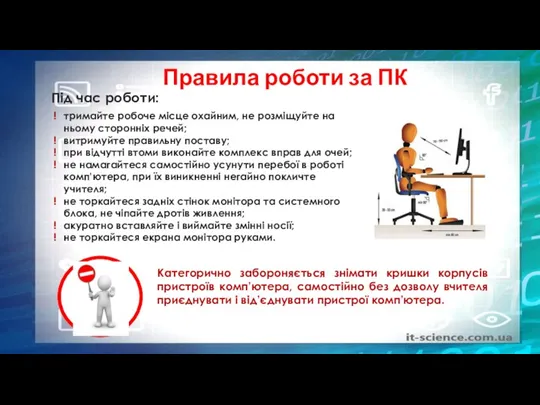

Неочевидные способы потерять свои деньги в криптовалюте Інформатика 9 клас. Урок 1

Інформатика 9 клас. Урок 1 15 минут про тиндер-сюрприз

15 минут про тиндер-сюрприз Преобразование форматов данных

Преобразование форматов данных Термины. Лекция 14

Термины. Лекция 14 Тестирование UI/UX

Тестирование UI/UX Редактор формул

Редактор формул Вірусы і антывірусныя праграмы

Вірусы і антывірусныя праграмы Информация и информационные процессы

Информация и информационные процессы Средства организации чертежа в САПР. Слои и свойства объектов

Средства организации чертежа в САПР. Слои и свойства объектов Единицы измерения информации

Единицы измерения информации Программа Tinkercad и сервис Circuits. Практическая работа № 2

Программа Tinkercad и сервис Circuits. Практическая работа № 2 Сравнительный анализ дизайна интернет-сайтов

Сравнительный анализ дизайна интернет-сайтов Введение, классификация сетей. Лекция 1

Введение, классификация сетей. Лекция 1 Интернет-магазин товаров для здоровья и красоты AltaiMag

Интернет-магазин товаров для здоровья и красоты AltaiMag Элементы алгебры логики. Математические основы информатики

Элементы алгебры логики. Математические основы информатики Изображение и графический редактор

Изображение и графический редактор Словарь для бизнес школы. Проект

Словарь для бизнес школы. Проект Информатика. Сжатие данных

Информатика. Сжатие данных ESET NOD32 Antivirus

ESET NOD32 Antivirus Захват файлов и записей

Захват файлов и записей