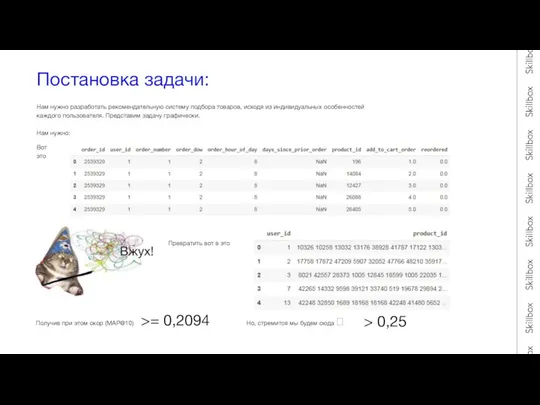

кол-во купленных за всю историю продуктов. В результате будем иметь для каждого пользователя такую картину: Повторим эту операцию 100 000 раз (для каждого пользователя) и преобразовав к итоговому виду, получим скор 0.27841.

Это будет наш эталон, к нему мы будем стремиться, однако мы не можем назвать такой подход рекомендательной системой, ведь мы ничего нового не предлагаем пользователю, а принимаем в учет только те товары, про которые он сам прекрасно знает и, более того, любит, т к это его топ.

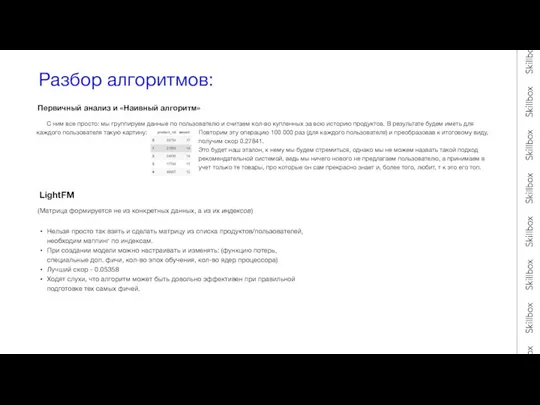

LightFM

(Матрица формируется не из конкретных данных, а из их индексов)

Нельзя просто так взять и сделать матрицу из списка продуктов/пользователей, необходим маппинг по индексам.

При создании модели можно настраивать и изменять: (функцию потерь, специальные доп. фичи, кол-во эпох обучения, кол-во ядер процессора)

Лучший скор - 0.05358

Ходят слухи, что алгоритм может быть довольно эффективен при правильной подготовке тех самых фичей.

Первичный анализ и «Наивный алгоритм»

Презентация на тему Олимпийские игры в Москве 1980

Презентация на тему Олимпийские игры в Москве 1980  Национализм как политическая идеология

Национализм как политическая идеология Презентация на тему Решение задач на нахождение площади поверхности и объемов тел вращения

Презентация на тему Решение задач на нахождение площади поверхности и объемов тел вращения  Moderní cukrovar HROCHŮV TÝNEC

Moderní cukrovar HROCHŮV TÝNEC Система работы учителя математики с родителями при подготовке учащихся к государственной итоговой аттестации в форме ЕГЭ

Система работы учителя математики с родителями при подготовке учащихся к государственной итоговой аттестации в форме ЕГЭ Внешняя политика Александра I в 1801-1812 гг.

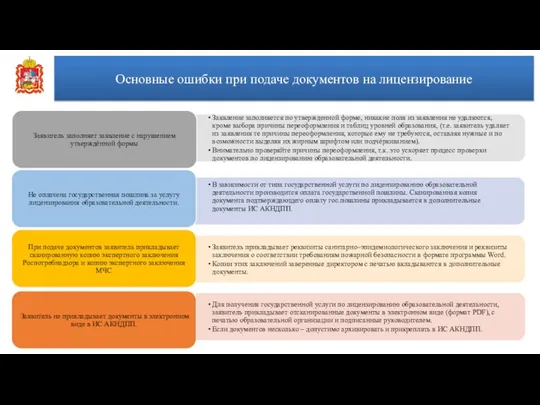

Внешняя политика Александра I в 1801-1812 гг. Основные ошибки при подаче документов на лицензирование

Основные ошибки при подаче документов на лицензирование Презентация на тему Изобразительное искусство классицизма и рококо

Презентация на тему Изобразительное искусство классицизма и рококо КИНЕШМА

КИНЕШМА Обработка нижнего среза изделия

Обработка нижнего среза изделия Педагогическая практика организации внеурочной и внеклассной деятельности

Педагогическая практика организации внеурочной и внеклассной деятельности Положение об общественном совете муниципального образования Северодвинск

Положение об общественном совете муниципального образования Северодвинск Луи , ПАСТЕР (Pasteur)

Луи , ПАСТЕР (Pasteur) Хохломская роспись

Хохломская роспись Горячая линия

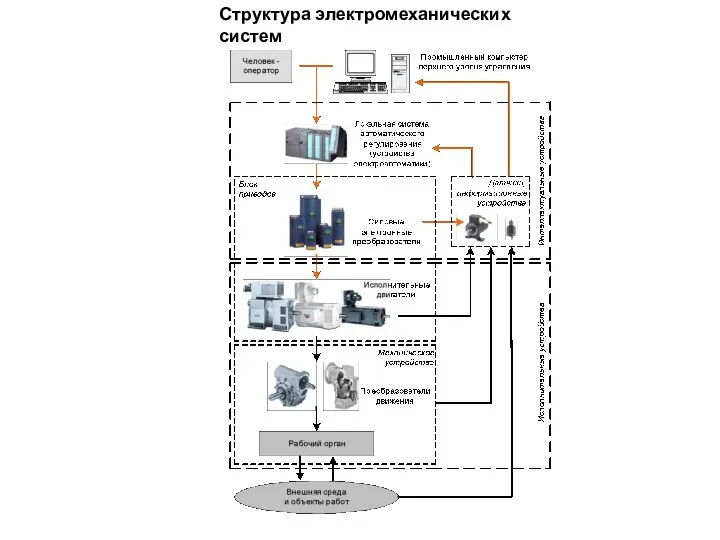

Горячая линия Структура электромеханических систем

Структура электромеханических систем Характер человека

Характер человека Преодоление сложностей при запоминании таблицы умножения

Преодоление сложностей при запоминании таблицы умножения Презентация на тему Юридическая клиника в кыргызско-российском славянском университете имени Бориса Ельцина

Презентация на тему Юридическая клиника в кыргызско-российском славянском университете имени Бориса Ельцина  Презентация на тему Военно-патриотическое воспитание

Презентация на тему Военно-патриотическое воспитание Обобщающий урок во 2 классе

Обобщающий урок во 2 классе Дистрибуция прессы в сети супермаркетов в России. Тенденции и перспективы развития.

Дистрибуция прессы в сети супермаркетов в России. Тенденции и перспективы развития. Использование 3D технологии в медицине

Использование 3D технологии в медицине Кружок робототехники

Кружок робототехники Война за независимость США

Война за независимость США Современная теория фотосинтеза

Современная теория фотосинтеза Программный комплекс «Карат» предназначен для создания в базе данных показателей любого типа, ручного ввода или автоматической п

Программный комплекс «Карат» предназначен для создания в базе данных показателей любого типа, ручного ввода или автоматической п Prezentacia_лекція_10-1_ТЕК (3)

Prezentacia_лекція_10-1_ТЕК (3)