Содержание

- 2. Содержание Вычислительные мощности Лаборатории суперкомпьютерного моделирования (ЛСМ) СКИФ Урал СКИФ Аврора Проекты ЛСМ, с хранением и

- 3. Динамика развития суперкомпьютерных мощностей в ЮУрГУ Суперкомпьютер СКИФ-Аврора ЮУрГУ Пиковая производительность 117.6 Teraflops 2010 г. Вычислительный

- 4. Кластер СКИФ Урал Число вычислительных узлов/процессоров/ядер: 166/332/1328 Тип процессора: Intel Xeon E5472 (4 ядра по 3.0

- 5. Суперкомпьютер СКИФ Аврора 4 планируемое место в рейтинге СНГ ТОР50 70 планируемое место в рейтинге TOP500

- 6. Параллельная система хранения Panasas ActiveStorage 5100 20Тб Производительное хранилище данных с архитектурой NAS, разработанное специально для

- 7. Проект PargreSQL Внедрение параллелизма в свободную последовательную СУБД PostreSQL СХД, 22-мар-11 Организация систем хранения на базе

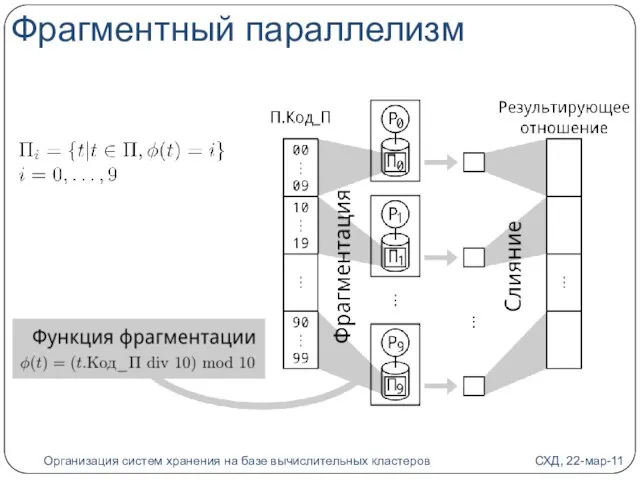

- 8. Фрагментный параллелизм СХД, 22-мар-11 Организация систем хранения на базе вычислительных кластеров

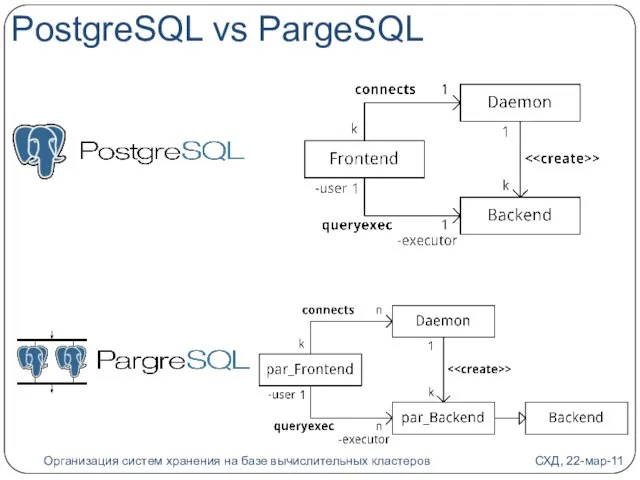

- 9. PostgreSQL vs PargeSQL СХД, 22-мар-11 Организация систем хранения на базе вычислительных кластеров

- 10. Проект MedMining Параллельная система сбора, накопления и анализа данных по эффективному использованию ресурсов человека при предельных

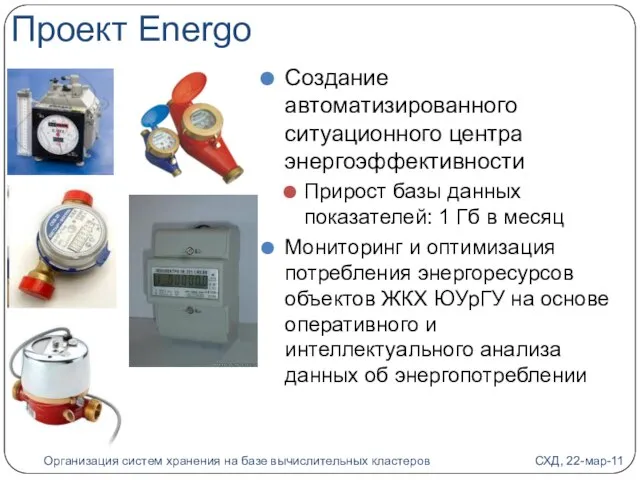

- 11. Проект Energo Создание автоматизированного ситуационного центра энергоэффективности Прирост базы данных показателей: 1 Гб в месяц Мониторинг

- 12. Проект VideoStorm Разработка параллельной системы управления видеоархивом телеканала ЮУрГУ-ТВ Хранение сырого, монтированного и сжатого видео Прирост

- 14. Скачать презентацию

Презентация на тему Болезни Земли

Презентация на тему Болезни Земли Лес – природное сообщество

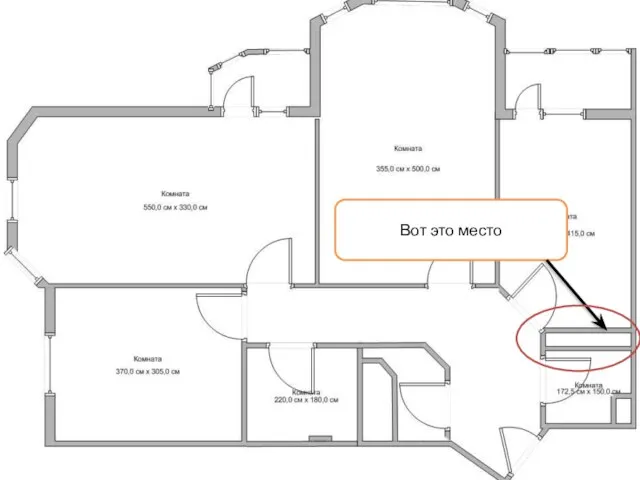

Лес – природное сообщество Вот это место

Вот это место Рекомендации по поддержке/коррекции имиджа с применением маркетинговых инструментов, брендинга, инструментов международного PR

Рекомендации по поддержке/коррекции имиджа с применением маркетинговых инструментов, брендинга, инструментов международного PR Презентация на тему Термины по обществознанию 6 класс

Презентация на тему Термины по обществознанию 6 класс Курение или здоровье -выбирайте сами!

Курение или здоровье -выбирайте сами! Поверхностное и коренное улучшение сенокосов и пастбищ

Поверхностное и коренное улучшение сенокосов и пастбищ Празнование нового года в Англии

Празнование нового года в Англии Биохимический состав плазмы крови

Биохимический состав плазмы крови «Применение производной и ознакомление с её прикладной частью ».

«Применение производной и ознакомление с её прикладной частью ». Техника графики

Техника графики ЧИСЛЕННЫЕ ИССЛЕДОВАНИЯ ТРЕХСЕКТОРНОЙ ИМИТАЦИОННОЙ МОДЕЛИ ОБЩЕГО РАВНОВЕСИЯ С ТЕНЕВЫМ ОБОРОТОМ

ЧИСЛЕННЫЕ ИССЛЕДОВАНИЯ ТРЕХСЕКТОРНОЙ ИМИТАЦИОННОЙ МОДЕЛИ ОБЩЕГО РАВНОВЕСИЯ С ТЕНЕВЫМ ОБОРОТОМ Внеигровые мероприятия в Российском университет

Внеигровые мероприятия в Российском университет Португалия

Португалия История развития спорта в посёлке Чернёво

История развития спорта в посёлке Чернёво Урок по творчеству шведской писательницы А.Линдгрен.

Урок по творчеству шведской писательницы А.Линдгрен. Предложение Группы компаний SIS для СТАДИОНОВ

Предложение Группы компаний SIS для СТАДИОНОВ Самый вкусный и ароматный бизнес

Самый вкусный и ароматный бизнес Классы органических веществ

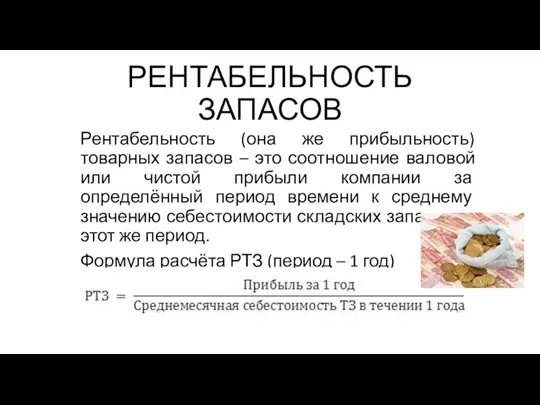

Классы органических веществ Рентабельность запасов

Рентабельность запасов Органические вещества живых организмов

Органические вещества живых организмов Презентация на тему Экологические факторы

Презентация на тему Экологические факторы Презентация на тему Динозавры

Презентация на тему Динозавры Михаил Васильевич Ломоносов(1711-1765)Ученый, поэт.

Михаил Васильевич Ломоносов(1711-1765)Ученый, поэт. Презентация на тему Военная техника

Презентация на тему Военная техника Тест-тренажер: «НРАВСТВЕННОЕ СОЗНАНИЕ» Автор: Назаретьянц Надежда Хачатуровна, педагог-психолог высшей квалификационной категор

Тест-тренажер: «НРАВСТВЕННОЕ СОЗНАНИЕ» Автор: Назаретьянц Надежда Хачатуровна, педагог-психолог высшей квалификационной категор РЕЧЕВОЙ ЭТИКЕТ

РЕЧЕВОЙ ЭТИКЕТ Город Юрьев-Польский – это край родной!

Город Юрьев-Польский – это край родной!