Содержание

- 2. Затронутые темы Многомерный анализ данных Понятие о дескрипторном пространстве, химическом расстоянии Понятие о дискриминантном и кластерном

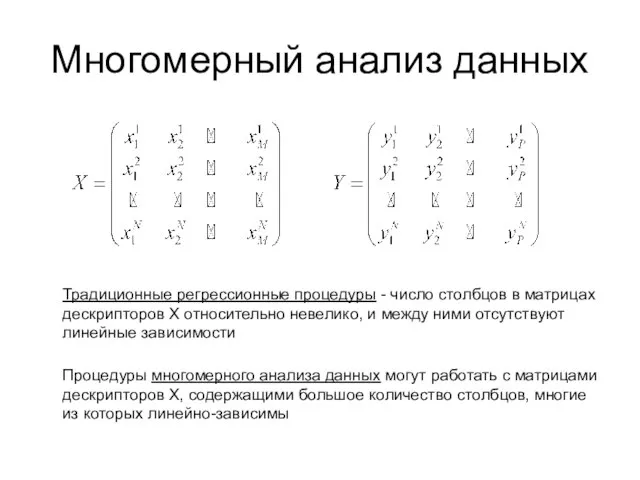

- 3. Многомерный анализ данных Традиционные регрессионные процедуры - число столбцов в матрицах дескрипторов X относительно невелико, и

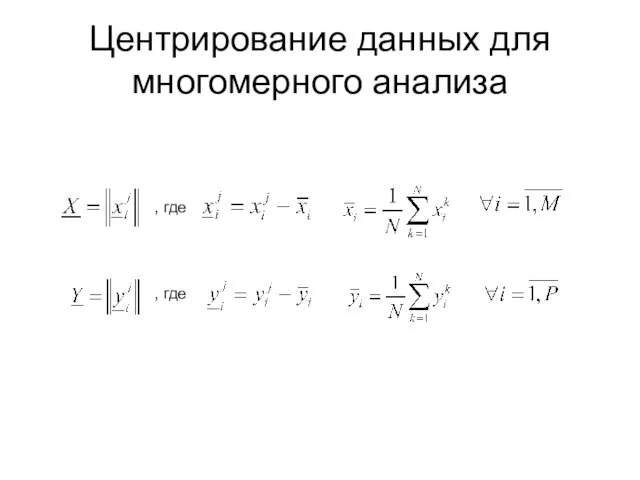

- 4. Центрирование данных для многомерного анализа , где , где

- 5. Дескрипторное пространство (пространство признаков, feature space, M-пространство) Оси x1, x2 – дескрипторы, точки x1, x2 –

- 6. Пространство соединений (пространство объектов, object space, N-пространство) Оси x1, x2 – соединения, вектора x1, x2 –

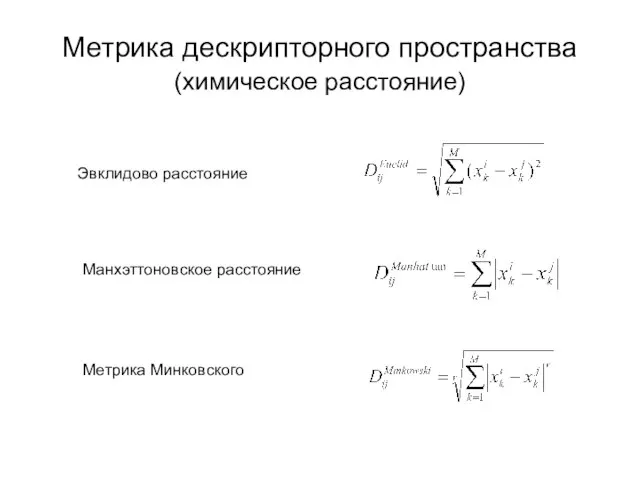

- 7. Метрика дескрипторного пространства (химическое расстояние) Эвклидово расстояние Манхэттоновское расстояние Метрика Минковского

- 8. Принцип сходства (Similarity Principle) Постулируется принцип: структурно близкие химические соединения обладают сходными свойствами Предполагается, что всегда

- 9. Дискриминантный анализ активное соединение неактивное соединение

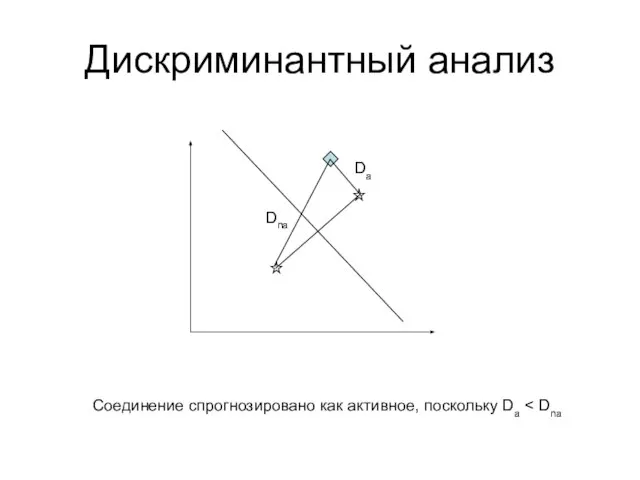

- 10. Дискриминантный анализ Da Dna Соединение спрогнозировано как активное, поскольку Da

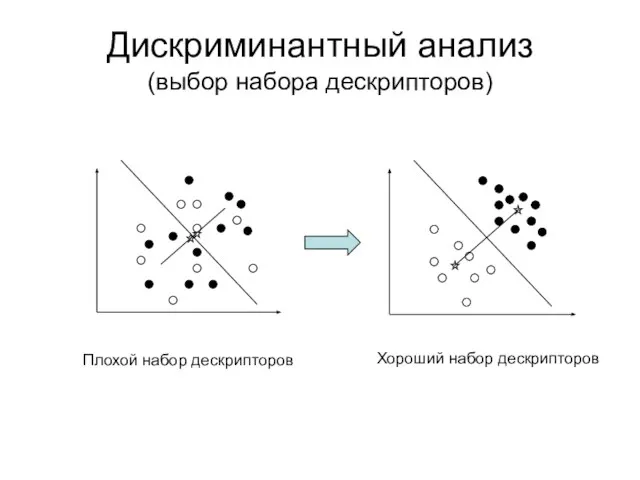

- 11. Дискриминантный анализ (выбор набора дескрипторов) Плохой набор дескрипторов Хороший набор дескрипторов

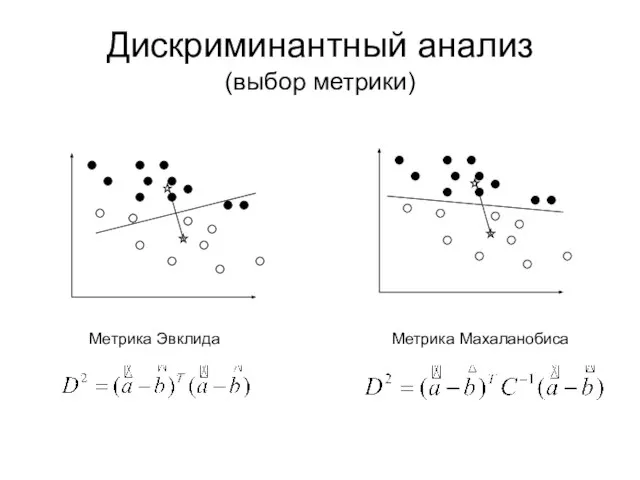

- 12. Дискриминантный анализ (выбор метрики) Метрика Эвклида Метрика Махаланобиса

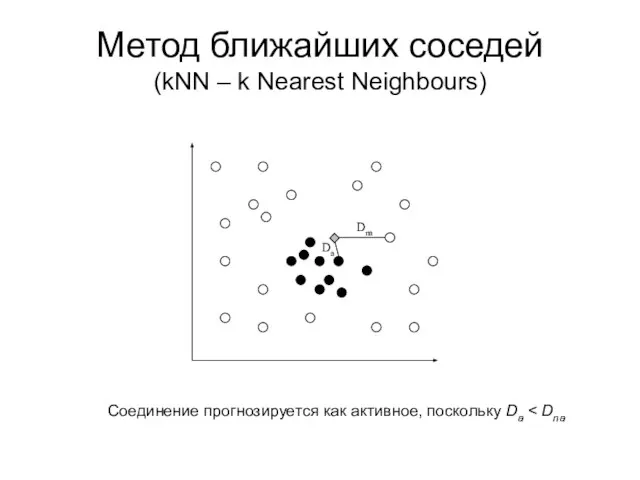

- 13. Метод ближайших соседей (kNN – k Nearest Neighbours) Соединение прогнозируется как активное, поскольку Da

- 14. Кластерный анализ Задача кластерного анализа – изучение внутренней структуры и выявление группировки данных Дендограмма

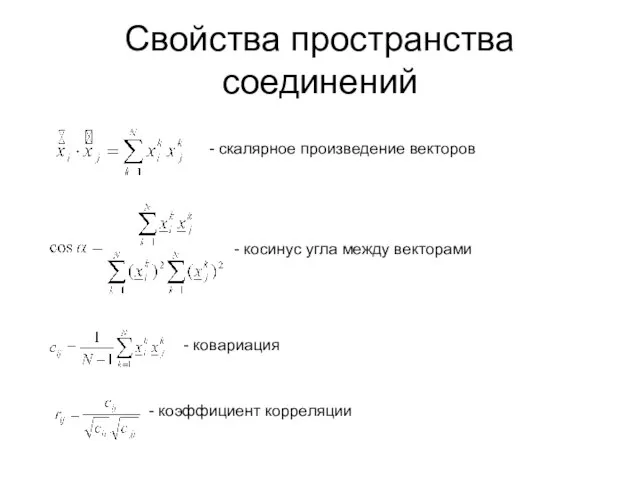

- 15. Свойства пространства соединений - скалярное произведение векторов - косинус угла между векторами - ковариация - коэффициент

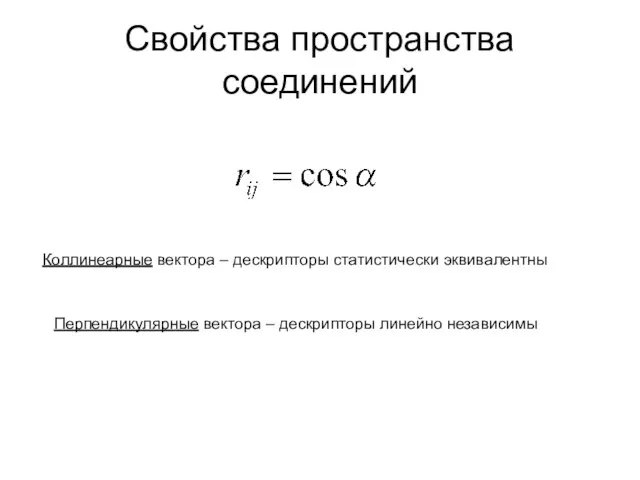

- 16. Свойства пространства соединений Коллинеарные вектора – дескрипторы статистически эквивалентны Перпендикулярные вектора – дескрипторы линейно независимы

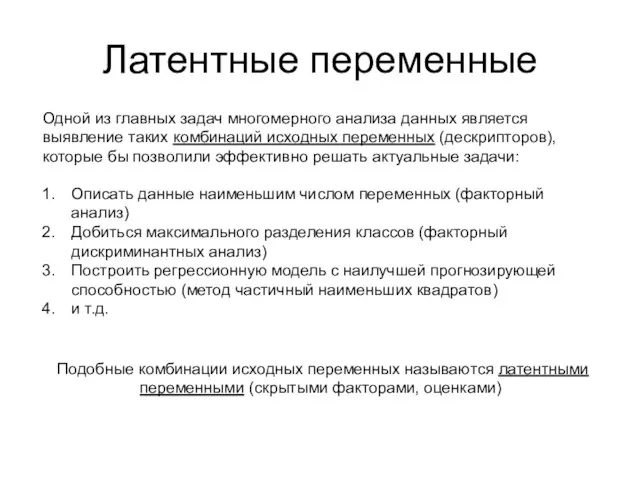

- 17. Латентные переменные Одной из главных задач многомерного анализа данных является выявление таких комбинаций исходных переменных (дескрипторов),

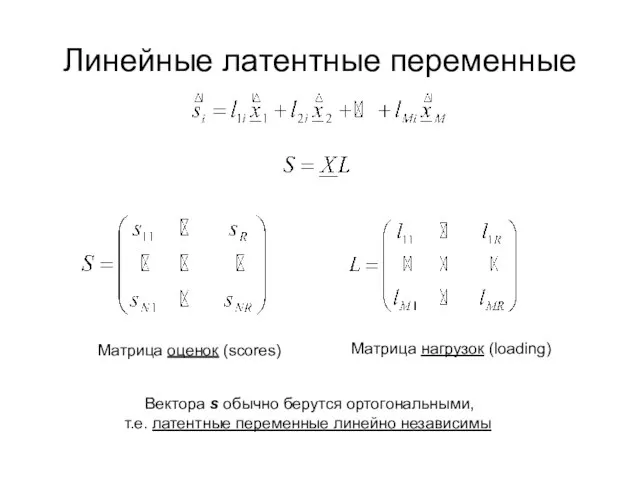

- 18. Линейные латентные переменные Матрица оценок (scores) Матрица нагрузок (loading) Вектора s обычно берутся ортогональными, т.е. латентные

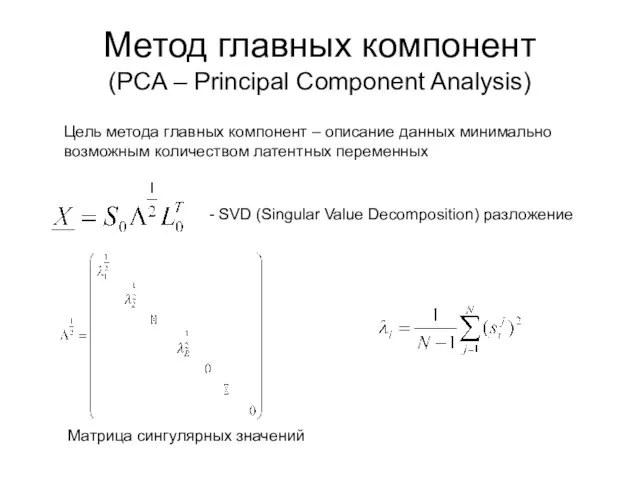

- 19. Метод главных компонент (PCA – Principal Component Analysis) Цель метода главных компонент – описание данных минимально

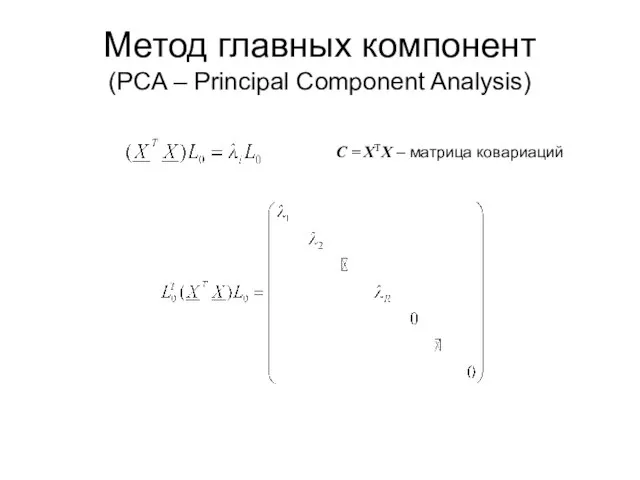

- 20. Метод главных компонент (PCA – Principal Component Analysis) C = XTX – матрица ковариаций

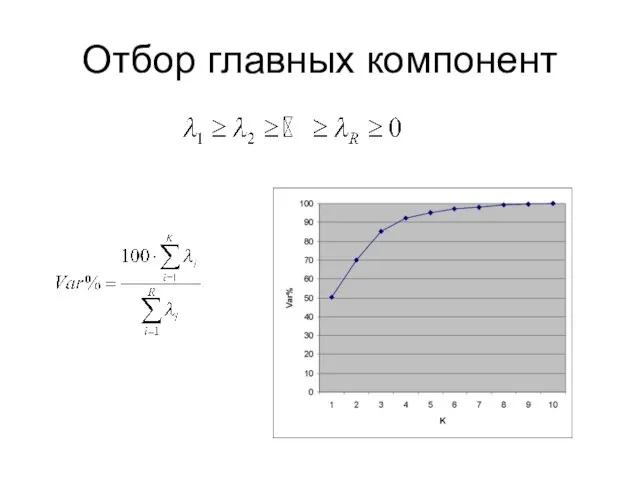

- 21. Отбор главных компонент

- 22. Главные компоненты

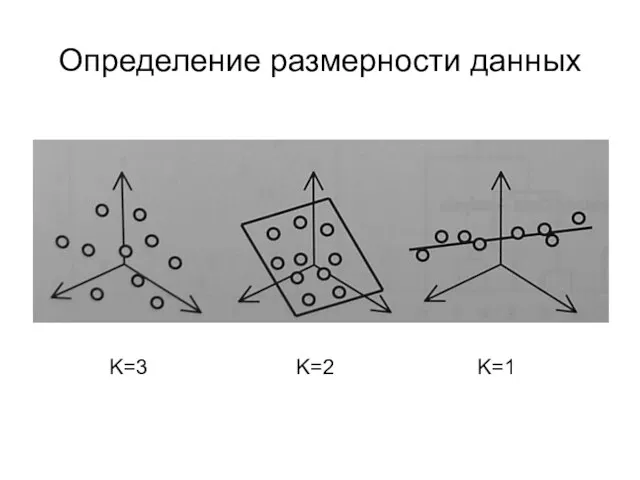

- 23. Определение размерности данных K=3 K=2 K=1

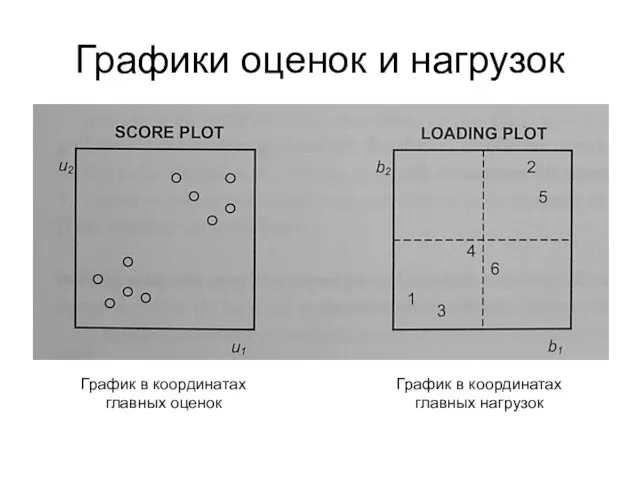

- 24. Графики оценок и нагрузок График в координатах главных оценок График в координатах главных нагрузок

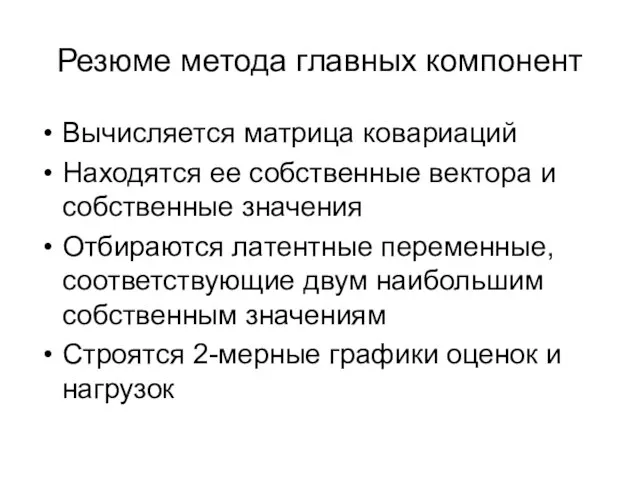

- 25. Резюме метода главных компонент Вычисляется матрица ковариаций Находятся ее собственные вектора и собственные значения Отбираются латентные

- 26. Факторный анализ Определяется число латентных переменных, необходимых для воспроизведения данных с заданной точностью Путем вращения векторов

- 27. Факторный (канонический) дискриминантный анализ Ищутся латентные переменные, позволяющие получить наилучшее разделение классов путем максимизации отношения межгрупповой

- 28. Метод частичных наименьших квадратов (PLS – Partial Least Squares) В методе частичных наименьших квадратов ищется набор

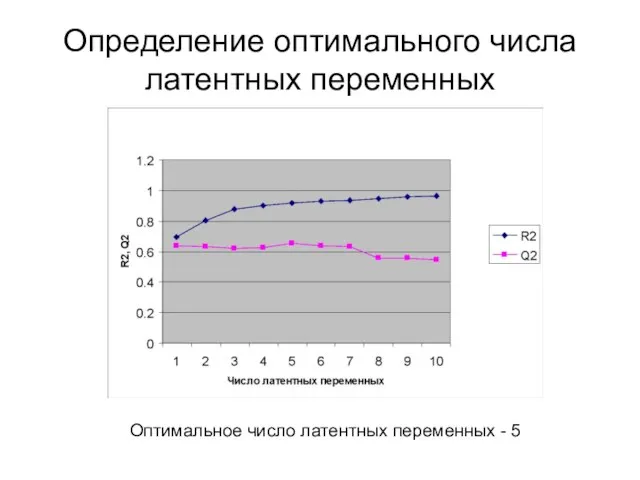

- 29. Определение оптимального числа латентных переменных Оптимальное число латентных переменных - 5

- 31. Скачать презентацию

Закон радиоактивного распада

Закон радиоактивного распада Тема 1.PR в пространстве маркетинга

Тема 1.PR в пространстве маркетинга Об итогах работы промышленного комплекса Курской области в январе-июле 2021 года

Об итогах работы промышленного комплекса Курской области в январе-июле 2021 года Австралия

Австралия Итоги работы дерматовенерологической службы Иркутской области за 2009 год, основные проблемы, пути решения, задачи на 2010 год.

Итоги работы дерматовенерологической службы Иркутской области за 2009 год, основные проблемы, пути решения, задачи на 2010 год. О формировании системы технического регулирования Таможенного союза

О формировании системы технического регулирования Таможенного союза Алгоритм как модель деятельности 10 класс

Алгоритм как модель деятельности 10 класс Урок толерантности

Урок толерантности Презентація

Презентація Роберт ван Оттердайк. Меры предотвращения порчи и уменьшения количества пищевых отходов

Роберт ван Оттердайк. Меры предотвращения порчи и уменьшения количества пищевых отходов Учебная практика

Учебная практика Результати виконання завдань державним службовцем, який займає посаду державної служби категорії Б або В

Результати виконання завдань державним службовцем, який займає посаду державної служби категорії Б або В Презентация для рекламодателей

Презентация для рекламодателей The cow. From Babylon to the present day

The cow. From Babylon to the present day интернет-буржуй Андрей Рябых

интернет-буржуй Андрей Рябых История города Рыбинска

История города Рыбинска Цифровая обработка сигналов

Цифровая обработка сигналов Тема: «КАК ОБОЙТИ УПРАВЛЕНЧЕСКИЕ ЛОВУШКИ»

Тема: «КАК ОБОЙТИ УПРАВЛЕНЧЕСКИЕ ЛОВУШКИ» Феварин в терапии алкогольной зависимости

Феварин в терапии алкогольной зависимости Презентация на тему Электронное декларирование

Презентация на тему Электронное декларирование  Третья модель Macintosh на базе OS 7

Третья модель Macintosh на базе OS 7 Дикие и домашние животные 2 класс

Дикие и домашние животные 2 класс О структуре современного урока математики

О структуре современного урока математики George. Style

George. Style Psychology and Globalization: Understanding a Complex Relationship

Psychology and Globalization: Understanding a Complex Relationship Студент ТГСХА

Студент ТГСХА Методы измерения и анализа миграции

Методы измерения и анализа миграции Приглашение к Сотрудничеству

Приглашение к Сотрудничеству