в свою очередь, создает неопределенность в исходах опытов, связанных с данным событием. Безусловно, степень неопределенности различна для разных ситуаций.

Для практики важно иметь возможность произвести численную оценку неопределенности разных опытов. Попробуем ввести такую количественную меру неопределенности

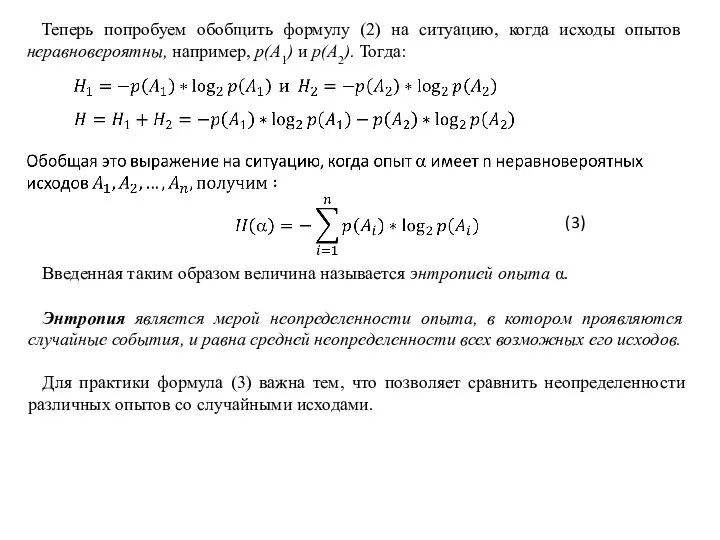

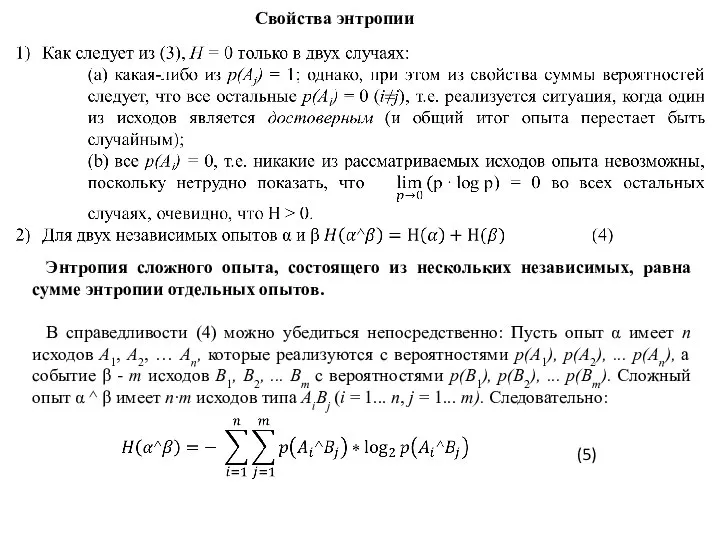

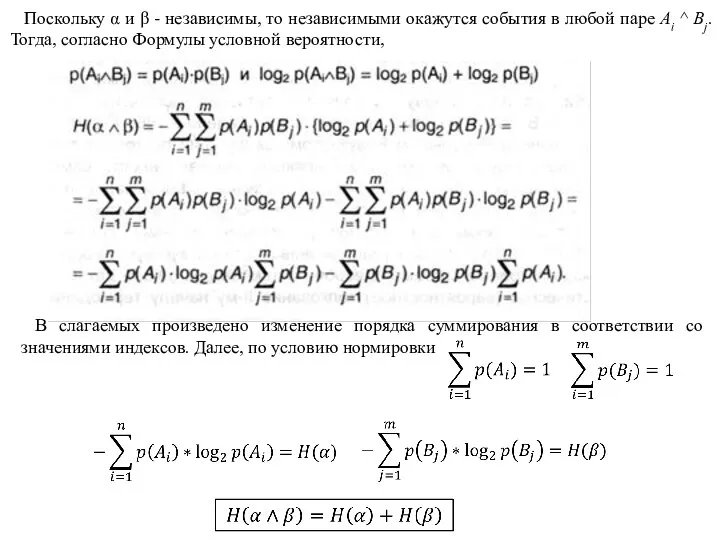

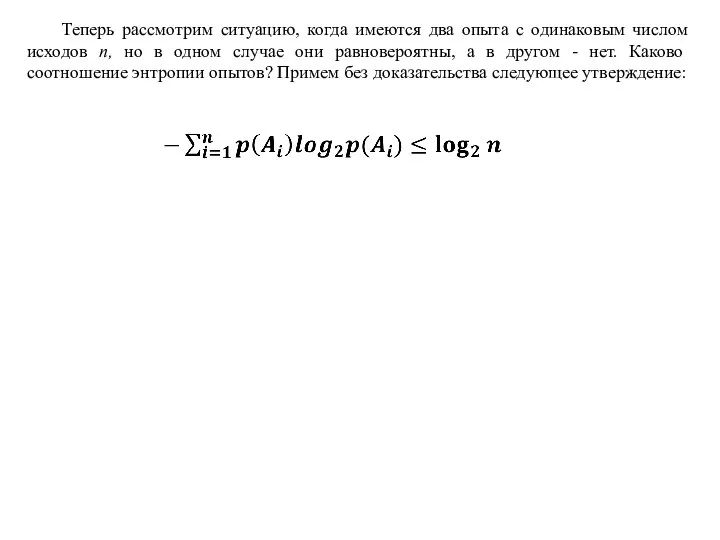

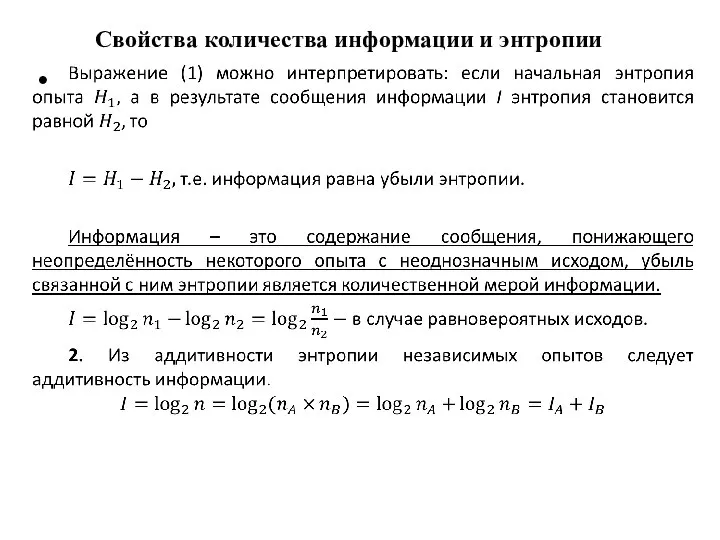

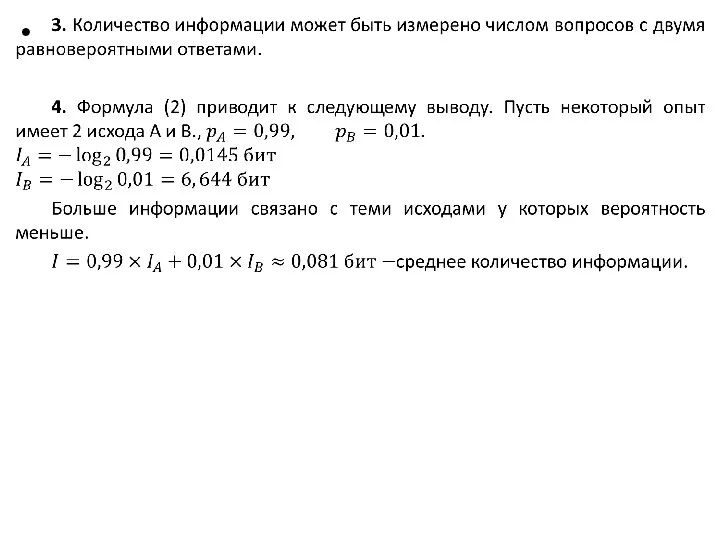

Энтропия

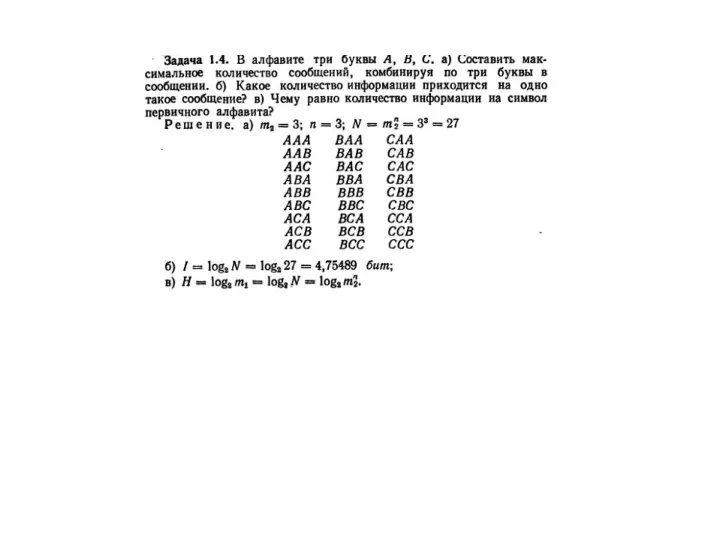

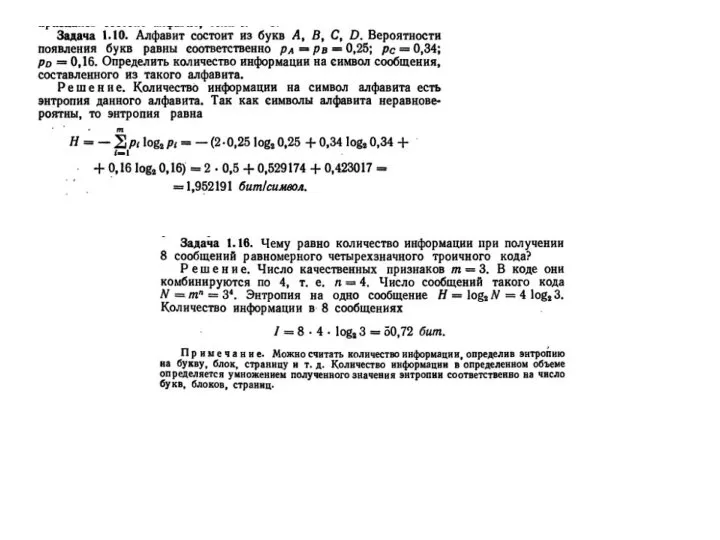

Рассмотри опыт с п равновероятных исходов. Очевидно, что неопределенность каждого из них зависит от n, т.е. мера неопределенности является функцией числа исходов f(n).

Можно указать некоторые свойства этой функции:

f(1) = 0, поскольку при п = 1 исход опыта не является случайным и, следовательно, неопределенность отсутствует;

f(n) возрастает с ростом п, поскольку чем больше число возможных исходов, тем более затруднительным становится предсказание результата опыта.

Энтропия как мера неопределенности

Интеллектуальный марафон

Интеллектуальный марафон Музыкальные компьютерные технологии

Музыкальные компьютерные технологии Турнир программистов. 7 класс

Турнир программистов. 7 класс Сказка Курочка ряба

Сказка Курочка ряба Базовые структуры алгоритмов

Базовые структуры алгоритмов Последняя версия 18-11

Последняя версия 18-11 Лабиринт в PowerPoint

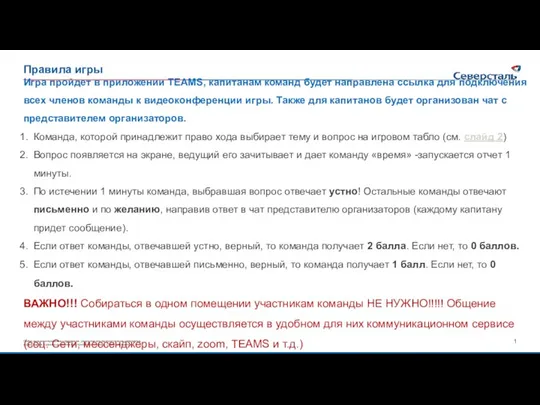

Лабиринт в PowerPoint Описание игры Умная сталь-1

Описание игры Умная сталь-1 Знакомство с компьютером

Знакомство с компьютером Разработка системы выделения контуров образов графических изображений

Разработка системы выделения контуров образов графических изображений Подготовка теста в приложении Power Point

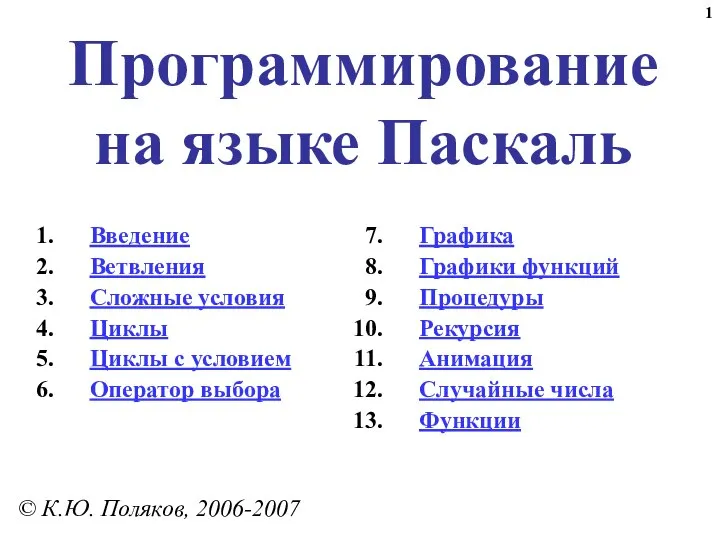

Подготовка теста в приложении Power Point Программирование на языке Паскаль

Программирование на языке Паскаль Вставка изображений в Web-страницы

Вставка изображений в Web-страницы Методы математического моделирования

Методы математического моделирования Информационное общество

Информационное общество Рекурсия в С++

Рекурсия в С++ Классы и структуры в C++

Классы и структуры в C++ Любая достаточно развитая технология неотличима от магии. Третий закон Артура Кларка

Любая достаточно развитая технология неотличима от магии. Третий закон Артура Кларка Sample PowerPoint File

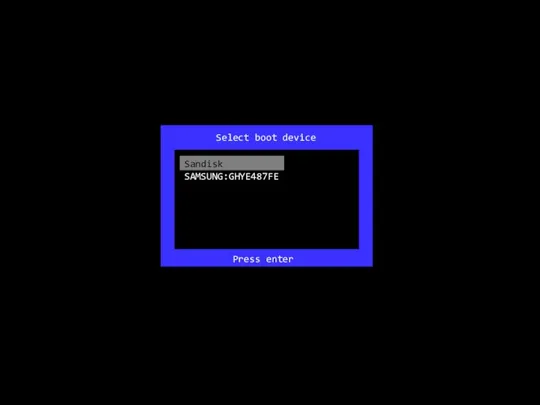

Sample PowerPoint File Select boot device Sandisk

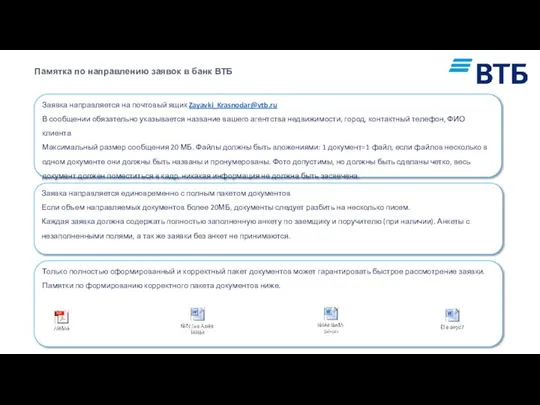

Select boot device Sandisk Направление заявок в банк ВТБ

Направление заявок в банк ВТБ Операционные системы

Операционные системы Подробная инструкция по заполнению заявок

Подробная инструкция по заполнению заявок Популярные образовательные площадки

Популярные образовательные площадки Программные средства визуализации данных

Программные средства визуализации данных Письменные источники информации

Письменные источники информации Управление изменениями

Управление изменениями Лекция 5

Лекция 5