Содержание

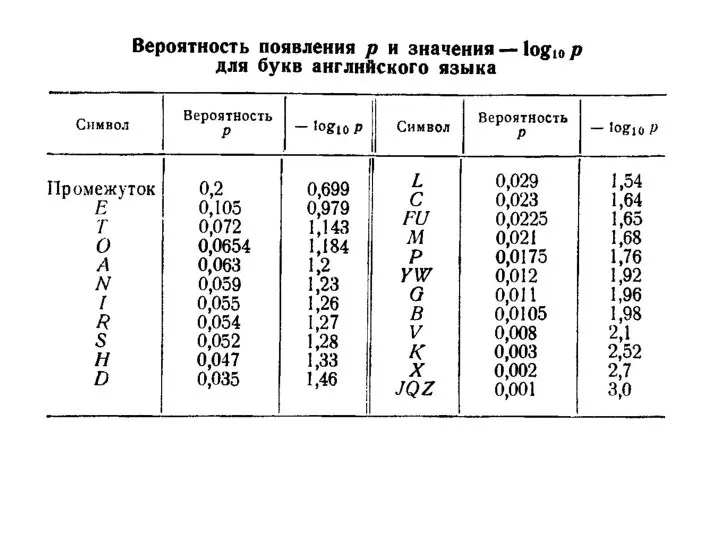

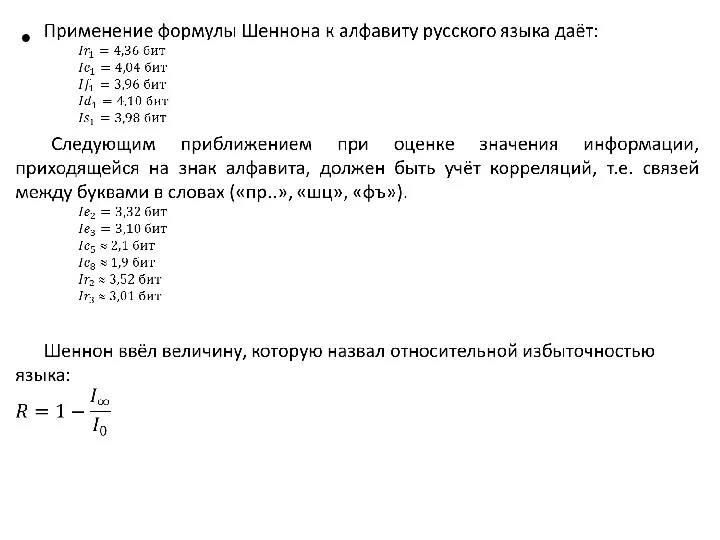

- 3. Таблица для средних частот букв русского алфавита

- 5. Сообщения, в которых вероятность появления каждого отдельного знака не меняется со временем, называют шенноновскими, а порождающий

- 7. Понятие о кодировании. Коды. Кодирование символьной информации Теория кодирования информации является одним из разделов теоретической информатики.

- 8. В зависимости от целей кодирования различают следующие его виды: Кодирование по образцу – используется всякий раз

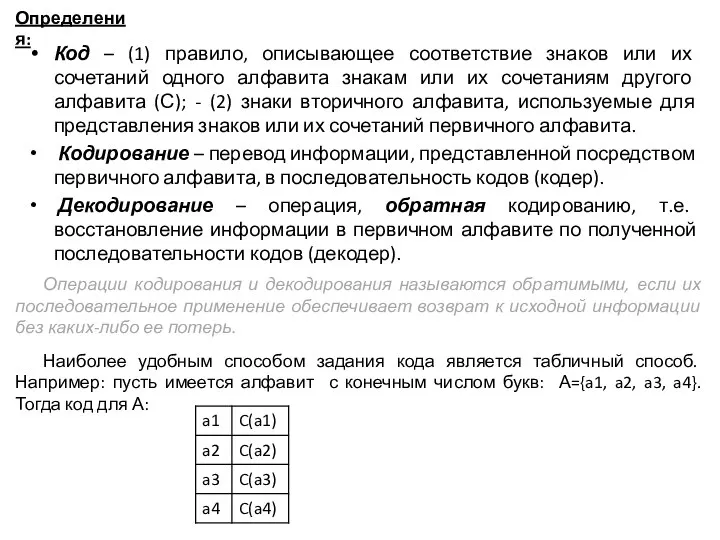

- 9. Код – (1) правило, описывающее соответствие знаков или их сочетаний одного алфавита знакам или их сочетаниям

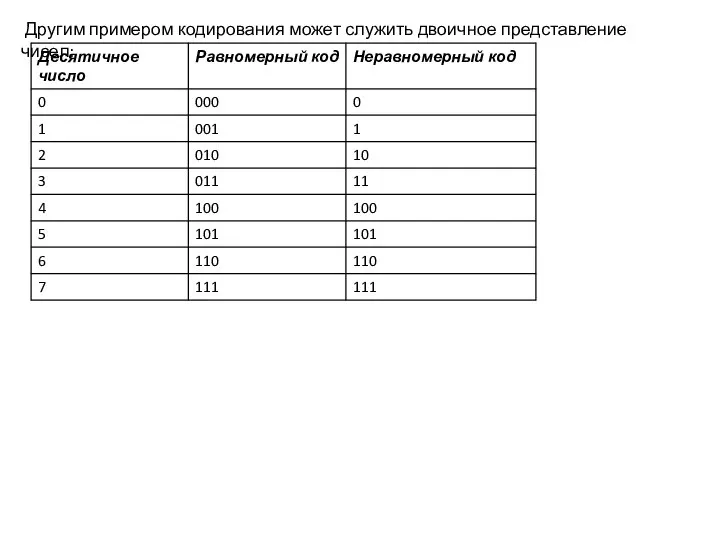

- 10. Другим примером кодирования может служить двоичное представление чисел:

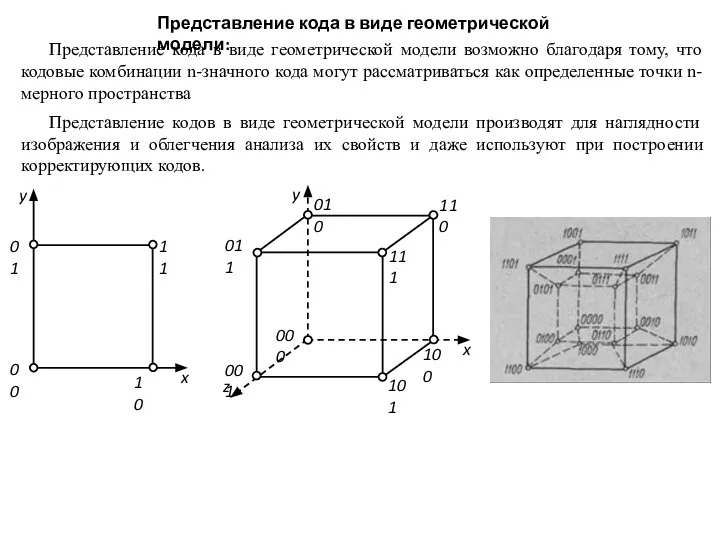

- 11. Представление кода в виде геометрической модели: Представление кода в виде геометрической модели возможно благодаря тому, что

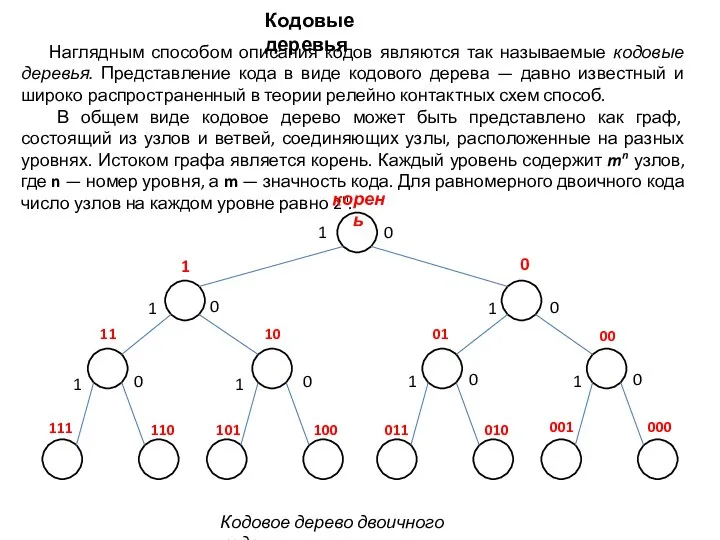

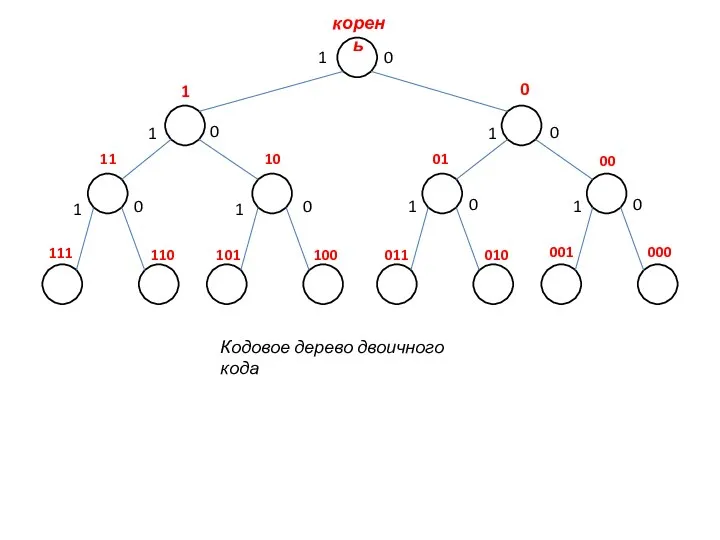

- 12. Наглядным способом описания кодов являются так называемые кодовые деревья. Представление кода в виде кодового дерева —

- 13. При помощи кодовых деревьев наглядно представляются коды, обладающие свойством префикса, или префиксные коды, т. е. коды,

- 14. Префиксом данной кодовой комбинации Аi является любая последовательность, составленная из ее начальной части, включая саму комбинацию

- 15. корень 1 0 1 0 1 1 1 1 1 1 0 0 0 0 0

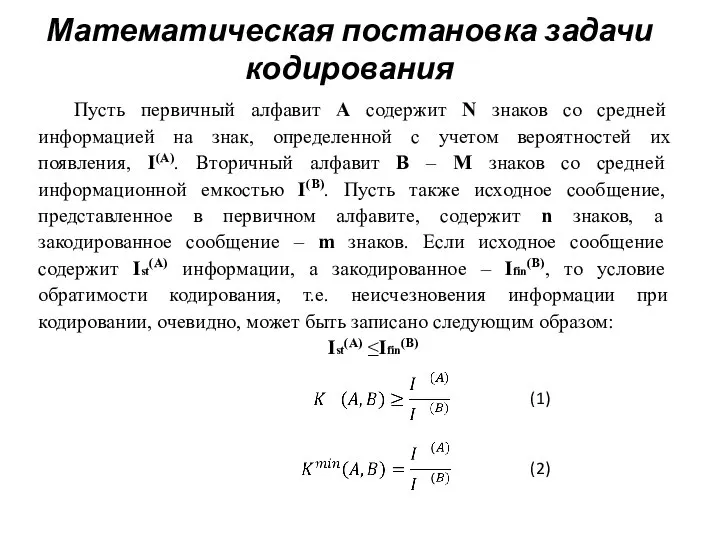

- 16. Математическая постановка задачи кодирования Пусть первичный алфавит A содержит N знаков со средней информацией на знак,

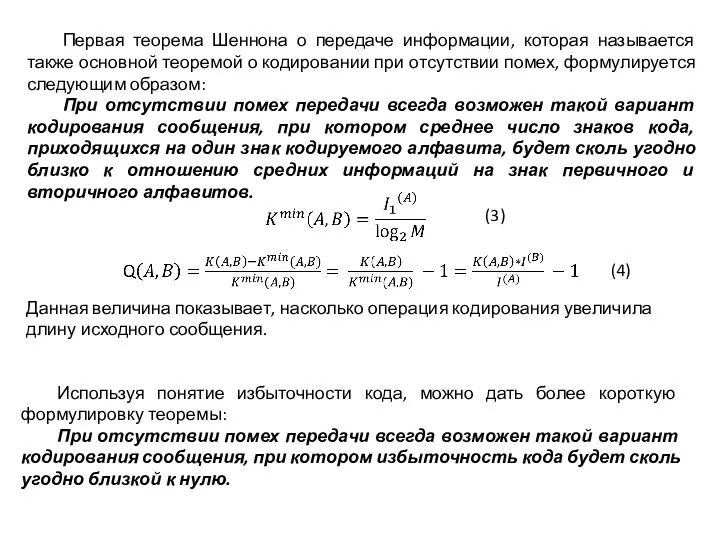

- 17. Первая теорема Шеннона о передаче информации, которая называется также основной теоремой о кодировании при отсутствии помех,

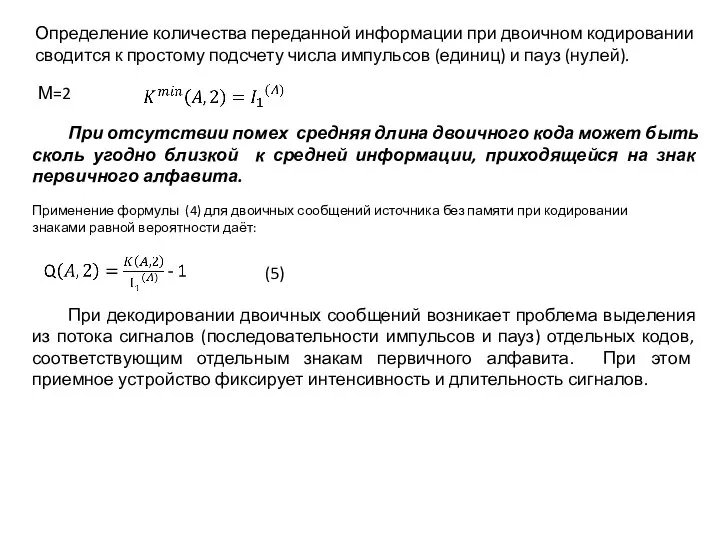

- 18. М=2 При отсутствии помех средняя длина двоичного кода может быть сколь угодно близкой к средней информации,

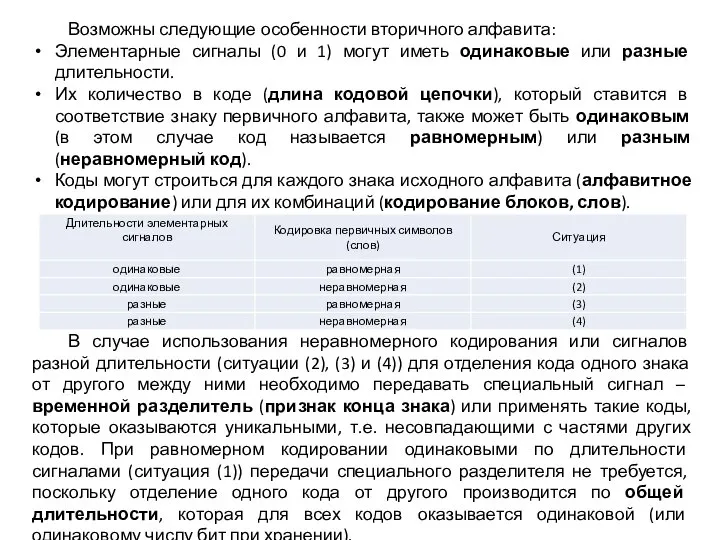

- 19. Возможны следующие особенности вторичного алфавита: Элементарные сигналы (0 и 1) могут иметь одинаковые или разные длительности.

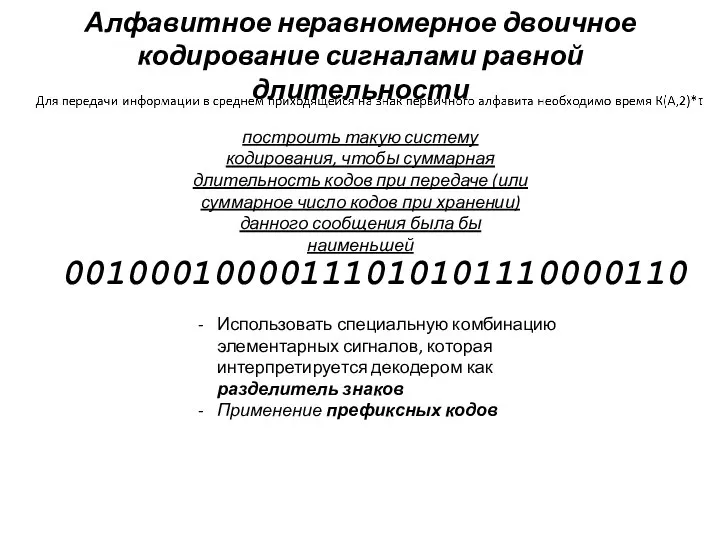

- 20. Алфавитное неравномерное двоичное кодирование сигналами равной длительности построить такую систему кодирования, чтобы суммарная длительность кодов при

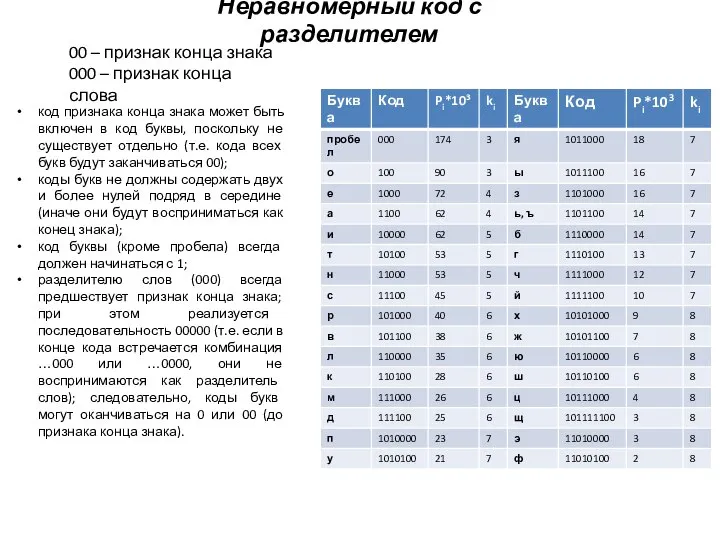

- 21. Неравномерный код с разделителем 00 – признак конца знака 000 – признак конца слова код признака

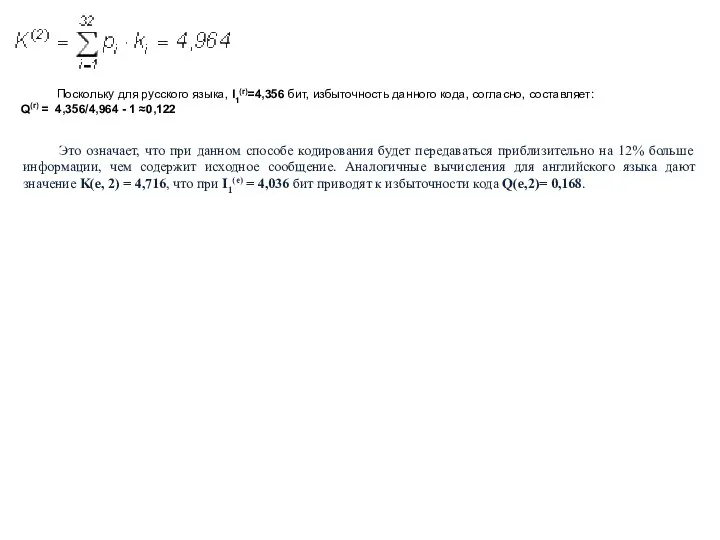

- 22. Поскольку для русского языка, I1(r)=4,356 бит, избыточность данного кода, согласно, составляет: Q(r) = 4,356/4,964 - 1

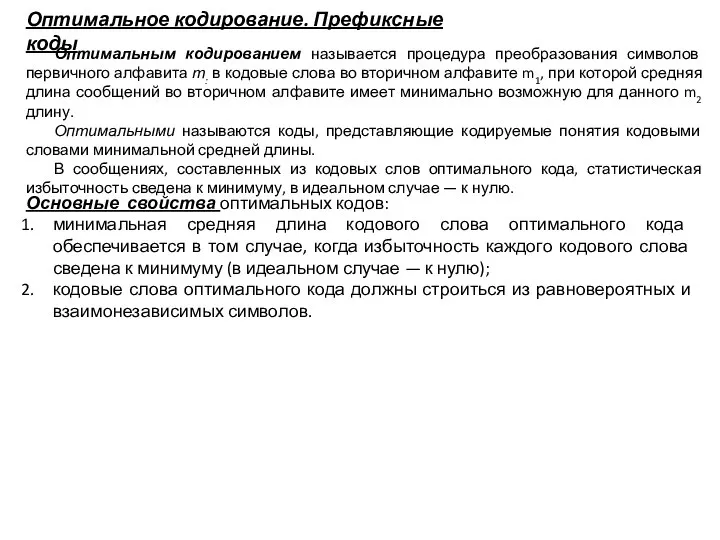

- 23. Оптимальное кодирование. Префиксные коды Оптимальным кодированием называется процедура преобразования символов первичного алфавита т: в кодовые слова

- 24. Неравномерный код может быть однозначно декодирован, если никакой из кодов не совпадает с началом (префиксом) какого-либо

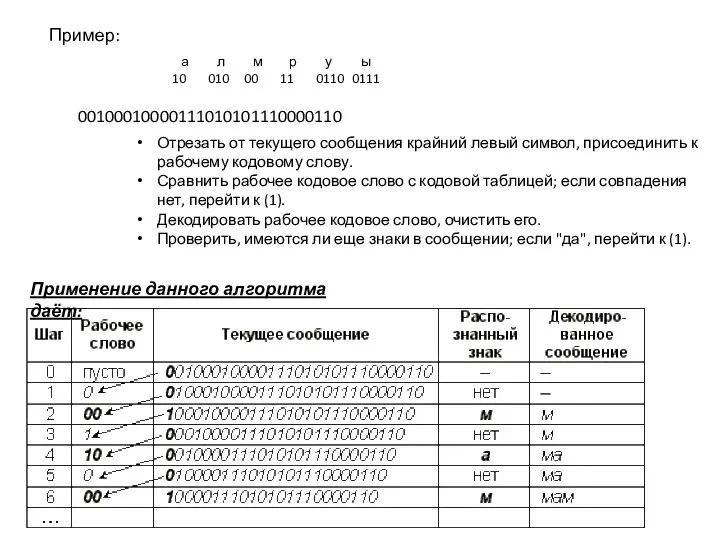

- 25. а л м р у ы 10 010 00 11 0110 0111 Пример: 00100010000111010101110000110 Отрезать от

- 26. Построение оптимального кода по методу Шеннона — Фано для сообщений сводится к следующей процедуре: множество из

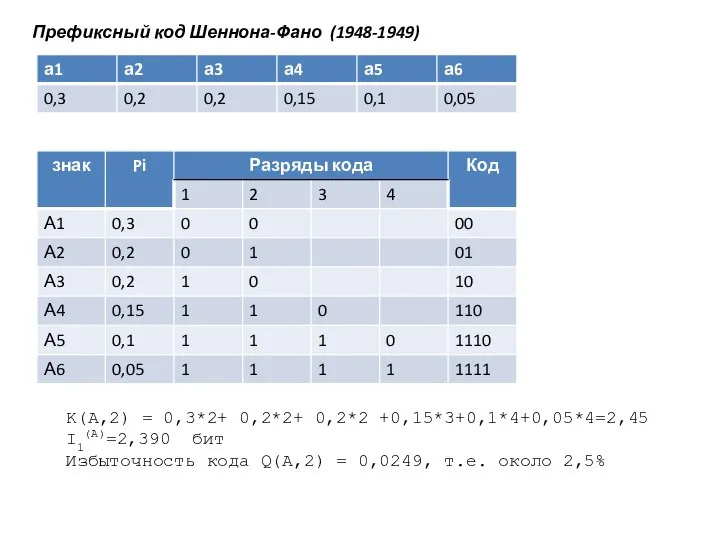

- 27. Префиксный код Шеннона-Фано (1948-1949) K(A,2) = 0,3*2+ 0,2*2+ 0,2*2 +0,15*3+0,1*4+0,05*4=2,45 I1(A)=2,390 бит Избыточность кода Q(A,2) =

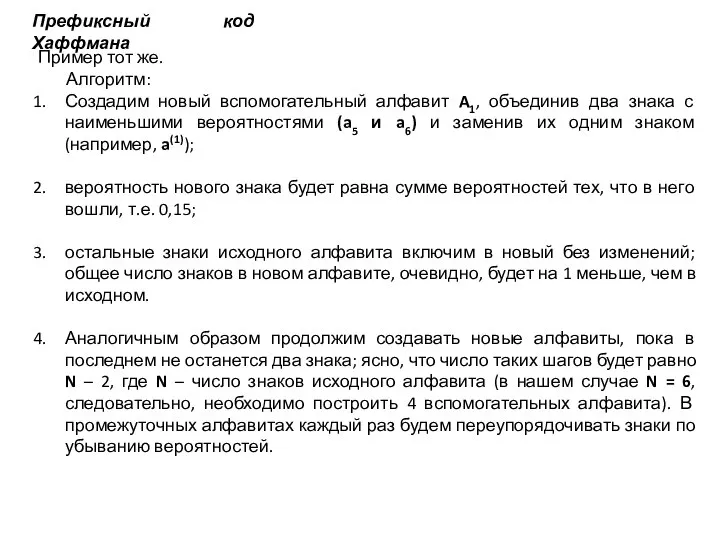

- 28. Префиксный код Хаффмана Пример тот же. Алгоритм: Создадим новый вспомогательный алфавит A1, объединив два знака с

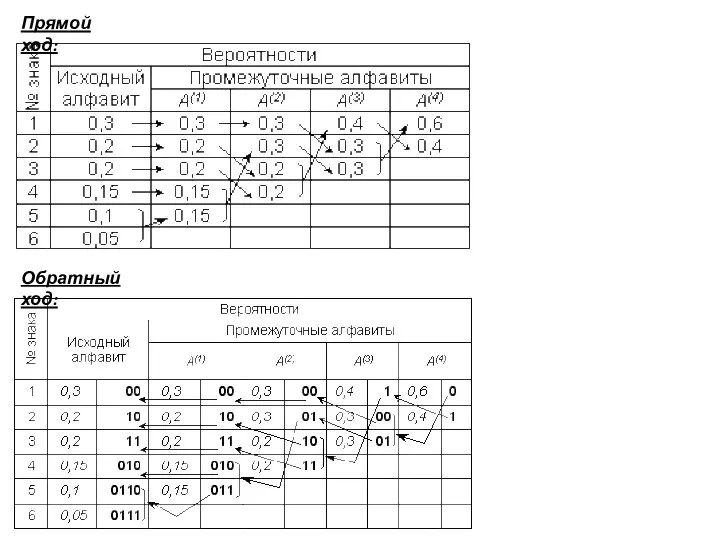

- 29. Прямой ход: Обратный ход:

- 30. Средняя длина кода оказывается равной K(2) = 4,395; избыточность кода Q(r) = 0,00887, т.е. менее 1%.

- 31. Равномерное алфавитное двоичное кодирование. Байтовый код В этом случае двоичный код первичного алфавита строится цепочками равной

- 33. Скачать презентацию

Имитация объема в photoshop

Имитация объема в photoshop 1C_Cabinet_sotrudnika_client

1C_Cabinet_sotrudnika_client 8-1-1

8-1-1 Молодёжные медиатренды 2018 года

Молодёжные медиатренды 2018 года Перспективы развития интернет-технологий

Перспективы развития интернет-технологий Человечек из фигур танцует

Человечек из фигур танцует Типы шрифтов

Типы шрифтов Презентация на тему Передача информации

Презентация на тему Передача информации  Автоматизация управления работой с клиентами посредством системы СRМ

Автоматизация управления работой с клиентами посредством системы СRМ Информационные системы

Информационные системы Сайт. Mid season sale

Сайт. Mid season sale Контрольная работа по информатике

Контрольная работа по информатике Мое творчество. Компьютерная графика

Мое творчество. Компьютерная графика Курсы компьютерной грамотности

Курсы компьютерной грамотности QA Automation HTTP. Page Object (part 2). Лекція 14

QA Automation HTTP. Page Object (part 2). Лекція 14 Устройство и принципы работы ЭВМ

Устройство и принципы работы ЭВМ Использование текстового процессора для обобщения темы Морфемика и орфография

Использование текстового процессора для обобщения темы Морфемика и орфография Стандартизация показателей

Стандартизация показателей Электронный документ и файл

Электронный документ и файл Мобильная безопасность

Мобильная безопасность Возможности для моделирования объектов инфраструктуры в программе Autodesk InfraWorks в рамках ООО Мособлтранспроект

Возможности для моделирования объектов инфраструктуры в программе Autodesk InfraWorks в рамках ООО Мособлтранспроект CryptoTrader - Сигналы

CryptoTrader - Сигналы Система контроля и управления доступом (СКУД)

Система контроля и управления доступом (СКУД) ZHAN Development Studio ZDS. Разработка и создание видео игр

ZHAN Development Studio ZDS. Разработка и создание видео игр Вікна. Символи

Вікна. Символи Электронная система Охрана труда

Электронная система Охрана труда Способы и схемы автоматического регулирования основных технологических параметров

Способы и схемы автоматического регулирования основных технологических параметров Одномерные массивы. (Python)

Одномерные массивы. (Python)