Содержание

- 2. Кодирование источника Для источников с памятью избыточность тем больше, чем выше степень статистической (вероятностной) зависимости символов

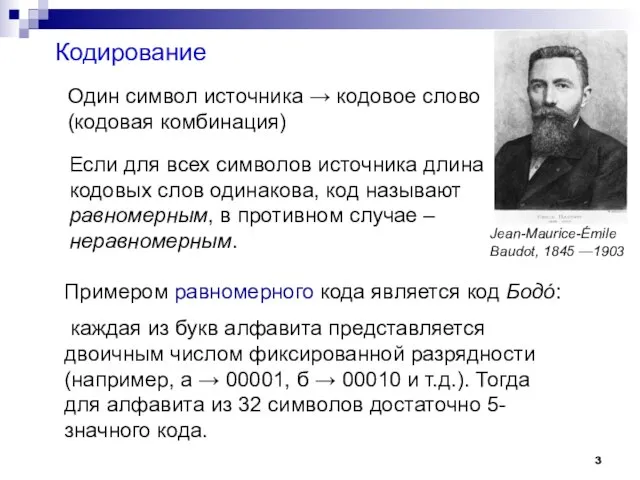

- 3. Кодирование Один символ источника → кодовое слово (кодовая комбинация) Если для всех символов источника длина кодовых

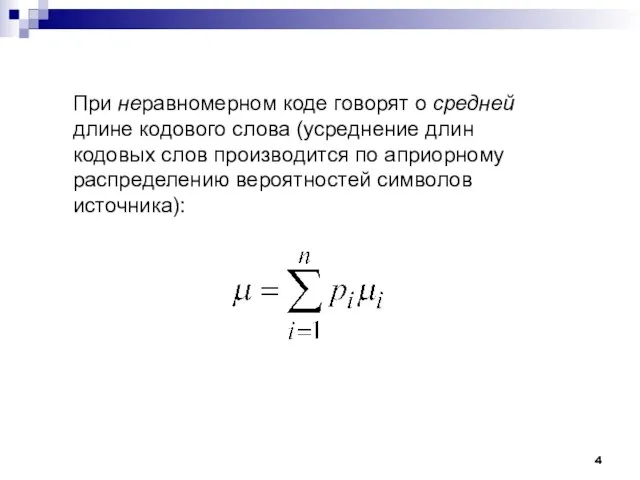

- 4. При неравномерном коде говорят о средней длине кодового слова (усреднение длин кодовых слов производится по априорному

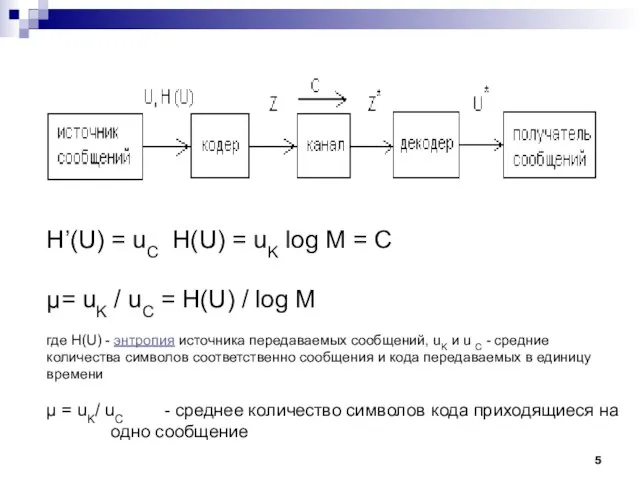

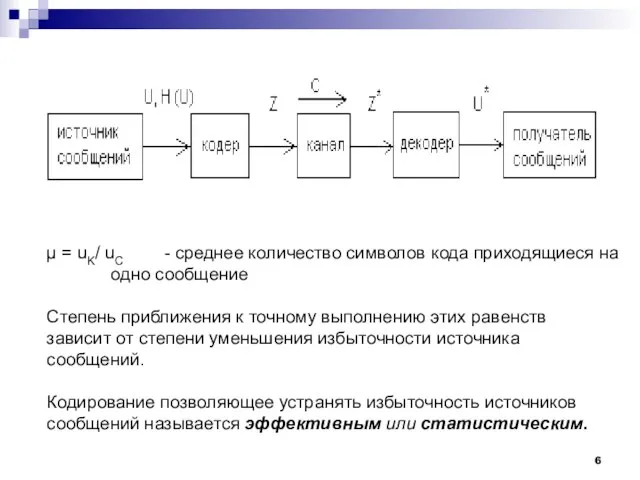

- 5. H’(U) = uC H(U) = uK log M = C µ= uK / uC = H(U)

- 6. µ = uK/ uC - среднее количество символов кода приходящиеся на одно сообщение Степень приближения к

- 7. Избыточность дискретных источников обуславливается двумя причинами: 1) памятью источника; 2) неравномерностью сообщений. Универсальным способом уменьшения избыточности

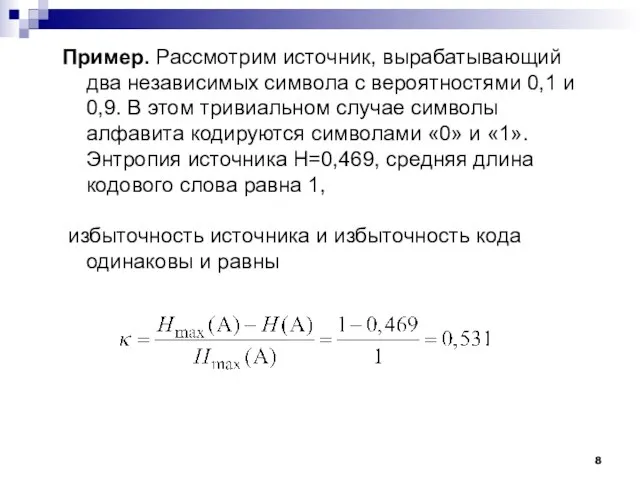

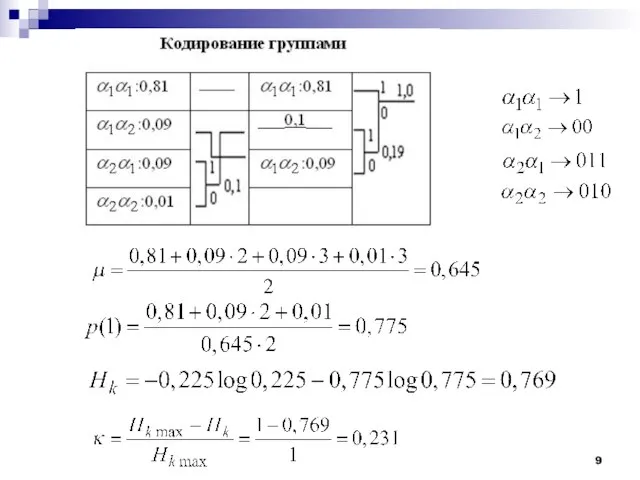

- 8. Пример. Рассмотрим источник, вырабатывающий два независимых символа с вероятностями 0,1 и 0,9. В этом тривиальном случае

- 10. 1-я Теорема Шеннона Предельные возможности статистического кодирования раскрывается в теореме Шеннона для канала без шума, которая

- 11. 1-я Теорема Шеннона Получить меньшее значение µ невозможно (обратная теорема). Обратная часть теоремы утверждающая, что невозможно

- 12. 1-я Теорема Шеннона «Основная теорема о кодировании в отсутствие шумов»: Среднюю длину кодовых слов для передачи

- 13. Пример. Если источник без памяти имеет объем алфавита 32, то при равновероятных символах его энтропия равна

- 14. Практическое значение теоремы Шеннона заключается в возможности повышения эффективности систем передачи информации (систем связи) путем применения

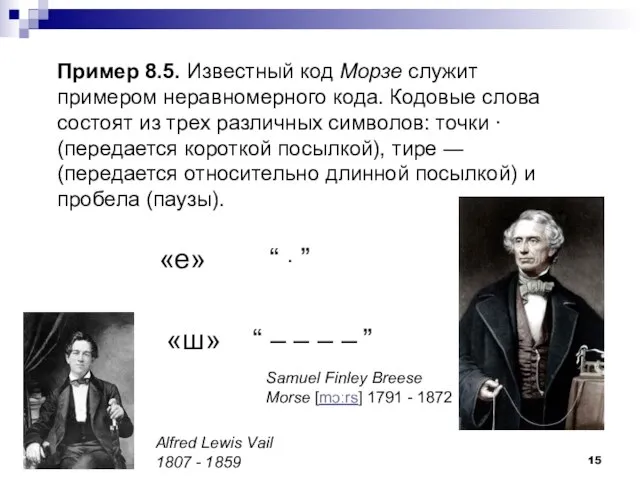

- 15. Пример 8.5. Известный код Морзе служит примером неравномерного кода. Кодовые слова состоят из трех различных символов:

- 16. Кодирование источника по Шеннону – Фано.

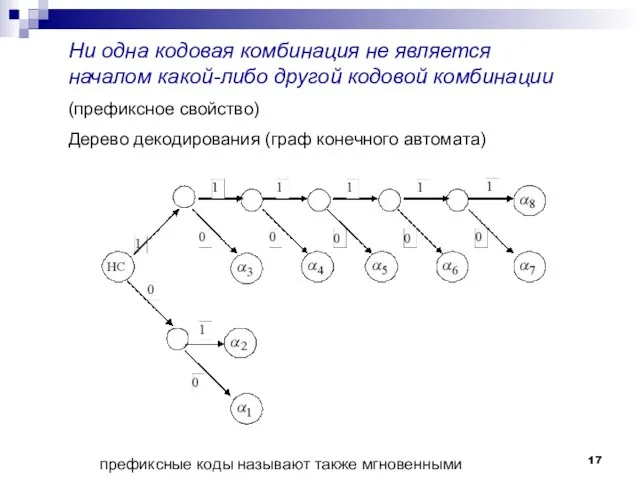

- 17. Ни одна кодовая комбинация не является началом какой-либо другой кодовой комбинации (префиксное свойство) Дерево декодирования (граф

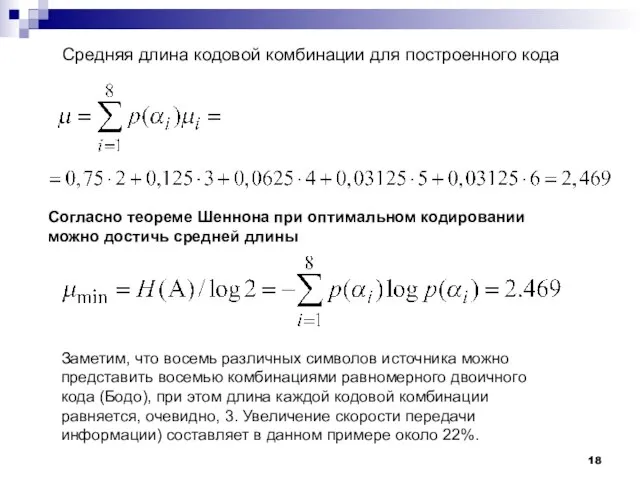

- 18. Средняя длина кодовой комбинации для построенного кода Согласно теореме Шеннона при оптимальном кодировании можно достичь средней

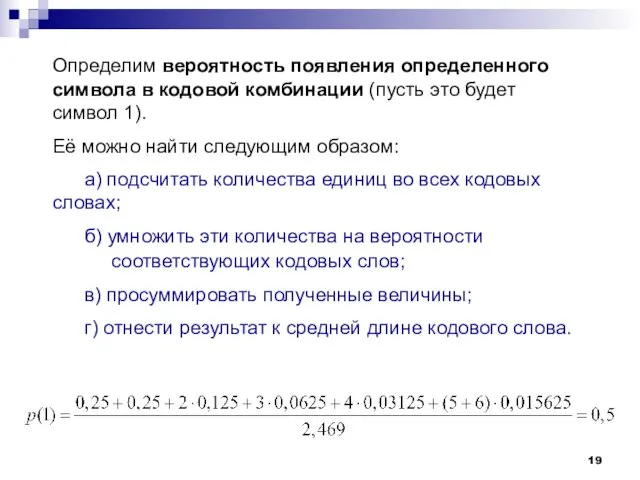

- 19. Определим вероятность появления определенного символа в кодовой комбинации (пусть это будет символ 1). Её можно найти

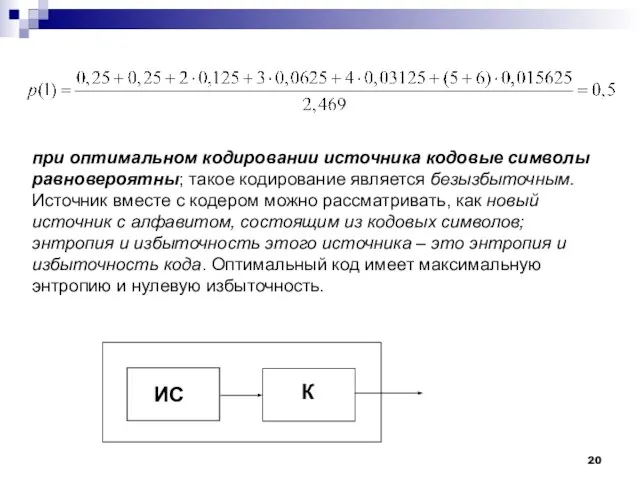

- 20. при оптимальном кодировании источника кодовые символы равновероятны; такое кодирование является безызбыточным. Источник вместе с кодером можно

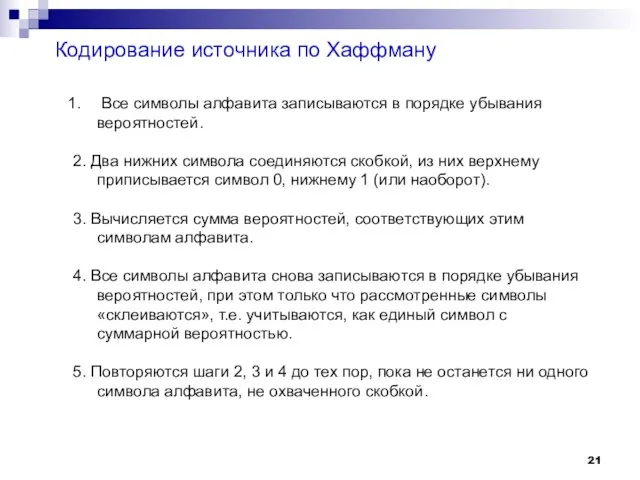

- 21. Кодирование источника по Хаффману Все символы алфавита записываются в порядке убывания вероятностей. 2. Два нижних символа

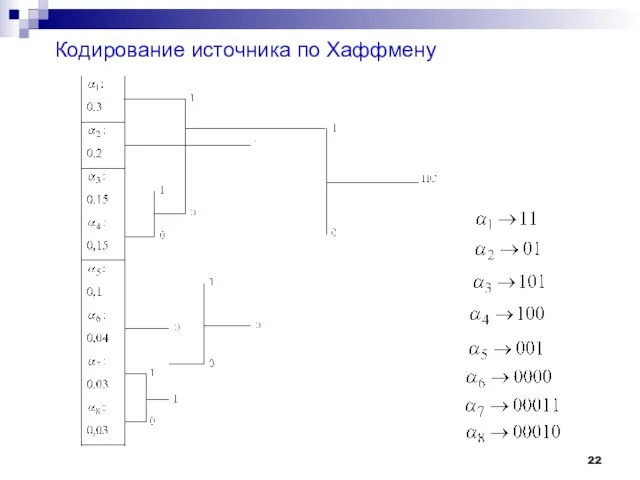

- 22. Кодирование источника по Хаффмену

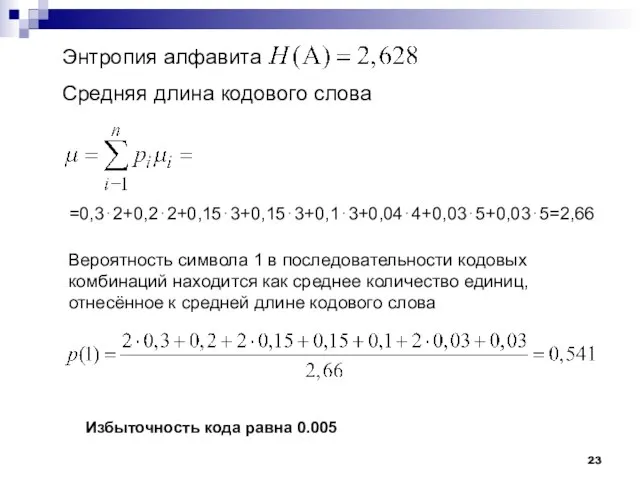

- 23. Энтропия алфавита . Средняя длина кодового слова =0,3⋅2+0,2⋅2+0,15⋅3+0,15⋅3+0,1⋅3+0,04⋅4+0,03⋅5+0,03⋅5=2,66 Вероятность символа 1 в последовательности кодовых комбинаций находится

- 24. Оптимальность кода Шеннона – Фано в рассмотренном примере объясняется специально подобранными вероятностями символов, так, что на

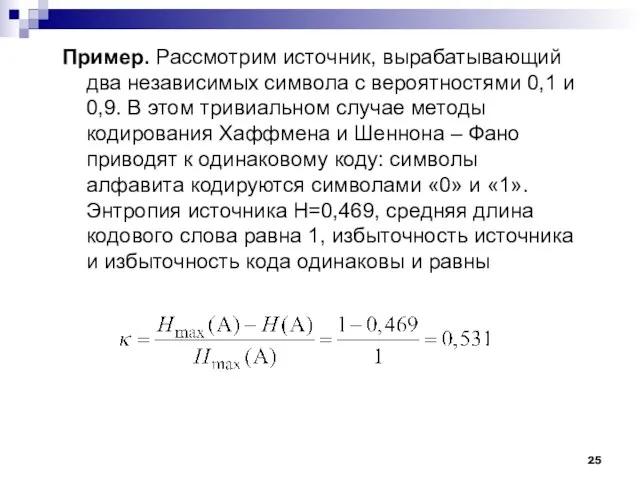

- 25. Пример. Рассмотрим источник, вырабатывающий два независимых символа с вероятностями 0,1 и 0,9. В этом тривиальном случае

- 27. Скачать презентацию

Руководство по работе с модулем NCR для поставщиков ФМ

Руководство по работе с модулем NCR для поставщиков ФМ Информатика. Алгоритмический язык. Лекция 8

Информатика. Алгоритмический язык. Лекция 8 CSS. Cascading Style Sheets. Урок 11 2

CSS. Cascading Style Sheets. Урок 11 2 Алгометрические структуры: повторение, ветвление

Алгометрические структуры: повторение, ветвление Основные свойства JavaScript. Лабораторная работа №16

Основные свойства JavaScript. Лабораторная работа №16 Структура LTE

Структура LTE Типографика. Правила ввода и оформления текста

Типографика. Правила ввода и оформления текста Нормализация данных. Пример

Нормализация данных. Пример Антивирусное программное обеспечение

Антивирусное программное обеспечение Этапы развития инициативных проектов

Этапы развития инициативных проектов БЭСТ-5. Мой бизнес

БЭСТ-5. Мой бизнес Работа в текстовом редакторе

Работа в текстовом редакторе Причины социального детокса

Причины социального детокса Контент. Работа с текстом

Контент. Работа с текстом HashConnect. Ключевые особенности

HashConnect. Ключевые особенности Интерпретация религии в Binding of Isaac

Интерпретация религии в Binding of Isaac Электронные библиотечные системы

Электронные библиотечные системы Архивация

Архивация Модели безопасности защиты от несанкционированного доступа. Лекция №3

Модели безопасности защиты от несанкционированного доступа. Лекция №3 Neom. Crowd Funder: Motion Principles

Neom. Crowd Funder: Motion Principles Генерация последовательностей. Лекция 13

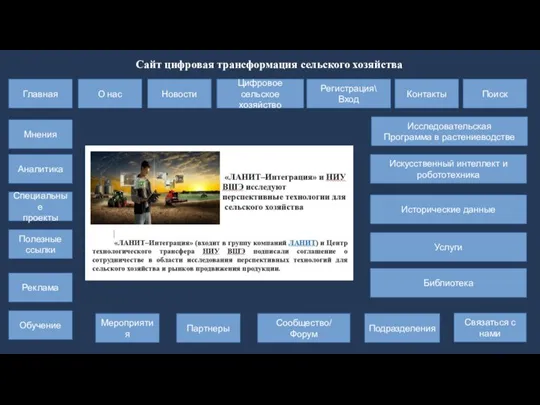

Генерация последовательностей. Лекция 13 Сайт цифровая трансформация сельского хозяйства

Сайт цифровая трансформация сельского хозяйства Программирование графической анимации. Задача Движение бильярдного шарика

Программирование графической анимации. Задача Движение бильярдного шарика Введение в курс. Криптографическая защита информации

Введение в курс. Криптографическая защита информации Технология создания цифровой мультимедийной информации

Технология создания цифровой мультимедийной информации 3D – печать. Механизмы и кинематика

3D – печать. Механизмы и кинематика Основные понятия баз данных

Основные понятия баз данных 1 семинар. Введение в контроль версий

1 семинар. Введение в контроль версий