Содержание

- 2. План лекции метрики качества с точки зрения классификации особенности метрик качества для матчинга метрики качества с

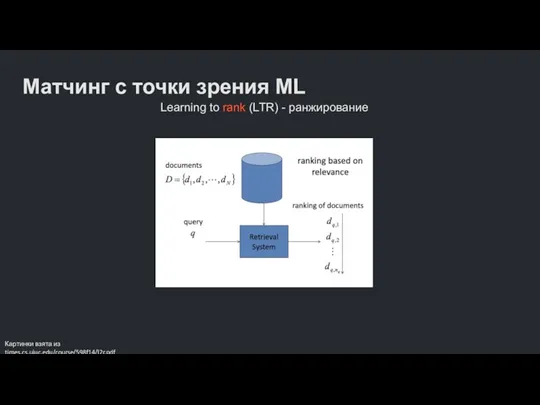

- 3. Матчинг с точки зрения ML Learning to rank (LTR) - ранжирование Картинки взята из times.cs.uiuc.edu/course/598f14/l2r.pdf

- 4. Что измерять в ранжировании? Качество / Точность – насколько аккуратна система ранжирования? Измеряем возможности системы ранжировать

- 5. Оценка качества ранжирования Методология оценки Кранфилда (Cranfield Evaluation Methodology): Зафиксированный набор документов Зафиксированный набор запросов Оценки

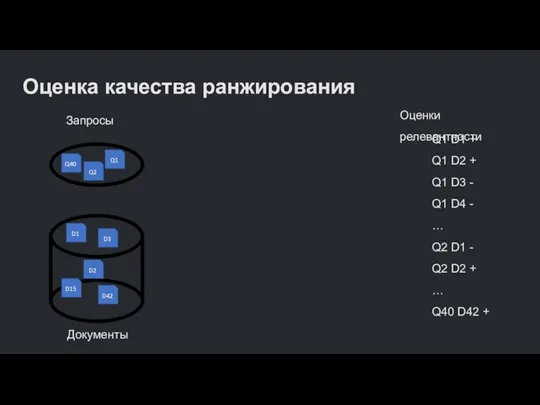

- 6. Оценка качества ранжирования Запросы Q40 Q2 Q1 Документы D1 D3 D15 D42 D2 Оценки релевантности Q1

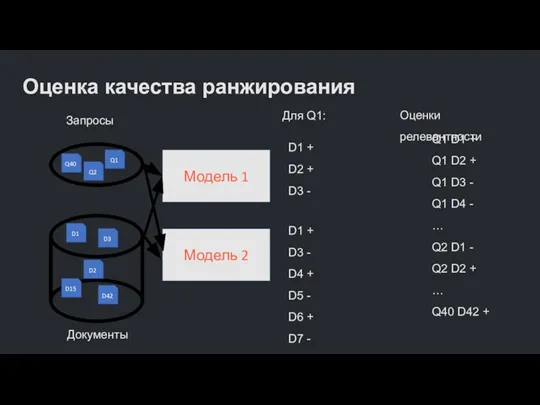

- 7. Оценка качества ранжирования Запросы Q40 Q2 Q1 Документы D1 D3 D15 D42 D2 Оценки релевантности Q1

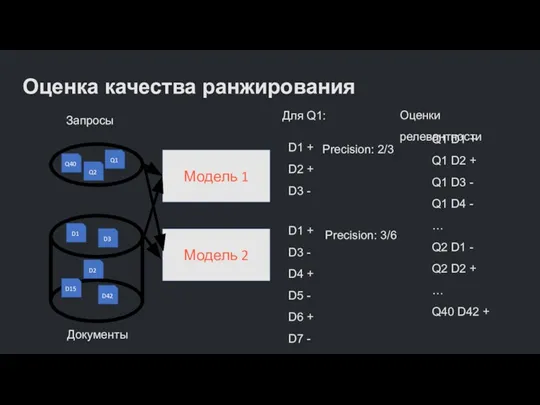

- 8. Оценка качества ранжирования Запросы Q40 Q2 Q1 Документы D1 D3 D15 D42 D2 Оценки релевантности Q1

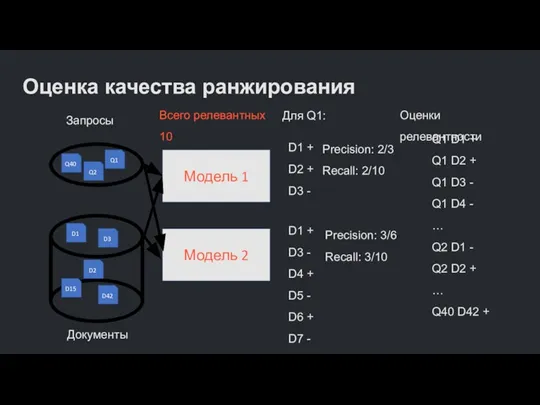

- 9. Оценка качества ранжирования Запросы Q40 Q2 Q1 Документы D1 D3 D15 D42 D2 Оценки релевантности Q1

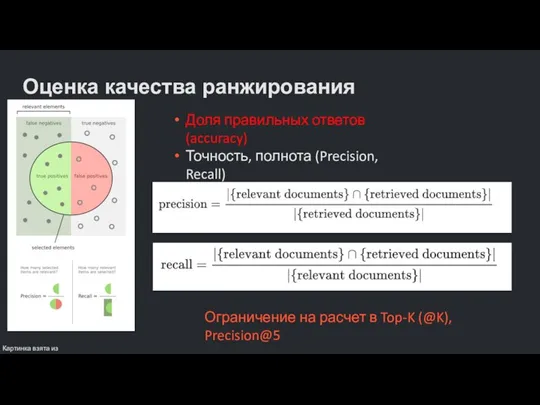

- 10. Оценка качества ранжирования Доля правильных ответов (accuracy) Точность, полнота (Precision, Recall) Картинка взята из en.wikipedia.org/wiki/Precision_and_recall Ограничение

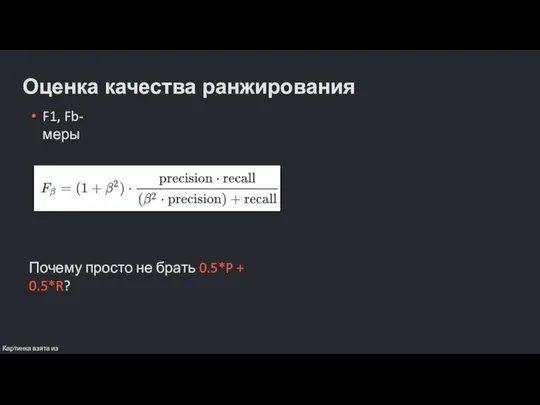

- 11. Оценка качества ранжирования F1, Fb-меры Картинка взята из en.wikipedia.org/wiki/Precision_and_recall Почему просто не брать 0.5*P + 0.5*R?

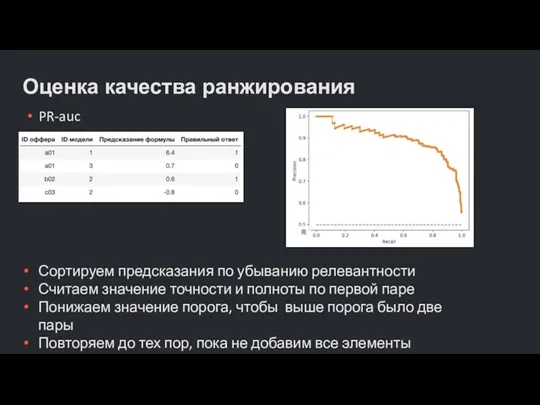

- 12. Оценка качества ранжирования PR-auc Сортируем предсказания по убыванию релевантности Считаем значение точности и полноты по первой

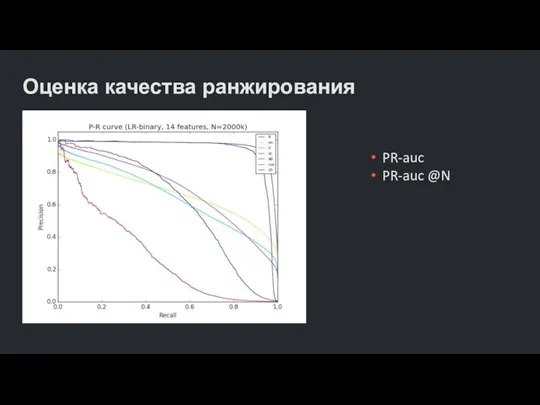

- 13. Оценка качества ранжирования PR-auc PR-auc @N

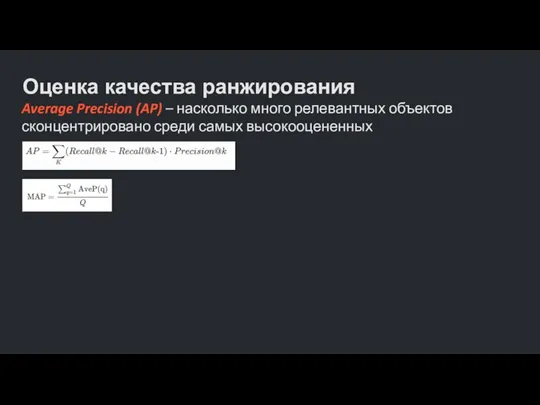

- 14. Оценка качества ранжирования Average Precision (AP) – насколько много релевантных объектов сконцентрировано среди самых высокооцененных

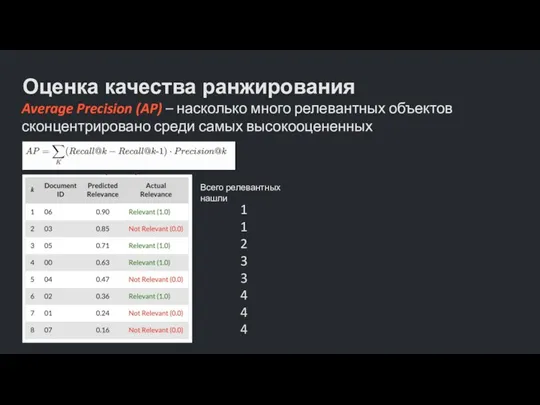

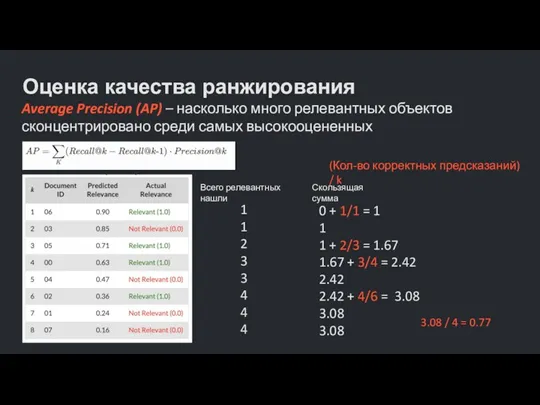

- 15. Оценка качества ранжирования Average Precision (AP) – насколько много релевантных объектов сконцентрировано среди самых высокооцененных Всего

- 16. Оценка качества ранжирования Average Precision (AP) – насколько много релевантных объектов сконцентрировано среди самых высокооцененных Всего

- 17. Оценка качества ранжирования Average Precision (AP) – насколько много релевантных объектов сконцентрировано среди самых высокооцененных

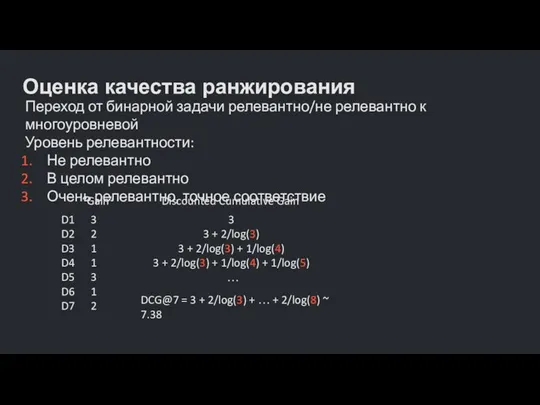

- 18. Оценка качества ранжирования Переход от бинарной задачи релевантно/не релевантно к многоуровневой Уровень релевантности: Не релевантно В

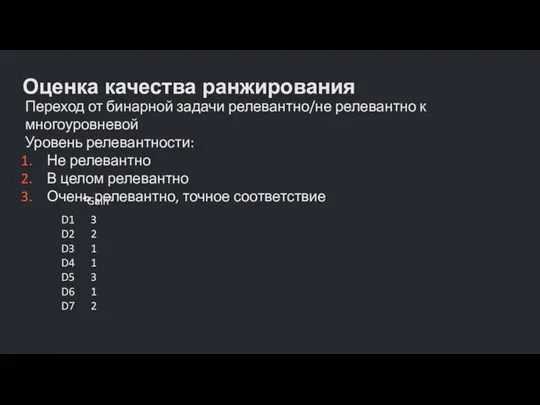

- 19. Оценка качества ранжирования Переход от бинарной задачи релевантно/не релевантно к многоуровневой Уровень релевантности: Не релевантно В

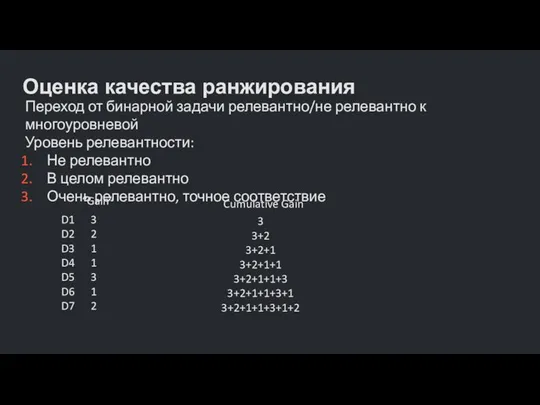

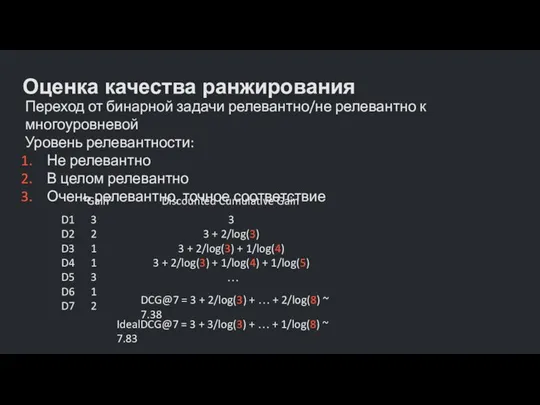

- 20. Оценка качества ранжирования Переход от бинарной задачи релевантно/не релевантно к многоуровневой Уровень релевантности: Не релевантно В

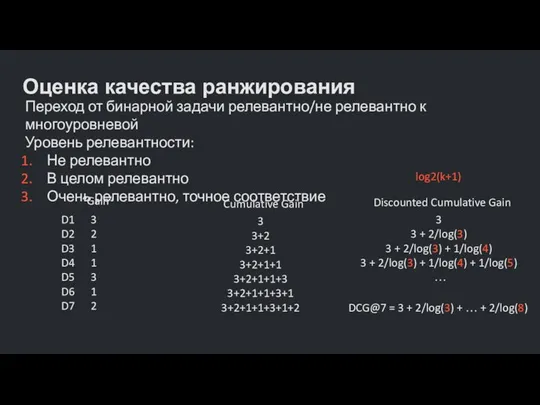

- 21. Оценка качества ранжирования Переход от бинарной задачи релевантно/не релевантно к многоуровневой Уровень релевантности: Не релевантно В

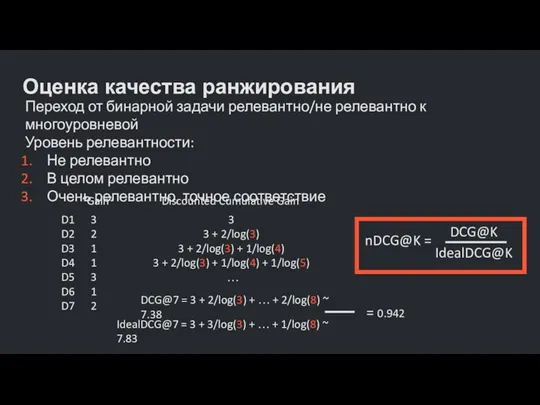

- 22. Оценка качества ранжирования Переход от бинарной задачи релевантно/не релевантно к многоуровневой Уровень релевантности: Не релевантно В

- 23. Оценка качества ранжирования Переход от бинарной задачи релевантно/не релевантно к многоуровневой Уровень релевантности: Не релевантно В

- 24. Оценка качества ранжирования Переход от бинарной задачи релевантно/не релевантно к многоуровневой Уровень релевантности: Не релевантно В

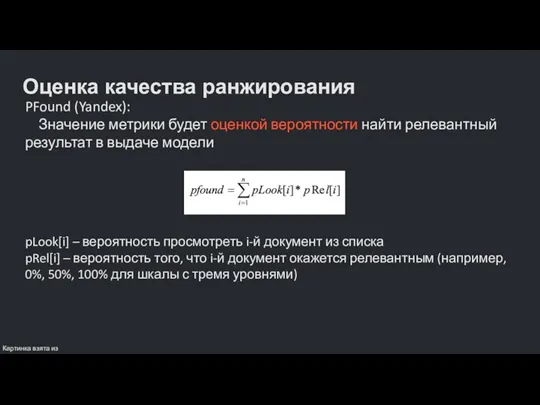

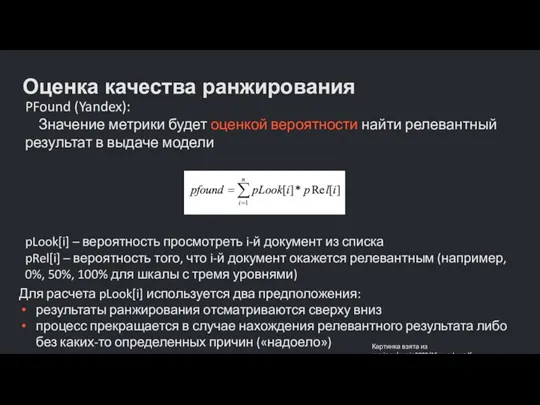

- 25. Оценка качества ранжирования PFound (Yandex): Значение метрики будет оценкой вероятности найти релевантный результат в выдаче модели

- 26. Оценка качества ранжирования PFound (Yandex): Значение метрики будет оценкой вероятности найти релевантный результат в выдаче модели

- 27. Оценка качества ранжирования pLook[i] – вероятность просмотреть i-й документ из списка pRel[i] – вероятность того, что

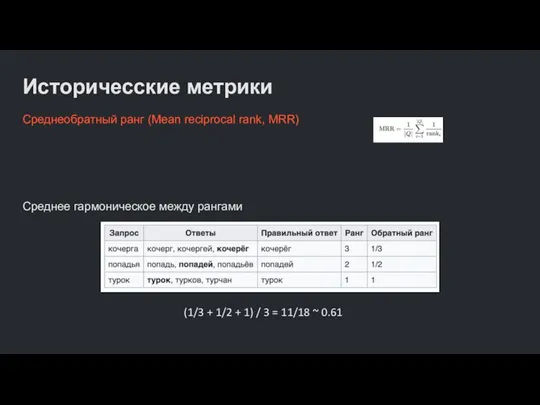

- 28. Историчесские метрики Среднеобратный ранг (Mean reciprocal rank, MRR) Среднее гармоническое между рангами (1/3 + 1/2 +

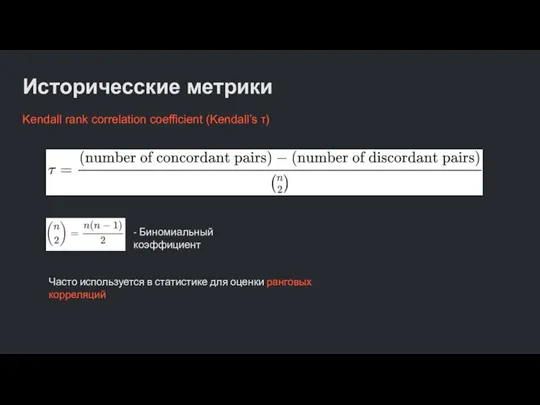

- 29. Историчесские метрики Kendall rank correlation coefficient (Kendall’s τ) - Биномиальный коэффициент Часто используется в статистике для

- 31. Скачать презентацию

![Оценка качества ранжирования pLook[i] – вероятность просмотреть i-й документ из списка pRel[i]](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/1033776/slide-26.jpg)

Tagul - web-сервис

Tagul - web-сервис Упаковка контента (нейминг)

Упаковка контента (нейминг) Справка по заполнению формы Перечень обособленных подразделений ЛПУ (без ФАП и ФП), требующих подключения к сети Интернет

Справка по заполнению формы Перечень обособленных подразделений ЛПУ (без ФАП и ФП), требующих подключения к сети Интернет Дизассемблирование циклов. Реверс-инжиниринг

Дизассемблирование циклов. Реверс-инжиниринг Растровая и векторная графика. Информатика для СПО

Растровая и векторная графика. Информатика для СПО Операторы. Операторы управления

Операторы. Операторы управления Методика SMART

Методика SMART Кодирование информации

Кодирование информации Применение электронной системы Hawk-Eye в различных видах спорта

Применение электронной системы Hawk-Eye в различных видах спорта Лабораторные работы по дисциплине: Базовые информационно-коммуникационные технологии

Лабораторные работы по дисциплине: Базовые информационно-коммуникационные технологии Сын Потапа. Рresentation csgo operation

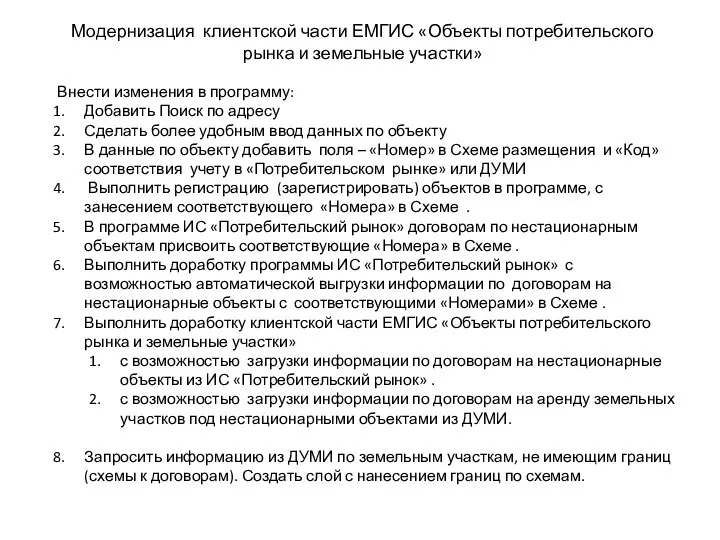

Сын Потапа. Рresentation csgo operation Модернизация клиентской части ЕМГИС Объекты потребительского рынка и земельные участки

Модернизация клиентской части ЕМГИС Объекты потребительского рынка и земельные участки Кодирование и шифрование данных

Кодирование и шифрование данных Создание 3D модели на основе операций твердотельного моделирования.(2 занятие)

Создание 3D модели на основе операций твердотельного моделирования.(2 занятие) Социальные группы

Социальные группы Table of Contents

Table of Contents Принципы построения телекоммуникационных вычислительных сетей (ТВС)

Принципы построения телекоммуникационных вычислительных сетей (ТВС) Zoom. Конференция для участника

Zoom. Конференция для участника Республиканский конкурс ИТ-Чемпион

Республиканский конкурс ИТ-Чемпион Алгоритмическая система Кумир

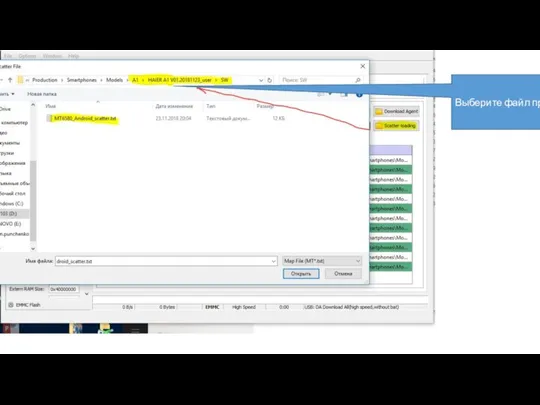

Алгоритмическая система Кумир Выберите файл

Выберите файл Кроссворд

Кроссворд Безопасный интернет

Безопасный интернет Сайт знакомств BezDebilov

Сайт знакомств BezDebilov Глава 2. Компьютер как универсальное устройство для работы с информацией. Тема 2.1. Основные компоненты компьютера и их функции

Глава 2. Компьютер как универсальное устройство для работы с информацией. Тема 2.1. Основные компоненты компьютера и их функции Аппаратное обеспечение ПК

Аппаратное обеспечение ПК Искусственные и естественные источники информации

Искусственные и естественные источники информации ORM в 1С-Битрикс. Выборка данных

ORM в 1С-Битрикс. Выборка данных