Содержание

- 3. Хайкин С. Нейронные сети: полный курс, 2-е изд., 2006 Гудфеллоу Я., Бенджио И., Курвилль А. Глубокое

- 7. Говорят, что компьютерная программа обучается на опыте E относительно некоторого класса задач T и меры качества

- 8. Классификация Классификация при отсутствии некоторых данных Регрессия Машинный перевод Структурный вывод Обнаружение аномалий Синтез и выборка

- 9. ОБУЧЕНИЕ

- 10. Ошибочная цель (неточная, неправильная) Ложные корреляции Накопление шума Технологические ошибки, неправильные запросы Данные не полны и/или

- 11. ЗАНЯТНЫЕ СОВПАДЕНИЯ

- 12. ЗАНЯТНЫЕ СОВПАДЕНИЯ

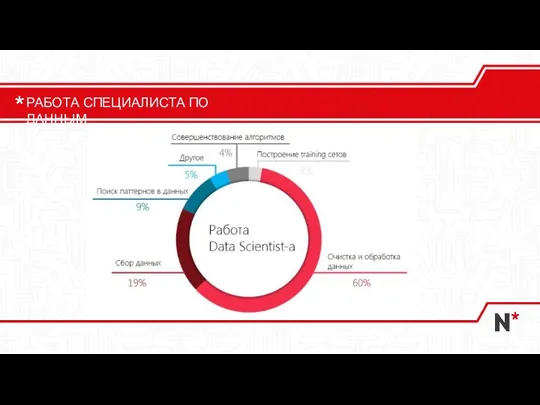

- 13. РАБОТА СПЕЦИАЛИСТА ПО ДАННЫМ

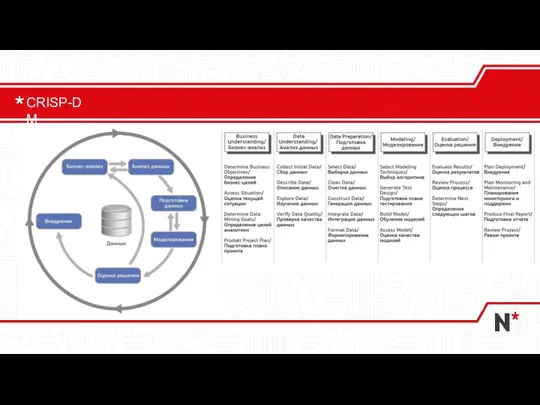

- 14. CRISP-DM

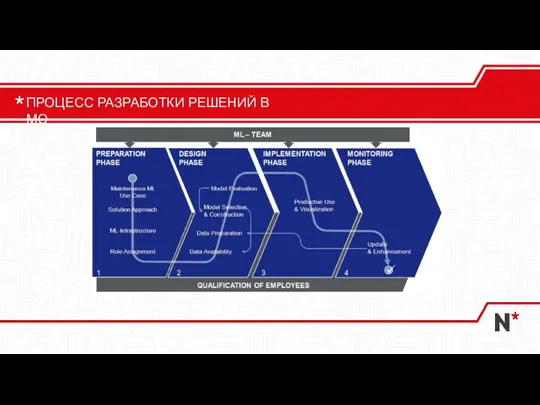

- 15. ПРОЦЕСС РАЗРАБОТКИ РЕШЕНИЙ В МО

- 16. DevOps DataOps ModelOps MLOps ГИБКИЕ ПРАКТИКИ

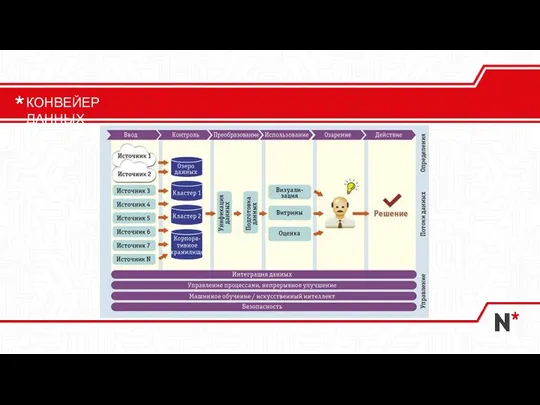

- 17. КОНВЕЙЕР ДАННЫХ

- 18. DATAOPS

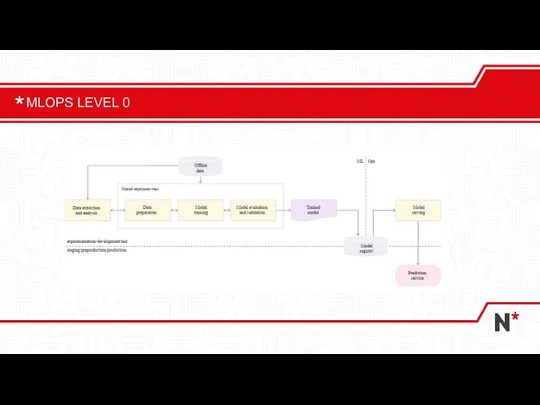

- 19. MLOPS LEVEL 0

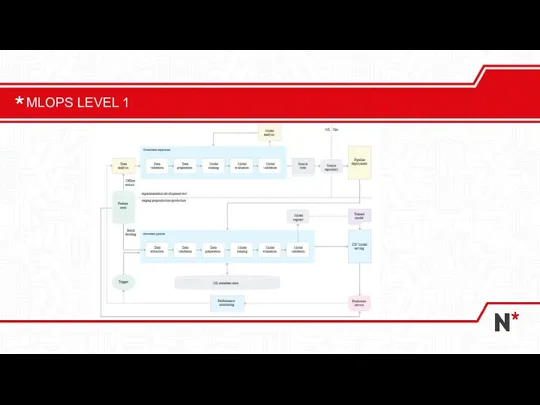

- 20. MLOPS LEVEL 1

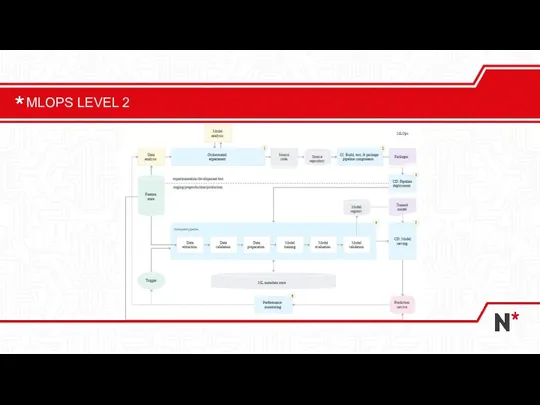

- 21. MLOPS LEVEL 2

- 22. Входные данные должны иметь смысл Ошибка в коде загрузчика Ошибки в разметке входных данных Слишком много

- 23. Извлекайте все данные, которые можно извлечь, но руководствуйтесь здравым смыслом. Оцените временной горизонт, полноту и корректность

- 24. Размерность пространства решения определяется количеством признаков и их увеличение приводит к экспоненциальному росту данных. Это в

- 25. тесная корреляционная взаимосвязь между отбираемыми для анализа признаками, совместно воздействующими на общий результат МУЛЬТИКОЛЛИНЕАРНОСТЬ

- 26. Инженерия признаков (feature extraction and feature engineering) – превращение данных, специфических для предметной области, в понятные

- 27. Исходные Производные Агрегированные – показатели, определенные по группе (сумма, среднее, минимум, максимум) Индикаторы – наличие или

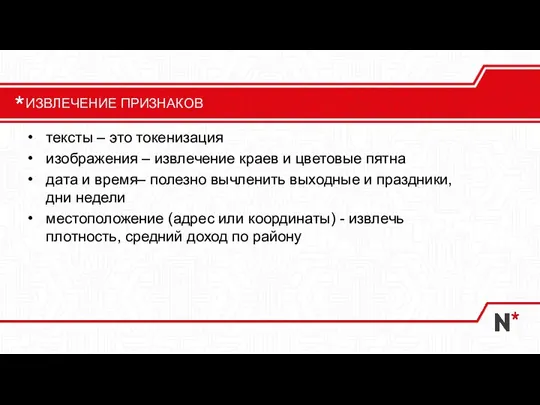

- 28. тексты – это токенизация изображения – извлечение краев и цветовые пятна дата и время– полезно вычленить

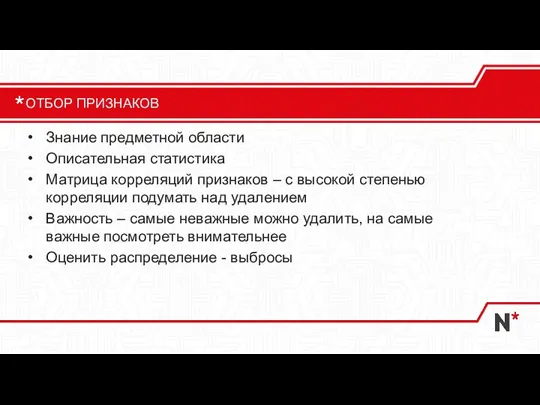

- 29. Знание предметной области Описательная статистика Матрица корреляций признаков – с высокой степенью корреляции подумать над удалением

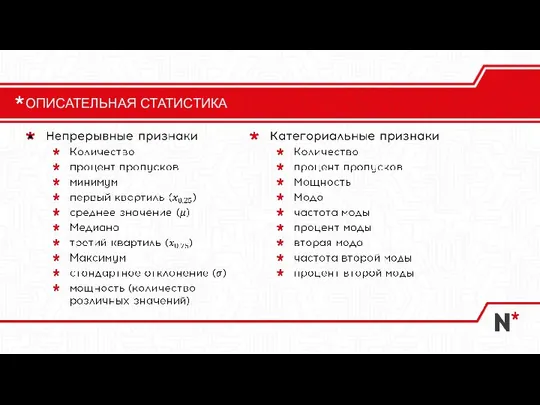

- 30. ОПИСАТЕЛЬНАЯ СТАТИСТИКА

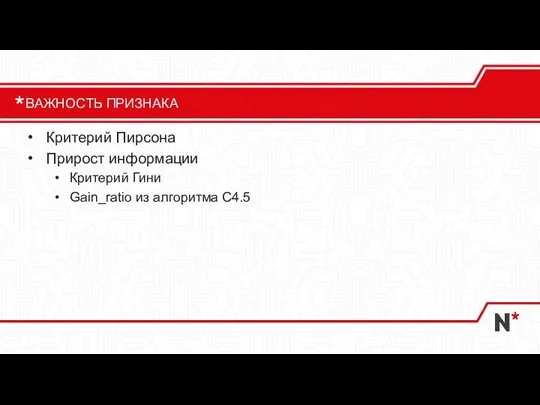

- 31. Критерий Пирсона Прирост информации Критерий Гини Gain_ratio из алгоритма C4.5 ВАЖНОСТЬ ПРИЗНАКА

- 32. КРИТЕРИЙ РАЗБИЕНИЯ

- 33. КРИТЕРИЙ РАЗБИЕНИЯ

- 34. КРИТЕРИЙ РАЗБИЕНИЯ

- 35. Неоткалиброванные признаки Слишком сильная аугментация Применение предобработки только для одной из выборок Долговечность признака Пропуски Нерегулярная

- 36. Если доля пропущенных значений выше 60%, такой признак стоит игнорировать Иногда сам факт отсутствия данных может

- 37. Не заполнять пропуски нулями! Не применять восстановление к признакам, имеющим более 30% пропусков среднее значение или

- 38. Если равна 1, полезной информации нет, удалить Если мощность значительно меньше количества экземпляров, можно изменить тип

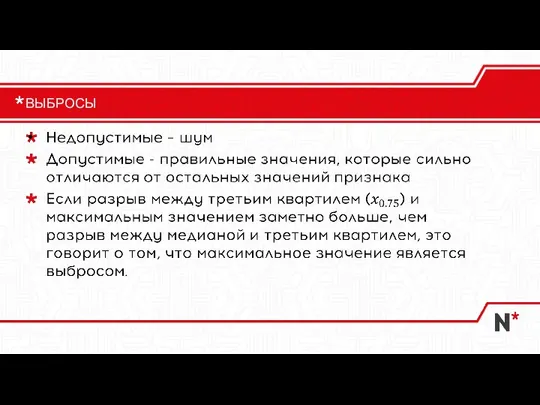

- 39. ВЫБРОСЫ

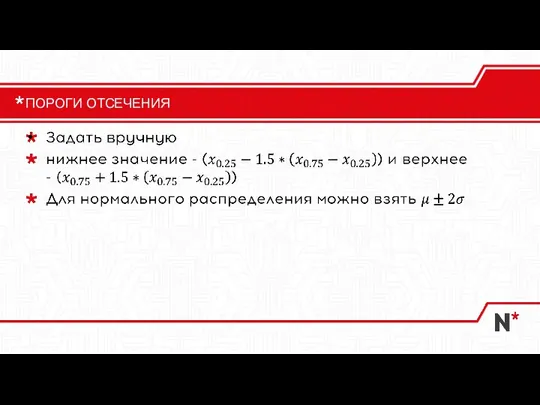

- 40. ПОРОГИ ОТСЕЧЕНИЯ

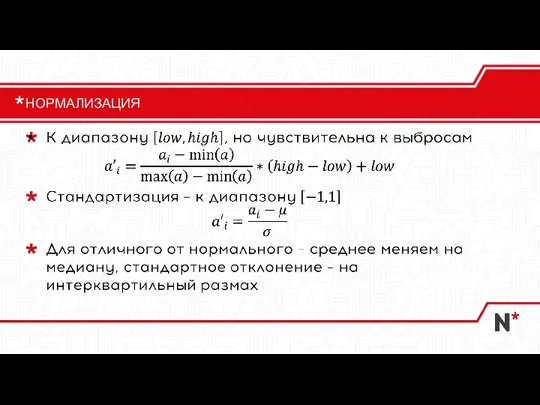

- 41. НОРМАЛИЗАЦИЯ

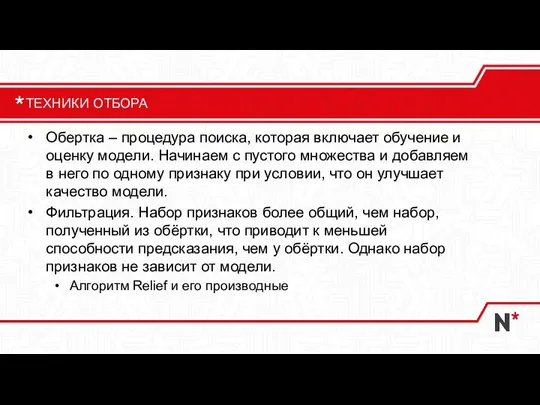

- 42. Обертка – процедура поиска, которая включает обучение и оценку модели. Начинаем с пустого множества и добавляем

- 44. Скачать презентацию

Презентация на тему Кодирование графики

Презентация на тему Кодирование графики  Защита конфиденциальной информации от несанкционированного доступа в автоматизированных системах

Защита конфиденциальной информации от несанкционированного доступа в автоматизированных системах Загальні принципи діі КС, структури високопродуктивних систем

Загальні принципи діі КС, структури високопродуктивних систем Программа - Ты предприниматель

Программа - Ты предприниматель EventsWallet — Платформа для успешного мероприятия

EventsWallet — Платформа для успешного мероприятия Windows Azure. Введение

Windows Azure. Введение Подача заявлений в 1 класс на портале АИС Е-услуги. Образование

Подача заявлений в 1 класс на портале АИС Е-услуги. Образование Профессия таргетолога и SMM-специалиста с нуля до первых проектов

Профессия таргетолога и SMM-специалиста с нуля до первых проектов Web – конструирование на HTML

Web – конструирование на HTML It инфраструктура корпорации

It инфраструктура корпорации Simcenter femap 2022.1

Simcenter femap 2022.1 Модели жизненного цикла

Модели жизненного цикла Системы счисления. Двоичное представление информации

Системы счисления. Двоичное представление информации Стратегия развития информационного общества

Стратегия развития информационного общества Website new slides

Website new slides Поняття текстового документа, його об'єктів. Текстовий процесор, його призначення. Середовище текстового процесора

Поняття текстового документа, його об'єктів. Текстовий процесор, його призначення. Середовище текстового процесора Машинное обучение: линейные модели final

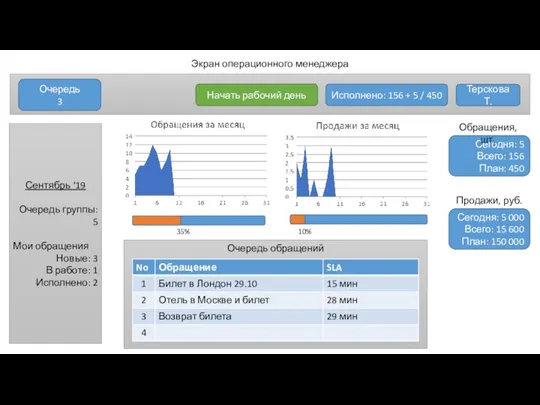

Машинное обучение: линейные модели final Экран операционного менеджера

Экран операционного менеджера Глобальные вызовы сетевого пространства: мотивы экстремистского речевого поведения

Глобальные вызовы сетевого пространства: мотивы экстремистского речевого поведения Rejestracja pracownika

Rejestracja pracownika Основы программирования. Поиск на графах

Основы программирования. Поиск на графах Алфавитный подход к измерению информации

Алфавитный подход к измерению информации Профиль Информационные системы в СМИ

Профиль Информационные системы в СМИ SWOT-анализ

SWOT-анализ Zakipki.Hack. Библиотека программиста

Zakipki.Hack. Библиотека программиста Презентация на тему Алгебра логики первая часть

Презентация на тему Алгебра логики первая часть  одирование тестовой, графической и звуковой информации

одирование тестовой, графической и звуковой информации Носители информации (результаты анкетирования)

Носители информации (результаты анкетирования)