Слайд 2Внутренний вид среднестатистического датацентра

Слайд 3Основные технические вызовы в классическом ДЦ

Электропитание (300 Вт на юнит, 10-12 КВт

на стойку,резерв)

Охлаждение (1 КВт ~ 3400 BTU/час, резерв)

Пожаротушение (фреон, углекислота, порошок уходи)

Управление трафиком

Контроль доступа

Борьба с владельцами здания

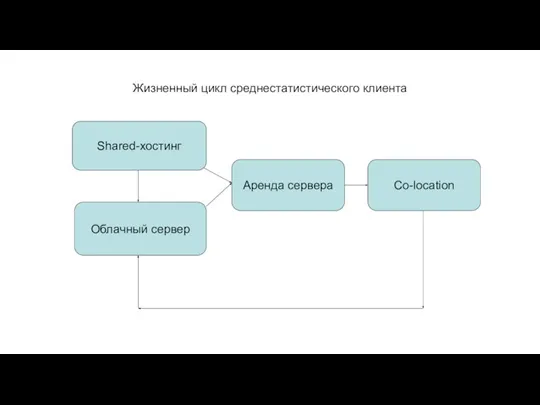

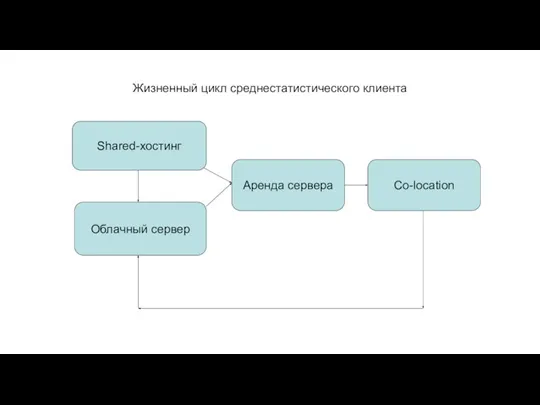

Слайд 4Жизненный цикл среднестатистического клиента

Shared-хостинг

Облачный сервер

Аренда сервера

Co-location

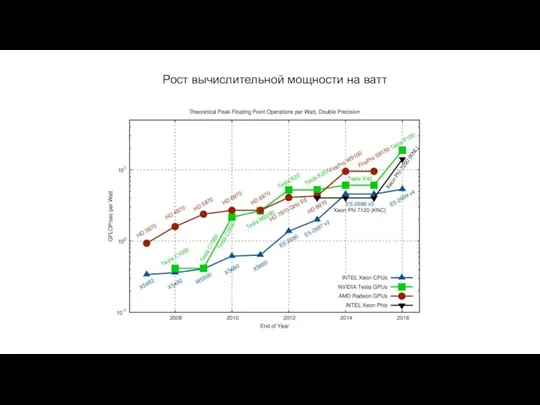

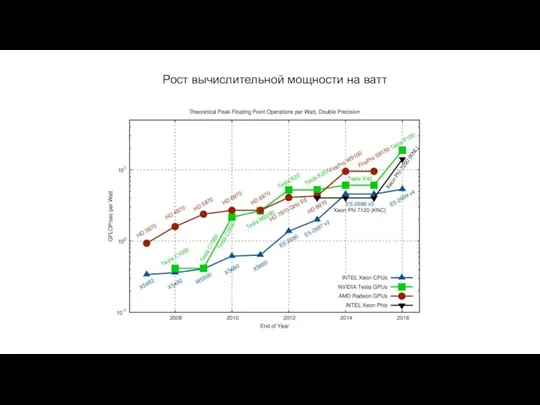

Слайд 5Рост вычислительной мощности на ватт

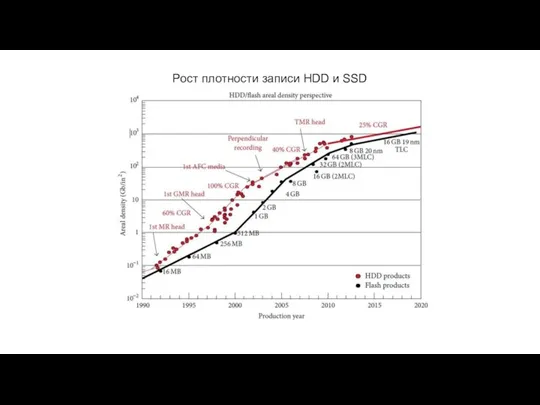

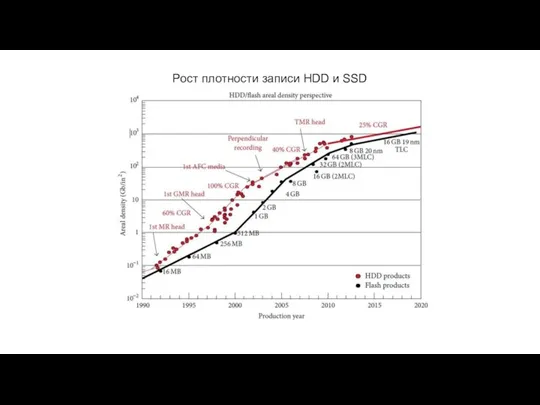

Слайд 6Рост плотности записи HDD и SSD

Слайд 7Увеличение плотности компоновки устройств

HP DL380G4

2004 год

HP DL380 Gen9

2014 год

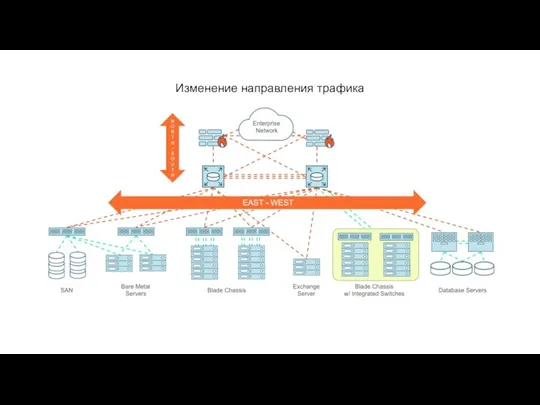

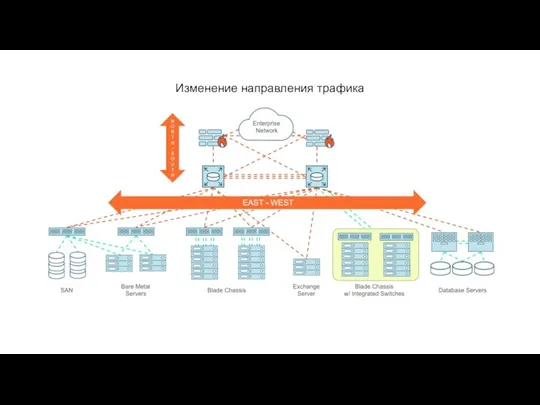

Слайд 8Изменение направления трафика

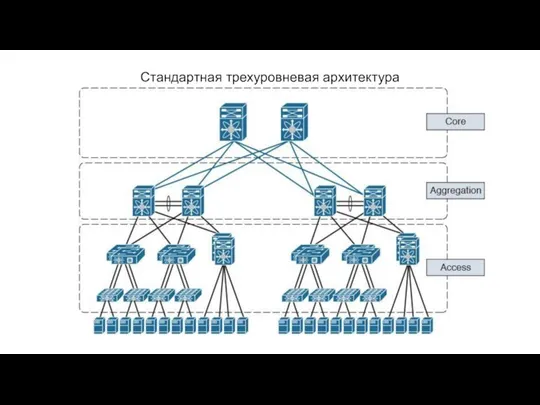

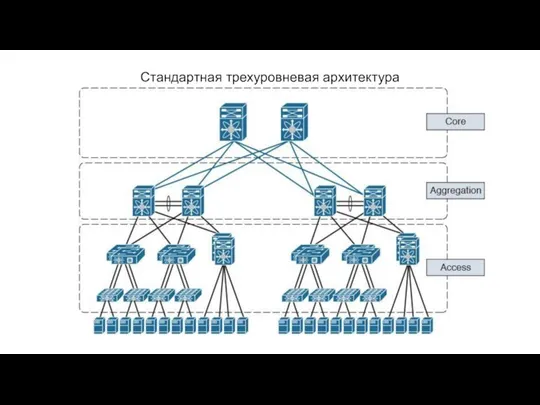

Слайд 9Стандартная трехуровневая архитектура

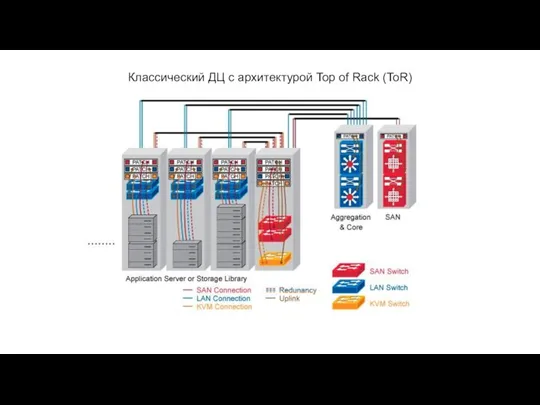

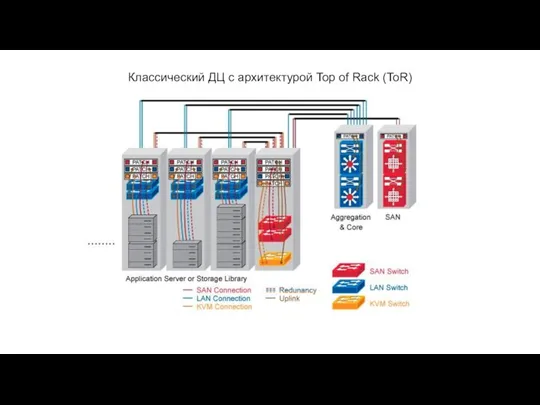

Слайд 10Классический ДЦ с архитектурой Top of Rack (ToR)

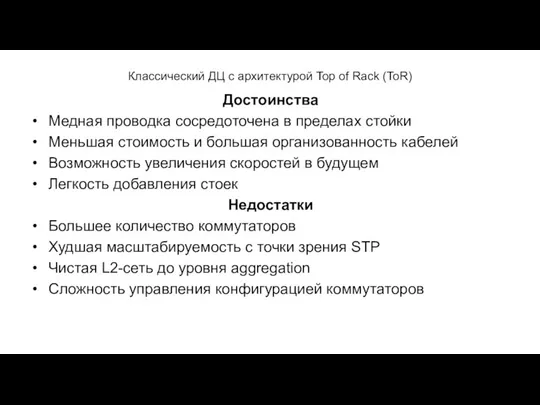

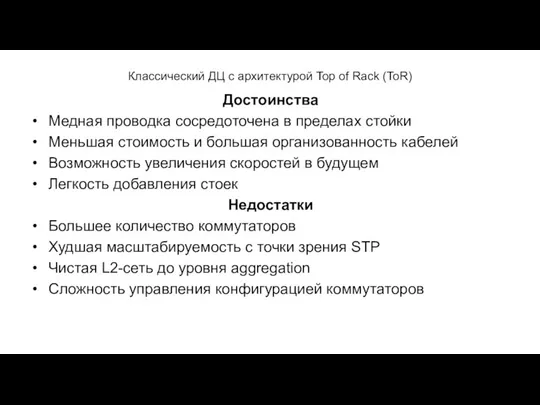

Слайд 11Классический ДЦ с архитектурой Top of Rack (ToR)

Достоинства

Медная проводка сосредоточена в пределах

стойки

Меньшая стоимость и большая организованность кабелей

Возможность увеличения скоростей в будущем

Легкость добавления стоек

Недостатки

Большее количество коммутаторов

Худшая масштабируемость с точки зрения STP

Чистая L2-сеть до уровня aggregation

Сложность управления конфигурацией коммутаторов

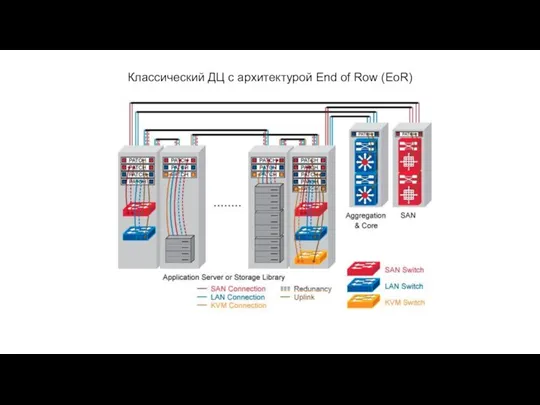

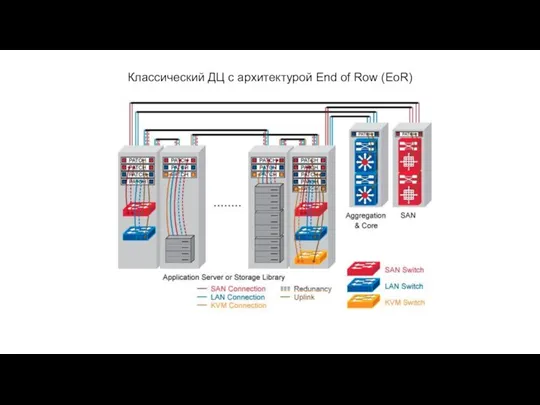

Слайд 12Классический ДЦ с архитектурой End of Row (EoR)

Слайд 13Классический ДЦ с архитектурой End of Row (EoR)

Достоинства

Меньшее количество коммутаторов

Лучшая масштабируемость с

точки зрения STP

Меньшее количество портов на уровне aggregation

Общая точка конфигурирования на весь ряд

Недостатки

Безумная медная проводка через весь ряд

Сложность поддержания патч-панелей в порядке

Увеличение скоростей выше 10G крайне проблематично

Добавление стойки превращается в войсковую операцию

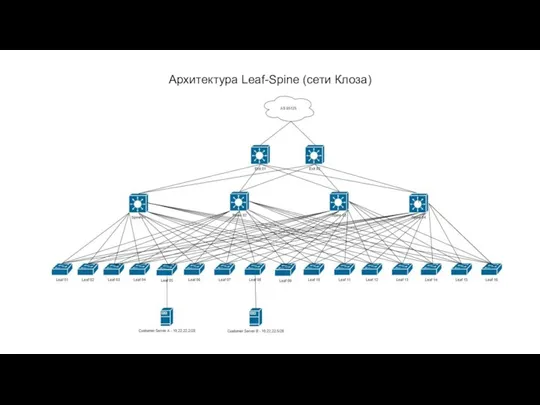

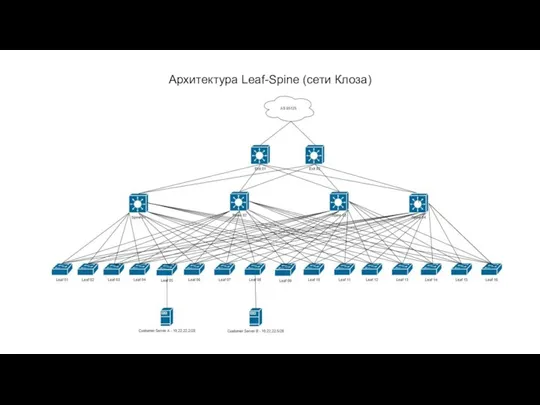

Слайд 14Архитектура Leaf-Spine (сети Клоза)

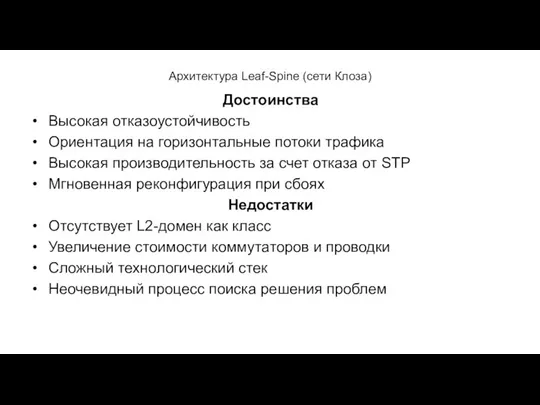

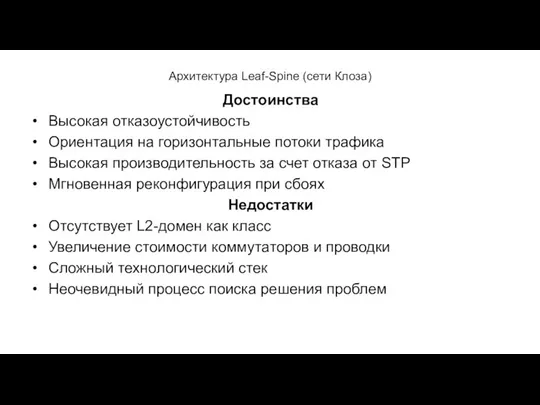

Слайд 15Архитектура Leaf-Spine (сети Клоза)

Достоинства

Высокая отказоустойчивость

Ориентация на горизонтальные потоки трафика

Высокая производительность за счет

отказа от STP

Мгновенная реконфигурация при сбоях

Недостатки

Отсутствует L2-домен как класс

Увеличение стоимости коммутаторов и проводки

Сложный технологический стек

Неочевидный процесс поиска решения проблем

Слайд 16А теперь со всем этим мы попытаемся взлететь..

Слайд 17Классический сценарий балансировки/резервирования нагрузки

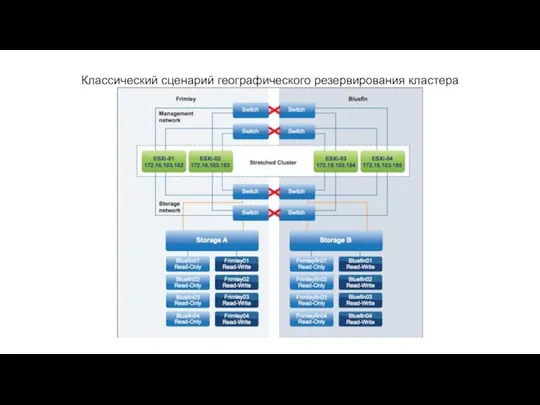

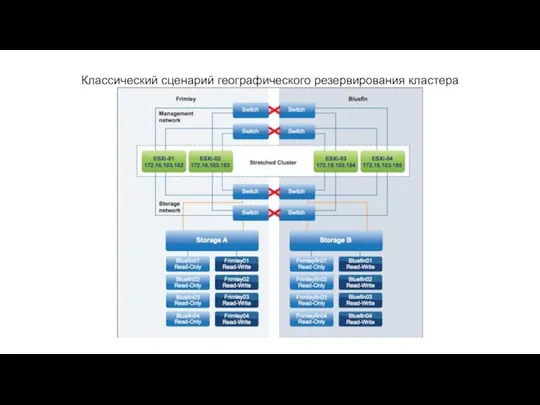

Слайд 18Классический сценарий географического резервирования кластера

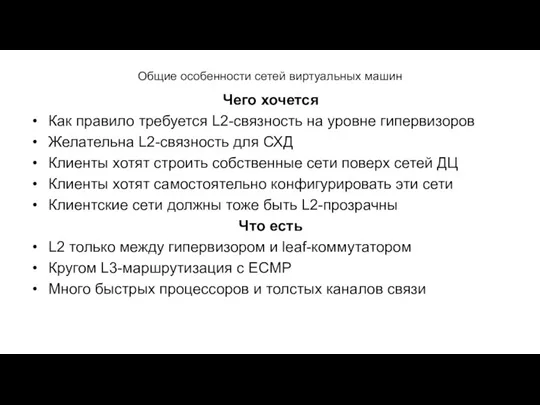

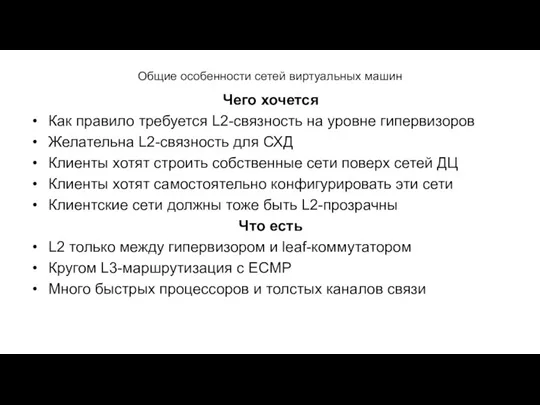

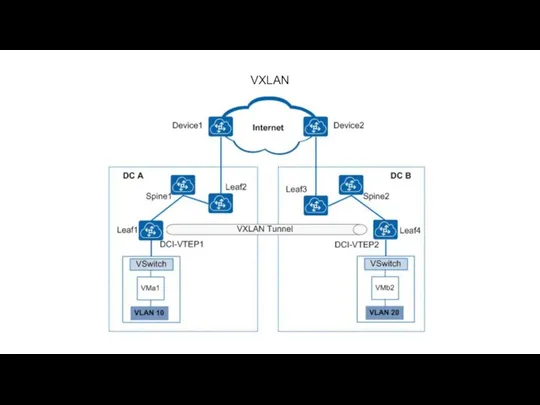

Слайд 19Общие особенности сетей виртуальных машин

Чего хочется

Как правило требуется L2-связность на уровне гипервизоров

Желательна

L2-связность для СХД

Клиенты хотят строить собственные сети поверх сетей ДЦ

Клиенты хотят самостоятельно конфигурировать эти сети

Клиентские сети должны тоже быть L2-прозрачны

Что есть

L2 только между гипервизором и leaf-коммутатором

Кругом L3-маршрутизация с ECMP

Много быстрых процессоров и толстых каналов связи

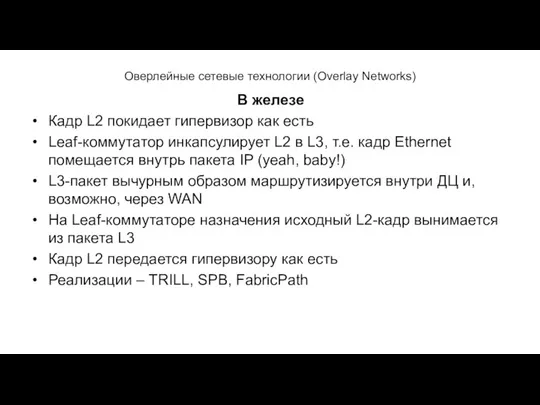

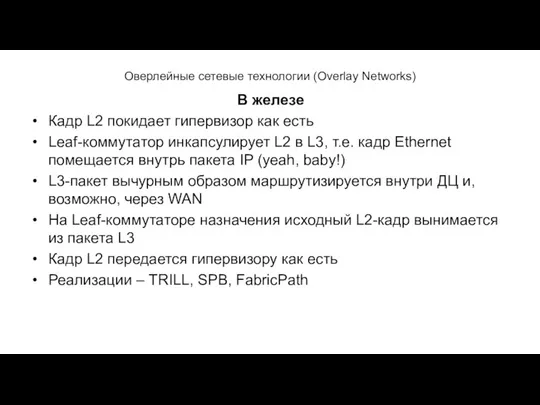

Слайд 20Оверлейные сетевые технологии (Overlay Networks)

В железе

Кадр L2 покидает гипервизор как есть

Leaf-коммутатор инкапсулирует

L2 в L3, т.е. кадр Ethernet помещается внутрь пакета IP (yeah, baby!)

L3-пакет вычурным образом маршрутизируется внутри ДЦ и, возможно, через WAN

На Leaf-коммутаторе назначения исходный L2-кадр вынимается из пакета L3

Кадр L2 передается гипервизору как есть

Реализации – TRILL, SPB, FabricPath

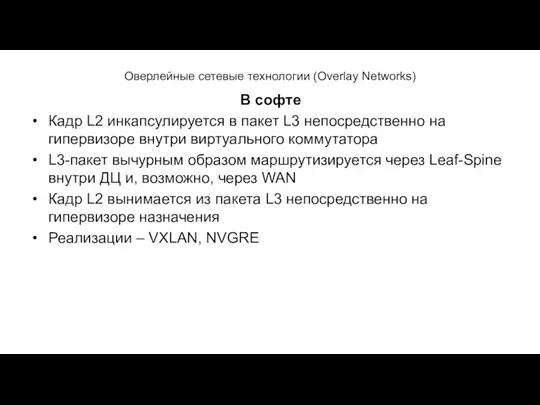

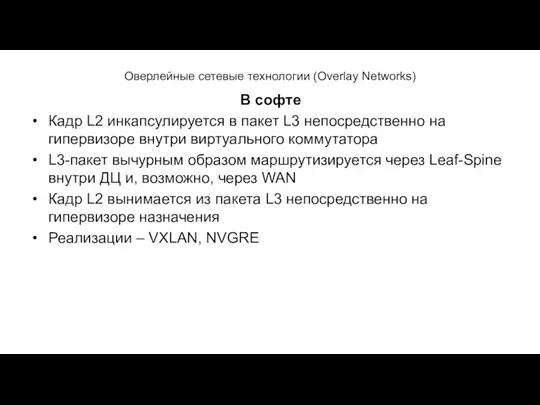

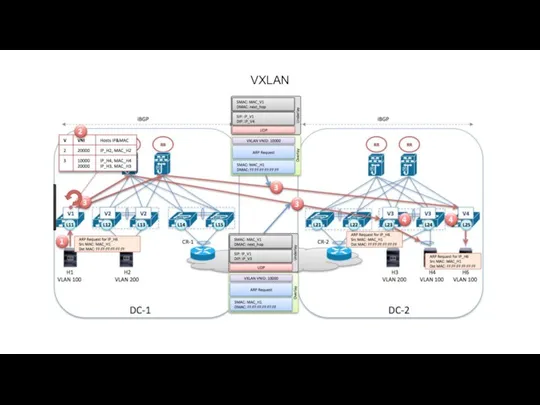

Слайд 21Оверлейные сетевые технологии (Overlay Networks)

В софте

Кадр L2 инкапсулируется в пакет L3 непосредственно

на гипервизоре внутри виртуального коммутатора

L3-пакет вычурным образом маршрутизируется через Leaf-Spine внутри ДЦ и, возможно, через WAN

Кадр L2 вынимается из пакета L3 непосредственно на гипервизоре назначения

Реализации – VXLAN, NVGRE

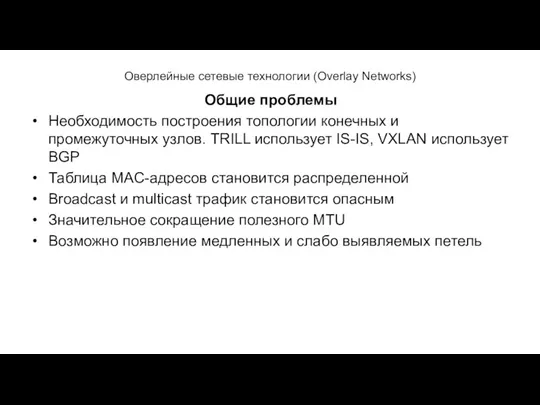

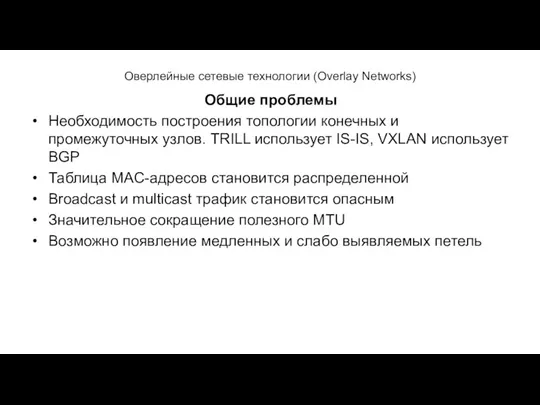

Слайд 22Оверлейные сетевые технологии (Overlay Networks)

Общие проблемы

Необходимость построения топологии конечных и промежуточных узлов.

TRILL использует IS-IS, VXLAN использует BGP

Таблица MAC-адресов становится распределенной

Broadcast и multicast трафик становится опасным

Значительное сокращение полезного MTU

Возможно появление медленных и слабо выявляемых петель

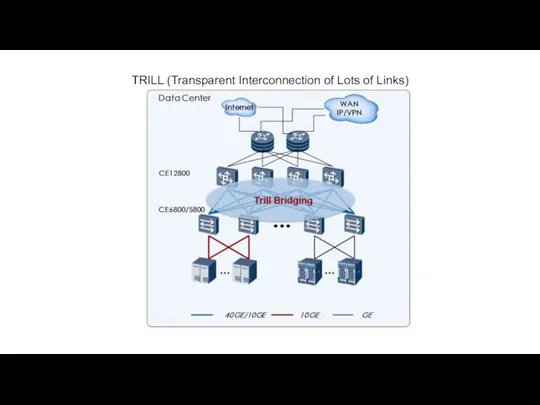

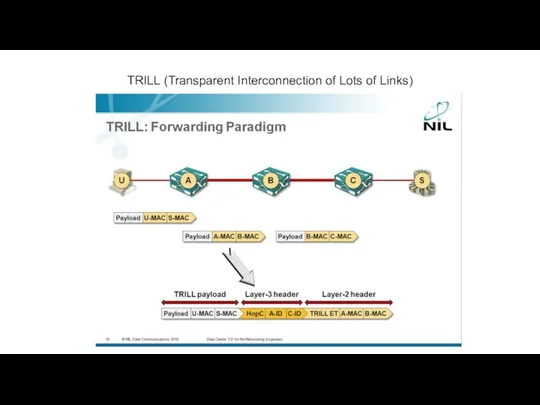

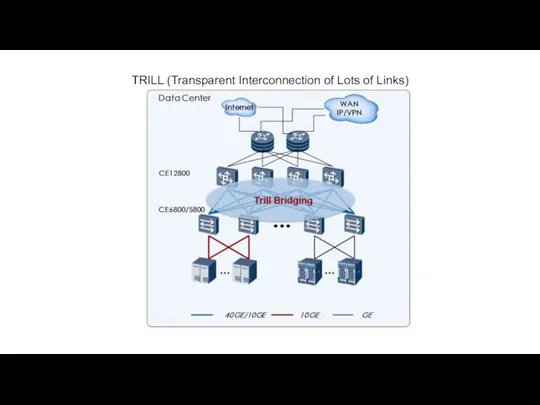

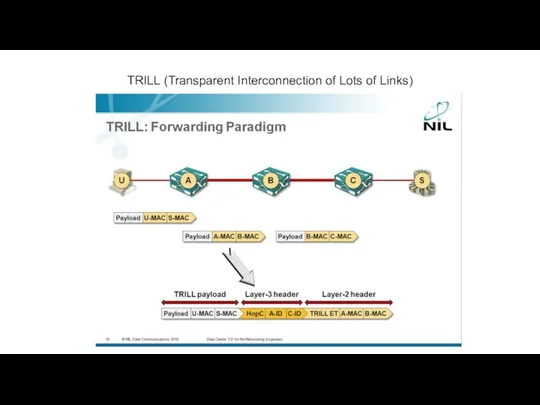

Слайд 23TRILL (Transparent Interconnection of Lots of Links)

Слайд 24TRILL (Transparent Interconnection of Lots of Links)

Свинограм

Свинограм Лекция 1

Лекция 1 Системы счисления. Математические основы информатики

Системы счисления. Математические основы информатики Модель Захмана

Модель Захмана Система управления НТД и требованиями. Техэксперт

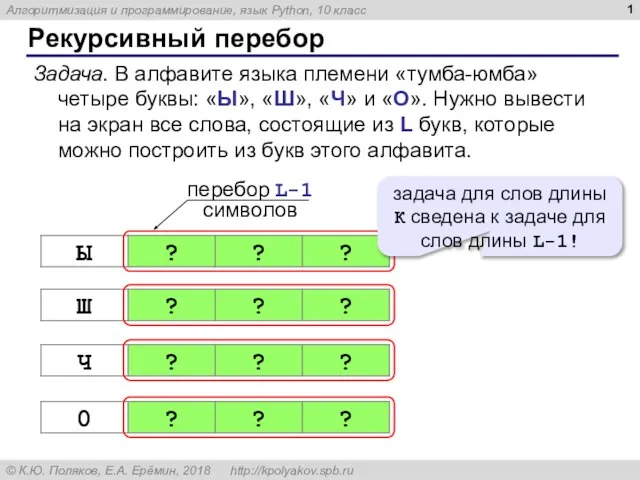

Система управления НТД и требованиями. Техэксперт Рекурсивный перебор. Алгоритмизация и программирование, язык Python

Рекурсивный перебор. Алгоритмизация и программирование, язык Python Цвета. Урок 10

Цвета. Урок 10 Вычисление площади поверхности конуса в табличном процессоре MS Excel

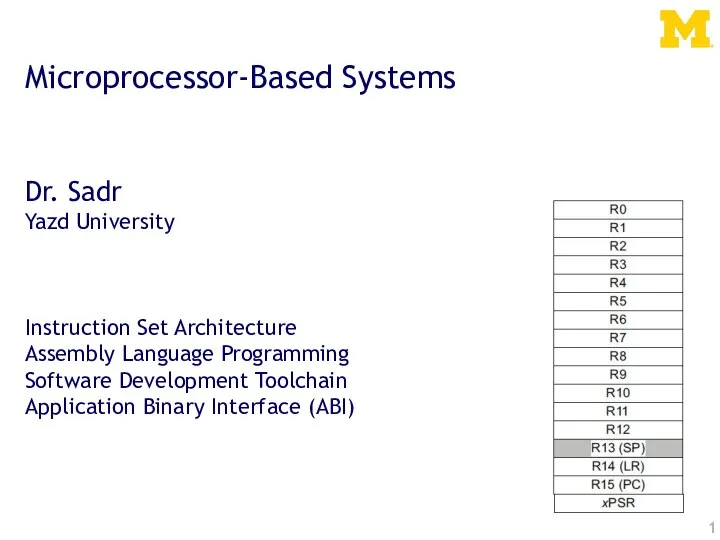

Вычисление площади поверхности конуса в табличном процессоре MS Excel Microprocessor-Based Systems

Microprocessor-Based Systems Текстовый редактор

Текстовый редактор Комплектование документного фонда в библиотеке

Комплектование документного фонда в библиотеке Компьютер. Процессор и память. Устройства ввода. Устройства вывода

Компьютер. Процессор и память. Устройства ввода. Устройства вывода Технология построения диаграммы Варианты использования в UML

Технология построения диаграммы Варианты использования в UML Мой графический редактор

Мой графический редактор Эффективные мобильные приложения для изучения английского языка

Эффективные мобильные приложения для изучения английского языка Cети ЦВМ - системообразующий элемент сложных технических систем

Cети ЦВМ - системообразующий элемент сложных технических систем Адресация в интернете

Адресация в интернете Сообщение по методу Цезаря

Сообщение по методу Цезаря Исследователи читальных залов: готовность к новым технологиям и краудсорсингу

Исследователи читальных залов: готовность к новым технологиям и краудсорсингу Уровневая модель ISO

Уровневая модель ISO Услуги компьютерных сетей. Удаленная база данных

Услуги компьютерных сетей. Удаленная база данных Сети, их виды. Топология сетей. Лекция 5

Сети, их виды. Топология сетей. Лекция 5 Обработка фото в Lightroom

Обработка фото в Lightroom Растровая и векторная графика

Растровая и векторная графика Анализ соцсети

Анализ соцсети Тест по информатике

Тест по информатике Разработка дополнительного программного модуля для конфигурации 1с предприятие

Разработка дополнительного программного модуля для конфигурации 1с предприятие Презентація (1)

Презентація (1)