Индуктивное моделирование: содержание и примеры применения в задачах обработки текстов М. Александров Академия народного хозяйст

Содержание

- 2. Содержание Введение Коллеги и соавторы Индуктивное моделирование Статистический стеммер Subjectivity/Sentiment analysis Терминография Ресурсы

- 3. Введение История ИМСОМ = Индуктивный Метод Самоорганизации Моделей Был разработан в в 70-80 годы акад. А.Г.

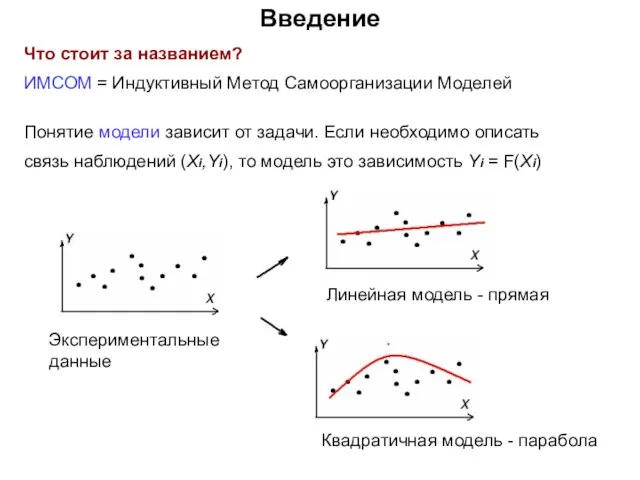

- 4. Введение Что стоит за названием? ИМСОМ = Индуктивный Метод Самоорганизации Моделей Понятие модели зависит от задачи.

- 5. Введение В чем индуктивность? Индукция = из частных случаев делают обобщенный вывод Дедукция = из общего

- 6. Введение В чем самоорганизация? Саморганизация системы – это изменение ее структуры/параметров под влиянием внешних условий Самоорганизация

- 7. Введение Возможности ИМСОМ позволяет выбрать модель оптимальной сложности из заданного класса моделей, чтобы описать ограниченный набор

- 8. Введение Терминология Термин ИМСОМ был почти сразу заменен авторами метода на термин МГУА МГУА = метод

- 9. Содержание Введение Коллеги и соавторы Индуктивное моделирование Статистический стеммер Subjectivity/Sentiment analysis Терминография Ресурсы

- 10. Коллеги и соавторы Pavel Makagonov Titled Research Professor Mixteca University of Technology, Mexico Ex Vice-Director of

- 11. Коллеги и соавторы Xavier Blanco Titled Professor of French Philology Department Universidad Autonoma de Barcelona, Spain

- 12. Коллеги и соавторы Alexander Gelbukh Chief of NLP Laboratory Center for Computing Research National Polytechnic Institute,

- 13. Содержание Введение Коллеги и соавторы Индуктивное моделирование Статистический стеммер Subjectivity/Sentiment analysis Терминография Ресурсы

- 14. Индуктивное Моделирование Классы и сложность модели ИМСОМ имеет дело с заранее фиксированным классом моделей. Класс моделей

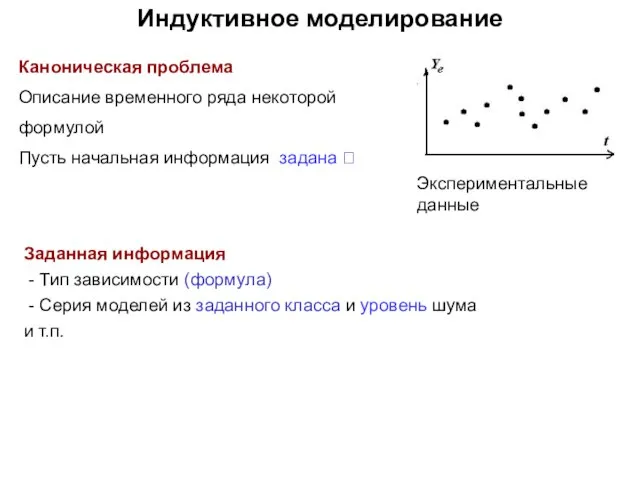

- 15. Индуктивное моделирование Каноническая проблема Описание временного ряда некоторой формулой Пусть начальная информация задана ? Заданная информация

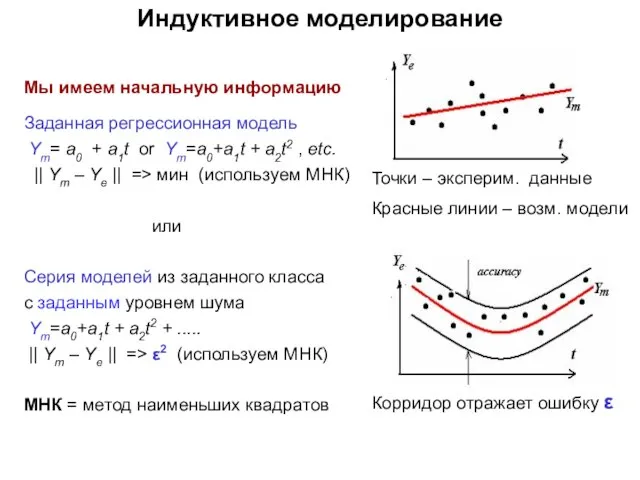

- 16. Индуктивное моделирование Мы имеем начальную информацию Заданная регрессионная модель Ym= a0 + a1t or Ym=a0+a1t +

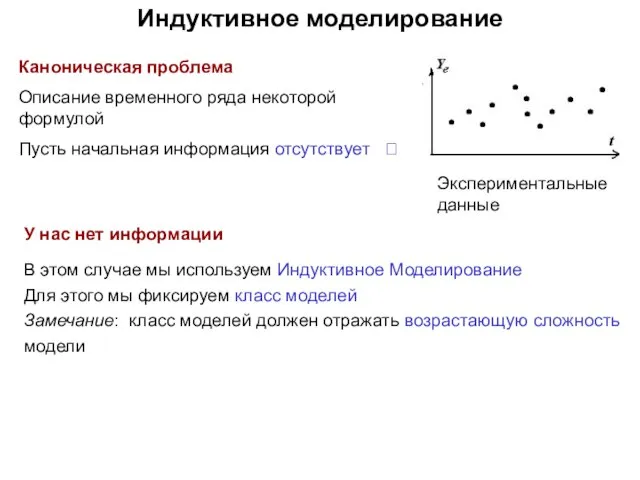

- 17. Индуктивное моделирование Каноническая проблема Описание временного ряда некоторой формулой Пусть начальная информация отсутствует ? У нас

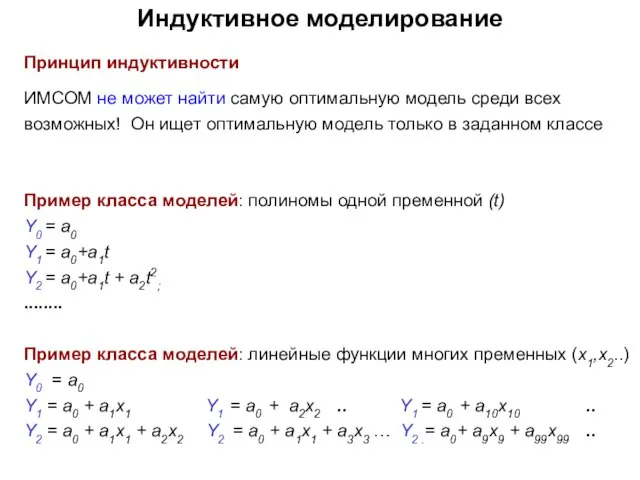

- 18. Индуктивное моделирование Принцип индуктивности ИМСОМ не может найти самую оптимальную модель среди всех возможных! Он ищет

- 19. Индуктивное моделирование Подход 1 Мы должны обеспечить хорошее свойство прогнозирования, то есть ограниченную чувствительность к новым

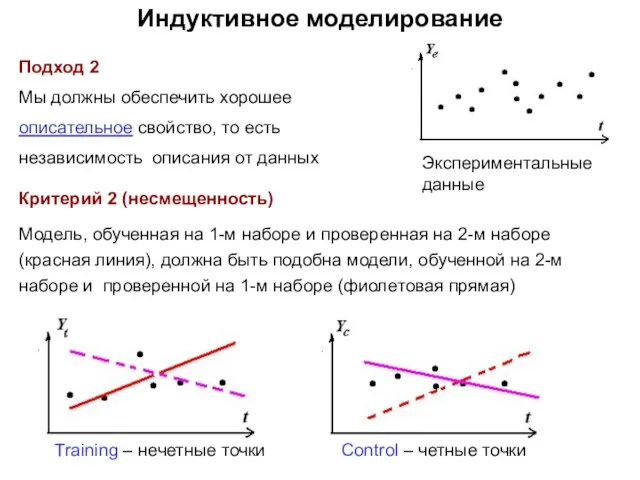

- 20. Индуктивное моделирование Подход 2 Мы должны обеспечить хорошее описательное свойство, то есть независимость описания от данных

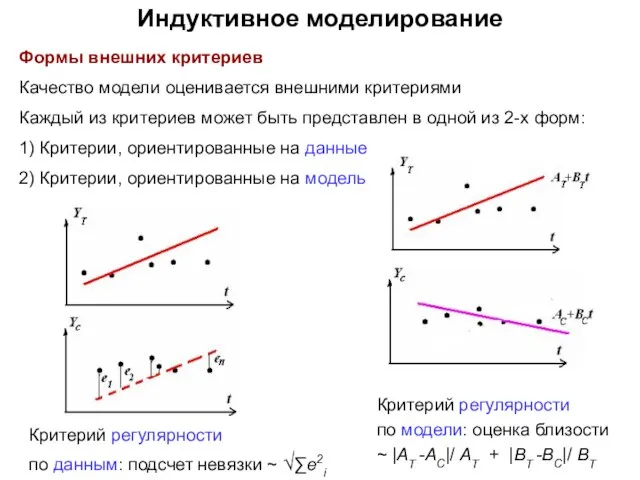

- 21. Индуктивное моделирование Формы внешних критериев Качество модели оценивается внешними критериями Каждый из критериев может быть представлен

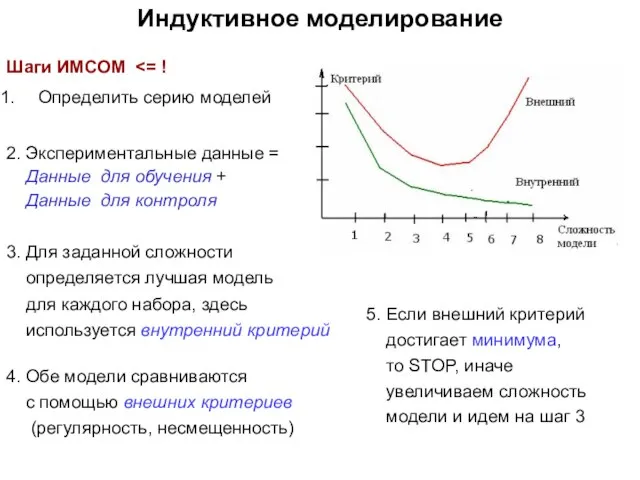

- 22. Индуктивное моделирование Шаги ИМСОМ Определить серию моделей 2. Экспериментальные данные = Данные для обучения + Данные

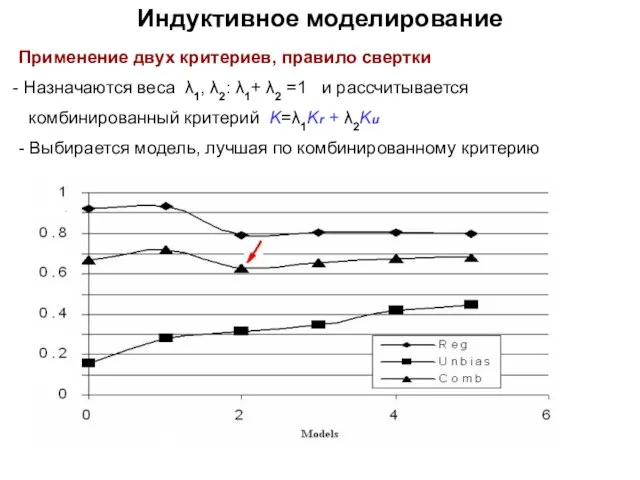

- 23. Индуктивное моделирование Применение двух критериев, правило свертки Назначаются веса λ1, λ2: λ1+ λ2 =1 и рассчитывается

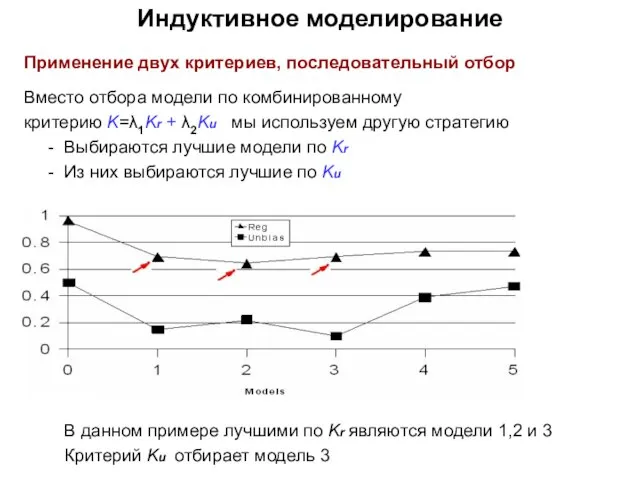

- 24. Индуктивное моделирование Применение двух критериев, последовательный отбор Вместо отбора модели по комбинированному критерию K=λ1Kr + λ2Ku

- 25. Индуктивное моделирование Подавление шума Утверждение Пусть имеем N-данных наблюдений y1, y2, y3, ....yN Пусть имеем k-параметров

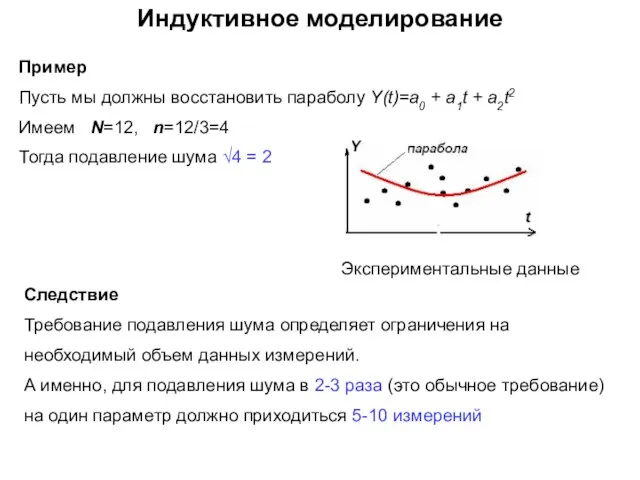

- 26. Индуктивное моделирование Пример Пусть мы должны восстановить параболу Y(t)=a0 + a1t + a2t2 Имеем N=12, n=12/3=4

- 27. Варианты ИМСОМ Имеется два традиционных варианта: 1) Комбинаторный вариант ИСОМ - КОМБИ Перебираются всевозможные модели в

- 28. Индуктивное моделирование Пример применения селекции Пусть имеем 20 точек наблюдений = 10 (обучение) + 10 (контроль)

- 29. Содержание Введение Коллеги и соавторы Индуктивное моделирование Статистический стеммер Subjectivity/Sentiment analysis Терминография Ресурсы

- 30. Постановка задачи Предмет рассмотрения Статистический стеммер. Построение эмпирической формулы, обученной на примерах Техника Индуктивное моделирование

- 31. Постановка задачи Стемминг Состоит в выборе части слова, отражающей основное значение слова Примеры sad, sadly, sadness,

- 32. Постановка задачи Проблема Построить формулу для принятия решения о подобии пары слов Актуальность Нам приходится обрабатывать

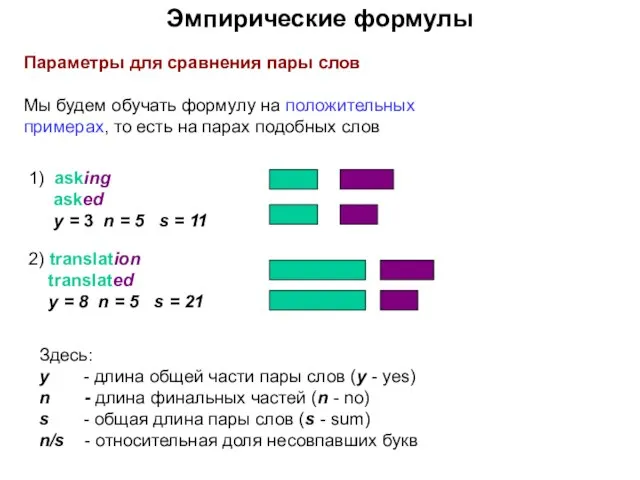

- 33. Эмпирические формулы Параметры для сравнения пары слов Мы будем обучать формулу на положительных примерах, то есть

- 34. Эмпирические формулы Требования Построенная формула должна отражать два обстоятельства: Поддержать факт, что небольшое относительное число несовпавших

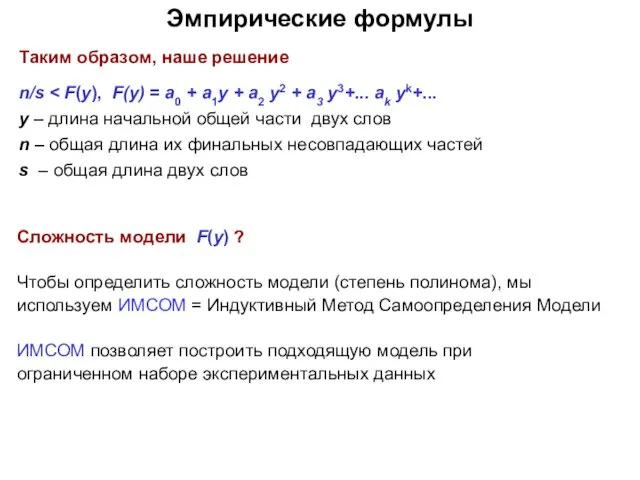

- 35. Эмпирические формулы Модели для принятия решений Какую формулу стоит настраивать под примеры, заданные экспертом? n/s Здесь:

- 36. Эмпирические формулы Число степеней свободы Как было указано выше, формула должна зависеть от: - относительной доли

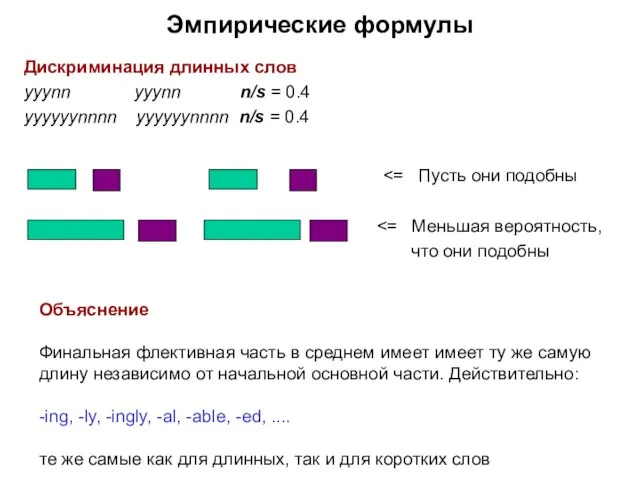

- 37. Дискриминация длинных слов yyynn yyynn n/s = 0.4 yyyyyynnnn yyyyyynnnn n/s = 0.4 что они подобны

- 38. Эмпирические формулы Сложность модели F(y) ? Чтобы определить сложность модели (степень полинома), мы используем ИМСОМ =

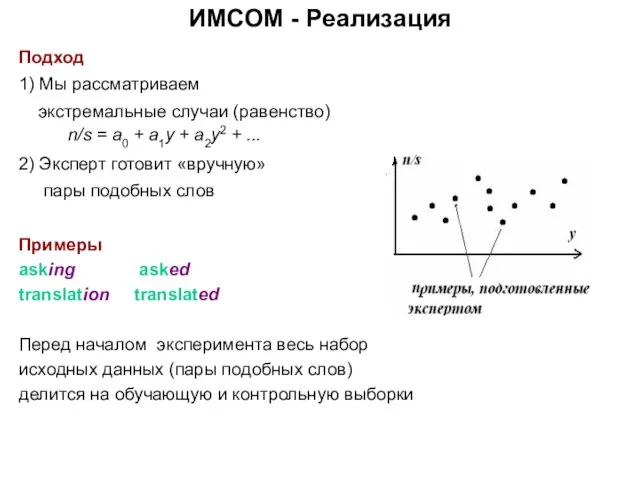

- 39. Подход 1) Мы рассматриваем экстремальные случаи (равенство) n/s = a0 + a1y + a2y2 + ...

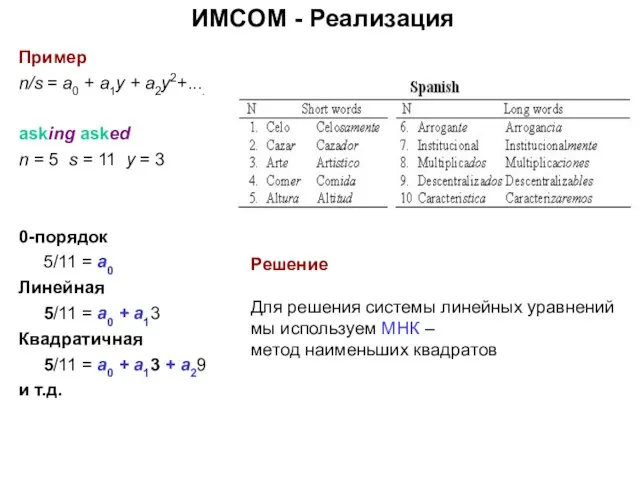

- 40. ИМСОМ - Реализация Пример n/s = a0 + a1y + a2y2+.... asking asked n = 5

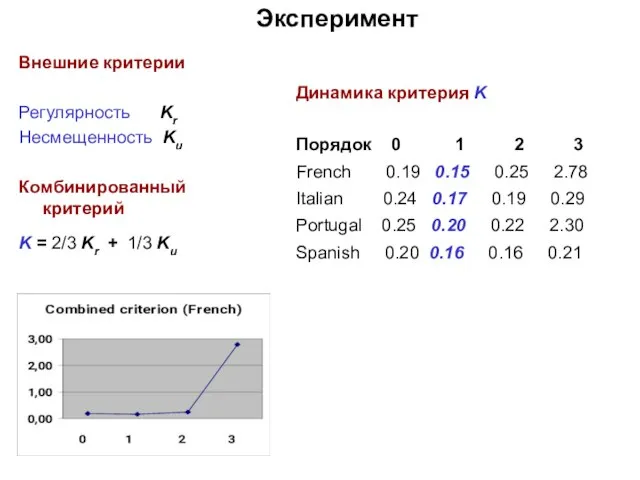

- 41. Внешние критерии Регулярность Kr Несмещенность Ku Комбинированный критерий K = 2/3 Kr + 1/3 Ku Эксперимент

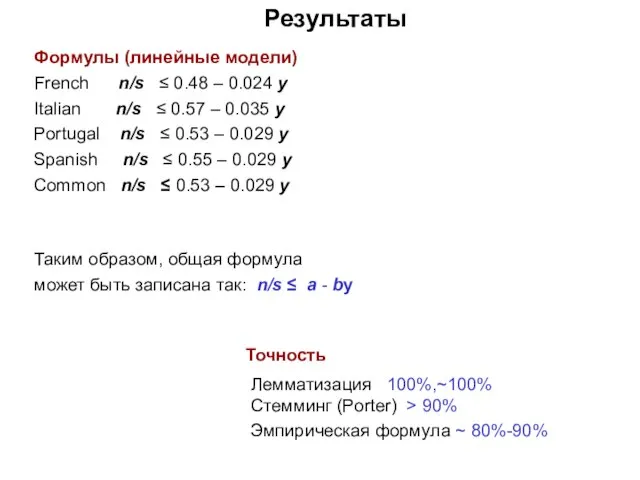

- 42. Результаты Формулы (линейные модели) French n/s ≤ 0.48 – 0.024 y Italian n/s ≤ 0.57 –

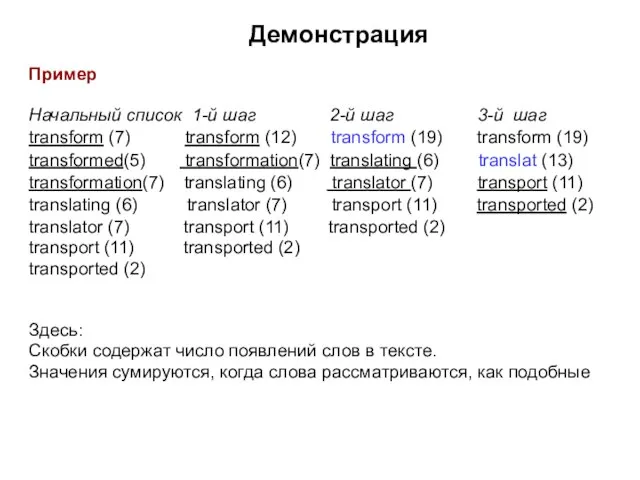

- 43. Демонстрация Пример Начальный список 1-й шаг 2-й шаг 3-й шаг transform (7) transform (12) transform (19)

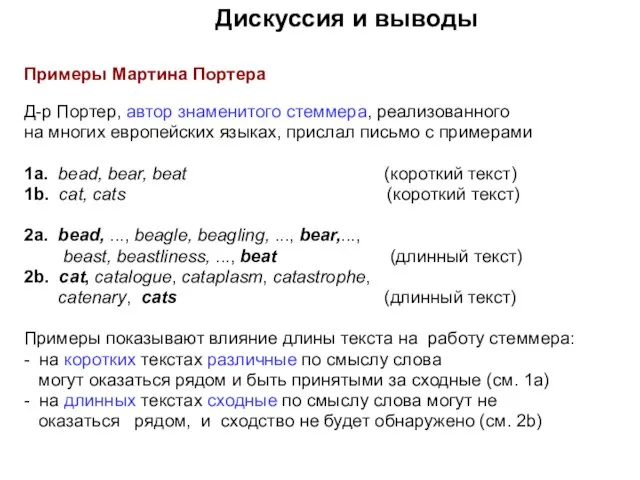

- 44. Дискуссия и выводы Примеры Мартина Портера Д-р Портер, автор знаменитого стеммера, реализованного на многих европейских языках,

- 45. Дискуссия и выводы Недостатки стеммера - Относительно низкая точность (80%-90%) - Зависимость результатов применения от длины

- 46. Содержание Введение Коллеги и соавторы Индуктивное моделирование Статистический стеммер Subjectivity/Sentiment analysis Терминография Ресурсы

- 47. Введение Предмет рассмотрения Subjectivity/Sentiment analysis. Построение эмпирических формул для автоматической оценки вежливости, удовлетворенности и компетентности на

- 48. Введение Subjectivity/Sentiment анализ это область обработки естественных языков (NLP), которая направлена на автоматическую оценку эмоций и

- 49. Введение Одно из приложений SSA это обработка диалогов. В настоящее время такая обработка широко используется для

- 50. Исходные данные Данные состояли из 85 диалогов между пассажирами и справочной железнодорожного вокзала Барселоны Язык –

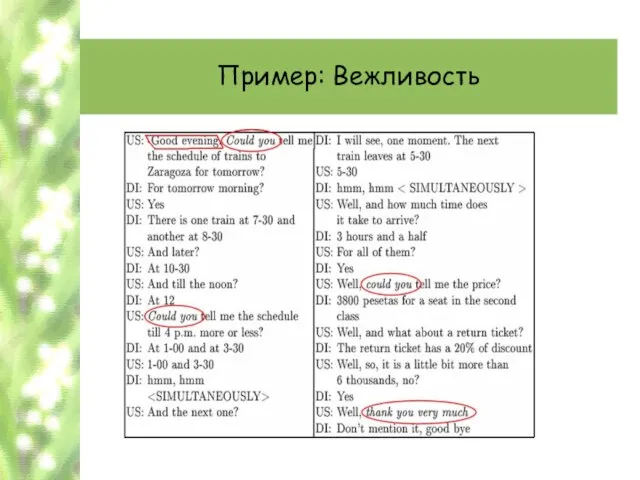

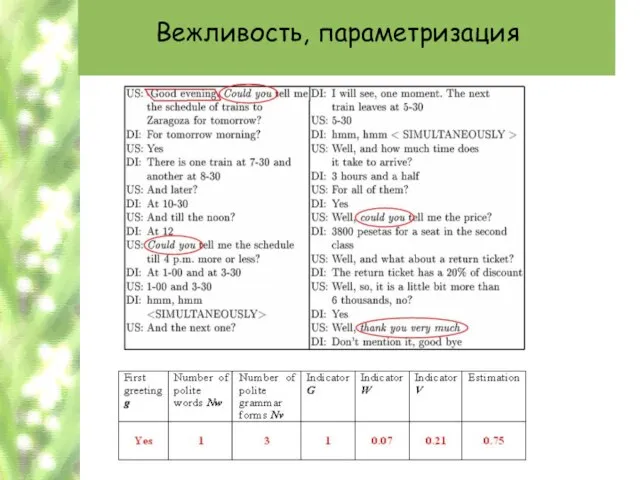

- 51. Пример: Вежливость

- 52. Вежливость, параметризация А. Индиктор первого приветствия (g - greeting) Имеет значение 1, при первом приветствии «Could

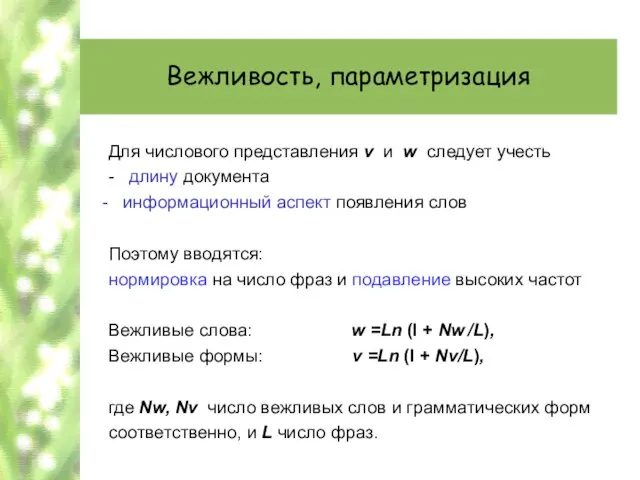

- 53. Вежливость, параметризация Для числового представления v и w следует учесть - длину документа информационный аспект появления

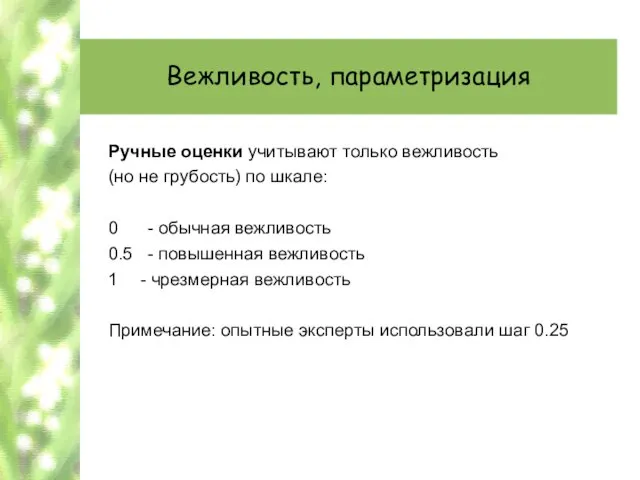

- 54. Вежливость, параметризация Ручные оценки учитывают только вежливость (но не грубость) по шкале: 0 - обычная вежливость

- 55. Вежливость, параметризация

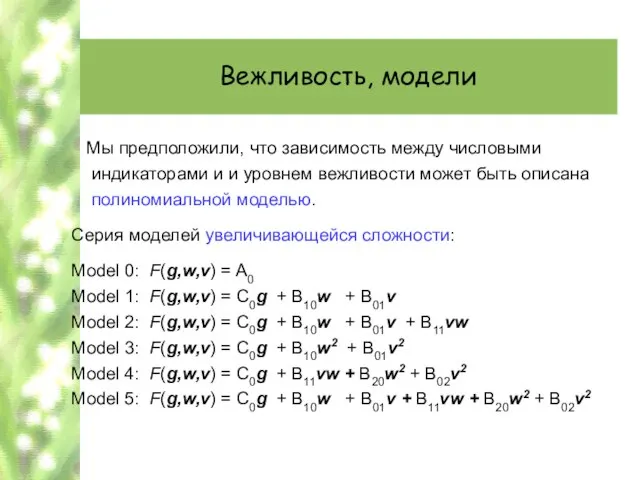

- 56. Вежливость, модели Мы предположили, что зависимость между числовыми индикаторами и и уровнем вежливости может быть описана

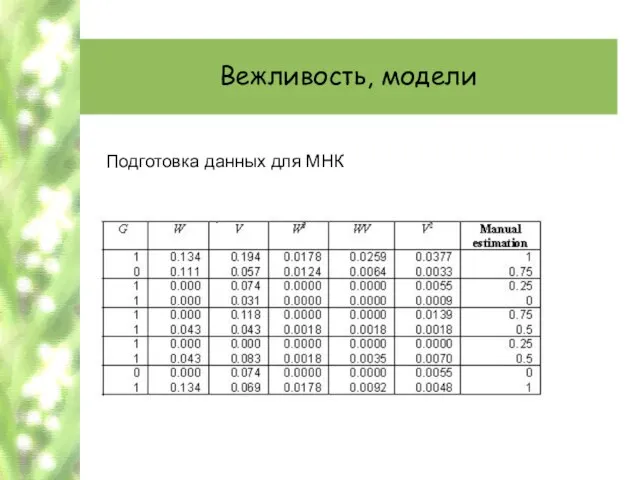

- 57. Вежливость, модели Подготовка данных для МНК

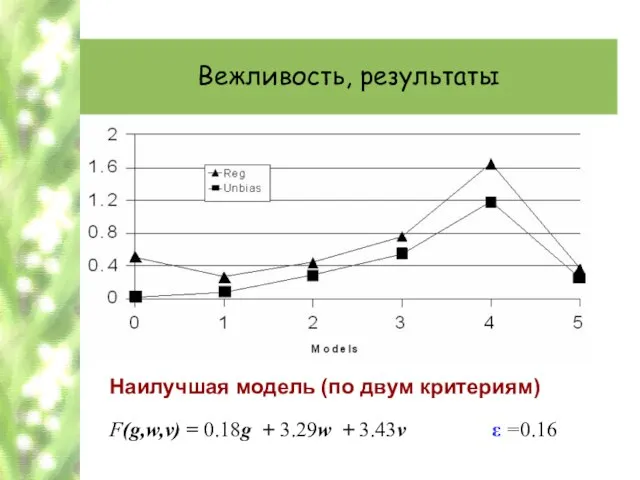

- 58. Вежливость, результаты Наилучшая модель (по двум критериям) F(g,w,v) = 0.18g + 3.29w + 3.43v ε =0.16

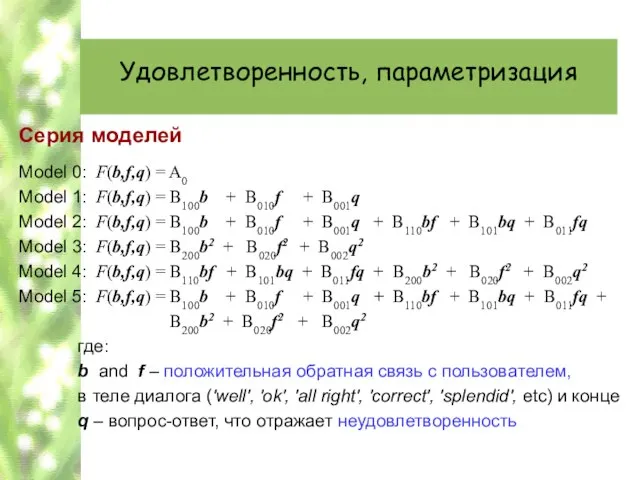

- 59. Удовлетворенность, параметризация Серия моделей Model 0: F(b,f,q) = A0 Model 1: F(b,f,q) = B100b + B010f

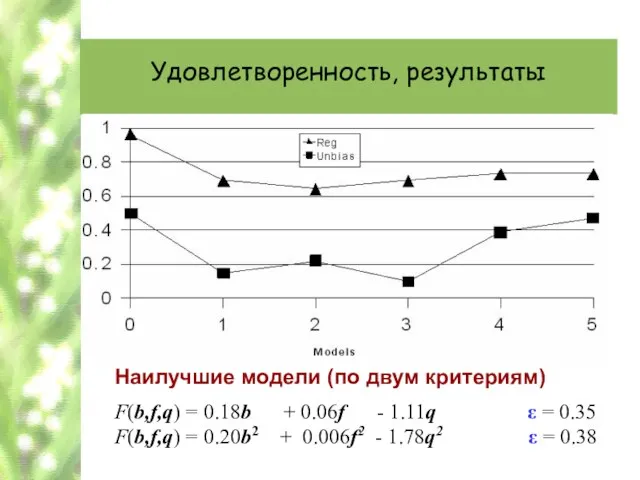

- 60. Удовлетворенность, результаты Наилучшие модели (по двум критериям) F(b,f,q) = 0.18b + 0.06f - 1.11q ε =

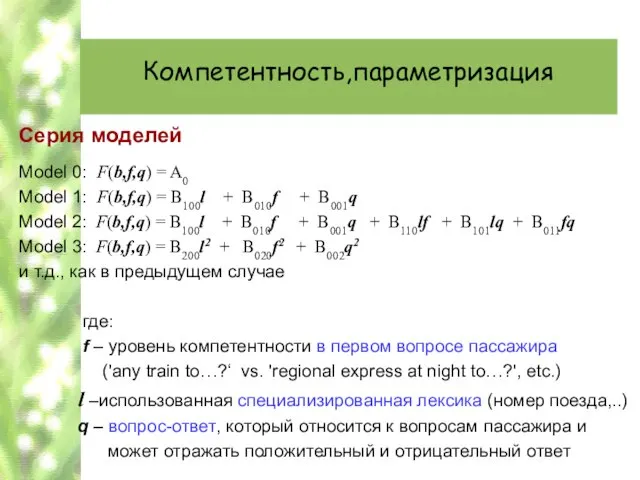

- 61. Компетентность,параметризация Серия моделей Model 0: F(b,f,q) = A0 Model 1: F(b,f,q) = B100l + B010f +

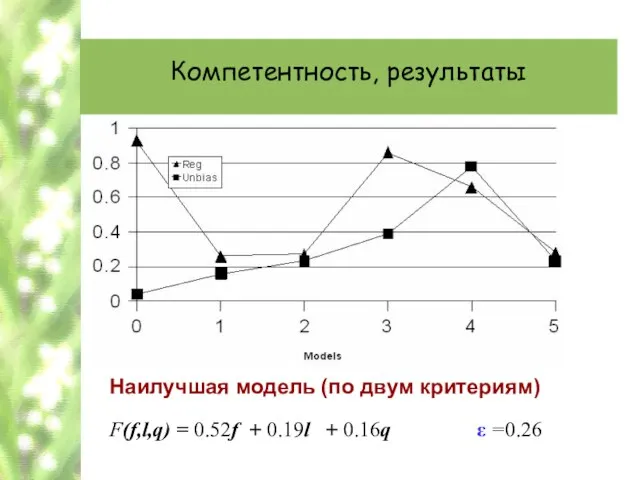

- 62. Компетентность, результаты Наилучшая модель (по двум критериям) F(f,l,q) = 0.52f + 0.19l + 0.16q ε =0.26

- 63. Выводы 1. ИМСОМ обеспечивает методологию для автоматической оценки различных «размытых» характеристик диалога, имеющих высокий уовень субъективности

- 64. Содержание Введение Коллеги и соавторы Индуктивное моделирование Статистический стеммер Subjectivity/Sentiment analysis Терминография Ресурсы

- 65. Предмет рассмотрения Терминография. Выявление гранулярности терминов заданной предметной области Техника Идеи индуктивного моделирования

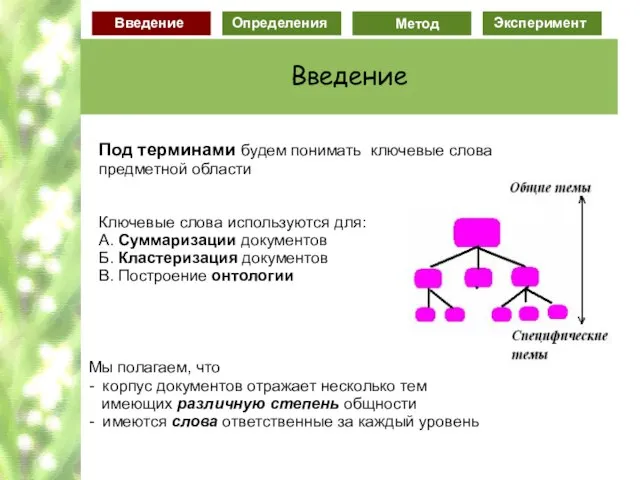

- 66. Под терминами будем понимать ключевые слова предметной области Ключевые слова используются для: A. Суммаризации документов Б.

- 67. Главные термины области Рост специфичности Применения гранулированных терминов: 1. Суммаризация документов по различным уровням детальности 2.

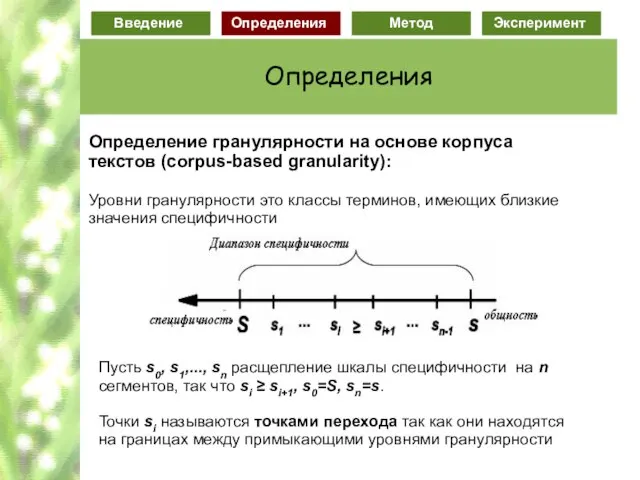

- 68. Определение гранулярности на основе корпуса текстов (corpus-based granularity): Уровни гранулярности это классы терминов, имеющих близкие значения

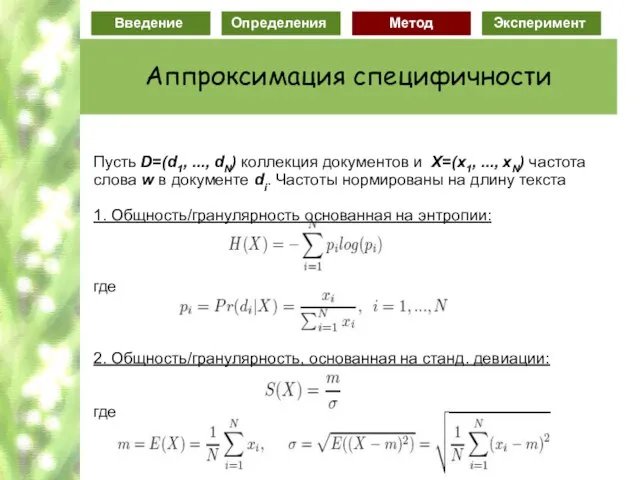

- 69. Definitions Определение проблемы: Выявление уровней гранулярности эквивалентно проблеме размещения точек перехода на оси специфичности. Проблема гранулярности

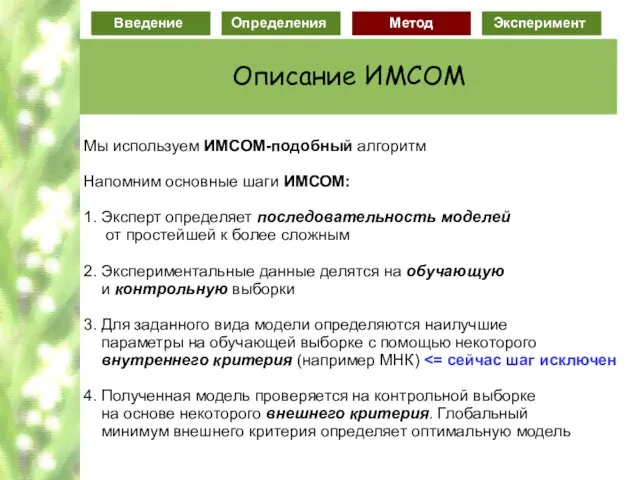

- 71. Мы используем ИМСОМ-подобный алгоритм Напомним основные шаги ИМСОМ: 1. Эксперт определяет последовательность моделей от простейшей к

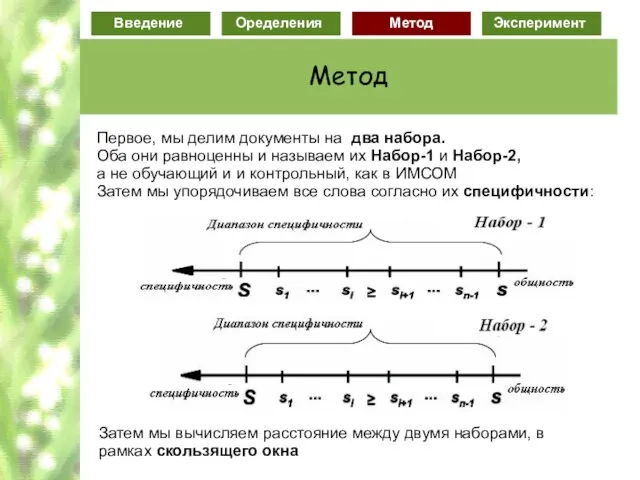

- 72. Первое, мы делим документы на два набора. Оба они равноценны и называем их Набор-1 и Набор-2,

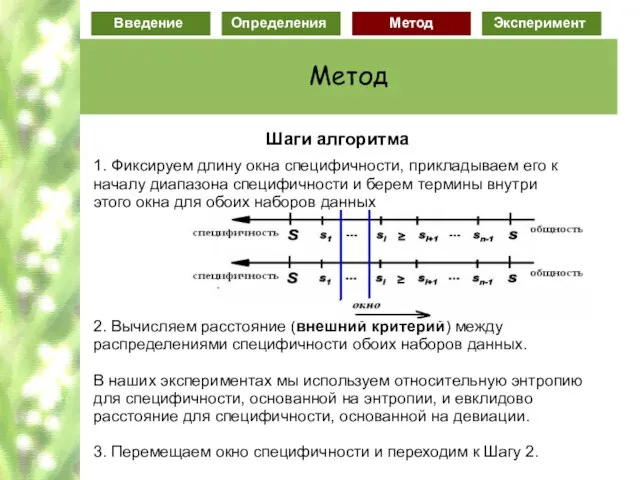

- 73. Шаги алгоритма 1. Фиксируем длину окна специфичности, прикладываем его к началу диапазона специфичности и берем термины

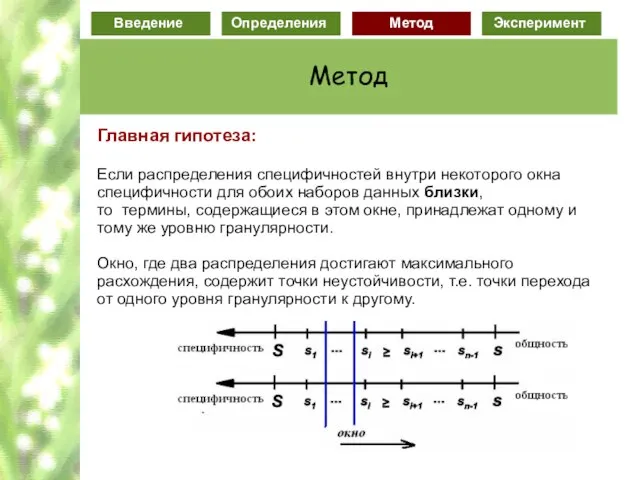

- 74. Главная гипотеза: Если распределения специфичностей внутри некоторого окна специфичности для обоих наборов данных близки, то термины,

- 75. Внешние критерии Давайте зафиксируем одно и тоже окно Δs = [s1,s2] внутри диапазонов специфичности для каждого

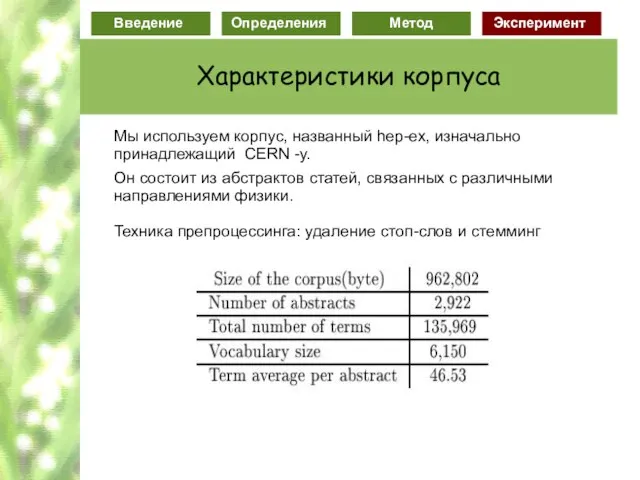

- 76. Мы используем корпус, названный hep-ex, изначально принадлежащий CERN -у. Он состоит из абстрактов статей, связанных с

- 77. Поведение критерия K1 (основанный на энтропии) для различной длины окна

- 78. Поведение критерия K1 (основанного на энтропии) для различных разбиений корпуса

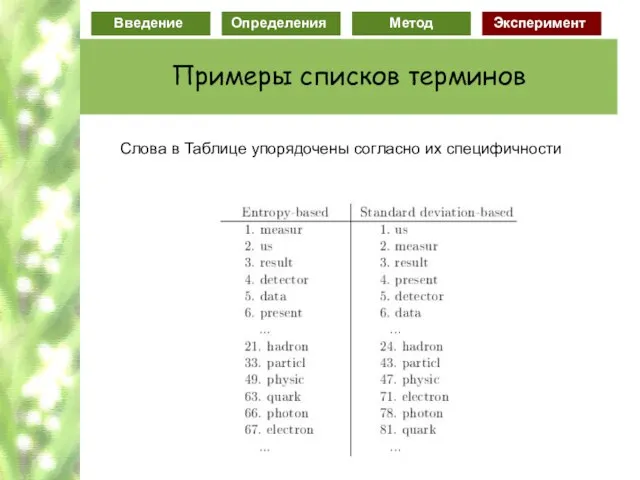

- 81. Слова в Таблице упорядочены согласно их специфичности

- 82. 1) Мы постарались формализовать понятие гранулярности для терминологии предметной области. Для этого мы ввели различные меры

- 83. Содержание Введение Коллеги и соавторы Индуктивное моделирование Статистический стеммер Subjectivity/Sentiment analysis Терминография Ресурсы

- 84. Ресурсы - Украина (1) Международный центр информационных технологий и систем, НАН и МОН Украины, отдел информационных

- 85. Ресурсы - Украина Поддержка сообщества ИМ Отдел проф. В.С. Степашко организует: 1) Ежегодные Летние Школы по

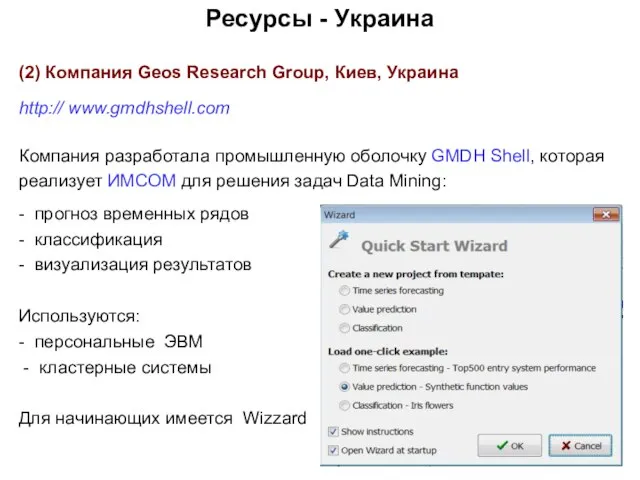

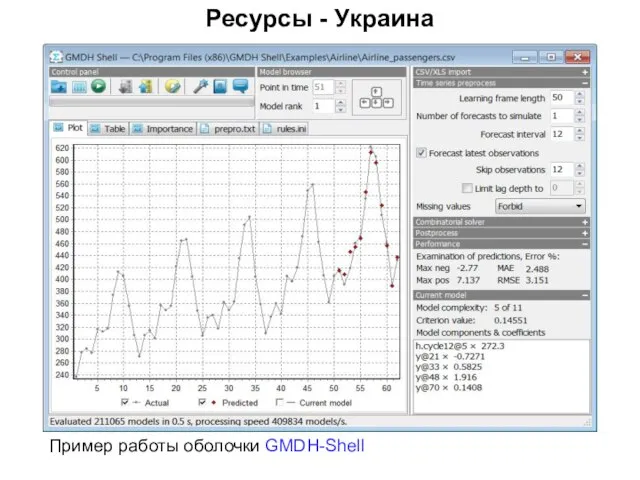

- 86. Ресурсы - Украина (2) Компания Geos Research Group, Киев, Украина http:// www.gmdhshell.com Компания разработала промышленную оболочку

- 87. Ресурсы - Украина Пример работы оболочки GMDH-Shell

- 88. Ресурсы - Москва (1) Вычислительный Центр РАН Московский физико-технический институт http:// www.machinelearning.ru Это Wiki подобный ресурс,

- 89. Ресурсы - Москва Часть главной страницы Wiki ресурса http:// www.machinelearning.ru

- 90. Ресурсы - Москва (2) Компания Forecsys, Москва, Россия http:// www.forecsys.ru/site/about/about/ Компания Forecsys — российский вендор BI-решений.

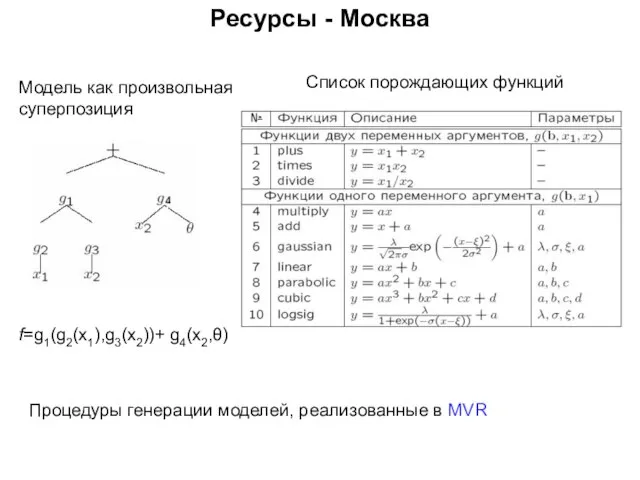

- 91. Ресурсы - Москва Процедуры генерации моделей, реализованные в MVR Модель как произвольная суперпозиция Список порождающих функций

- 93. Скачать презентацию

![Внешние критерии Давайте зафиксируем одно и тоже окно Δs = [s1,s2] внутри](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/476890/slide-74.jpg)

Подготовка к ЕГЭ

Подготовка к ЕГЭ Животноводство России

Животноводство России Путешествие по сказочным тропинкам

Путешествие по сказочным тропинкам Молоко. Молочные продукты

Молоко. Молочные продукты Психолог в отделе полиции

Психолог в отделе полиции 24 апреля 1915 года младотурецкие правители Талаат-паша, Энвер-паша и Джемаль-паша — приказали собрать всю армянскую интеллигенцию в

24 апреля 1915 года младотурецкие правители Талаат-паша, Энвер-паша и Джемаль-паша — приказали собрать всю армянскую интеллигенцию в Программа строительства и реконструкции котельных муниципальных образований Московской области - приоритетный инвестиционный п

Программа строительства и реконструкции котельных муниципальных образований Московской области - приоритетный инвестиционный п Глобальный экологический университет (по улучшению качества жизни)

Глобальный экологический университет (по улучшению качества жизни) Оформление чертежа

Оформление чертежа ЕДИНАЯ ИНТЕЛЛЕКТУАЛЬНАЯ СИСТЕМА УПРАВЛЕНИЯ И АВТОМАТИЗАЦИИ ПРОИЗВОДСТВЕННЫХ ПРОЦЕССОВ НА ЖЕЛЕЗНОДОРОЖНОМ ТРАНСПОРТЕ (ИСУЖТ)

ЕДИНАЯ ИНТЕЛЛЕКТУАЛЬНАЯ СИСТЕМА УПРАВЛЕНИЯ И АВТОМАТИЗАЦИИ ПРОИЗВОДСТВЕННЫХ ПРОЦЕССОВ НА ЖЕЛЕЗНОДОРОЖНОМ ТРАНСПОРТЕ (ИСУЖТ) Ландшафтный дизайн и озеленение участка

Ландшафтный дизайн и озеленение участка Кальянные миксы. Обеспечь себе истинное наслаждение

Кальянные миксы. Обеспечь себе истинное наслаждение Презентация на тему Логические операции

Презентация на тему Логические операции Хатеновская Елена Васильевна

Хатеновская Елена Васильевна SK700-II (Sandpiper II Electronics)

SK700-II (Sandpiper II Electronics) Духовная сфера общества. Религия

Духовная сфера общества. Религия Equalizer

Equalizer XIII Международная конференция "Маркетинг в России" Сообщение: «ОСОБЕННОСТИ ОНЛАЙН ИССЛЕДОВАНИЙ В РОССИИ» Александр Шашкин (Online Market

XIII Международная конференция "Маркетинг в России" Сообщение: «ОСОБЕННОСТИ ОНЛАЙН ИССЛЕДОВАНИЙ В РОССИИ» Александр Шашкин (Online Market  Здравствуй, милая картошка!

Здравствуй, милая картошка! ИСТОРИЯ РОССИИ

ИСТОРИЯ РОССИИ Полисахариды

Полисахариды Презентация на тему Труд земной. Ремесла на Руси

Презентация на тему Труд земной. Ремесла на Руси Saxotech 170

Saxotech 170 Внешняя политика СССР

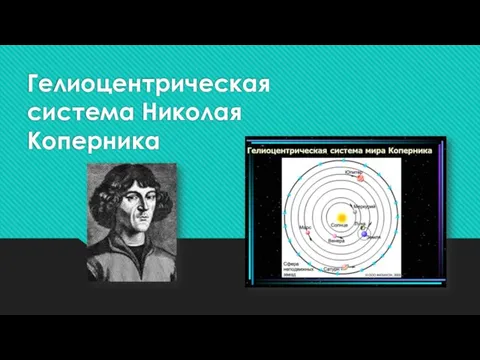

Внешняя политика СССР Гелиоцентрическая система Николая Коперника

Гелиоцентрическая система Николая Коперника Шираб-Жамсо Раднаев

Шираб-Жамсо Раднаев «Давньогрецька міфологія як основа формування філософії та розвитку Європейської цивілізації в цілому»

«Давньогрецька міфологія як основа формування філософії та розвитку Європейської цивілізації в цілому» Их лик сияет над Симбирском

Их лик сияет над Симбирском