Содержание

- 2. Введение Кластеризация документов – это процесс обнаружения естественных групп в коллекции документов. Кластеризацию может служить как

- 3. Содержание Оценка качества кластеризации Применение векторной модели в кластеризации Иерархическая кластеризация «Разделяющая» кластеризация Генеративные алгоритмы Спектральная

- 4. Оценка качества кластеризации Не существует единого (общепризнанного, применимого во всех случаях) метода оценки Оценка предполагает, что

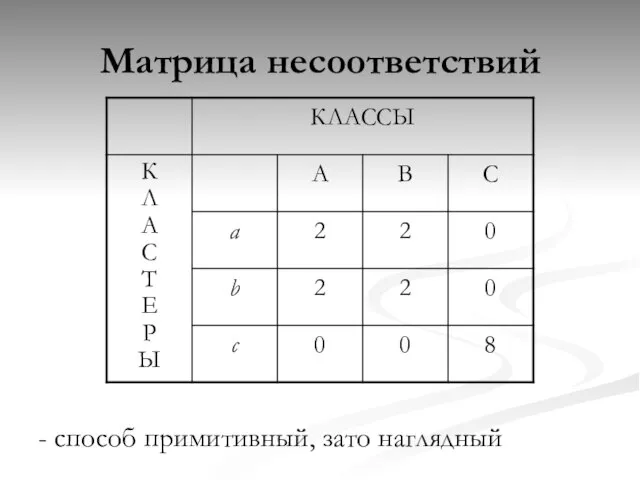

- 5. Матрица несоответствий - способ примитивный, зато наглядный

- 6. Метрики заимствованные из информационного поиска Полнота (recall): R = tp / (tp+fn) Точность (presicion): P =

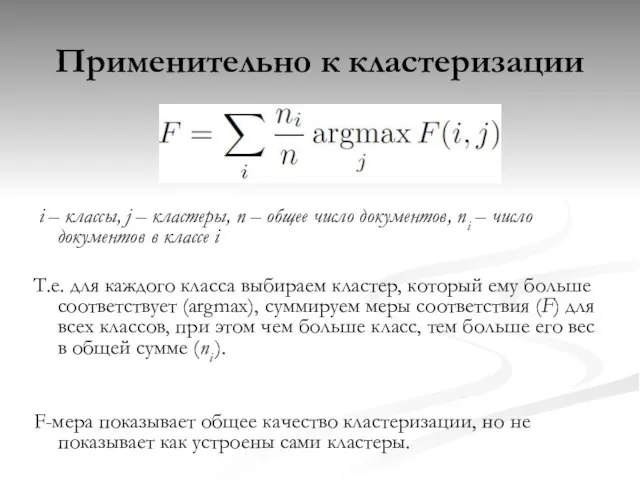

- 7. Применительно к кластеризации i – классы, j – кластеры, n – общее число документов, ni –

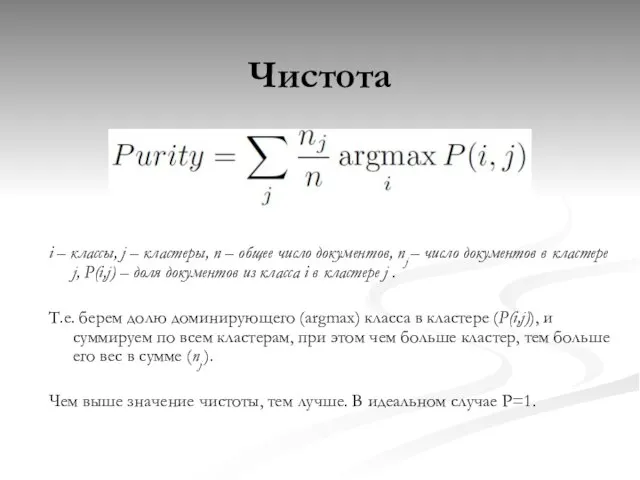

- 8. Чистота i – классы, j – кластеры, n – общее число документов, nj – число документов

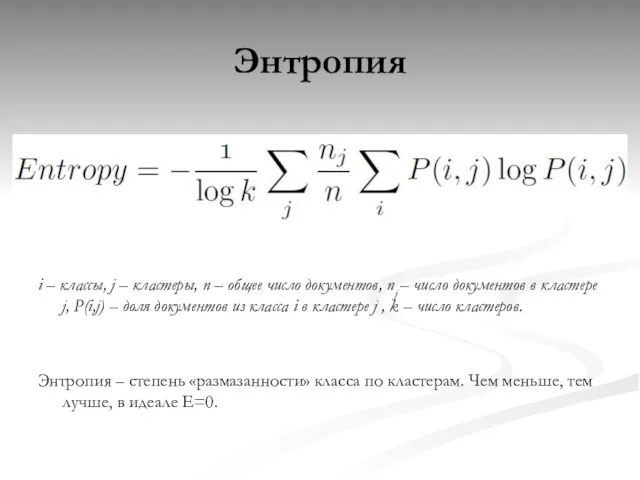

- 9. Энтропия i – классы, j – кластеры, n – общее число документов, nj – число документов

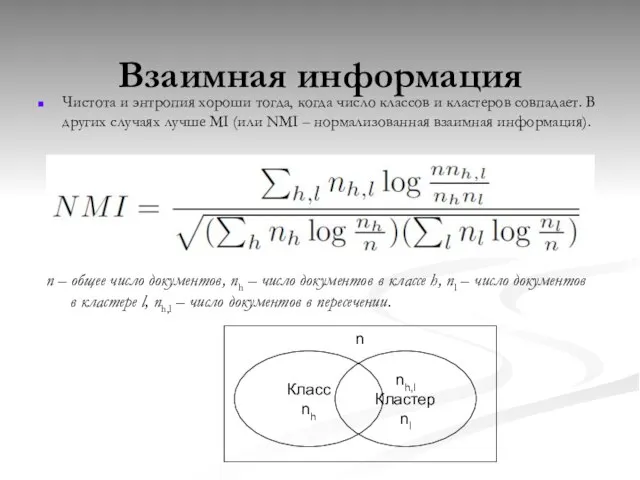

- 10. Взаимная информация Чистота и энтропия хороши тогда, когда число классов и кластеров совпадает. В других случаях

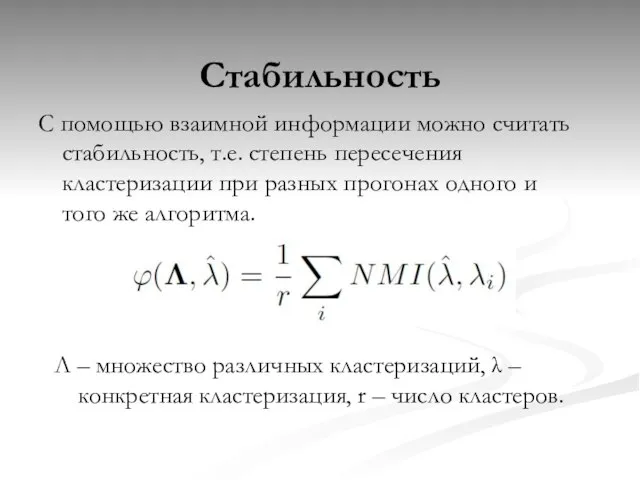

- 11. Стабильность С помощью взаимной информации можно считать стабильность, т.е. степень пересечения кластеризации при разных прогонах одного

- 12. Содержание Оценка качества кластеризации Применение векторной модели в кластеризации Иерархическая кластеризация «Разделяющая» кластеризация Генеративные алгоритмы Спектральная

- 13. Векторная модель Коллекция из n документов и m различных терминов представляется в виде матрицы mxn, где

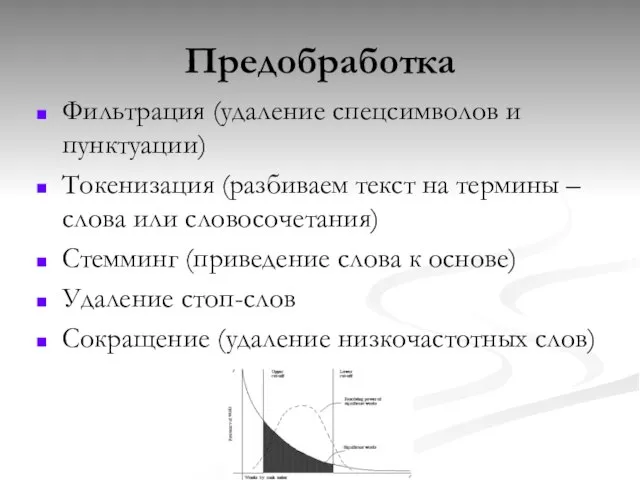

- 14. Предобработка Фильтрация (удаление спецсимволов и пунктуации) Токенизация (разбиваем текст на термины – слова или словосочетания) Стемминг

- 15. Содержание Оценка качества кластеризации Применение векторной модели в кластеризации Иерархическая кластеризация «Разделяющая» кластеризация Генеративные алгоритмы Спектральная

- 16. Иерархическая кластеризация На начальной стадии каждый документ – сам себе кластер. На каждом шаге документы объединяются

- 17. Содержание Оценка качества кластеризации Применение векторной модели в кластеризации Иерархическая кластеризация «Разделяющая» кластеризация Генеративные алгоритмы Спектральная

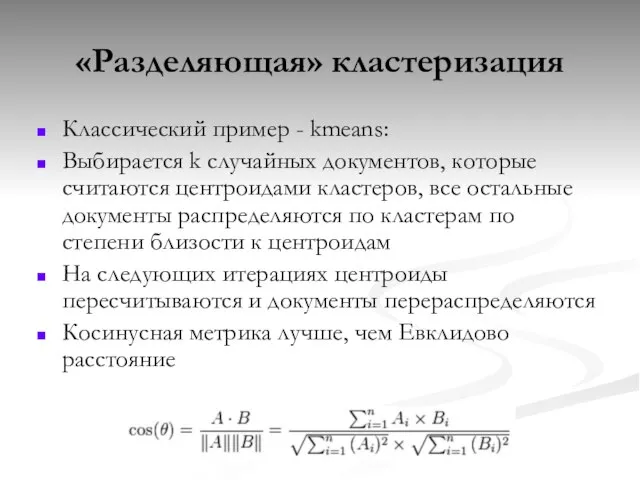

- 18. «Разделяющая» кластеризация Классический пример - kmeans: Выбирается k случайных документов, которые считаются центроидами кластеров, все остальные

- 19. Недостатки kmeans Результаты могут быть различными в зависимости от инициализации. Может останавливаться на субоптимальном локальном минимуме

- 20. Содержание Оценка качества кластеризации Применение векторной модели в кластеризации Иерархическая кластеризация «Разделяющая» кластеризация Генеративные алгоритмы Спектральная

- 21. Генеративные алгоритмы Дискриминативные алгоритмы, которые основаны на попарной близости документов, имеют сложность O(n2) по определению. Генеративные

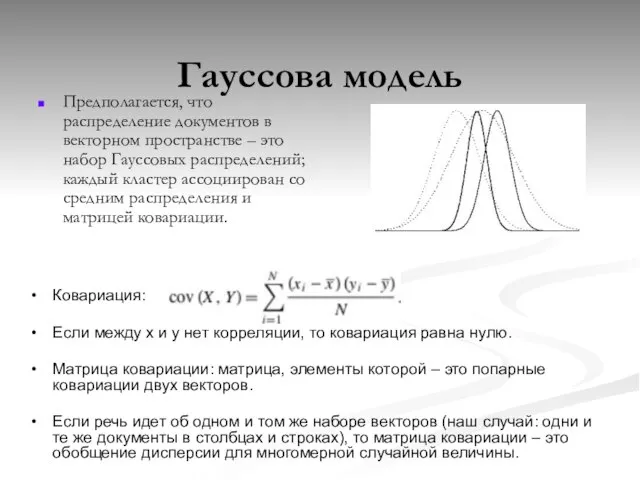

- 22. Гауссова модель Предполагается, что распределение документов в векторном пространстве – это набор Гауссовых распределений; каждый кластер

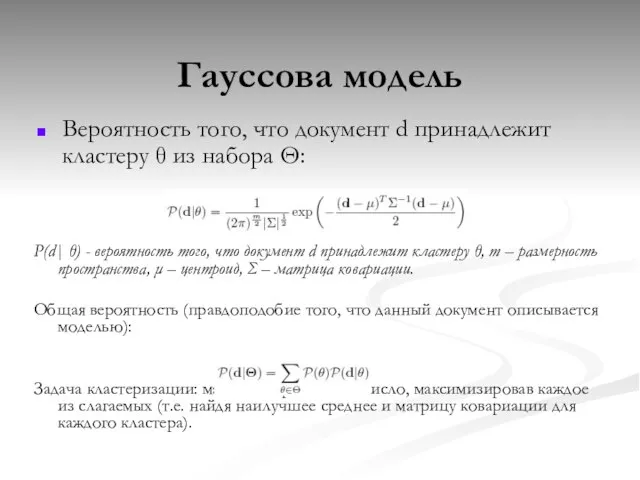

- 23. Гауссова модель Вероятность того, что документ d принадлежит кластеру θ из набора Θ: P(d| θ) -

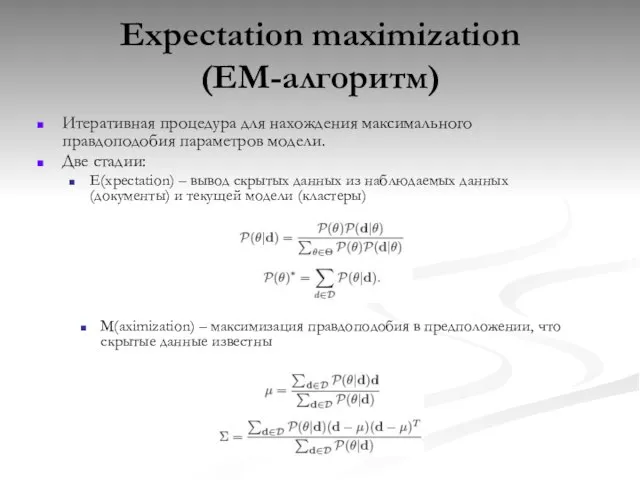

- 24. Expectation maximization (EM-алгоритм) Итеративная процедура для нахождения максимального правдоподобия параметров модели. Две стадии: E(xpectation) – вывод

- 25. EM-алгоритм Большое число свободных параметров может приводить к переобучению. Сокращение размерности: выбор дискриминирующих свойств для каждого

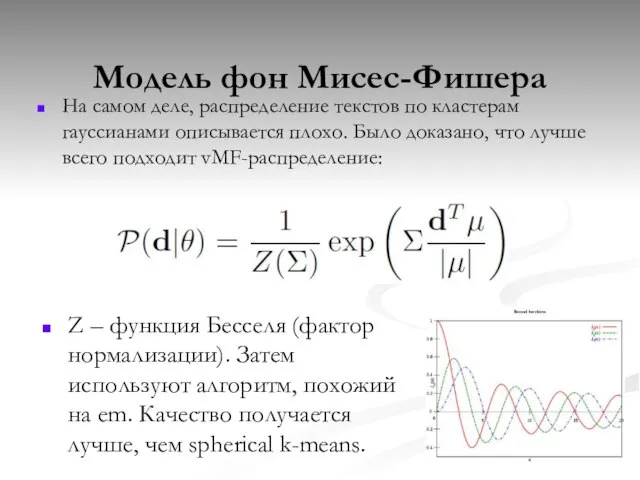

- 26. Модель фон Мисес-Фишера На самом деле, распределение текстов по кластерам гауссианами описывается плохо. Было доказано, что

- 27. Содержание Оценка качества кластеризации Применение векторной модели в кластеризации Иерархическая кластеризация «Разделяющая» кластеризация Генеративные алгоритмы Спектральная

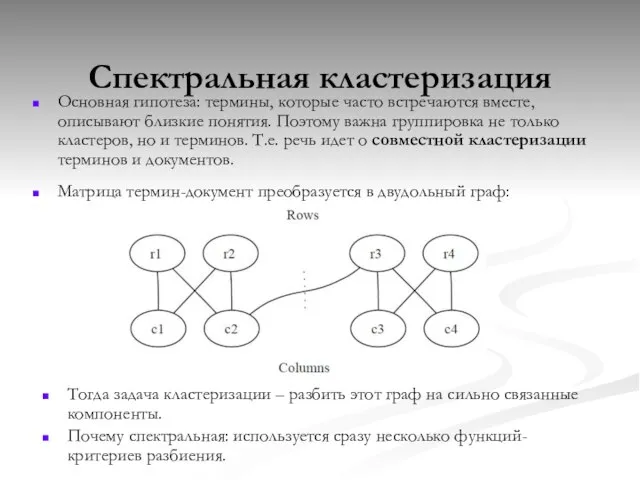

- 28. Спектральная кластеризация Основная гипотеза: термины, которые часто встречаются вместе, описывают близкие понятия. Поэтому важна группировка не

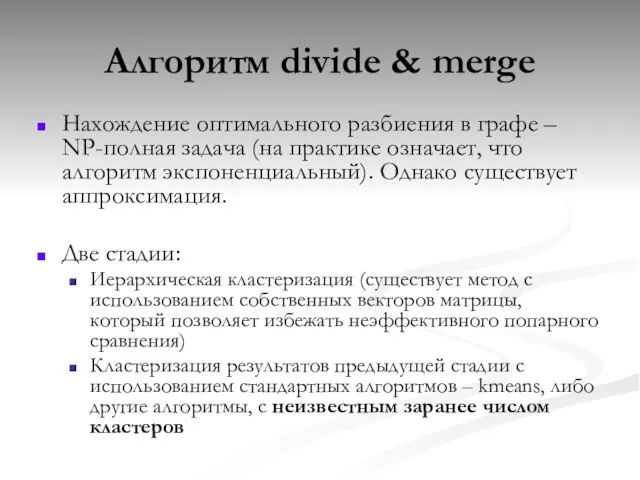

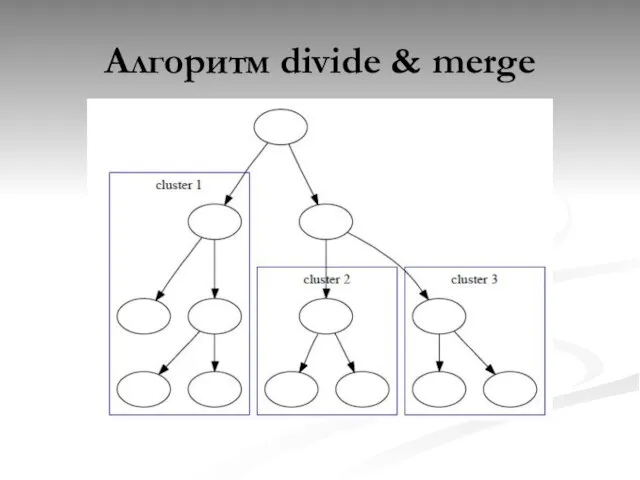

- 29. Алгоритм divide & merge Нахождение оптимального разбиения в графе – NP-полная задача (на практике означает, что

- 30. Алгоритм divide & merge

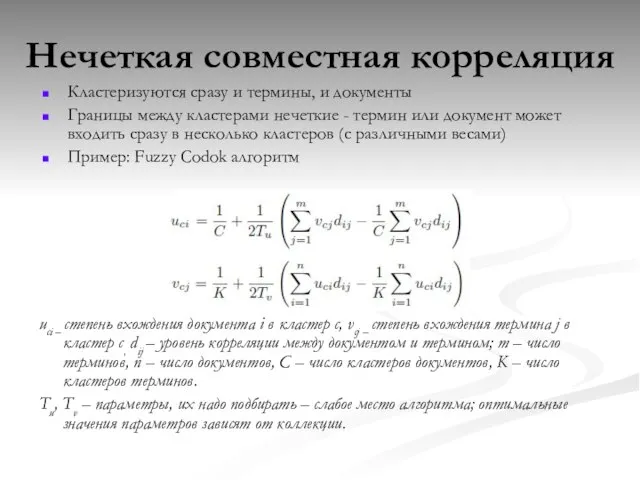

- 31. Нечеткая совместная корреляция Кластеризуются сразу и термины, и документы Границы между кластерами нечеткие - термин или

- 32. Содержание Оценка качества кластеризации Применение векторной модели в кластеризации Иерархическая кластеризация «Разделяющая» кластеризация Генеративные алгоритмы Спектральная

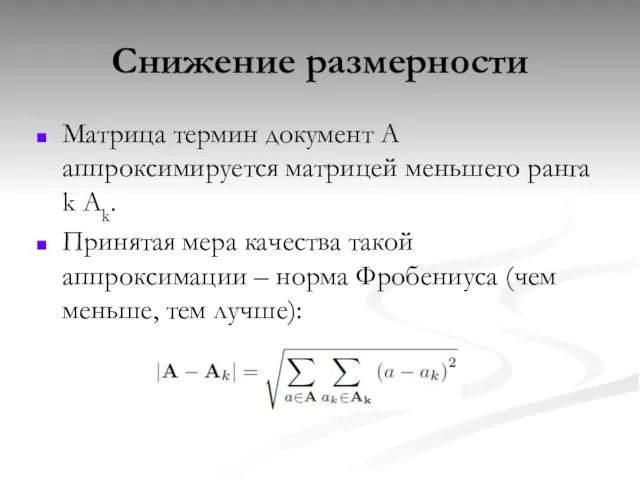

- 33. Снижение размерности Матрица термин документ А аппроксимируется матрицей меньшего ранга k Ak. Принятая мера качества такой

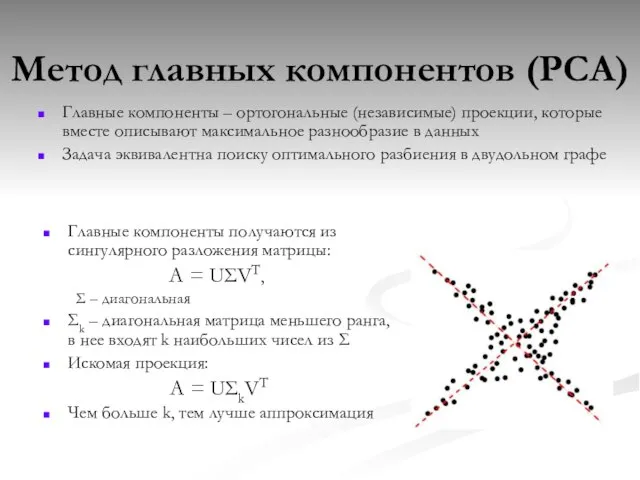

- 34. Метод главных компонентов (PCA) Главные компоненты – ортогональные (независимые) проекции, которые вместе описывают максимальное разнообразие в

- 35. Метод главных компонентов + В результате получается оптимальная аппроксимация + Различие в расстояниях внутри кластеров и

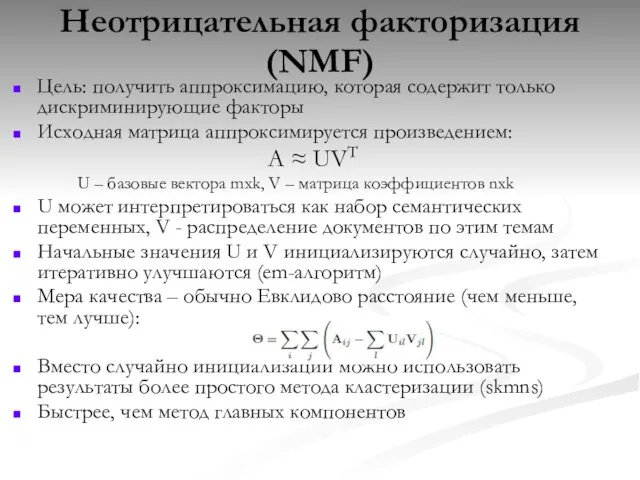

- 36. Неотрицательная факторизация (NMF) Цель: получить аппроксимацию, которая содержит только дискриминирующие факторы Исходная матрица аппроксимируется произведением: A

- 37. Мягкая спектральная кластеризация Из редуцированного пространства трудно породить нечеткую кластеризацию, потому что усечение матрицы приводит к

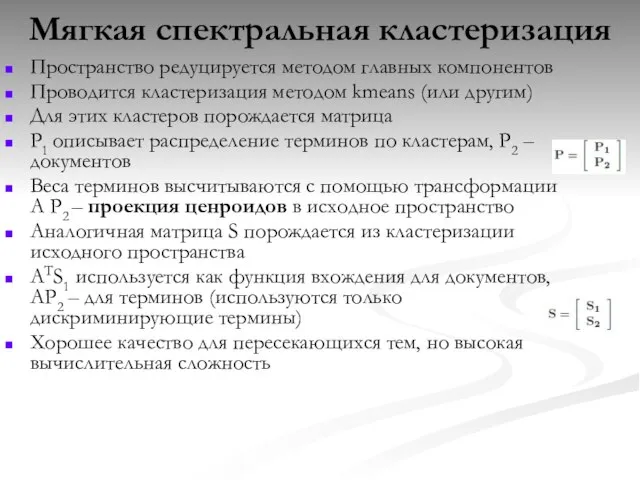

- 38. Мягкая спектральная кластеризация Пространство редуцируется методом главных компонентов Проводится кластеризация методом kmeans (или другим) Для этих

- 39. Lingo “description comes first” Сокращается размерность пространства Базисные вектора полученной редуцированной матрицы воспринимаются как метки кластеров

- 40. Содержание Оценка качества кластеризации Применение векторной модели в кластеризации Иерархическая кластеризация «Разделяющая» кластеризация Генеративные алгоритмы Спектральная

- 41. Модели с учетом порядка слов Маша любит Васю, Вася любит Машу – векторная модель не учитывает

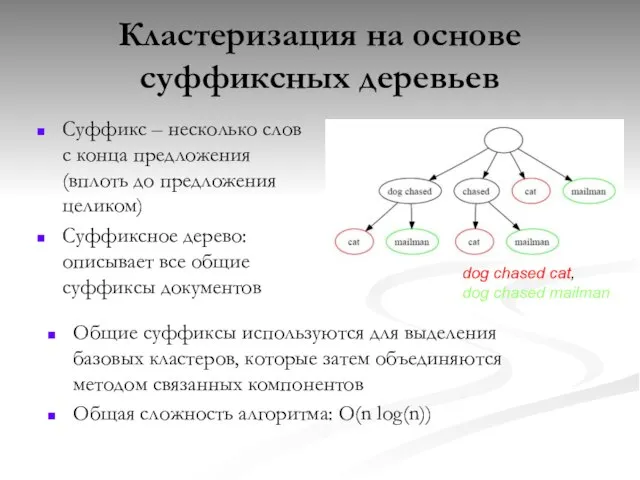

- 42. Кластеризация на основе суффиксных деревьев Суффикс – несколько слов с конца предложения (вплоть до предложения целиком)

- 43. Кластеризация на основе суффиксных деревьев Кластеры включают не все документы (документ может иметь суффикс, которые не

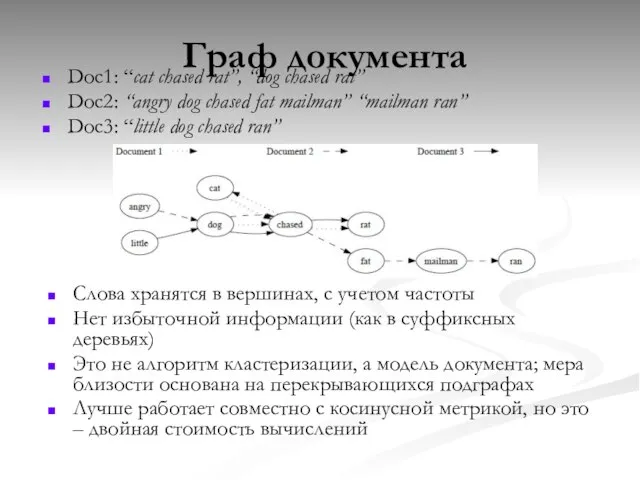

- 44. Граф документа Doc1: “cat chased rat”, “dog chased rat” Doc2: “angry dog chased fat mailman” “mailman

- 45. Заключение Качество кластеризации определяется по стандартным мерам, при этом итоговая кластеризация не всегда выглядит «естественно» Проблема

- 47. Скачать презентацию

Отчет о прохождении производственной практикив УВД г. Краснодара

Отчет о прохождении производственной практикив УВД г. Краснодара Виды наказаний

Виды наказаний Викторина по биологии «Птицы»

Викторина по биологии «Птицы» Подарки молодоженам от компании «Табакоff»

Подарки молодоженам от компании «Табакоff» Презентация на тему Влияние солнца на землю

Презентация на тему Влияние солнца на землю Лучше гор могут быть только горы…

Лучше гор могут быть только горы… Кресло: Бюрократ T-898

Кресло: Бюрократ T-898 Государственное бюджетное образовательное учреждение города Москвы Гимназия №1540

Государственное бюджетное образовательное учреждение города Москвы Гимназия №1540 Этноархеология

Этноархеология Эксперт. Общие подходы к формированию критериев оценивания

Эксперт. Общие подходы к формированию критериев оценивания Что такое DLP сегодня?

Что такое DLP сегодня? Многообразие танцевальной музыки

Многообразие танцевальной музыки Разграничение понятий акцентуация характера и психопатия

Разграничение понятий акцентуация характера и психопатия Человек в религиозных традициях мира

Человек в религиозных традициях мира Влажность воздуха

Влажность воздуха Совершенствование системы турбонаддува автомобильного дизеля 4ДТНА1

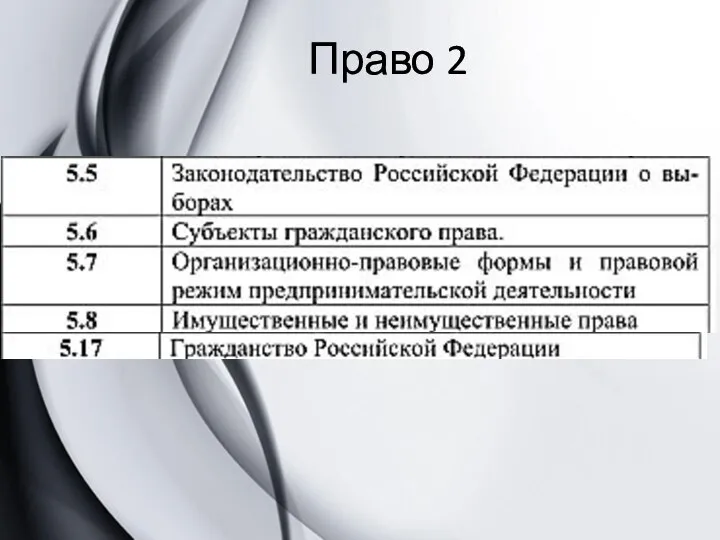

Совершенствование системы турбонаддува автомобильного дизеля 4ДТНА1 Избирательное право. Гражданское право

Избирательное право. Гражданское право Потребительское кредитование

Потребительское кредитование спасем окружающую среду

спасем окружающую среду Оборона, граница, разведка

Оборона, граница, разведка Учись играя и играй учась!

Учись играя и играй учась! Виктор Михайлович Васнецов

Виктор Михайлович Васнецов Презентация на тему Россия в начале ХХ века

Презентация на тему Россия в начале ХХ века Интеллектуальная игра « Эрудит »

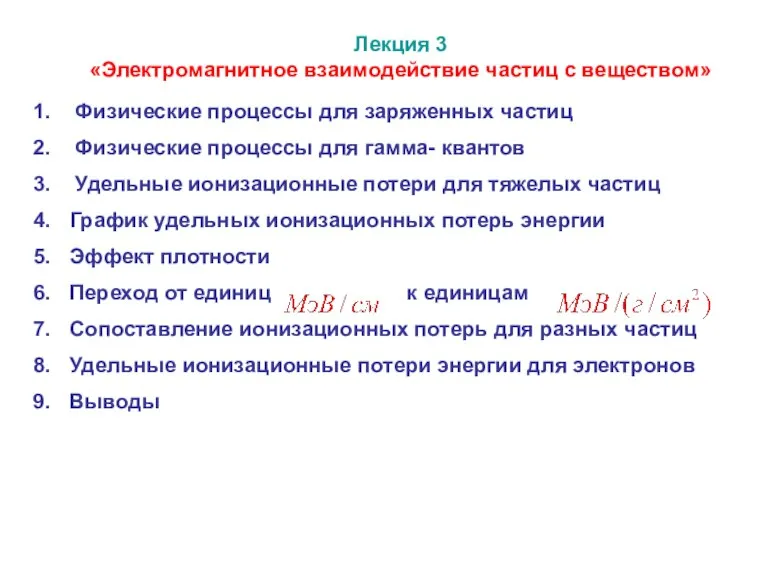

Интеллектуальная игра « Эрудит » Электромагнитное взаимодействие частиц с веществом

Электромагнитное взаимодействие частиц с веществом Этикет

Этикет Управление конфликтами

Управление конфликтами Международное гуманитарное право

Международное гуманитарное право