Содержание

- 2. МОДУЛЬНЫЙ ПОДХОД К ПОЗНАНИЮ (с) Леда Космидес, Джон Туби

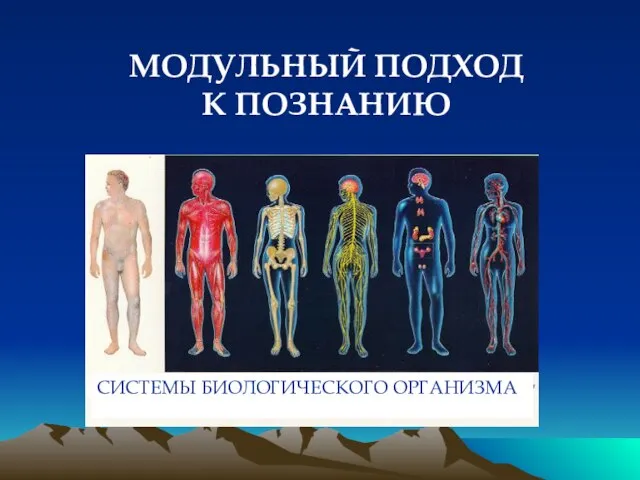

- 3. МОДУЛЬНЫЙ ПОДХОД К ПОЗНАНИЮ

- 4. ОСНОВЫ МОДУЛЬНОГО ПОДХОДА К ПОЗНАНИЮ Ноэм Хомский (1988): врожденность языковой способности и ее независимость от других

- 5. Языковая способность как отдельный модуль Ген FOXP2 хромосомы 7 Разница в усвоении L1 и L2 Трудности

- 6. ОСНОВЫ МОДУЛЬНОГО ПОДХОДА К ПОЗНАНИЮ Идея модульности познания -- Дэвид Марр (1945-1980): «Любой большой массив вычислений

- 7. РОЖДЕНИЕ МОДУЛЬНОГО ПОДХОДА К ПОЗНАНИЮ Джерри Фодор (1983): общая концепция «модульности»: познание как мозаика специализированных модулей

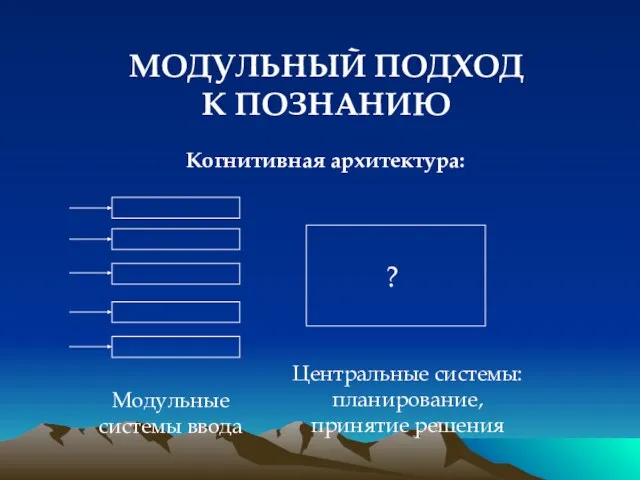

- 8. МОДУЛЬНЫЙ ПОДХОД К ПОЗНАНИЮ Когнитивная архитектура: Модульные системы ввода Центральные системы: планирование, принятие решения

- 9. КРИТЕРИИ ВЫДЕЛЕНИЯ МОДУЛЕЙ Особая сфера влияния, или специализация (domain specificity): каждый модуль компетентен в обработке одного

- 10. Насколько речь модульна? Недавнее появление в филогенезе Пластичность поведенческих проявлений Пластичность нервных механизмов Произвольность связей между

- 11. ГИПОТЕЗА ВСЕОБЩЕЙ МОДУЛЬНОСТИ Дэн Спербер: познание полностью модульно -- так же, как биологический организм. Неспециализированных систем

- 12. КРИТИКА МОДУЛЬНОГО ПОДХОДА 1. Теоретическая: проблема обучения и пластичности познания; влияние культуры на «модульные» процессы (см.

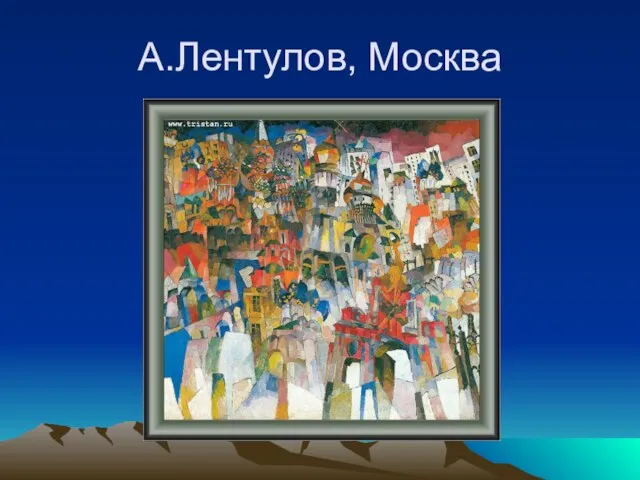

- 13. А.Лентулов, Москва

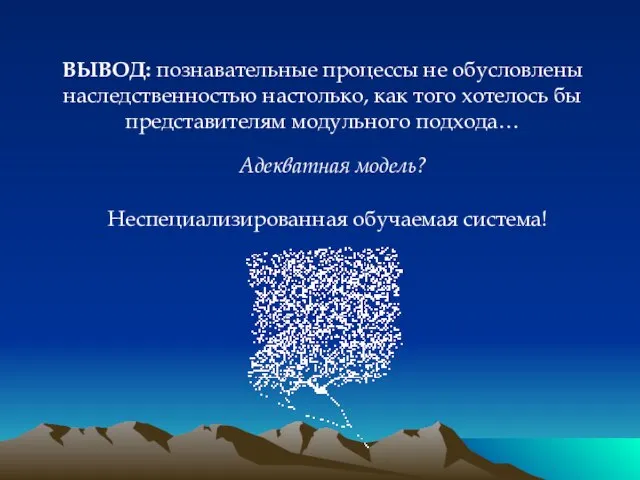

- 14. ВЫВОД: познавательные процессы не обусловлены наследственностью настолько, как того хотелось бы представителям модульного подхода… Неспециализированная обучаемая

- 15. Представление и приобретение знаний: есть ли альтернатива компьютерной метафоре?

- 16. Нейронные сети: Мозг как компьютер vs. Компьютер как мозг

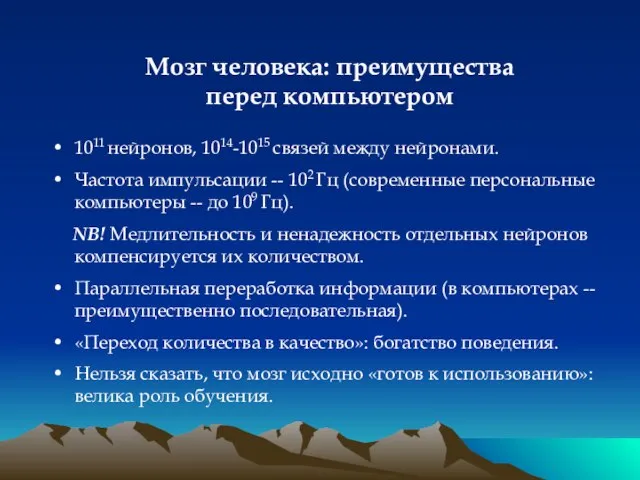

- 17. Мозг человека: преимущества перед компьютером 1011 нейронов, 1014-1015 связей между нейронами. Частота импульсации -- 102 Гц

- 18. Нейросетевой подход: основные положения Процессы познания -- результат взаимодействия большого числа простых перерабатывающих элементов, связанных друг

- 19. Классы задач, решаемых современными нейросетями: Классификация: распознавание образов, распознавание голосов, верификация подписей, постановка диагноза, анализ экспериментальных

- 20. Нейронные сети: рождение идеи (1943) Уоррен Маккаллох (1898-1969) Уолтер Питтс (1923-1969) «Логическое исчисление присуще нейронной активности»

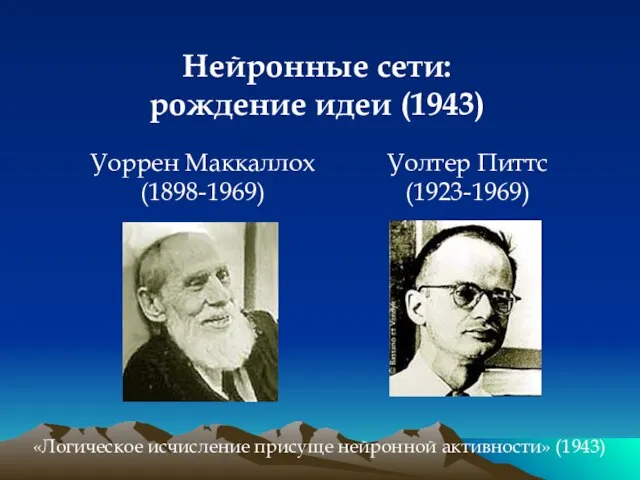

- 21. Нейронные сети РЕАЛЬНЫЙ НЕЙРОН

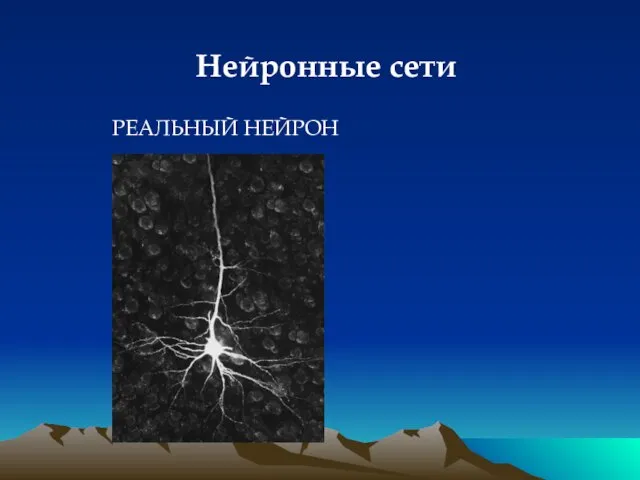

- 22. Мозг человека содержит 1011 нейронов. Состав нейрона: аксон, 10 000 дендритов, синапсы Состояние нейрона: возбуждение и

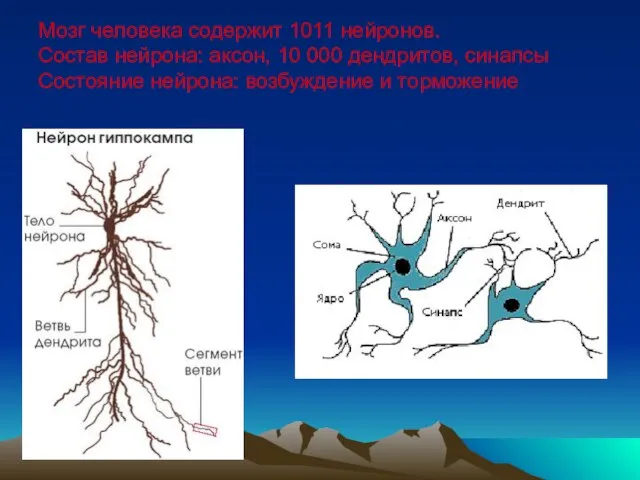

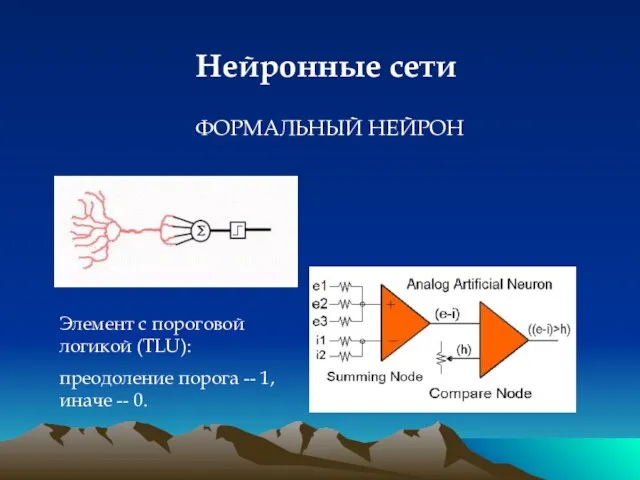

- 23. Нейронные сети ФОРМАЛЬНЫЙ НЕЙРОН Элемент с пороговой логикой (TLU): преодоление порога -- 1, иначе -- 0.

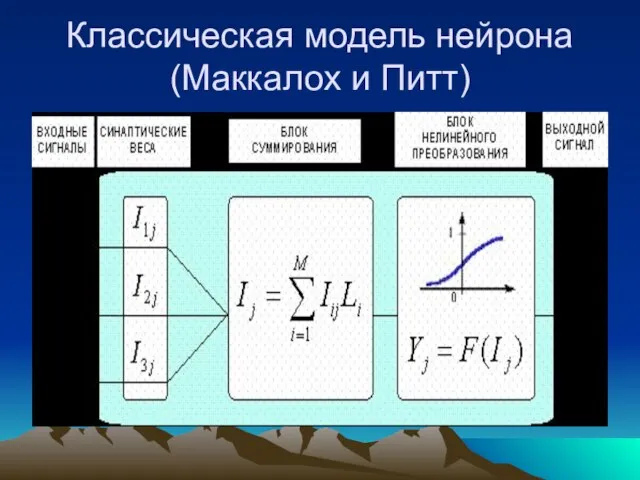

- 24. Формальный нейрон Входные сигналы формируются в рецепторах (не входят нейрон). Далее эти сигналы умножаются на веса

- 25. Нейрон как компьютер Сигнал сумматора: n – количество синапсов i – индекс сигнала xi – входной

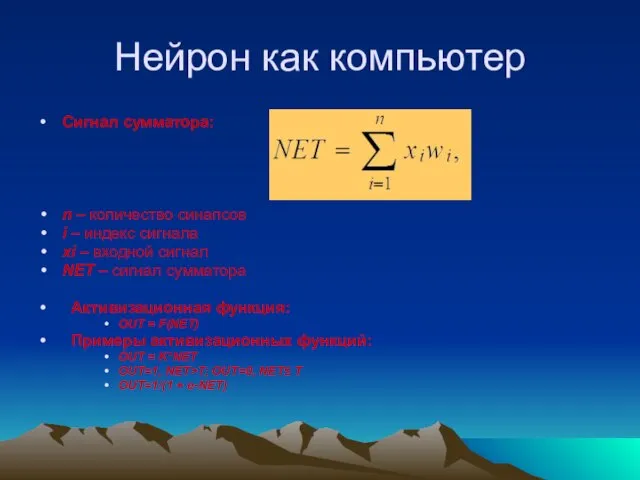

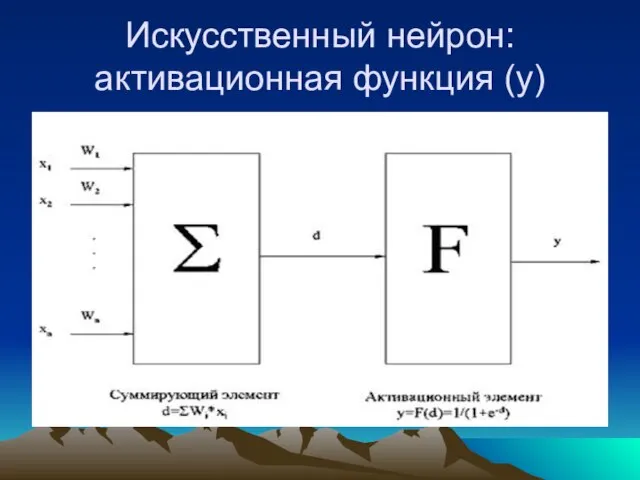

- 26. Искусственный нейрон: активационная функция (y)

- 27. Классическая модель нейрона (Маккалох и Питт)

- 28. Нейронная сеть Нейронная сеть – ориентированный ациклический граф, вершины которого нейроны разбиты на слои. Ребра –

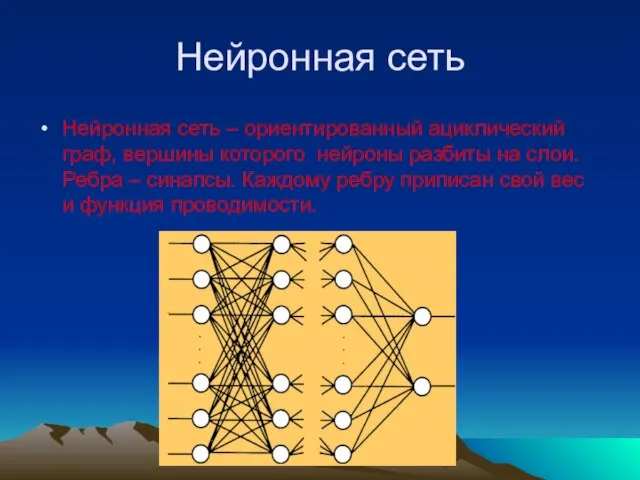

- 29. Три типа нейронов: входные (рецепторы) -- активируются извне; внутренние (центральные) -- активируются входными и прочими нейронами

- 30. Теоретическая концепция искусственной сети Маккаллоха и Питтса Правила функционирования сети: задержки в распространении активации одинаковы для

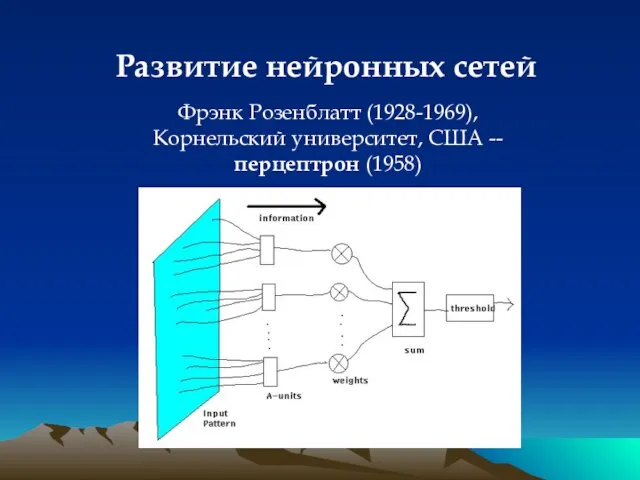

- 31. Развитие нейронных сетей Фрэнк Розенблатт (1928-1969), Корнельский университет, США -- перцептрон (1958)

- 32. Развитие нейронных сетей Фрэнк Розенблатт (1928-1969), Корнельский университет, США 1962 -- «Принципы нейродинамики: перцептроны и теория

- 33. Перцептрон Розенблатта

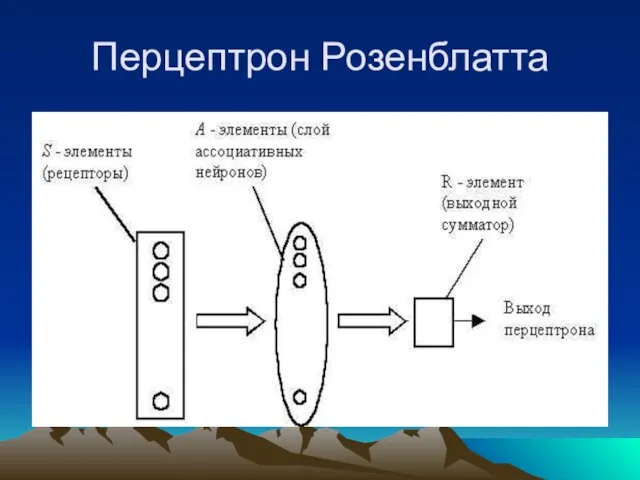

- 34. Перцептрон Розенблатта Однослойный персептрон характеризуется матрицей синаптических связей ||W|| от S- к A-элементам. Элемент матрицы отвечает

- 35. Обучение нейронной сети Нейронная сеть обучается, чтобы для некоторого множества входных сигналов давать желаемое множество выходных

- 36. Обучение перцептрона Обучение классической нейронной сети состоит в подстройке весовых коэффициентов каждого нейрона. Пусть имеется набор

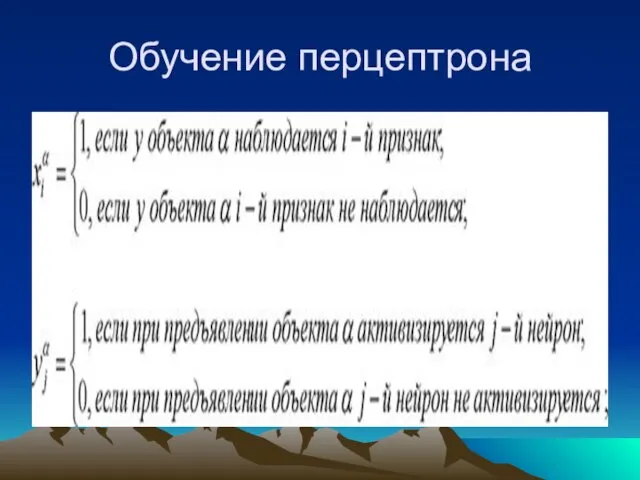

- 37. Обучение перцептрона

- 38. Обучение перцептрона Будем называть нейронную сеть обученной на данной обучающей выборке, если при подаче на вход

- 39. Обучение перцепторна Система связей между рецепторами S и A - элементами, так же как и пороги

- 40. Обучение перцептрона Предъявляем обучающую выборку: объекты (например, круги либо квадраты) с указанием класса, к которым они

- 41. ОБУЧЕНИЕ НЕЙРОННОЙ СЕТИ Дональд Олдинг Хебб (1904-1985) Итог -- образование «нейронного ансамбля», который все быстрее активируется

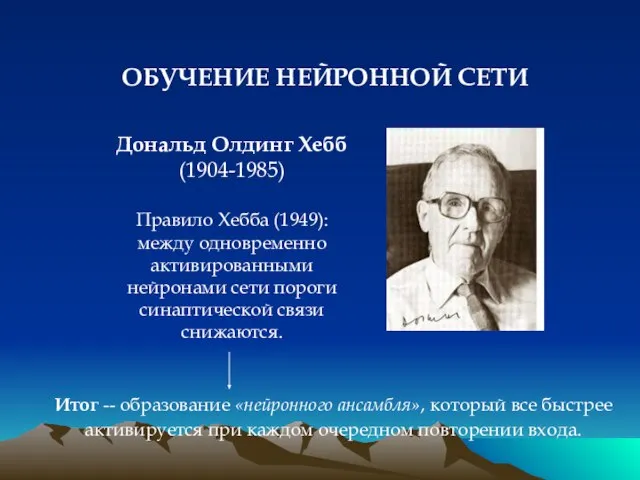

- 42. УПАДОК КОННЕКЦИОНИЗМА 1969 -- Марвин Минский, Сеймур Пейперт «Перцептроны»: приговор нейронным сетям?

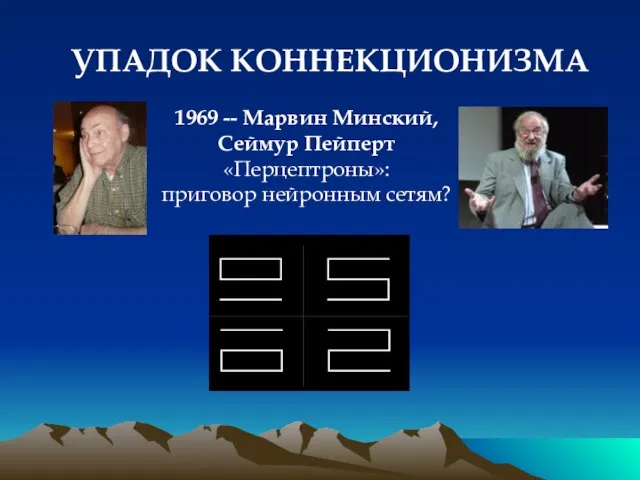

- 43. РЕНЕССАНС КОННЕКЦИОНИЗМА 1986 -- Дэвид Румельхарт (Стэнфорд), Джеймс Макклелланд (Карнеги-Меллон) «Параллельно-распределенная переработка» (PDP)

- 44. АРХИТЕКТУРА НЕЙРОННОЙ СЕТИ

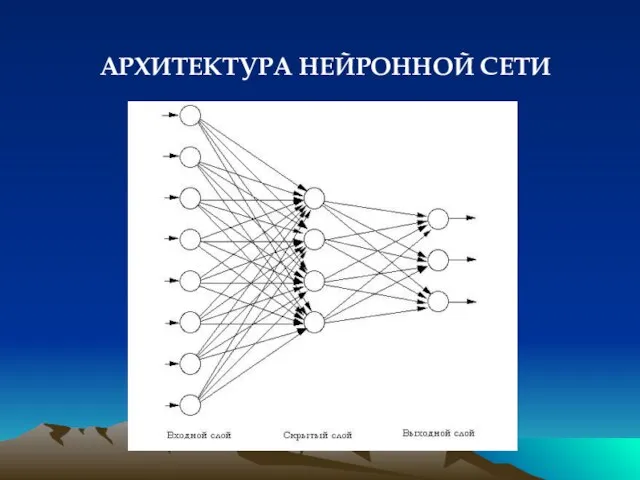

- 45. Основные понятия: «Нейрон» (unit, node) -- элемент сети, который суммирует входные сигналы и, в случае превышения

- 46. ОБУЧЕНИЕ НЕЙРОННОЙ СЕТИ: «Обучение с наставником»: задачи распознавания (заранее известен правильный ответ -> сеть настраивается на

- 47. Алгоритм обучения (метод градиентного спуска aka обратное распространение ошибки) Выбрать очередную пару векторов Xk и Yk

- 48. Обучение нейрона Угол между векторами: скалярное произведение / произведение длин Минимизация средней квадратичной ошибки при помощи

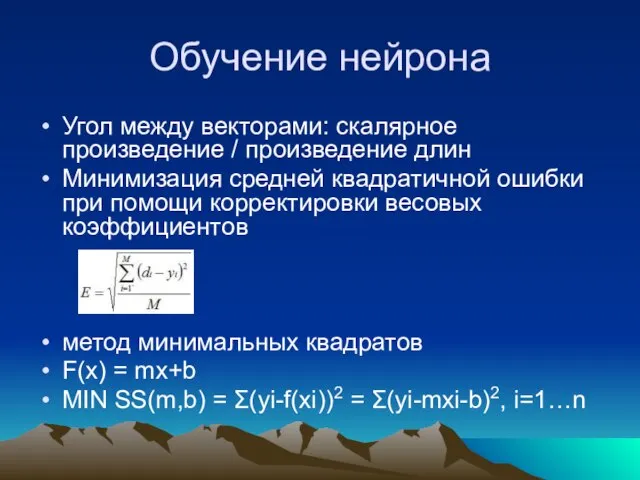

- 49. Организация памяти (Макклелланд, 1981):

- 50. Работа сети Nodes organized in pools Inhibitory weights within pool Excitatory weights between pools Individual units

- 51. Преимущество нейронной сети Retrieve info from partial description •Correct info from incorrect input •Retrieve info not

- 52. Коннекционизм Формирование у нейронной сети «социальных стереотипов»

- 53. ПРЕИМУЩЕСТВА СЕТЕВОЙ АРХИТЕКТУРЫ Возможность обучения Распределенное хранение информации ПРОБЛЕМЫ НЕЙРОСЕТЕВОГО ПОДХОДА Границы пластичности субстрата и «содержательная»

- 54. Нейронные сети Символьные модели неявные правила, «интуитивные» задачи (индивидуальные знания): умозаключение по аналогии, выделение фигуры на

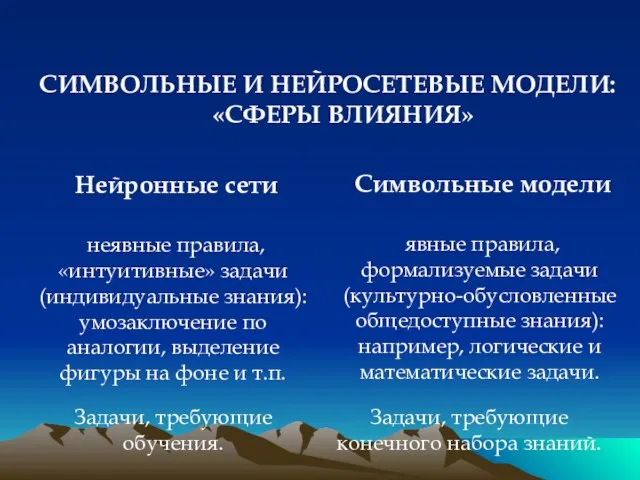

- 55. Нейронные сети Символьные модели СИМВОЛЬНЫЕ И НЕЙРОСЕТЕВЫЕ МОДЕЛИ: «СФЕРЫ ВЛИЯНИЯ»

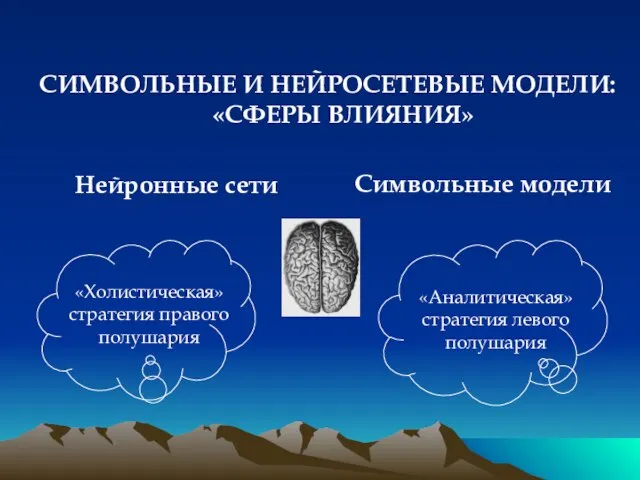

- 56. Нейронная сеть распознавание образов, быстрые ответы на запросы сложной окружающей среды ВОЗМОЖНОСТИ ИНТЕГРАЦИИ НЕЙРОСЕТЕВОГО И СИМВОЛЬНОГО

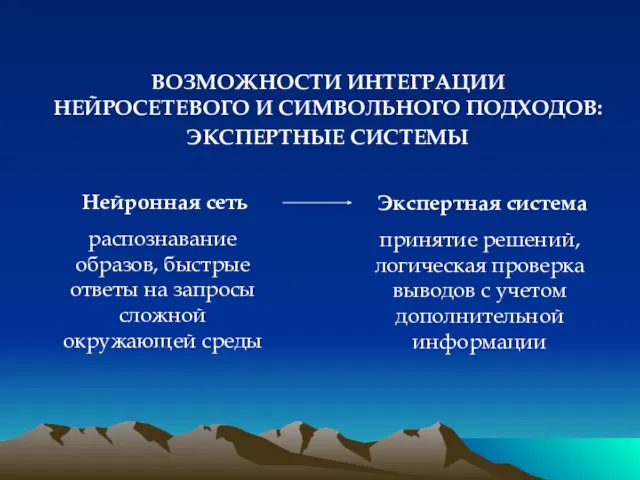

- 58. Скачать презентацию

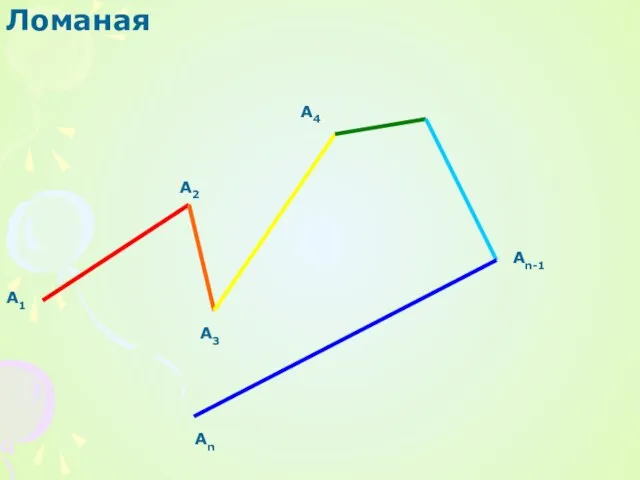

Презентация на тему Ломаная

Презентация на тему Ломаная Проблемы сотрудничества и “Вместе руководим”

Проблемы сотрудничества и “Вместе руководим” Презентация на тему Занимательная геометрия (3 класс)

Презентация на тему Занимательная геометрия (3 класс)  Параллелометрия

Параллелометрия  Природа Кавказа в произведениях М.Ю. Лермонтова

Природа Кавказа в произведениях М.Ю. Лермонтова  Управление Росреестра по Вологодской области

Управление Росреестра по Вологодской области Презентация на тему Многообразие живых организмов

Презентация на тему Многообразие живых организмов  Моделирование. Классификация моделей

Моделирование. Классификация моделей Автонашел. Помощь в поиске лучшего автомобиля с пробегом

Автонашел. Помощь в поиске лучшего автомобиля с пробегом Гейзеры

Гейзеры Обучающая анимация по физике

Обучающая анимация по физике Основные этапы эволюции управления персоналом

Основные этапы эволюции управления персоналом Презентация на тему Сюжетно-ролевая игра как средство всестороннего развития ребенка

Презентация на тему Сюжетно-ролевая игра как средство всестороннего развития ребенка «ЭНЕРГЕТИКА ДОМА».

«ЭНЕРГЕТИКА ДОМА». Государство как экономический агент

Государство как экономический агент Методическое обеспечение работы с кадрами

Методическое обеспечение работы с кадрами Вспоминая лето. Цветы. Программа по изобразительному искусству под редакцией Б.М. Неменского для 1 класса

Вспоминая лето. Цветы. Программа по изобразительному искусству под редакцией Б.М. Неменского для 1 класса Особенности обучения леворуких детей

Особенности обучения леворуких детей Основной. Deutsch

Основной. Deutsch Игровые технологии

Игровые технологии Требования, предъявляемые к составлению и оформлению должностного регламента государственного служащего

Требования, предъявляемые к составлению и оформлению должностного регламента государственного служащего История парламентаризма в России

История парламентаризма в России Древнейшие стоянки на Нижнем Дону

Древнейшие стоянки на Нижнем Дону Монгол хэл

Монгол хэл Презентация на тему Отряд Непарнокопытные

Презентация на тему Отряд Непарнокопытные  Управленческое решение

Управленческое решение Презентация на тему ГИДРОДИНАМИЧЕСКИЕ АВАРИИ

Презентация на тему ГИДРОДИНАМИЧЕСКИЕ АВАРИИ  Презентация на тему Откуда произошла пасха

Презентация на тему Откуда произошла пасха