Содержание

- 2. Информация. Информация- сведения, разъяснения, изложения.

- 3. Информация- Общенаучное понятие. Используется в различных науках: информатике, физике, кибернетике, биологии, и т.д.

- 4. В физике: Энтропия – хаос, отсутствие информации Антиэнтропия – мера упорядоченности и сложности системы. Увеличивается сложность

- 5. В биологии: Понятие связывается с поведением живых организмов, которое строится на основе получения использования организмом информации

- 6. В кибернетике: Понятие связано с процессами управления в сложных системах (живых организмах или технических устройствах). Процессы

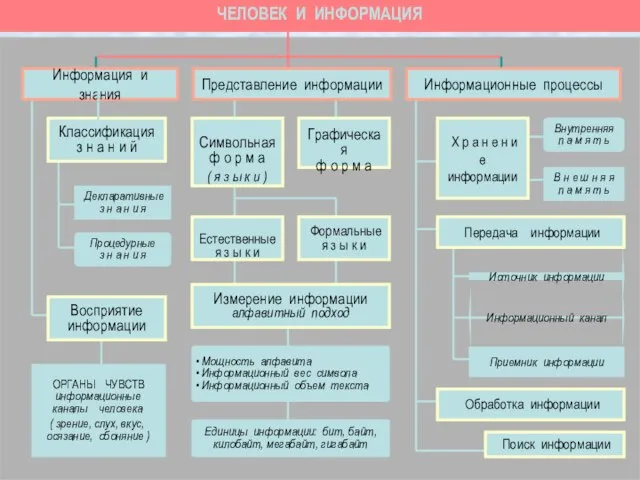

- 7. ЧЕЛОВЕК И ИНФОРМАЦИЯ ОРГАНЫ ЧУВСТВ информационные каналы человека ( зрение, слух, вкус, осязание, обоняние ) Восприятие

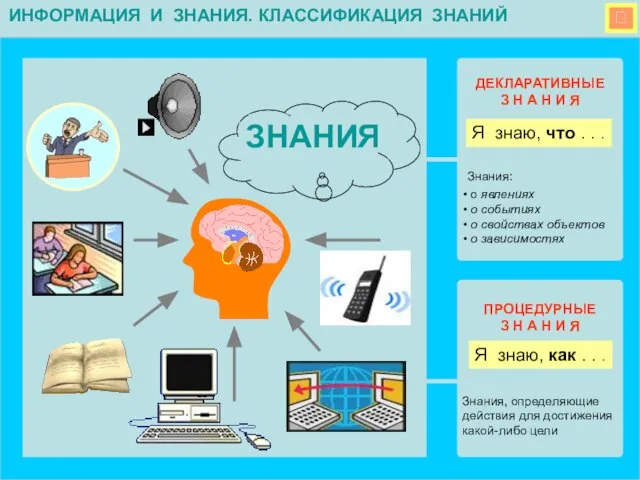

- 8. ДЕКЛАРАТИВНЫЕ З Н А Н И Я ПРОЦЕДУРНЫЕ З Н А Н И Я Знания: о

- 9. ВОСПРИЯТИЕ ИНФОРМАЦИИ Человек воспринимает информацию из внешнего мира с помощью всех своих органов чувств, которые

- 10. ФОРМЫ ПРЕДСТАВЛЕНИЯ ИНФОРМАЦИИ Формальные ЯЗЫКИ ЯЗЫК – это знаковый способ представления информации Естественные ЯЗЫКИ

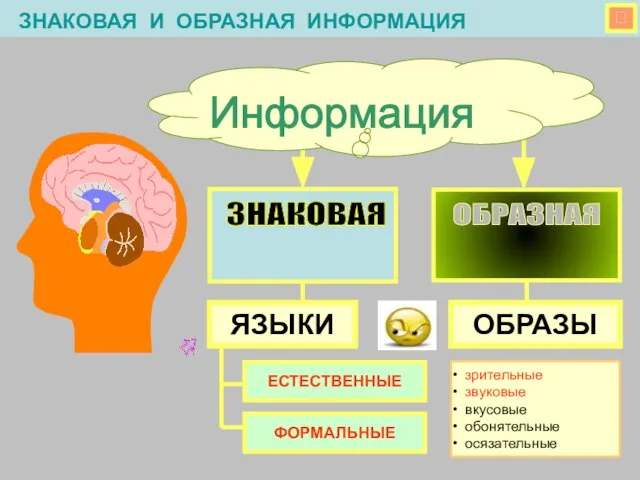

- 11. ЗНАКОВАЯ И ОБРАЗНАЯ ИНФОРМАЦИЯ Информация ОБРАЗНАЯ ОБРАЗЫ ЯЗЫКИ зрительные звуковые вкусовые обонятельные осязательные ЕСТЕСТВЕННЫЕ ФОРМАЛЬНЫЕ

- 12. ЯЗЫК – это знаковый способ представления информации. Общение на языках - это процесс передачи информации в

- 13. ХРАНЕНИЕ ИНФОРМАЦИИ ПЕРЕДАЧА ИНФОРМАЦИИ М О З Г человека носитель информации Внутренняя память Внешние носители информации

- 14. АНАЛОГИЯ МЕЖДУ КОМПЬЮТЕРОМ И ЧЕЛОВЕКОМ В памяти компьютера х р а н я т с

- 15. ПЕРЕДАЧА ИНФОРМАЦИИ ПЕРЕДАЧА ИНФОРМАЦИИ происходит между источником и приемником по информационным каналам связи. Источник информации

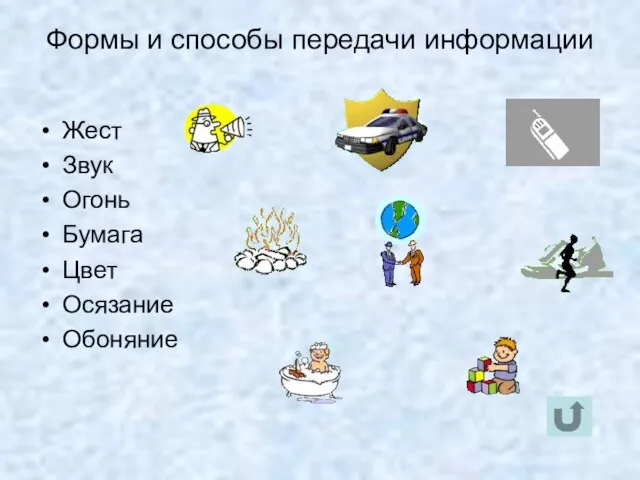

- 16. Формы и способы передачи информации Жест Звук Огонь Бумага Цвет Осязание Обоняние

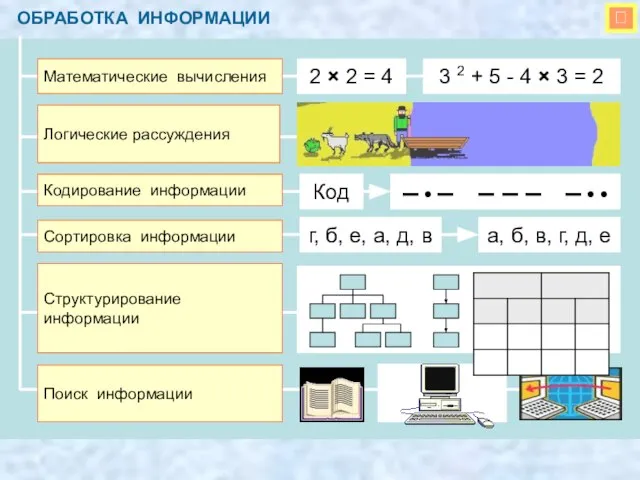

- 17. ОБРАБОТКА ИНФОРМАЦИИ

- 18. Свойства информации

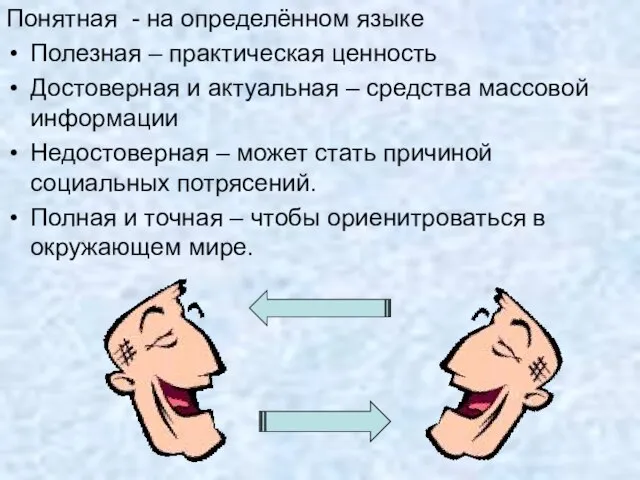

- 19. Понятная - на определённом языке Полезная – практическая ценность Достоверная и актуальная – средства массовой информации

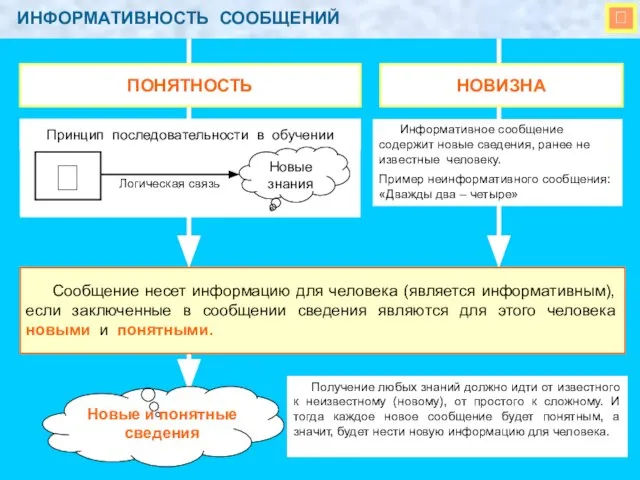

- 20. ИНФОРМАТИВНОСТЬ СООБЩЕНИЙ Получение любых знаний должно идти от известного к неизвестному (новому), от простого к

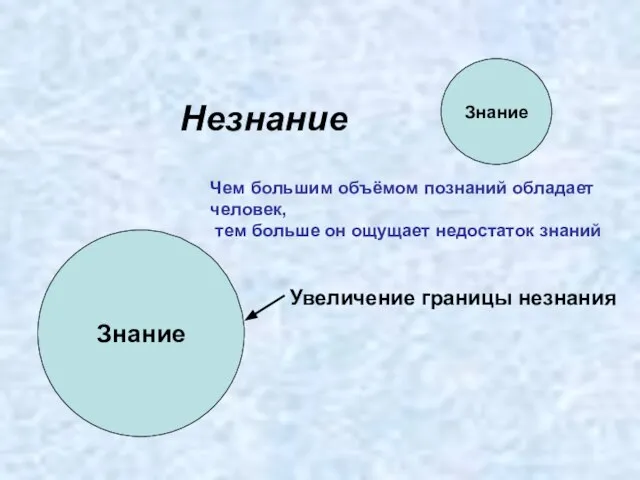

- 21. Знание Незнание Знание Чем большим объёмом познаний обладает человек, тем больше он ощущает недостаток знаний Увеличение

- 22. Уменьшение неопределённости знаний Если некоторое сообщение приводит к уменьшению неопределённости знаний. То такое сообщение содержит информацию.

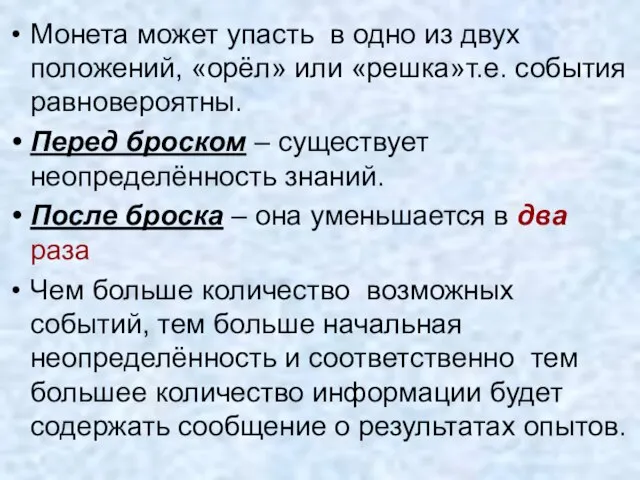

- 23. Монета может упасть в одно из двух положений, «орёл» или «решка»т.е. события равновероятны. Перед броском –

- 24. Единицы измерения количества информации

- 25. За единицу количества информации принимается такое количество информации, которое содержит сообщение, уменьшающее неопределённость знаний в два

- 26. ЕДИНИЦЫ ИЗМЕРЕНИЯ ИНФОРМАЦИИ СИМВОЛЬНЫЙ АЛФАВИТ КОМПЬЮТЕРА русские (РУССКИЕ) буквы латинские (LAT) буквы цифры (1, 2,

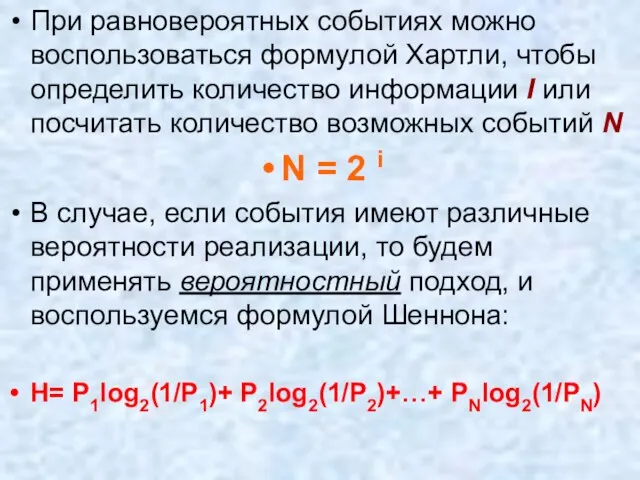

- 27. При равновероятных событиях можно воспользоваться формулой Хартли, чтобы определить количество информации I или посчитать количество возможных

- 28. АЛФАВИТНЫЙ ПОДХОД К ИЗМЕРЕНИЮ ИНФОРМАЦИИ МОЩНОСТЬ АЛФАВИТА число символов в алфавите (его размер) N ИНФОРМАЦИОННЫЙ

- 29. Число равновероятных в о з м о ж н ы х с о б ы т

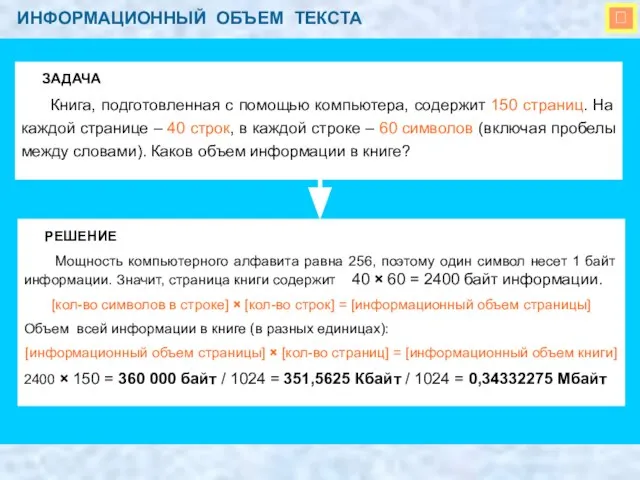

- 30. ИНФОРМАЦИОННЫЙ ОБЪЕМ ТЕКСТА ЗАДАЧА Книга, подготовленная с помощью компьютера, содержит 150 страниц. На каждой странице

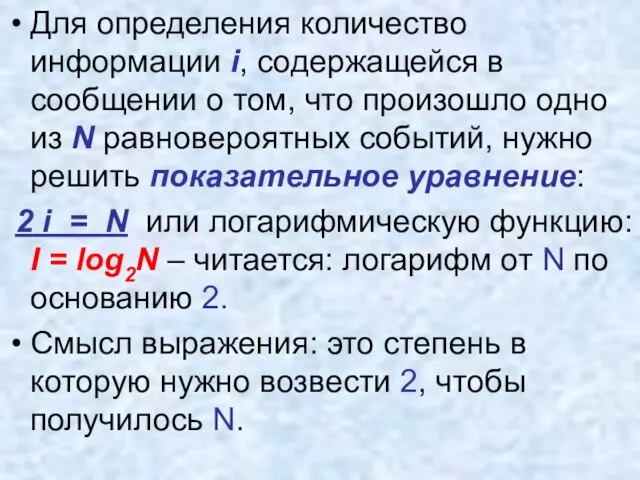

- 31. Для определения количество информации i, содержащейся в сообщении о том, что произошло одно из N равновероятных

- 32. Например: вычислим количество информации в сообщении о том, ч то из колоды карт случайным образом достали

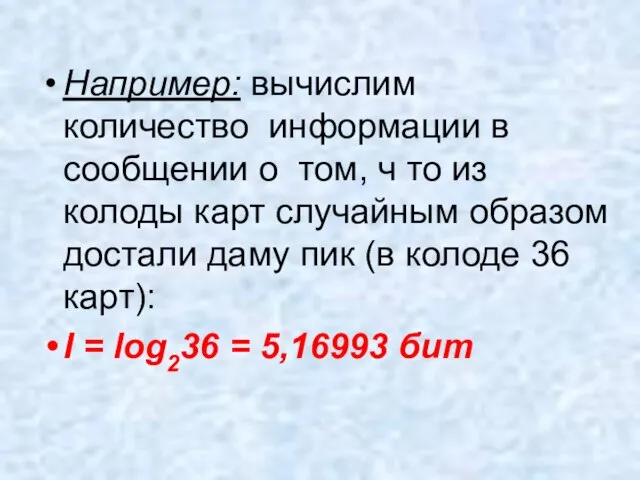

- 33. ПОКАЗАТЕЛЬНОЕ УРАВНЕНИЕ N i Определение количества информации, содержащейся в сообщении о том, что произошло одно из

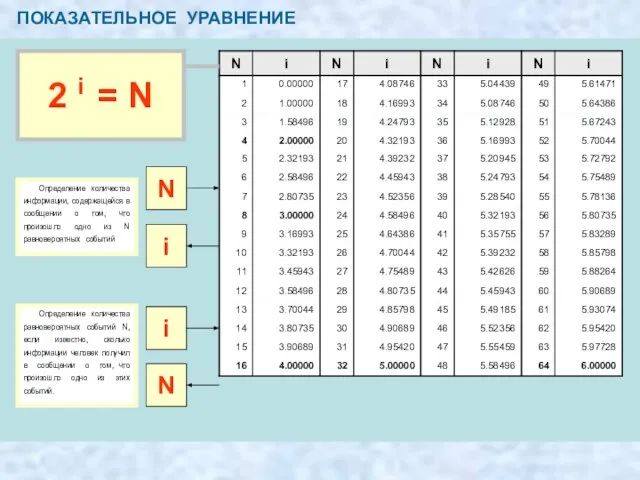

- 34. КОЛИЧЕСТВО ИНФОРМАЦИИ В СООБЩЕНИИ Задача 1. При угадывании целого числа в диапазоне от 1 до N

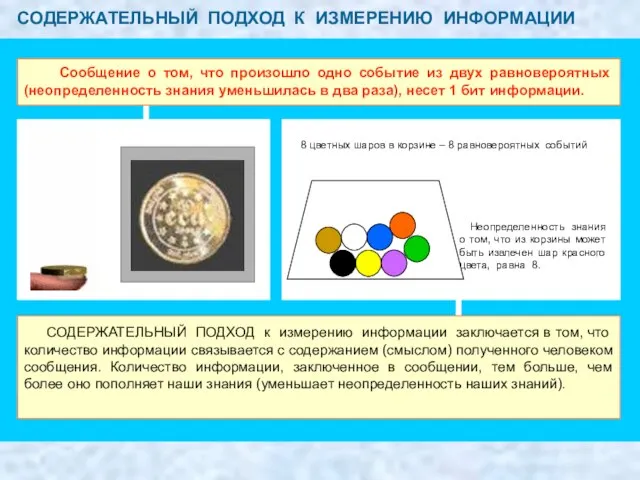

- 35. СОДЕРЖАТЕЛЬНЫЙ ПОДХОД К ИЗМЕРЕНИЮ ИНФОРМАЦИИ Сообщение о том, что произошло одно событие из двух равновероятных (неопределенность

- 36. Вероятность пусть при бросании несимметричной четырёхгранной пирамидки вероятность отдельных событий будет: Р1= 1/2 (0,5), Р2= 1/4(0,25),

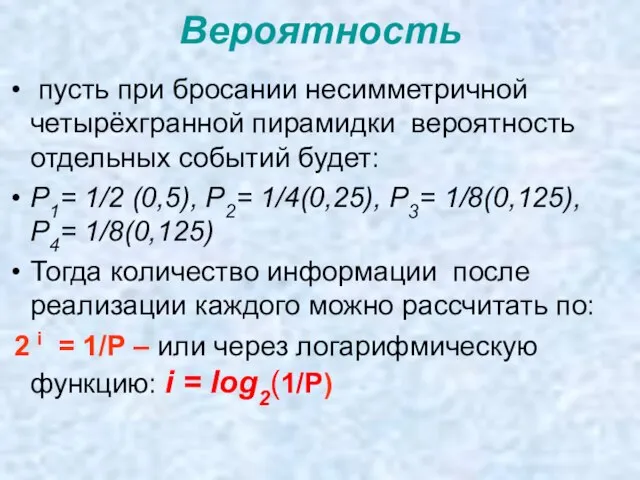

- 37. i 1= log2(1/0.5) = log22 = 1бит i 2= log2(1/0.25) = log24= 2бита i 3= log2(1/0.125)

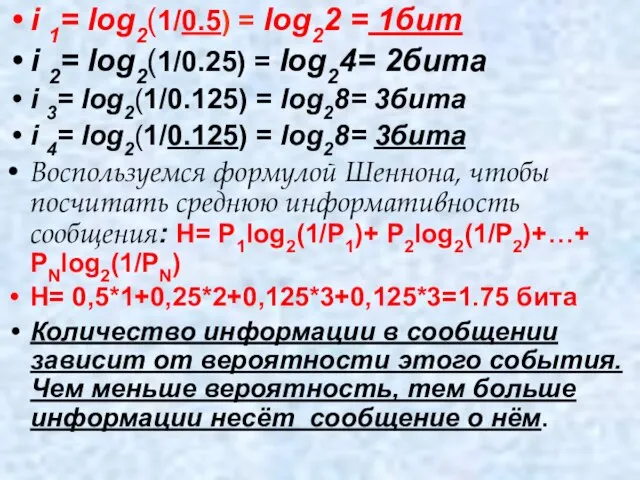

- 38. При равновероятностных событиях формула Шеннона переходит в формулу Хартли: т.к. Р1=Р2=Р3…=1/N i = log2(1/N)= log24= 2

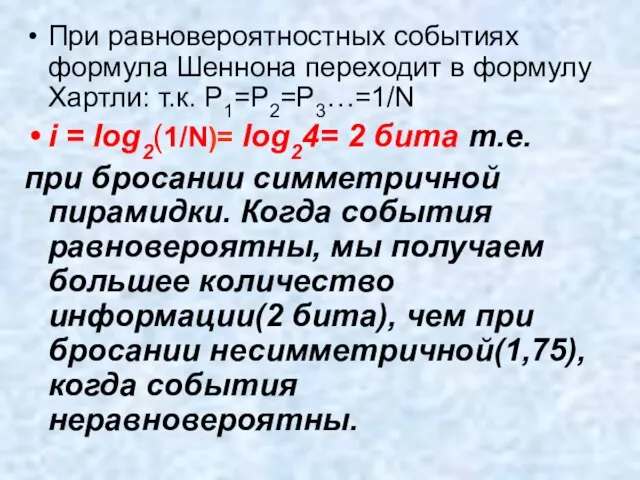

- 40. Скачать презентацию

Африка

Африка Тууль Максим Юрьевич «Клуб Участников Проектного Процесса», Директор АКБ «Надежный банк», Президент тел: (495) 7675=02=23; E-mail: TMY@proje

Тууль Максим Юрьевич «Клуб Участников Проектного Процесса», Директор АКБ «Надежный банк», Президент тел: (495) 7675=02=23; E-mail: TMY@proje Илларион Михайлович Прянишников (1840-1894)

Илларион Михайлович Прянишников (1840-1894) ТЕРРИТОРИЯ ЛЮБВИ

ТЕРРИТОРИЯ ЛЮБВИ Презентация на тему И.С. Тургенева «Муму»

Презентация на тему И.С. Тургенева «Муму»  Презентація 10 клас Урок 31

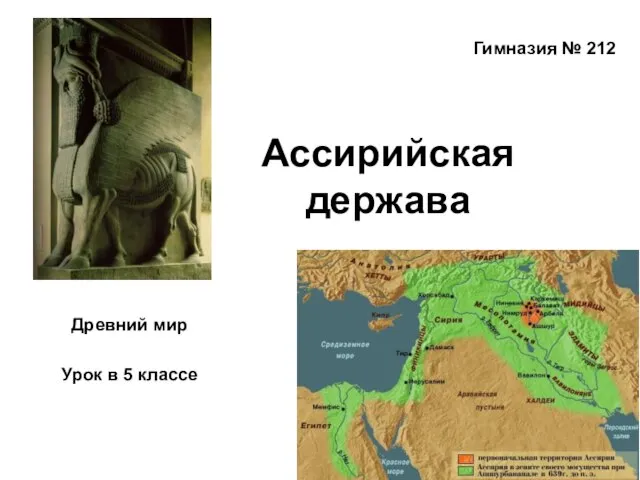

Презентація 10 клас Урок 31 Ассирийская держава

Ассирийская держава Презентация 2

Презентация 2 Сертификация систем качества

Сертификация систем качества История развития зоологии

История развития зоологии Реализуемое имущество АО РоссельхозБанк: транспортные средства, с/х техника и оборудование

Реализуемое имущество АО РоссельхозБанк: транспортные средства, с/х техника и оборудование Обработка нижних срезов рукавов

Обработка нижних срезов рукавов Давайте знакомиться!

Давайте знакомиться! Мой первый бизнес-план

Мой первый бизнес-план Украшения своими руками

Украшения своими руками Стратегическое планирование и его этапы. Планирование маркетинга. Контроль. Типы маркетингового контроля

Стратегическое планирование и его этапы. Планирование маркетинга. Контроль. Типы маркетингового контроля Требования к информации, формируемой в бухгалтерском учете

Требования к информации, формируемой в бухгалтерском учете Центр«Интеллектуальные электронные энергосберегающие системы»(ЦИЭС)

Центр«Интеллектуальные электронные энергосберегающие системы»(ЦИЭС) Защитные очки

Защитные очки Карельский научный центр Российской академии наук. Молодые учёные

Карельский научный центр Российской академии наук. Молодые учёные История Т-34

История Т-34 По страницам русского языка

По страницам русского языка Ксюша

Ксюша Урок 20.1. Перевод дела в архив (на примере гражданского дела)

Урок 20.1. Перевод дела в архив (на примере гражданского дела) Презентация на тему Имена существительные нарицательные и собственные

Презентация на тему Имена существительные нарицательные и собственные Аудитория украинского интернета: статистика и тенденции

Аудитория украинского интернета: статистика и тенденции Любить но кого же?

Любить но кого же? Право, семья, ребенокКравченко, 9 класс

Право, семья, ребенокКравченко, 9 класс