Содержание

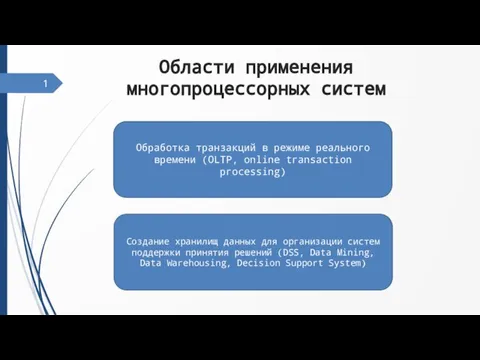

- 2. Области применения многопроцессорных систем 1 Обработка транзакций в режиме реального времени (OLTP, online transaction processing) Создание

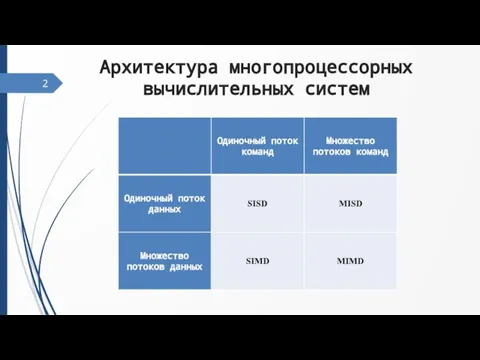

- 3. Архитектура многопроцессорных вычислительных систем 2

- 4. Многопроцессорные системы с общей памятью 3 ЦП ЦП ЦП ОБЩАЯ ФИЗИЧЕСКАЯ ПАМЯТЬ I/O подсистема

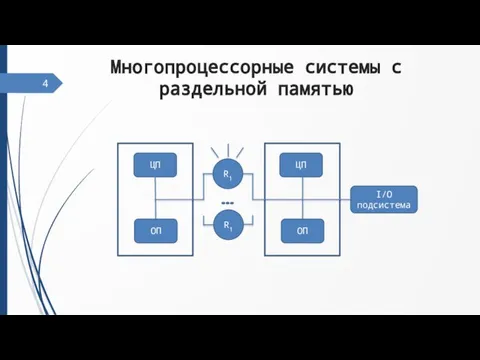

- 5. Многопроцессорные системы с раздельной памятью 4 ЦП ОП ЦП ОП I/O подсистема R1 R1

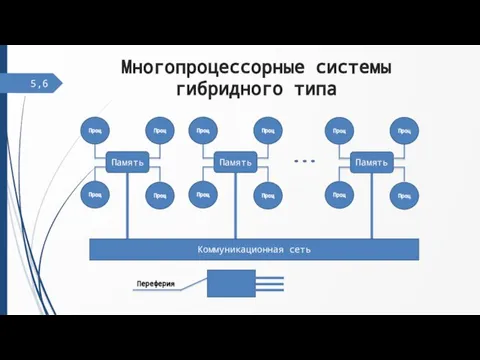

- 6. Многопроцессорные системы гибридного типа 5, Память Проц Проц Проц Проц Память Проц Проц Проц Проц Память

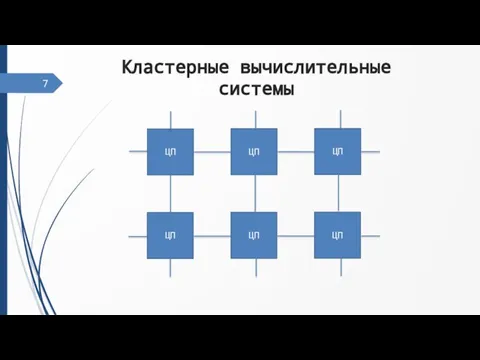

- 7. Кластерные вычислительные системы ЦП ЦП ЦП ЦП ЦП ЦП

- 8. Компьютерные сети ПК Маршрутизатор ПК Маршрутизатор Канал связи Линия связи Линия связи Линия связи

- 9. Коммуникационные среды В самом общем смысле архитектуру компьютера можно определить как способ соединения компьютеров между собой,

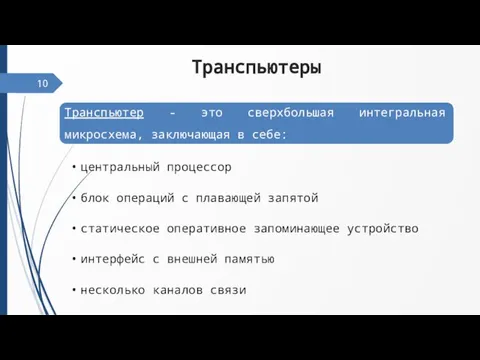

- 10. Транспьютеры

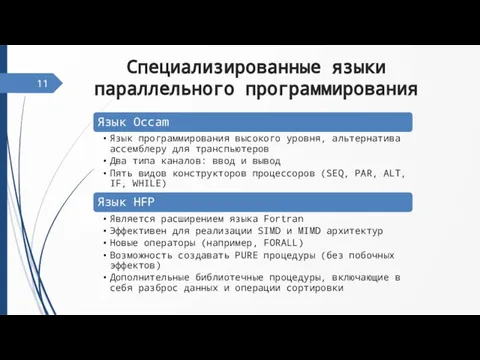

- 11. Специализированные языки параллельного программирования

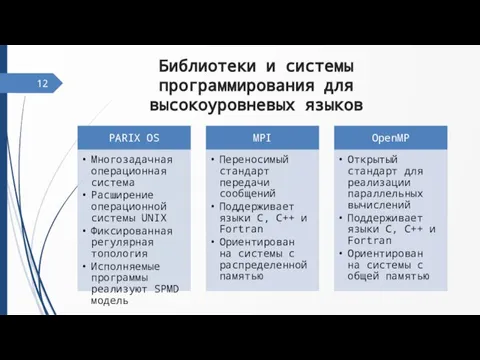

- 12. Библиотеки и системы программирования для высокоуровневых языков

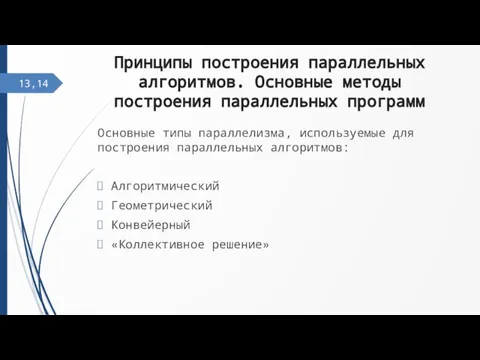

- 13. Принципы построения параллельных алгоритмов. Основные методы построения параллельных программ Основные типы параллелизма, используемые для построения параллельных

- 14. Алгоритмический параллелизм Алгоритмическим параллелизмом называется параллелизм, который выявляется путем выделения в данном алгоритме тех фрагментов, которые

- 15. Геометрический параллелизм Геометрический параллелизм допускает разбиение данных на части по числу процессоров, при котором обработку каждой

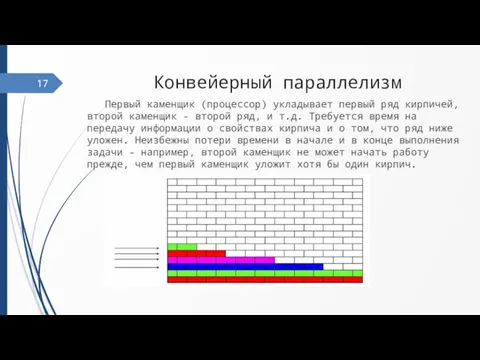

- 16. Конвейерный параллелизм Первый каменщик (процессор) укладывает первый ряд кирпичей, второй каменщик - второй ряд, и т.д.

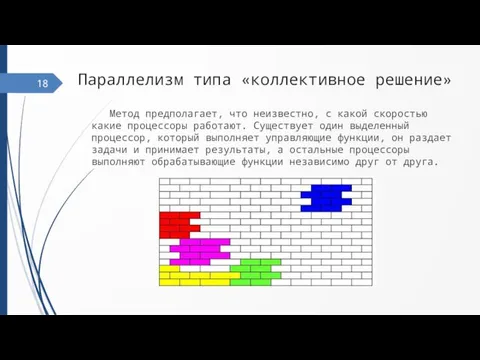

- 17. Параллелизм типа «коллективное решение» Метод предполагает, что неизвестно, с какой скоростью какие процессоры работают. Существует один

- 18. Статическая и динамическая балансировка загрузки процессоров Статическая балансировка выполняется до начала выполнения параллельного приложения. Алгоритм динамической

- 19. Проблема тупиков Тупик - ситуация, в которой один или несколько процессов ожидают какого-либо события, которое никогда

- 20. Недетерминированность параллельных программ Недетерминированность процессов происходит от того, что они обмениваются данными в непредсказуемые моменты времени.

- 21. Эффективность, ускорение параллельных программ. Ускорением параллельного алгоритма (Sp), называют отношение времени выполнения алгоритма на одном процессоре

- 22. Оценка времени выполнения алгоритма Степенью параллелизма алгоритма называют число действий алгоритма, которые могут выполняться одновременно, каждое

- 23. Внутренний параллелизм Внутренние свойства алгоритма, не зависящие от вида и особенностей вычислительных систем. На разных этапах

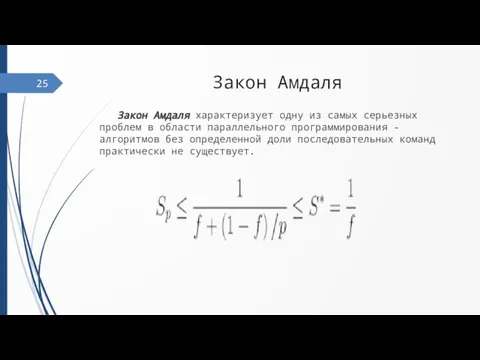

- 24. Закон Амдаля Закон Амдаля характеризует одну из самых серьезных проблем в области параллельного программирования - алгоритмов

- 25. Параллельная программа как ансамбль взаимодействующих последовательных процессов Поскольку параллельная программа — это множество взаимодействующих последовательных процессов,

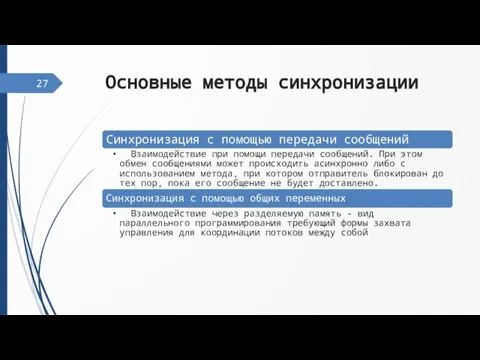

- 26. Основные методы синхронизации 27

- 27. Синхронизация с помощью передачи сообщений 28

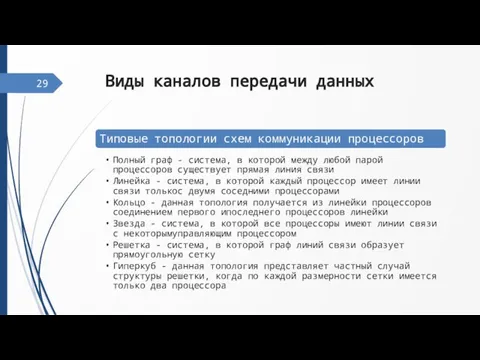

- 28. Виды каналов передачи данных 29

- 29. Синхронный и асинхронный обмен сообщениями 30

- 30. Защита разделяемых данных Для организации разделения ресурсов между несколькими потоками необходимо иметь возможность: определения доступности запрашиваемых

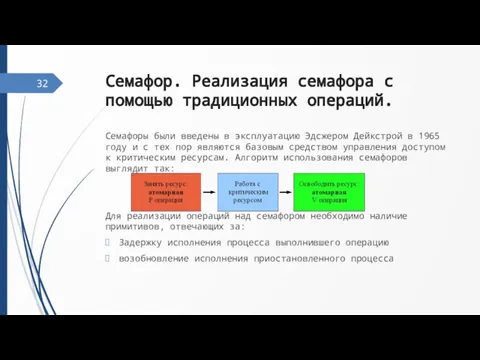

- 31. Семафор. Реализация семафора с помощью традиционных операций. Семафоры были введены в эксплуатацию Эдсжером Дейкстрой в 1965

- 32. Критическая секция. Монитор, Очереди заданий. Критическая секция — объект синхронизации потоков, позволяющий предотвратить одновременное выполнение некоторого

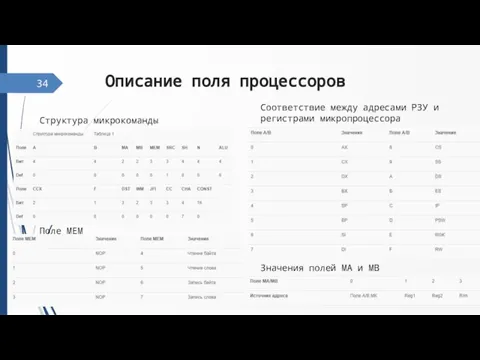

- 33. Описание поля процессоров 34 Структура микрокоманды Соответствие между адресами РЗУ и регистрами микропроцессора Значения полей MA

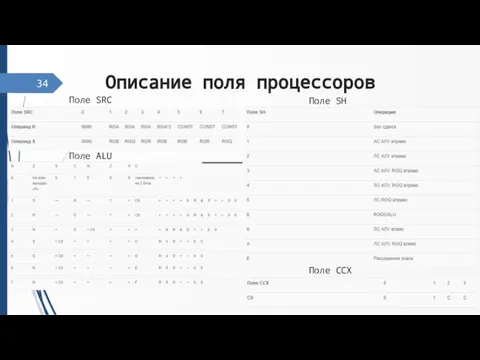

- 34. Описание поля процессоров 34 Поле SRC Поле SH Поле ALU Поле CCX

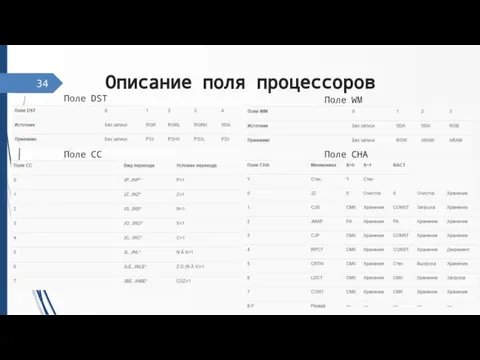

- 35. Описание поля процессоров 34 Поле DST Поле WM Поле CC Поле CHA

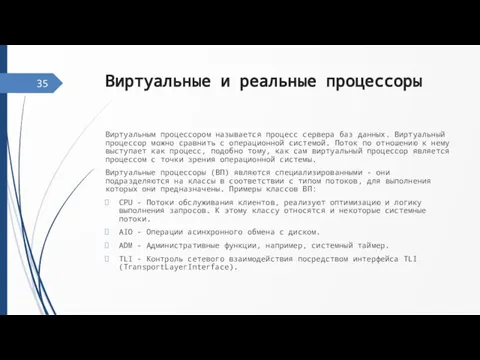

- 36. Виртуальные и реальные процессоры Виртуальным процессором называется процесс сервера баз данных. Виртуальный процессор можно сравнить с

- 37. Параллельное и конкурентное выполнение процессов 36

- 38. Физические и виртуальные каналы Виртуальные каналы — это устойчивые пути следования трафика, создаваемые в сети с

- 39. Физические и виртуальные топологии В MPI топология представляет собой механизм сопоставления процессам, принадлежащим группе, альтернативных по

- 40. Режимы передачи данных Режим передачи (transmissionmode) определяет возможные направления передачи сигналов между узлами сети. Существуют три

- 41. 40 Измерение времени На время выполнения программы влияют следующие факторы: Ввод исходной информации в программу. Качество

- 42. 41 Отладка программы Отладка — этап разработки компьютерной программы, на котором обнаруживают, локализуют и устраняют ошибки.

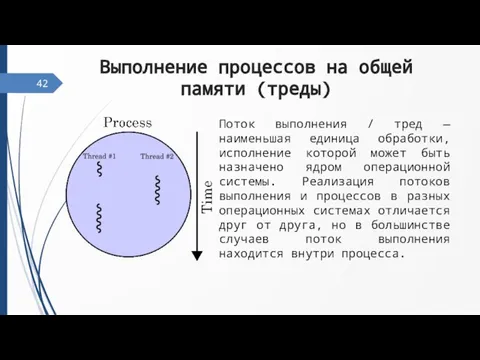

- 43. 42 Выполнение процессов на общей памяти (треды) Поток выполнения / тред — наименьшая единица обработки, исполнение

- 44. 43 Использование семафоров для синхронизации тредов Семафоры традиционно использовались для синхронизации процессов, обращающихся к разделяемым данным.

- 45. 44 Примеры математических моделей применение которых требуют суперкомпьютерных вычислений Кратко разработку и программную реализацию моделирования задач

- 46. 45 Кинетически согласованные разностные схемы Многие из проблем, связанных с использованием многопроцессорных вычислительных систем для решения

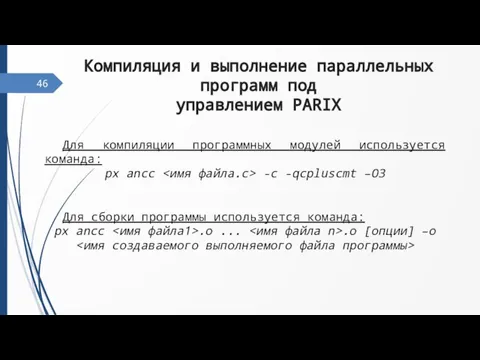

- 47. 46 Компиляция и выполнение параллельных программ под управлением PARIX Для компиляции программных модулей используется команда: px

- 48. 47 Уровни оптимизации выполняемого программного кода Решение проблемы быстрой и недорогой разработки эффективного программного обеспечения для

- 49. 48 Заголовочные файлы и библиотеки передачи данных, порождения процессов и доступа к семафорам Send, Recv –

- 50. 49 Запуск и прекращение выполнения программы. Утилита nrm. Сервер epxd Для запуска PARIX-приложения используется команда run.

- 51. 50 Анализ результатов выполнения параллельной программы. Распределение и освобождение разделов Команда run занимает указанный раздел, так

- 52. 51 Заголовочные файлы и библиотеке MPI. Версии MPI: lam, mpich. Версии Mpi для Unix. Версия Mpi

- 53. 52 Мониторинг выполнения параллельной программы Обычно для целей трассировки в исследуемую программу встраиваются "профилировочные" вызовы, которые

- 54. 53 Некоторые средства Unix (rsh, ssh, bash, ping, scp) их использование для подготовки, выполнения и отладки

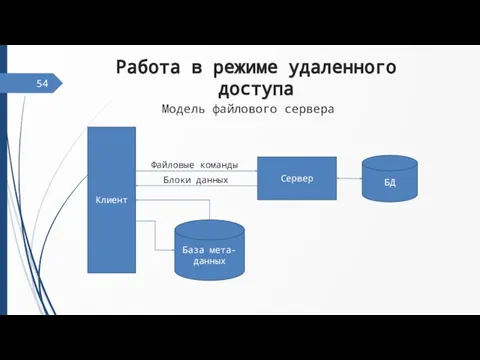

- 55. Работа в режиме удаленного доступа 54 Клиент Сервер БД База мета-данных Файловые команды Блоки данных Модель

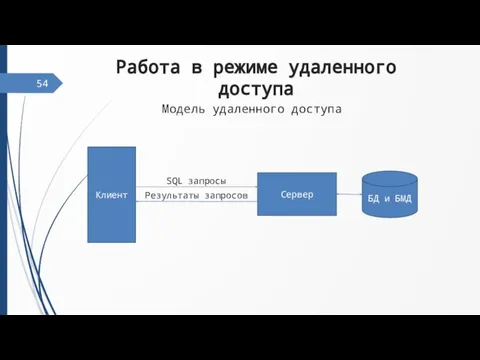

- 56. Работа в режиме удаленного доступа 54 Клиент Сервер БД и БМД SQL запросы Результаты запросов Модель

- 57. Статическая и динамическая балансировка нагрузки 55

- 58. Диффузная балансировка нагрузки 56 Диффузная балансировка нагрузки является методом динамической балансировки загрузки процессоров, где перераспределение вычислительной

- 59. Централизованное и децентрализованное управление вычислениями 57

- 60. Построение алгоритмов динамической балансировки загрузки на основе технологии «клиент-сервер» Нагрузка на объединенные между собой серверы распределяется

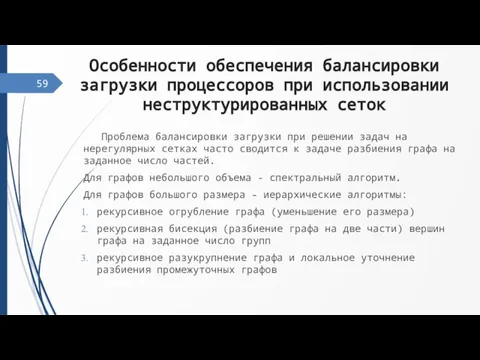

- 61. Особенности обеспечения балансировки загрузки процессоров при использовании неструктурированных сеток Проблема балансировки загрузки при решении задач на

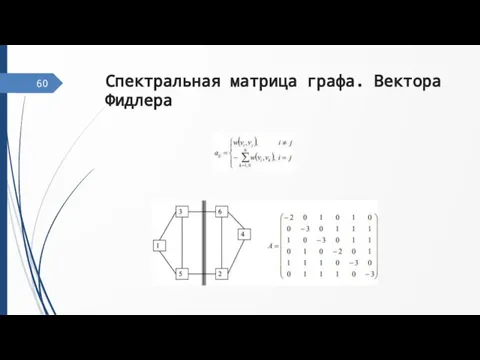

- 62. Спектральная матрица графа. Вектора Фидлера 60

- 63. Иерархические алгоритмы разбиения больших графов Алгоритм Кернигана-Лина: Формирование множества пар вершин для перестановки. Построение новых вариантов

- 64. Методы визуализации двух и трехмерных сеточных данных Под двухмерной визуализацией понимается отображение данных на плоскости в

- 65. 63 Сжатие сеточных данных, заданных на структурированных и неструктурированных сетках. Работоспособность системы распределенной визуализации трехмерных скалярных

- 67. Скачать презентацию

Физика и спорт

Физика и спорт ИДЕНТИФИКАЦИОННОЕ ИССЛЕДОВАНИЕ ПОДПИСЕЙ (общие положения)

ИДЕНТИФИКАЦИОННОЕ ИССЛЕДОВАНИЕ ПОДПИСЕЙ (общие положения) Эволюция человекаАвт. М. А. Линева

Эволюция человекаАвт. М. А. Линева Азбука в загадках-добавлялках

Азбука в загадках-добавлялках 29 ноября — День Матери

29 ноября — День Матери Периодичность, четность и нечетность функций

Периодичность, четность и нечетность функций Насекомые Урок окружающего мира 2 класс

Насекомые Урок окружающего мира 2 класс Необычные религии мира. Гайкославие

Необычные религии мира. Гайкославие Приглашение к сотрудничеству. Гольфстрим

Приглашение к сотрудничеству. Гольфстрим Презентация на тему Выполните задание

Презентация на тему Выполните задание Базовые нормативные документы. Лаборатория

Базовые нормативные документы. Лаборатория Святые Вера, Надежда, Любовь и мать их София

Святые Вера, Надежда, Любовь и мать их София Презентация на тему: Педиатрия и гигиена - основные понятия и принципы

Презентация на тему: Педиатрия и гигиена - основные понятия и принципы СЕМИНАР (для членов Совета по качеству) Разработка СМК в ИрГТУ 1.1. Понятие качества. Связь СМК с стандар-тами ИСО-9000. Модель TQM. Основ

СЕМИНАР (для членов Совета по качеству) Разработка СМК в ИрГТУ 1.1. Понятие качества. Связь СМК с стандар-тами ИСО-9000. Модель TQM. Основ Услуга«УВЕРЕННЫЙ ПРИЕМ»

Услуга«УВЕРЕННЫЙ ПРИЕМ» А что такое катехизис?

А что такое катехизис? Строитель…Найдешь ли профессию в мире нужней?!

Строитель…Найдешь ли профессию в мире нужней?! Przydomowa Oczyszalnia Ścieków

Przydomowa Oczyszalnia Ścieków УСТРОЙСТВА ВВОДА ИНФОРМАЦИИ

УСТРОЙСТВА ВВОДА ИНФОРМАЦИИ TITLE

TITLE  Правовой статус несовершеннолетних с рождения до совершеннолетия

Правовой статус несовершеннолетних с рождения до совершеннолетия День защиты детей

День защиты детей Управляемая RGB - подсветка

Управляемая RGB - подсветка Персонал Мотор любой организации

Персонал Мотор любой организации Зарождение философской мысли

Зарождение философской мысли Николаева Людмила Павловна - исполнительный директор РСПОК «Содействие»

Николаева Людмила Павловна - исполнительный директор РСПОК «Содействие» Инженер по эксплуатации железных дорог

Инженер по эксплуатации железных дорог BUS

BUS