Содержание

- 2. Структура кластера Узел доступа (access node) СХД Узел (worker node) Узел (worker node) SSH подключение к

- 3. Общая информация Для работы на кластере используется SLURM при входе на кластер необходимо подгружать его модуль

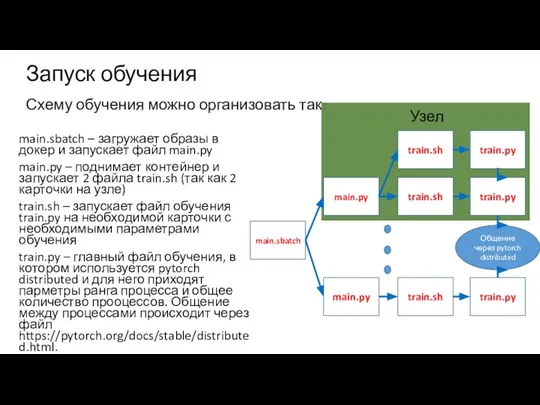

- 4. Запуск обучения Схему обучения можно организовать так: main.sbatch – загружает образы в докер и запускает файл

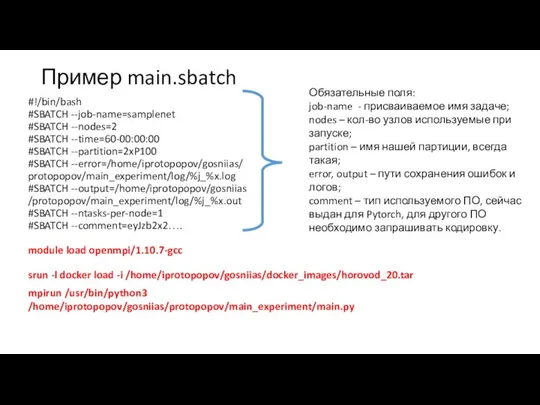

- 5. Пример main.sbatch #!/bin/bash #SBATCH --job-name=samplenet #SBATCH --nodes=2 #SBATCH --time=60-00:00:00 #SBATCH --partition=2xP100 #SBATCH --error=/home/iprotopopov/gosniias/ protopopov/main_experiment/log/%j_%x.log #SBATCH --output=/home/iprotopopov/gosniias

- 6. Примечание main.sbatch При запуске мы всегда загружаем образ и поднимаем контейнеры, но процессы могут падать и

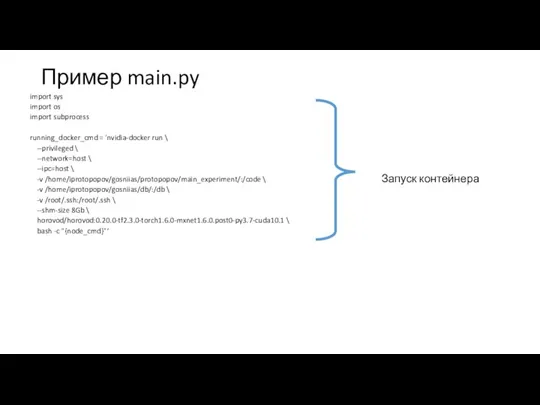

- 7. Пример main.py import sys import os import subprocess running_docker_cmd = 'nvidia-docker run \ --privileged \ --network=host

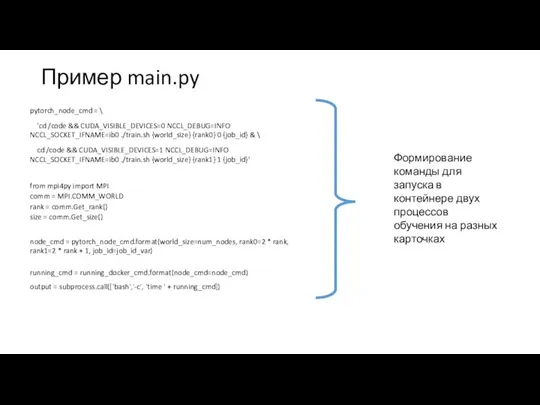

- 8. Пример main.py pytorch_node_cmd = \ 'cd /code && CUDA_VISIBLE_DEVICES=0 NCCL_DEBUG=INFO NCCL_SOCKET_IFNAME=ib0 ./train.sh {world_size} {rank0} 0 {job_id}

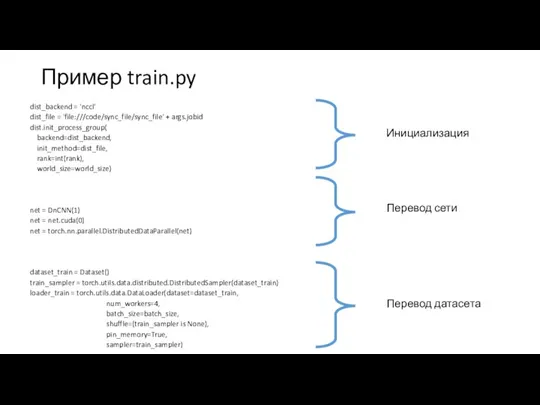

- 9. Пример train.py dist_backend = 'nccl' dist_file = 'file:///code/sync_file/sync_file' + args.jobid dist.init_process_group( backend=dist_backend, init_method=dist_file, rank=int(rank), world_size=world_size) net

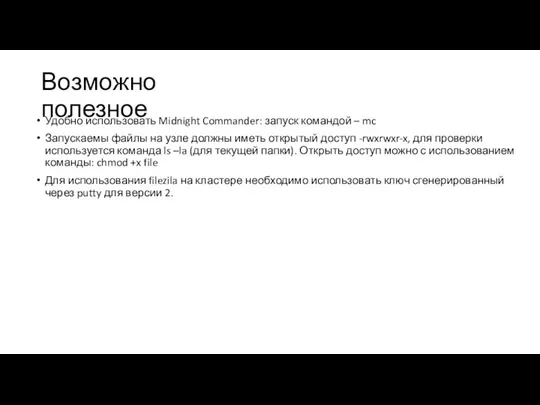

- 10. Возможно полезное Удобно использовать Midnight Commander: запуск командой – mc Запускаемы файлы на узле должны иметь

- 12. Скачать презентацию

Реки России

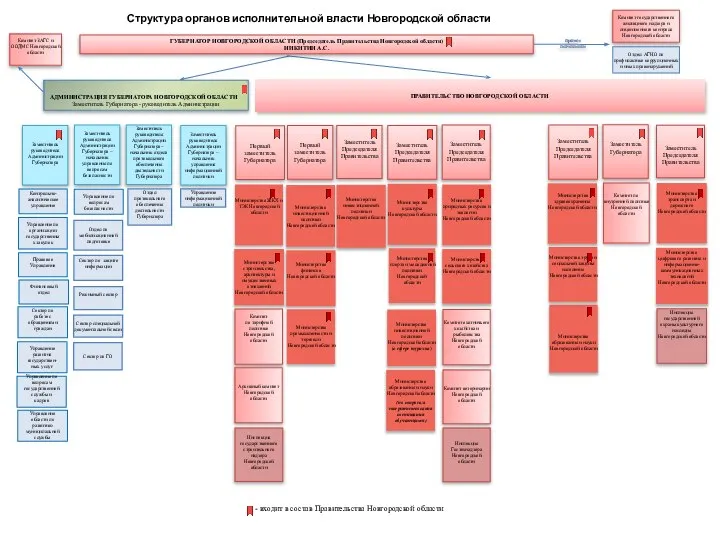

Реки России Структура ПНО АГНО ОИВ

Структура ПНО АГНО ОИВ Разные типы личностей. Утром

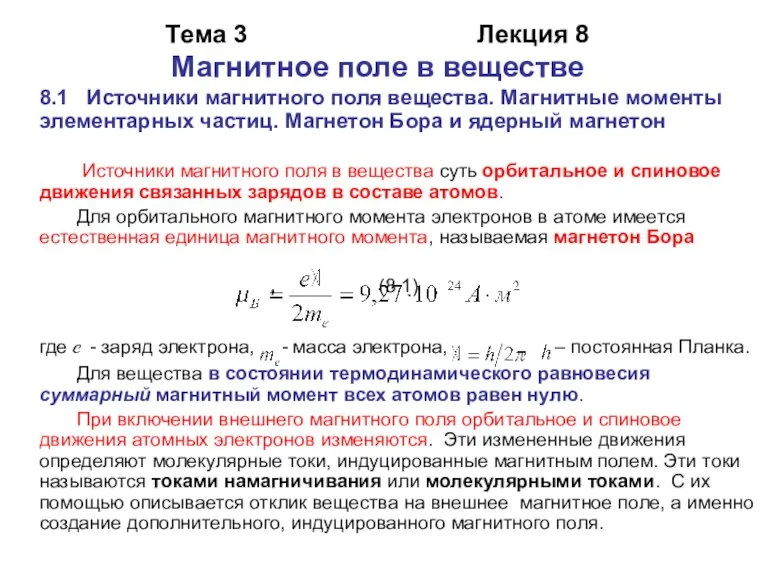

Разные типы личностей. Утром Магнитное поле в веществе

Магнитное поле в веществе Иоганн Мельхиор Динглингер

Иоганн Мельхиор Динглингер Характеристика детей с ЗПР. Неблагоприятные семейные факторы влияющие на ребенка с ЗПР

Характеристика детей с ЗПР. Неблагоприятные семейные факторы влияющие на ребенка с ЗПР Память ROM

Память ROM Мастерская авторских сумок Diana Ulanova

Мастерская авторских сумок Diana Ulanova Рубительные машины

Рубительные машины Комплекс упражнений

Комплекс упражнений Измерения (параметры) развития эффективности ОГО

Измерения (параметры) развития эффективности ОГО Рис.1

Рис.1 Они подарили нам МИР

Они подарили нам МИР Мастер-класс. Божья коровка

Мастер-класс. Божья коровка Цветовая коррекция лица

Цветовая коррекция лица Past perfect simple, continuous

Past perfect simple, continuous МЫ ЗАЯВЛЯЕМ: СОХРАНЕНИЕ НАШЕГО ВЕЧНОГО ДОМА В НАШИХ ИНТЕРЕСАХ! ОБРАЩЕНИЕ УЧАЩИХСЯ ГОУ СОШ №

МЫ ЗАЯВЛЯЕМ: СОХРАНЕНИЕ НАШЕГО ВЕЧНОГО ДОМА В НАШИХ ИНТЕРЕСАХ! ОБРАЩЕНИЕ УЧАЩИХСЯ ГОУ СОШ №  Урок русского языка в 5 классе

Урок русского языка в 5 классе ეთნიკური უმცირესობების წარმომადგენლებისათვის პროფესიული და უმაღლესი განათლების ხელმისაწვდ

ეთნიკური უმცირესობების წარმომადგენლებისათვის პროფესიული და უმაღლესი განათლების ხელმისაწვდ Презентация на тему что такое хвоинки 1 класс

Презентация на тему что такое хвоинки 1 класс  Применение нестандартных форм проведения уроков иностранного языка в средней общеобразовательной школе

Применение нестандартных форм проведения уроков иностранного языка в средней общеобразовательной школе Озеро Увильды

Озеро Увильды ДОКАЗЫВАНИЕ КОРРУПЦИОННЫХ ФАКТИЧЕСКИХ ОБСТОЯТЕЛЬСТВ ПО УГОЛОВНОМУ ЗАКОНОДАТЕЛЬСТВУ ЗАРУБЕЖНЫХ

ДОКАЗЫВАНИЕ КОРРУПЦИОННЫХ ФАКТИЧЕСКИХ ОБСТОЯТЕЛЬСТВ ПО УГОЛОВНОМУ ЗАКОНОДАТЕЛЬСТВУ ЗАРУБЕЖНЫХ Комментарии по сайту

Комментарии по сайту Канада. Признаки государства

Канада. Признаки государства Вооруженные силы России

Вооруженные силы России Методы личной работы как важнейшее условие эффективной деятельности рукуводителя

Методы личной работы как важнейшее условие эффективной деятельности рукуводителя Ресторан французской кухни на 125 мест

Ресторан французской кухни на 125 мест