- Главная

- Информатика

- Архитектура вычислительных систем. (Лекция 1)

Содержание

- 2. Введение в предмет ЦЕЛЬ развития вычислительных систем – повышение эффективности обработки данных: скорость + объем +

- 3. Этапы развития (1) РУЧНОЙ ЭТАП – пальцы, счеты, абак (у греков), узелковый счет (у индейцев) и

- 4. Этапы развития (2) ЭЛЕКТРОМЕХАНИЧЕСКИЙ этап – Табулятор – устройство простейшей обработки данных, введенных с перфокарт (1887,

- 5. Принципы фон Неймана Электронная элементная база Организация памяти в виде однородного линейного адресного пространства Параллельная организация

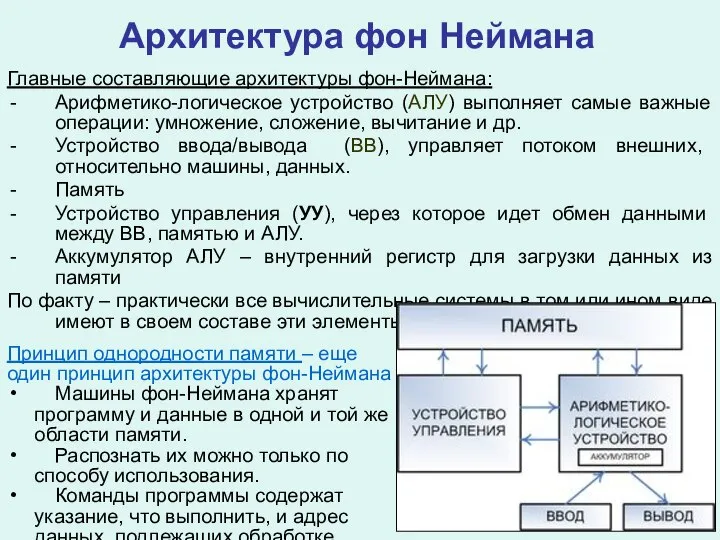

- 6. Архитектура фон Неймана Главные составляющие архитектуры фон-Неймана: Арифметико-логическое устройство (АЛУ) выполняет самые важные операции: умножение, сложение,

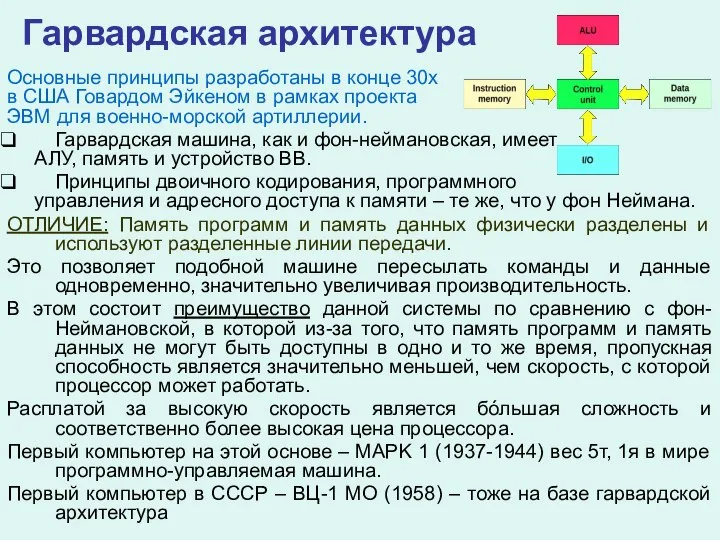

- 7. Гарвардская архитектура Основные принципы разработаны в конце 30х в США Говардом Эйкеном в рамках проекта ЭВМ

- 8. Уровни архитектуры компьютера Уровень физических устройств – элементная база. Цифровой логический уровень. Вентили (логические схемы) –

- 9. Поколения ЭВМ (элементная база) Первое поколение – электронные лампы (1945-1955) Второе поколение – транзисторы (1955-1965) Третье

- 10. ТИПЫ СОВРЕМЕННЫХ КОМПЬЮТЕРОВ Одноразовые (безбатарейные) микросхемы – проигрывание мелодий на поздравительных открытках, маркирование товаров и т.п.

- 11. Зачем и где нужны мощные ЭВМ Автомобилестроение (а также самолеты и космические аппараты и т.п.) Нефте-

- 12. Еще примеры Моделирование взрывов атомной бомбы после запрета реальных испытаний Расчет аэродинмаики болидов «Формулы 1» BMW

- 13. Суперкомпьютеры (1) Главные аспекты: Высокопроизводительные вычислительные системы Программные технологии параллельной обработки данных Параллельные алгоритмы Что такое

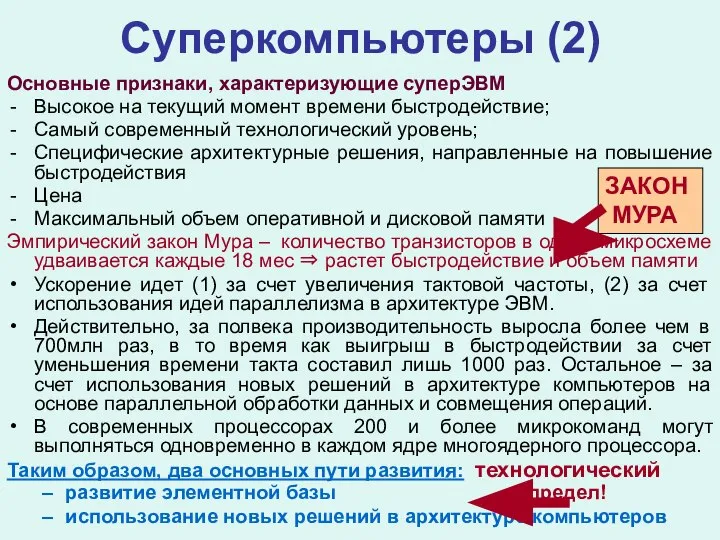

- 14. Суперкомпьютеры (2) Основные признаки, характеризующие суперЭВМ Высокое на текущий момент времени быстродействие; Самый современный технологический уровень;

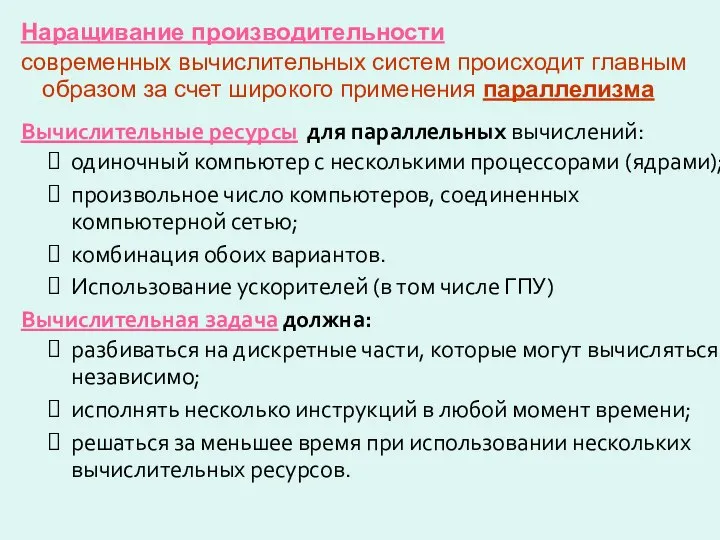

- 15. Наращивание производительности современных вычислительных систем происходит главным образом за счет широкого применения параллелизма Вычислительные ресурсы для

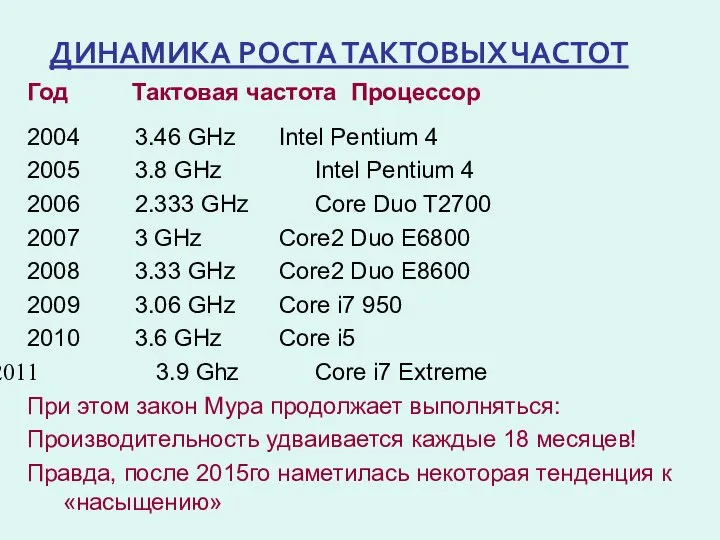

- 16. ДИНАМИКА РОСТА ТАКТОВЫХ ЧАСТОТ Год Тактовая частота Процессор 2004 3.46 GHz Intel Pentium 4 2005 3.8

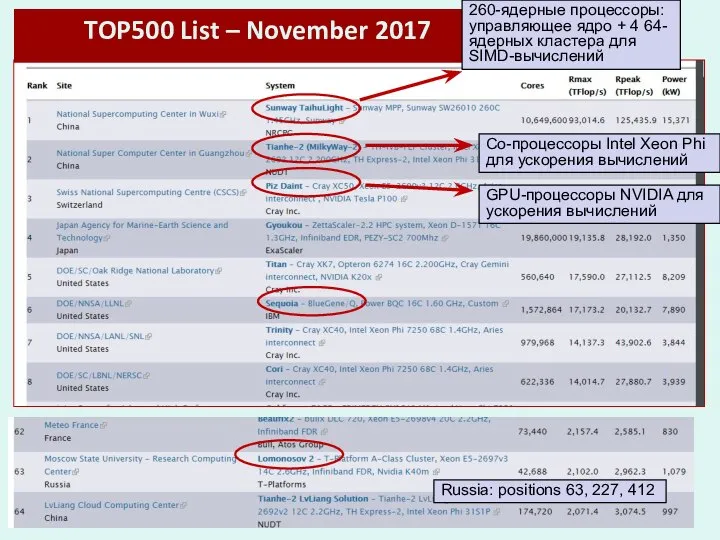

- 17. TOP500 List – November 2017 260-ядерные процессоры: управляющее ядро + 4 64-ядерных кластера для SIMD-вычислений Со-процессоры

- 18. Современные высокопроизводительные системы Особенности современных суперкомпьютерных систем: Многоядерность Гетерогенность Сверхплотная компоновка Внутрипроцессорнный параллелизм Со-процессоры для ускорения

- 19. Параллельная обработка данных (1) Параллельная обработка данных обычно подразделяется на собственно параллельную и конвейерную. Параллельная обработка

- 20. Параллельная обработка данных (2) Если же каждую микрооперацию выделить в отдельный этап (ступень) конвейерного устройства, то

- 21. Краткая история параллелизма (1) Идеи параллелизма появились очень давно. Самарский в начале 50х провел расчет эволюции

- 22. Краткая история параллелизма (2) IBM STRETCH (1961): опережающий просмотр команд, расслоение памяти. В 1956 подписан контракт

- 23. Краткая история параллелизма (3) CDC 7600 (1969) конвейерные независимые ФУ. Восемь независимых конвейерных ФУ – сочетание

- 24. Краткая история параллелизма (4) CRAY 1 (1976): векторно-конвейерные процессоры – классика жанра В 1972 С.Крэй покидает

- 25. Краткая история параллелизма (5) Плюс: простота архитектуры, дешевизна, легко подобрать оптимальную конфигурацию по производительности и себестоимости

- 26. Краткая история параллелизма (6) 80е: массовое производство однокристальных микропроцессоров → всеохватывающее распространение ПК. 1989: Микропроцессор Intel

- 28. Скачать презентацию

Слайд 2Введение в предмет

ЦЕЛЬ развития вычислительных систем –

повышение эффективности обработки

Введение в предмет

ЦЕЛЬ развития вычислительных систем –

повышение эффективности обработки

скорость + объем + надежность + цена + удобство

На протяжении всей истории человечества эволюция вычислительных систем (от совсем простых к супер-производительным) обусловлена потребностями решения все более и более сложных счетных задач

Достижение определенного уровня возможностей вычислительных систем выводит на более высокий уровень возможности человека в области науки и технологий. Это, в свою очередь, приводит к необходимости решения более сложных вычислительных задач, т.е. к необходимости совершенствования производительности вычислительных систем и т.д.

Таким образом – развитие вычислительных систем идет рука об руку с развитием промышленности, технологий, науки и других отраслей деятельности человека

Слайд 3Этапы развития (1)

РУЧНОЙ ЭТАП –

пальцы, счеты, абак (у греков),

узелковый

Этапы развития (1)

РУЧНОЙ ЭТАП –

пальцы, счеты, абак (у греков),

узелковый

МЕХАНИЧЕСКИЙ ЭТАП –

Леонардо да Винчи (~1500г) – эскиз сумматора

Шиккард (1623) – первое действующее устройство сложения – «механические часы», 1 экз.

Паскаль (1641) – суммирующая машина, 50 экз.

Лейбниц (1671) – арифмометр, 4 действия

Начало 19 века – элементы автоматизации (ткацкий станок Жаккарда, управление перфокартами, перфолентами) и попытки их применения для вычислительных устройств.

Бэбидж (1822) – описание «разностной машины» для вычисления мат. функций, используемых в навигации (полиномы 4й степени, 15 знаков)

Проект «аналитической» машины Бэбиджа – прообраз современной ЭВМ: память (склад), ввод с перфокарт, вывод на печать, счетное устройство (мельница)

Ада Лавлейс (1843) – основы программирования, первая в мире программа для «аналитической машины»

Базовые элементы – механические (валики, зубчатые колеса и т.п.)

Человек участвует в процессе счета на всех этапах

Слайд 4Этапы развития (2)

ЭЛЕКТРОМЕХАНИЧЕСКИЙ этап –

Табулятор – устройство простейшей обработки

данных, введенных

Этапы развития (2)

ЭЛЕКТРОМЕХАНИЧЕСКИЙ этап –

Табулятор – устройство простейшей обработки

данных, введенных

Главный элемент – электромеханическое реле

Табуляторы определили развитие на 50-60 лет, широко использовались в США, России, Канаде.

30е годы – программно-управляемые вычислительные машины на этой основе

ЭЛЕКТРОННЫЙ этап –

40е годы – начала меняться элементная база, стали использовать электронное реле (триггер), изобретенное еще в начале 20го века.

Сформулированы принципы фон-Неймана (1944)

Первая действующая машина фон-Неймановского типа (1949) – EDSAC (Electronic Delay Storage Automatic Calculator) – автоматический вычислитель с электронной памятью, 100 арифметических операций в секунду.

С этой машины принято отсчитывать первое поколение компьютеров – электронно-вычислительных машин, ЭВМ. Развитие шло в рамках фон-неймановской архитектуры, наращивались количественные характеристики.

Уже на этом этапе использовался параллелизм.

Слайд 5Принципы фон Неймана

Электронная элементная база

Организация памяти в виде однородного

линейного адресного

Принципы фон Неймана

Электронная элементная база

Организация памяти в виде однородного

линейного адресного

Параллельная организация обработки разрядов

Параллельная передача разрядов по внутренним каналам

Принцип адресности.

Структурно основная память состоит из пронумерованных ячеек, причем процессору в произвольный момент доступна любая ячейка. Для доступа к используются номера соответствующих ячеек — адреса.

Принцип программного управления.

Все вычисления, предусмотренные алгоритмом решения задачи, должны быть представлены в виде программы, состоящей из последовательности управляющих слов — команд. Каждая команда предписывает некоторую операцию из набора операций, реализуемых вычислительной машиной.

Принцип двоичного кодирования.

Вся информация, как данные, так и команды, кодируются двоичными цифрами 0 и 1. Каждый тип информации представляется двоичной последовательностью и имеет свой формат.

ЭТИ ПРИНЦИПЫ ХАРАКТЕРНЫ ДЛЯ ВСЕХ ВЫЧИСЛИТЕЛЬНЫХ СИСТЕМ

Слайд 6Архитектура фон Неймана

Главные составляющие архитектуры фон-Неймана:

Арифметико-логическое устройство (АЛУ) выполняет самые важные операции:

Архитектура фон Неймана

Главные составляющие архитектуры фон-Неймана:

Арифметико-логическое устройство (АЛУ) выполняет самые важные операции:

Устройство ввода/вывода (ВВ), управляет потоком внешних, относительно машины, данных.

Память

Устройство управления (УУ), через которое идет обмен данными между ВВ, памятью и АЛУ.

Аккумулятор АЛУ – внутренний регистр для загрузки данных из памяти

По факту – практически все вычислительные системы в том или ином виде имеют в своем составе эти элементы.

Принцип однородности памяти – еще

один принцип архитектуры фон-Неймана

Машины фон-Неймана хранят

программу и данные в одной и той же

области памяти.

Распознать их можно только по

способу использования.

Команды программы содержат

указание, что выполнить, и адрес

данных, подлежащих обработке.

Слайд 7Гарвардская архитектура

Основные принципы разработаны в конце 30х

в США Говардом Эйкеном в

Гарвардская архитектура

Основные принципы разработаны в конце 30х

в США Говардом Эйкеном в

ЭВМ для военно-морской артиллерии.

Гарвардская машина, как и фон-неймановская, имеет

АЛУ, память и устройство ВВ.

Принципы двоичного кодирования, программного

управления и адресного доступа к памяти – те же, что у фон Неймана.

ОТЛИЧИЕ: Память программ и память данных физически разделены и используют разделенные линии передачи.

Это позволяет подобной машине пересылать команды и данные одновременно, значительно увеличивая производительность.

В этом состоит преимущество данной системы по сравнению с фон-Неймановской, в которой из-за того, что память программ и память данных не могут быть доступны в одно и то же время, пропускная способность является значительно меньшей, чем скорость, с которой процессор может работать.

Расплатой за высокую скорость является бόльшая сложность и соответственно более высокая цена процессора.

Первый компьютер на этой основе – MAPK 1 (1937-1944) вес 5т, 1я в мире программно-управляемая машина.

Первый компьютер в СССР – ВЦ-1 МО (1958) – тоже на базе гарвардской архитектура

Слайд 8Уровни архитектуры компьютера

Уровень физических устройств – элементная база.

Цифровой логический уровень. Вентили (логические

Уровни архитектуры компьютера

Уровень физических устройств – элементная база.

Цифровой логический уровень. Вентили (логические

схемы) – простейшие цифровые устройства для

логических операций, регистров памяти и др.

Уровень микроархитектуры. Наборы вентилей,

формирующие локальную память, АЛУ и др.

Уровень машинных инструкций. Аппаратная реализация (непосредственное выполнение или микропрограммная реализация)

Уровень операционной системы (ОС). Изначально назначением ОС была интерпретация команд оператора в набор машинных инструкций (отсюда и название). В дальнейшем функции ОС существенно расширились и усложнились. В современном понимании ОС – комплекс взаимосвязанных программ для управления ресурсами компьютера и организации взаимодействия с пользователем (управление аппаратными средствами, работа с файлами, выполнение прикладных программ, ввод\вывод данных и др.). ОС — первый и основной набор программ, загружающийся в компьютер.

Уровень ассемблера

Уровень прикладных программ (язык высокого и сверхвысокого уровня)

Слайд 9Поколения ЭВМ (элементная база)

Первое поколение – электронные лампы (1945-1955)

Второе поколение – транзисторы

Поколения ЭВМ (элементная база)

Первое поколение – электронные лампы (1945-1955)

Второе поколение – транзисторы

Третье поколение – интегральные схемы (1965-1980)

Четвертое поколение – БИС (1980-сейчас) – широкий спектр архитектур (от ПК до суперкомпьютеров и ГРИД). В основе – все те же принципы фон Неймана, только АЛУ и УУ размещаются на одном кристалле микропроцессора.

Пятое поколение – что далее?

технологии искусственного интеллекта?

«невидимые» компьютеры и всепроникающая компьютеризация – внедрение микро-компьютеров в состав разных устройств во всех сферах деятельности человека

квантовый компьютинг? Биотехнологии?

Слайд 10ТИПЫ СОВРЕМЕННЫХ КОМПЬЮТЕРОВ

Одноразовые (безбатарейные) микросхемы – проигрывание мелодий на поздравительных открытках, маркирование

ТИПЫ СОВРЕМЕННЫХ КОМПЬЮТЕРОВ

Одноразовые (безбатарейные) микросхемы – проигрывание мелодий на поздравительных открытках, маркирование

Встроенные компьютеры – выполняют функции управления устройствами и организации пользовательских интерфейсов (часы, машины, бытовая техника и т.п.)

Мобильные и игровые компьютеры, смартфоны.

Персональные компьютеры и ноутбуки

Сетевые серверы

Кластеры

Мэйнфреймы, суперкомпьютеры

Распределенные вычислительные системы (ГРИД, облака и т.п.)

высокопроизводительные

системы

Слайд 11Зачем и где нужны мощные ЭВМ

Автомобилестроение (а также самолеты и космические аппараты

Зачем и где нужны мощные ЭВМ

Автомобилестроение (а также самолеты и космические аппараты

Нефте- и газодобыча

Фармакология, биология, биофизика, биохимия

Сейсморазведка, метеорология, климатология

Синтез новых материалов, химия, нанотехнологии

Обработка эксп. данных в ядерной физике и физике частиц

Климатология. Современные модели описываются системами трехмерных нелинейных уравнений в частных производных, решения которой должны воспроизводить все важные характеристики ансамбля состояний реальной климатической системы. Нет возможности поставить реальный эксперимент, т.е. высокие требования к точности.

(1) Краш-тесты компании Ford: 4–60 млн.долл., 10–150 образцов новых моделей. Компьютерное моделирование сократило расходы на треть.

(2) Благодаря компьютерному моделированию (Cray) были найдены слабые точки кузова Nissan Maxima и наиболее эффективные способы их удаления. Корпус в результате удалось сделать на 10% прочнее.

(3) Компания Дюпон: искали замену хлорофлюорокарбону. За неделю провели расчеты (5тыс.долл.), нашли материал с теми же свойствами, но нейтральный к озону (сэкономили 3 месяца и 50 тыс. долларов).

Слайд 12Еще примеры

Моделирование взрывов атомной бомбы

после запрета реальных испытаний

Расчет аэродинмаики болидов

Еще примеры

Моделирование взрывов атомной бомбы

после запрета реальных испытаний

Расчет аэродинмаики болидов

BMW – суперкомпьютер 12 Тфлопс для моделирования работы аэродинамической трубы для виртуальных испытаний

Audi – суперкомпьютер 39 Тфлопс для моделирования столкновений с препятствиями.

Pratt&Whitney – 3D-модель авиадвигателя, 350 Тфлопс. Подтверждена безопасность самолета SuperJett-100 при аварийной посадке без выпущенных шасси.

Экзафлопный проект (США) – модель «всего самолета», «всей АЭС» и т.п.

Экзафлопс – 1018 операций с плавающей точкой в сек.

Петафлопс – 1015

Терафлопс – 1012

Итак, необходимость мощных вычислений очевидна, поэтому развитие идет быстрыми темпами, несмотря на огромные финансовые затраты.

Слайд 13Суперкомпьютеры (1)

Главные аспекты:

Высокопроизводительные вычислительные системы

Программные технологии параллельной обработки данных

Параллельные алгоритмы

Что такое суперкомпьютеры

Быстрое

Суперкомпьютеры (1)

Главные аспекты:

Высокопроизводительные вычислительные системы

Программные технологии параллельной обработки данных

Параллельные алгоритмы

Что такое суперкомпьютеры

Быстрое

Оксфордский толковый словарь по вычислительной технике (1986): суперкомпьютер – очень мощная ЭВМ с производительностью свыше 10 Mflops. Сегодня этот результат перекрывают ПК.

В начале 90х границу провели у отметки 300 Mflops. В 1996 планку подняли до 5 Gflops. Так, компьютер занимавший в ноябре 2011 500е место в Тop500, имеет производительность 96.4 Tflop\s, 1е место – 11280 Tflop\s.

Ироничное определение дал Кен Батчер (Ken Batcher):

суперкомпьютер – устройство, сводящее проблему вычислений к проблеме ввода/вывода.

Слайд 14Суперкомпьютеры (2)

Основные признаки, характеризующие суперЭВМ

Высокое на текущий момент времени быстродействие;

Самый современный

Суперкомпьютеры (2)

Основные признаки, характеризующие суперЭВМ

Высокое на текущий момент времени быстродействие;

Самый современный

Специфические архитектурные решения, направленные на повышение быстродействия

Цена

Максимальный объем оперативной и дисковой памяти

Эмпирический закон Мура – количество транзисторов в одной микросхеме удваивается каждые 18 мес ⇒ растет быстродействие и объем памяти

Ускорение идет (1) за счет увеличения тактовой частоты, (2) за счет использования идей параллелизма в архитектуре ЭВМ.

Действительно, за полвека производительность выросла более чем в 700млн раз, в то время как выигрыш в быстродействии за счет уменьшения времени такта составил лишь 1000 раз. Остальное – за счет использования новых решений в архитектуре компьютеров на основе параллельной обработки данных и совмещения операций.

В современных процессорах 200 и более микрокоманд могут выполняться одновременно в каждом ядре многоядерного процессора.

Таким образом, два основных пути развития: технологический

развитие элементной базы предел!

использование новых решений в архитектуре компьютеров

ЗАКОН

МУРА

Слайд 15Наращивание производительности

современных вычислительных систем происходит главным образом за счет широкого применения

Наращивание производительности

современных вычислительных систем происходит главным образом за счет широкого применения

Вычислительные ресурсы для параллельных вычислений:

одиночный компьютер с несколькими процессорами (ядрами);

произвольное число компьютеров, соединенных компьютерной сетью;

комбинация обоих вариантов.

Использование ускорителей (в том числе ГПУ)

Вычислительная задача должна:

разбиваться на дискретные части, которые могут вычисляться независимо;

исполнять несколько инструкций в любой момент времени;

решаться за меньшее время при использовании нескольких вычислительных ресурсов.

Слайд 16ДИНАМИКА РОСТА ТАКТОВЫХ ЧАСТОТ

Год Тактовая частота Процессор

2004 3.46 GHz Intel Pentium 4

2005 3.8 GHz Intel Pentium

ДИНАМИКА РОСТА ТАКТОВЫХ ЧАСТОТ

Год Тактовая частота Процессор

2004 3.46 GHz Intel Pentium 4

2005 3.8 GHz Intel Pentium

2006 2.333 GHz Core Duo T2700

2007 3 GHz Core2 Duo E6800

2008 3.33 GHz Core2 Duo E8600

2009 3.06 GHz Core i7 950

2010 3.6 GHz Core i5

3.9 Ghz Core i7 Extreme

При этом закон Мура продолжает выполняться:

Производительность удваивается каждые 18 месяцев!

Правда, после 2015го наметилась некоторая тенденция к «насыщению»

Слайд 17TOP500 List – November 2017

260-ядерные процессоры: управляющее ядро + 4 64-ядерных кластера

TOP500 List – November 2017

260-ядерные процессоры: управляющее ядро + 4 64-ядерных кластера

Со-процессоры Intel Xeon Phi для ускорения вычислений

GPU-процессоры NVIDIA для ускорения вычислений

Russia: positions 63, 227, 412

Слайд 18Современные высокопроизводительные системы

Особенности современных суперкомпьютерных систем:

Многоядерность

Гетерогенность

Сверхплотная компоновка

Внутрипроцессорнный параллелизм

Со-процессоры для ускорения

Современные высокопроизводительные системы

Особенности современных суперкомпьютерных систем:

Многоядерность

Гетерогенность

Сверхплотная компоновка

Внутрипроцессорнный параллелизм

Со-процессоры для ускорения

Современные высокопроизводительные системы:

Суперкомпьютеры

Метакомпьютинговые системы ( GRID, Cloud )

Широкое использование параллелизма

Объединение огромного числа вычислительных узлов (процессоров, ядер, потоков, компьютеров) для одновременной обработки данных

- мультипроцессинг

- мультикомпьютинг

Архитектурные решения для совмещения операций внутри процессоров (конвейерность выполнения машинных команд, суперскалярность, VLIW, hyperthreading)

Слайд 19Параллельная обработка данных (1)

Параллельная обработка данных обычно подразделяется на собственно параллельную и

Параллельная обработка данных (1)

Параллельная обработка данных обычно подразделяется на собственно параллельную и

Параллельная обработка данных – объединение нескольких однотипных независимых устройств, способных выполнять одну и ту же работу. Одно устройство выполнит 100 операций за время Т, 5 устройств – за время Т/5, т.е. в 5 раз быстрее.

Аналогии из жизни: один человек вскопает огород за 10 часов, а бригада 50 человек с такими же способностями, работая одновременно, справятся с той же работой за 12 мин.

Контрпример: землекопы копают яму. Пока их немного, время работы уменьшается пропорционально числу людей. НО(!) избыточность людей замедляет процесс.

Конвейерная обработка данных – идея заключается в выделении отдельных этапов выполнения общей операции, причем каждый этап, выполнив свою работу, передает результат следующему, одновременно принимая новую порцию входных данных для обработки от предыдущего.

Выигрыш в скорости обработки получаем за счет совмещения прежде разнесенных во времени операций. Пример – автомобильный конвейер.

Пусть в операции можно выделить 5 последовательных микроопераций, каждая выполняется за 1сек. Одно неделимое последовательное устройство 100 операций выполнит за 500 сек.

Слайд 20Параллельная обработка данных (2)

Если же каждую микрооперацию выделить в отдельный этап (ступень)

Параллельная обработка данных (2)

Если же каждую микрооперацию выделить в отдельный этап (ступень)

В общем случае – n операций будут выполнены на L-ступенчатом конвейере за L+n-1 тактов (единиц времени), а последовательно – за L*n единиц времени.

Казалось бы, конвейерную обработку можно заменить обычным параллелизмом, продублировав основное устройство столько раз, сколько ступеней конвейера предполагается выделить. Действительно, 5 неделимых устройств из нашего примера обработают выполнят 100 операций за 100 сек, чуть быстрее конвейерного устройства.

Однако! Увеличив в 5 раз число устройств, мы значительно увеличиваем объем и стоимость аппаратуры. Представим, что на автозаводе решили убрать конвейер, сохранив темпы выпуска автомобилей. Если раньше на конвейере одновременно находилась 1000 автомобилей, то по аналогии с предыдущим примером надо набрать 1000 бригад, каждая из которых (1) в состоянии полностью собрать автомобиль от начала до конца, выполнив сотни разного рода операций, и (2) сделать это за то же время, что машина прежде находилась на конвейере. Можно представили себе – насколько велика стоимость такого автомобиля.

Слайд 21Краткая история параллелизма (1)

Идеи параллелизма появились очень давно. Самарский в начале 50х

Краткая история параллелизма (1)

Идеи параллелизма появились очень давно. Самарский в начале 50х

Изначально элементы параллелизма внедрялись в передовых, единичных компьютерах. Затем технологии спускались в компьютеры среднего класса, а потом становились стандартом для ЭВМ, включая РС и ПК.

IBM 701 (1953), IBM 704 (1955): разрядно-параллельная память, разрядно-параллельная арифметика.

Первые компьютеры имели разрядно-последовательную память, слова считывались бит за битом. IBM701 - первый коммерчески доступный компьютер, использующий разрядно-параллельную память и разрядно-параллельную арифметику. Наибольшую популярность получила модель IBM704 (продано 150 экз., впервые применена память на ферритовых сердечниках и аппаратное АУ с плавающей точкой).

IBM 709 (1958): независимые процессоры ввода/вывода.

Процессоры первых компьютеров сами управляли вводом/выводом. Так как скорость самого быстрого внешнего устройства (тогда магнитная лента) в 1000 раз < скорости процессора, то во время ввода/вывода процессор простаивал. Модель IBM709: к IBM704 присоединили 6 независимых процессоров ввода/вывода, которые могли работать параллельно с основным процессором. Модель получилась очень удачной, продано 400 экз., последний выключен аж в 1975 (20 лет!)

Слайд 22Краткая история параллелизма (2)

IBM STRETCH (1961): опережающий просмотр команд, расслоение памяти. В

Краткая история параллелизма (2)

IBM STRETCH (1961): опережающий просмотр команд, расслоение памяти. В

(1) опережающий просмотр для считывания команд, вычисления адресов и выборки операндов; т.е. совмещение различных этапов выполнения нескольких команд

(2) расслоение памяти на два банка для согласования низкой скорости выборки из памяти и более высокой скорости выполнения операций. Каждый банк независимо может передавать данные а АЛУ. Прообраз современной иерархии памяти

ATLAS (1963): конвейер команд. Разработка университета Манчестера.

Впервые использован конвейерный принцип, выполнение команд разбито на 4 стадии: выборка команды, вычисление адреса операнда, выборка операнда и выполнение операции. Это позволило уменьшить время выполнения команд с 6мкс до 1.6мкс. (2тыс оп\сек!). ATLAS оказал огромное влияние и на ПО: впервые использована мультипрограммная ОС на базе использования виртуальной памяти и системы прерываний.

CDC 6600 (1964): независимые функциональные устройства.

Фирма Control Data Corporation (CDC), основанная Сеймуром Р. Крэем (Seymour R. Cray) выпускает первый компьютер, в котором использовано 10 независимых ФУ с производительностью 2-3 млн. оп\сек. Впервые параллелизм в явном виде! Машина имела громадный успех на научном рынке, активно вытесняя машины фирмы IBM.

Слайд 23Краткая история параллелизма (3)

CDC 7600 (1969) конвейерные независимые ФУ.

Восемь независимых конвейерных ФУ

Краткая история параллелизма (3)

CDC 7600 (1969) конвейерные независимые ФУ.

Восемь независимых конвейерных ФУ

ILLIAC IV (1974): матричные процессоры.

Ключевая идея – матрица синхронно работающих процессоров. Проект - 256 процессорных элементов (ПЭ) = 4 квадранта по 64ПЭ, возможность реконфигурации: 2 квадранта по 128ПЭ или 1 квадрант из 256ПЭ, такт 40нс, производительность 1Гфлоп.

Реальность - работы начаты в 1967, к концу 1971 изготовлен 1 квадрант, в 1974 введен в эксплуатацию, доводка велась до 1975; центральная часть системы: устройство управления (УУ) + матрица 64ПЭ. Работал до 1982, затем был сдан в музей.

УУ – простая ЭВМ с небольшой производительностью, управляющая матрицей ПЭ; все ПЭ работают в синхронном режиме, выполняя в каждый момент времени одну и ту же команду, поступившую от УУ, но над своими данными. Каждый ПЭ имел собственное АЛУ с полным набором команд, каждый ПЭ имел доступ только к своей ОП.

Стоимость в 4 раза выше, чем в проекте, сделан лишь 1 квадрант, такт 80нс, реальная производительность 50Мфлоп. Проект опередил свое время, но оказал огромное влияние на архитектуру последующих ЭВМ.

IVTRAN: Идеи параллельных компилляторов.

Стрела, СССР, 60е – «групповые операции» - прообраз векторных ФУ.

Слайд 24Краткая история параллелизма (4)

CRAY 1 (1976): векторно-конвейерные процессоры – классика жанра

В 1972

Краткая история параллелизма (4)

CRAY 1 (1976): векторно-конвейерные процессоры – классика жанра

В 1972

Главное новшество – введение векторных команд, работающих с целыми массивами независимых данных и позволяющих эффективно использовать векторно-конвейерные ФУ.

Более 10 лет ВК суперкомпьютеры Cray занимали лидирующие позиции в производстве суперЭВМ.

К началу 2000х выявились три направления в архитектуре суперЭВМ.

(1) Векторно-конвейрные компьютеры.

Конвейерные ФУ & векторных команд. В отличие от традиционного подхода, векторные команды оперируют целыми массивами независимых данных, что позволяет эффективно загружать доступные конвейеры. → SSE, графические процессоры

Плюс: векторизацию осуществляет компилятор, т.е. не нужна специальная технология распараллеливания; высокая производительность

Минус: высокая себестоимость векторных ФУ.

(2) Массивно-параллельные компьютеры с распределенной памятью.

ПЭ снабжены каждый своей локальной памятью и соединены между собой посредством некоей коммуникационной среды (матрица).

Слайд 25Краткая история параллелизма (5)

Плюс: простота архитектуры, дешевизна, легко подобрать оптимальную конфигурацию по

Краткая история параллелизма (5)

Плюс: простота архитектуры, дешевизна, легко подобрать оптимальную конфигурацию по

Минус: межпроцессорное взаимодействие намного медленнее, чем локальная обработка данных самими процессорами. Поэтому написать эффективную программу сложно. Пользователь должен сам организовывать обмен данными между процессорами с использованием специальных технологий.

(3) Параллельные компьютеры с общей памятью. Вся оперативная память компьютеров разделяется несколькими одинаковыми процессорами.

Плюс: Единое адресное пространство, т.е. легче программированть; нет проблемы межпроцессорного взаимодействия. → многоядерность

Минус: Ограничено по техническим причинам число процессоров.

Архитектура NUMA (ccNUMA) объединение преимуществ логически единого адресного пространства с масштабируемостью MPP-систем.

Конец 80х – начало 90х: прогресс микроэлектроники и коммуникационных технологий привел к размыванию граней между суперкомпьютерами и компьютерами серийного производства.

Напоминаем: Суперкомпьютер – мелкосерийная (штучная) вычислительная установка, многократно превосходящая по вычислительной мощности массово выпускаемые компьютеры, т.е.

Не «ширпотреб»;

Ориентация на снижение времени расчета «больших задач».

Слайд 26Краткая история параллелизма (6)

80е: массовое производство однокристальных микропроцессоров → всеохватывающее распространение ПК.

1989:

Краткая история параллелизма (6)

80е: массовое производство однокристальных микропроцессоров → всеохватывающее распространение ПК.

1989:

90е: Бурное развитие Ethernet, Fast Ethernet и других высокоскоростных коммуникационных технологий привели к удешевлению ЭВМ с распределенной памятью, к повышению их эффективности за счет сокращения времени взаимодействия.

Кластеры выделенных рабочих станций. Кластер – связанный набор полноценных компьютеров, используемый в качестве единого ресурса. Кластеры строятся на базе объединения серийных микропроцессоров с помощью серийных коммуникационных технологий и с использованием стандартных ОС (главным образом, UNIX\LINUX) и стандартизованных систем управления ресурсами. В настоящее время все суперкомпьютеры списка Тор500 построены на базе кластерных технологий, а также гибридных архитектур

Метакомпьютинг – объединение разнородных, пространственно распределенных вычислительных ресурсов в единую вычислитель-ную инфраструктуру. (ГРИД, Интернет-компьютинг)

ГРИД – среда, объединяющая находящиеся в разных местах глобальной телекоммуникационной сети вычислительные установки и предназначенная для выполнения распределенных приложений на этих установках.

Решение задач

Решение задач Компьютерная арифметика

Компьютерная арифметика Практикум: Составление блок-схем алгоритмов линейной структуры

Практикум: Составление блок-схем алгоритмов линейной структуры Пэкмен. Обзор на Скайрим

Пэкмен. Обзор на Скайрим Разборы задач №1 - НОК, математика

Разборы задач №1 - НОК, математика Программные среды компьютерной графики. Лекция 08-2

Программные среды компьютерной графики. Лекция 08-2 Информация и её свойства. Информация и информационные процессы

Информация и её свойства. Информация и информационные процессы Дизайн приложения

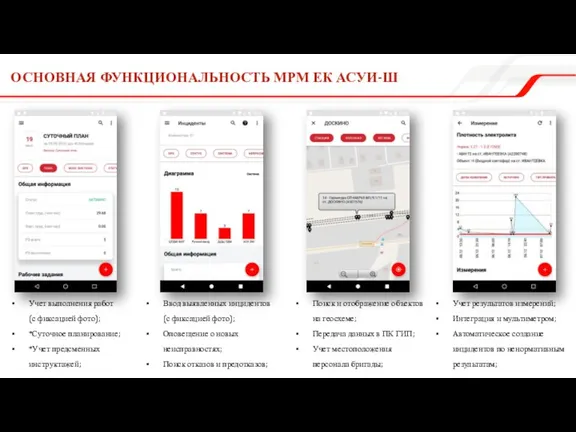

Дизайн приложения Основная функциональность МРМ ЕК АСУИ-Ш

Основная функциональность МРМ ЕК АСУИ-Ш Системы Geograph. GeoDraw — система для создания цифровых карт

Системы Geograph. GeoDraw — система для создания цифровых карт Pointers in C++

Pointers in C++ Qr коды. Задания

Qr коды. Задания OpenFOAM. Открытая интегрируемая платформа для численного моделирования задач механики сплошных сред

OpenFOAM. Открытая интегрируемая платформа для численного моделирования задач механики сплошных сред Графические возможности текстового редактора

Графические возможности текстового редактора Тестирование ПО. Уровень 1. Тестировщик программного обеспечения

Тестирование ПО. Уровень 1. Тестировщик программного обеспечения Создание компьютерной игры

Создание компьютерной игры Основы Си

Основы Си Английские сокращения в Интернет-переписке

Английские сокращения в Интернет-переписке Adobe Photoshop

Adobe Photoshop Кодирование данных и структуры данных

Кодирование данных и структуры данных Введение в профессиональную деятельность

Введение в профессиональную деятельность Презентация "Информационная безопасность" - скачать презентации по Информатике

Презентация "Информационная безопасность" - скачать презентации по Информатике РЖД пассажирам. Расширение функционала

РЖД пассажирам. Расширение функционала Твиттерские – молодежная субкультура, появившаяся в социальной сети Твиттер

Твиттерские – молодежная субкультура, появившаяся в социальной сети Твиттер Иетернет - уроки

Иетернет - уроки Применение технологий информационного моделирования в службе ПТО

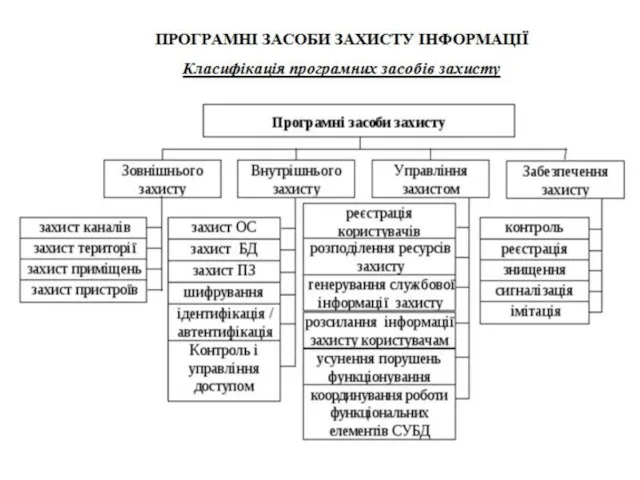

Применение технологий информационного моделирования в службе ПТО Програмні засоби захисту інформації

Програмні засоби захисту інформації лекция 5

лекция 5