Содержание

- 2. План презентации Apache Spark обзор Как работает Spark RDD Трансформация и действие Структура задания Spark ©2020

- 3. ©2020 «Неофлекс». Все права защищены 3 Краткая история Spark

- 4. ©2020 «Неофлекс». Все права защищены 3 Что такое Apache Spark Apache Spark – это BigData фреймворк

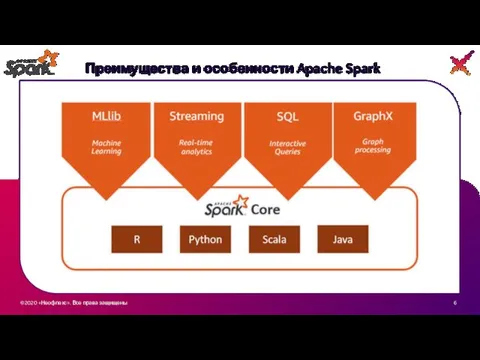

- 5. ©2020 «Неофлекс». Все права защищены 3 Преимущества и особенности Apache Spark Spark — всё-в-одном для работы

- 6. ©2020 «Неофлекс». Все права защищены 3 Преимущества и особенности Apache Spark

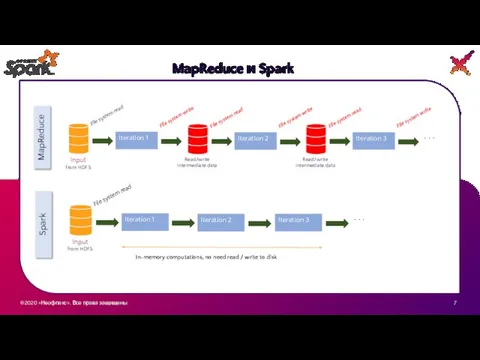

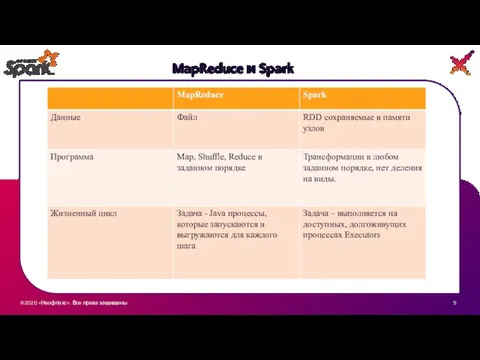

- 7. ©2020 «Неофлекс». Все права защищены 3 MapReduce и Spark

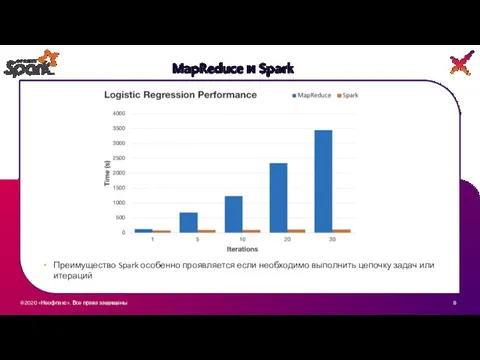

- 8. ©2020 «Неофлекс». Все права защищены 3 MapReduce и Spark Преимущество Spark особенно проявляется если необходимо выполнить

- 9. ©2020 «Неофлекс». Все права защищены 3 MapReduce и Spark

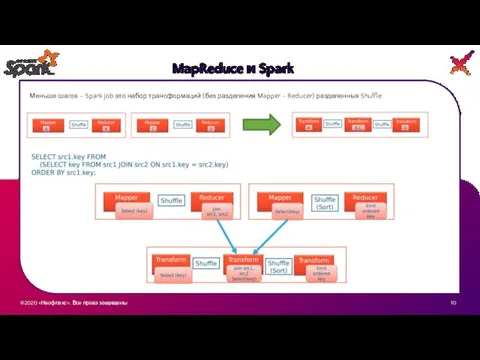

- 10. ©2020 «Неофлекс». Все права защищены 3 MapReduce и Spark Меньше шагов – Spark job это набор

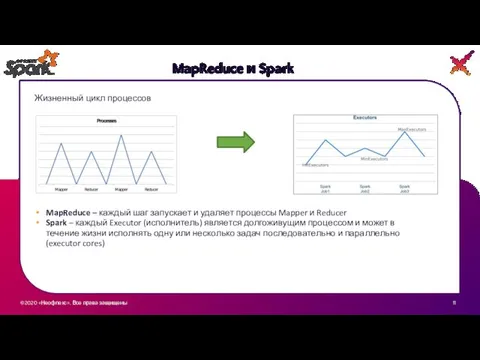

- 11. ©2020 «Неофлекс». Все права защищены 3 MapReduce и Spark Жизненный цикл процессов MapReduce – каждый шаг

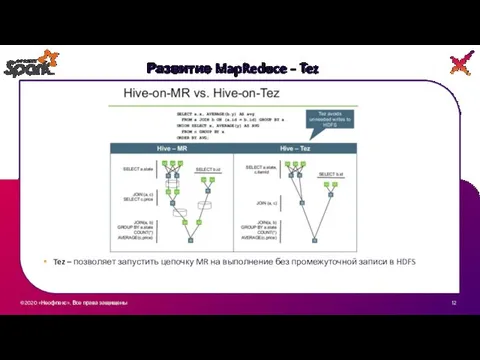

- 12. ©2020 «Неофлекс». Все права защищены 3 Развитие MapReduce - Tez Tez – позволяет запустить цепочку MR

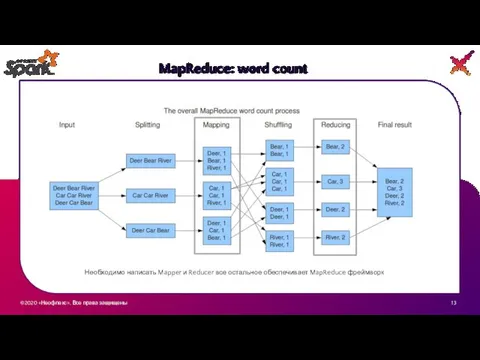

- 13. ©2020 «Неофлекс». Все права защищены 3 MapReduce: word count Необходимо написать Mapper и Reducer все остальное

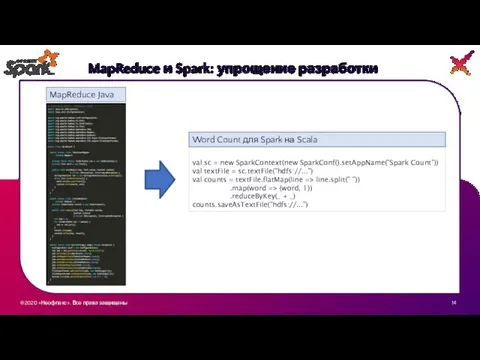

- 14. ©2020 «Неофлекс». Все права защищены 3 MapReduce и Spark: упрощение разработки MapReduce Java val sc =

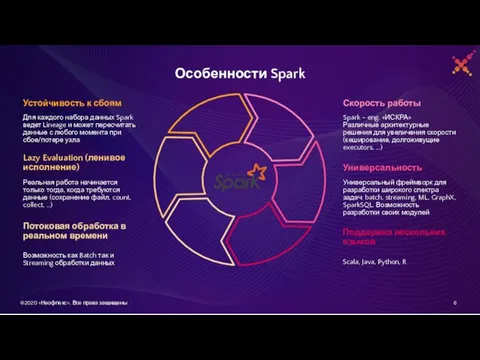

- 15. Особенности Spark Для каждого набора данных Spark ведет Lineage и может пересчитать данные с любого момента

- 16. Основные концепции Spark ©2020 «Неофлекс». Все права защищены 11

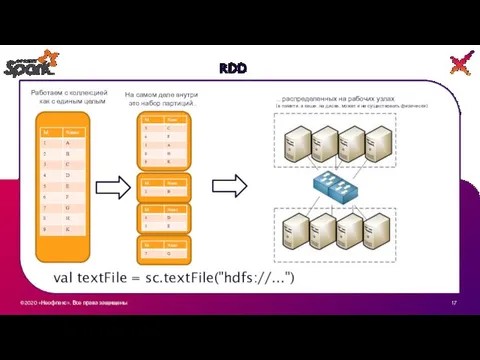

- 17. ©2020 «Неофлекс». Все права защищены 3 RDD На самом деле внутри это набор партиций… Работаем с

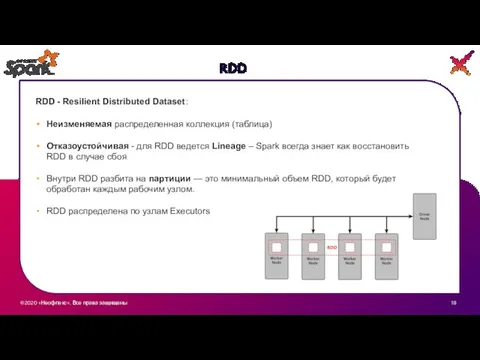

- 18. ©2020 «Неофлекс». Все права защищены 3 RDD RDD - Resilient Distributed Dataset: Неизменяемая распределенная коллекция (таблица)

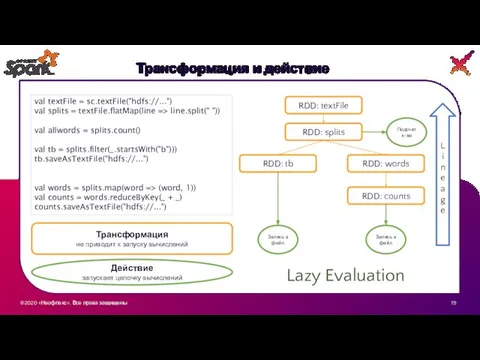

- 19. ©2020 «Неофлекс». Все права защищены 3 Трансформация и действие val textFile = sc.textFile("hdfs://...") val splits =

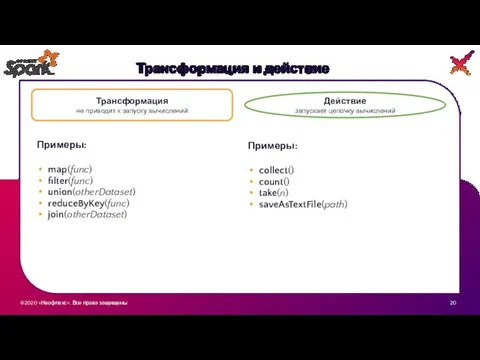

- 20. ©2020 «Неофлекс». Все права защищены 3 Трансформация и действие Трансформация не приводит к запуску вычислений Действие

- 21. Плюсы и минусы Lazy Evaluation Улучшает читаемость кода, можно разбивать на небольшие куски, потом все соберется

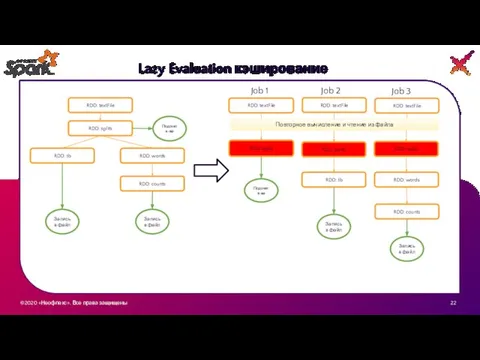

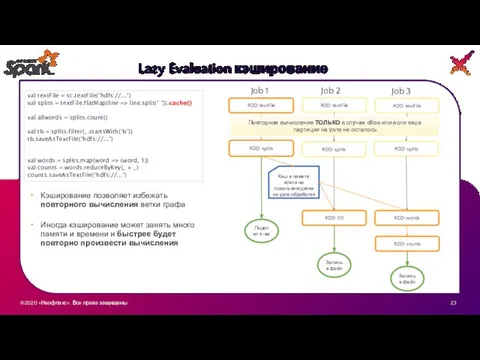

- 22. ©2020 «Неофлекс». Все права защищены 3 Lazy Evaluation кэширование RDD: textFile RDD: splits Подсчет к-ва RDD:

- 23. ©2020 «Неофлекс». Все права защищены 3 Lazy Evaluation кэширование RDD: textFile RDD: splits Подсчет к-ва RDD:

- 24. Как устроено приложение Spark ©2020 «Неофлекс». Все права защищены 11

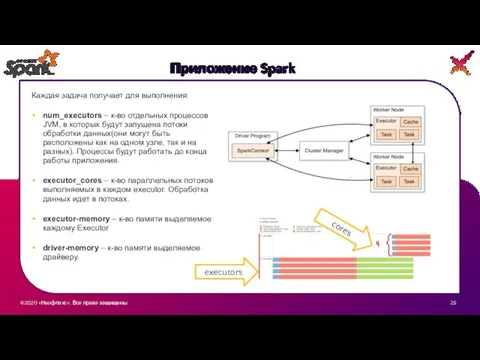

- 25. ©2020 «Неофлекс». Все права защищены 3 Приложение Spark executors cores Каждая задача получает для выполнения: num_executors

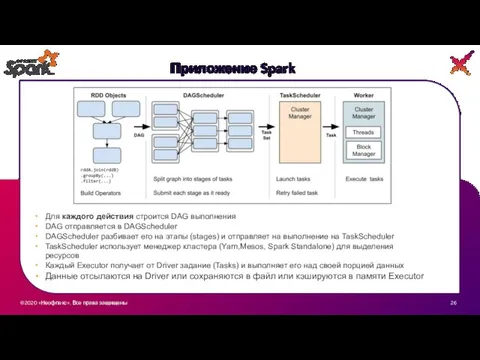

- 26. ©2020 «Неофлекс». Все права защищены 3 Приложение Spark Для каждого действия строится DAG выполнения DAG отправляется

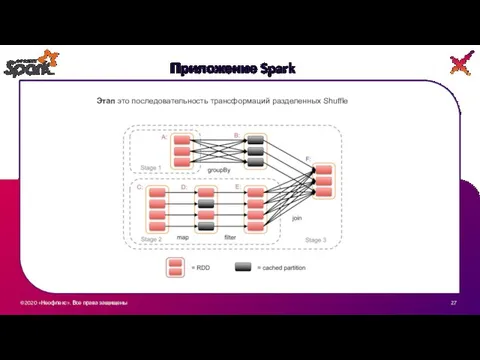

- 27. ©2020 «Неофлекс». Все права защищены 3 Приложение Spark Этап это последовательность трансформаций разделенных Shuffle

- 28. Звучит интересно, хочу попробовать !!! ©2020 «Неофлекс». Все права защищены 11

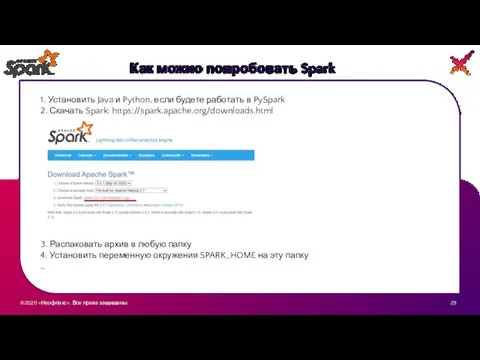

- 29. ©2020 «Неофлекс». Все права защищены 3 Как можно попробовать Spark 3. Распаковать архив в любую папку

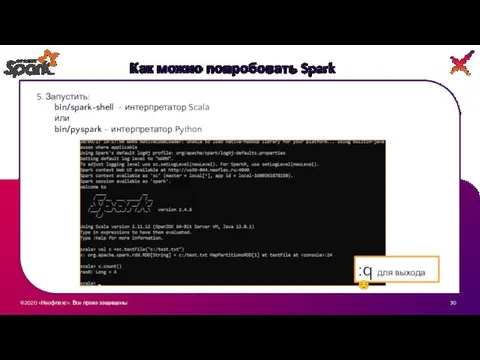

- 30. ©2020 «Неофлекс». Все права защищены 3 Как можно попробовать Spark 5. Запустить: bin/spark-shell - интерпретатор Scala

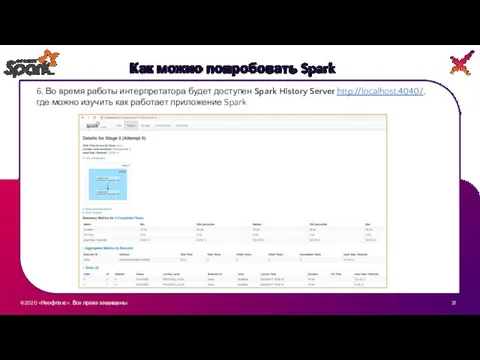

- 31. ©2020 «Неофлекс». Все права защищены 3 Как можно попробовать Spark 6. Во время работы интерпретатора будет

- 33. Скачать презентацию

Обучающие компьютерные игры

Обучающие компьютерные игры Построение проблемосодержащих и проблемо-разрешающих моделей для сложных систем

Построение проблемосодержащих и проблемо-разрешающих моделей для сложных систем Двоичная арихметика

Двоичная арихметика Организация вычислений в электронных таблицах обработка числовой информации в электронных таблицах

Организация вычислений в электронных таблицах обработка числовой информации в электронных таблицах Доработка вёрстки страницы о товаре

Доработка вёрстки страницы о товаре МК Осенний листопад

МК Осенний листопад Компьютер – универсальное устройство обработки информации

Компьютер – универсальное устройство обработки информации Пакет подготовки презентаций

Пакет подготовки презентаций Вычисления в электронных таблицах

Вычисления в электронных таблицах Программное обеспечение персонального компьютера

Программное обеспечение персонального компьютера Человек в цифровой среде (лекция 1)

Человек в цифровой среде (лекция 1) Особенности SQL применительно к СУБД MySQL

Особенности SQL применительно к СУБД MySQL I always come to work

I always come to work Презентация на тему Защита файлов и управление доступом к ним

Презентация на тему Защита файлов и управление доступом к ним  Руководство по оплате инвестиционных программ компании ICN Holding с использованием платежной системы Банка Авангард

Руководство по оплате инвестиционных программ компании ICN Holding с использованием платежной системы Банка Авангард Интернет

Интернет UML диаграммы

UML диаграммы Экстремизм в молодёжной среде. Безопасные сети

Экстремизм в молодёжной среде. Безопасные сети Виртуальный музей: от картинок до WebDoc’а

Виртуальный музей: от картинок до WebDoc’а Вася на Сене

Вася на Сене Wowstocks (логотип,кнопка homepage)

Wowstocks (логотип,кнопка homepage) Приключения Терентия в Интерляндии

Приключения Терентия в Интерляндии Правила техники безопасности при работе за компьютером

Правила техники безопасности при работе за компьютером Электронный документ и файл

Электронный документ и файл Вершинный шейдер. Графика в современных играх

Вершинный шейдер. Графика в современных играх Условные операторы

Условные операторы Основные информационные процессы и их реализация с помощью компьютера. Лекция 4

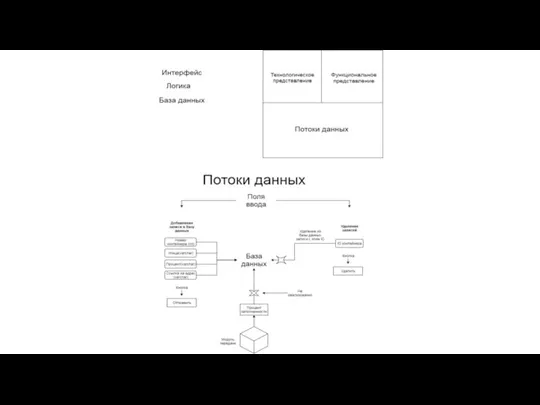

Основные информационные процессы и их реализация с помощью компьютера. Лекция 4 Потоки данных

Потоки данных