Содержание

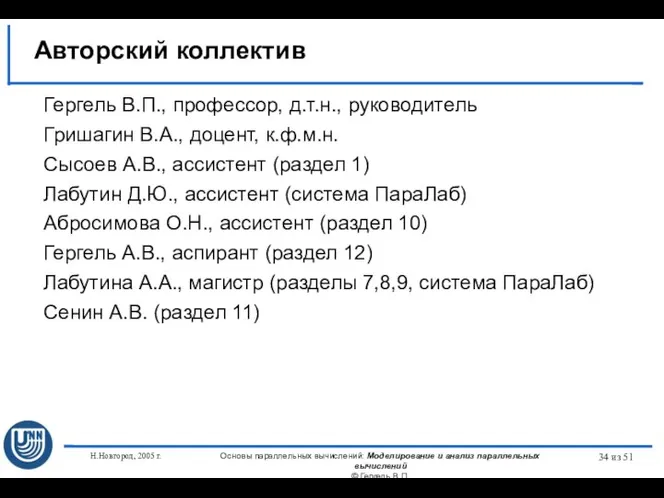

- 2. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 3. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 4. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 5. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

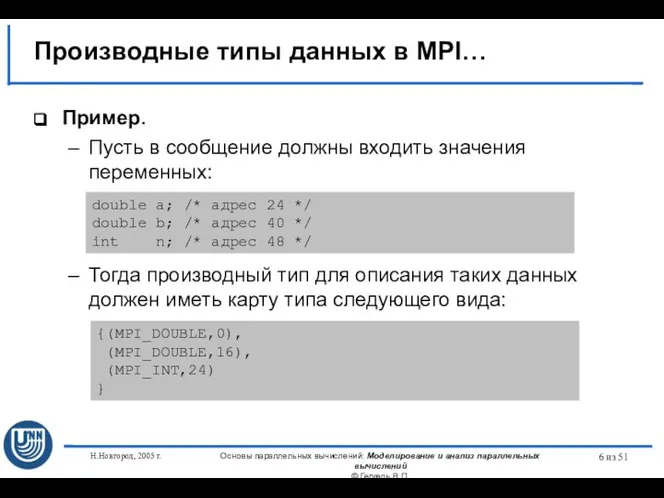

- 6. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

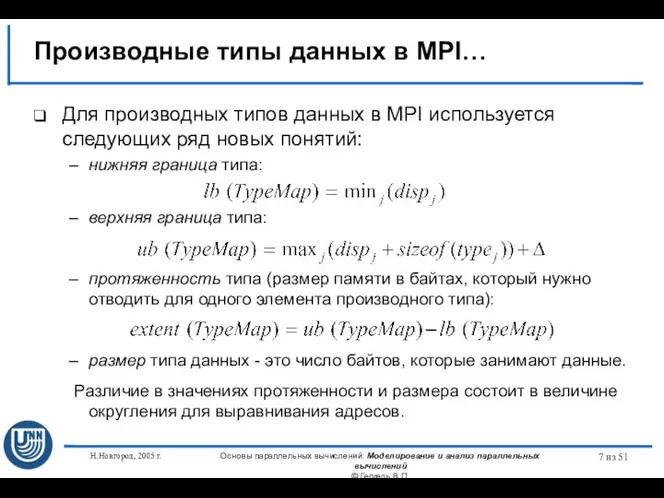

- 7. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

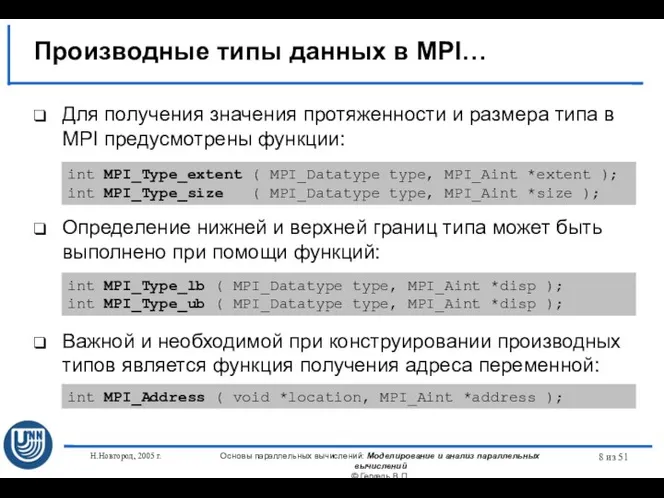

- 8. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

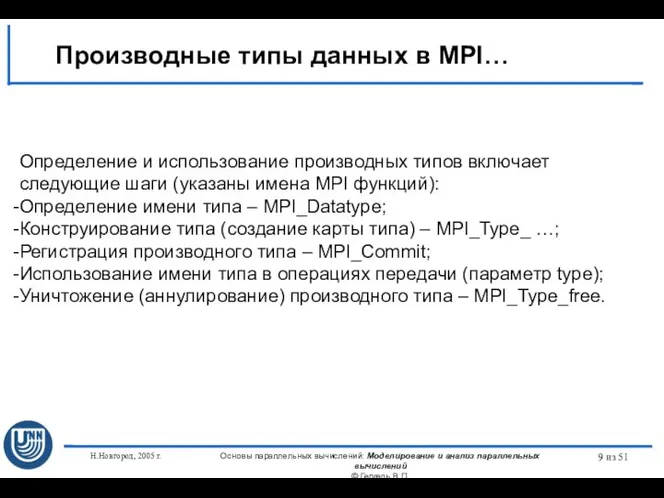

- 9. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 10. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 11. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

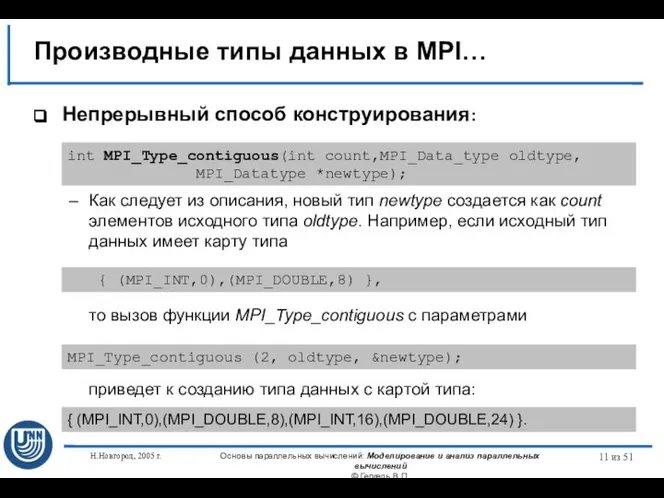

- 12. Графическая интерпретация работы конструктора MPI_Type_contiguous

- 13. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

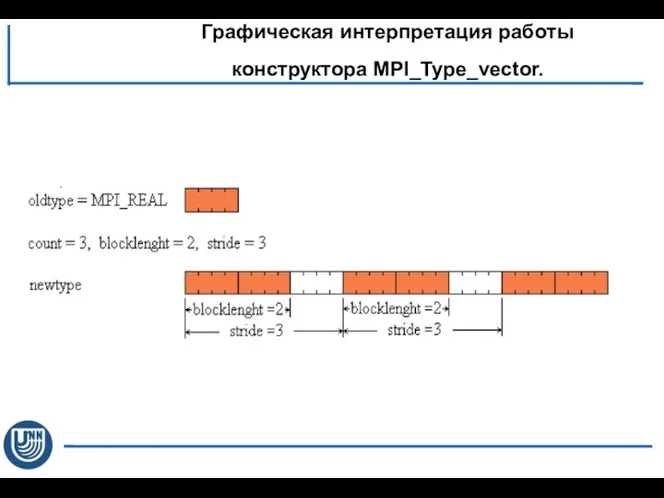

- 14. Графическая интерпретация работы конструктора MPI_Type_vector.

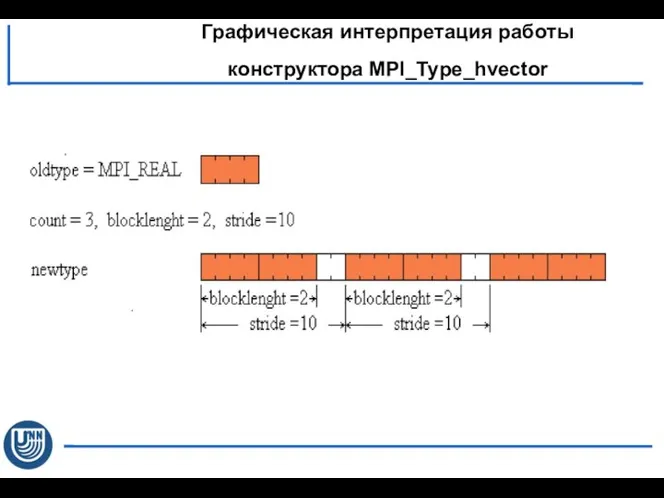

- 15. Графическая интерпретация работы конструктора MPI_Type_hvector

- 16. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 17. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

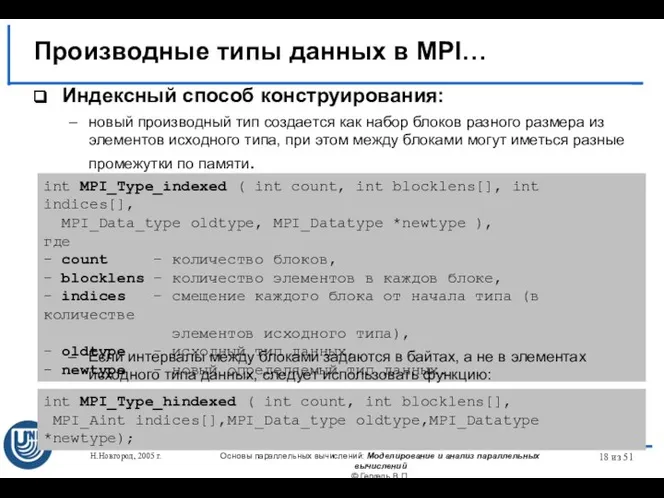

- 18. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

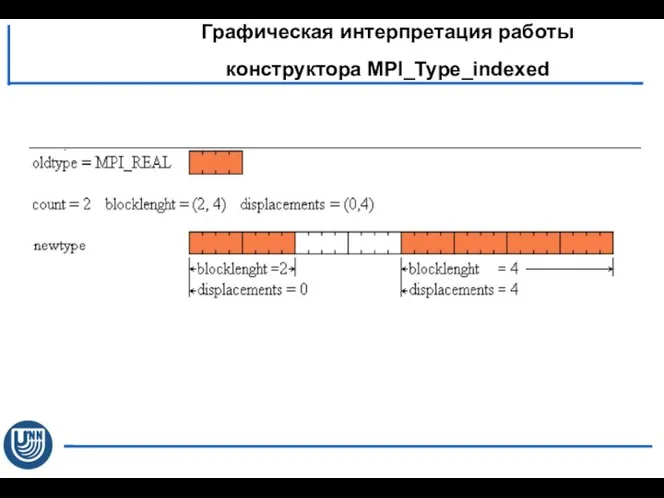

- 19. Графическая интерпретация работы конструктора MPI_Type_indexed

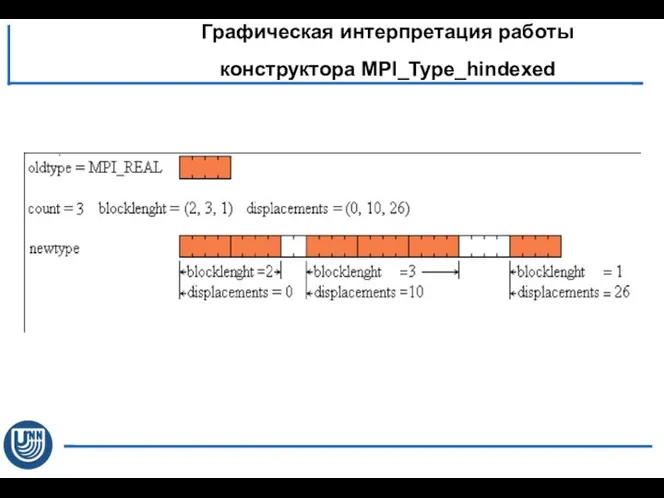

- 20. Графическая интерпретация работы конструктора MPI_Type_hindexed

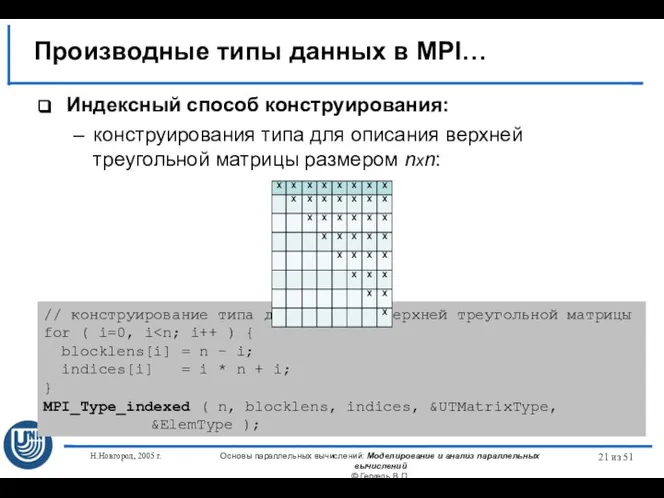

- 21. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

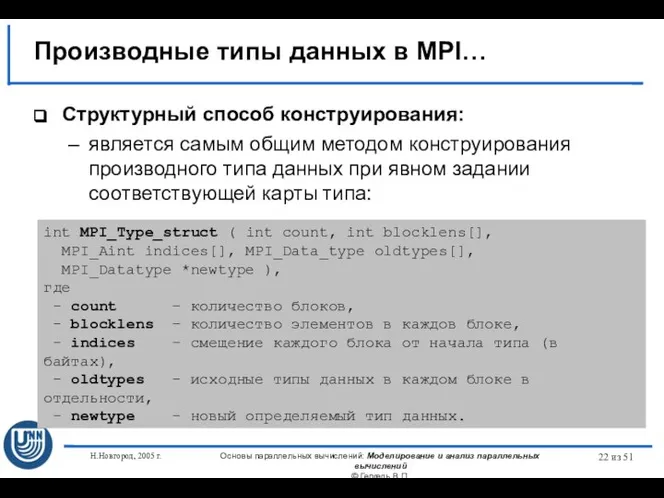

- 22. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

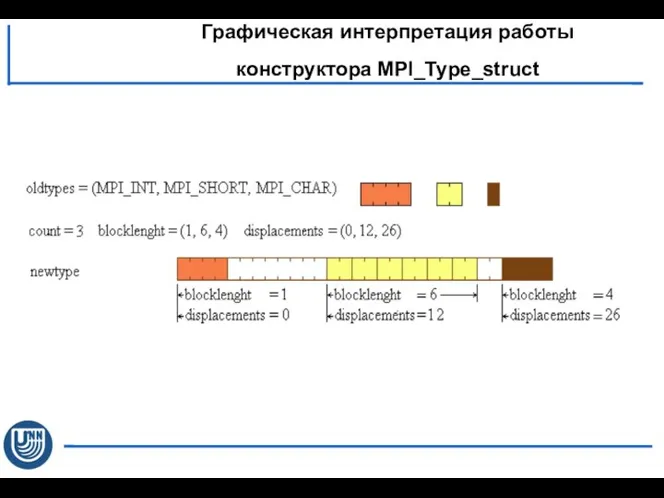

- 23. Графическая интерпретация работы конструктора MPI_Type_struct

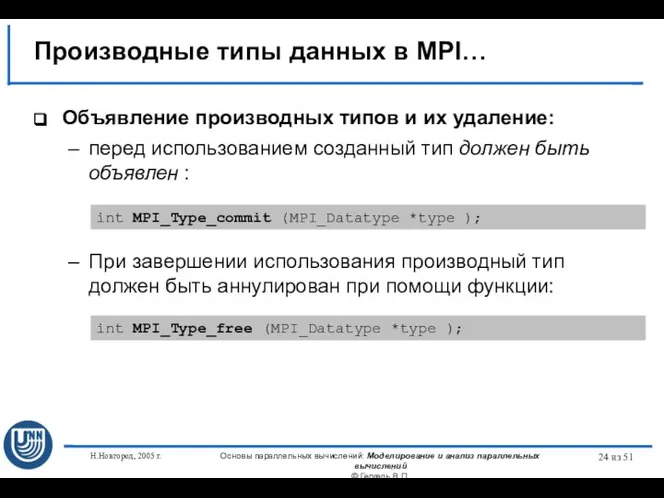

- 24. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 25. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 26. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 27. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 28. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 29. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 30. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 31. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 32. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 33. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 34. Н.Новгород, 2005 г. Основы параллельных вычислений: Моделирование и анализ параллельных вычислений © Гергель В.П. из 51

- 36. Скачать презентацию

проектирование ис 2016 03

проектирование ис 2016 03 Источники информации в проектной деятельности

Источники информации в проектной деятельности Интерактивные визуальные коммуникации.Genially

Интерактивные визуальные коммуникации.Genially Исходная концептуальная схема обеспечения ИБ

Исходная концептуальная схема обеспечения ИБ Презентация на тему Возможности использования компьютерной техники в офисах фирм

Презентация на тему Возможности использования компьютерной техники в офисах фирм  Условный оператор, оператор выбора. Процедуры вводы-вывода. Логические операции в Паскале, таблицы истинности. Лекция 5

Условный оператор, оператор выбора. Процедуры вводы-вывода. Логические операции в Паскале, таблицы истинности. Лекция 5 Режим анализ ZEMAX

Режим анализ ZEMAX HTML (HyperText Markup Language, язык разметки гипертекста)

HTML (HyperText Markup Language, язык разметки гипертекста) Разгони свой сайт. Кэширование

Разгони свой сайт. Кэширование Позиционная система счисления

Позиционная система счисления Прикладные ПО для работы делопроизводителя

Прикладные ПО для работы делопроизводителя Атака на браузеры

Атака на браузеры Управление IT-сервисами и контентом

Управление IT-сервисами и контентом Презентация на тему Палитры цветов в системах цветопередачи

Презентация на тему Палитры цветов в системах цветопередачи  Программирование DJI Tello в редакторе Scratch 2.0

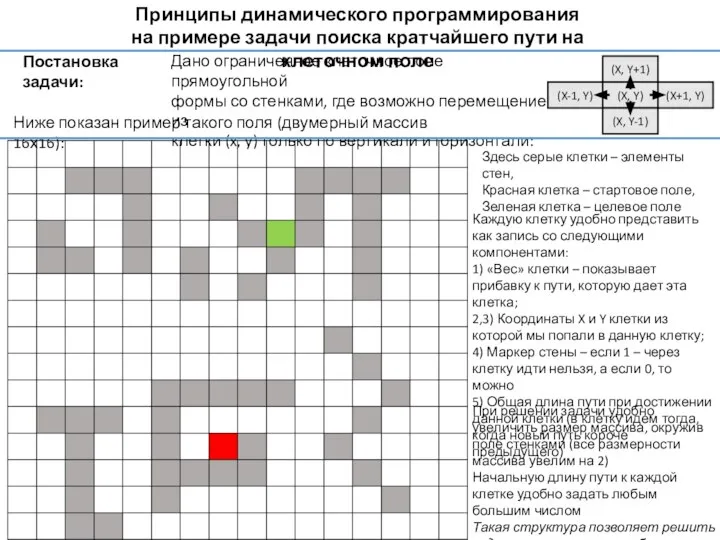

Программирование DJI Tello в редакторе Scratch 2.0 Принципы динамического программирования на примере задачи поиска кратчайшего пути на клеточном поле

Принципы динамического программирования на примере задачи поиска кратчайшего пути на клеточном поле Технологии беспроводной связи

Технологии беспроводной связи Франчайзинг. Проведение фотомониторинга

Франчайзинг. Проведение фотомониторинга Урок информатики в 7 классе

Урок информатики в 7 классе Entity Framework. Потоки

Entity Framework. Потоки Анализ данных. Основные принципы

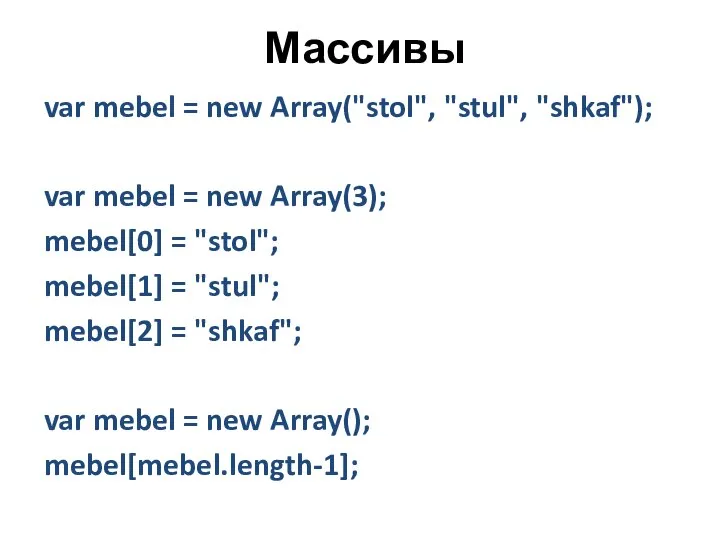

Анализ данных. Основные принципы Массивы. Функция showDay

Массивы. Функция showDay Поисковые запросы. Электронный каталог научной библиотеки ЧелГУ

Поисковые запросы. Электронный каталог научной библиотеки ЧелГУ 3D models

3D models Интернет-магазин товаров для здоровья и красоты AltaiMag

Интернет-магазин товаров для здоровья и красоты AltaiMag Защита персональных данных в ПАО Гофрон

Защита персональных данных в ПАО Гофрон Файлы и файловые структуры

Файлы и файловые структуры Исправление ошибок в простой программе с условными операторами. ЕГЭ 24

Исправление ошибок в простой программе с условными операторами. ЕГЭ 24