Содержание

- 2. Восприятие информации Человек воспринимает информацию из внешнего мира с помощью всех своих органов чувств, которые являются

- 3. Виды информации По способу восприятия: Визуальная Аудиальная Тактильная Вкусовая обонятельная

- 4. Виды информации По форме представления: Графическая Числовая Текстовая Звуковая Табличная

- 5. Существуют различные подходы к измерению количества информации: 1) Алфавитный 2) Содержательный 3) Вероятностный Количество информации –

- 6. 1. АЛФАВИТНЫЙ ПОДХОД Алфавитный подход основан на подсчете числа символов в сообщении и позволяет определить количество

- 7. Основоположником алфавитного подхода измерения информации является великий российский ученый-математик Андрей Николаевич Колмогоров (1903-1987).

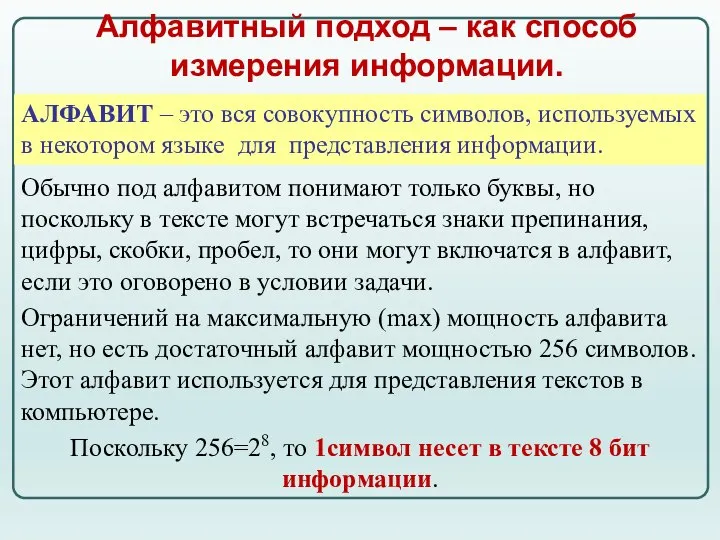

- 8. Обычно под алфавитом понимают только буквы, но поскольку в тексте могут встречаться знаки препинания, цифры, скобки,

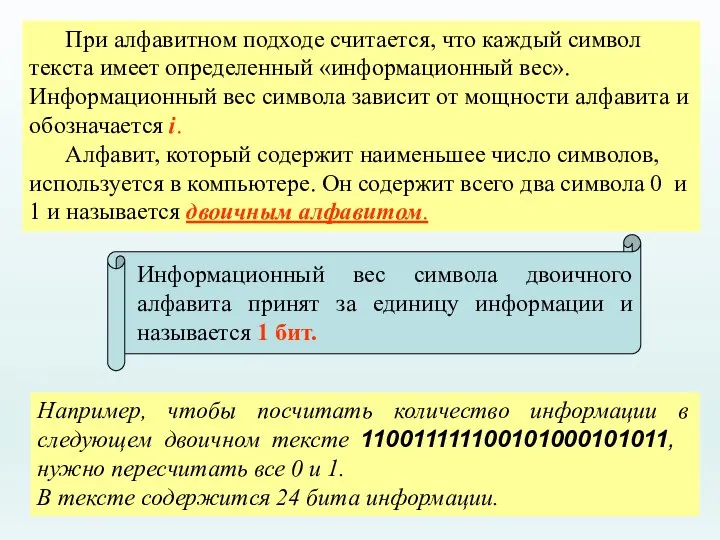

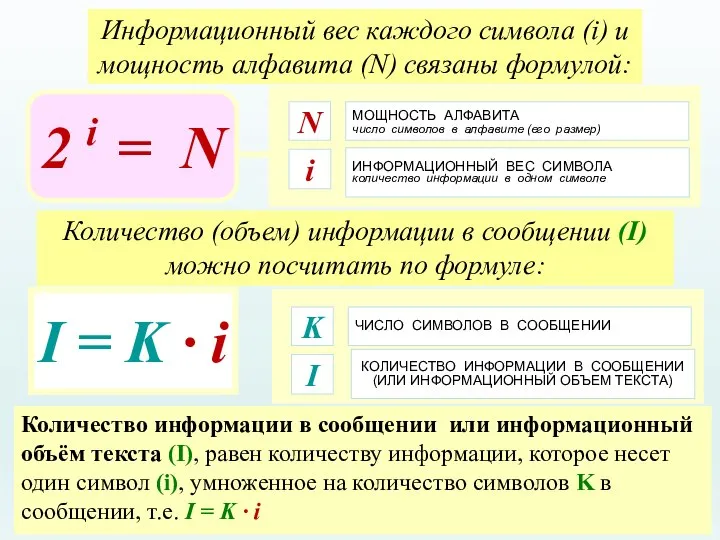

- 9. При алфавитном подходе считается, что каждый символ текста имеет определенный «информационный вес». Информационный вес символа зависит

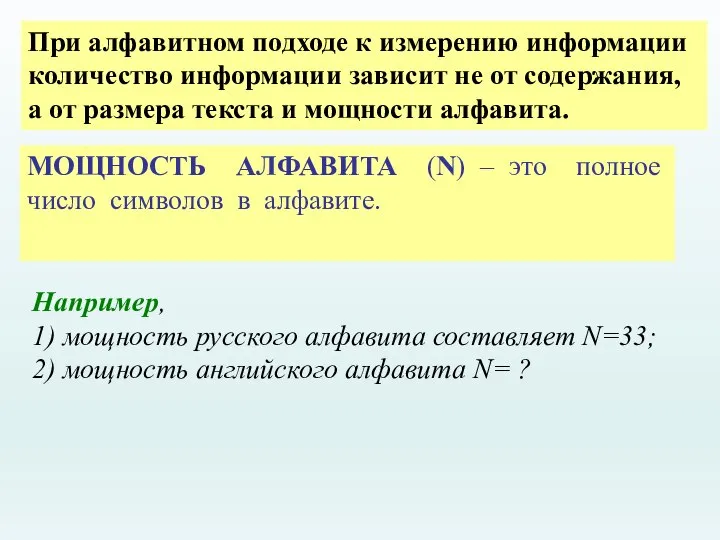

- 10. При алфавитном подходе к измерению информации количество информации зависит не от содержания, а от размера текста

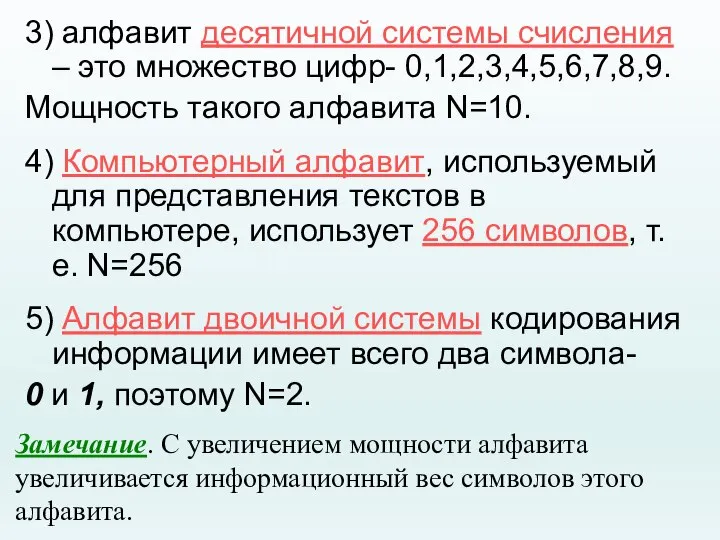

- 11. 3) алфавит десятичной системы счисления – это множество цифр- 0,1,2,3,4,5,6,7,8,9. Мощность такого алфавита N=10. 4) Компьютерный

- 12. МОЩНОСТЬ АЛФАВИТА число символов в алфавите (его размер) N ИНФОРМАЦИОННЫЙ ВЕС СИМВОЛА количество информации в одном

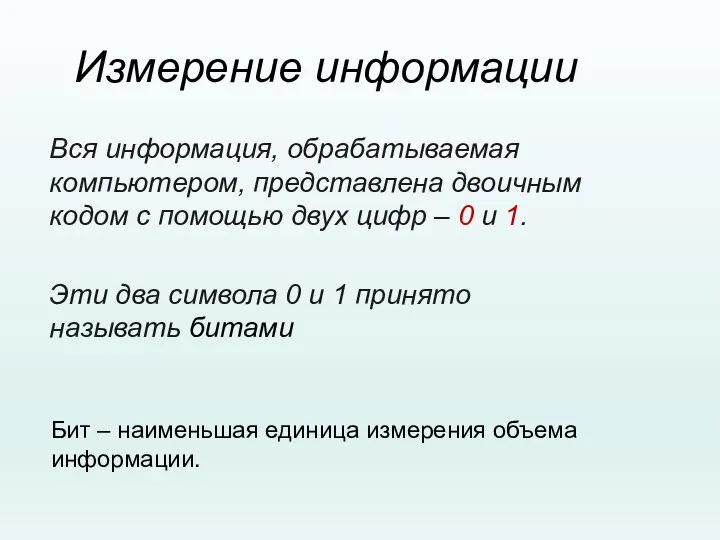

- 13. Измерение информации Вся информация, обрабатываемая компьютером, представлена двоичным кодом с помощью двух цифр – 0 и

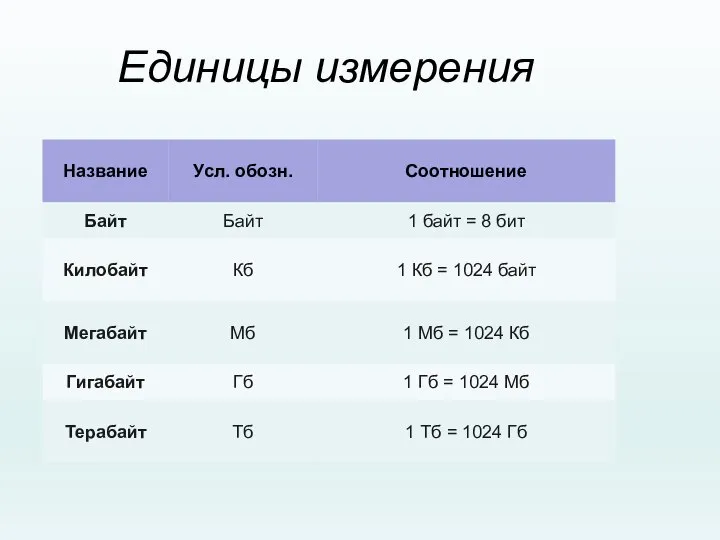

- 14. Единицы измерения

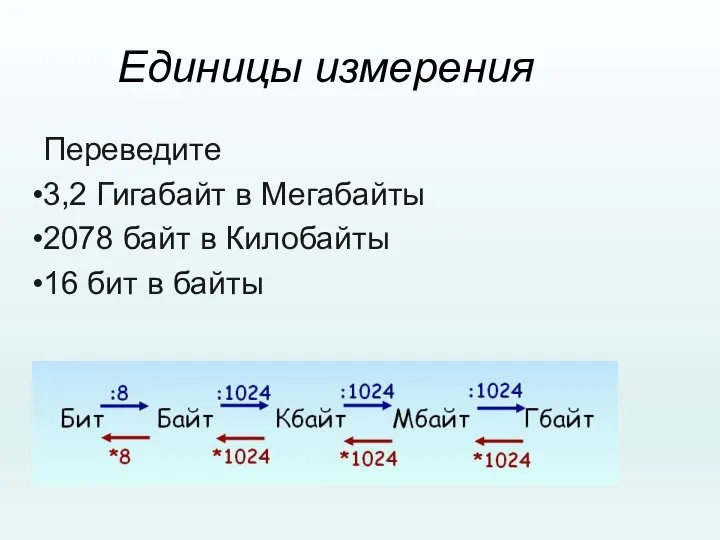

- 15. Единицы измерения Переведите 3,2 Гигабайт в Мегабайты 2078 байт в Килобайты 16 бит в байты

- 16. ЕДИНИЦЫ ИЗМЕРЕНИЯ ИНФОРМАЦИИ СИМВОЛЬНЫЙ АЛФАВИТ КОМПЬЮТЕРА русские (РУССКИЕ) буквы латинские (LAT) буквы цифры (1, 2, 3,

- 17. Скорость передачи информации Прием-передача информации могут происходить с разной скоростью. Количество информации, передаваемое за единицу времени,

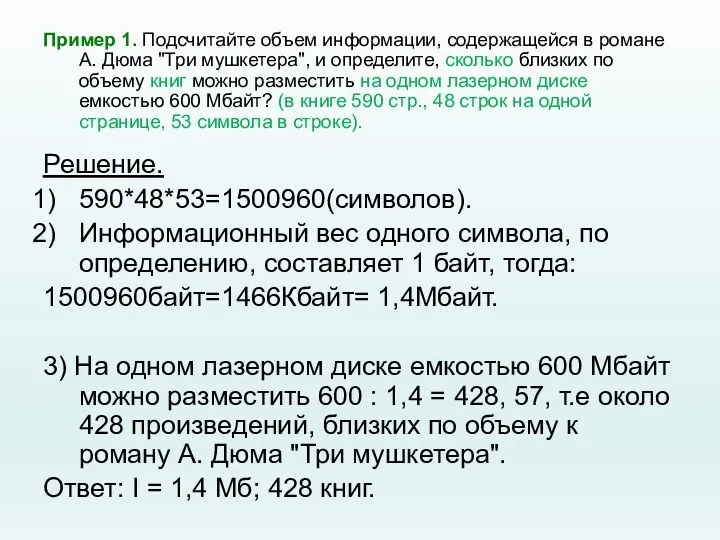

- 18. Пример 1. Подсчитайте объем информации, содержащейся в романе А. Дюма "Три мушкетера", и определите, сколько близких

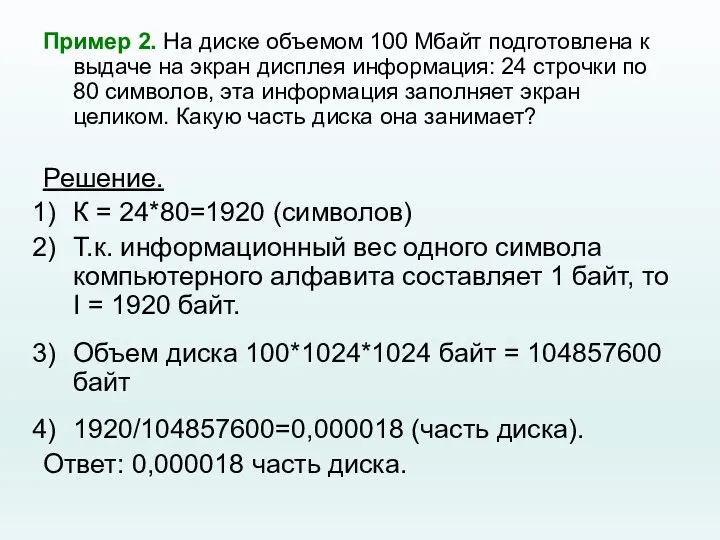

- 19. Пример 2. На диске объемом 100 Мбайт подготовлена к выдаче на экран дисплея информация: 24 строчки

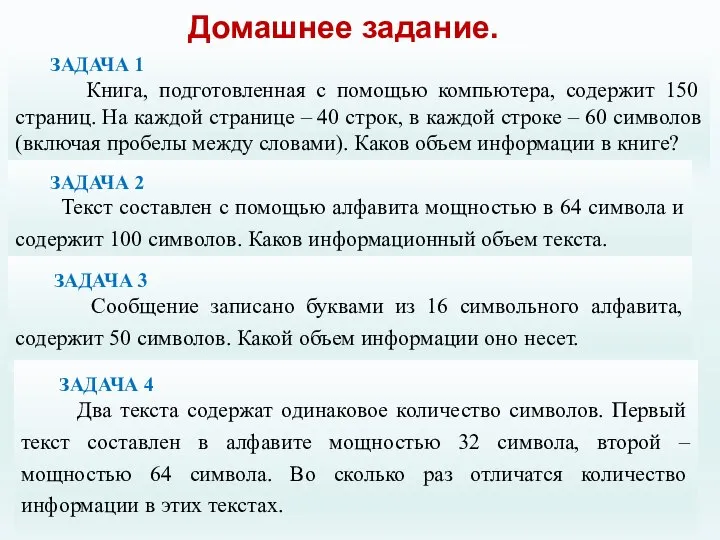

- 20. Домашнее задание. ЗАДАЧА 1 Книга, подготовленная с помощью компьютера, содержит 150 страниц. На каждой странице –

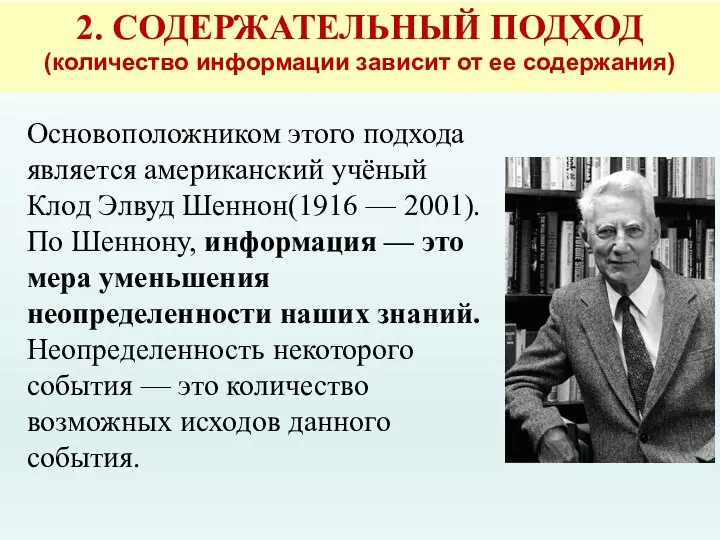

- 21. 2. СОДЕРЖАТЕЛЬНЫЙ ПОДХОД (количество информации зависит от ее содержания) Основоположником этого подхода является американский учёный Клод

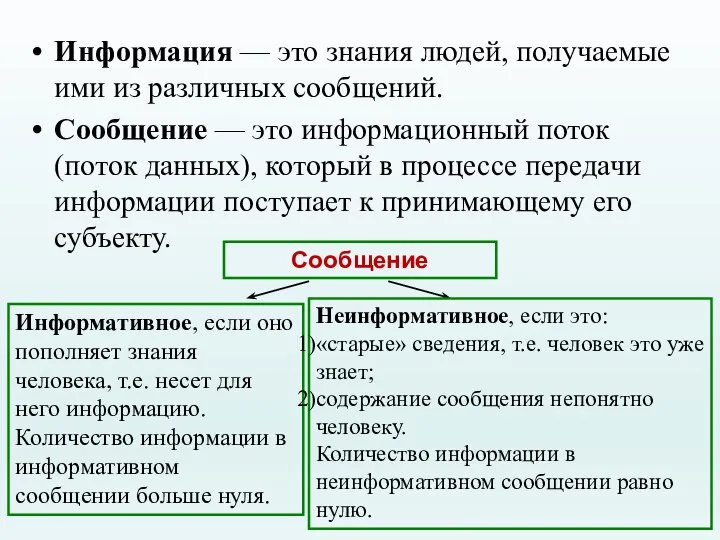

- 22. Информация — это знания людей, получаемые ими из различных сообщений. Сообщение — это информационный поток (поток

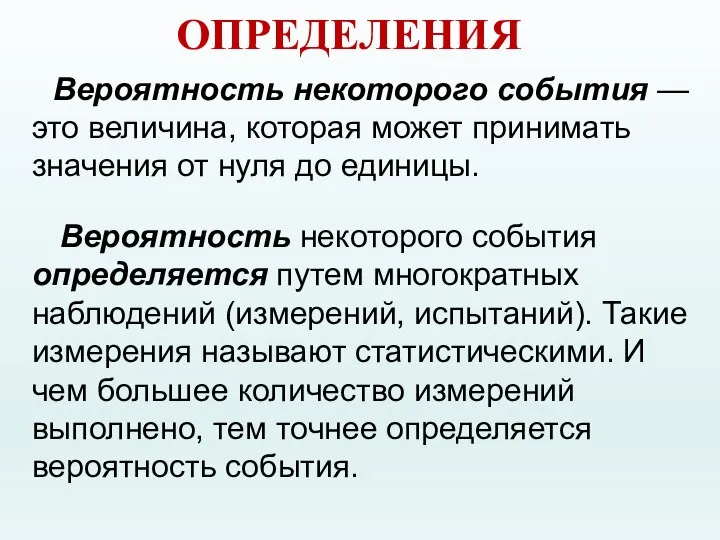

- 23. Вероятность некоторого события — это величина, которая может принимать значения от нуля до единицы. Вероятность некоторого

- 24. Формула, используемая для вычисления количества информации, зависит от ситуаций, которых может быть две: 1. Все возможные

- 25. Равновероятные события. 2i = N 1 бит — это количество информации в сообщении об одном из

- 26. Примеры. Пример 1. Сколько информации содержит сообщение о том, что из колоды карт достали даму пик?

- 27. Пример 2. Сколько информации содержит сообщение о выпадении грани с числом 3 на шестигранном игральном кубике?

- 28. Данную задачу можно решить иначе: Из уравнения Хартли имеем: 2i = 6. Так как 22 2

- 29. 2i = 1/p Решая данное показательное уравнение относительно i, получаем: i = log2(1/p) формула Шеннона 3.

- 30. Пример 3. На автобусной остановке останавливаются два маршрута автобусов: № 5 и № 7. Студенту дано

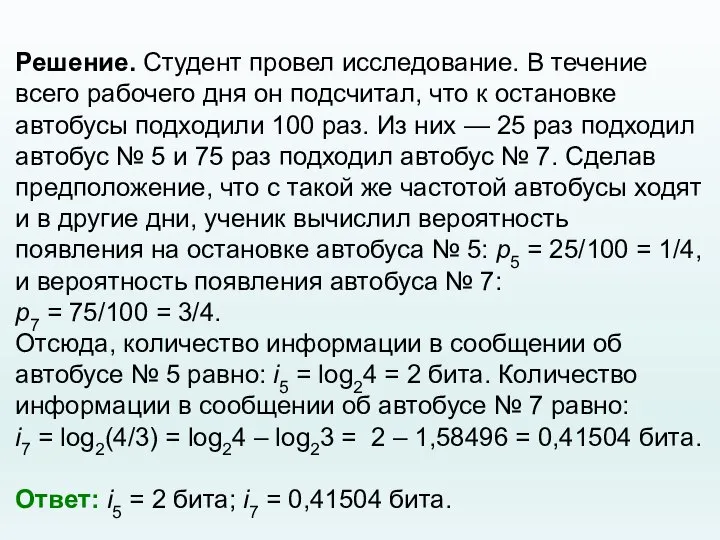

- 31. Решение. Студент провел исследование. В течение всего рабочего дня он подсчитал, что к остановке автобусы подходили

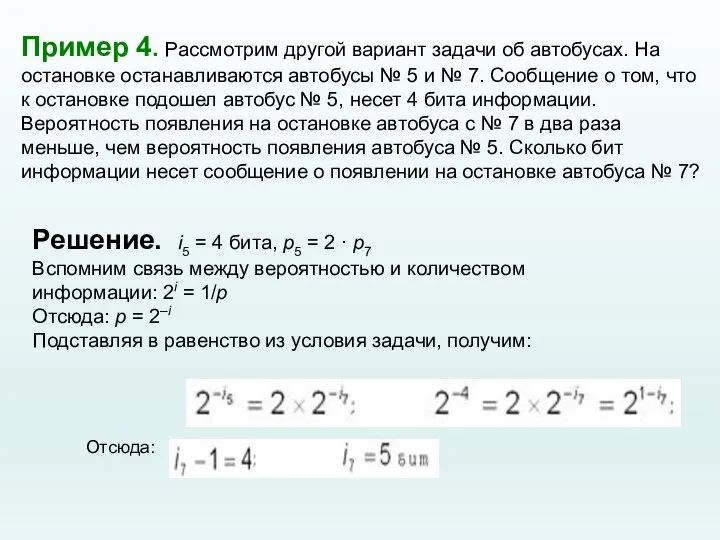

- 32. Пример 4. Рассмотрим другой вариант задачи об автобусах. На остановке останавливаются автобусы № 5 и №

- 33. Вывод: уменьшение вероятности события в 2 раза увеличивает информативность сообщения о нем на 1 бит. Очевидно

- 35. Скачать презентацию

Программное обеспечение и его классификация

Программное обеспечение и его классификация Виды графики. 8 класс

Виды графики. 8 класс Состав и работа ПК

Состав и работа ПК Логические элементы

Логические элементы Существенные свойства и принятия

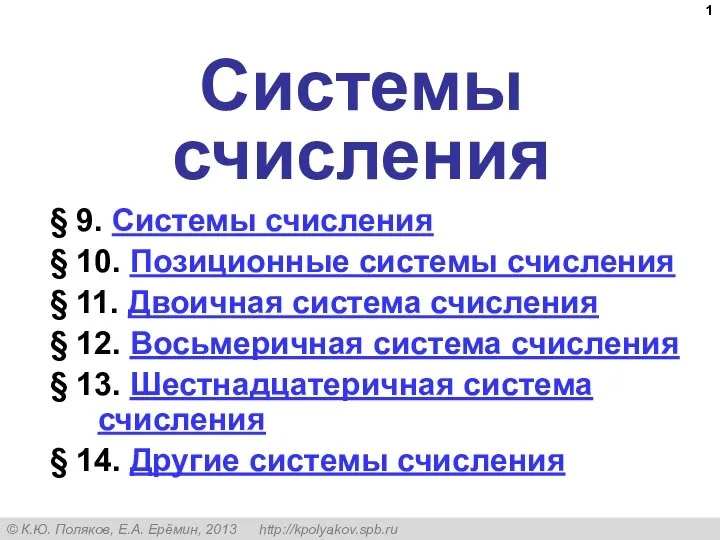

Существенные свойства и принятия Системы счисления

Системы счисления Журнал Культура и политика 2016 в словах и образах

Журнал Культура и политика 2016 в словах и образах Управление изменениями

Управление изменениями Приходная накладная

Приходная накладная Каб Телевидение. Вайфай. Проводной интернет. Иконки для услуг

Каб Телевидение. Вайфай. Проводной интернет. Иконки для услуг ВКР: Справочник учебных заведений города

ВКР: Справочник учебных заведений города Диалоги в поселке

Диалоги в поселке Создание таблицы

Создание таблицы Microsoft Office Excel: понятия и возможности

Microsoft Office Excel: понятия и возможности Классическая стеганография

Классическая стеганография Сообщество Детский нейропсихолог. Нейрокоррекция

Сообщество Детский нейропсихолог. Нейрокоррекция Fazan. Информационный портал на околокультурную тематику

Fazan. Информационный портал на околокультурную тематику Защита персональных данных работника

Защита персональных данных работника Параллельное программирование. Программирование взаимодействующих процессов

Параллельное программирование. Программирование взаимодействующих процессов Как игровой мир реагирует на действия игрока

Как игровой мир реагирует на действия игрока Помощь сетевекам при работе в интернете. Боли разных целевых аудиторий

Помощь сетевекам при работе в интернете. Боли разных целевых аудиторий содержательный подход

содержательный подход Процедура загрузки документов KYC

Процедура загрузки документов KYC Тексти і текстовий редактор. Середовище текстового редактора. Правила введення тексту. Збереження текстового документа

Тексти і текстовий редактор. Середовище текстового редактора. Правила введення тексту. Збереження текстового документа Бинарная логика. 9-10 лет. Сеть клубов программирования и робототехники. Урок №10

Бинарная логика. 9-10 лет. Сеть клубов программирования и робототехники. Урок №10 Программа мотивации 2019 год

Программа мотивации 2019 год Как получить информацию журналисту

Как получить информацию журналисту Системы счисления. Понятие системы счисления

Системы счисления. Понятие системы счисления