Содержание

- 2. Информатика и Биоинформатика Биологическая задача Формализация Формализация Формализация Алгоритм Алгоритм Алгоритм Алгоритм Алгоритм Тестирование Параметры Параметры

- 3. Пример: сравнение последовательностей Тестирование: алгоритм должен распознавать последовательности, для которых известно, что они биологически (структурно и/или

- 4. Сравнение последовательностей Формализация1: глобальное выравнивание Алгоритм1: Граф выравнивания, динамическое программирование Алгоритм1а: Граф выравнивания, динамическое программирование, линейная

- 5. Сравнение последовательностей Формализация2: локальное выравнивание Алгоритм2: Граф локального выравнивания, динамическое программирование Параметры: Матрица сходства, штраф за

- 6. Сравнение последовательностей Формализация3: локальное выравнивание с аффинными штрафами Алгоритм3: Расширенный граф локального выравнивания, динамическое программирование Параметры:

- 7. Сравнение последовательностей Алгоритм4: FASTA. формальная задача плохо определена Параметры: Размер якоря, матрица сходства, штраф за делецию

- 8. Сравнение последовательностей Алгоритм5: BLAST. формальная задача плохо определена Параметры: Размер якоря, матрица сходства, штраф за делецию

- 9. Выравнивания

- 10. Редакционное расстояние Элементарное преобразование последовательности: замена буквы или удаление буквы или вставка буквы. Редакционное расстояние: минимальное

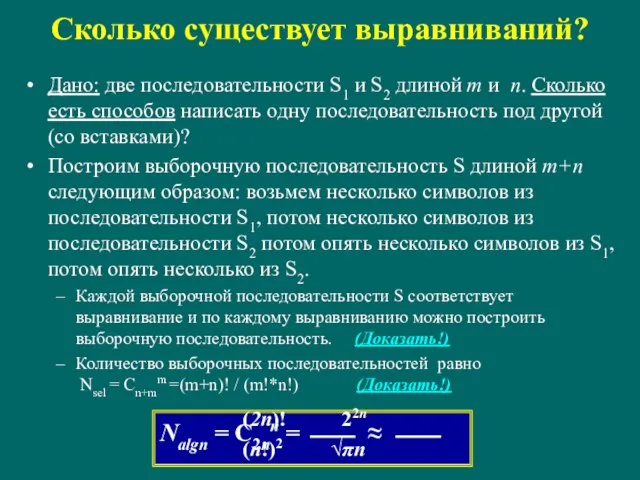

- 11. Сколько существует выравниваний? Дано: две последовательности S1 и S2 длиной m и n. Сколько есть способов

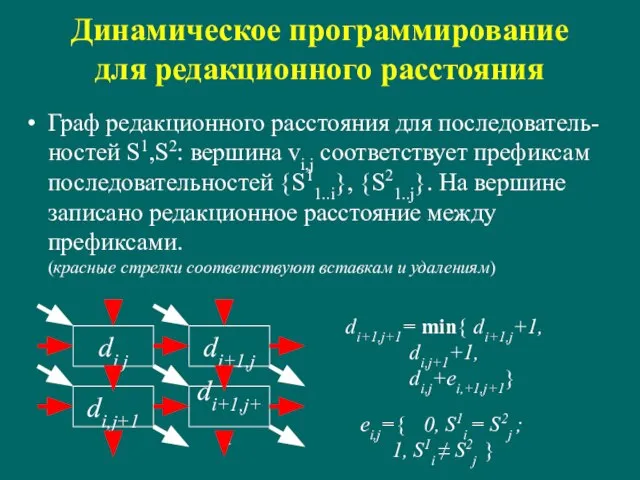

- 12. Динамическое программирование для редакционного расстояния Граф редакционного расстояния для последователь-ностей S1,S2: вершина vi,j соответствует префиксам последовательностей

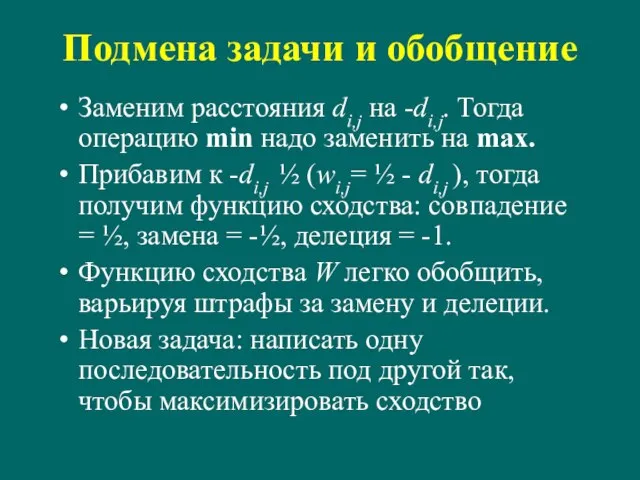

- 13. Подмена задачи и обобщение Заменим расстояния di,j на -di,j. Тогда операцию min надо заменить на max.

- 14. Граничные условия wi,j wi+1,j wi,j+1 wi+1,j+1 w1,1 начало w1,2 d2,1 wn,m-1 wn,m w2,1 wn-1,m конец При

- 15. Как не штрафовать за концевые делеции wi,j w1,1 начало w1,2 w2,1 wn,m-1 wn,m w3,1 wn-1,m конец

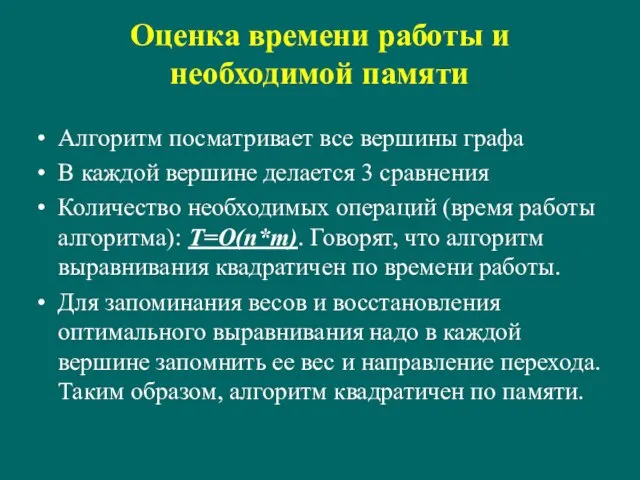

- 16. Оценка времени работы и необходимой памяти Алгоритм посматривает все вершины графа В каждой вершине делается 3

- 17. Где можно сэкономить? Во-первых не обязательно запоминать веса во всех вершинах. При просмотре матрицы выравнивания (графа

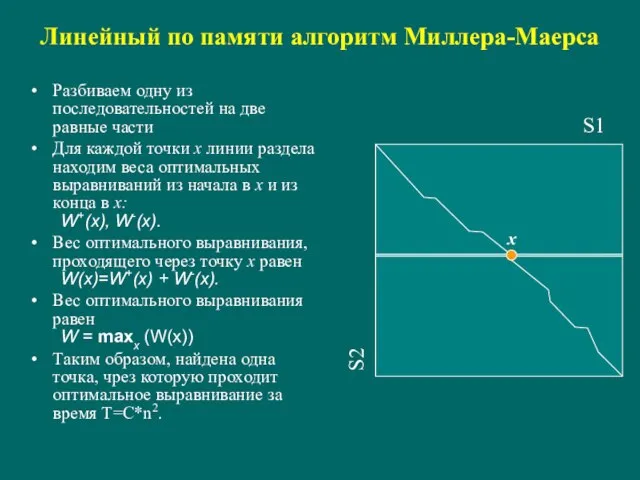

- 18. Линейный по памяти алгоритм Миллера-Маерса Разбиваем одну из последовательностей на две равные части Для каждой точки

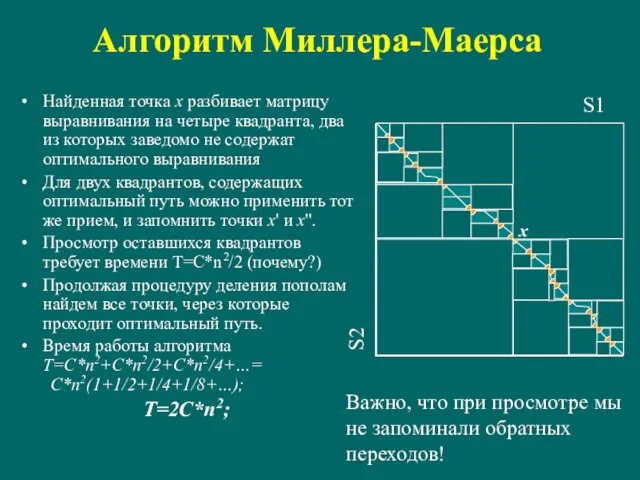

- 19. Алгоритм Миллера-Маерса Найденная точка x разбивает матрицу выравнивания на четыре квадранта, два из которых заведомо не

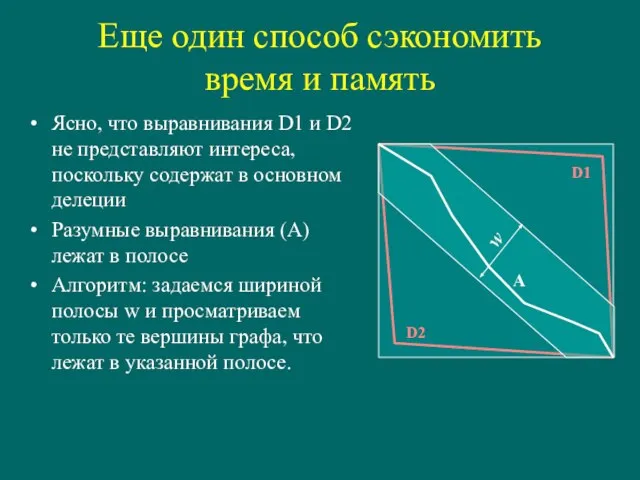

- 20. Еще один способ сэкономить время и память Ясно, что выравнивания D1 и D2 не представляют интереса,

- 21. Локальное выравнивание Локальным оптимальным выравниванием называется такое оптимальное выравнивание фрагментов последовательностей, при котором любое удлинение или

- 22. Алгоритм Смита-Ватермана wi,j w1,1 начало w1,2 w2,1 wn,m-1 wn,m w3,1 wn-1,m конец wn,m-2 wn-2,m w1,3 0

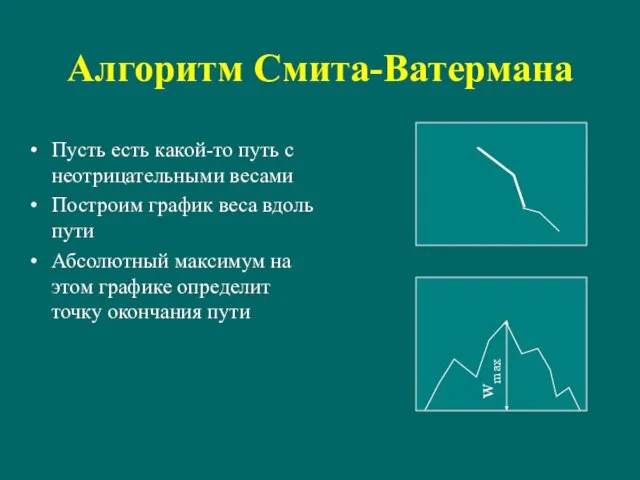

- 23. Алгоритм Смита-Ватермана Пусть есть какой-то путь с неотрицательными весами Построим график веса вдоль пути Абсолютный максимум

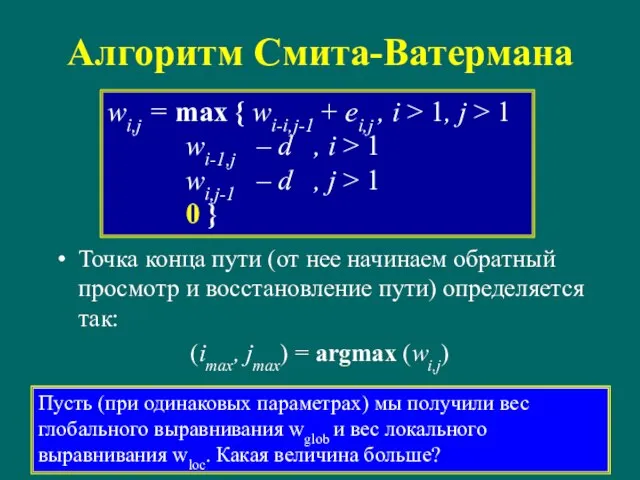

- 24. Алгоритм Смита-Ватермана Точка конца пути (от нее начинаем обратный просмотр и восстановление пути) определяется так: (imax,

- 25. Более общая зависимость штрафа за делецию от величины делеции Простейшая модель делеции: элементарное событие – удаление

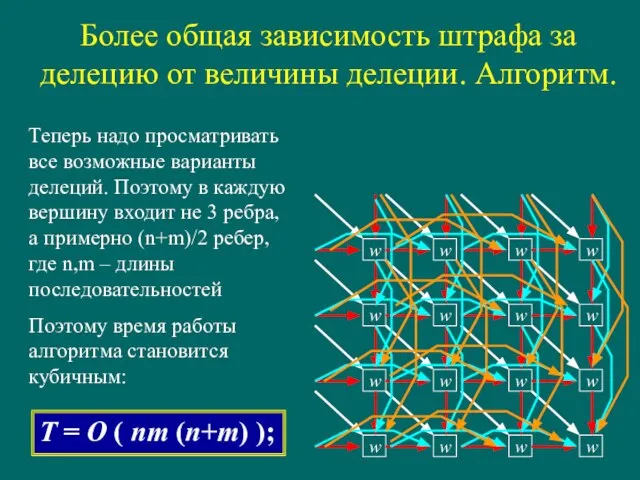

- 26. Более общая зависимость штрафа за делецию от величины делеции. Алгоритм. Теперь надо просматривать все возможные варианты

- 27. Аффинные штрафы за делецию Вместо логарифмической зависимости используют зависимость вида: Δ ( l ) = dopen+

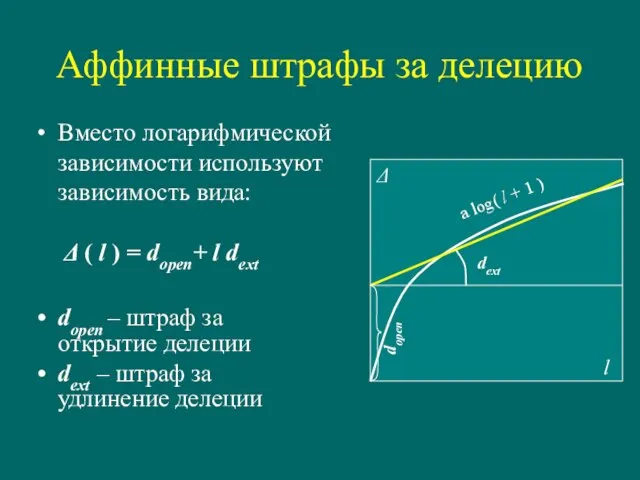

- 28. Алгоритм для аффинных штрафов Веса на ребрах ei,j сопоставление dopen открытие делеции dext продолжение делеции ei,j

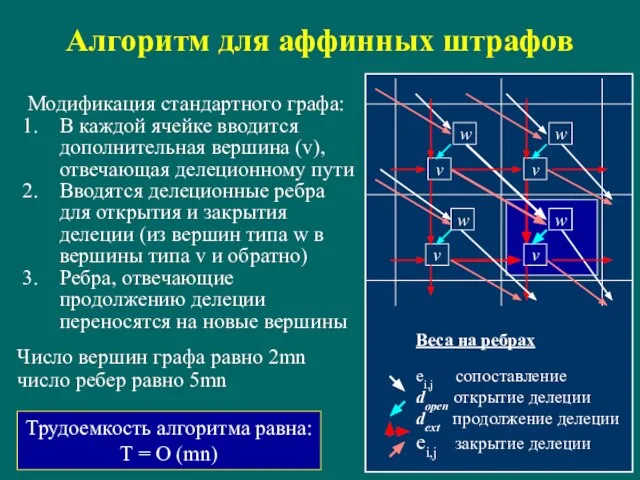

- 29. Рекурсия для аффинных штрафов w i, j = max ( w i-1, j-1+ei j , v

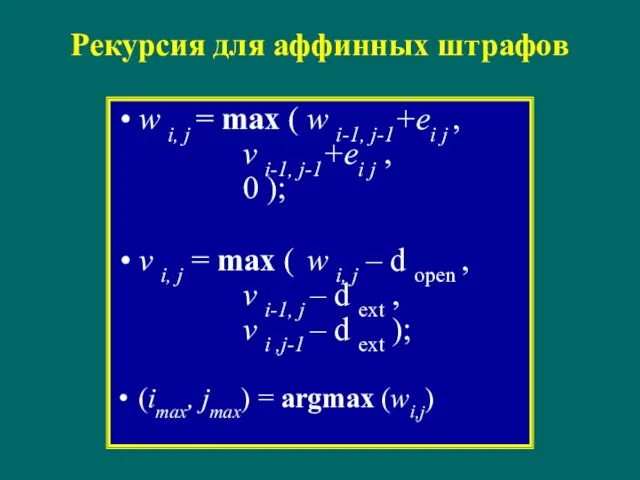

- 30. Матрицы замен

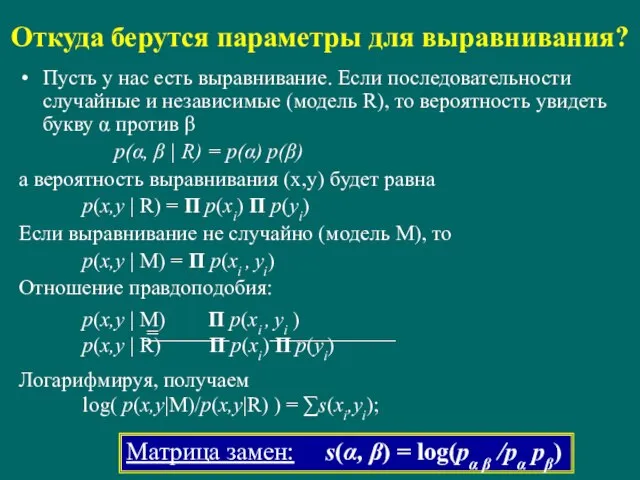

- 31. Откуда берутся параметры для выравнивания? Пусть у нас есть выравнивание. Если последовательности случайные и независимые (модель

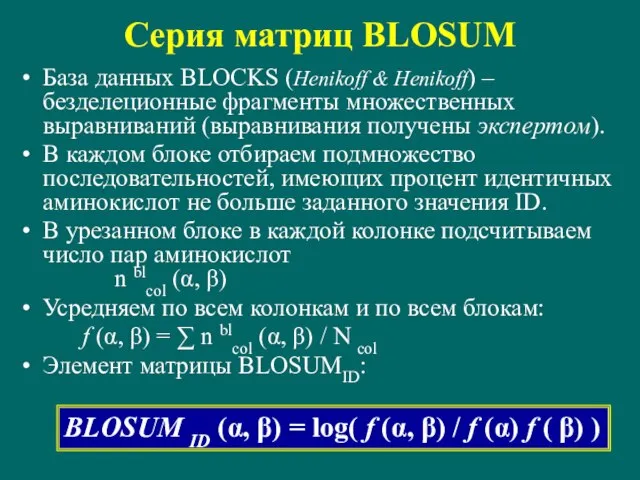

- 32. Серия матриц BLOSUM База данных BLOCKS (Henikoff & Henikoff) – безделеционные фрагменты множественных выравниваний (выравнивания получены

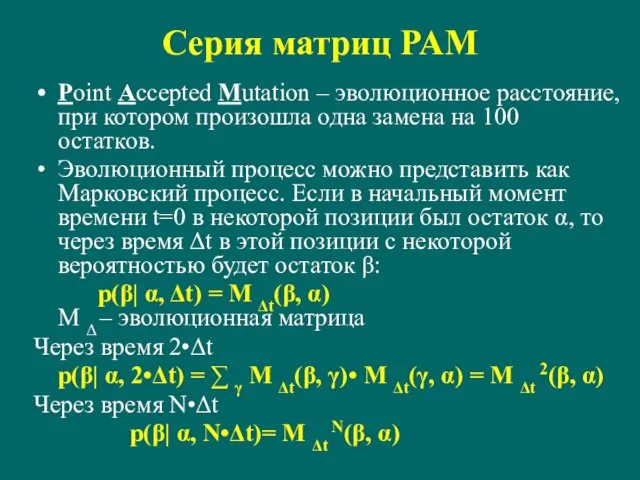

- 33. Серия матриц PAM Point Accepted Mutation – эволюционное расстояние, при котором произошла одна замена на 100

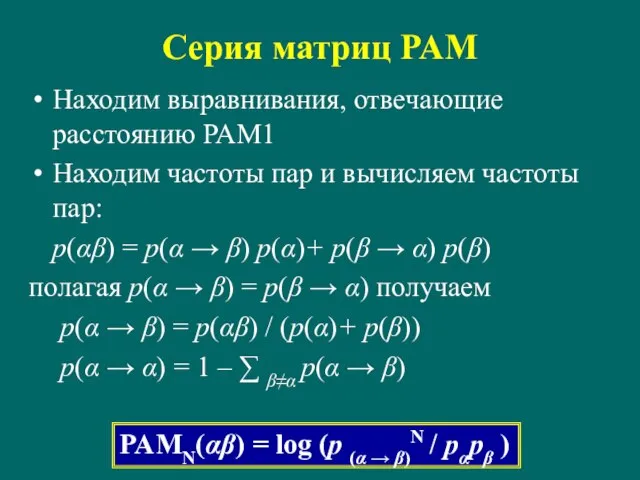

- 34. Серия матриц PAM Находим выравнивания, отвечающие расстоянию PAM1 Находим частоты пар и вычисляем частоты пар: p(αβ)

- 35. Статистика выравниваний

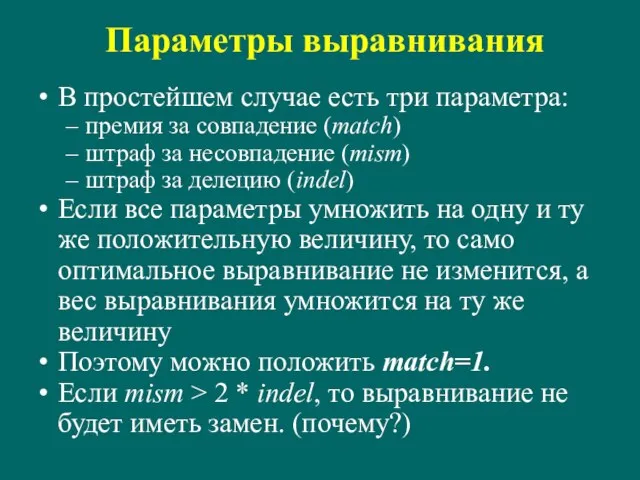

- 36. Параметры выравнивания В простейшем случае есть три параметра: премия за совпадение (match) штраф за несовпадение (mism)

- 37. Статистика выравниваний Допустим мы выровняли две последовательности длиной 100 и получили вес 20. Что это значит?

- 38. Статистика выравниваний Базовая (вообще говоря неправильная) модель – Бернуллиевские последовательности (символы генерируются независимо друг от друга

- 39. Частные случаи локального выравнивания mism = 0, indel = 0 – максимальная общая подпоследовательность mism =

- 40. Наибольшая общая подпоследовательность Длина оптимальной подпоследовательности есть случайная величина r(n), зависящая от длины последовательностей. Пусть две

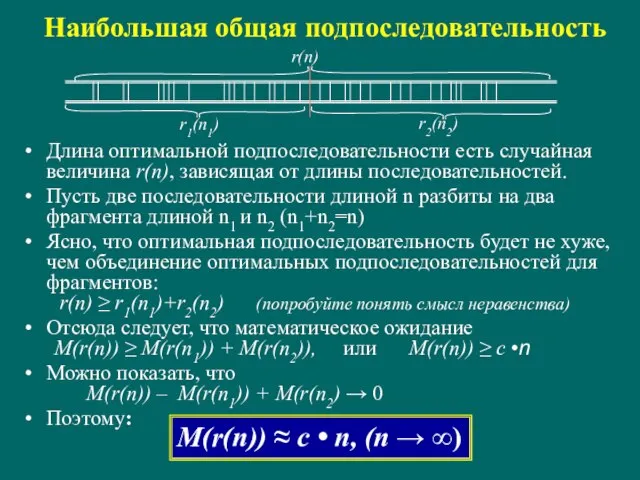

- 41. Наибольшее общее слово Наложим одну последовательность на другую. Будем идти вдоль пары последовательностей и, если буквы

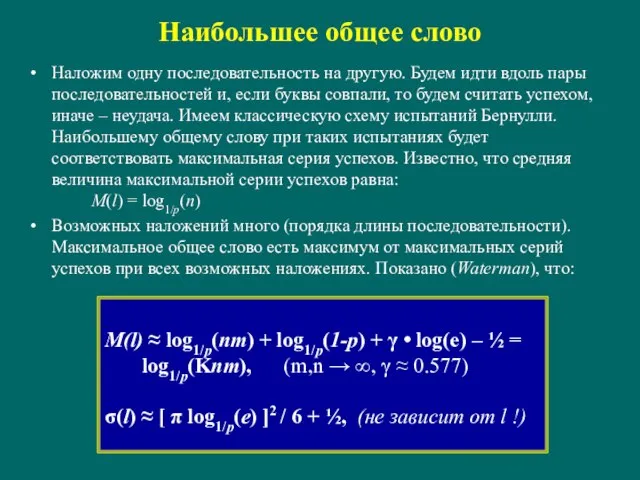

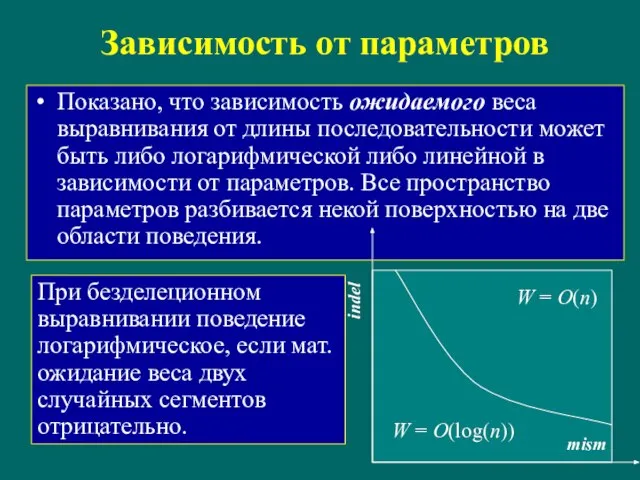

- 42. Зависимость от параметров Показано, что зависимость ожидаемого веса выравнивания от длины последовательности может быть либо логарифмической

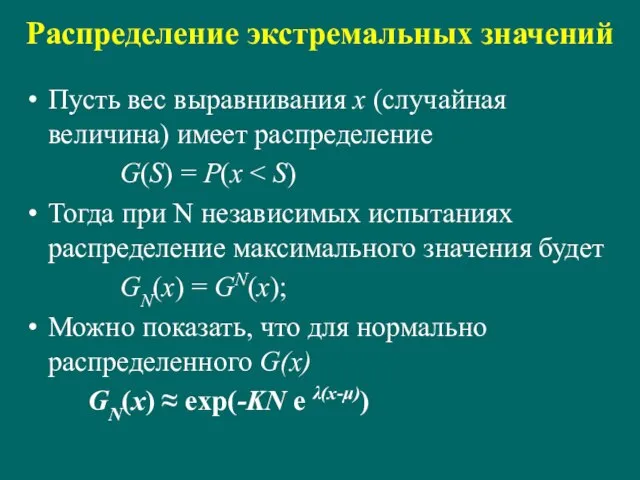

- 43. Распределение экстремальных значений Пусть вес выравнивания x (случайная величина) имеет распределение G(S) = P(x Тогда при

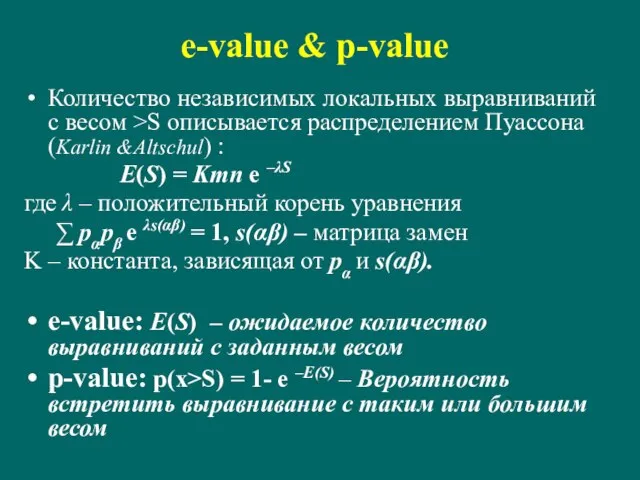

- 44. e-value & p-value Количество независимых локальных выравниваний с весом >S описывается распределением Пуассона (Karlin &Altschul) :

- 45. Поиск по банку

- 46. Поиск по банку. Хеширование. Подготовка банка – построение хэш-таблицы. Хэш-функция – номер слова заданного размера (l-tuple,

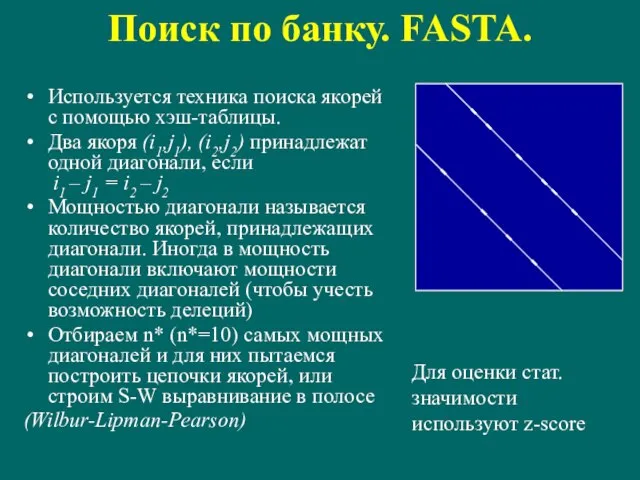

- 47. Поиск по банку. FASTA. Используется техника поиска якорей с помощью хэш-таблицы. Два якоря (i1,j1), (i2,j2) принадлежат

- 48. Поиск по банку. BLAST1. Ищем якоря с помощью хэш-таблицы Каждый якорь расширяем с тем, чтобы получить

- 49. Поиск по банку. BLAST2. T-соседней l-граммой LT для l-граммы L называется такая l-грамма, что вес ее

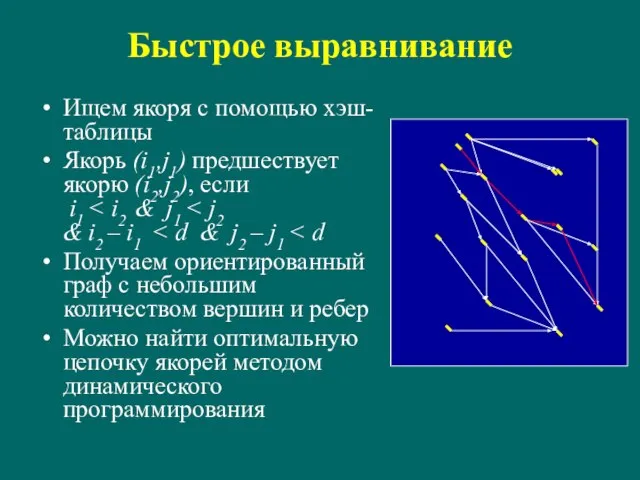

- 50. Быстрое выравнивание Ищем якоря с помощью хэш-таблицы Якорь (i1,j1) предшествует якорю (i2,j2), если i1 Получаем ориентированный

- 51. Введение в Байесову статистику

- 52. Введение в Байесову статистику Задача. Мы 3 раза бросили монету и 3 раза выпал орел. Какова

- 53. Введение в Байесову статистику P(3o | p) = p3; P(3o, p) = P(3o | p) Pa

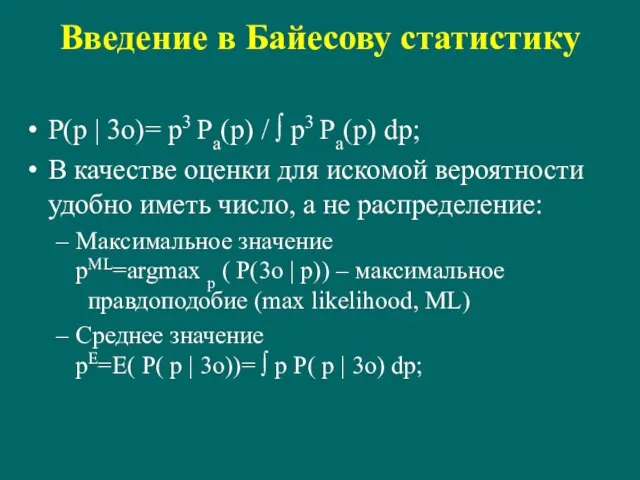

- 54. Введение в Байесову статистику P(p | 3o)= p3 Pa(p) / ∫ p3 Pa(p) dp; В качестве

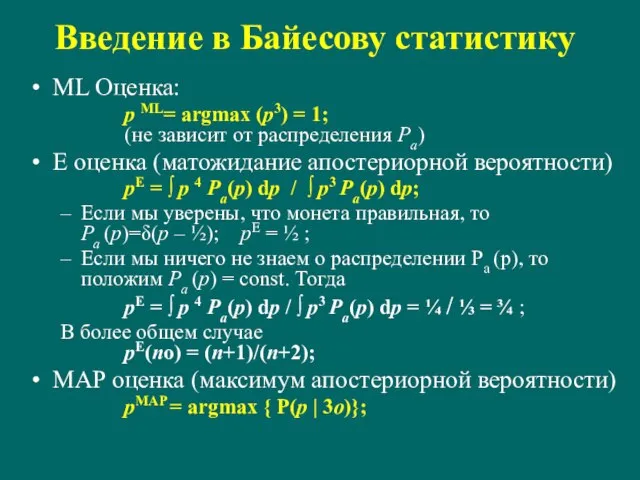

- 55. Введение в Байесову статистику ML Оценка: p ML= argmax (p3) = 1; (не зависит от распределения

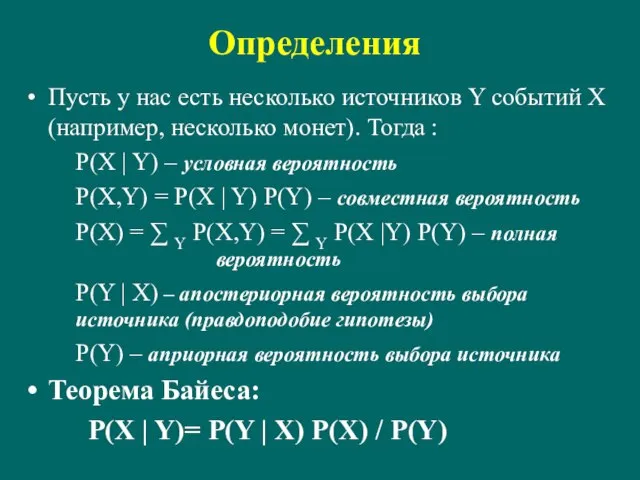

- 56. Определения Пусть у нас есть несколько источников Y событий X (например, несколько монет). Тогда : P(X

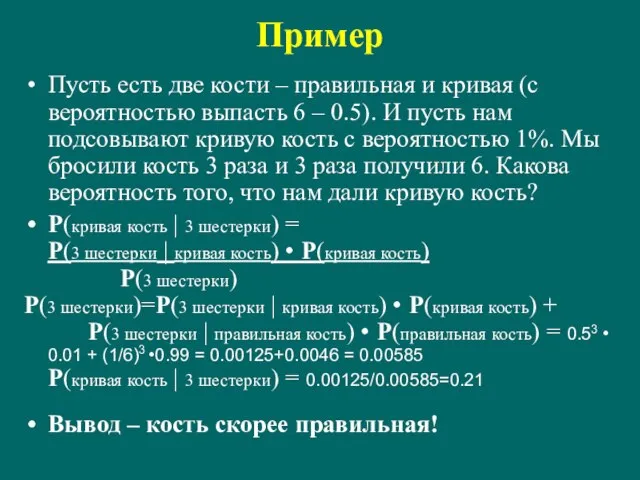

- 57. Пример Пусть есть две кости – правильная и кривая (с вероятностью выпасть 6 – 0.5). И

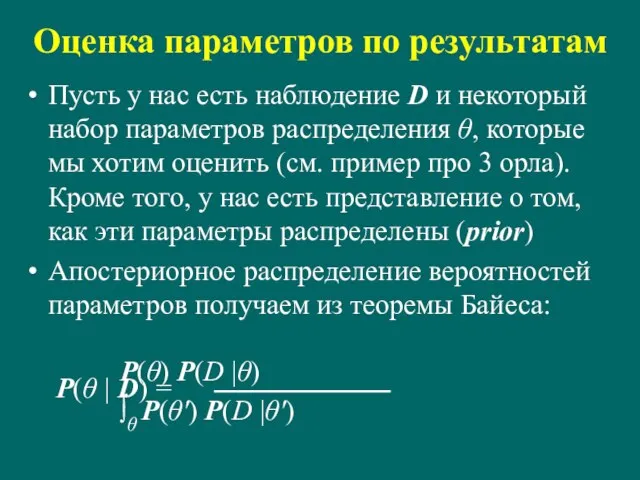

- 58. Оценка параметров по результатам Пусть у нас есть наблюдение D и некоторый набор параметров распределения θ,

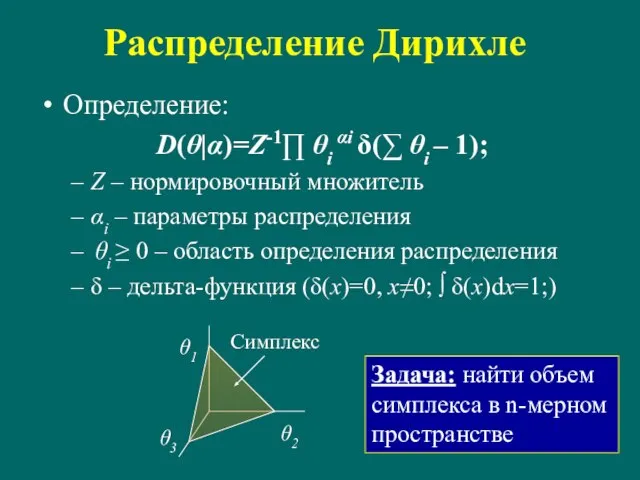

- 59. Распределение Дирихле Определение: D(θ|α)=Z-1∏ θi αi δ(∑ θi – 1); Z – нормировочный множитель αi –

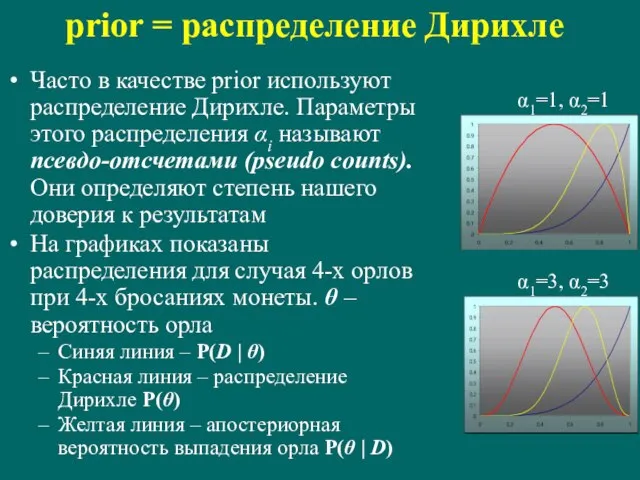

- 60. prior = распределение Дирихле Часто в качестве prior используют распределение Дирихле. Параметры этого распределения αi называют

- 61. Скрытые Марковские модели (HMM)

- 62. Пример Пусть некто имеет две монеты – правильную и кривую. Он бросает монету и сообщает нам

- 63. Биологические примеры Дана аминокислотная последовательность трансмембранного белка. Известно, что частоты встречаемости аминокислот в трансмембранных и в

- 64. Описание HMM Пример с монетой можно представить в виде схемы конечного автомата: Прямоугольники означают состояния Кружки

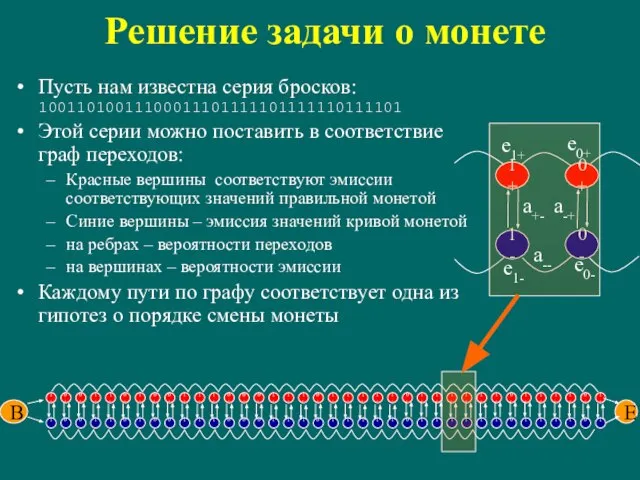

- 65. Решение задачи о монете Пусть нам известна серия бросков: 10011010011100011101111101111110111101 Этой серии можно поставить в соответствие

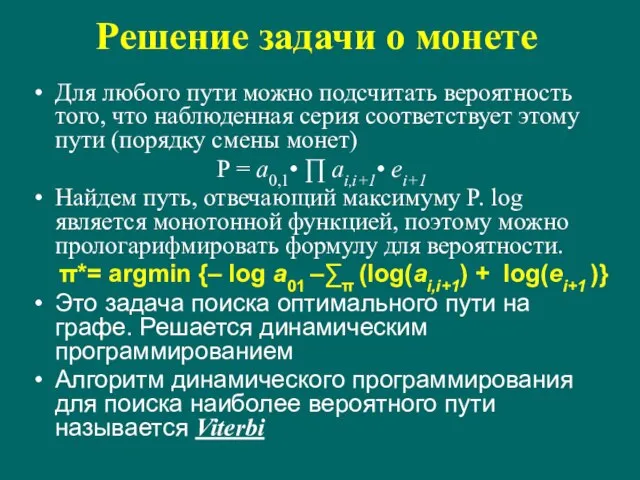

- 66. Решение задачи о монете Для любого пути можно подсчитать вероятность того, что наблюденная серия соответствует этому

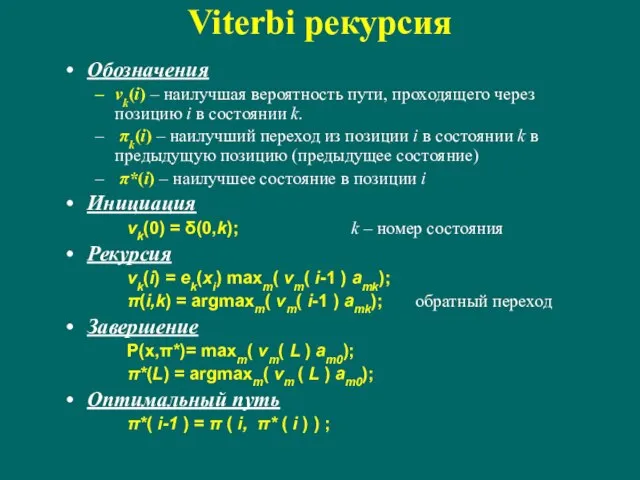

- 67. Viterbi рекурсия Обозначения vk(i) – наилучшая вероятность пути, проходящего через позицию i в состоянии k. πk(i)

- 68. Другая постановка задачи Для каждого наблюденного значения определить вероятность того, что в этот момент монета была

- 69. Оценка параметров HMM Есть две постановки задачи. Есть множество наблюдений с указанием, где происходит смена моделей

- 70. Оценка параметров HMM при наличии обучающей выборки Здесь используется техника оценки параметров методом наибольшего правдоподобия. Пусть

- 71. Оценка параметров HMM при наличии обучающей выборки Можно показать, что при большом количестве наблюдений справедливы оценки

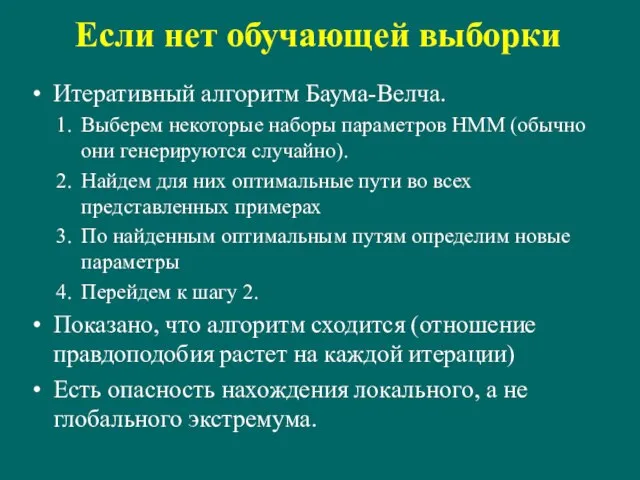

- 72. Если нет обучающей выборки Итеративный алгоритм Баума-Велча. Выберем некоторые наборы параметров HMM (обычно они генерируются случайно).

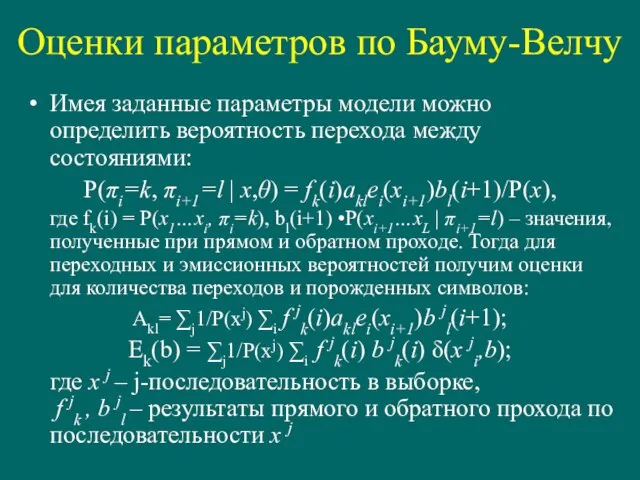

- 73. Оценки параметров по Бауму-Велчу Имея заданные параметры модели можно определить вероятность перехода между состояниями: P(πi=k, πi+1=l

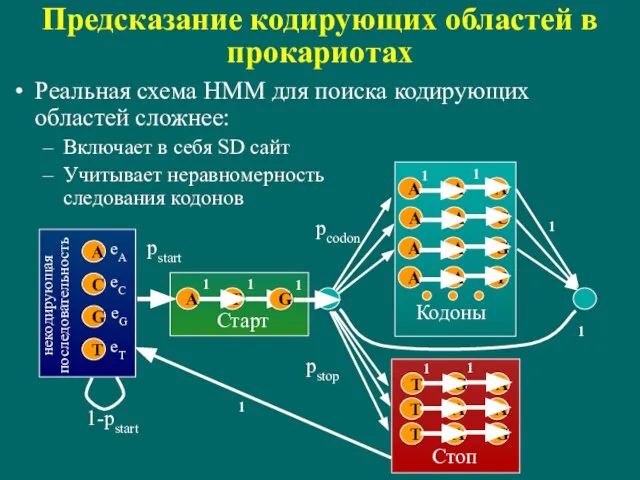

- 74. Предсказание кодирующих областей в прокариотах Реальная схема HMM для поиска кодирующих областей сложнее: Включает в себя

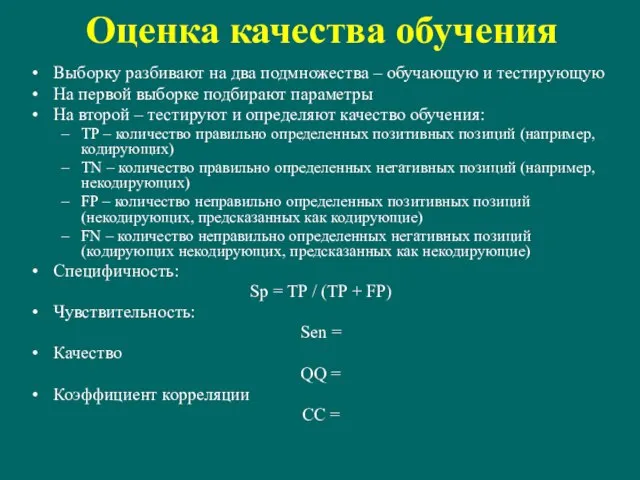

- 75. Оценка качества обучения Выборку разбивают на два подмножества – обучающую и тестирующую На первой выборке подбирают

- 76. Профили

- 77. Способы описания множественного выравнивания Дано: множественное выравнивание. Задача: определить принадлежит ли некая последовательность данному семейству. Простейший

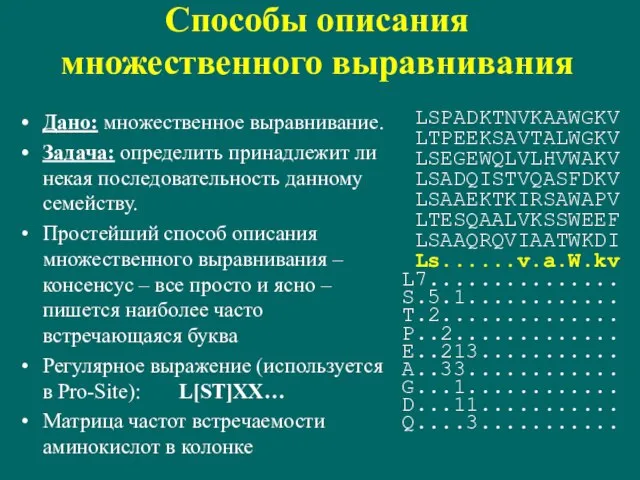

- 78. Энтропия колонки Пусть колонка содержит nα букв типа α. Тогда вероятность появления такой колонки при случайных

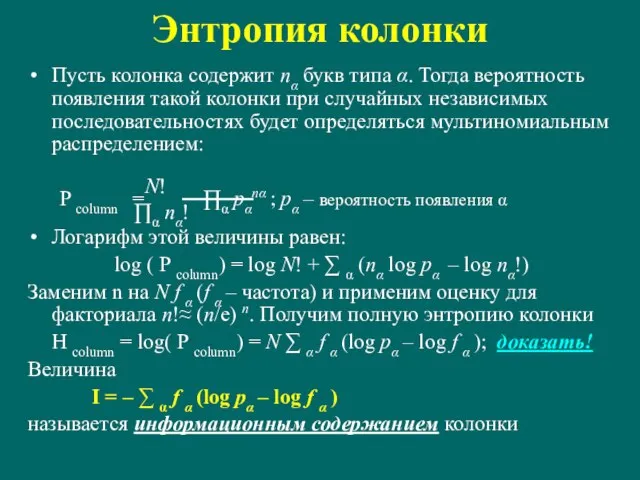

- 79. HMM профиль Модель: каждая последовательность множественного выравнивания является серией скрытой Марковской модели. Профиль – описание Марковской

- 80. HMM с учетом возможности вставок Делеция в профиле и в последовательности могут идти подряд (в отличие

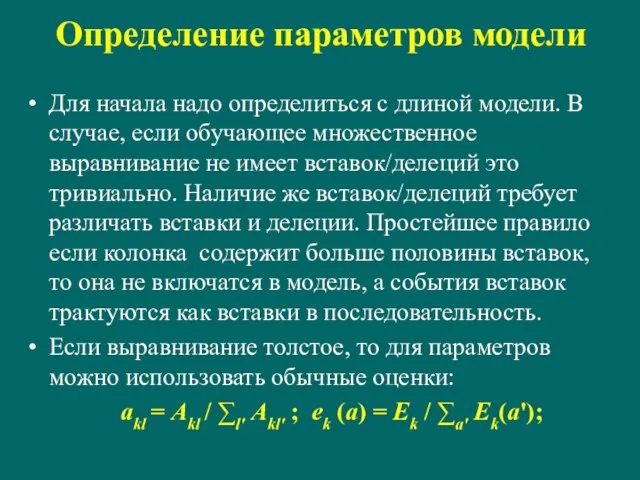

- 81. Определение параметров модели Для начала надо определиться с длиной модели. В случае, если обучающее множественное выравнивание

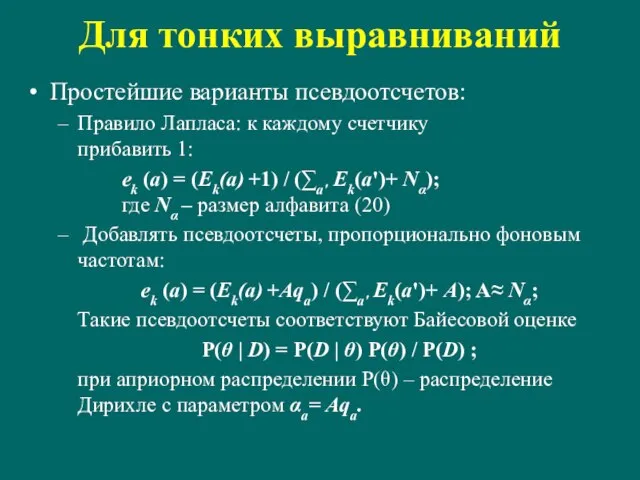

- 82. Для тонких выравниваний Простейшие варианты псевдоотсчетов: Правило Лапласа: к каждому счетчику прибавить 1: ek (a) =

- 83. Смеси Дирихле Представим себе, что на распределение вероятностей влияют несколько источников – частота встречаемости символа в

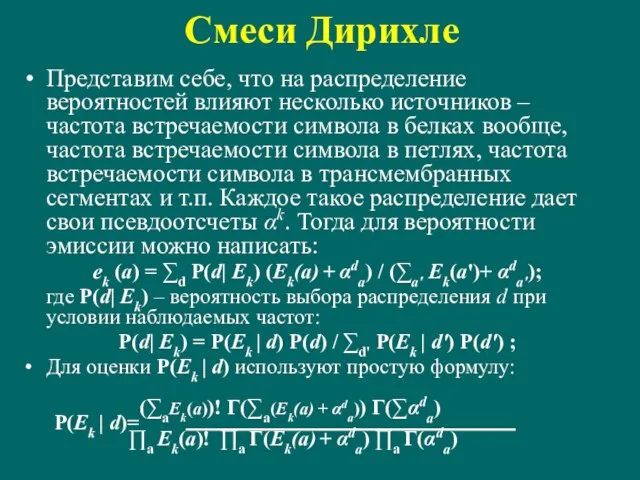

- 84. Использование матрицы замен Еще один способ введения псевдоотсчетов. У нас есть матрица замен аминокислотных остатков (например,

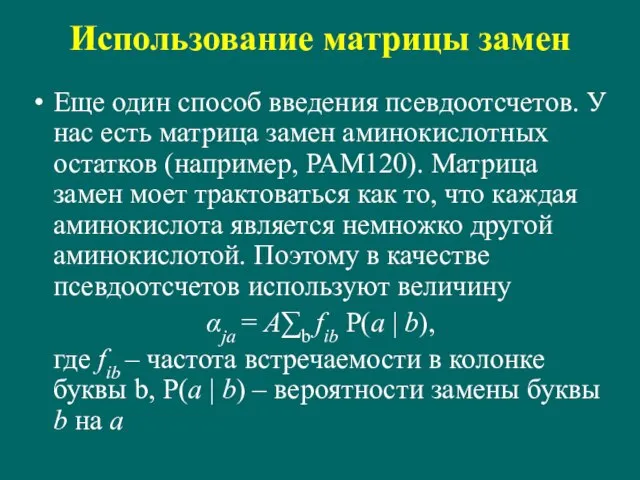

- 85. Использование предка Все последовательности xk в выравнивании произошли от общего предка y. P(yj=a | alignment)=qa∏kP(xkj|a)/∑a' qa∏kP(xkj|a)

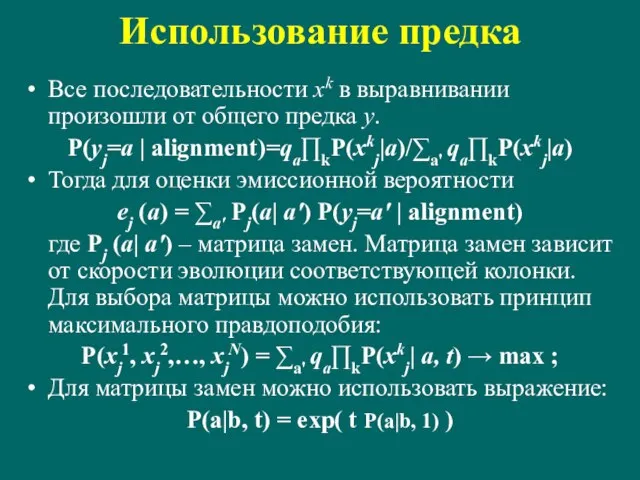

- 86. А чему же равно A? Для компенсации малости выборок используют псевдоотсчеты. Разные подходы дают разные распределения

- 87. Это еще не все … При вычислении эмиссионных вероятностей используется предположение о независимости испытаний. Однако, в

- 88. Взвешивание последовательностей Способ учета неравномерной представленности последовательностей в выборке называется взвешиванием последовательностей. Каждой последовательности в выравнивании

- 89. Взвешивание последовательностей Метод Герштейна-Сонхаммера-Чотьи Пусть нам известно филогенетическое дерево с расстояниями на ветвях. На листьях –

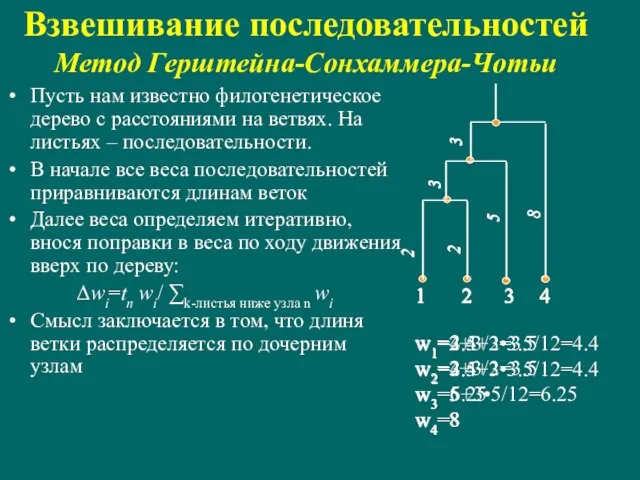

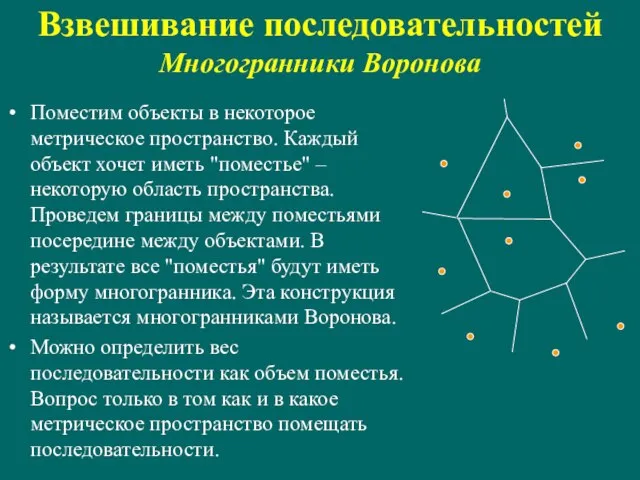

- 90. Взвешивание последовательностей Многогранники Воронова Поместим объекты в некоторое метрическое пространство. Каждый объект хочет иметь "поместье" –

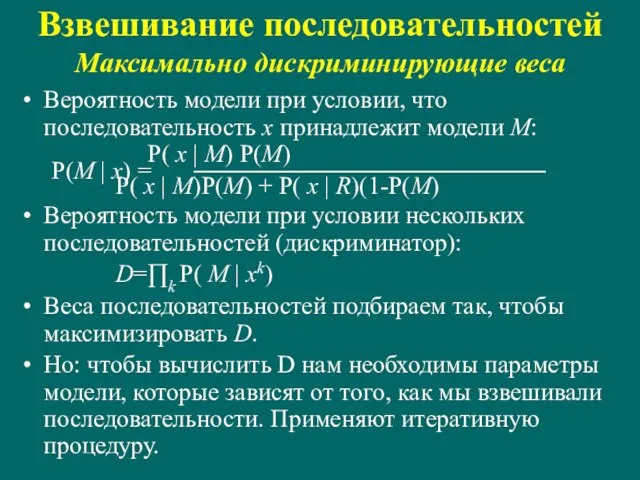

- 91. Вероятность модели при условии, что последовательность x принадлежит модели M: P( x | M) P(M) P(M

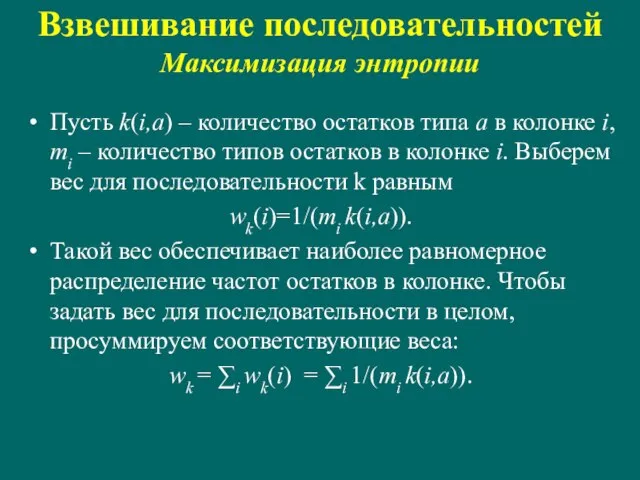

- 92. Взвешивание последовательностей Максимизация энтропии Пусть k(i,a) – количество остатков типа a в колонке i, mi –

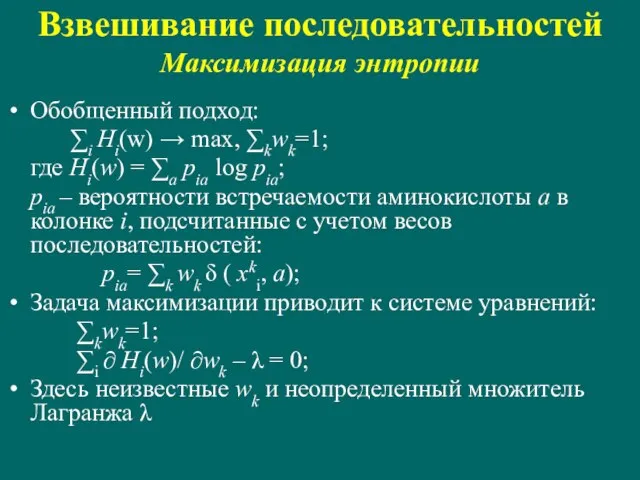

- 93. Обобщенный подход: ∑i Hi(w) → max, ∑kwk=1; где Hi(w) = ∑a pia log pia; pia –

- 94. Множественное выравнивание

- 95. Множественное выравнивание Способ написать несколько последовательностей друг под другом (может быть с пропусками) так, чтобы в

- 96. Оценка качества множественного выравнивания Энтропийная оценка Обычно считают, что колонки в выравнивании независимы. Поэтому качество выравнивания

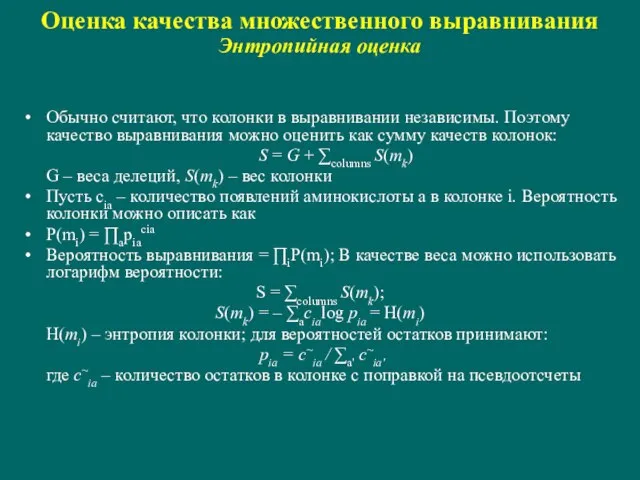

- 97. Оценка качества множественного выравнивания Сумма пар Другой традиционный способ оценки – сумма весов матрицы соответствия аминокислотных

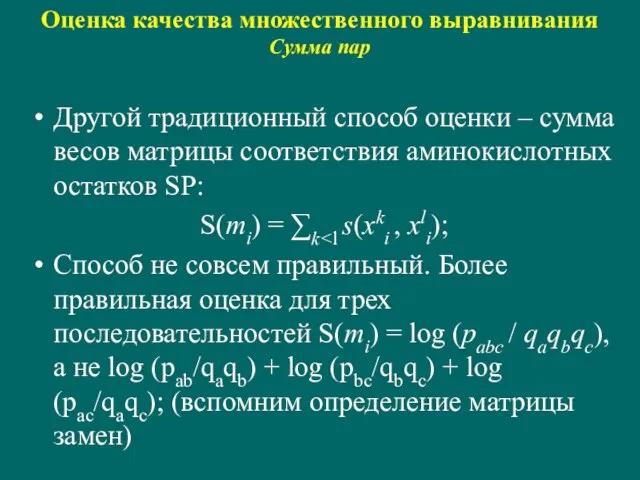

- 98. Если есть функционал, то его надо оптимизировать Элементарные переходы: Сопоставление трех Сопоставление двух и одна делеция

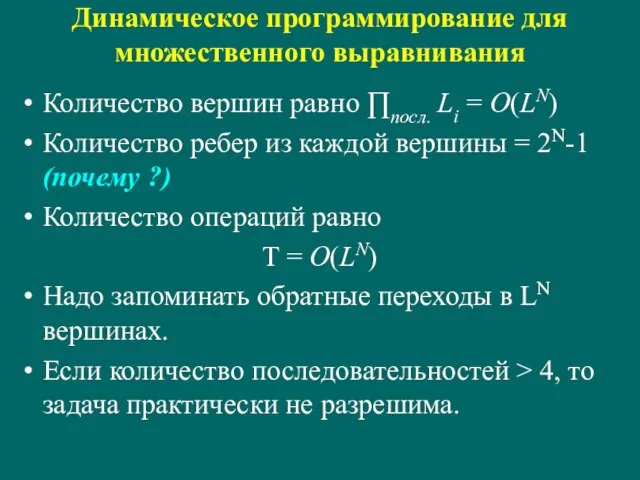

- 99. Динамическое программирование для множественного выравнивания Количество вершин равно ∏посл. Li = O(LN) Количество ребер из каждой

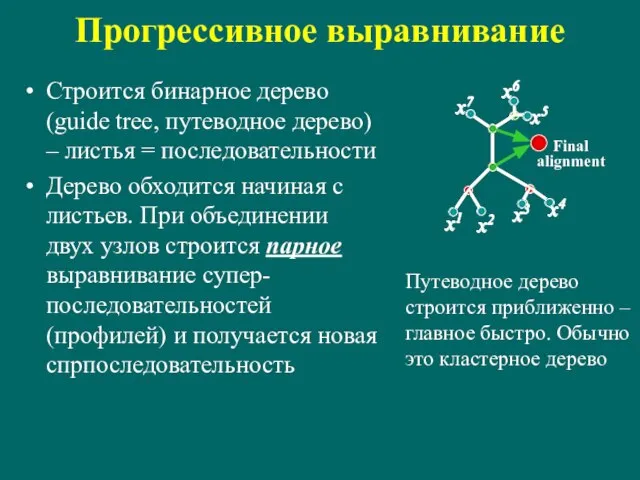

- 100. Прогрессивное выравнивание Строится бинарное дерево (guide tree, путеводное дерево) – листья = последовательности Дерево обходится начиная

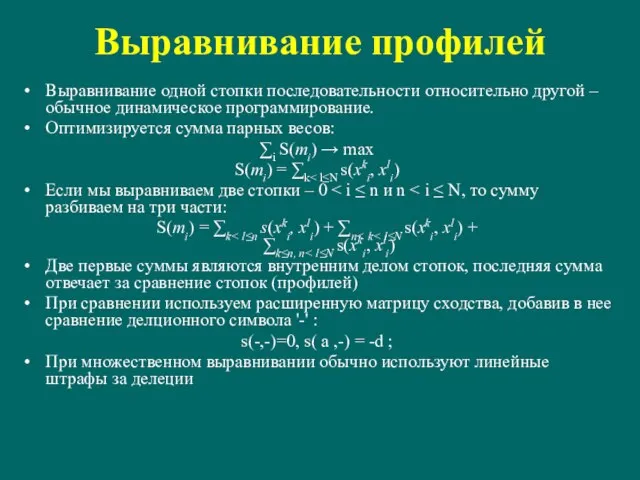

- 101. Выравнивание профилей Выравнивание одной стопки последовательности относительно другой – обычное динамическое программирование. Оптимизируется сумма парных весов:

- 102. ClustalW Строится матрица расстояний с использованием попарных выравниваний Строится NJ дерево (метод ближайшего соседа) Строится прогрессивное

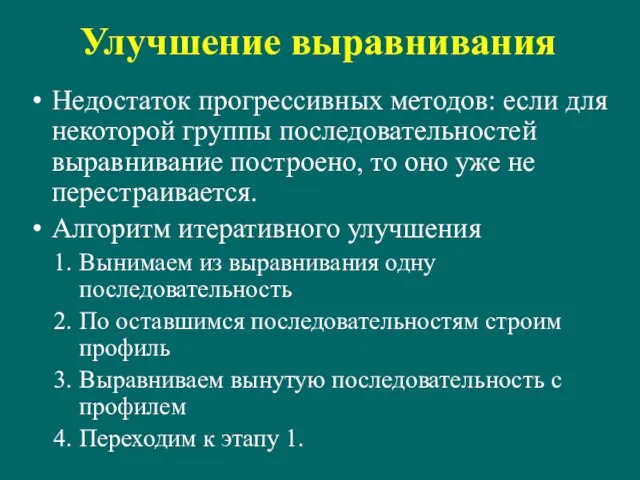

- 103. Улучшение выравнивания Недостаток прогрессивных методов: если для некоторой группы последовательностей выравнивание построено, то оно уже не

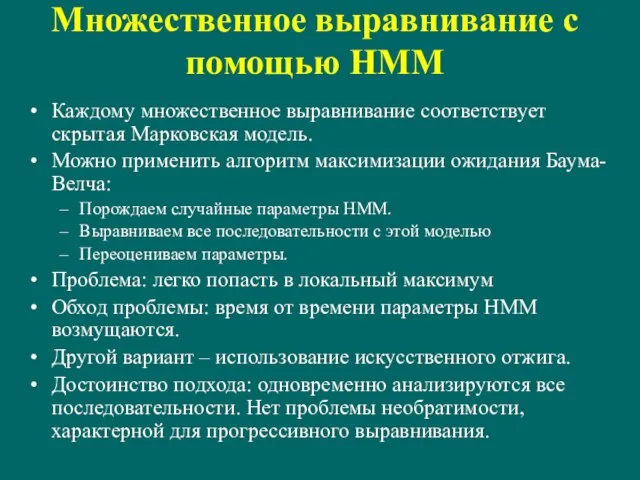

- 104. Множественное выравнивание с помощью HMM Каждому множественное выравнивание соответствует скрытая Марковская модель. Можно применить алгоритм максимизации

- 105. Блочное выравнивание

- 106. Поиск сигналов

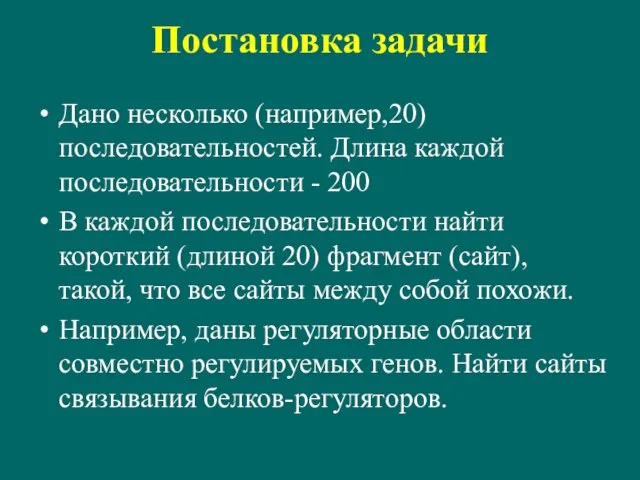

- 107. Постановка задачи Дано несколько (например,20) последовательностей. Длина каждой последовательности - 200 В каждой последовательности найти короткий

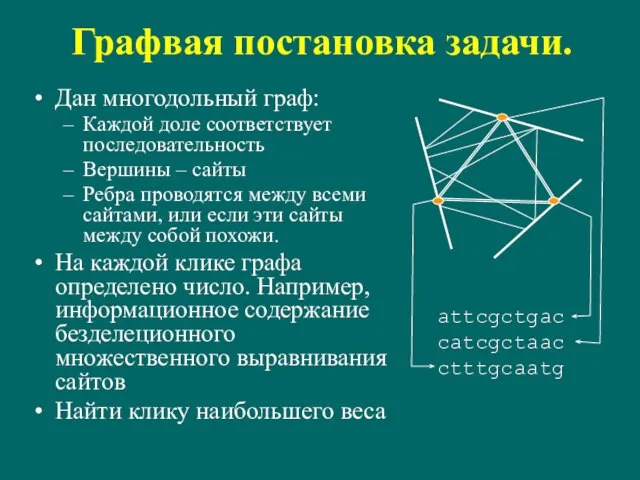

- 108. Графвая постановка задачи. Дан многодольный граф: Каждой доле соответствует последовательность Вершины – сайты Ребра проводятся между

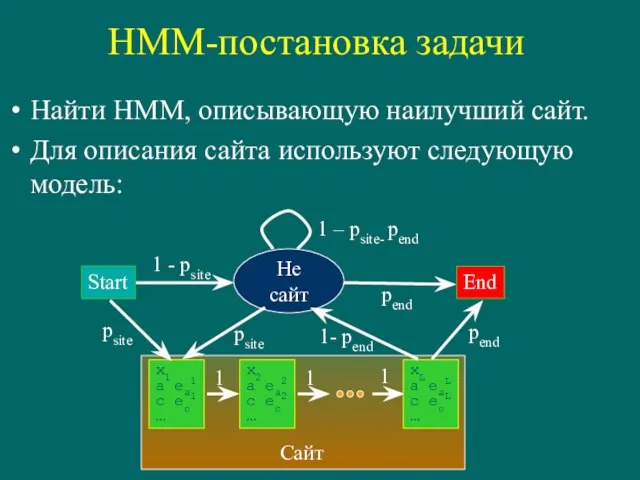

- 109. HMM-постановка задачи Найти HMM, описывающую наилучший сайт. Для описания сайта используют следующую модель: Start Не сайт

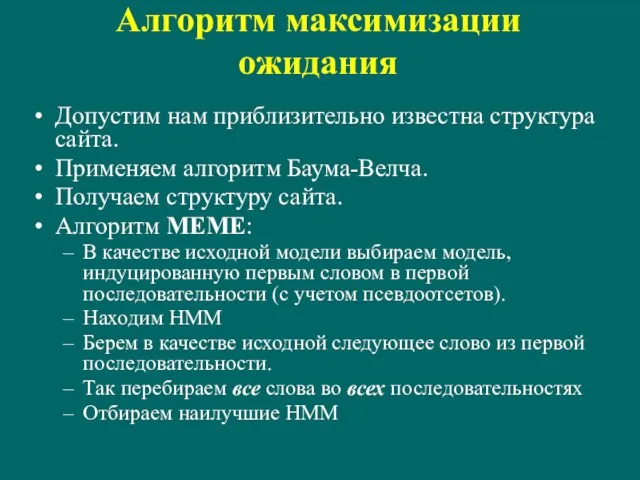

- 110. Алгоритм максимизации ожидания Допустим нам приблизительно известна структура сайта. Применяем алгоритм Баума-Велча. Получаем структуру сайта. Алгоритм

- 111. Гиббс сэмплер Задача: найти набор позиций сайтов в последовательностях Инициация: В качестве решения выбираем произвольный набор

- 112. Вероятности для Гиббс сэмплера Вероятности для Гиббс сэмплера

- 113. Комбинаторные методы

- 114. RNA

- 115. Вторичная структура РНК Вторичной структурой называется совокупность спаренных оснований Биологическая роль вторичной структуры: Структурная РНК –

- 116. Элементы вторичной структуры Шпилька Спираль Внутренняя петля Множственная петля Выпячивание Псевдоузел 5' 3'

- 117. Способы представления вторичных структур Топологическая схема Круговая диаграмма Массив спаренных оснований Список спиралей

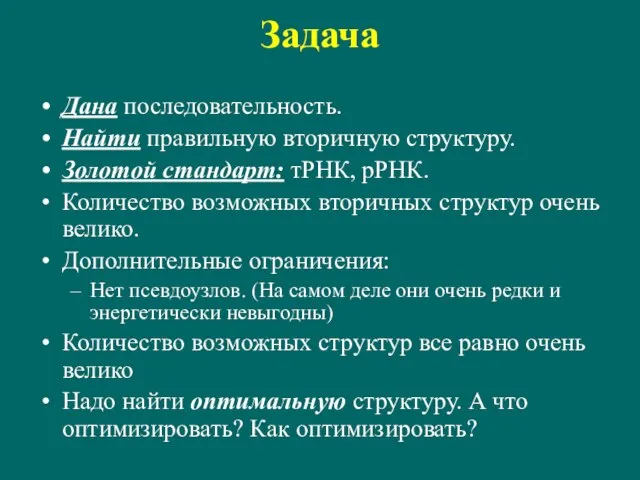

- 118. Задача Дана последовательность. Найти правильную вторичную структуру. Золотой стандарт: тРНК, рРНК. Количество возможных вторичных структур очень

- 119. Комбинаторный подход Построим граф: вершины – потенциальные нуклеотидные пары (или потенциальные спирали) Ребро проводится, если пары

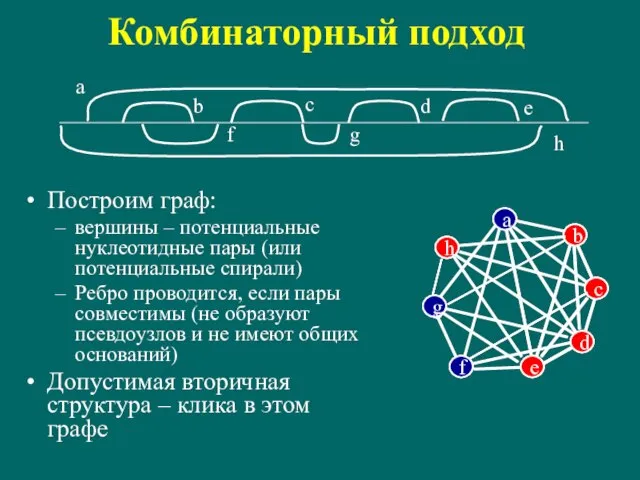

- 120. Структуры без псевдоузлов Структура без псевдоузлов = правильное скобочное выражение Может быть представлено в виде дерева

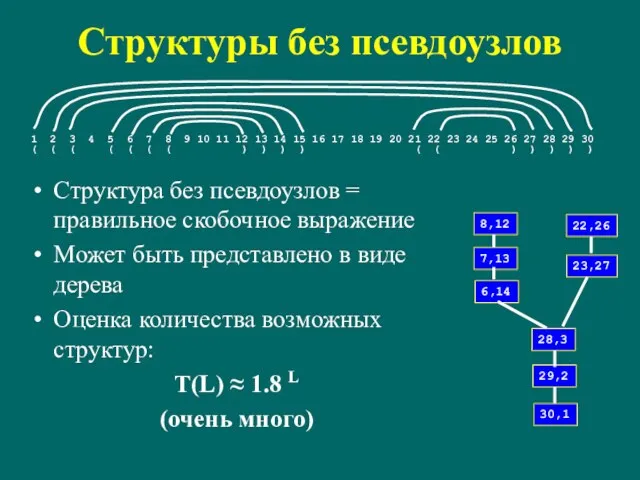

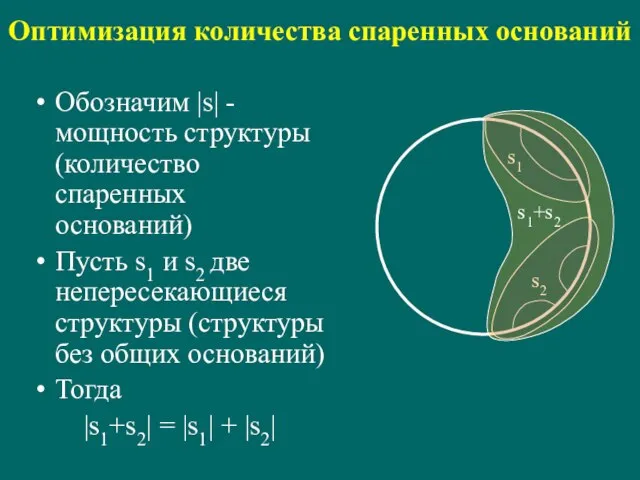

- 121. Оптимизация количества спаренных оснований Обозначим |s| - мощность структуры (количество спаренных оснований) Пусть s1 и s2

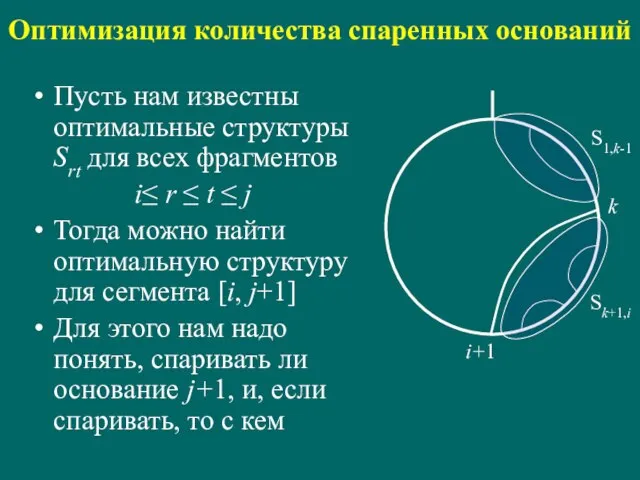

- 122. Оптимизация количества спаренных оснований Пусть нам известны оптимальные структуры Srt для всех фрагментов i≤ r ≤

- 123. Динамическое программирование для количества спаренных оснований (Нуссинофф) Количество спаренных оснований в оптимальной структуре S*i,j+1 определяется как

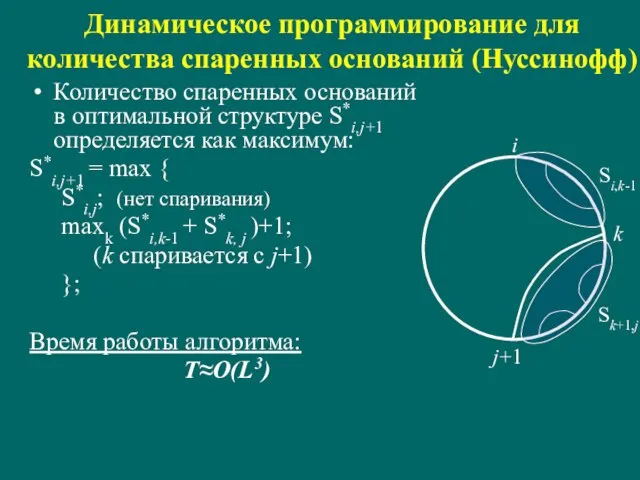

- 124. Динамическое программирование для количества спаренных оснований При поиске оптимального количества спаренных оснований заполняется треугольная матрица весов

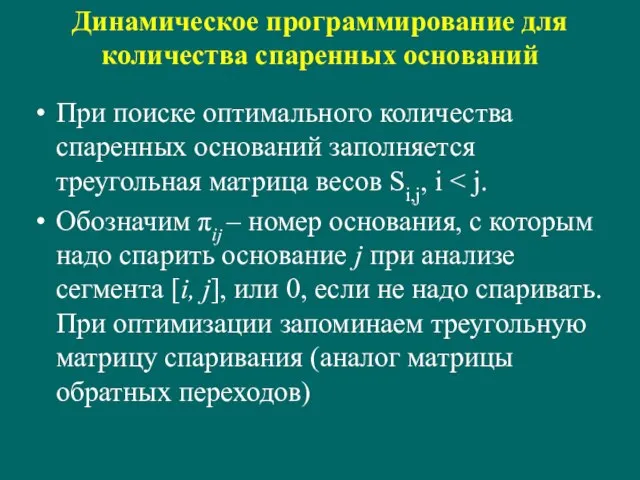

- 125. Восстановление структуры по матрице спаривания - - 17 - 2 2 16 - 3 15 -

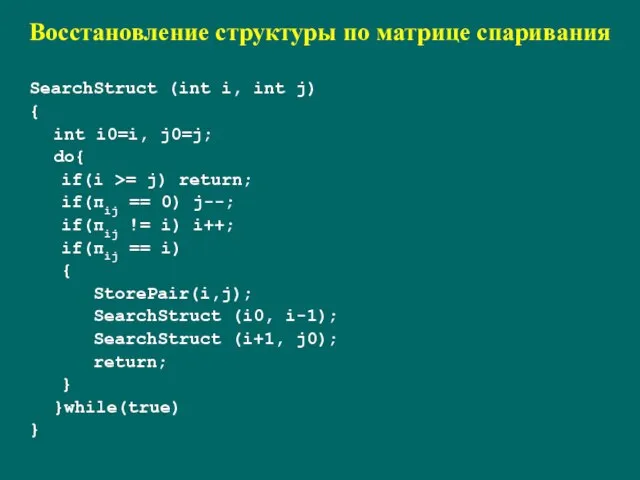

- 126. Восстановление структуры по матрице спаривания SearchStruct (int i, int j) { int i0=i, j0=j; do{ if(i

- 127. Энергия вторичной структуры Энергия спиралей Энергия петель (энтропия) A – U C – G A –

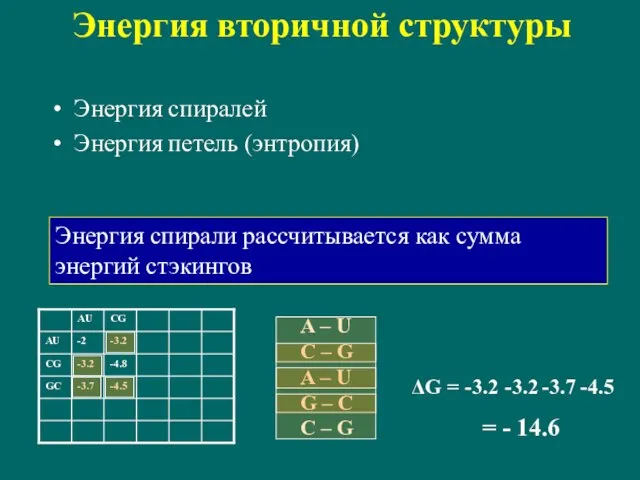

- 128. Энергия петель Энергия свободной цепи ΔG = B + 3/2 kT ln L Для шпилек при

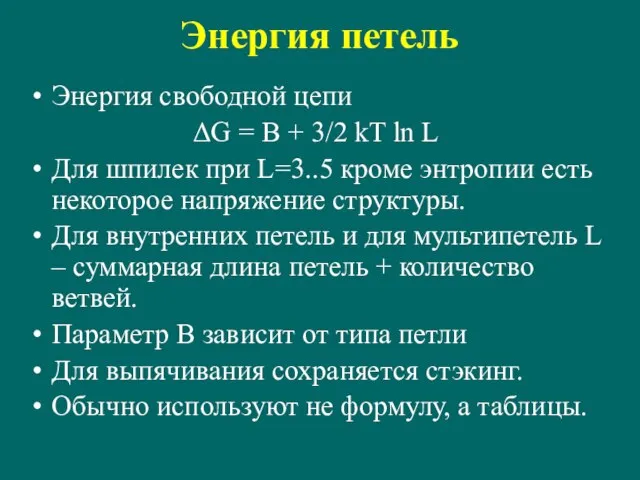

- 129. Минимизация энергии Обычное динамическое программирование не проходит – нет аддитивности. Определения нуклеотид h называется доступным для

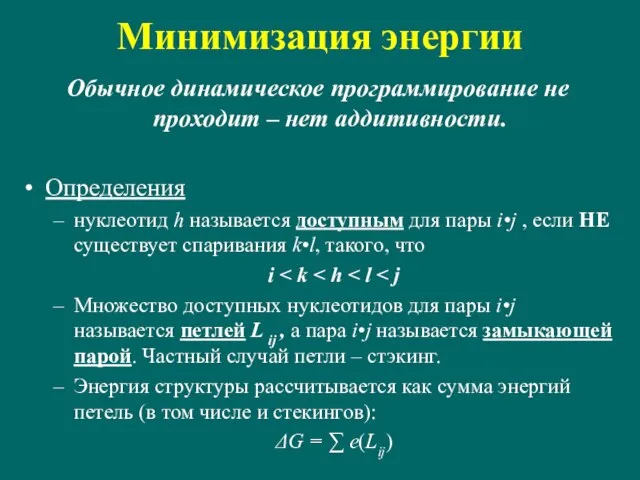

- 130. Алгоритм Зукера Введем две переменные: W(i,j) – минимальная энергия для структуры на фрагменте последовательности [i, j];

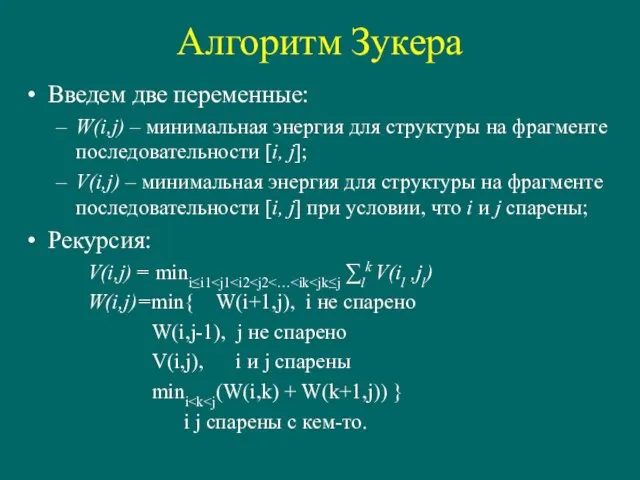

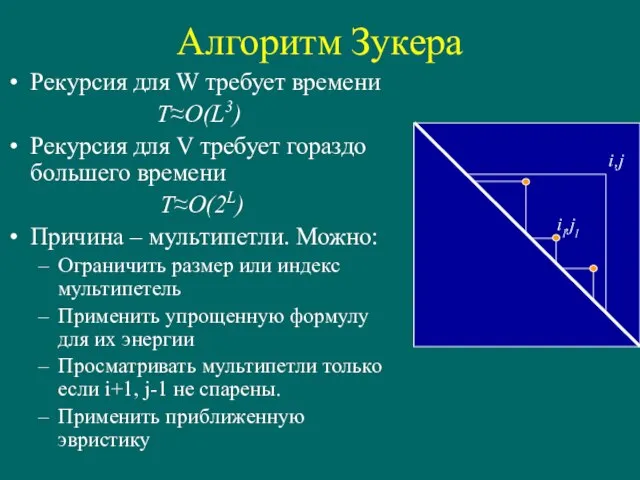

- 131. Алгоритм Зукера Рекурсия для W требует времени T≈O(L3) Рекурсия для V требует гораздо большего времени T≈O(2L)

- 132. Проблемы минимизации энергии Только около 80% тРНК сворачиваются в правильную структуру Энергетические параметры определены не очень

- 133. Решение проблем Искать субоптимальные структуры Искать эволюционно консервативные структуры. структуры тРНК и рРНК определены именно так

- 134. Поиск субоптимальных структур и структурных элементов Статистическая сумма Z = ∑ exp(-ΔGi /kT) Если мы просуммируем

- 135. Консенсусные вторичные структуры РНК

- 136. Основные задачи Построение консенсуса Дано: набор последовательностей для которых известно, что они имеют общую вторичную структуру

- 137. Метод ковариаций Пусть дано множественное выравнивание последовательностей Взаимная информация двух колонок: I(A,B) = ∑ αβ fAB(αβ)

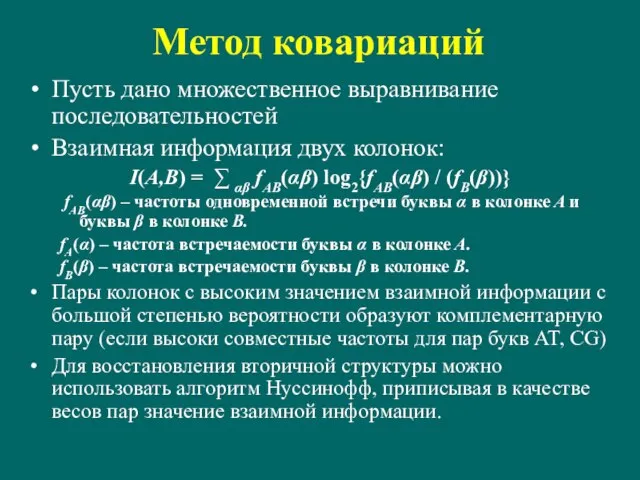

- 138. Грамматики Определения Терминальным символом называется символ, который может получаться в строке (обозначается малыми буквами) Нетерминальный символ

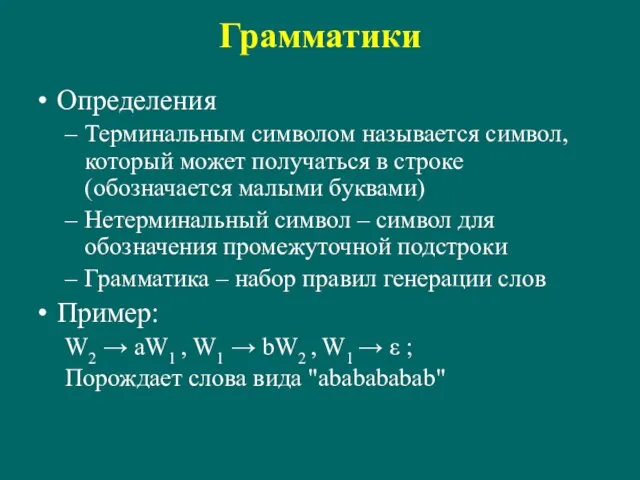

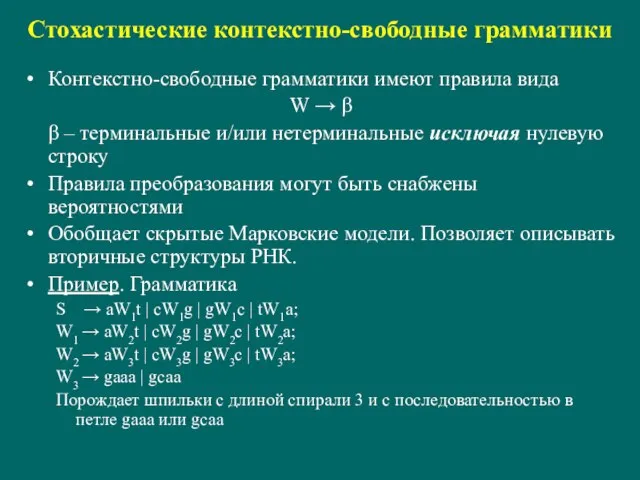

- 139. Стохастические контекстно-свободные грамматики Контекстно-свободные грамматики имеют правила вида W → β β – терминальные и/или нетерминальные

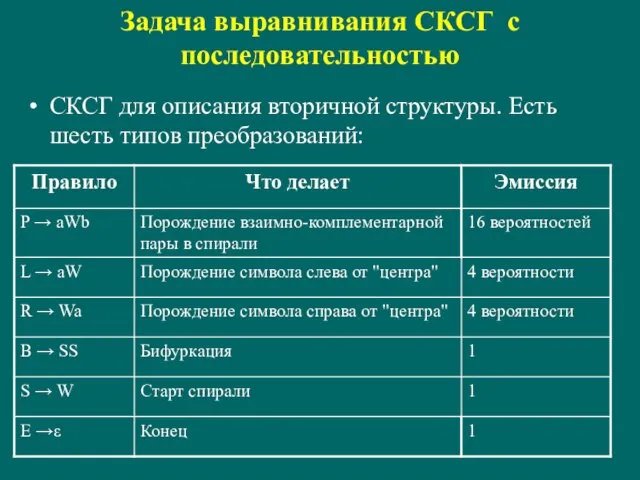

- 140. Задача выравнивания СКСГ с последовательностью СКСГ для описания вторичной структуры. Есть шесть типов преобразований:

- 141. Общая модель для выравнивания вторичной структуры с последовательностью

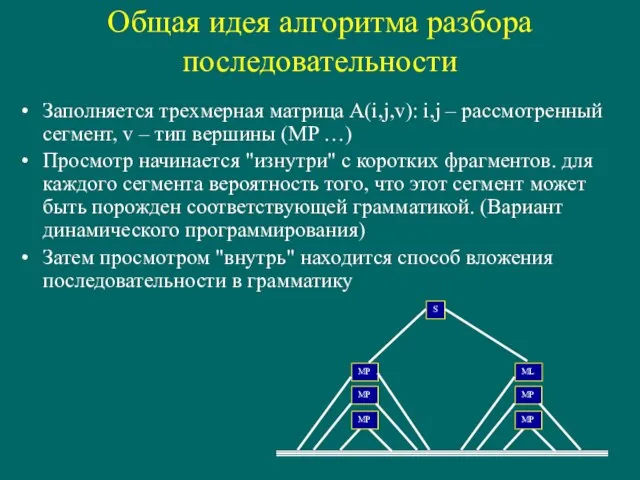

- 142. Общая идея алгоритма разбора последовательности Заполняется трехмерная матрица A(i,j,v): i,j – рассмотренный сегмент, v – тип

- 143. Поиск генов

- 145. Скачать презентацию

Технологическое предпринимательство для школьников: от изобретения к бизнесу! Занятие 2

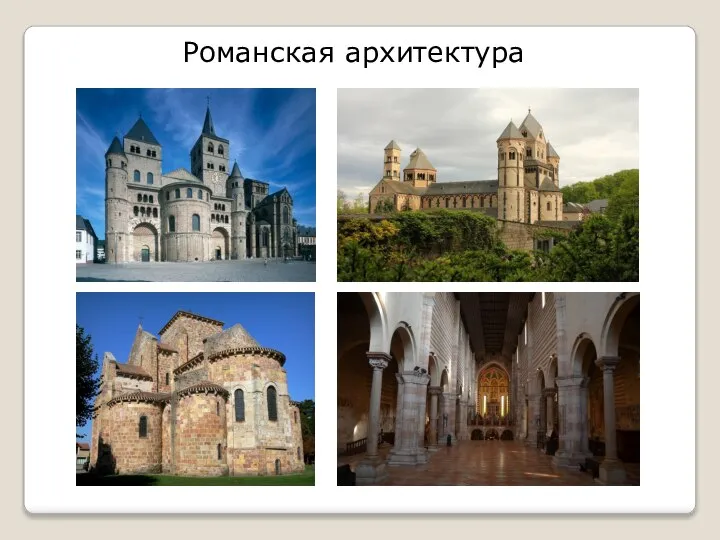

Технологическое предпринимательство для школьников: от изобретения к бизнесу! Занятие 2 Романская архитектура

Романская архитектура Выборы Лидера совета старшеклассников

Выборы Лидера совета старшеклассников Роботы в древней греции

Роботы в древней греции Функция

Функция Поисковое продвижение: как увеличить его эффективность?

Поисковое продвижение: как увеличить его эффективность? Рекламные решения

Рекламные решения Мегалитическая архитектура 8 класс

Мегалитическая архитектура 8 класс Планета дорог

Планета дорог Забота о ближнем - призвание христианина

Забота о ближнем - призвание христианина МОДЕЛИ ПЕДАГОГИЧЕСКОГО ОБЩЕНИЯ

МОДЕЛИ ПЕДАГОГИЧЕСКОГО ОБЩЕНИЯ Презентация на тему Правила поведения при пожаре

Презентация на тему Правила поведения при пожаре  Викторина по произведению А.С. Пушкина "Капитанская дочка"

Викторина по произведению А.С. Пушкина "Капитанская дочка" Конструирование и моделирование одежды

Конструирование и моделирование одежды Медиабезопасность

Медиабезопасность Агатэ Элерс, отдел Международного сотрудничества Услуги и опыт Немецкого Энергетического Агентства в реализации СО- и МЧР-проект

Агатэ Элерс, отдел Международного сотрудничества Услуги и опыт Немецкого Энергетического Агентства в реализации СО- и МЧР-проект ВСЕМ! ВСЕМ! ВСЕМ! 7 ФЕВРАЛЯ, В 17 ЧАСОВ ГИМНАЗИЯ № 3 ЖДЁТ СВОИХ ВЫПУСКНИКОВ

ВСЕМ! ВСЕМ! ВСЕМ! 7 ФЕВРАЛЯ, В 17 ЧАСОВ ГИМНАЗИЯ № 3 ЖДЁТ СВОИХ ВЫПУСКНИКОВ  Что нас окружает ?

Что нас окружает ? НИД кафедры ЭиУ в 2020/21 уч. году Проблемы, задачи, пути развития

НИД кафедры ЭиУ в 2020/21 уч. году Проблемы, задачи, пути развития Британские художники

Британские художники Год театра в России. Научно-практическая конференция

Год театра в России. Научно-практическая конференция Презентация3

Презентация3 Винтовые лестницы

Винтовые лестницы Экспорт нефти и нормативно-правовое регулирование

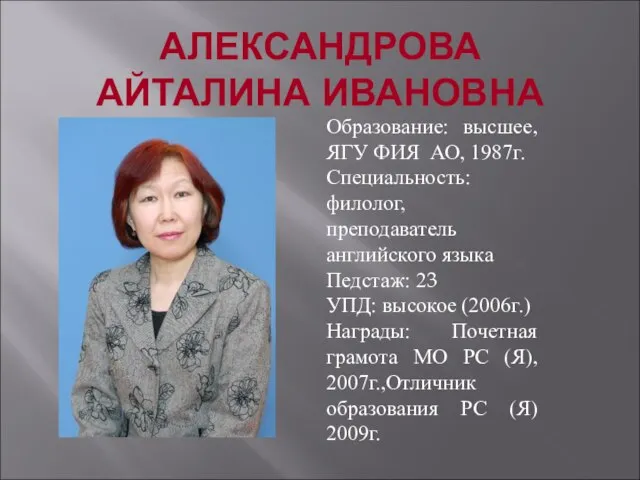

Экспорт нефти и нормативно-правовое регулирование Александрова Айталина Ивановна

Александрова Айталина Ивановна Готовность первоклассника к школе

Готовность первоклассника к школе Отклонение в поведении ребенка как социально-педагогическая проблема

Отклонение в поведении ребенка как социально-педагогическая проблема Презентация на тему Миграции населения России (8 класс)

Презентация на тему Миграции населения России (8 класс)