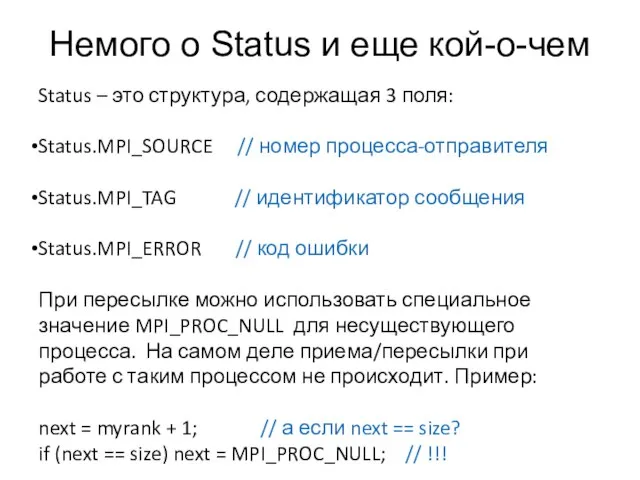

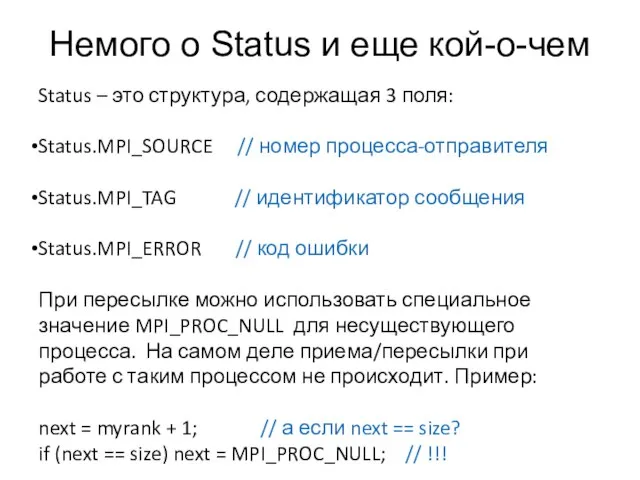

Слайд 2Немого о Status и еще кой-о-чем

Status – это структура, содержащая 3 поля:

Status.MPI_SOURCE

// номер процесса-отправителя

Status.MPI_TAG // идентификатор сообщения

Status.MPI_ERROR // код ошибки

При пересылке можно использовать специальное значение MPI_PROC_NULL для несуществующего процесса. На самом деле приема/пересылки при работе с таким процессом не происходит. Пример:

next = myrank + 1; // а если next == size?

if (next == size) next = MPI_PROC_NULL; // !!!

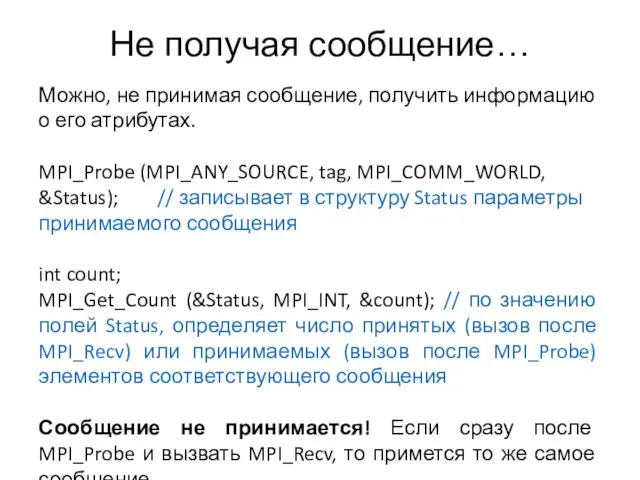

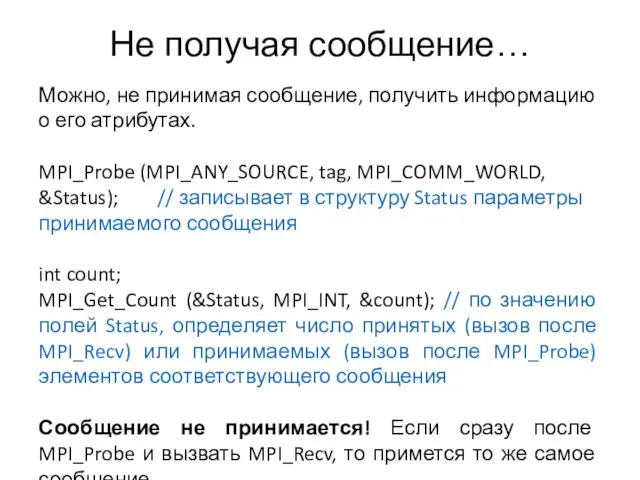

Слайд 3Не получая сообщение…

Можно, не принимая сообщение, получить информацию о его атрибутах.

MPI_Probe (MPI_ANY_SOURCE,

tag, MPI_COMM_WORLD, &Status); // записывает в структуру Status параметры принимаемого сообщения

int count;

MPI_Get_Count (&Status, MPI_INT, &count); // по значению полей Status, определяет число принятых (вызов после MPI_Recv) или принимаемых (вызов после MPI_Probe) элементов соответствующего сообщения

Сообщение не принимается! Если сразу после MPI_Probe и вызвать MPI_Recv, то примется то же самое сообщение.

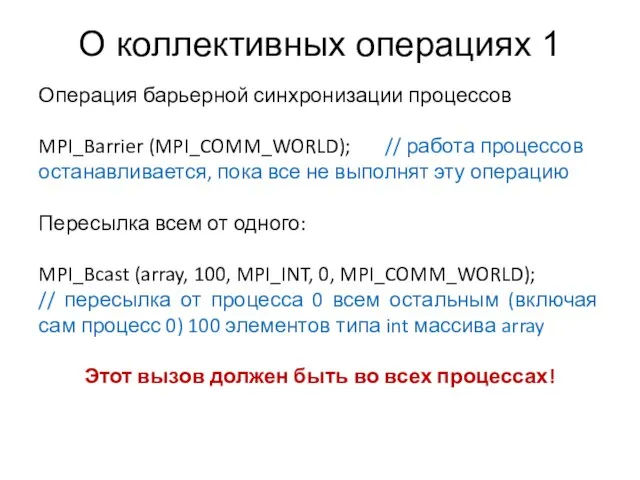

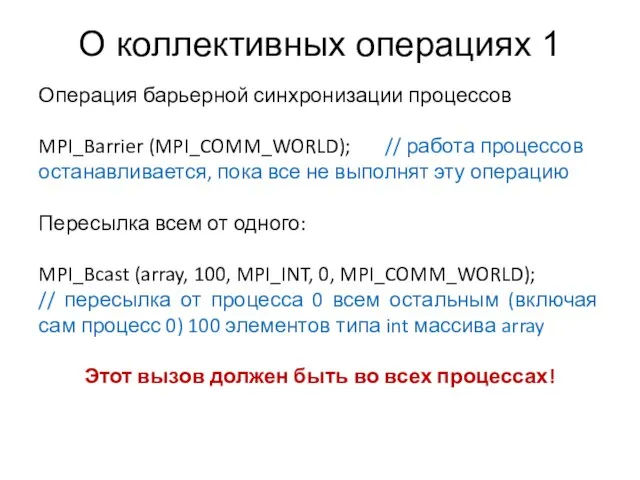

Слайд 4О коллективных операциях 1

Операция барьерной синхронизации процессов

MPI_Barrier (MPI_COMM_WORLD); // работа процессов останавливается,

пока все не выполнят эту операцию

Пересылка всем от одного:

MPI_Bcast (array, 100, MPI_INT, 0, MPI_COMM_WORLD);

// пересылка от процесса 0 всем остальным (включая сам процесс 0) 100 элементов типа int массива array

Этот вызов должен быть во всех процессах!

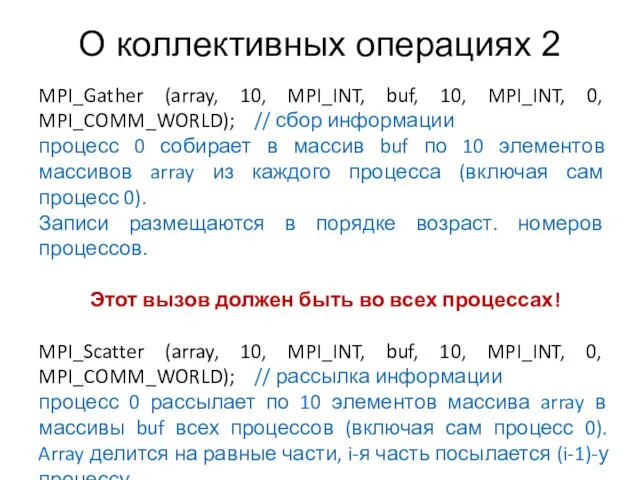

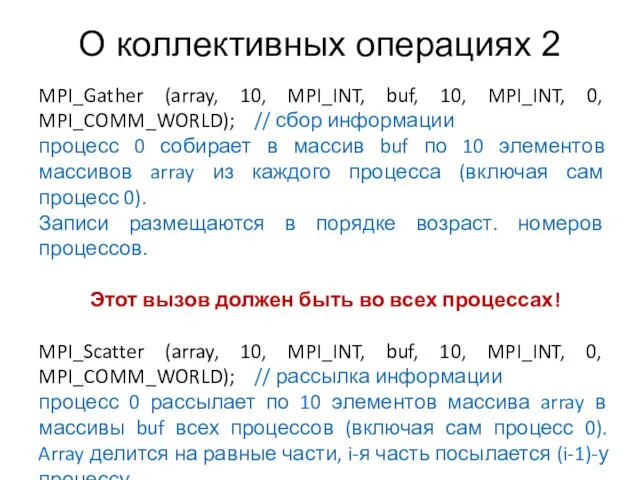

Слайд 5О коллективных операциях 2

MPI_Gather (array, 10, MPI_INT, buf, 10, MPI_INT, 0, MPI_COMM_WORLD);

// сбор информации

процесс 0 собирает в массив buf по 10 элементов массивов array из каждого процесса (включая сам процесс 0).

Записи размещаются в порядке возраст. номеров процессов.

Этот вызов должен быть во всех процессах!

MPI_Scatter (array, 10, MPI_INT, buf, 10, MPI_INT, 0, MPI_COMM_WORLD); // рассылка информации

процесс 0 рассылает по 10 элементов массива array в массивы buf всех процессов (включая сам процесс 0). Array делится на равные части, i-я часть посылается (i-1)-у процессу.

Этот вызов должен быть во всех процессах!

TA_lec2

TA_lec2 тема 1.3 - Программное обеспечение вычислительной техники. Операционные системы

тема 1.3 - Программное обеспечение вычислительной техники. Операционные системы Программные средства эконометрического анализа и прогнозирования

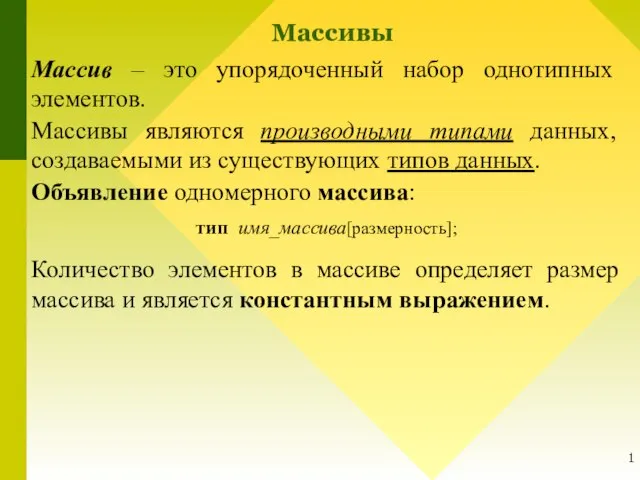

Программные средства эконометрического анализа и прогнозирования Массивы и указатели

Массивы и указатели Разработка программы формирующей на базе исходного кода интерфейс доступа к нему в стиле Fluent API

Разработка программы формирующей на базе исходного кода интерфейс доступа к нему в стиле Fluent API Презентация _Как устроен персональный компьютер_ (7 класс)

Презентация _Как устроен персональный компьютер_ (7 класс) Что такое Wi-Fi

Что такое Wi-Fi Локальная сеть

Локальная сеть Географические информационные системы

Географические информационные системы Работа с документами

Работа с документами Предварительная информация

Предварительная информация Ребусы по информатике

Ребусы по информатике Тестовые задания для самоконтроля

Тестовые задания для самоконтроля Гендерное воспитание. Ты не один

Гендерное воспитание. Ты не один От комплексной автоматизации к цифровизации производства

От комплексной автоматизации к цифровизации производства Logowanie do MS Teams

Logowanie do MS Teams Наталья 20210329118

Наталья 20210329118 Информационные технологии

Информационные технологии Формирование архива данных аэрологического зондирования

Формирование архива данных аэрологического зондирования Медиа-безопасность. Социальные сети

Медиа-безопасность. Социальные сети Электронная таблица

Электронная таблица Программное обеспечение: Уровни и классификация

Программное обеспечение: Уровни и классификация Системы координат. Справочная система. Занятие №3

Системы координат. Справочная система. Занятие №3 066fdf0730015183ddb5308b8c442912

066fdf0730015183ddb5308b8c442912 Отечественная и зарубежная нормативно-правовая база в области информационной безопасности сетевого оборудования. (Лекция 2)

Отечественная и зарубежная нормативно-правовая база в области информационной безопасности сетевого оборудования. (Лекция 2) Решение систем линейных уравнений при помощи компьютерных технологий

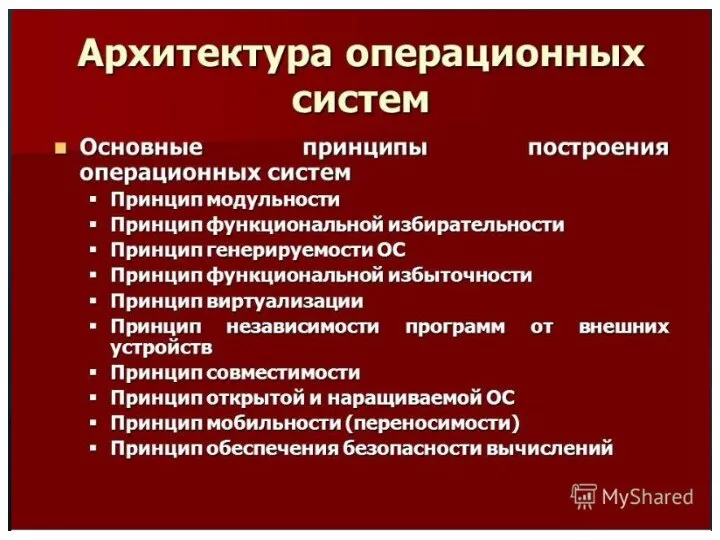

Решение систем линейных уравнений при помощи компьютерных технологий Архитектура операционных систем

Архитектура операционных систем Вирусы

Вирусы